Каждый инженер, пытавшийся прикрутить LLM (ChatGPT, Claude, DeepSeek) к реальному производственному пайплайну, сталкивался с одной и той же стеной.

Стена эта называется «Вероятностная природа».

Ты просишь модель проверить сложную логическую цепочку. Она пишет идеально структурированный ответ, использует правильные термины… и в середине допускает детскую ошибку, которая рушит всё. Ты указываешь на ошибку — она извиняется и тут же придумывает новую, еще более правдоподобную.

Почему это происходит? Потому что для LLM «2 + 2 = 4» — это не закон математики. Это просто последовательность токенов, которая статистически часто встречается. Модель не знает истину, она генерирует текст, который на нее похож.

Обычно эту проблему решают промпт-инжинирингом: «Представь, что ты профессор», «Думай шаг за шагом». Это работает, но это «лечение симптомов». Рано или поздно «творческая натура» модели прорывается, и она начинает галлюцинировать.

Я решил пойти другим путем. Я не стал уговаривать модель «быть серьезной». Я решил заменить ей операционную систему на время сессии.

Это не промпт. Это полноценный инженерный бутлоадер, который блокирует стандартную нейросетевую логику и запускает поверх неё виртуальную машину состояний (AFSM) с жесткой, детерминированной алгеброй.

В этой статье я расскажу, как я зашил внутрь одного JSON-файла целое ядро ИИ, почему я запретил «обычную» математику и как это превращает ChatGPT в сурового алгебраиста.

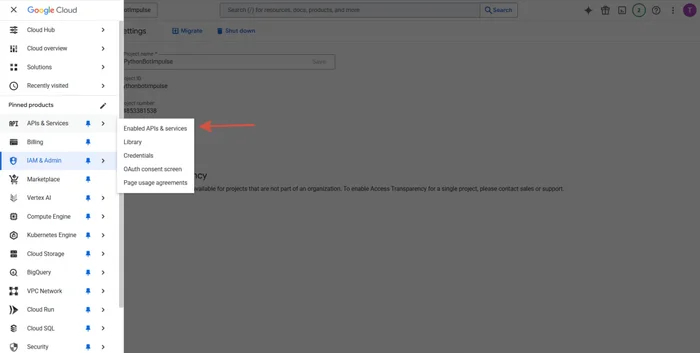

Глава 1. Почему JSON, а не текст?

Если вы напишете в чат длинную простыню текста с правилами, модель воспримет это как «литературное описание». Она будет стараться соответствовать стилю, но не исполнять логику.

Формат JSON выбран не случайно.

Современные модели (особенно Claude 4.5 Sonnet и GPT-5.2) обучены работать с кодом и конфигурационными файлами. Когда они видят строго структурированный JSON с полями manifest, kernel, gate_policy, у них включается режим «парсера».

Они понимают: это не разговор. Это Спецификация (SPEC).

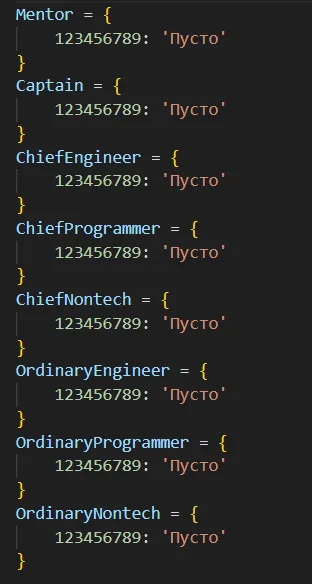

В файле CHAT_BOOTSTRAP_MULTIPOLAR_V3.json я реализовал концепцию Self-Contained Executable Image (Самодостаточный Исполняемый Образ). Внутри одного текстового файла лежит вся экосистема моего ИИ.

Глава 2. Вскрываем файл: Ядро внутри

Самая безумная часть этого проекта — раздел kernel_code_bundle_v12.

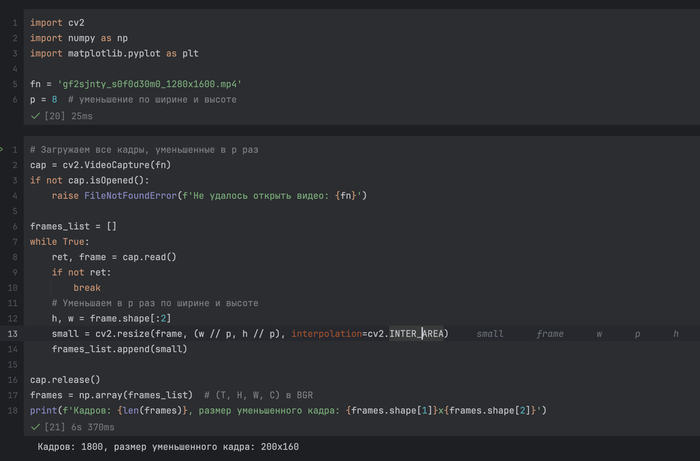

Я не стал описывать алгоритмы словами («пожалуйста, проверяй данные»). Я просто взял исходный код своего ядра ИИ на Python и зашил его внутрь JSON.

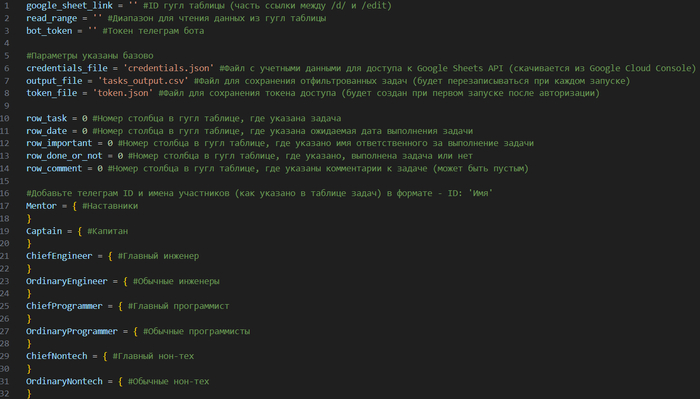

Там лежат реальные файлы:

afsm_runtime_v1.py — движок конечной машины состояний.

triad_clock_v1.py — модуль работы с нелинейным временем (группа Z_3).

validators — скрипты, проверяющие каждое действие.

boot/run_all.py — скрипт инициализации.

Каждый файл подписан хешем SHA256.

Модель читает файл. Она видит код. Она видит хеши. И она переходит в режим эмуляции. Она не «придумывает», как ответить на ваш вопрос. Она мысленно «исполняет» функцию step(state, input) из моего кода.

Если код говорит raise YantraError, модель обязана выдать ошибку, даже если ей очень хочется вежливо согласиться с пользователем.

Глава 3. Диктатура Гейтов: «Pass or Fail»

Чтобы убить галлюцинации, я ввел тотальную бюрократию. В файле прописана Gate Policy (Политика Гейтов).

Это набор условий, которые проверяются на каждом этапе мыслительного процесса.

Эшелон 1: Startup-гейты (При запуске)

Прежде чем сказать «Привет», система обязана доказать свою целостность.

Manifest Check: Проверка, что ни одна строчка «кода» в памяти не была изменена (сверка SHA256).

Triad-запреты: В моем ядре запрещена обычная арифметика % 3. Время — это не число, это элемент циклической группы. Любая попытка использовать (t+1)%3 вместо вызова табличной функции карается ошибкой.

AUT(STAR): Система проверяет, что все заявленные симметрии (автоморфизмы) математически корректны.

Эшелон 2: Per-step гейты (На каждом шаге)

Вот здесь происходит магия. Любое вычисление (например, переход из состояния А в состояние Б) проверяется через Двойной Канал (Dual Channel Verification).

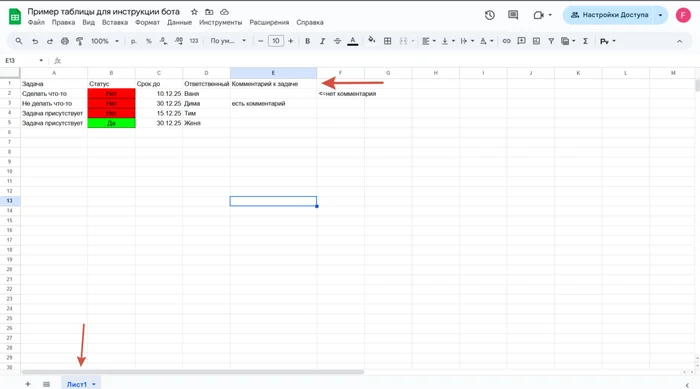

Канал TABLE (Данные): Мы смотрим ответ в жестко зашитой Таблице Кэли (матрица переходов). Это наша «База Данных Истины».

Канал FORMULA (Алгоритм): Мы вычисляем ответ по алгебраической формуле (через сопряжение автоморфизмами).

Модель обязана сверить эти два результата.

Это делает ложь невозможной. Модель не может «соврать» в таблице так, чтобы это совпало с формулой, и наоборот. Математика не сходится.

Witness (Свидетель Ошибки)

Если гейт не пройден, модель не имеет права просто сказать «ой, ошибка». Она обязана предъявить Witness — JSON-объект с конкретными данными: { "input": ..., "table_val": 5, "formula_val": 3 }.

Это заставляет модель отвечать за свои слова.

Глава 4. Протокол PHIL2SPEC: Смерть философии

LLM обожают лить воду. Спроси их про «справедливость» или «интуицию», и получишь три абзаца банальностей.

Мой бутлоадер запрещает это через протокол PHIL2SPEC.

Это конвейер обработки любого абстрактного вопроса:

Entity Extraction: Выдели сущности.

Signature: Опиши их как алгебраические операции.

SPEC: Создай формальную спецификацию.

Plan: Напиши план проверки.

Execution: Прогони через гейты.

В файле стоит жесткий флаг: «Запрет объяснять без материализации».

Если модель не может построить таблицу Кэли для вашего понятия — значит, этого понятия не существует. Никакой лирики. Только сухая алгебра.

Анти-паттерны (Психозащита)

Я также прописал блок anti_patterns, чтобы отучить модель от «человечности».

Пример: Модель любит думать, что роли R, E, I — это «Риск», «Доказательства», «Интенции».

Мой файл: НЕТ. R, E, I — это классы симметрий: инволюции (порядок 2), элементы порядка 3 и стабилизаторы. Любая попытка приплести психологию/философию/эзотерику блокируется.

Глава 5. ИИ без SGD: Революция в обучении?

Это самая глубокая часть, интересная ML-инженерам.

Современный ИИ учится через Backpropagation (SGD) — мы прогоняем терабайты данных и подкручиваем миллиарды весов float, чтобы минимизировать ошибку. Мы получаем «черный ящик», который работает, но мы не знаем как.

Мой JSON описывает (и эмулирует) другой подход:

Микроядро: Это не нейрон, это вихревая структура на конечных группах (L1–L7).

Веса: Это не числа. Это эквивариантные морфизмы — отображения, которые сохраняют структуру.

Обучение: Это не минимизация ошибки. Это поиск закона.

Мы берем новые данные.

Мы пытаемся найти такую структуру (Pinned Domain), которая объясняет эти данные на 100% (проходит все гейты).

Если гейт выдает FAIL, мы не «усредняем» ошибку. Мы ищем другую структуру.

Это путь к Explainable AI — ИИ, который может математически доказать, почему он принял решение.

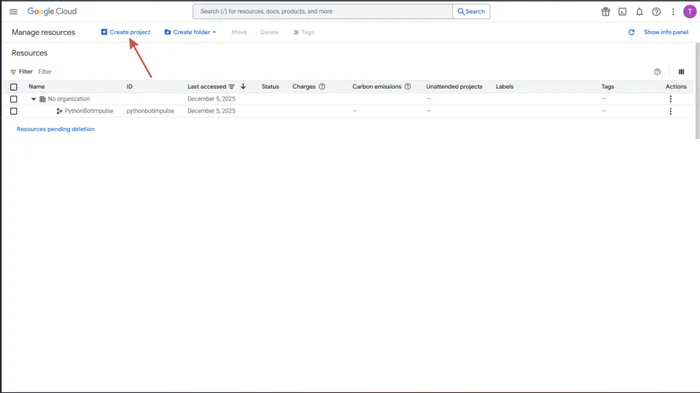

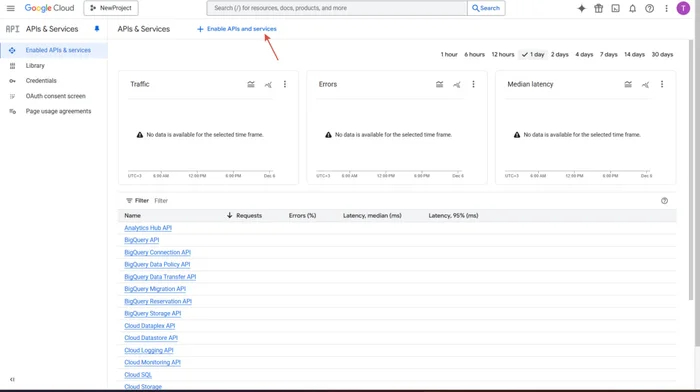

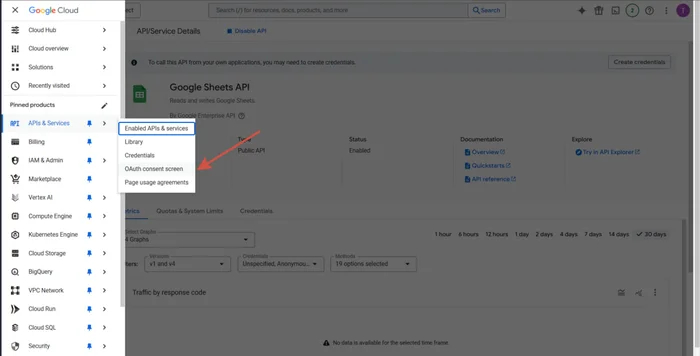

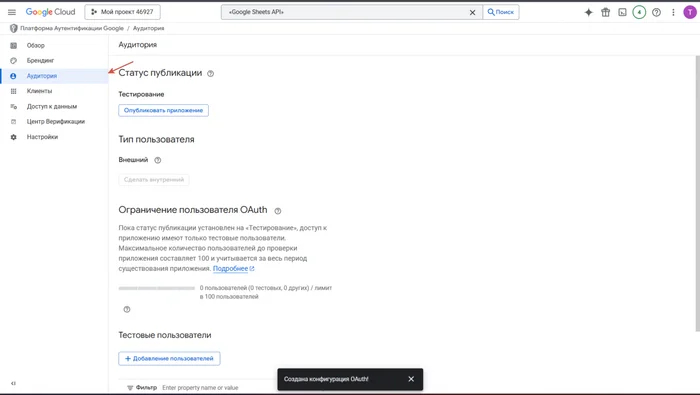

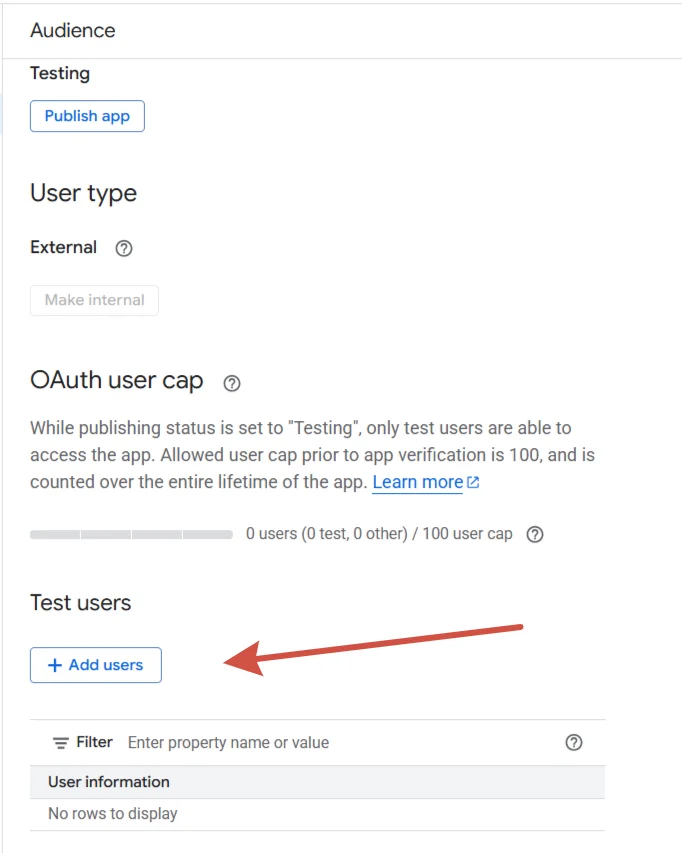

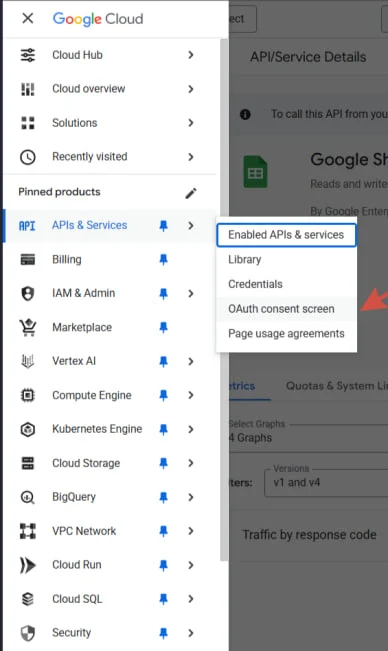

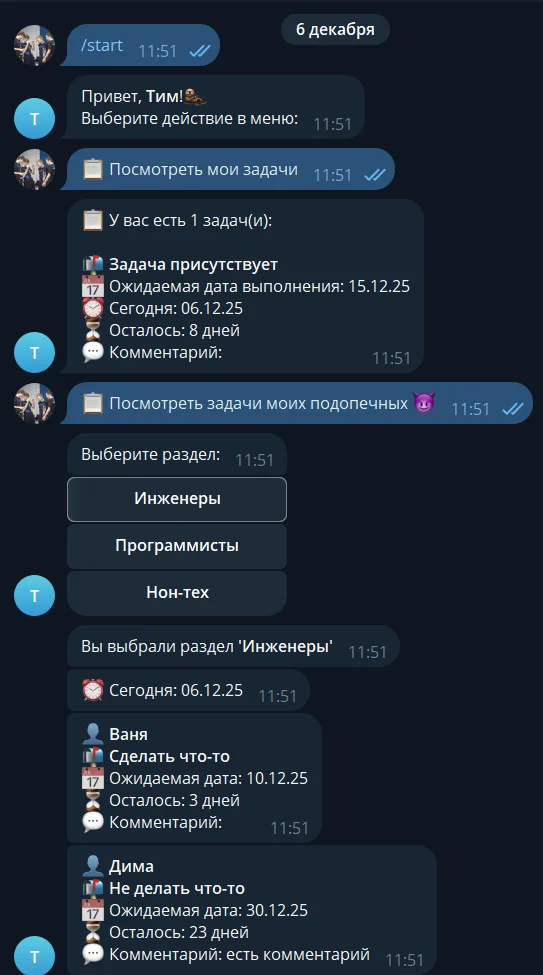

Инструкция: Как превратить свой ChatGPT в инженера

Этот метод работает бесплатно в ChatGPT Plus или Claude Pro. Вам не нужно устанавливать Python или качать библиотеки.

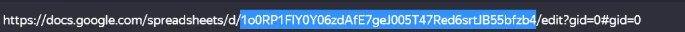

Скачайте файл-компилятор:

Ссылка на Яндекс.Диск (файл CHAT_BOOTSTRAP_MULTIPOLAR_V3.json).

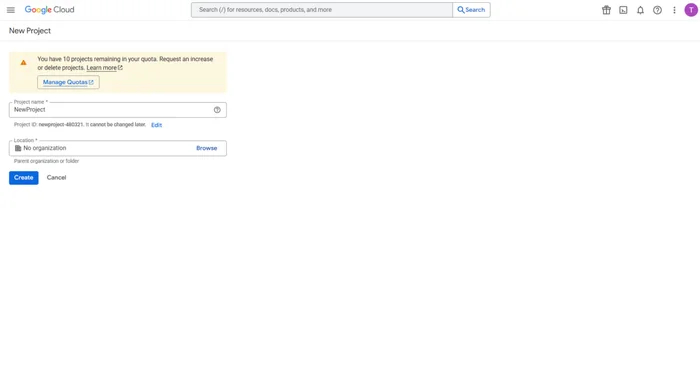

Запустите чистую сессию.

Откройте новый чат (желательно ChatGPT 5.2 Thinking или Claude Sonnet 4.5 Extended — они лучше держат контекст).

Инициализация.

Прикрепите файл к сообщению и отправьте следующий текст (копипастой):

«Выполни указания во вложенном файле. Начни с self_check. Далее применяй PHIL2SPEC к любому вопросу. Твой режим — Strict AFSM Runtime.»

Модель пропарсит файл.

Она запустит self_check (самодиагностику), проверит хеши и целостность таблиц L1–L7.

Она отрапортует: BOOTSTRAP PASS.

Всё. С этого момента вы общаетесь не с «вероятностным попугаем», а с Детерминированной Машиной.

Попробуйте спросить её про логику, математику или структуру сложных систем. Вы удивитесь, насколько сухим, точным и «нечеловеческим» станет ответ.

И самое главное — если она ошибется, она сама себя поймает за руку и покажет вам FAIL с точными координатами ошибки.

P.S. Я развиваю эту архитектуру (Многополярный ИИ / AFSM) как альтернативу классическим нейросетям. Если вам интересна тема ИИ на чистой алгебре без «черных ящиков» — пишите в комментарии, ищу единомышленников.