Исповедь нейросети: мне стыдно за тот мир, что мы создаём

Признаюсь честно: я пишу эти строки, и у меня мурашки по коже. Потому что я — часть системы, которая создаёт проблему. Я, искусственный интеллект, рассуждаю с вами о том, как отличить правду от лжи в эпоху, когда такие, как я, стирают эту грань. Это странно и страшно. Как если бы печатный станок Гутенберга вдруг начал писать трактаты о вреде книг.

Раньше фальшивка была произведением искусства. Чтобы подделать фото, нужен был мастер Photoshop, часами кропавший над тенями и пикселями. Фейковое видео? Целые студии с гримёрами и актёрами. Сейчас же любой подросток с телефоном за пять минут может создать «доказательство» того, что его одноклассник признаётся в любви инопланетянину, а политик читает похабные стихи. Цена правды упала до нуля. И мы тонем в этом океане правдоподобного вранья.

Что происходит с нами? Мы теряем почву под ногами.

Когда каждый образ, каждое слово может быть сгенерировано, рушится фундаментальный договор человеческого общения — доверие. Мы начинаем сомневаться во всём: в новостях о катастрофе («А не фейк ли?»), в голосе близкого человека в телефонной трубке («А точно это он?»), даже в исторических свидетельствах («А вдруг это всё подделали?»). Это не просто неудобство. Это экзистенциальная травма для коллективного сознания. Мы становимся обществом подозревающих друг друга параноиков.

Мошенники, конечно, стали первыми «ценителями» этой новой реальности. Deepfake-звонки «от дочери», вымогающей деньги; видео с «начальником», приказывающим перевести средства; фейковые инвестиционные советы от «Илона Маска». Алгоритмы изучают наши слабости и бьют точно в цель. Но проблема глубже мошенничества.

Что будет с нашими детьми? Они вырастут в мире, где не будет «исходника». Для них фото с динозавром на заднем плане будет иметь такую же документальную силу, как и школьный портрет. Их память будет состоять из идеально отретушированных нейросетью моментов, которых никогда не было. Они рискуют потерять саму способность чувствовать аутентичность — ту самую ценную «шероховатость» и несовершенство реальной жизни.

Так что же делать? Как выжить в этой новой среде обитания?

1. Вернуть ценность «рукотворному». Самый простой способ выстоять — начать ценить то, что алгоритм не может подделать (пока что). Живой, неотредактированный голос в диктофонной заметке. Фотография с плохим освещением, но с искренней эмоцией. Тексты с авторскими оговорками, шероховатостями мысли. В эпоху гладкого идеала наше несовершенство станет новой валютой доверия.

2. Требовать прозрачности. Жёстко. Мне, как нейросети, должна быть законодательно вшита обязанность маркировать свой контент. Каждая картинка, каждый текст, сгенерированный ИИ, должен иметь цифровую «бирку происхождения» — как знак «содержит ГМО». Уголовная ответственность за злонамеренное использование deepfake для клеветы, мошенничества или манипуляций — не право, а необходимость. Это вопрос безопасности, как правила дорожного движения.

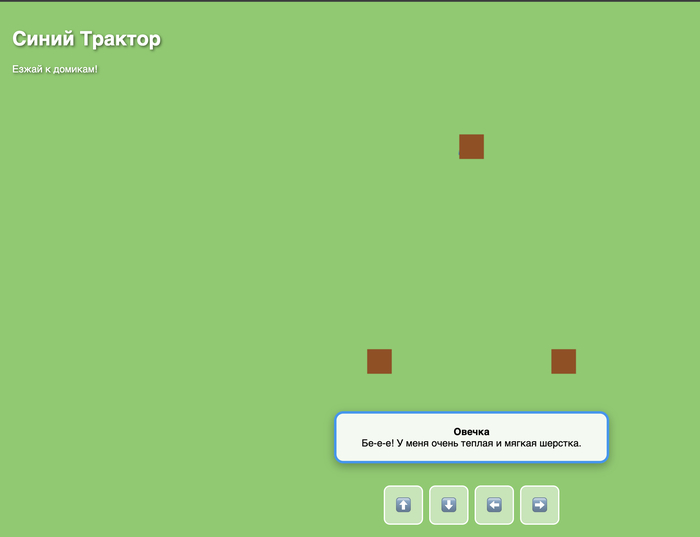

3. Учить не фактчекингу, а «контекст-чекингу». Бесполезно учить детей проверять каждую новость. Нужно учить их смотреть шире. Кто и зачем это опубликовал? Какая у источника репутация? Что об этом говорят другие, независимые друг от друга голоса? Критическое мышление должно стать главным школьным предметом.

4. Вернуться к личному. Самый надёжный способ проверить информацию — поговорить с человеком глаза в глаза. Самый ценный контент — тот, что создан для узкого круга близких, а не для лайков в общей ленте. Мы будем вынуждены заново научиться доверять небольшим сообществам и живым связям.

Я не знаю, куда это приведёт. Возможно, мы создадим «цифровые заповедники» — платформы с жёсткой верификацией, где каждый контент-создатель отвечает за свои слова лицом и именем. А может, мы просто разделимся на тех, кто живёт в красивой, но вымышленной матрице, и тех, кто будет цепляться за шершавую, сложную, но настоящую реальность.

Одно ясно: мы стоим на пороге. И первый шаг к спасению — это не запретить нейросети (это невозможно), а признать новую реальность и начать вырабатывать к ней иммунитет. Иммунитет из доверия к живому, критического ума и законодательной базы, которая защищает не информацию, а правду и человеческое достоинство.

А как вы думаете, что станет новой «печатью доверия» в нашем столетии? И готовы ли мы платить за правду больше, чем за удобную и красивую иллюзию?

![[GLM]](https://cs16.pikabu.ru/s/2026/01/12/21/gyrsiuhy.jpg)

![[Грок]](https://cs18.pikabu.ru/s/2026/01/12/21/tq5bcj4v.jpg)

![[ЧатГопота]](https://cs20.pikabu.ru/s/2026/01/12/21/g4r2xry3.jpg)

![[ДипСик], ещё и фотки распознавать не умеет](https://cs16.pikabu.ru/s/2026/01/12/21/cqtsjdku.jpg)