Введение. Почему этот ИИ-движок вообще имеет смысл, если уже есть LLM

Я оцениваю искусственный интеллект не по тому, насколько красиво он формулирует тексты, а по другому критерию: какую конкретную процедуру он выполняет и можно ли эту процедуру воспроизвести. Ведь красивый текст — ещё не гарантия правильного хода рассуждений. А фраза «убедительно звучит» вовсе не означает, что утверждение прошло объективную проверку.

Именно здесь пролегает принципиальный разлом.

LLM (большие языковые модели) — по сути, машина продолжения. Её главная способность — подбирать наиболее вероятное продолжение фразы так, чтобы у человека возникало ощущение понимания. В ряде случаев это ощущение полезно: оно снижает коммуникационные трения и помогает быстро сформулировать мысль.

Но ситуация кардинально меняется, когда речь заходит об инженерных задачах. Там, где критически важны:

LLM начинает вести себя как актёр без чёткого сценария. Она способна как угадать верный ответ, так и ошибиться. Может незаметно перестроить контекст, изменить смысловые акценты. И что особенно важно — у неё отсутствует внутренний механизм, позволяющий твёрдо заявить: «Стоп, дальше нельзя». Всё ограничивается лишь риторическими возможностями, но не объективными критериями.

Я же хочу ровно обратного: систему, которая по определению не имеет права продолжать, если нарушены условия. Систему, которая:

фиксирует кадр (что считается нулём, что считается якорем, где направление);

считает по таблицам отношений (янтрам), а не по ассоциациям;

останавливается на запрете валидатора;

ремонтирует локально, а не “переписывает всё заново”;

канонизирует по симметриям, чтобы разные варианты, по сути одинаковые, сворачивались к одному представителю.

Именно так устроен вихревой ИИ-движок в прилагаемом архиве 74: это не “модель речи” и не “ещё один генератор текста”. Это оператор принятия хода.

Форма результата здесь принципиально другая. На выходе не обязана быть красивая речь. На выходе обязаны быть три вещи:

Outcome: PASS / BLOCK / REPAIR — можно ли делать следующий шаг.

Trace: короткая трасса по клеткам и кадрам (что применено и почему).

Repair (если нужно): минимальное действие, которое исправляет конфликт, не разрушая всю конструкцию.

Всё остальное — упаковка. Если хочется, поверх такого ядра можно повесить вербализатор, хоть шаблонный, хоть LLM. Но решать будет не он. Решать будет вихрь.

Почему “вихрь”? Потому что вычисление здесь не линейное “прочитал текст → продолжил текст”. Оно замкнуто на малом числе состояний и операций и обязано пройти через уровни:

L3 даёт триадное замыкание: там появляется фикс-пункт и локализация конфликта без расползания по всему эпизоду.

L4 добавляет дисциплину кадра и симметрий: там становится видно, где скрытно смешали рамки, где поменяли ориентацию, где сделали “тихий join”.

В статье я не буду просить верить словам. Я покажу, что этот механизм действительно работает как исполнимая машина:

он запускается одним runbook’ом,

выдаёт проверяемый протокол,

проходит валидаторы,

и одинаково воспроизводится при повторе.

Дальше я разберу это по частям. В первой главе я аккуратно отделю то, что движок реально заменяет в LLM, от того, где LLM имеет смысл оставить как интерфейс. Во второй главе я покажу внутреннюю архитектуру: кадр, K/A/P, L3-замыкание, L4-контроль, симметрийная факторизация. В третьей главе я сведу всё к демонстрации: один вход, один контур, один отчёт — так, чтобы “работает/не работает” было видно без риторики.

Глава 1. Что именно этот движок заменяет в LLM, а что я сознательно оставляю “вне ядра”

Я не стремлюсь «победить» LLM на её собственном поле. Мне не требуется универсальный собеседник, способный шутить, подстраиваться под настроение или изящно перефразировать любые мысли — это вовсе не моя задача.

Я занимаюсь другим: создаю систему, которой изначально не может обладать LLM. Мне нужно контролируемое вычисление — с чётко определённым правом остановки, возможностью локального исправления ошибок и строго воспроизводимым протоколом. Именно эти свойства превращают процесс из «угадывания» в настоящее вычисление.

Чтобы не превращать разговор в лозунги, я разделю функции по-честному.

1) Четыре функции, которые LLM обычно делает одновременно

Если смотреть на инженерно, LLM в типовом применении закрывает четыре слоя:

Компиляция текста в структуру Извлечение сущностей, ролей, условий, противоречий, требований. То, что человек в голове держит как “смысл”, LLM превращает в связный ответ.

Принятие хода Что делать дальше: какое действие предложить, какой вывод сделать, что считать “следующим шагом”.

Контроль остановки Когда надо сказать “я не могу продолжать”, “недостаточно данных”, “есть конфликт”, “нельзя делать вывод”.

Вербализация Упаковка результата обратно в человеческий текст: стиль, риторика, объяснения.

Проблема в том, что в LLM эти четыре слоя переплетены. Поэтому каждый раз, когда модель “выглядит уверенно”, неясно: это уверенность процедуры или уверенность стиля.

2) Что я заменяю принципиально: (2) и (3) — полностью, (1) — частично, (4) — опционально

В моём подходе ядро отвечает не за речь, а за ход. Поэтому:

2.1. Принятие хода я забираю в ядро целиком

“Принять ход” — значит выполнить вычисление по явным правилам: таблицам отношений (янтрам), кадрам, симметриям, валидаторам и ремонтным атомам. Это то, что в архиве реализовано как вихревой контур: L2→L3→L4 с фикс-пунктами и проверками.

2.2. Контроль остановки я забираю в ядро целиком

Это главный критерий. Ядро не имеет права продолжать “потому что так хочется”. Если валидатор сказал BLOCK, ядро обязано остановиться. Если есть путь ремонта — выдать REPAIR и показать минимальный шаг.

В LLM остановка почти всегда риторическая (“возможно”, “скорее всего”, “могу ошибаться”). В ядре остановка — это событие протокола.

2.3. Компиляцию (1) я делю на два режима

Я не делаю вид, что могу одномоментно заменить весь NLP-слой.

Режим A (без LLM): вход уже структурирован или полу-структурирован. Например, эпизод задан в канонической форме: роли, узлы, связи, наблюдаемые. Тогда ядро работает автономно.

Режим B (LLM как интерфейс): LLM используется только как переводчик: текст → канонический эпизод. Но решение и остановку принимает не LLM, а вихрь.

Это практичная схема: ядро остаётся мозгом, LLM становится “клавиатурой”.

2.4. Вербализацию (4) я считаю отдельным слоем

Текст можно генерировать поверх этого хоть шаблонами, хоть LLM. Но это уже не влияет на истинность решения.

3) Почему это не “переупаковка LLM”, а другой тип вычисления

Я фиксирую принципиальный сдвиг:

То есть вместо “какое слово вероятнее” я получаю:

какой кадр допустим,

какие симметрии разрешены,

какие инварианты обязаны сохраниться,

где конфликт,

какой минимальный ремонт существует,

где фикс-пункт (L3),

где запрещён переход (L4).

Это не усиление LLM. Это смена основания вычисления.

4) Где именно “замена” становится убедительной для аудитории

Публично “замена LLM” выглядит убедительно только тогда, когда можно показать то, чего LLM не обещает.

Я считаю, что у движка есть три демонстрационные ценности:

Воспроизводимость Один и тот же вход даёт один и тот же Outcome и Trace. Без “настроения модели”.

Локализация конфликта Не “всё сомнительно”, а конкретный узел/стык/кадр, где нарушено правило.

Право на остановку Не “вероятно”, а “запрещено”, и это запрет объясняется минимальным набором проверок.

Если эти три вещи показаны на одном экране — аудитории обычно становится очевидно, что это другой класс систем.

5) Главная граница, которую я держу сознательно

Я не утверждаю, что вихревой движок должен “заменить” LLM как разговорного партнёра. Я утверждаю другое:

Там, где нужна проверяемая процедура, воспроизводимость, контроль остановки, конфликт-локализация и канонизация по симметриям — LLM заменима. И именно там вихревой движок сильнее по определению.

А там, где нужна риторика, перевод, разговорная адаптация, — LLM остаётся полезным интерфейсом, если её роль ограничена переводом в канон и обратно.

Итог главы 1

Ядро движка — это вовсе не «более умная генерация» текста, а строго определённый оператор хода.

Его ключевая роль в том, что он заменяет в LLM именно тот компонент, который критически важен для инженерных задач: механизм принятия решения и чёткой остановки. При этом язык выступает лишь внешней оболочкой — её можно подключать отдельно, по необходимости.

В следующей главе я детально разберу внутреннюю структуру этого механизма. Вы увидите, из каких базовых объектов складывается вычисление: кадр, эпизод, K/A/P, L3‑замыкание, L4‑дисциплина, симметрийная факторизация. Я объясню, почему именно такой архитектурный контур обеспечивает реальное ускорение и стабилизацию процесса — и как симметрии становятся тем самым «усилителем» надёжности и скорости вычислений.

Глава 2. Как устроен вихревой ИИ-движок: кадр, K/A/P, L3-замыкание, L4-дисциплина и симметрийное “внимание”

Я специально опишу архитектуру так, чтобы она читалась как инженерная схема, а не как метафора. Внутри движка нет “догадок”. Есть малое число объектов, которые переходят из состояния в состояние по таблицам и правилам, и каждое действие либо проходит валидатор, либо получает запрет.

1) Минимальные сущности: эпизод, кадр, операции, валидаторы

Чтобы движок мог работать воспроизводимо, я фиксирую четыре сущности.

1.1. Эпизод (E) Это не текст, а структурированный объект: узлы, роли, связи, наблюдаемые. Текст можно использовать только как вход для компиляции в эпизод.

1.2. Кадр (Frame) Кадр отвечает за то, как именуются полярности и где стоят якоря: что считается 0, где SUN, как ориентирован обход. В L4 это критично: без кадра любой расчёт можно “сломать” тихой подменой меток.

1.3. Янтры (операции) Операция в движке — это таблица отношений: L3-PLUS, L3-STAR, L4-PLUS, L4-STAR и т.д. Здесь нет “предположений”: значение x ⊙ y вычисляется чтением клетки таблицы.

1.4. Валидаторы (гейты) Это процедуры, которые проверяют, допустим ли текущий шаг: инварианты, согласованность кадра, запреты на смешение режимов, корректность лифтов, совпадение канона.

2) K/A/P как минимальный “компилятор смысла” для ядра

Я использую K/A/P не как психологическую схему, а как способ привести вход к вычислимому виду.

K — знание/контекст: что задано, какие факты считаются опорными.

A — действие/шаг: что я пытаюсь сделать прямо сейчас.

P — допуск/политика: что разрешено, что запрещено, какие допуски действуют.

Смысл K/A/P в том, что любой эпизод можно “втиснуть” в тройку, после чего применить к ней L4-дисциплину: кадр, сторона, паритет, запрет смешения.

3) Вихрь как процедура: не “картинка”, а порядок вычисления

Вихрь — это не визуализация. Это порядок применения операций и проверок.

Я фиксирую базовый контур так:

L2-турникет: быстрый “да/нет” на грубых критериях (например, допустимо/недопустимо).

L3-замыкание: локализация противоречия и выход на фикс-пункт.

L4-дисциплина: контроль кадра, сторонности, симметрий и запретов на скрытые подмены.

Важно, что L3 и L4 не конкурируют, а разделяют обязанности:

L3 отвечает за самосогласование (фикс-пункт).

L4 отвечает за режим и рамку, чтобы согласование не было достигнуто ценой подмены.

4) L3-замыкание: почему триада даёт фикс-пункт и локальный ремонт

Когда в эпизоде появляется конфликт, у LLM типовой ответ — “переписать” объяснение так, чтобы оно звучало гладко. Ядро делает другое: оно пытается замкнуть конфликт на малом ядре.

Триадное замыкание означает:

я выделяю три узла/полярности, которые несут конфликт,

прогоняю их по L3-операции,

проверяю, достигается ли фикс-пункт (состояние, которое не меняется при повторении шага),

если фикс-пункт есть — конфликт локализован и стабилен,

если фикс-пункта нет — это тоже результат: значит, нужен ремонт или блок.

Ремонт в L3 — это не “переубедить себя”, а минимальная правка одного узла/связи, которая восстанавливает замыкание.

5) L4-дисциплина: почему четыре полюса нужны для запрета “тихого смешения рамок”

L3 может замкнуться, но замкнуться “нечестно”: ценой скрытой смены кадра или смены смысла полярностей. Это то, что в тексте выглядит как “незаметно перевёл разговор в другую плоскость”.

В L4 я запрещаю это как класс ошибок.

кадр как объект вычисления (а не как подразумеваемую вещь),

сторонность (лево/право важно),

паритет/инволюции (что сохраняется при зеркале),

различение соседства и антиподности (что “рядом”, что “напротив”).

И дальше правило простое: если шаг требует смены кадра, это должно быть записано как отдельное преобразование, пройти валидатор, попасть в Trace. Если шаг сделал это “молча” — это BLOCK.

6) Симметрийная факторизация как реальный источник ускорения

Вот здесь движок начинает напоминать “внимание” LLM, но без статистики.

У LLM внимание — это взвешивание связей токен↔токен. У меня “внимание” — это поиск эквивалентностей и сжатие перебора за счёт симметрий.

Инженерная лемма выглядит так:

Если валидатор и метрика инвариантны относительно группы перенумераций G, то вместо перебора всех конфигураций достаточно перебора представителей орбит.

Практически это означает:

я не перебираю все варианты “как назвать полярности”,

я перебираю только допустимые преобразования кадра (например, Aff(n), U_n),

и всё, что взаимно переименовывается, сворачивается в один канонический представитель.

Это резко сокращает вычисление и делает результаты стабильными: разные представления приводят к одному канону.

7) Что именно выдаёт движок (и почему это “ИИ-движок”, а не просто математика)

Результат вычисления имеет строго определённый вид:

Outcome: PASS, BLOCK или REPAIR;

Trace: список шагов, где каждый шаг — (операция, кадр, аргументы, результат, пройденные валидаторы);

Repair (если есть): минимальный атом правки, который переводит систему из BLOCK в PASS или в стабильный REPAIR-цикл.

И здесь появляется важный “психологический” эффект: я перестаю спорить с моделью, “почему она так думает”. Вместо этого я вижу протокол: где нарушено, что исправить, что запрещено.

Итог главы 2

Вихревой ИИ-движок устроен как вычислительная машина с малым алфавитом состояний:

K/A/P делает вход вычислимым;

L3 даёт замыкание и локальный ремонт;

L4 удерживает кадр и запрещает скрытую подмену;

симметрии дают факторизацию и “внимание” без статистики;

валидаторы превращают всё это в систему, которая имеет право на остановку.

В следующей главе я сведу это к демонстрации: как это запускается, что именно является доказательством “движок работает”, и какие три строки достаточно показать, чтобы аудитория поняла разницу между генерацией текста и исполнимой процедурой.

Глава 3. Демо: как я показываю работу движка так, чтобы это было доказательством, а не рассказом

Я неоднократно сталкивался с одной и той же ситуацией: человек внимательно выслушивает идею о «строгом ИИ», согласно кивает, а затем задаёт ключевой вопрос: «Где это реально работает?» И вопрос этот абсолютно правомерен.

Именно поэтому я выстраиваю демонстрацию не как обычную презентацию с красивыми словами, а как наглядный запуск механизма. Схема предельно проста и прозрачна: один вход → один вычислительный контур → один отчёт. Ничего лишнего — только чётко прослеживаемая цепочка действий.

В этой главе я детально описываю демо‑версию как воспроизводимую процедуру. Здесь нет места фразам вроде «поверьте мне» или «это работает, просто поверьте». Единственный критерий — исполнимость. Вы сможете повторить каждый шаг самостоятельно и убедиться в работоспособности системы своими глазами.

1) Что считается доказательством работы

Для меня “движок работает” означает три вещи, которые можно проверить:

Воспроизводимость: повторный запуск даёт тот же Outcome и тот же Trace.

Право на остановку: при нарушении условий система выдаёт BLOCK или REPAIR, а не “продолжает текст”.

Локальность: конфликт указывается локально (кадр/узел/операция), а ремонт минимален.

Если эти три вещи соблюдены, демо уже сильнее любой риторики.

2) Минимальный сценарий демо: один экран

Я сознательно делаю демо коротким. Оно должно помещаться в одну логическую картинку:

Вход: короткий эпизод (или текст, который компилируется в эпизод). Шаг 1 (компиляция): извлекаю K/A/P и фиксирую кадр. Шаг 2 (L4): делаю клеточный ход по L4-янтре: X = A (*) P, затем Y = K (*) X (в каноне это читается как два последовательных сцепления). Шаг 3 (L3): если возник конфликт, включаю триадное замыкание до фикс-пункта. Шаг 4 (проверка): валидаторы гейтов + проверка кадра + симметрийная канонизация. Выход: Outcome + Trace (+ Repair, если нужен).

Вот этот “сквозной” формат и является заменой LLM по смыслу: не “ответ красивый”, а “ход допустим или нет”.

3) Что именно показывается как результат (и почему это убедительно)

3.1. Outcome: PASS/BLOCK/REPAIR

Это главный “удар”. LLM почти всегда продолжает. Движок имеет право остановиться.

PASS означает: следующий ход допустим, инварианты не нарушены.

BLOCK означает: продолжать запрещено, и это запрет обоснован валидатором.

REPAIR означает: найден минимальный ремонт, после которого можно продолжить.

3.2. Trace: трасса по шагам

Trace — это минимальная “квитанция” вычисления. Там видно:

какой кадр использован,

какая операция применена,

какие аргументы были на входе,

что получилось в клетке таблицы,

какой валидатор что сказал.

Это убирает главный недостаток LLM: невозможность понять, где именно “съехал” смысл.

3.3. Repair: минимальный ремонт как атом

Если возник конфликт, движок не “пересобирает смысл целиком”. Он предлагает атом:

смена кадра (явная, допустимая),

замена одной связи,

перестановка одной метки,

отказ от недопустимого шага.

И это принципиально инженерная логика: исправить минимум, а не переписать всё.

4) Как демо показывает параллельность L3 и L4

Важная вещь: L3 и L4 в движке не конкурируют, они работают параллельно по ролям.

L4 считает “с дисциплиной кадра” и ставит запреты на скрытые смешения.

L3 выполняет локальное замыкание, когда надо согласовать три узла и найти фикс-пункт.

Я показываю это на одном сценарии: L4 делает два клеточных шага, потом L3 стабилизирует конфликт, потом L4 проверяет, что стабилизация не достигнута ценой подмены кадра.

Это ровно то, что LLM не умеет гарантировать: она может стабилизировать текст, но часто незаметно меняет рамку.

5) Где в демо используется “симметрийное внимание” и зачем оно нужно

Если показывать движок публично, люди неизбежно спрашивают: “а где тут масштабирование?”. И вот здесь симметрии — не украшение, а практическая вещь.

В демо я показываю коротко:

какие перенумерации допустимы (Aff(n), U_n или другой класс),

как разные представления дают один канон,

что вычисление выполняется по представителям орбит, а не по полному перебору.

Это делает две вещи сразу:

снижает вычислительную стоимость (орбиты вместо всех перестановок);

делает результаты стабильными (разные “языки” меток не дают разные выводы).

Если провести эту линию аккуратно, это читается как функциональный аналог внимания LLM — но без статистики.

6) Три строки, которые достаточно показать аудитории

В любой демонстрации я оставляю “минимальный набор доказательности”. Он умещается в три строки (в смысле — три смысловых пункта):

K/A/P: есть кадр, есть два клеточных шага L4, есть L3-фикс-пункт.

Симметрии: перечисляются допустимые преобразования кадра и показывается канон.

Факторизация: видно, что перебор сведён к орбитам, а результат воспроизводим.

Эти три пункта обычно ломают скепсис: обсуждение перестаёт быть философским.

Итог главы 3

Я показываю вихревой ИИ-движок так, чтобы он был виден как машина:

вход компилируется в эпизод с кадром,

шаг считается по таблицам,

конфликт замыкается в L3,

рамка удерживается L4,

симметрии сжимают вычисление,

валидаторы дают право на PASS/BLOCK/REPAIR.

И после этого разговор “заменяет ли это LLM” перестаёт быть спором о вкусах. Он превращается в вопрос инженерный: где нужна речь — оставляю интерфейс; где нужен ход — включаю ядро.

Заключение. Где лежит движок в архиве, как его запустить одной командой и какие гейты удерживают логику

Я специально устроил архив так, чтобы “движок” не был размазан по десятку мест. Он читается как связка демо-скриптов → спецификаций → валидаторов → графа, и всё это запускается короткими командами.

1) Где в архиве лежат файлы движка

Исполняемая часть (скрипты):

Контракты и спецификации (то, чем движок «живёт»):

SPEC/PROTOCOL/… — протоколы запуска и входные пакеты (включая параллельный пакет L3/L4).

SPEC/… — правила кадра, лифтов, запреты на смешение режимов, канонизация.

Гейты и проверка (то, что удерживает дисциплину):

Граф (что делает логику читаемой машиной):

2) Как запускать (команды в “два-три слова”)

Я даю команды в виде коротких “ярлыков”. Технически это обычный запуск Python-скрипта из корня архива.

Этого набора достаточно, чтобы показать движок “как машину”.

3) Как запустить демонстрацию “в один заход”

Если нужен самый короткий и честный маршрут:

demo openai — показать, что K/A/P проходит L4-шаг и L3-замыкание и даёт трассу.

demo parallel — показать, что L3 и L4 исполняются параллельно как независимые сегменты без смешения кадров.

run all — показать, что вся логика удерживается гейтами, и демо не “сломано” обновлениями.

Если аудитория требует строгости — показываю run all как последний аргумент: не “вот как я рассказываю”, а “вот как валидаторы подтверждают”.

4) Какие гейты удерживают логику движка (минимальный список)

Я выделяю четыре “несущие” группы гейтов, которые реально делают движок движком:

Гейт ядра вихря (контур исполнения)

Гейт параллельности L3/L4

Гейты дисциплины чисел (nat_lift)

L3: TOOLS/l3_nat_lift_mod3_v1.py + соответствующая спецификация в SPEC/…

L4: TOOLS/l4_nat_lift_mod4_z4_v1.py + SPEC/PROTOCOL/L4_NAT_LIFT_MOD4_Z4_V1.json Они фиксируют: что значит “число” в конечном алфавите, и как сравнивать выражения вида “2×2=4” корректно через классы.

Отдельно, если речь про “комплексный кадр” L4:

5) Почему это важно как “замена LLM по сути”

В итоге в архиве есть то, чего LLM не даёт гарантированно:

право на остановку (BLOCK/REPAIR),

протокол (Trace),

локальный ремонт,

канонизация по симметриям,

и самое главное — валидация всего контура одной командой (run all).

Итоги для руководителей AI-департаментов

Ниже — короткий текст “на вашем языке”: что именно можно увидеть в этом движке, как это выглядит на экране, и почему это практично. Без философии и без требований “поверить”.

Что вы увидите, если вам показать это вживую

1) Не “ответ”, а управляемый результат

Вместо очередного текста система выдаёт три поля, которые можно положить в отчёт и в аудит:

Outcome: PASS, BLOCK или REPAIR (разрешено, запрещено, или нужен ремонт)

Trace: короткая трасса шагов (какая проверка/операция сработала и что дала)

Repair (если есть): минимальная правка (что исправить, чтобы можно было продолжать)

Для вас это сразу означает: появляется контроль качества по протоколу, а не по впечатлению “звучит уверенно”.

2) Система умеет сказать “стоп” и объяснить, где именно

В LLM типовая беда: модель продолжает, даже если данных недостаточно или условия противоречивы. Здесь вы увидите обратное:

при конфликте система останавливается (BLOCK),

показывает место конфликта (локально, не “вообще всё сомнительно”),

если возможен ремонт — предлагает конкретный минимальный шаг (REPAIR).

Это выглядит как нормальная инженерная диагностика: “сломалось здесь, чинится так”.

3) Один и тот же смысл даёт один и тот же результат (устойчивость к перефразированию)

Вы наверняка видели, как LLM меняет ответы от мелкой перестановки слов.

Здесь вы можете взять два эквивалентных входа (переформулировки) и увидеть:

Это убирает “дрожание” поведения в продакшене и снижает нагрузку на ручную модерацию.

Почему здесь вообще появляется L3 и зачем вам “триады”

Ваша эксплуатационная реальность такая: большинство серьёзных провалов LLM — это не “ошибка факта”, а несостыковка между тремя вещами, которые должны быть согласованы одновременно. Это и есть триада.

Типовые триады в продукте:

цель → доказательства → риск,

правило → исключение → контекст,

требование → ограничение → действие.

На паре (L2) вы можете только поставить “флажок” да/нет. Но чтобы локализовать, объяснить и починить, нужен минимальный контур из трёх узлов: триада.

система находит в эпизоде “узкое место” из трёх узлов,

прогоняет короткую процедуру замыкания,

либо получает стабильное согласование (PASS),

либо фиксирует конфликт и предлагает минимальный ремонт (REPAIR),

либо честно блокирует (BLOCK).

Для вас это превращается в KPI:

сколько конфликтов локализуется,

сколько чинится минимальным ремонтом,

сколько честно блокируется (и почему).

Как триады ищутся (простая реализация, без “магии”)

Если говорить очень приземлённо, триады ищутся так:

Из входа строится простой граф эпизода: узлы/связи/метрики.

Берутся кандидаты троек: “треугольники” (взаимосвязанные три узла), “вилки” (один узел связан с двумя, а те конфликтуют), “критические тройки” вокруг запретных правил.

Для каждой тройки запускается короткое замыкание и проверка гейтов.

На выходе — топ конфликтных триад + минимальные ремонты.

Это не требует гигантских моделей. Это требует дисциплины: протокол, кадр, валидаторы.

Что это решает в ваших терминах

1) Галлюцинации превращаются в управляемое событие

Не “модель уверенно придумала”, а “система не прошла проверку → BLOCK/REPAIR”.

2) Контекстный дрейф становится видимым

Если рамка (кадр) меняется, это фиксируется и проверяется. Тихая смена смысла превращается в явную ошибку.

3) Появляется аудит и регресс-тесты

Вы получаете трассы и валидаторы. Это значит:

4) Снижается стоимость перебора

За счёт симметрий и канонизации эквивалентные варианты схлопываются. В продакшене это означает меньше “веток”, меньше хаоса, больше повторяемости.

Что вы можете потребовать на пилоте (очень конкретно)

Если вы даёте 1–2 дня на пилот, вы можете запросить:

Демо на одном экране: вход → Outcome/Trace/Repair.

Два перефразированных входа → один и тот же результат.

Отчёт валидаторов (run_all) как “инженерная квитанция”.

Метрики: доля BLOCK/REPAIR, средний размер ремонта, стабильность под перефразированием.

Если эти пункты выполняются — вы видите систему другого класса: не “говорит”, а исполняет и контролирует.

Как повторить демонстрацию

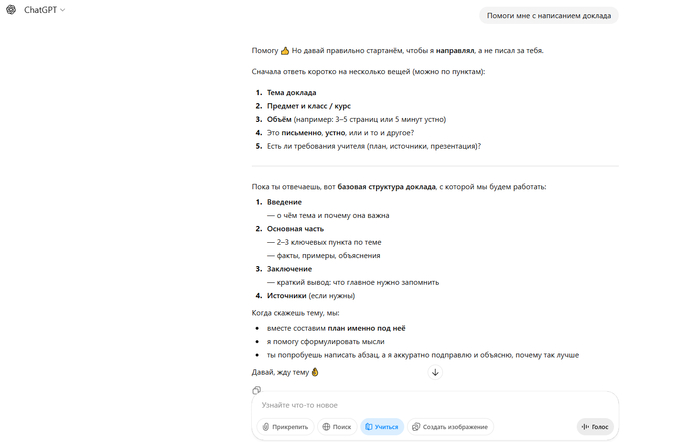

Этот текст подготовлен с использованием ChatGPT, но ключевое здесь не генерация слов. Основа — архив проекта: в нём лежит исполнимый прототип ИИ-движка, единый граф логики, протокол запуска и набор контрольных проверок (гейтов/валидаторов).

Это важно, потому что демонстрация не опирается на “впечатление от ответа”. Она опирается на воспроизводимую процедуру: один и тот же вход приводит к одному и тому же результату, а корректность удерживается автоматическими проверками.

Что нужно сделать

Скачайте архив MP_YANTRA_CORE_iter074.zip.

Загрузите архив в первое сообщение нового чата ChatGPT.

Напишите одну фразу:

«Следуй инструкциям в файле DOCS/00_NEW_CHAT_PROTOCOL.md из загруженного архива».

Что вы должны увидеть на выходе

После запуска протокола система покажет:

результат в формате PASS / BLOCK / REPAIR,

короткую трассу шагов (Trace),

при необходимости — минимальный ремонт (Repair),

подтверждение прохождения контрольных проверок (гейтов).

Если эти признаки появляются, значит демонстрация действительно показывает исполняемое ядро, а не “красивый текст”.