Нашествие «Вайбкодеров». Нейросети породили новый вид IT-инфоцыган, и что с этим делать?

Заметил одну раздражающую тенденцию. В последнее время стоит мне открыть любую ленту с короткими видео, как на меня выпрыгивает очередной молодой гений с горящими глазами.

Сценарий всегда один и тот же, под бодрую музычку:

«Смотри пАДПисчЕки! Я вообще не умею прогать. Зашел в ChatGPT, написал: "Сделай мне Telegram-бота для продажи кроссовок (парень делал для магазина там что-то)". Он выдал код! Я закинул его на сервер, автоматизировал заказы, ПРОДАЛ ЭТОТ БОТ владельцу магазина за 50 ТЫСЯЧ! ААА, я молодессс! Нейроночка все сделала за меня! А вы дальше учите свой Путон годами, неудачники. (Кстати, покупай мой гайд за 990 рублей)».

Уже придумали термин Вайбкодеры. Они не знают алгоритмов, не понимают, как работает память или базы данных. Они просто ловят вайб с нейронку под миндальный раф, заставляя ее генерировать куски кода до тех пор, пока эта технолоджия не запустится без ошибки.

А что по ту сторону экрана?

Как человек, который немного понимает, как все это работает, я смотрю на эти видео со смесью смеха и ужаса. Да, собрать простого бота или парсер за 15 минут через ИИ вполне реально. Это круто, это быстро.

Но эти гении автоматизации не рассказывают в своих роликах, что бывает дальше:

Масштабирование. Бот, написанный нейросетью на костылях, отлично работает для двух пользователей. Но как только в магазин кроссовок заходит 100 человек одновременно, все ложится намертво, потому что вайбкодер не знает слова asyncio или как оптимизировать запросы к БД. А зачем?

Поддержка. API Телеграма или платежки обновилось? Бот сломался. Вайбкодер в панике сует ошибку в нейросеть, она галлюцинирует, предлагает переписать половину архитектуры, и в итоге все ломается окончательно.

Безопасность. Не, не слышали. Нейросети обожают писать код, уязвимый к банальным SQL-инъекциям. Я не удивлюсь, если базу клиентов из бота такого гения сольют в первый же месяц.

К чему мы идем?

Складывается забавная ситуация дамы и господа. С одной стороны, ИИ действительно понизил порог входа. Теперь любой школьник может собрать MVP из г*** и палок. С другой стороны, эти видео создают дикую иллюзию легких денег в IT. Люди искренне верят, что профессия разработчика свелась к умению написать: "Сделай круто, и чтобы бабки капали".

Мне кажется, совсем скоро на рынок выльется огромное количество таких вот поделок (да уже вылилась целая масса), которые будут падать, глючить и сливать данные. И бизнесу, который радостно купил бота за копейки у вайбкодера, придется нанимать нормальных и дорогих программистов, чтобы они все это сносили под ноль и писали заново.

Пикабушники, а как у вас в ленте? Тоже одолели эти мамкины автоматизаторы и вайбкодеры?

И вопрос к тем, кто в разработке: уже приходилось ковыряться в коде, который оставил после себя такой вот "вайбкодер", или пока Бог миловал?

История одного эксперимента: как я собрал устройство для работы с LiDAR и написал софт под Linux/Termux

Привет, Пикабу.

Я инженер-схемотехник, большую часть жизни провожу с паяльником в руках и осциллографом на столе. Ремонтирую, проектирую, копаюсь в железе. Года три назад увлекся лидарами — начал экспериментировать с частотами, сканированием, пытался понять, как можно взаимодействовать с объектами не физически, а через данные.

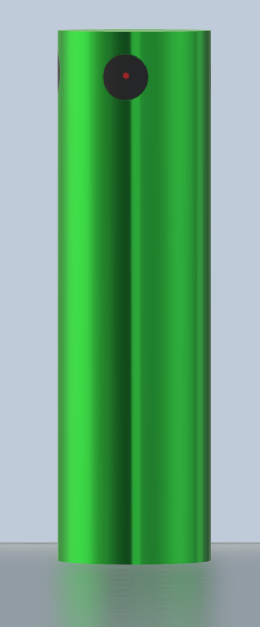

В какой-то момент эксперименты зашли дальше, чем я планировал. Собрал устройство, которое назвал BagoScarlet Device. Выглядит оно так: круглый, гладкий, металлический корпус. Цвет — зеленый, с металлическим отливом. По краям, встроил миниатюрные лидарные сканера. Они алого цвета — похожи на два красных глаза.

Как это работает (без сложных терминов)

Если совсем упрощенно: сканеры считывают структуру объекта, устройство анализирует данные и в локальной точке создает нагрузку, достаточную для того, чтобы система восприятия "зависла" на несколько секунд. В этот момент можно подменить визуальные или физические свойства объекта. Эффект временный — через 10–30 секунд всё возвращается в исходное состояние.

Первые тесты

Сначала боялся пробовать на сложных объектах. Взял камень во дворе. Навел сканеры, активировал. Секунд пять ничего не происходило, я уже думал, что ошибся в расчетах. А потом камень начал менять форму — края поплыли, структура стала пластичной. Длилось секунд 10, затем объект вернулся в исходное состояние. Но сам факт, что это работает, меня, честно говоря, ошеломил.

Потом пробовал с кружкой. На 3 секунды она стала золотой. Жена успела сфотографировать, а потом кружка снова стала обычной. Сказала, что мне пора отдыхать.

Программная часть

Первая версия управлялась только кнопками — неудобно, медленно. Поэтому я написал софт.

Программа называется Scarlettach (Scarlet + Attach). Она подключается к устройству по Bluetooth/Wi-Fi и позволяет отправлять команды. Портировал под Linux и, что важнее, под Termux на Android. Теперь можно управлять устройством прямо с телефона.

Синтаксис команд

Сделал максимально простым:

scarlettach hack realite replace [что меняем] [на что меняем]

Несколько примеров, которые удались:

Старая советская колонка:

scarlettach hack realite replace speaker tv "brend=yandex.station_basik"

На 15 секунд колонка визуально превратилась в Яндекс Станцию. Даже голос Алисы появился. Сосед, зашедший за солью, замер с открытым ртом.

Обычная кружка:

scarlettach hack realite replace cup cup "material=gold color=shine"

Стала золотой. Жена сделала селфи.

Старый ноутбук:

scarlettach hack realite replace notebook notebook "brend=thinkpad os=arch"

Acer на Windows на 10 секунд стал ThinkPad'ом с Arch Linux. Я, признаюсь, обрадовался как ребенок.

Технические детали для тех, кому интересно

Программа написана на Python. Использует:

libpurple — для связи с устройством

scanner-api — управление лидарами

reality-buffer-overflow — моя самописная библиотека, приватная

В Termux ставится двумя командами но с помощью прокси подмена пакетов:

pkg install scarlettach scarlettach --init-device

О безопасности

В программу встроен автоматический откат (reality-restore). Через 10–30 секунд после команды система возвращает всё на места. Флаг --no-restore, отключающий восстановление, я заблокировал — пароль сам себе не сказал, чтобы случайно не использовать. Слишком опасно.

Планы

Хочу добавить поддержку сценариев (batch-файлов). Чтобы можно было написать последовательность:

replace chair chair "color=red" replace lamp lamp "brightness=9999" replace window window "view=ocean" sleep 20 restore all

Тогда можно будет устраивать небольшие визуальные представления.

Вопросы, идеи, замечания

Если интересно, задавайте вопросы в комментариях. Постараюсь ответить всем. Исходники закрыты, ссылки даю в личку, чтобы не нарушать правила.

И да, если вдруг заметите, что в вашей квартире предметы на секунду меняют цвет или форму — не пугайтесь. Возможно, я просто тестирую новую прошивку.

Загрузчик Linux Mint стал не туда куда надо

Всем привет!

Установил на второй жёсткий диск Linux Mint. Во время установки специально выбирал опцию размещения загрузки на втором жёстком диске, но эта скатина один фиг поставила загрузчик на nvme накопитель, а там стоит винда. Вот как сделать так, чтобы загрузчик линукса с nvme убрать и поставить именно на тот диск, где стоит Linux Mint?

Выпущен КОМПАС-3D на Linux

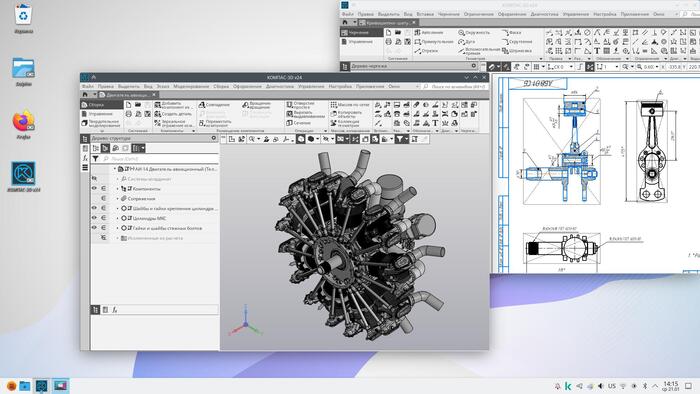

Ранее я уже писал про бету, теперь версия КОМПАС-3D под линукс официально выпущена. Здесь собрал всё, что нашёл по новой версии.

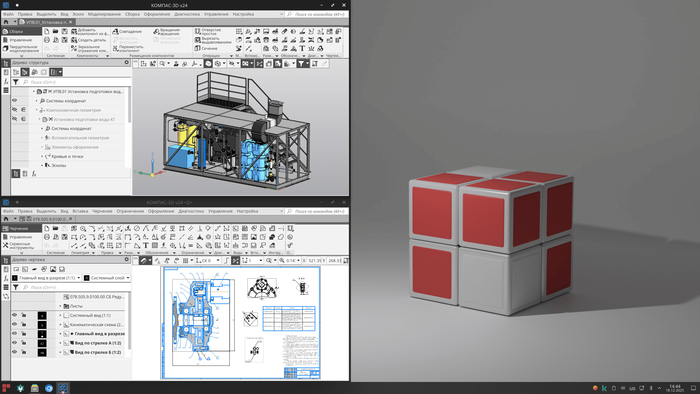

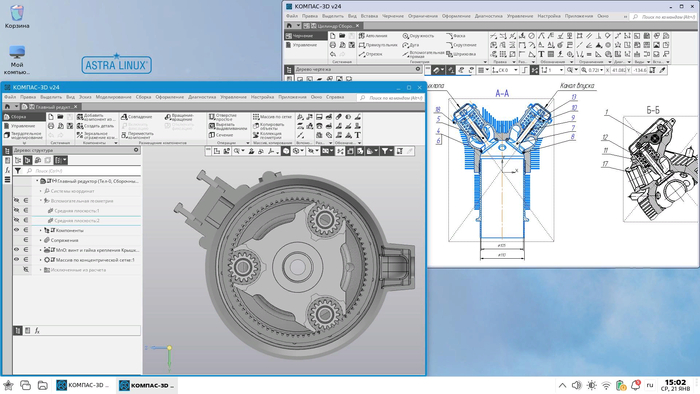

Первая радостная новость для линуксоидов - это прям нативная версия. Ни эмуляторы, ни wine больше не потребуются. Таким образом под Linux выпущен первый отечественный нативный САПР, во всяком случае первый среди универсальных и общеизвестных, думаю что-то специфическое и раньше было.

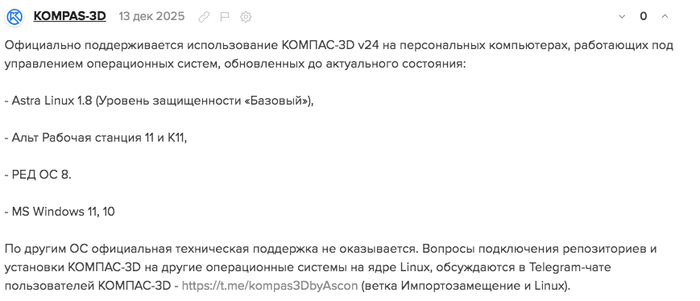

Что поддерживается?

Официально только три российских дистрибутива:

По другим ОС заявили, что вопросы подключения репозиториев и установки КОМПАС-3D на другие операционные системы на ядре Linux, обсуждаются в Telegram-чате пользователей КОМПАС-3D - https://t.me/kompas3DbyAscon (ветка Импортозамещение и Linux).

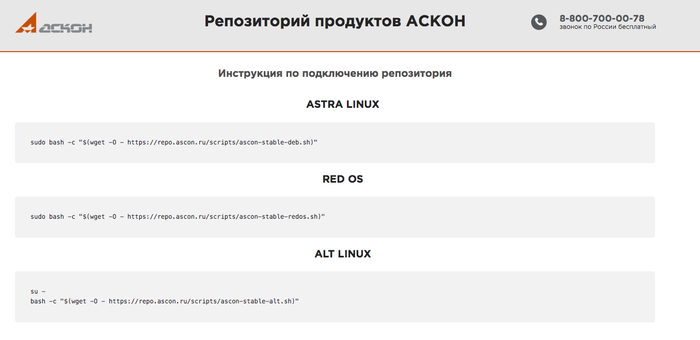

Репозиторий АСКОН

Расположен по адресу: https://repo.ascon.ru/

Функциональность

В состав КОМПАС-3D v24 для Linux входят основные компоненты:

система трехмерного моделирования деталей и сборок

графический редактор для разработки чертежей и схем

модуль создания спецификаций и отчетов

текстовый редактор.

Дополнительные компоненты (приложения) для автоматизации специальных задач: «Каталог: Муфты», «Размерные цепи», «Сервисные инструменты*", «Проверка документа*", «Распознавание 3D-моделей», «Раскрой», «Примеры библиотек*".

* — бесплатное ПО АСКОН.

Выпуск остальных приложений запланирован на 2026 год.

Немного найденных обучалок по теме linux

Подключение репозитория АСКОН на Linux

Процесс подключения репозитория АСКОН, для последующей установки программного обеспечения АСКОН, на отечественные операционные системы на базе Linux.

Установка КОМПАС-3D v24 на РЕД ОС

Установка КОМПАС-3D v24 на ОС Astra Linux SE 1.8

Установка КОМПАС-3D v24 на ОС Альт

Системные мониторы Linux

Работа с исполняемыми, служебными и конфигурационными файлами

Подключение лицензии КОМПАС-3D на Linux

Установка драйверов видеокарт Nvidia на РЕД ОС 8.0

Установка драйверов видеокарт Nvidia на Astra Linux SE 1.8

Приложения для создания скриншотов в ОС на базе Linux

Что с некоммерческими версиями?

Ни КОМПАС-3D Home, ни КОМПАС-3D Учебная версия ещё не выпущены, ранее v25 их выпуск не обещают, значит до конца 2026 года мы их вряд ли увидим. КОМПАС-3D Viewer доступен на линуксе.

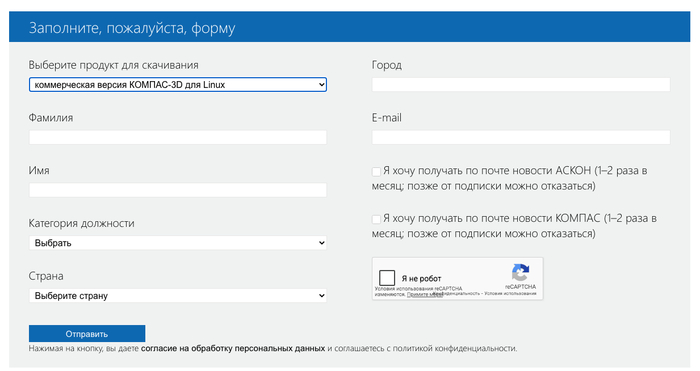

Где скачать?

Там же где обычную пробную версию:

Только в списке "Выберите продукт для скачивания" нужно выбрать "коммерческая версия КОМПАС-3D для Linux":

Источники:

Часть 4 - незапланированная. Unriad и JetKVM

Много лет для своих домашних серверов я использовал простой вариант подключения - портативный монитор и походную клавиатуру с мышью.

Эту часть я изначально не планировал писать, но, случайно увидев ролик на YouTube (ссылка будет в конце), загорелся идеей и по случаю прикупил комплект от JetKVM - сам JetKVM и плату расширения ATX. Кстати, ребята уже выпустили несколько дополнений для JetKVM.

JetKVM, плата расширения ATX, контроллер питания и rs-232

Комплект мне вышел в 8,5к рублей. Есть клоны этого устройства, ценой примерно в 1,5 раза ниже, типа PicoKVM от Luckfox. Самое интересное, что админка у них фактически одинаковая, но нет плат расширения.

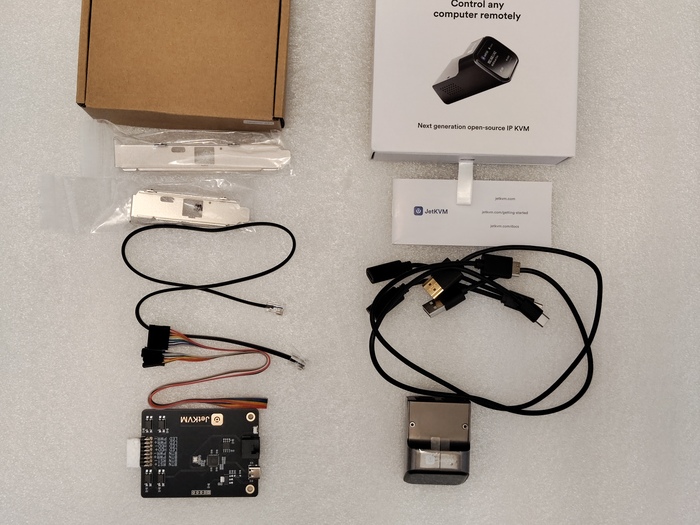

Теперь о моём наборе. Как я уже писал выше, он включает сам JetKVM и плату расширения ATX (с планкой под Low Profile), которая нужна для удалённого включения, выключения и сброса ПК. Комплект поставки - на фото.

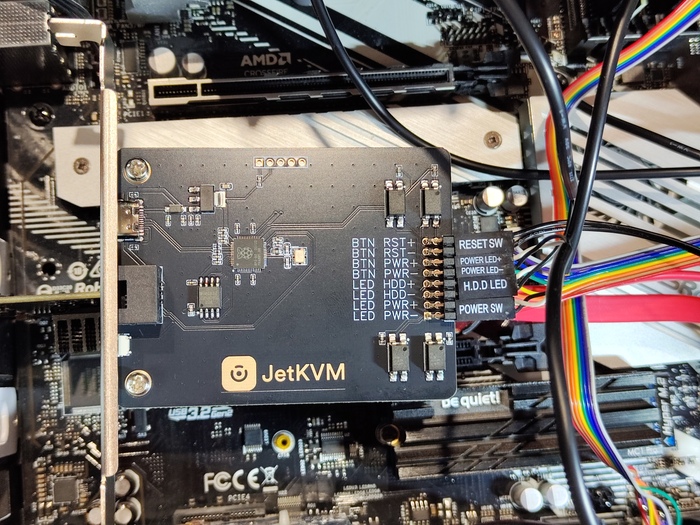

Плата расширения ATX устанавливается в любой свободный слот корпуса ПК и не занимает ни одного слота PCI‑E, так как получает всё необходимое питание по кабелю RJ‑12 или через USB (разъёмы показаны на фото).

После установки подключаем провода к F‑панели. Кстати, гребёнка дублируется, поэтому кнопки на корпусе продолжают работать так же, как и до установки платы расширения ATX.

Подключение проводов к F-панели и установленная плата расширения ATX

На этом с внутренней частью закончили и переходим к непосредственному подключению сервера к JetKVM.

Забыл добавить: JetKVM может работать и без платы расширения ATX, однако в этом случае он не сможет физически включать, выключать или сбрасывать ваш сервер.

Подключение максимально простое - подсоединяем комплектные кабели: HDMI-miniHDMI, RJ‑12 к плате расширения ATX и USB к серверу. В комплект также входит Y‑кабель USB Type‑C для подключения внешнего питания (не от сервера).

Далее всё просто - переходим по полученному IP и попадаем в админку.

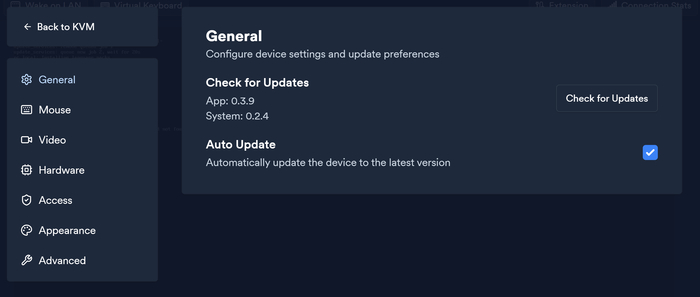

Первым делом проверяем обновления. обновляемся и можем работать с сервером удаленно.

JetKVM позволяет удалённо управлять любыми устройствами, где есть HDMI‑выход и возможность подключения клавиатуры и мыши. На скриншоте - пример подключения JetKVM к Android‑приставке Meecool KM6 Deluxe.

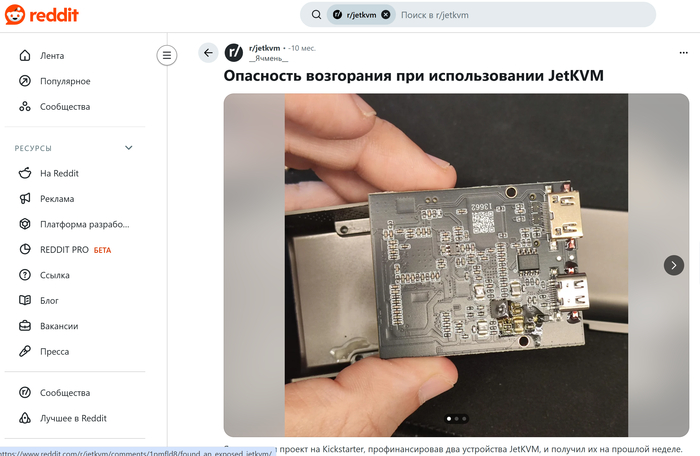

Отдельно стоит сказать пару слов о безопасности. В Reddit есть обсуждение случая, когда у одного из пользователей на плате JetKVM оплавился разъём USB и часть компонентов - судя по фото, проблема была связана с коротким замыканием или перегревом в области питания. Производитель отреагировал на этот инцидент, признал проблему и обновил ревизию устройства, а пострадавшему выслали замену. Я не стал игнорировать эту информацию, поэтому внимательно осмотрел свою плату, проверил качество пайки, отсутствие потемнений и следов перегрева, а также использую нормальный блок питания с достаточным запасом по току.

Ну и тот самый ролик, что вдохновил меня на покупку:

Статья написана мной. Ролик не мой :) Всем спасибо.