Правдиво ли видео, где телеведущий похож на фоторобот мужчины, подозреваемого в подглядывании за женщинами в туалете?

В ноябре 2025 года в мемных пабликах (и на Пикабу) завирусился ролик, на котором ведущий новостей сообщает о розыске человека, подсматривавшего за женщинами в уборных. При этом подозреваемый похож на самого журналиста. Мы проверили подлинность этого видео.

Спойлер для ЛЛ: это ИИ. На Пикабу в итоге поставили соответствующий тэг. Но тренд на генерацию довольно правдоподобных фейковых новостных выпусков так себе. Очень, очень тревожно.

Вирусный ролик якобы представляет собой фрагмент новостной передачи на некоем англоязычном телеканале. Telegram-канал «КБ плюс» (247 000 просмотров на момент написания этого разбора) описал происходящее так: «Полиция разыскивает неизвестного, который повадился подсматривать за женщинами в дамских уборных в центре города. Очевидцы описывают его как мужчину средних лет, примерно 180 см роста, в очках, с бородкой и залысиной. Сегодня утром полиция распространила набросок внешности подозреваемого, созданный на основе его словесного портрета». Человек на фотороботе при этом оказался подозрительно похожим на журналиста, рассказавшего об этой новости на видео. «Главное в ходе расследования — не выйти на самого себя», — пошутили в Telegram-канале «Двач» (278 000 просмотров).

По данным сервиса TGStat, в русскоязычном сегменте Telegram были опубликованы по меньшей мере 150 аналогичных постов, которые в общей сложности получили около 1,5 млн просмотров. О ролике рассказали каналы «Коза кричала» (152 000 просмотров), «Мышеловка» (112 000), «Лепра» (99 000), «Гусь Гагарик» (79 000), «Кувалда 18+» (57 000), «Шахназаров» (45 000) и др. Видео стало популярным и в других соцсетях. Например, во «ВКонтакте» подобный пост в паблике «Борщ» набрал 205 000 просмотров, а в соцсети X один из твитов посмотрели более 169 000 раз. В TikTok этот ролик с русскими субтитрами набрал 790 000 просмотров

В 15-секундном вирусном видео ведущий по-английски произносит:

«Власти разыскивают мужчину, которого видели пробирающимся в женские туалеты в центре города. По словам очевидцев, ему примерно 45 лет, рост около 6 футов (примерно 183 см. — Прим. ред.), он носит очки, аккуратно подстриженную бороду и имеет залысины. Полиция сегодня опубликовала этот фоторобот».

Сам фоторобот показан на заднем плане, и мужчина с рисунка внешне очень напоминает рассказывающего о нём журналиста. Заметила это и вторая ведущая, с удивлением смотрящая на коллегу. При этом в видео нет логотипа телеканала, из эфира которого якобы вырезан этот фрагмент, и указаний на то, в каком именно городе полиция разыскивает злоумышленника.

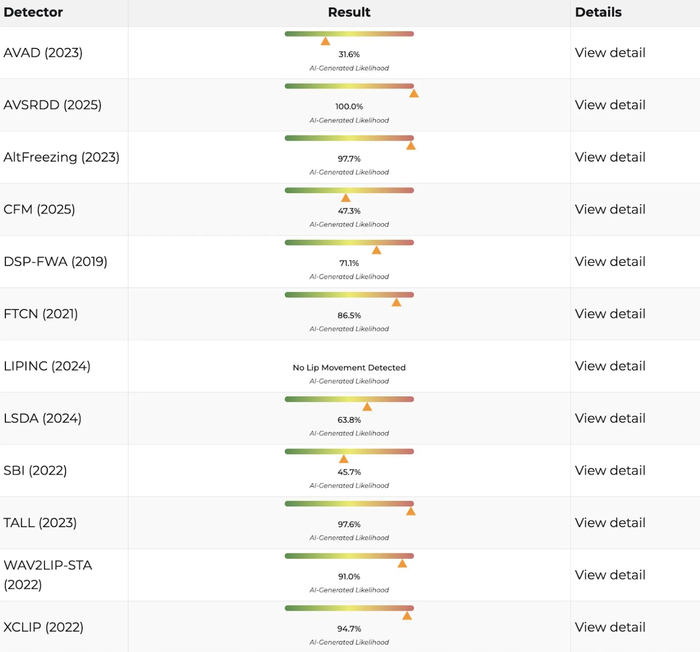

На самом деле ни людей, ни телестудии из этого ролика в реальности не существует — он был создан при помощи ИИ.

Впервые это видео появилось в TikTok, где 14 ноября 2025 года его опубликовал пользователь AI_Flicks_Gone_wild (@flicks_gone_wild). Тогда блог назывался @curious_flicks, и вотермарку именно с таким юзернеймом можно найти в некоторых упомянутых выше постах. Оригинальное видео в TikTok сопровождается специальной плашкой о том, что оно было создано с помощью нейросетей. Несмотря на название блога, которое можно перевести как «дико разошедшиеся ИИ-ролики», из примерно 130 видео, опубликованных там с конца октября, вирусным стало лишь это, а почти все остальные набрали от пары десятков до нескольких сотен просмотров. В некоторых из них стоят соответствующие теги об ИИ, а в части роликов заметны вотермарки модели Sora 2.

Завирусившийся в русскоязычном сегменте Telegram ролик — один из серии подобных видео, опубликованных AI_Flicks_Gone_wild. В одном из них ведущий был похож на предполагаемого похитителя нижнего белья, а в другом в студии показывали фоторобот кота, убившего хозяина. Созданные с помощью ИИ ролики на ту же тему в середине ноября выпускали и другие пользователи TikTok.

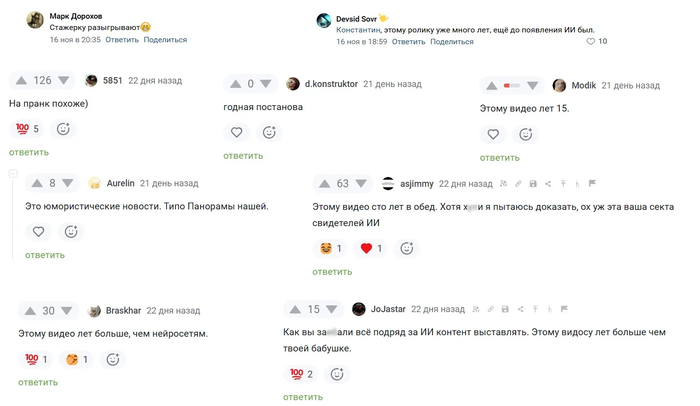

Некоторые пользователи «Пикабу» и «ВКонтакте», принявшие вирусный ролик за настоящий, посчитали, что это был некий розыгрыш ведущих или выпуск сатирических новостей. Другие написали, что это видео было снято очень давно и поэтому не могло быть создано нейросетью.

(Спасибо, @so1nyshk0)

Судя по всему, это пример так называемого эффекта Манделы, когда воспоминания разных людей совпадают, но противоречат фактам. Так, в этом случае пользователи уверенно заявляют, будто много лет назад видели вышедший в конце 2025 года ролик. Вероятно, дело в том, что ранее они посмотрели похожие отрывки реальных новостных передач и спутали их с ИИ-видео. Немного оправдаем пикабушников :)

В 2010 году в Торонто в преддверии саммита «Большой двадцатки» разыскивали покупателя удобрений, которые можно использовать для создания взрывчатых веществ. В эфире CBC News тогда показали фоторобот мужчины, который, по словам интернет-пользователей, был похож на инспектора полиции.

Годом позже завирусился репортаж корреспондента CBS, который освещал инцидент с нападением на женщину. Внимание зрителей привлекло то, что журналист очень напоминал подозреваемого с фоторобота. Фрагмент того эфира затем попал в передачу Good Morning America, ведущая которой пошутила, что нападавший также похож на её коллегу по студии.

В 2016 году похожая ситуация произошла в программе Crimewatch на BBC: в Сети завирусился фрагмент, когда в студии показали снимок преступника, внешне напоминавшего телеведущего.

Схожие сцены не раз встречались и в художественных произведениях. К примеру, в 2007 году в одном из эпизодов сериала «Офис» герой не мог понять, что он похож на фоторобот преступника, которого сам и разыскивал

Ещё в 1969 году скетч на эту тему выходил в шоу «Летающий цирк Монти Пайтона».

Таким образом, ставший вирусным отрывок телеэфира, во время которого показали фоторобот злоумышленника, подсматривающего за женщинами в туалете и похожего на ведущего новостей, был сгенерирован нейросетью.

Наш вердикт: неправда

«Проверено» в Телеграм

В сообществе отсутствуют спам, реклама и пропаганда чего-либо (за исключением здравого смысла)