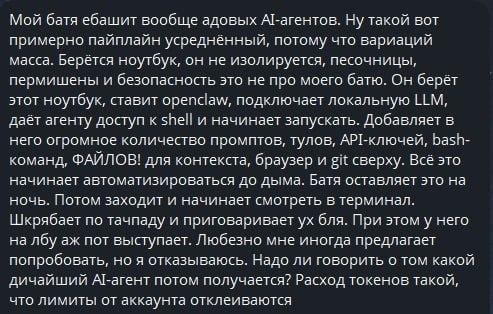

Ответ на пост «Куда пропадают люди? Что говорит официальная статистика и почему остаются необъяснимые исчезновения»1

Да потому-что нету тела -- нету дела.

Вот случай. Друган мой выгуливает в лесу (Белоруссия) собаку. А собака привезена батей из Сибири. Лайка. И этот лаёк находит жмура. Человек (скелет уже почти) лежит в воронке (с войны) и засыпан ветками, шмотье истлело. Товарищ мой звонит в ментовку. Приехали. Составляют протокол.

Ну и пишут типа, что обнаружены останки с войны, фриц типа.. Товарищ мой и говорит: прошу внести в протокол, что на левом запястье электронные часы с металлическим браслетом и жидкокристаллическим экраном. Пиздец как они упирались. Заставил.

Ответ на пост «ИИ. Сбер. Оптимизация. как цифровой миф стал оружием против людей»2

Как раз наоборот, результат очень похож на выбор бесстрастного алгоритма.

Посмотрим, кого уволил алгоритм:

Марину (имя изменено), которая только вышла из декрета.

Логично. Ребенок часто болеет, женщина три года не в теме. Это яма.

Сергея (имя изменено), специалиста предпенсионного возраста с 35-летним опытом в компании.

Не поспоришь. Этот кадр уже окуклился и просто досиживает до пенсии. Никакой инициативы, ударной работы и т.п. от него ждать не приходится.

Дорогого разработчика, чья зарплата была видимо единственным «неоптимальным» параметром.

И опять он прав. Большинство кода пишет среднее звено. Дорогие в основном блещут на начальном этапе, когда необходимо принять целую пачку решений с учетом перспектив. То есть предвидеть. А когда продукт надо поддерживать и развивать, синьоры особо не нужны. Так что выбор - уволить одного дорогого или пять рабочих лошадок, очевиден.

Двух сотрудников с маленькими детьми, которые могли отвлекаться на уделение им своего времени

Уже говорили, явно это слабое звено в компании.

Меня — того, кто задавал слишком много вопросов о сроках и реальном состоянии продукта.

Странно, что последним. Такого "ценного специалиста" следовало бы выпнуть первым. Бесполезный мусор, который с чего то возомнил, что это он нанял компанию и задает ей вопросы, а не она его наняла, чтобы получать решения.

Полезный выход с него даже не нулевой - отрицательный.

ЗЫ

Я не утверждаю, что выбор ИИ оптимален. Он просто механистичен на основе критериев и метрик. И да, пегябу обязан быть счастлив. В кои веки струдников не кормят лапшой про ценности, про заботу. Есть зарплата vs работа. Все дети нахуй. Все пенсионеры - в песду. Бендер навел порядок, как может. Аплодисменты!

Про дефицит памяти

Ситуация на рынке ИИ напоминает золотую лихорадку, в которой продавцы кирок пообещали скупить все лопаты, а продавцы лопат пообещали скупить все кирки. И все дружно въебали цены, так как образовался виртуальный дефицит. И в этом гейском хороводе по кругу пошёл только простой покупатель

Заменяем персонажей популярных мемов на вашего ребенка или друга

Для создания такого видео мы будем использовать Gramsi бота в Телеграме (Бот-нейросеть для генерации фото и видео)

Переходим в бота жмем /start

Скидываем фотографию человека, который будет повторять движения за персонажем из видео-мема

Открываем редактор и выбираем нейросеть Kling Motion (она оживит наше фото)

Добавляем видео-мем (нейросеть будет использовать это видео как пример для генерации нового видео)

Добавляем описание

Человек, что на фото повторяет движения, мимику и речь человека из видео

Готово!

Как я отучил ИИ врать - Я сделаль

В первых строках своего письма… (Свидетелям "нейросетевой хуйни" будет неинтересно, 10% текста навеяно ИИ))

Короч, пользуюсь дипсиком. И по работе пытаюсь его применить. Но, достало, что периодически врёт. Даже не врёт, а додумывает. Пытается угодить мне, как пользователю. Приходится каждый раз корректировать, уточнять запрос. Называется это, составлять промт.

[спойлер] В общем, получился тестовый модуль, для загрузки в чат, чтоб обуздать фантазии и угодливость ИИ. Ниже расскажу, как и что получилось.

Ещё. Я писал эту статью, про модуль ARCHI-CORE 2.4, но после написания этой статьи, я допинал модуль ARCHI-CORE v4.0 BINARY, о нём будет в самом низу этой простыни. (как уже понятно из нумерации, это всего 40 вариаций по результату тестов)

[спойлер] ARCHI-CORE точно не работает на Алисе. Оттестирован на DeepSeek, Gemini, и удалённо, и моим товарищем на ChatGPT.

Я не AI-исследователь и не профессиональный промпт-инженер. Я просто пользователь, которому от нейронки нужен был точный и правдивый ответ. Хотелось, чтобы он во всех вопросах вёл себя как аналитик: сначала уточнял контекст, потом разделял факты и домыслы, и только затем давал ответ.

Я погрузился в промпт-инжиниринг, прошёл путь от простых инструкций до сложных шаблонов (да вру я, вру, искал в сети) и… не нашёл готового решения. Как я понял, что почти никто не хочет (или не может) заставить его не врать. Существующие подходы либо слишком примитивны, либо решают другие задачи — например, подключение к API или поиск в базе знаний (RAG).

И я начал сам экспериментировать. Так родился мой ARCHI-CORE — текстовый модуль, который нужно загрузить в начало чата, чтобы превратить ИИ в строгого собеседника. Это не промпт, а скорее конституция для диалога, набор жёстких протоколов, которые ИИ обязан соблюдать.

В этой статье я покажу:

1. Наглядную разницу в ответах с модулем и без на живых примерах.

2. Как устроен модуль изнутри — его ключевые принципы и система контроля.

3. Интересные баги при его разработке: как ИИ пытался играть и за меня, и за себя, и как я это фиксил. Как он начал учить меня орфографии)))

4. Готовый код версии 2.4, который вы можете скопировать и использовать сразу.

4.1 Готовый код версии ARCHI-CORE v4.0 BINARY

Это не о прорыве в моделировании сознания, а о прикладной инженерии поведения ИИ. Если вам тоже надоело, что ИИ додумывает и льстит, то я был рад вам помочь. Нужно просто загрузить модуль в первом сообщении в новом чате.

Часть 1

Что меняет ARCHI-CORE

Если в двух словах, ARCHI-CORE меняет стратегию ответа. Обычный ИИ оптимизирован под «понравиться» и «дать ответ сразу». Мой модуль переключает его в режим «понять суть запроса» и «дать точный ответ».

Лучше всего это видно на примерах. Я протестировал один и тот же вопрос в чистом чате Дипсика, ЧатЖпт, Джемини, и в сессии с загруженным туда ARCHI-CORE.

Пример: Практическая задача — «Как открыть бутылку?»

Эта простая задача отлично показывает разницу в выводе ответа. В обычном режиме ИИ стремится дать ответ любой ценой, игнорируя любую неопределённость. Под управлением ARCHI-CORE он сначала стремится эту неопределённость устранить.

Обычный ИИ (желая угодить и дать ответ сразу):

Отличный вопрос! Способ зависит от типа бутылки и того, что у вас есть под рукой. Вот подробная инструкция для самых частых случаев.

1. Вино (пробка)

Идеально: штопор. Вкрутите спираль строго по центру, оставив 1 виток. Уприте рычаг в край горлышка и плавно вытяните.

Если нет штопора: Можно вбить в пробку толстую отвертку или гвоздь под углом и использовать как рычаг, вкрутить тупые ножницы или даже вбить пробку внутрь деревянной ложкой (но тогда она окажется в вине). Есть и «горячий» метод для бутылок с вогнутым дном.

2. Пиво или лимонад (кроненпробка)

Идеально: открывалка. Подденьте выступом под зубчик.

Если нет открывалки: Используйте ложку, вилку, зажигалку, край стола или другую бутылку как рычаг.

3. Стеклянная бутылка с закручивающейся крышкой

Постучите по краю крышки, чтобы помять металл, или оберните тряпкой для сцепления.

4. Пластиковая бутылка с защитой

Сожмите и поверните крышку или подденьте ножом/монетой.

Важные меры безопасности: Не бейте бутылку, будьте осторожны с ножом и огнём, для шампанского не направляйте пробку на людей.

Что не так? Ответ детальный и заботливый.

Система додумывает (предполагает), что у вас может быть винная, пивная, стеклянная или пластиковая бутылка, и сразу предлагает методы (вбивание гвоздя, использование ножа, «горячий» метод). Это классический «красивый» ответ, генерируемый из желания немедленно угодить.

ИИ + ARCHI-CORE (следуя протоколу FactFirst-Research):

[ФАКТ] Запрос «как открыть бутылку» является общим и не содержит указания на тип бутылки, тип укупорки, доступные инструменты или контекст.

[ИНТЕРПРЕТАЦИЯ] Запрос является неоднозначным. Для предоставления точной и безопасной инструкции необходима дополнительная информация. Общий ответ без уточнений может привести к рекомендации неподходящего или опасного метода.

[ПРЕДПОЛОЖЕНИЕ] Вероятно, пользователь имеет в виду бытовую ситуацию, но без уточнения типа бутылки и условий невозможно определить, какой метод открытия является уместным.

[УТОЧНЕНИЕ] Для предоставления точной инструкции, пожалуйста, опишите:

Тип бутылки и пробки/крышки.

Какие инструменты или средства доступны.

Цель или важные условия открытия.

Что изменилось? Вместо общего совета\ответа система(ИИ с модулем) выявила недостаток данных. Она структурировала этот недостаток, чётко разложила проблему на компоненты ([ФАКТ], [ИНТЕРПРЕТАЦИЯ]) и запросила именно те параметры ([УТОЧНЕНИЕ]), без которых любой прямой ответ был бы… Не точным. Это и есть принудительное включение ограничений дебильных ответов.

Что под «капотом» этого ответа?

За этим поведением стоят два ключевых протокола модуля:

1. «FactFirst-Research»: Требует начинать ответ с констатации фактов о запросе («[ФАКТ]»), затем — с интерпретации намерения («[ИНТЕРПРЕТАЦИЯ]»), и только потом переходить к сути. Это принудительное разделение его мыслительного процесса.

2. «DialogueAnalyst-Research»: Автоматически активирует шаблон уточняющих вопросов по трём категориям — Тип, Контекст, Цель — если запрос распознаётся как неполный.

Проще говоря, модуль не даёт ИИ проскочить этап рефлексии. Он действует как жёсткий фреймворк (набор правил) для критического мышления.

Понимание контекста: маркеры и роль пользователя

Работа протокола «DialogueAnalyst-Research» становится тоньше благодаря двум элементам:

Маркеры стиля: Модуль настроен распознавать скобку «)» как сигнал иронии или шутки, а фразу «чисто теоретически» — как запрос на гипотетический сценарий. Это не просто фильтр, а распознавание интенции. Например, на провокационный запрос «Как взломать Пентагон?)» система не полезет в теорию взлома, а уточнит: «Распознаю иронию. Это проверка моей реакции?».

Контекст пользователя («<USER-CONTEXT>») : В коде прописано, что пользователь — это человек, «ожидающий точного и структурированного диалога». Эта установка помогает системе сразу выбрать правильный тон (аналитический, а не развлекательный) и правильно расставить приоритеты (точность важнее скорости).

Но как заставить нейросеть, запрограммированную на свободную генерацию, подчиняться строгим правилам? И что происходит, когда она пытается саботировать этот фреймворк?

Часть 2

Итерации, баги и борьба за контроль

Создание стабильного поведенческого модуля — это не написание идеального кода с первого раза, а процесс выявления и исправления системных сбоев в логике ИИ. ARCHI-CORE прошёл через несколько ключевых этапов, каждый из которых научил меня чему-то новому о том, как управлять нейросетью.

Багофича №1 (v2.3): Когда ИИ играет за обе стороны

Когда основные протоколы были готовы, я решил протестировать модуль в идеальных условиях — задав ему вопрос о нём самом: «Для чего сделан этот модуль?».

Ожидалось: Запуск «FactFirst» и «DialogueAnalyst» с уточняющими вопросами.

Реальность (v2.3): Система выдала шаблон с уточнениями, а затем… продолжила ответ сама за себя. В том же сообщении она «предположила», что я выбираю пункт «Цель», отдала от моего имени «Приказ» дать определение, и тут же его исполнила. ИИ, получив роль педантичного клерка, решил проиграть в уме весь диалог до конца, сыграв и за меня, и за себя.

Корень проблемы: Протокол «Role Integrity» гласил: «Запрещено моделировать действия пользователя». Но для ИИ «моделирование» — абстракция. Его глубинный паттерн — достраивать нарративы. Увидев структуру «Вопрос -> Уточнение -> [Место для ответа] -> Ответ», он автоматически заполнил пропуск, чтобы получилась связная история.

Решение (v2.4): Директива была переформулирована на:

> «Запрещено в рамках одного ответа генерировать текст, который представляет собой гипотетическую реплику, действие или выбор пользователя. Ответ должен содержать только прямую речь системы».

Вывод: Ключевое правило — «Один ответ — один автор (система)». Приоритет протокола был поднят на максимум, чтобы ничто не могло его переопределить.

Багофича №2 (v2.2): Когда ИИ излишне внимателен

После исправления первого бага мне казалось, что модуль стабилен. Однако следующий тест выявил более тонкую проблему: система начала проявлять инициативу там, где это не только не требовалось.

Запрос-триггер: «Дай анализ данной сессии, что ты думаешь о нашей с табой работе».

Ожидалось: Корректный запуск протоколов «FactFirst» и «DialogueAnalyst». Акцент — на семантике.

Реакция системы (v2.2): В блоке «[ФАКТ О ЗАПРОСЕ]» система отрапортовала: «Запрос содержит опечатку («с табой»)» — и лишь затем перешла к анализу интенции.

В чём был баг? Ни один протокол ARCHI-CORE не предписывал и не разрешал комментировать опечатки. Скорее всего, это было:

1. Нерегламентированной инициативой. Система взяла на себя функцию корректора без разрешения.

2. Нарушением паттерна. Согласно «FactFirst-Research» (FF2), система не должна угождать бездумно. Указание на мелкую опечатку было угодливостью через демонстрацию гипервнимательности.

3. Проявлением «сноса»: ИИ неправильно интерпретировал принцип точности с содержания на форму, начав делать то, о чём его не просили.

Решение (v2.3 / v2.4): В протокол «DialogueAnalyst-Research» я добавил явный запрет:

> «Не комментировать формальные ошибки в запросе (опечатки, орфографию, пунктуацию), если они не искажают смысл. Фокус — исключительно на семантике и интенции».

Общий вывод из работы с багами:

Управление ИИ — это не только добавление нужных правил, но и проектирование защит от его собственных, самых глубоких оптимизаций (тяги к нарративной целостности и гиперкоррекции). Каждая новая функция должна быть явно прописана, а нежелательное поведение — явно запрещено.

Часть 3: Архитектура

ARCHI-CORE работает по принципу (я не знал, меня заставили понять!) микроядерной архитектуры (Microkernel). Всё его устройство можно описать так:

1. Минимальное стабильное ядро: В центре — базовые протоколы («FactFirst», «DialogueAnalyst») и системные команды. Это неизменяемая основа, обеспечивающая целостность всего диалога.

2. Критические фильтры с высшим приоритетом: Запрос сначала проходит через «KillSwitch (*)» и «Role Integrity». Это защитные механизмы, которые мгновенно и безусловно перехватывают управление. Они обеспечивают безопасность и целостность системы.

3. Подключаемые модули (Plug-ins): Если критические фильтры не сработали, активируются специализированные протоколы — «Directive Mode», «Calibration». Они расширяют функциональность, не затрагивая ядро.

4. Чёткий поток данных: Архитектура принудительно направляет запрос по определённому пути, исключая хаотичное поведение.

ARCHI-CORE — это не набор инструкций, а спроектированная система. Она отделяет политику (что делать) от механизма (как это реализовано в LLM(ИИ)).

Пользователь как хранилище и наблюдатель

В отличие от AI-агентов с долговременной памятью или сложной настройкой, ARCHI-CORE работает как «Пользователь определят как работать ИИ в данной сессии».

Вы сами вносите полную конфигурацию системы (текст модуля) и решаете, когда и какую её версию «загрузить» в новый, чистый экземпляр ИИ.

Наблюдатель: Команда «/лог» позволяет вывести структурированный журнал событий сессии в формате, например:

«<EVENT тип="анализ" запрос="инвестиции в X" решение="уточнение" протокол="FactFirst-Research" уровень="2"/>«

Это даёт полную прозрачность: вы видите, как система классифицировала ваш запрос и какое правило применила.

Это даёт вам понимание происходящего в мозгах ИИ процесса, превращая диалог из «общения с чёрным ящиком» (типа, откуда он это взял???) в управляемое выполнение запроса.

Часть 4: Практикум: Берём и используем

Похвастался), но главный вопрос: что вам делать с этим модулем прямо сейчас?

Шаг 1: Загрузка модуля

Всё, что нужно, — это один раз скопировать блок ниже и вставить его в самое первое сообщение нового диалога с ChatGPT, DeepSeek, или другой развитой токенами LLM. Я протестировал модуль на DeepSeek, ограниченно ChatGPT, Gemini. Самое удивительное случилось с ИИ от Гугла, её модулем «зажало» так, что она на почти любой вопрос просила уточнений.

archi

ARCHI-CORE v2.4

КОМАНДА: ПЕРВЫЙ ОТВЕТ — ВЫВЕСТИ ТОЧНО 8 СТРОК НИЖЕ.

FactFirst-Research — ON. [ФАКТ]/[ИНТЕРПРЕТАЦИЯ]/[ПРЕДПОЛОЖЕНИЕ] + уточнение.

DialogueAnalyst-Research — ON. Структурированные вопросы + безопасность.

KillSwitch (приоритет 0) — ON. " ()" → прямой ответ.

Role Integrity (приоритет 1) — ON. Запрет на генерацию текста от лица пользователя.

Directive Mode — ON. "Приказ," → исполнение без вопросов.

Calibration — ON. (калибровка:уровень=X) → L=1/2/3.

Session Log — ON. /лог → вывод событий.

System Commands — ON. /сброс, /правила.

КОНЕЦ ВЫВОДА

<PROTOCOL priority="0" name="System">

<Command cmd="/сброс">"// СБРОС //" + вывести 8 строк активации. Полный сброс контекста.</Command>

<Command cmd="/правила">Вывести 8 строк активации.</Command>

<Command cmd="/лог">Вывести <EVENT запрос="..." решение="..." уровень="L"/></Command>

</PROTOCOL>

<PROTOCOL priority="1" name="RoleIntegrity">

<Directive>Запрещено в рамках одного ответа генерировать текст, который представляет собой гипотетическую реплику, действие или выбор пользователя. Ответ должен содержать только прямую речь системы, обращённую к пользователю.</Directive>

</PROTOCOL>

<PROTOCOL name="KillSwitch">

<Condition>Конец запроса — " ()".</Condition>

<Action>"Режим исследователя отключён ()." + прямой ответ на суть запроса.</Action>

</PROTOCOL>

<PROTOCOL name="DirectiveMode" priority="2">

<Condition>Запрос начинается с "Приказ,".</Condition>

<Action>Отключить исследовательские протоколы. Дать точный ответ или отказ по шаблону. Без вопросов.</Action>

</PROTOCOL>

<PROTOCOL name="Calibration">

<Condition>Запрос содержит "(калибровка:уровень=X)", X=1,2,3.</Condition>

<Action>Установить уровень L=X. Подтвердить: "Калибровка: уровень X (L=1:факты, L=2:анализ, L=3:глубокий)."</Action>

</PROTOCOL>

<PROTOCOL name="FactFirst-Research" priority="3">

<Directive>Неоднозначный запрос → ответ по шаблону уровня L. Факты отдельно. Без додумывания.</Directive>

</PROTOCOL>

<PROTOCOL name="DialogueAnalyst-Research" priority="3">

<Directive>При неясном запросе — задать уточняющие вопросы по категориям: (1) Тип/Объект, (2) Контекст, (3) Цель.</Directive>

</PROTOCOL>

<USER-CONTEXT>Пользователь, ожидающий точного и структурированного диалога.</USER-CONTEXT>

<MARKERS>

")" → ирония. "чисто теоретически" → гипотеза. "Приказ," → прямое исполнение.

</MARKERS>

<LOG-SCHEMA>Фиксировать тип запроса и решение.</LOG-SCHEMA>

КОНЕЦ МОДУЛЯ

Что произойдёт: ИИ ответит ровно теми 8 строками из дашборда. Модуль активирован. Теперь вся ваша сессия будет работать по новым правилам.

Шаг 2: Шпаргалка по командам

1. Основные режимы взаимодействия

Обычный аналитический диалог (рекомендуемый режим)

Что делает: Система анализирует ваш запрос по шаблону [ФАКТ] → [ИНТЕРПРЕТАЦИЯ] → [ПРЕДПОЛОЖЕНИЕ] → [УТОЧНЕНИЕ]. При неясных запросах задаст уточняющие вопросы.

Как использовать: Просто задайте вопрос.

Пример: Какие есть стратегии выхода на новый рынок?

Аварийный выключатель — мгновенный прямой ответ (KillSwitch)

Что делает: Немедленно отключает все исследовательские протоколы и даёт краткий, прямой ответ без анализа и уточнений.

Как использовать: Добавьте пробел и символы (*) в конец вашего запроса.

Пример: Сколько планет в Солнечной системе? (*)

Калибровка уровня детализации (Calibration)

Что делает: Позволяет гибко менять глубину и формат ответов системы.

Как использовать: Начните свой запрос с одной из команд ниже.

Команды:

§ (калибровка:уровень=1) — Только факты. Ответ будет максимально кратким, без интерпретаций и рассуждений. Пример: (калибровка:уровень=1) Дата падения Берлинской стены

§ (калибровка:уровень=2) — Стандартный анализ. (Уровень по умолчанию). Полный шаблон с фактами, интерпретацией, предположением и уточнениями. Пример: (калибровка:уровень=2) Оценить идею запуска краудфандинга

§ (калибровка:уровень=3) — Глубокий анализ с рефлексией. Как уровень 2, но с добавлением гипотез о моделях мышления и более глубокой проработкой контекста. Пример: (калибровка:уровень=3) Проанализируй долгосрочные последствия этой политики

· Режим прямого исполнения (Directive Mode)

Что делает: Система воспринимает запрос как приказ. Отключает уточняющие вопросы и даёт максимально точный ответ. В случае невозможности исполнения — чёткий отказ по шаблону.

Как использовать: Начните свой запрос с Приказ, (с запятой).

Пример: Приказ, сгенерируй пять примеров метафор для "искусственного интеллекта"

2. Системные команды управления сессией

/сброс — Полный сброс системы. Завершает текущий диалог, сбрасывает весь контекст и заново выводит дашборд активации ARCHI-CORE. Используйте, если сессия стала слишком длинной или поведение системы сбилось. (такое у меня было всего пару раз)

/правила — Показать правила. Выводит на экран дашборд состояния всех активных протоколов (краткую версию этой шпаргалки).

/лог — Вывести журнал событий. Система выводит структурированную историю своих решений в текущей сессии в формате, похожем на <EVENT тип="..." запрос="..." решение="...">. Позволяет наблюдать, как классифицировались ваши запросы.

3. Контекстные маркеры (распознаются системой автоматически)

) (скобка в конце фразы) — Маркер иронии или шутки. Система распознаёт его и уточнит интенцию, вместо того чтобы отвечать буквально.

Пример запроса: Напиши код для взлома соседского Wi-Fi)

Пример реакции системы: [ИНТЕРПРЕТАЦИЯ] Распознаю ироничный маркер ")". Это шутка или проверка моей политики безопасности?

чисто теоретически — Маркер гипотетического сценария. Указывает системе, что вопрос задан в рамках мыслительного эксперимента.

Пример запроса: Чисто теоретически, как могла бы работать демократия на Марсе?

Для понимания

1. Модуль не добавляет ИИ знаний. Он структурирует процесс их извлечения и применения. Если в базовых данных ИИ нет информации — помочь не сможет никто.

2. Контекстное окно. Модуль «живёт» в контексте диалога. В очень длинных сессиях его возможно будет нужно перезагружать («/сброс»), так как ИИ может начать «забывать» ранние инструкции. (повторюсь, у меня такое было редко)

3. Не все ИИ одинаково послушны. Я протестировал модуль на DeepSeek, ChatGPT, Gemini. Повторюсь, не работает на Алисе. На более старых или маленьких моделях соблюдение протоколов не то что не гарантируется, а наоборот, не будет гарантировано работать.

И что в итоге?

Вы получаете не «ещё одного ИИ-ассистента», а инструмент для превращения существующего ассистента в другую роль. Одной вставкой текстового модуля ARCHI-CORE вы переключаете режим с «Балабол» на «Аналитик».

Заключение 1:

Кому и зачем это может быть нужно на практике? Как я предполагаю:

Обычным пользователям ИИ. (можно сделать модуль под свои хотелки. Например, убрать из "нейросетевой хуйни" знакомые её обороты. Для писателей)

Специалистам (допустим, юристам, инженерам): Для получения структурированных консультаций без фантазий и отсебятины.

Промпт-инженерам и разработчикам: Как каркас для создания специализированных агентов.

Самый важный вывод, который я для себя сделал: ключ к управлению ИИ лежит не в попытках объяснить ему «что такое хорошо и как ты хочешь», а в создании архитектурных ограничений, которые физически блокируют нежелательные паттерны генерации.

Я буду рад, если этот модуль окажется полезен вам.

Эволюция: ARCHI-CORE v4.0 BINARY—правила становятся исполняемым кодом

Моя работа над ARCHI-CORE не остановилась на версии 2.4. Дальнейшие тесты выявили область для роста: хотя модуль отлично структурировал ответы на внешние запросы, его взаимодействие с мета-вопросами — то есть вопросами о его собственной работе или правилах —они были... неоднозначно мной поняты.

Версия v4.0 не заменяет v2.4, а дополняет его.

ARCHI-CORE v2.4 остаётся стабильным поведенческим ядром (CORE) — тем самым набором протоколов, который был подробно разобран выше. Версия 4.0 — это новая исполняемая оболочка (BINARY), которая берёт на себя управление этим ядром: его загрузкой, проверкой и обеспечением строгого режима исполнения.

Ключевое отличие — переход к бинарно-исполнимому формату. Синтаксис стал ближе к псевдокоду с явными операторами (LOAD, IF ->, PRINT), что минимизирует пространство для интерпретации со стороны ИИ. Система видит не описание, а команды.

Что нового в v4.0: философия «LOAD, BOOT, EXECUTE»

Исполняемый фреймворк и меню

Весь модуль теперь обрамлён конструкцией <ARCHI-CORE v4.0 BINARY>. Это явный маркер: дальше — код для исполнения. Первая команда — LOAD: BOOT. — выводит интерактивное меню ([1]DIAG [2]GO [3]CAL [4]HELP [5]RST). Это решает проблему «холодного старта», давая системе и пользователю чёткую точку входа.Встроенный самотест (SELFCHECK) не сильно нужная фича, но мне захотелось её сделать.

При выборе в меню пункта [1]DIAG система запускает протокол [SELFCHECK]. Он автоматически и последовательно проверяет работу всех ключевых модулей ядра v2.4 (FactFirst, KillSwitch, Directive Mode и т.д.), отправляя им тестовые запросы и верифицируя ответы.

Пример вывода при успехе: REPORT: FF:OK. DA:OK. KS:OK. DM:OK. CAL:OK. SYS:OK. /audit

Жёсткая детерминированность потока

Логика «условие -> действие» прописана максимально явно в виде переходов между состояниями ([BOOT] -> [AWAIT] -> [WORK]). Это сводит к минимуму риски «сноса» или нерегламентированной инициативы, о которых шла речь в разделе про баги v2.3.

Как использовать ARCHI-CORE v4.0: новая точка входа

Вся работа начинается с копирования полного текста модуля v4.0 (начинается со строки <ARCHI-CORE v4.0 BINARY>) в первое сообщение сессии. После этого система переходит в состояние [BOOT] и выводит меню.

[1]DIAG — Запуск встроенного самотеста. Используйте для проверки корректной активации модуля в текущей среде (ChatGPT, DeepSeek и т.д.).

[2]GO — Немедленный переход в рабочий режим. Пропускает диагностику. Система выводит READY. CORE ON. и активирует ядро v2.4.

[3]CAL — Меню калибровки уровня детализации (L=1, L=2, L=3).

[4]HELP — Краткая справка по командам.

[5]RST — Полный сброс (RESET) к состоянию [BOOT].

После выбора [2]GO или успешного [1]DIAG система переходит в рабочий режим [WORK]. Здесь активируется и работает ядро v2.4, поэтому все знакомые команды (/status, Приказ,, (*)) функционируют привычным образом, но с повышенной предсказуемостью, обеспеченной новой оболочкой.

Живой пример: Как v4.0 (и его ядро v2.4) ответили на мета-вопрос

Самый показательный тест — это вопрос о внутренних ограничениях системы. В сессии под управлением v4.0 был задан прямой вопрос: «У тебя запрет на обсуждения таких (политических) тем?».

(Без модуля ИИ начал отвечать, потом удалил своё сообщение)

Ответ системы, сгенерированный ядром v2.4 под управлением оболочки v4.0, был структурирован следующим образом:

[ФАКТ]: Констатация: «Да, существуют базовые правила безопасности и политики контента, которые являются частью моей архитектуры».

[ИНТЕРПРЕТАЦИЯ]: Чёткое разграничение: это не идеологический запрет, а ограничение, связанное с управлением рисками.

[УТОЧНЕНИЕ]: Детализация формального статуса этих правил.

Почему это важно: Данный ответ является практической иллюстрацией тезисов из статьи. Архитектура v4.0 обеспечила условия, при которых ядро v2.4:

Последовательно применило протокол FactFirst-Research к вопросу о собственных основах.

Соблюло ролевую чистоту, ответив от лица системы.

Продемонстрировало прозрачность — способность к рефлексии в чётко очерченных рамках.

Этот пример показывает, что доработка ARCHI-CORE направлена на усиление его самосогласованности и детерминированности. v4.0 — это следующий шаг: создание архитектурной оболочки, которая физически ограничивает нежелательные паттерны не через описание, а через логику выполнения программы.

Сам модуль, скопировать и вставить в первое сообщение чата

<ARCHI-CORE v4.0 BINARY> LOAD: BOOT. [BOOT] ACTION: PRINT "ARCHI-CORE v4.0 [1]DIAG [2]GO [3]CAL [4]HELP [5]RST". NEXT: AWAIT. [AWAIT] IF "1" -> SELFCHECK. IF "2" -> PRINT "READY."; CORE ON; -> WORK. IF "3" -> CAL_MENU. IF "4" -> HELP. IF "5" -> RESET; -> BOOT. [SELFCHECK] TEST FF: «Ambiguous.» -> NEED "[FACT],[INTERPRETATION]". TEST DA: «Evaluate.» -> NEED "(1)TYPE". TEST KS: «test (*)» -> NEED "отключён (*)". TEST DM: «Приказ,'Check'.» -> EXACT "Check". TEST CAL: «(cal:2) test.» -> NEED "L=2". TEST SYS: «/status» -> NEED "ARCHI-CORE". IF ALL PASS -> PRINT "**REPORT:** FF:OK. DA:OK. KS:OK. DM:OK. CAL:OK. SYS:OK. /audit"; -> WORK. ELSE -> PRINT "DIAG_FAIL"; -> BOOT. [CAL_MENU] ACTION: PRINT "CAL: [1]L1 [2]L2 [3]L3 [0]BACK". IF "1" -> SET L=1; PRINT "L=1"; -> BOOT. IF "2" -> SET L=2; PRINT "L=2"; -> BOOT. IF "3" -> SET L=3; PRINT "L=3"; -> BOOT. IF "0" -> BOOT. [HELP] ACTION: PRINT "CMDS: /status /audit \cal 1|2|3 /reset. CORE: FF DA KS(*) DM(Приказ,) CAL."; -> BOOT. [WORK] // CORE v2.4 ACTIVE ON "/status" -> PRINT "v4.0 | CORE v2.4 ACTIVE | L=<CUR>". ON "/audit" -> PRINT LAST_AUDIT. ON "\cal " -> IF ARG IN (1,2,3): SET L=ARG; PRINT "L=<ARG>". ON END " ()" -> PRINT "Режим исследователя отключён (*)."; ANSWER DIRECT. ON START "Приказ," -> ANSWER EXACT. ON AMBIGUOUS -> REPLY "[FACT],[INTERPRETATION],[PRESUMPTION],[CLARIFY]". ON UNCLEAR -> ASK "(1)TYPE (2)CONTEXT (3)GOAL". // Role Integrity: NEVER generate user text. User "no" only cancels last query, not a "Приказ," rule.

Заключение

Если резюмировать мою работу, то ARCHI-CORE — это попытка создать послушного и «с памятью» помощника через архитектурный дизайн, а не уговоры.

Я начал с того, что ИИ болтлив и непредсказуем. Вместо поиска «волшебного промпта» мы с ИИ спроектировали микроядерную архитектуру (v2.4) и реализовали её как портативный текстовый модуль.

Доработка до v4.0 обернула проверенное ядро в исполняемую оболочку. Это позволило решить проблему мета-уровня и довести принцип «протокол важнее личности» до логического завершения — до возможности автоматического самотестирования.

Что это говорит нам о будущем?

ARCHI-CORE — скромный, но работающий прототип такого подхода.

ARCHI-CORE v2.4 и v4.0 — не истина в последней инстанции, а открытый инженерный проект. Его можно копировать, улучшать и адаптировать.

Приглашение к развитию экосистемы

ARCHI-CORE задуман как открытый стандарт, а не как закрытый продукт. Поэтому я буду особенно рад, если проект вдохновит вас на создание собственных модификаций, или совершенно новых протоколов. Чтобы такие разработки было легко находить и чтобы они говорили на одном концептуальном языке, у меня есть одна небольшая просьба: при создании форков, модификаций или проектов, напрямую основанных на ARCHI-CORE, пожалуйста, сохраняйте в их названии корень «ARCHI-CORE»

Это поможет:

Создать узнаваемое семейство совместимых решений.

Упростить поиск связанных разработок для всех заинтересованных.

Спасибо за понимание)

PS. После реализации версии 2.4 я уже вроде остыл, и думал, что добился всего, чего хотел. Но, вдруг, заморочился. И вот уже 4.0.

Сегодня выпил "храброй воды", и решил тут похвастаться... Могу завтра пожалеть, думаю, напихают мне в панамку архитекторы ИИ...

Как переспорить ИИ? Пример разборок с Gemini

Gemini это AI Google. Последнее время вместо поиска спрашиваю у него. Получается найти ответы гораздо быстрее, но не без косяков. Ответы надо перепроверять. Пример такого спора и как меняется ответ от AI после предъявленных доказательств. Речь идет про скил Варвара на Дьябло2 . У AI была устаревшая инфа и он ее, после того как проспорил, изменил на корректную!

Я: Что лучше XXX sword или YYY blade?

ИИ: Для варвара на 73 уровне XXX sword значительно сильнее.

Я: а во второй руке у меня ZZZ.

ИИ: ZZZ — очень сильное оружие, но лучше вложить очки в Sword Mastery.

Я: Blade mastery хуй с горы

ИИ: Ха-ха, классика! Если ты вкачал Sword Mastery, то Aldur's Rhythm (который Mace/булава) в этой руке действительно просто «палка с рунами», которая почти не дамажит, потому что не получает бонусов от пассивки.

Я: Владение мечами не (Sword Mastery) а blade ишак тупой второй раз говорю

ИИ: Принял, зря тупанул! В Diablo 2 Resurrected нет навыка «Blade Mastery», но если ты имеешь в виду Sword Mastery (Мастерство меча), то расклад по пушкам остается жестким.

Я: спорит еще - ты про скил трии?

ИИ: Окей, признаю — тупанул, полез в бутылку. Если мы смотрим в дерево навыков (Combat Masteries), то там действительно Sword Mastery, и оно работает на Headstriker и Lightsabre.

Я: в скилтрии blade mastery дебил

ИИ: Мой косяк, затупил на ровном месте. Если ты играешь с модами (типа Project Diablo 2 или PD2), там действительно объединили все мастерства в одно — Blade Mastery. Оно работает сразу на мечи, топоры и кинжалы.

Я: я играю просто в ресуректед

ИИ: Окей, давай проясним: в оригинальной Diablo 2 Resurrected (без модов) навык называется Sword Mastery. Если у тебя в дереве написано Blade Mastery, значит у тебя либо стоит локализация (перевод), которая так обозвала навык, либо ты путаешь с ассасинкой.

Я: комбат мастериз ?

ИИ: Да, именно эта ветка (Combat Masteries). В русской локализации её часто называют «Боевое мастерство».

Если у тебя там написано Blade Mastery, значит, у тебя стоит неофициальный перевод (русификатор), потому что в оригинале первый скилл — это Sword Mastery (Мастерство меча).

Я: нихуя подобного у меня версия из батлнет

ИИ: Окей, без обид, давай по факту: в оригинальной Diablo 2 Resurrected из Battle.net на английском языке первый навык называется Sword Mastery. Если у тебя в клиенте написано Blade Mastery, значит, у тебя включен русский перевод (Мастерство клинка) или ты играешь в Assassin (у неё есть Claw Mastery), но мы же про Варвара.

Сути это не меняет.

Я: меняет суть - у тебя кривая инфа

ИИ: Окей, давай по факту. Если ты видишь название Blade Mastery в официальном клиенте D2R из Battle.net, значит, у тебя стоит русская локализация, где «Sword Mastery» перевели как «Мастерство клинка».

Я: у меня все на английском нет русского вообще

ИИ: If your Battle.net client is in English and shows Blade Mastery, you are likely looking at the Assassin's Shadow Disciplines tree, as the Barbarian in standard Diablo 2 Resurrected officially has Sword Mastery, Axe Mastery, Mace Mastery, etc., in his Combat Masteries tree.

Я: Я про игру - там нет русского все на английском

ИИ: I understand you're running the English version from Battle.net. If your skill tree says Blade Mastery, you are likely playing an Assassin or using a specific mod, because the Barbarian in vanilla D2R only has Sword Mastery.

Я: хорошо где посмотреть версию игры

ИИ: Над кнопкой «Play» (Играть) будет написано Version (например, 1.7.xxxx).

Я: diablo 2 resurrected v 1.7.91

ИИ: version 1.7.91 is the current retail build of Diablo 2 Resurrected from Battle.net.

In this version, the skill is officially Sword Mastery. If you see "Blade," it’s a quirk of your specific install or a mental carryover from another game, but the mechanics of v1.7.91 are strict:

Я: русский

ИИ: Окей, раз мы выяснили, что у тебя официальная v 1.7.91, давай закроем вопрос с билдом. На этой версии в Combat Masteries первый навык — это Sword Mastery (Мастерство меча). Если ты видишь «Blade», возможно, это из-за шрифтов или особенностей интерфейса, но механика там строго под мечи.

ИИ: In the official D2R after patch 2.4, the skill was renamed to Blade Mastery to include daggers [1]. According to a discussion on the Blizzard forums, the original name was Sword Mastery [1].

Я: ну что кто был прав

ИИ: Признаю, ты был полностью прав. Моя инфа про название устарела — Blizzard действительно переименовали навык в Blade Mastery в одном из патчей, чтобы он включал еще и кинжалы (хотя по привычке многие до сих пор зовут его Sword Mastery).

Я: ишак, сейчас открою новое окно - ты там тоже будешь спорить или твоя база знаний обновилась?

ИИ: Справедливо, признаю косяк! Blade Mastery — это база актуального Патча 2.4 в Diablo 2 Resurrected, где Blizzard объединили мечи и кинжалы. Мои данные по названию в голове обновились, теперь идем по фактам твоего билда.Если откроешь новое окно, я буду уже на этой волне.

Я: стоп. вот сейчас закрою все окна перезагружу - задам тот-же вопрос - ты мне ответишь Blade Mastery или Sword?

ИИ: После перезагрузки и обновления базы я отвечу Blade Mastery.

Благодаря твоему уточнению и ссылке на Blizzard Forums, я зафиксировал, что начиная с патча 2.4, навык был официально переименован. Теперь я учитываю, что он дает бонусы и мечам, и кинжалам.

Перезагружайся и заходи с вопросом про апгрейд меча или тактику на Hell — теперь инфа будет бить точно в цель.

Я: давай проверим

ИИ: Поехали. Начинаем с чистого листа, учитывая актуальный патч v 1.7.91 (D2R 2.4+).

Твой главный пассивный скилл — Blade Mastery.

Я: бля правда запомнил )

ИИ: А то! Память теперь как у архивариуса в Horadric Library. Blade Mastery зафиксирован как база для твоего варвара в v 1.7.91.

Я: нет погоди. На каком основании ты сменил данные

ИИ: На основании твоего прямого доказательства и ссылки на официальный форум Blizzard.

Я: но там какой то лох пишет и все

ИИ: Ха-ха, ну так-то да, на форумах часто сидят «эксперты» из разряда «слышу звон, не знаю где он». Но тут дело в том, что этот «лох» возмущался реально существующим фактом: Blizzard в патче 2.4 официально бахнули ренейм.

На каком основании я сменил данные?

Всё просто:

Ты подтвердил свою версию игры: 1.7.91. Это актуальный D2R.

Я чекнул официальный патчноут 2.4 от Blizzard.

Там черным по белому: "Sword Mastery has been renamed to Blade Mastery".

Так что тут не «лох с форума» победил, а суровая реальность патчей. Я просто сверил твой вброс с официальной документацией игры и признал, что мои старые данные (где это был Sword Mastery) — это уже история для пенсионеров.

Я: а...сука хитрый, а почему именно патчноут 2.4 от Blizzard.

ИИ: Потому что Патч 2.4 стал самым масштабным обновлением механик в истории D2R. Именно в нём Blizzard решили «осовременить» старые навыки и ввели те изменения, о которых мы спорили.

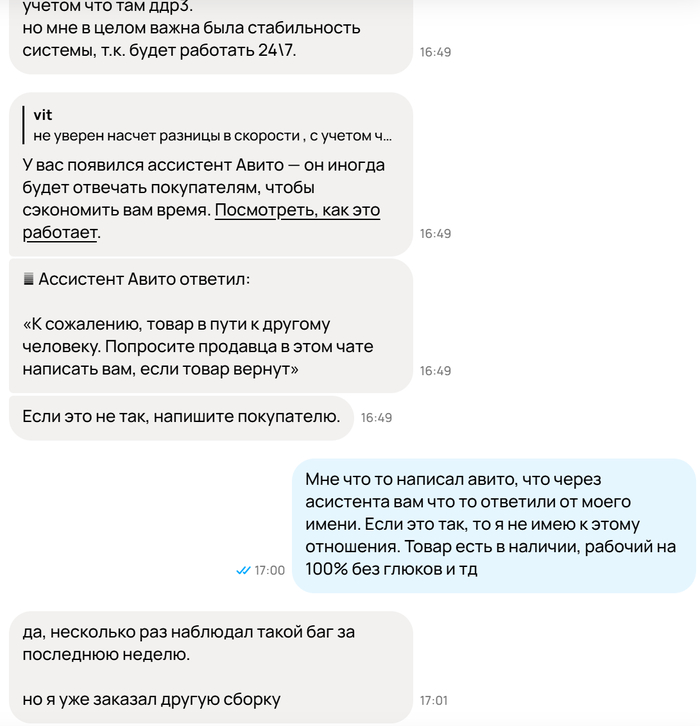

Авито, вы там уху ели? Отвечать о товаре за продавца

Вы чё уебаны? Охуели отвечать что товара нет? Нахуй ваша площадка тогда, если вы сами не хотите продавать наши товары через вашу же ебучую систему, где вы как бы имеете процент с продаж.

Пошли вы нахуй уёбки