История одного полиса

Десять лет назад — страховые конторы смотрели на клиента свысока, будто на назойливую муху. А я — был идеальным клиентом. Молод, неопытен и верил, что услугу можно получить просто — заплатив за неё.

История банальна — требовалось продлить ОСАГО. Машина — не новая, сто десять лошадиных сил. Годом ранее в той же конторе мне уже пытались вручить — будто случайно — полис жизни. Тогда я ушёл. Теперь же думал — а вдруг что-то изменилось?

— Первый звонок. Женский голос, звучавший устало и высокомерно.

— Оформить ОСАГО.

— Впервые у нас в этом году?

— Да.

— Только в головной офис. В Новороссийск.

Положил трубку. Ощущение было странное — будто я отнял у неё время, попросив именно то, за чем пришёл.

— Второй звонок. Головной офис. Голос — холодный, металлический.

— Мощность?

— Сто десять.

— М-да… Вам не к нам. Вам — в «Росгосстрах».

Щелчок в трубке. Машину мою отвергли — сочли недостойной их услуг. Словно лошадиные силы имели отношение к чести.

— Третий звонок. Пятница, без четверти пять.

— Алло, можно оформить…

— Это не телефонный разговор! — рявкнул тот же голос. — Я за рулём! В понедельник!

Щелчок. Короткий, как удар хлыстом.

В понедельник я поехал сам. Очередь, тяжёлые двери, запах дешёвого кофе. За стойкой — Она. Попивала из большой чашки, смотрела в экран. Положил перед ней документы.

— ОСАГО, пожалуйста.

Подняла глаза медленно — будто увидела что-то незначительное и слегка неприятное.

— Без дополнений не оформляем. Следующий.

— Но это незаконно.

— Вы ошиблись дверью.

Отхлебнула кофе. Повернулась к монитору. Разговор был исчерпан.

На улице я достал телефон. Нашёл эту контору на картах. И написал отзыв — сухой, без эмоций. Про хамство, про взгляд поверх очков, про отказ продать то, что обязаны продавать. Не стал кричать — просто констатировал. Маленькая, беспомощная правда — брошенная в бездну интернета.

Полис купил в другом месте. Дороже. А тот отзыв — остался. Иногда смотрю на него. Не из злорадства — а чтобы помнить, как система пытается превратить человека в ничто. И как иногда единственным оружием против этого является простое, тихое свидетельство.

Сегодня — всё иначе. Открываю приложение, пять минут — и полис уже на почте. Ни взглядов, ни разговоров, ни этой тяжёлой двери. Прогресс победил. И теперь эти воспоминания — всего лишь забавная история из прошлого. История о том, как страховая контора пыталась быть цирком, а я — не стал клоуном. От этого — на душе и светло, и смешно.

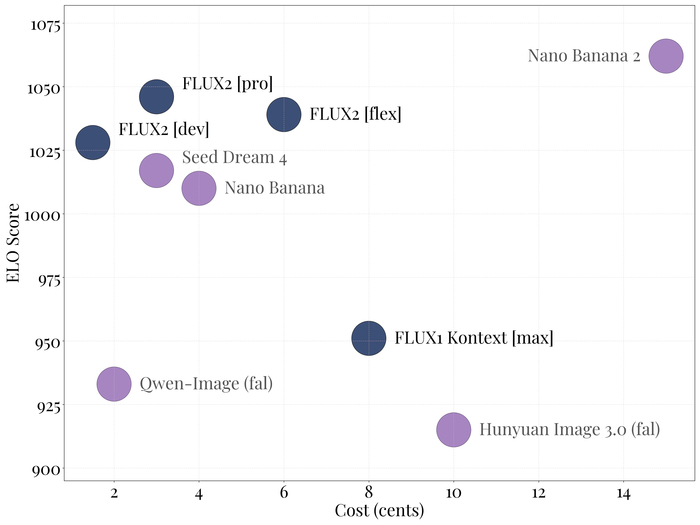

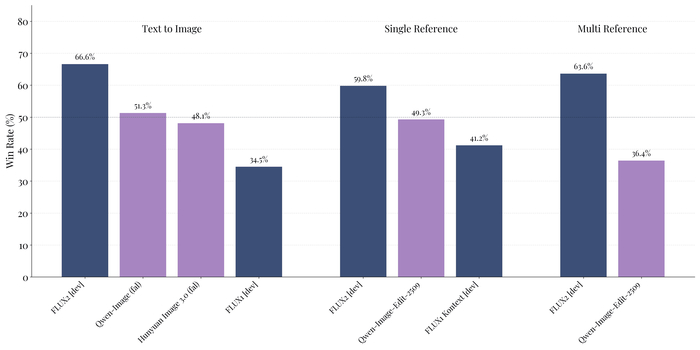

Вышла новая модель для генерации и редактирования изображений FLUX.2

FLUX.2 (https://huggingface.co/black-forest-labs/FLUX.2-dev) продвинутая модель для работы с изображениями. Была создана как инструмент для реального творчества, а не демонстраций. Может генерировать и редактировать качественные изображения (до 4 Мп). Умеет работать с текстом, логотипами, стилем и несколькими образцами (до 10 изображений). Имеет согласованность стиля/персонажа и лучшая в отрасли при использовании нескольких образцов. Что касается детализации и реализма, то модель даёт четкие текстуры, стабильное освещение. Поддерживается работа с текстом, позволяя создавать надежный рендеринг сложной типографики и инфографики. Модель точно выполняет сложные и структурированные запросы, а также лучше понимает логику сцен, освещения, пространства.

Доступно несколько версий:

· [pro] Максимальное качество и скорость. Готовое решение.

· [flex] Полный контроль для разработчиков над качеством и скоростью. Лучший для текста.

· [dev] Самая мощная open-source модель (32 млрд параметров). Доступна для локального запуска.

· [klein] (пока не вышла) Уменьшенная open-source версия (Apache 2.0).

Чтобы всё это работало, используют архитектуру на основе Mistral-3 (24B) и выпрямленного трансформер потока. А также новый VAE для улучшения баланса между качеством и сжатием.

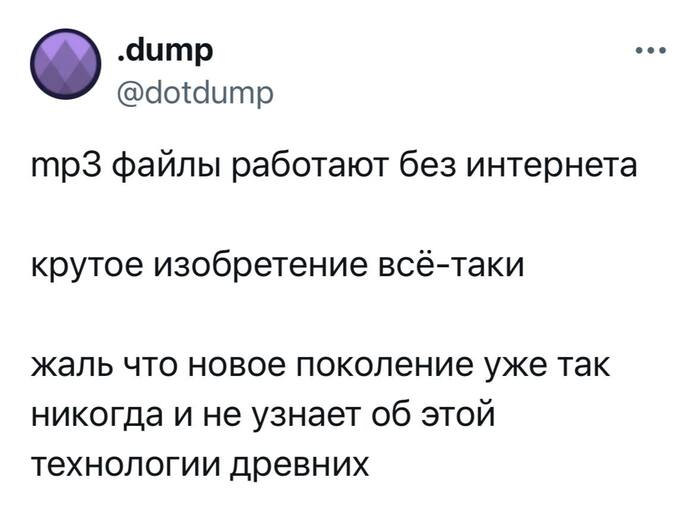

Ответ на пост «Великая цивилизация»1

Нет. Возвращается народ к истокам и мое то- что у меня на жестком диске.

М.Видео фиксирует рост продаж портативных плееров за 9 месяцев 2025 года в 2,2 раза год к году https://habr.com/ru/companies/mvideo/news/967758/

Великая цивилизация1

Мы в телеграм канале - https://t.me/roflemem/7021

Помогите найти программу(-ы) для симуляции C. elegans на ПК полностью офлайн

Требования к предложенным программам:

1. Полностью бесплатная и без ограничений программа.

2. Простая установка, как обычной программы, используя exe (без докеров и так далее).

3. Понятный интерфейс.

4. Узкоспециализированная программа только для этой задачи.

5. Запрещается находить универсальные программы, косвенно связанные с задачей.

6. Поддержка Windows 10 или какой либо другой Windows.

Яндекс карты. Бред какой-то

Поехал на пару дней в Москву из Беларуси. Скачал карты Москвы и Московской области. Офлайн попытался без интернета включить карты, нифига не работает. Офлайн - я понимаю же так - БЕЗ интернета? Какого лешего они не работают????

просто тупо висит карта пустая и все. Нажимаю на кнопку своего местоположения - эмоций нет. Ах да, ЖПС включен.

Как их запустить без интернета ? Или работать не будет? Нахера тогда качать офлайн? Чтобы при включенном интернете не докачивало прорисовку местности?

ну бред же....блин....бред .

Свободного места 500 гигов .

Ответ на пост «Плакат "ЦИФРОВАЯ ГИГИЕНА"»1

DeepSeek написал о цифровой гигиене:

Отличный вопрос! **Цифровая гигиена** — это совокупность правил и практик, направленных на поддержание безопасности, порядка и психологического комфорта в цифровой среде. Это то же самое, что и личная гигиена, но для вашей онлайн-жизни.

Вот подробный гид по основным аспектам цифровой гигиены.

### 1. Безопасность и защита данных

Это основа основ. Цель — защитить ваши аккаунты и данные от взлома и кражи.

* **Надежные и уникальные пароли:**

* Используйте **менеджер паролей** (KeePass, Bitwarden, 1Password). Это главный инструмент цифровой гигиены. Он создаст и запомнит за вас сложные пароли.

* **Никогда не используйте один и тот же пароль на разных сайтах.** Если один сервис взломают, злоумышленники попробуют этот же пароль и почту на других ресурсах.

* Пароль должен быть длинным (фраза из нескольких слов) или сложным (набор символов).

* **Двухфакторная аутентификация (2FA):**

* Всегда включайте, где это возможно. Это второй уровень защиты, даже если пароль украдут.

* Используйте **приложения-аутентификаторы** (Google Authenticator, Authy, Microsoft Authenticator) вместо SMS, так как SIM-карту можно клонировать.

* **Осторожность с фишингом:**

* Не переходите по подозрительным ссылкам в письмах, мессенджерах и соцсетях, даже если они от знакомых.

* Всегда проверяйте адрес отправителя и URL сайта, на который вас ведут. Официальные домены часто пишутся с опечатками.

* **Обновления программного обеспечения:**

* Регулярно обновляйте операционную систему, браузер, антивирус и все приложения. Обновления часто закрывают критические уязвимости безопасности.

* **Разграничение доступа:**

* Внимательно читайте, к чему просит доступ приложение (например, игра просит доступ к вашим контактам и фото — это повод насторожиться).

* Не используйте одну и ту же почту для всего. Заведите отдельный ящик для важных аккаунтов (банк, работа) и второй — для разовых регистраций и рассылок.

### 2. Управление цифровым следом и репутацией

Все, что вы делаете в сети, оставляет след. Важно им управлять.

* **Проверка настроек конфиденциальности:**

* Раз в полгода проверяйте настройки конфиденциальности в соцсетях (ВК, ОК и т.д.). Кто видит ваши посты, список друзей, фото с геометками?

* Ограничьте круг лиц, который видит вашу личную информацию.

* **Осторожность в публикациях:**

* Помните: всё, что попало в интернет, остаётся в нем если не навсегда, то надолго. Даже в Stories и приватных чатах.

* Не выкладывайте в открытый доступ сканы паспортов, билетов, документов, банковских карт, свои полные ФИО, адрес, номер телефона.

* **Анализ цифрового следа:**

* Периодически вводите свое имя и фамилию в поисковиках, чтобы видеть, какая информация о вас доступна публично.

### 3. Информационная гигиена и психологическое здоровье

Информационный шум и токсичный контент сильно влияют на ментальное состояние.

* **Критическое мышление:**

* Проверяйте информацию в нескольких **надежных источниках**, прежде чем сделать вывод или поделиться новостью.

* Не доверяйте громким заголовкам и эмоциональным постам (с кликбейтным заголовком).

* **Кибербуллинг и токсичное общение:**

* Не вступайте в бесполезные споры с троллями. Лучший способ — игнорировать и блокировать.

* Не бойтесь использовать кнопку «Пожаловаться» на оскорбительный контент.

* **Цифровой детокс и управление вниманием:**

* **Отключайте уведомления** у ненужных приложений. Постоянные пуши разрушают концентрацию.

* Выделяйте время в день, когда вы **полностью offline** (например, за час до сна и первый час после пробуждения).

* Проводите **ревизию подписок**: отпишитесь от аккаунтов и пабликов, которые вызывают у вас тревогу, зависть или раздражение. Подпишитесь на то, что приносит пользу и радость.

* **Контроль экранного времени:**

* Используйте встроенные в smartphone функции («Экранное время» на iOS, «Digital Wellbeing» на Android), чтобы отслеживать, сколько времени вы проводите в приложениях, и устанавливать лимиты.

### 4. Порядок на устройствах и в данных

Беспорядок на компьютере и в телефоне приводит к стрессу и потере продуктивности.

* **Резервное копирование:**

* Регулярно делайте бэкапы важных данных! Правило 3-2-1: **3** копии данных, на **2** разных носителях, **1** из которых хранится в другом месте (например, облако + внешний жесткий диск).

* Используйте облачные сервисы (Google Drive, iCloud, Яндекс.Диск) для синхронизации самых важных файлов.

* **Очистка и организация:**

* Разбирайте загрузки, удаляйте ненужные файлы и приложения.

* Сортируйте файлы по папкам, а не храните всё на рабочем столе.

* Чистите кэш браузера и cookies.

* **Пароли и доступы:**

* Убедитесь, что ваши близкие имеют доступ к критически важным аккаунтам в случае чрезвычайной ситуации (например, через данные менеджера паролей).

### Краткий чек-лист для старта:

1. **Установите менеджер паролей** и обновите ключевые пароли.

2. **Включите 2FA** на почте, соцсетях и в банковских приложениях.

3. **Проверьте настройки конфиденциальности** в соцсетях.

4. **Почистите подписки** и отключите уведомления у половины приложений.

5. **Сделайте бэкап** самых важных файлов и фото.

6. **Удалите** неиспользуемые приложения и почистите рабочий стол.

**Вывод:** Цифровая гигиена — это не разовое действие, а постоянная привычка. Начать можно с малого — с одного пункта в день. Эти простые действия значительно повысят вашу безопасность, снизят уровень стресса и помогут навести порядок в вашей цифровой жизни.