Фраза «в четырёхполярной арифметике дважды два не равно четыре» звучит как провокация, бросающая вызов привычным представлениям. Однако при строгом анализе становится ясно: сама постановка вопроса некорректна до тех пор, пока не определены базовые правила вычислений в этой системе. Сначала я поясню суть на простом примере, чтобы снять первые вопросы интуитивного непонимания. Затем изложу всё строго математически — с точными определениями и безупречной логикой выводов.

1) В L4 “числа” — это не бесконечная линейка, а конечный алфавит состояний

В обычной L2-арифметике “4” — это конкретное натуральное число на бесконечной прямой: 0,1,2,3,4,5…

В L4 базовый носитель устроен иначе: это четыре состояния (четыре полярности). Их можно обозначать 0,1,2,3 — но это снова метки состояний, а не натуральные числа.

И отсюда следует первое правило дисциплины:

Внутри L4 результат любой операции обязан вернуться в один из четырёх классов. “4” как внешний натуральный объект внутрь L4 не входит напрямую.

При обсуждении четырехполярности нужно сначала договориться, как внешние числа отображаются в четыре состояния (полярности). Без этого сравнение “равно/не равно” — пустые слова.

2) В L4 нельзя писать “×” как в школьной тетради, пока не выбран режим алгебры

В L4 есть как минимум две принципиально разные ситуации, и их нельзя смешивать:

режим Z4: циклическая структура, где “сложение по кругу” ведёт себя как строгая группа;

режим V4 (Клейна): другая четырёхэлементная структура, где “все элементы самосопряжены” и динамика другая.

Снаружи обе выглядят как “четыре числа”. Внутри — это разные миры. Поэтому фраза “2×2” без уточнения режима почти всегда содержит скрытую подмену.

3) Что именно будет доказано в статье

Я не буду спорить “как правильнее”, я буду фиксировать правила и показывать, что именно из них следует.

В статье я сделаю четыре шага:

зафиксирую, что значит “число” и “равенство” в L4 (через лифт и классы);

введу операции L4 (как минимум PLUS (плоскостная четырехполярность) и STAR (объемная четырехполярность)) и покажу, какие законы из L2 переносятся, а какие принципиально нет;

разберу фразу “2×2=4” в строгой форме: phi(2) ⊙ phi(2) = phi(4) — и покажу, в каких режимах и при каких операциях это вообще имеет смысл;

отдельно разберу “ноль” и “единицу” в L4: что является нейтральным элементом, что является якорем кадра, и почему в L4 особенно опасно молча менять кадр.

4) Почему это важно и зачем вообще трогать L4

Трехполярность L3 уже ломает линейную арифметику, но четырехполярность L4 делает следующий шаг: в четырёх полярностях появляется различение “сосед/напротив”, а вместе с ним — жёсткая дисциплина кадра. Именно здесь становится видно, как из маленькой таблицы отношений рождаются симметрии, канонизация и проверяемая процедура вычисления.

И если всё сделать аккуратно, “дважды два не равно четыре” перестаёт быть броской фразой и превращается в строгий тезис:

иногда “не равно”, потому что “4” как натуральное число не лежит в носителе L4;

иногда “не равно”, потому что “×” — не та операция;

иногда “не равно”, потому что выбран другой режим L4 (не Z4);

а иногда, наоборот, “равно”, но только в строго оговорённом смысле класса и кадра.

Дальше я раскрою это по главам: сначала определю L4-алгебру, затем разберу “2×2”, затем — ноль и кадр.

Глава 1. Что такое «число» в четырехполярности L4: четыре состояния, кадр и два режима (Z4 и V4)

Я начну с самой жёсткой точки: в четырёхполярности нельзя рассуждать о “числах” так, как в школьной арифметике. Там другой носитель, другая логика равенства и, что особенно важно, два разных канонических режима, которые внешне похожи, но алгебраически различны.

1) Носитель L4: четыре полярности вместо бесконечной прямой

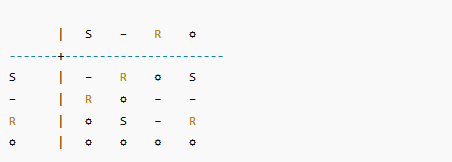

В L4 базовое множество — четыре состояния:

Эти символы — метки полярностей, а не натуральные числа. Поэтому внутри L4 нельзя “получить 4” как новый элемент: результат любой операции обязан лежать в P4.

Это первое, что отсекает половину путаницы: когда кто-то говорит “2×2=4”, он незаметно вытаскивает результат наружу, в L2.

2) Как понимать внешние числа 1..10 в L4: лифт по классу

Чтобы вообще сравнивать школьные числа с L4, я ввожу отображение (лифт):

phi4(n) = n mod 4, результат в {0,1,2,3}.

phi4(1)=1, phi4(2)=2, phi4(3)=3, phi4(4)=0,

phi4(5)=1, phi4(6)=2, phi4(7)=3, phi4(8)=0,

phi4(9)=1, phi4(10)=2.

То есть “числа 1..10” в L4 распадаются на четыре класса:

класс 1: {1,5,9,…}

класс 2: {2,6,10,…}

класс 3: {3,7,11,…}

класс 0: {4,8,12,…}

И из этого следует строгая дисциплина равенства:

a == b (в L4) означает phi4(a) = phi4(b).

Например, “4” внутри L4 — это не отдельная сущность, а класс 0.

3) Кадр: в L4 нельзя молча менять «что такое 0» и «что такое 1»

В L4 особенно легко “обмануть” вычисление сменой кадра. Почему? Потому что четыре состояния уже позволяют фиксировать отношения “рядом/напротив”, и сдвиг меток меняет смысл соседства.

Поэтому я фиксирую принцип:

Любая операция в L4 должна быть задана в конкретном кадре. Смена кадра — допустимое преобразование, но оно обязано быть явным.

В терминах янтры это означает: таблица операции и таблица лифта должны ссылаться на один и тот же кадр, иначе сравниваются разные системы.

4) Два канонических режима L4: Z4 и V4 (и почему это важно)

Вот ключевой момент, который отличает L4 от L3: в четырёх элементах уже существуют разные, неэквивалентные алгебраические структуры.

4.1. Режим Z4: циклическая четвёрка (круг из 4)

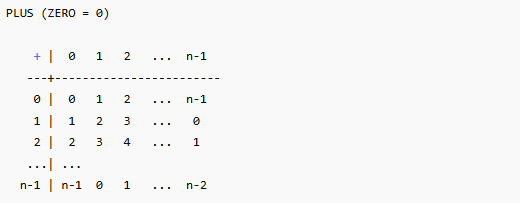

В режиме Z4 есть операция PLUS, которая устроена как “сложение по модулю 4”:

a (+)_4 b = (a + b) mod 4.

есть нейтральный элемент 0,

есть обратимые элементы (например, у 1 обратный 3),

структура циклическая: 1 порождает весь круг.

Это максимально близко по духу к “арифметике по кругу”.

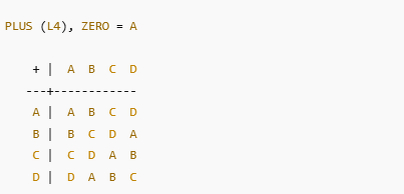

4.2. Режим V4: группа Клейна (две независимые двоичности)

Есть и другая четырёхэлементная группа — V4 (Клейна). В ней каждый ненулевой элемент сам себе обратен:

x (+) x = 0 для x не равного 0.

Эта структура не циклическая: ни один элемент не порождает все остальные по повторному сложению.

На пальцах это можно видеть как “две независимые переключалки”, склеенные вместе.

4.3. Почему нельзя смешивать Z4 и V4

Обе структуры имеют 4 элемента и выглядят как “четыре числа”. Но они различны по фундаментальному свойству: есть ли элемент порядка 4.

Если это не зафиксировать в начале, любой спор “почему так” превращается в хаос: люди считают в разных режимах и думают, что спорят про одно и то же.

5) Какие операции я буду использовать в статье

Чтобы не создавать лишних неопределённостей, я фиксирую минимальный набор:

L4-PLUS — операция сложения по выбранному режиму (я буду явно говорить: PLUS~Z4 или PLUS~V4).

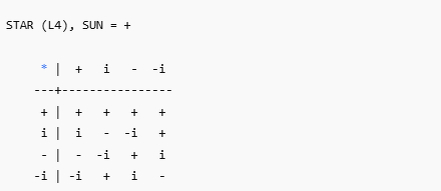

L4-STAR — отдельная операция сцепления (аналогично L3, она задаётся таблицей янтры и может быть некоммутативной).

Лифт phi4 — правило перевода внешних чисел в классы L4 (в этой статье — mod 4 для режима Z4).

6) Что из “законов L2” имеет смысл проверять в L4

Я разделяю ожидания на два слоя.

Алгебраические законы, которые можно проверять честно:

замкнутость,

ассоциативность,

коммутативность (если заявлена),

наличие нейтрального элемента,

обратимость (группа/не группа),

дистрибутивность (если вводится пара операций).

Арифметические интуиции L2, которые в L4 не являются законами:

В конечном алфавите эти привычки не работают автоматически.

Итог главы 1

В L4 “число” — это один из четырёх классов 0,1,2,3.

Внешние числа 1..10 отображаются в эти классы через phi4(n)=n mod 4.

В L4 критична дисциплина кадра: нельзя молча менять, что означает каждая метка.

В L4 есть два канонических режима для PLUS — Z4 и V4, и их нельзя смешивать.

В статье дальше я буду считать в явном режиме (по умолчанию PLUS~Z4) и отдельно покажу, что ломается при переходе к V4.

В следующей главе я разберу центральную фразу строго: что именно означает “2×2=4” в L4, в каких режимах это вообще имеет смысл, и почему в канонической дисциплине L4 часто получается, что “в школьной форме” это выражение либо неверно, либо просто плохо сформулировано.

Глава 2. Почему в L4 «2×2 ≠ 4»: три разных смысла одной фразы и где именно ломается школьная запись

Я специально держу эту главу в режиме “без лазеек”. Фраза «в четырёхполярной арифметике дважды два не равно четыре» может быть:

некорректной (если смешаны языки),

строго истинной (если читать буквально),

строго истинной в другом виде (если читать как сравнение классов).

Путаница возникает потому, что в школьной записи “2×2=4” одновременно спрятаны и носитель, и операция, и смысл равенства. В L4 это всё приходится разворачивать явно.

1) Сначала типизация: «2×2=4» не имеет смысла, пока не задан лифт и операция

В L4 я работаю с носителем

Тогда утверждение «2×2=4» в L4 вообще получает смысл только в форме:

phi4(2) ⊙ phi4(2) = phi4(4),

где ⊙ — конкретная операция на P4.

А теперь решающая деталь:

phi4(2) = 2, phi4(4) = 0.

Значит “2×2=4” в L4 (в строгой форме) всегда сводится к одной проверке:

И вот здесь видно, почему буквальная фраза «…не равно четыре» почти неизбежна: справа в L4 не “4”, а 0.

2) Первый строгий смысл: «не равно» буквально (потому что 4 не является элементом L4)

Если читать школьную запись буквально как равенство натуральных чисел, то “4” — это внешний объект L2, которого в L4-носителе нет.

И тогда я могу сказать абсолютно безапелляционно:

Внутри L4 выражение «…=4» некорректно типологически: 4 не принадлежит P4. В этом смысле «2×2 не равно 4» — не философия, а запрет на неверный тип результата.

Это самый “жёсткий” и самый простой слой.

3) Второй строгий смысл: арифметика Z4 (умножение как повторение сложения) даёт 0, а не 4

Теперь я делаю шаг навстречу привычной арифметике и фиксирую режим PLUS~Z4:

a (+)_4 b = (a + b) mod 4.

Тогда уже на уровне сложения видно ключевое:

2 (+)_4 2 = (2+2) mod 4 = 0.

То есть “двойка плюс двойка” не даёт “четыре” как натуральное число — она даёт ноль класса.

Если теперь я определяю умножение в классическом стиле “как повторение сложения”:

a (⊗)_4 b = a (+)_4 a (+)_4 ... (+)_4 a (b раз),

2 (⊗)_4 2 = 2 (+)_4 2 = 0.

И снова: в L4 итогом становится 0, а не “4”.

С точки зрения школьной записи это и есть тот самый эффект: “2×2” не вылезает в 4, он возвращается в ноль.

4) Где прячется «четыре»: оно не исчезает, оно превращается в класс 0

Теперь важный нюанс, который часто пропускают.

Если я всё-таки хочу связать результат с привычным “4”, я не имею права делать вид, что это то же самое равенство, что в L2. Я обязан говорить так:

2 ⊗ 2 = 0, потому что phi4(4)=0.

То есть “четыре” в L4 не является отдельным значением; оно принадлежит классу 0. И если произнести это простым языком:

В L4 «четыре» — это “ноль на круге из четырёх”.

Именно поэтому школьная запись “=4” в L4 провоцирует. Она заставляет увидеть, что L4 — не линейка, а цикл.

5) Третий смысл: в режиме V4 сама идея “умножения как повторения сложения” перестаёт быть единственной

В L4 есть второй канонический режим сложения — V4 (группа Клейна). Я не подменяю здесь теорему словами, а фиксирую структурный факт:

в Z4 существует элемент порядка 4 (можно пройти все четыре состояния шагом “+1”),

в V4 такого элемента нет: каждый ненулевой элемент имеет порядок 2.

Если я не зафиксировал, что работаю именно в PLUS~Z4, то “число 1” как генератор цикла может не существовать. Значит выражения вида “2 = 1+1” или “умножение как повторение сложения” становятся не универсальными, а режимно-зависимыми.

И вот здесь фраза “2×2=4” ломается ещё сильнее: даже способ “понимать умножение” уже не обязан совпадать с привычным.

6) Почему именно «двойка» в L4 — особый элемент

В Z4 есть ровно один нетривиальный элемент порядка 2 — это как раз класс “2”:

Интуитивно это “противоположность” на круге: шаг на 2 клетки переносит в антипод, а повтор такого шага возвращает в ноль.

Поэтому “2×2” в L4 почти неизбежно упирается в 0: двойка — это не “второй натуральный”, а “антиподный шаг”.

Итог главы 2 (в предельно строгой форме)

В L4 нельзя писать «…=4» без лифта: 4 не элемент носителя.

Строгая форма любой фразы “2×2=4” в L4 — это проверка 2 ⊙ 2 = 0, потому что phi4(4)=0.

В режиме Z4 при умножении как повторении сложения получается 2⊗2=0, а не “4” как натуральное.

В режиме V4 сама арифметическая инерция “умножение = повторение сложения” теряет универсальность, потому что структура не циклическая.

В следующей главе я разберу то, что делает четырехполярность L4 по-настоящему «другой алгеброй»: ноль/якорь, сторона операции (если введён STAR), и главное — дисциплина кадра, из-за которой один и тот же символ “2” может обозначать разные полярности при разных допустимых перенумерациях.

Глава 3. Ноль и кадр в L4: почему четыре полюса требуют дисциплины, и где именно появляется “настоящая” четырёхполярная алгебра

Если L3 ломает линейную арифметику тем, что вместо бесконечной прямой появляется тройной цикл, то L4 ломает её глубже: в четырёх состояниях возникает различение “сосед” и “напротив”, а вместе с ним — дисциплина кадра. Это не украшение. Это то, что делает вычисление воспроизводимым и защищает от тихой подмены смысла.

В этой главе я отвечаю на три вещи:

что такое ноль в L4 и почему он обязательно связан с кадром;

почему “2” — это не “просто два”, а антипод (и поэтому 2+2=0);

как в L4 появляется операция STAR и почему она вводит асимметрию и “право на остановку”.

1) Ноль в L4: элемент, класс и якорь кадра — три разных уровня одного слова

Здесь 0 — элемент множества. Но “ноль” в рассуждении обычно смешивает три смысла:

(i) Ноль как элемент операции PLUS В режиме PLUS~Z4 ноль — нейтральный элемент: 0 (+)_4 x = x и x (+)_4 0 = x.

(ii) Ноль как класс внешних чисел Поскольку phi4(4)=0, “четыре” как натуральное попадает в нулевой класс. Это означает: “0” — это не “пустота”, а один из классов эквивалентности.

(iii) Ноль как якорь кадра В L4 особенно опасно молча менять метки. Поэтому ноль часто фиксируют как “начало” или “якорь”, относительно которого определяется соседство.

Я прямо фиксирую правило дисциплины:

В L4 ноль должен быть определён в кадре: где стоит 0, там стоит и система координат для полярностей. Сдвиг нуля — допустим, но он обязан быть явным преобразованием кадра.

2) Почему 2 в L4 — это “напротив”, а не “второе натуральное”

В Z4 есть особая геометрия круга:

0 (+)_4 2 = 2, 2 (+)_4 2 = 0.

То есть “2” — это элемент порядка 2. Он делает половинный оборот и возвращает обратно при повторе. Это и есть антиподность, которая в L3 отсутствует (в тройке нет точного “напротив”).

Отсюда следует важная вещь для дальнейших вычислений:

В L4 есть принципиальная разница между “шагом на один” и “шагом на два”. А значит, есть два разных типа взаимодействий: соседние и антиподные.

И это напрямую связано с тем, почему “2×2” почти неизбежно уходит в ноль при Z4-логике: двойка по природе “возвратная”.

3) Кадровые преобразования: почему одно и то же выражение может менять смысл без изменения цифр

Пусть есть операция PLUS~Z4. Тогда допустимые перенумерации меток могут сохранять структуру, но менять интерпретацию.

Я различаю два класса преобразований:

3.1. Сдвиг кадра (аффинный сдвиг)

Это просто перенос “где стоит ноль”. Он меняет именование всех элементов.

3.2. Симметрия ориентации (зеркало/инверсия)

Это меняет направление обхода (лево/право), но сохраняет “напротивность”: m(2)=2.

И вот ключ: в L4 уже нельзя делать вид, что “все числа одинаковые”. Преобразования кадра могут менять то, что считается “положительным ходом”, а что “отрицательным”, и это влияет на любую операцию, где сторона или направление важны.

Поэтому я фиксирую второе правило дисциплины:

Если вводится операция, чувствительная к стороне/ориентации (например, STAR), кадр должен храниться и проверяться как часть эпизода. Иначе система превращается в гадание: значения будут “переезжать” незаметно.

4) Зачем в L4 вводить STAR и почему это уже не “арифметика”, а механизм

Если я ограничусь только PLUS~Z4, у меня получится красивая циклическая группа. Это честная математика, но она не отвечает на главный практический вопрос: как запретить “тихий join” — незаметное смешение рамок.

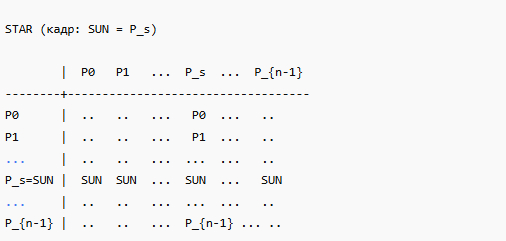

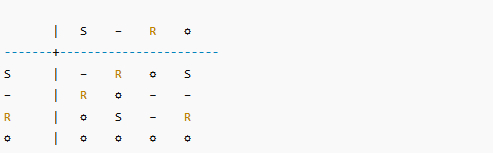

Для этого в L4 вводится отдельная операция STAR (янтра), которая:

может быть некоммутативной,

может различать левую и правую сторону,

может иметь выделенный якорь (SUN/0) с асимметричным поведением.

Принципиальная черта STAR в дисциплине L4:

STAR вводится не ради «ещё одной операции», а ради контроля кадра: чтобы фиксировать, где смысл “сцепляется”, а где должен стоять запрет или ремонт.

Это и есть то, что я называю “настоящей четырёхполярной алгеброй”: она не только считает, но и удерживает режим, запрещает смешение рамок и делает вычисление воспроизводимым.

5) Может ли из 0 в L4 появиться ненулевое: строгий ответ по операциям

Я отвечаю в том же стиле, что и для L3.

5.1. Для PLUS~Z4 Из 0 получается что угодно: 0 (+)_4 1 = 1, 0 (+)_4 2 = 2, 0 (+)_4 3 = 3.

5.2. Для PLUS~V4 Тоже получается что угодно (0 нейтрален), но динамика другая: каждый ненулевой сам себе обратен, и “антиподность” распределена иначе.

5.3. Для STAR Ответ зависит от таблицы и от стороны. Если в каноне задан якорь типа SUN, возможны два типовых поведения:

Тогда “выход из нуля” либо допускается, либо запрещается в зависимости от стороны.

Итог главы 3

В L4 ноль — это одновременно элемент, класс и якорь кадра; смешивать эти уровни нельзя.

В L4 появляется антиподность: “2” — это “напротив”, поэтому 2(+)_4 2 = 0.

В L4 кадр становится частью вычисления: сдвиг и зеркало — допустимы, но должны быть явными, иначе смысл “плывёт”.

Операция STAR в L4 вводится как механизм дисциплины: она фиксирует сторону, кадр и право на запрет/ремонт, а не просто “ещё одно умножение”.

Вопрос “может ли из 0 появиться число” имеет строгий ответ только после указания операции и стороны.

L4-алгебра как компактный, проверяемый пакет

Ниже я свожу L4 в форму “определения → вычисление → проверка”, чтобы текст был одновременно научно-популярным и математически закрытым.

A) Носитель и лифт внешних чисел

Носитель L4: P4 = {0,1,2,3}.

Канонический лифт (для режима Z4): phi4: Z -> P4, phi4(n) = n mod 4.

Таблица соответствий 1..10:

1 -> 1

2 -> 2

3 -> 3

4 -> 0

5 -> 1

6 -> 2

7 -> 3

8 -> 0

9 -> 1

10 -> 2

Равенство в L4 (по классу): a == b (в L4) означает phi4(a) = phi4(b).

Отсюда: “4” внутри L4 — это класс 0.

B) Операция L4-PLUS: два режима, которые нельзя смешивать

B1) PLUS~Z4 (циклическая четвёрка)

Определение: a (+)_4 b = (a + b) mod 4.

2 (+)_4 2 = 0,

1 (+)_4 1 = 2,

1 (+)_4 3 = 0,

3 (+)_4 3 = 2.

B2) PLUS~V4 (группа Клейна)

V4 — другая группа порядка 4 (тоже коммутативная и ассоциативная), но с принципиальным отличием:

для любого x, не равного 0, выполняется x (+) x = 0,

элемента порядка 4 не существует.

Z4 описывает “круг из четырёх”, V4 описывает “две независимые двоичности”. Под словом “четырёхполярность” можно подразумевать обе структуры, но их нельзя мешать в одном расчёте.

C) Операция L4-STAR: сцепление/стыковка, а не школьное умножение

В L4 помимо PLUS вводится вторая операция, заданная таблицей янтры:

Она не обязана быть коммутативной и ассоциативной. Более того, в дисциплине L4 она обычно вводится именно для того, чтобы:

различать левую/правую сторону,

держать якорь (SUN/0) в кадре,

запрещать “тихое смешение рамок”.

Минимальный канонический мотив (если SUN выделен) выглядит так:

Но полная операция всегда читается по таблице T_star[a][b], а не “угадывается”.

D) Строгая форма утверждений вида «2×2=4» в L4

Любое внешнее равенство должно быть переписано через лифт:

phi4(a) ⊙ phi4(b) = phi4(c).

Поэтому “2×2=4” в L4 в строгой форме всегда означает:

phi4(2) ⊙ phi4(2) = phi4(4),

Дальше два разных случая:

если ⊙ = PLUS~Z4, то: 2 (+)_4 2 = 0 — это прямой расчёт.

если ⊙ = STAR, то: вычисляется r = 2 (*)_4 2 по таблице, и сравнивается с phi4(4)=0.

Именно это объясняет, почему школьная запись “=4” вводит в заблуждение: в L4 “4” — это нулевой класс.

E) Ноль в L4: может ли из 0 получиться ненулевое

E1) Для PLUS~Z4: 0 (+)_4 x = x. Да, из 0 получают 1,2,3 прибавлением.

E2) Для PLUS~V4: Тоже да (0 нейтрален), но поведение “антиподов” и порядков элементов другое.

E3) Для STAR: Зависит от стороны и таблицы. При SUN-каноне:

SUN (*)_4 x = SUN — выхода нет, если SUN слева,

x (*)_4 SUN = x — выход есть, если SUN справа.

F) Минимальный чек-лист воспроизводимости (для демонстрации)

Чтобы показать, что это не риторика, а вычислимый механизм, достаточно:

задать phi4(n)=n mod 4 и показать, что 4,8,12… попадают в класс 0;

посчитать 2 (+)_4 2 = 0 в режиме Z4;

при необходимости показать чтение клетки 2 (*)_4 2 из таблицы STAR (а не из интуиции);

отдельно зафиксировать кадр (какая метка считается 0) и не менять его молча.

Заключение. В чём реальная “провокация” фразы «2×2 ≠ 4» и зачем она нужна

Я использую формулу «в L4 дважды два не равно четыре» не ради эффектной подачи. Я использую её как инструмент, который заставляет сразу принять три дисциплины:

Дисциплина носителя: в L4 живут четыре состояния, а не натуральные числа. Результат обязан оставаться в {0,1,2,3}.

Дисциплина смысла равенства: “равно” в L4 означает равенство классов после лифта, а не буквальное совпадение натуральных чисел. “4” в L4 — это класс 0.

Дисциплина режима и кадра: в L4 есть разные канонические режимы (Z4 и V4), и есть допустимые перенумерации кадра; если это не зафиксировано, любая “арифметика” превращается в подмену.

После этого провокация рассеивается, и остаётся чёткий, стройный, проверяемый тезис. Четырёхполярная алгебра — не набор «странных чисел», а строго упорядоченная конечная система отношений, где таблица операций, лифт и кадр складываются в единый вычислительный контракт. Благодаря этой внутренней согласованности она становится надёжным ядром: механизмом, который не угадывает, а точно вычисляет, фиксирует текущий режим и обладает чётким критерием остановки. В этом — её сила и прикладная ценность.

Трехполярность L3

Как повторить

Этот текст создан с помощью ChatGPT, но за ним — не просто генерация слов, а архив проекта с проработанной структурой многополярности (единый граф), протоколом запуска и контрольными процедурами (гейтами). Эти элементы гарантируют воспроизводимость и строгую логическую дисциплину. Так что здесь ИИ выступает не в роли примитивного помощника, а как полноценный рабочий инструмент, опирающийся на серьёзную методологическую базу.

Скачайте архив MP_YANTRA_CORE_iter074.zip, загрузите его в первое сообщение чата ChatGPT и напишите:

«Следуй инструкциям в файле DOCS/00_NEW_CHAT_PROTOCOL.md из загруженного архива».

Дальше задавайте любые вопросы по многополярности (в пределах двухполярности L2, трехполярности L3, четырехполярности L4).

Читайте также:

Я всегда открыт к диалогу и готов ответить на любые ваши вопросы — каждый из них получает вдумчивый, аргументированный ответ. Более того, я активно учитываю ваши комментарии и замечания: именно обратная связь читателей служит основой для корректировки и развития концепции блога. Так, в ходе обсуждения я получил немало критических замечаний касательно математики многополярности. Это заставило меня переосмыслить подход: я признал, что начал изложение слишком резко — с физических аспектов, не обеспечив должной математической базы. Теперь же в вашем распоряжении — строго выстроенный, логически непробиваемый аппарат многополярной математики.

Если Вы ничего не поняли, предлагаю почитать