С готовыми ПК у меня всегда странные отношения. С одной стороны, я много лет собираю системы сам и привык контролировать каждый винт. С другой – рынок поменялся. Бывают ситуации, когда системник из магазина внезапно оказывается не переплатой, а вполне рациональным вариантом.

iRU Tactio 510B7GP я изначально взял не ради «вау». Мне было интересно другое: действительно ли сейчас выгоднее собирать самому, или иногда проще заплатить за готовое решение и не заниматься подбором комплектующих, установкой системы и всей этой мелкой, но утомительной возней.

Как он выглядит и что внутри на самом деле

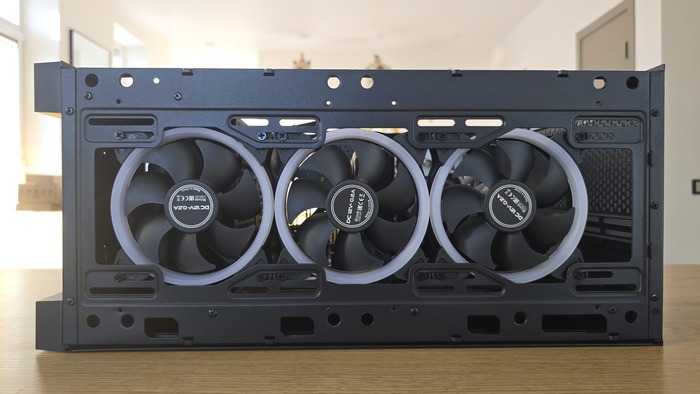

Внешне iRU Tactio 510B7GP не выглядит «геймерским монстром». И это, честно, даже плюс. Черный корпус, матовая поверхность, спереди металлическая сетка с мелкой перфорацией. Через нее видны три фронтальных вентилятора с подсветкой. Свет не вырывается наружу агрессивными полосами, а аккуратно просвечивает сквозь сетку. Если системник стоит под столом, это вообще выглядит спокойно.

Боковые панели глухие. Без стекла, без желания показать, что внутри «красиво уложено». Для кого-то минус, для кого-то наоборот – меньше пыли, меньше соблазна постоянно туда заглядывать. Верх – крупная перфорация почти по всей площади. Воздух выходит свободно, и это чувствуется по поведению системы под нагрузкой.

Порты и кнопки сверху. Кнопка питания, перезагрузка, несколько USB, разъемы под наушники и микрофон, отдельная кнопка управления подсветкой. И вот эта кнопка – мелочь, но приятная. Не нужно лезть в софт, если вдруг вечером захотелось тишины и темноты.

Сзади все по классике: интерфейсная панель материнской платы, три DisplayPort и HDMI от видеокарты, вентиляционная решетка, блок питания внизу. Никаких сюрпризов.

Внутренняя компоновка: без шоу, но логично

Открываешь корпус – и сразу видно, что это не эконом. Блок питания установлен снизу в отдельной зоне, забор воздуха через нижнюю перфорацию. Это значит, что он не греется от видеокарты и процессора. Мелочь, но правильная.

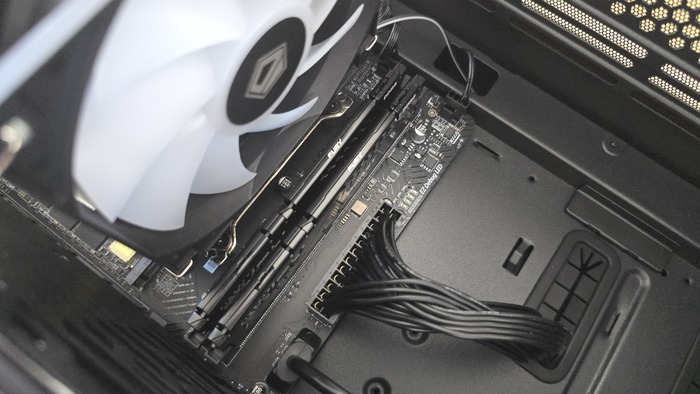

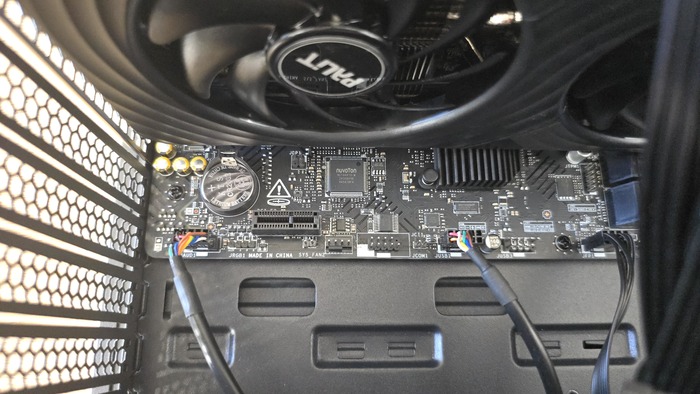

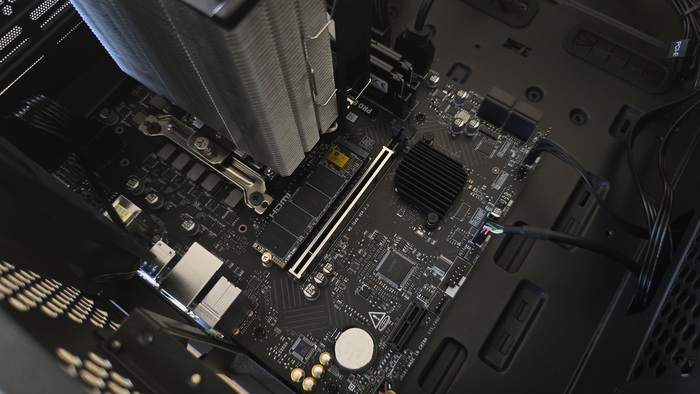

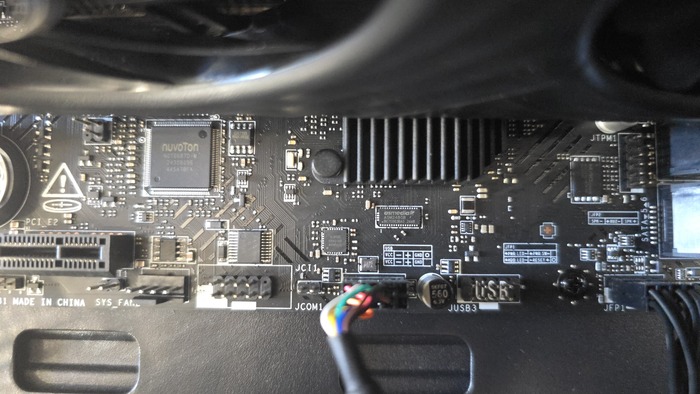

Материнская плата MSI PRO B760M-E формата mATX стоит с заметным запасом пространства в корпусе. Справа и снизу есть свободные зоны, через которые удобно выводятся кабели. Основные жгуты питания выведены аккуратно, без натяжения и перекрестов, которые мешают потоку воздуха. Процессор охлаждается башенным кулером ID-COOLING SE-224-XTS ARGB. Обычная односекционная башня с 120 мм вентилятором. Никаких излишеств, но и ощущения «маловато» нет. Между кулером и верхней панелью остается пространство, воздух не зажат.

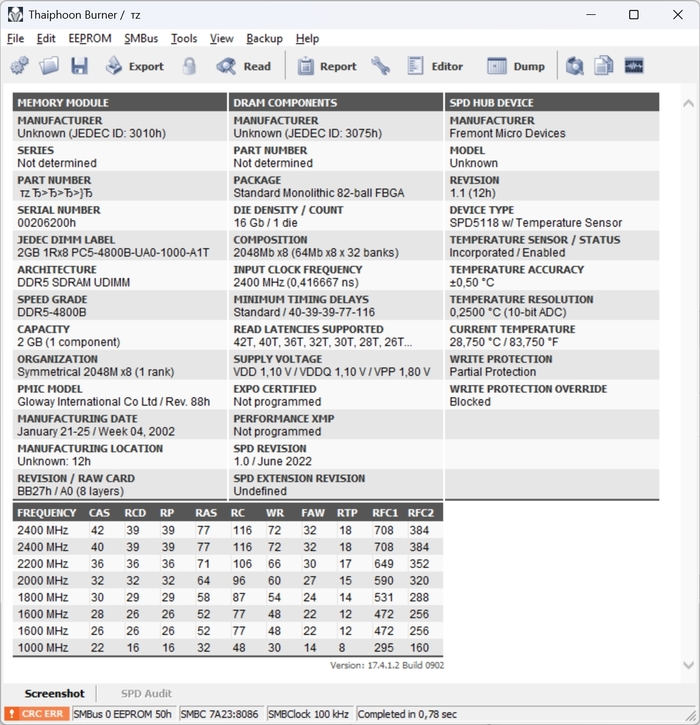

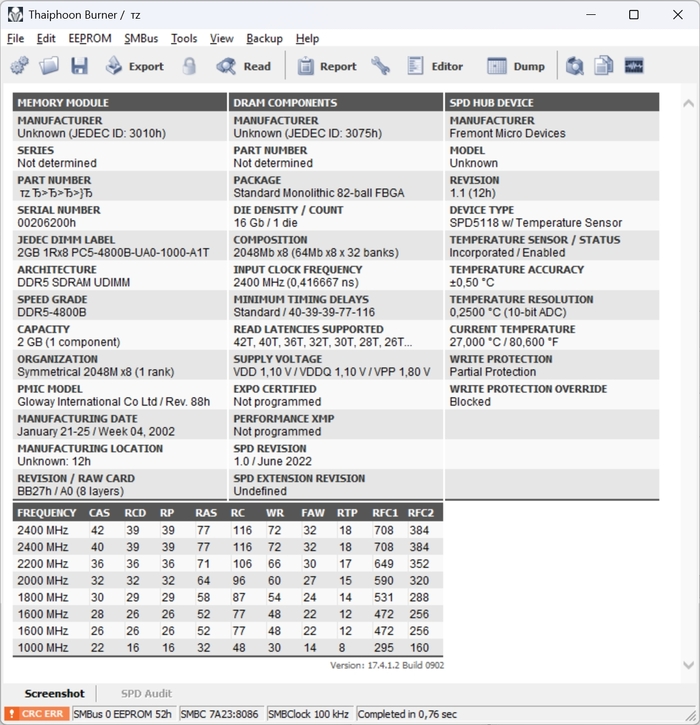

Память – два модуля Kingston Fury, оба слота заняты. Радиаторы не упираются в вентилятор кулера, ничего не перекошено. Все стоит как должно.

Видеокарта Palit RTX 5060 Ti Dual занимает два слота. По длине она не доходит до фронтальных вентиляторов, и между ней и передней стенкой остается свободное пространство. Это важно: поток воздуха не перекрыт кабелями, не создается ощущения «запихнули впритык».

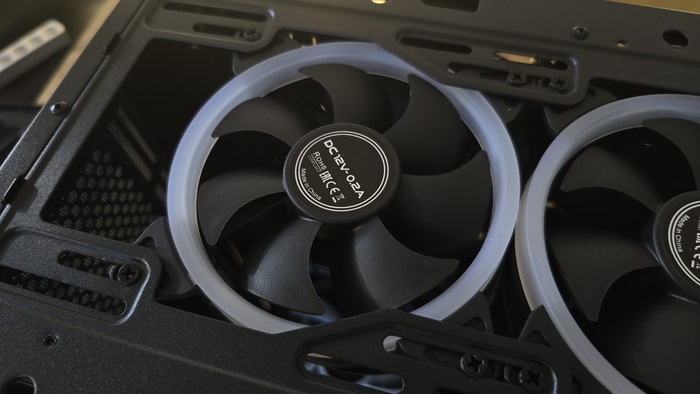

Спереди три 120 мм вентилятора на вдув, сзади один на выдув. Прямая схема: холодный воздух заходит спереди, проходит через видеокарту и зону процессора и выходит назад и вверх. Никаких сложных воздушных туннелей, все максимально просто.

Кабель-менеджмент реализован через пространство за поддоном материнской платы. Излишки проводов убраны вниз, крышка закрывается без давления на жгуты.

Отдельный момент – накопители. Основной NVMe стоит в единственном M.2 слоте на плате. Дополнительно есть корзина под 2.5 и 3.5 дюйма. То есть расширение возможно, но не через второй быстрый M.2, а через SATA.

Что это за конфигурация на самом деле

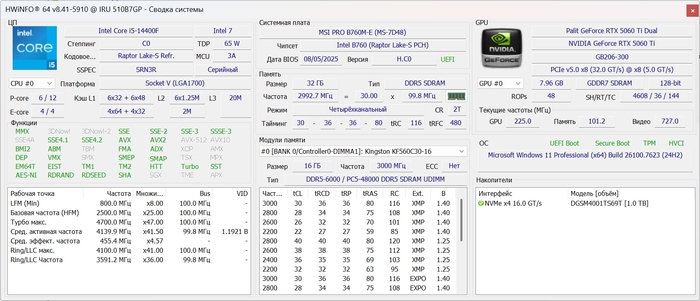

Внутри стоит Intel Core i5-14400F. Никакой экзотики, нормальный гибрид на 6 производительных и 4 энергоэффективных ядра. Без встроенной графики, значит ставка сразу делается на дискретную видеокарту. В моем случае это Palit GeForce RTX 5060 Ti Dual с 8 ГБ видеопамяти.

Плата – MSI PRO B760M-E. И вот тут уже видно характер сборки. Это не «платформа под эксперименты и тесты». Два слота под память, один M.2 под NVMe, базовый набор интерфейсов. Все работает, но пространства для разрастания нет. Система задумана как законченная.

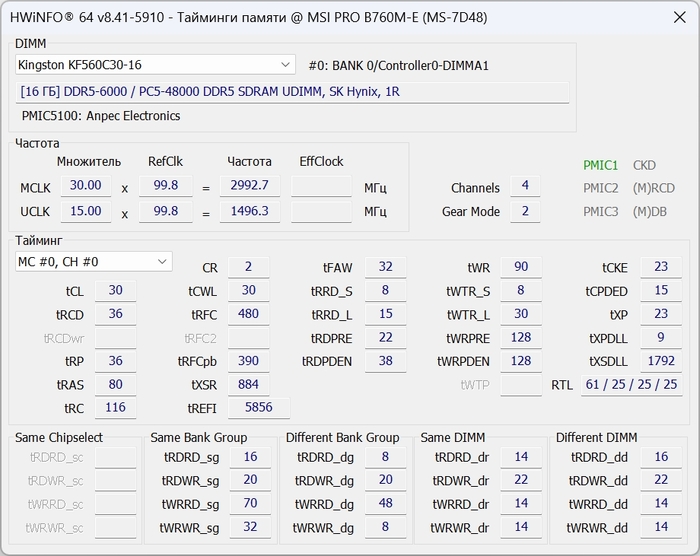

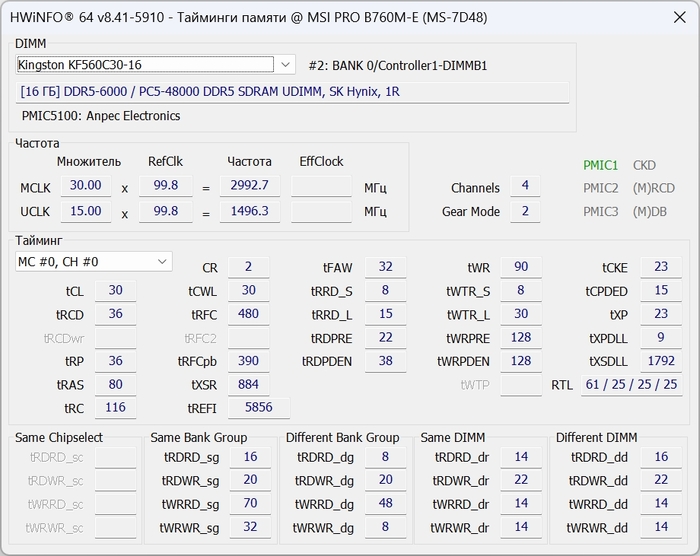

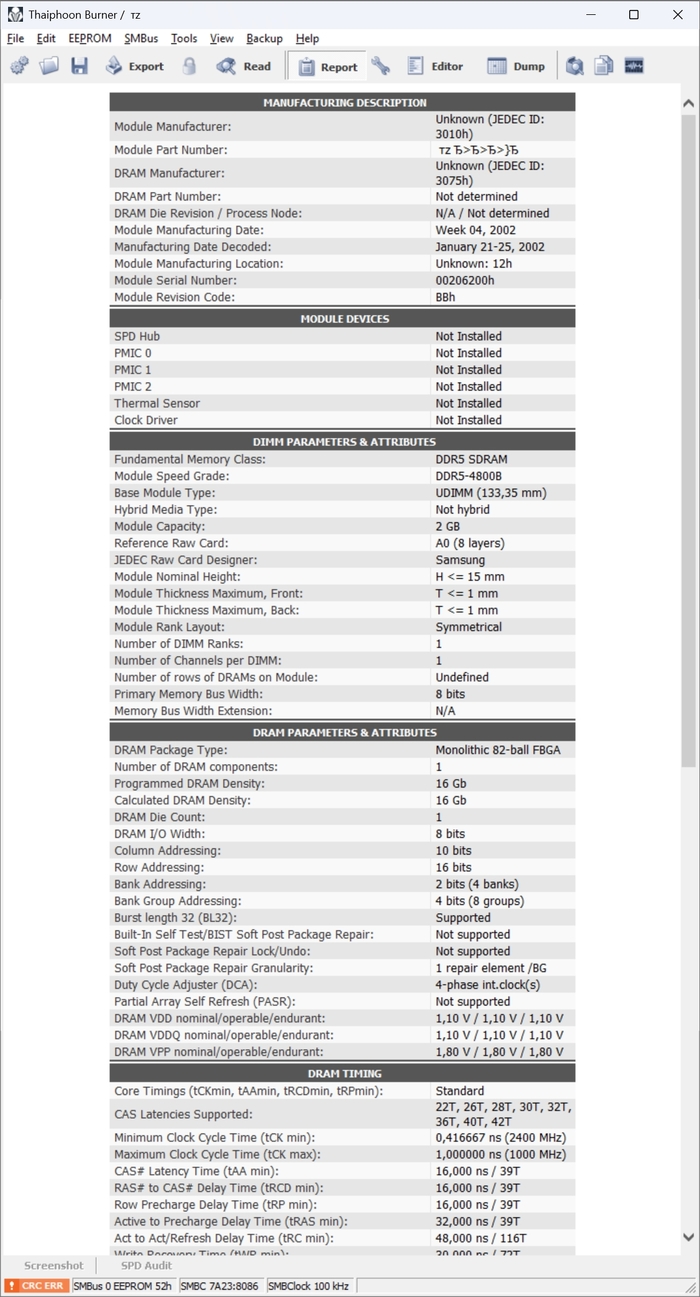

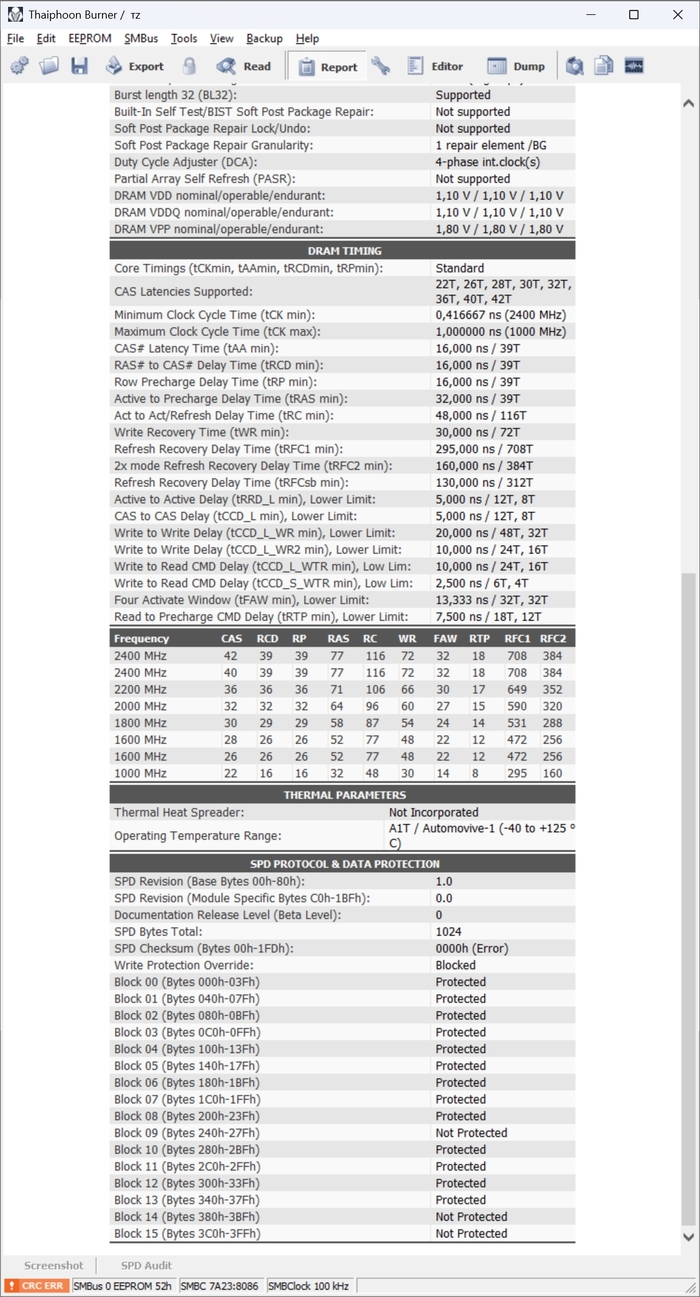

Оперативная память – 32 ГБ DDR5, в моем случае она работает на 6000 МГц с таймингами 30-36-36-80. По AIDA64 это подтверждается, частота шины около 2993 МГц, что для DDR5-6000 абсолютно логично. Оба слота заняты, так что, если когда-то понадобится 64 ГБ – это уже будет полная замена модулей.

Накопитель – NVMe 1 ТБ, Digma Meta S69. Это единственный M.2 на плате. Захочется второй быстрый SSD – не получится, только через SATA. И это тот момент, который нужно понимать заранее, а не после покупки.

По охлаждению все довольно честно: башенный кулер на процессоре, три 120 мм вентилятора спереди на вдув и один сзади на выдув. Корпус дышит через сетку спереди и сверху, поэтому поток воздуха прямой, без лабиринтов. Под нагрузкой система ведет себя спокойно, но об этом позже.

Если коротко, это не «премиум-сборка», и не «эконом с сюрпризами». Это конкретный набор железа, собранный под понятный сценарий: универсальный домашний ПК с игровым уклоном.

И дальше уже вопрос не в том, тянет ли он. А в том, где у него границы.

Синтетика. Не ради цифр, а ради понимания

Я начал с PCMark 10. Не потому что это «обязательный тест», а потому что он лучше всего показывает, как система чувствуется в обычной жизни. Запуск приложений, браузер, видеосвязь, офис – вот это все. И здесь конфигурация ведет себя спокойно. Итог около десяти тысяч баллов – это не рекорд, но и не бюджетная просадка. Essentials уверенные, Productivity без провалов, Digital Content Creation на уровне, который позволяет говорить о базовом монтаже и работе с графикой без нервов. То есть в повседневной эксплуатации это не «игровая коробка, которая в браузере тупит». Баланс соблюден.

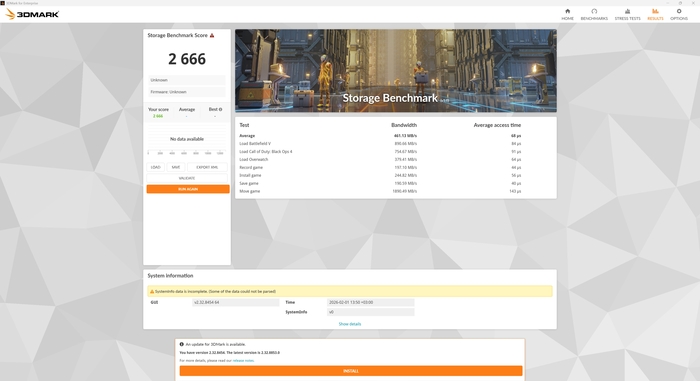

Дальше – накопитель. В PCMark Storage он не выглядит чемпионом. И это важно. Линейные скорости в CrystalDiskMark у него красивые, под 5 ГБ/с, но прикладной профиль показывает, что это нормальный NVMe среднего класса, без ощущения «пушки-гонки».

Это не значит, что система тормозит. Это значит, что, если вы часто работаете с крупными проектами, переносите тяжелые файлы, разницу между условным флагманским SSD и этим вы заметите. Но в бытовом сценарии – нет.

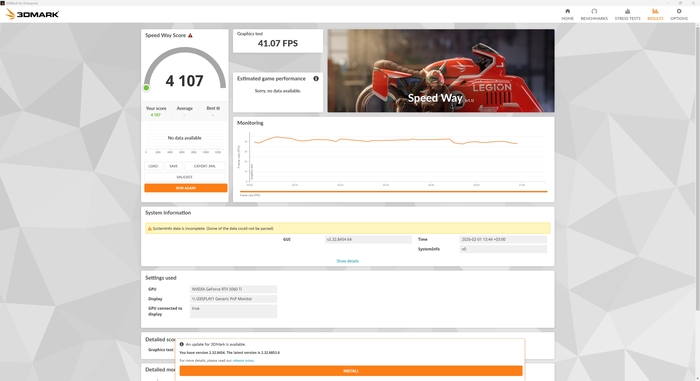

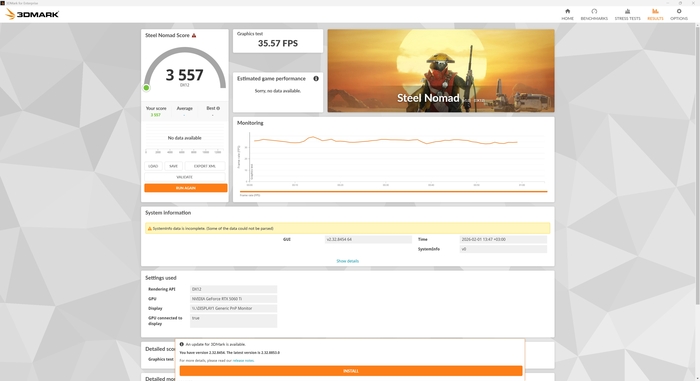

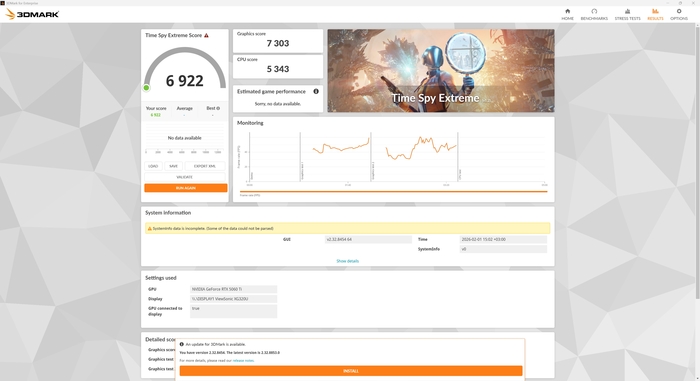

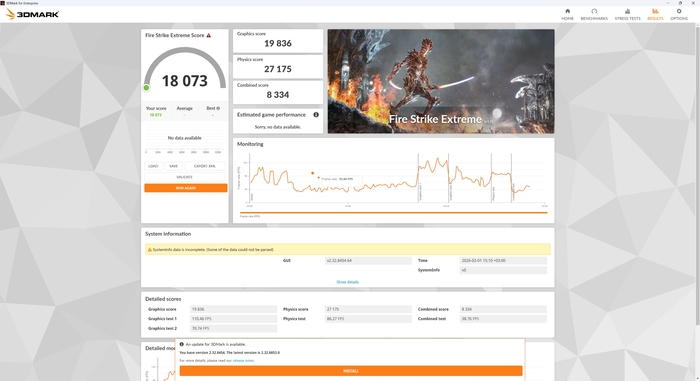

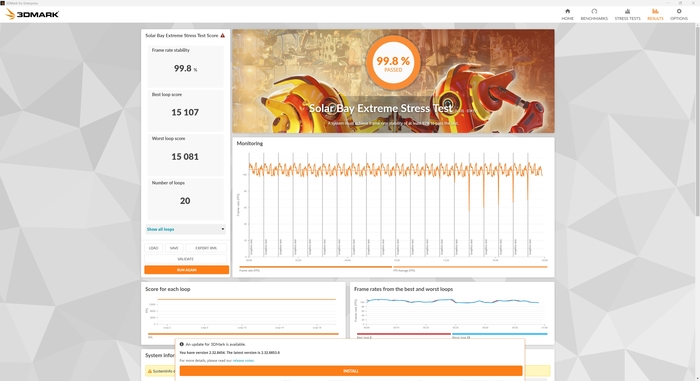

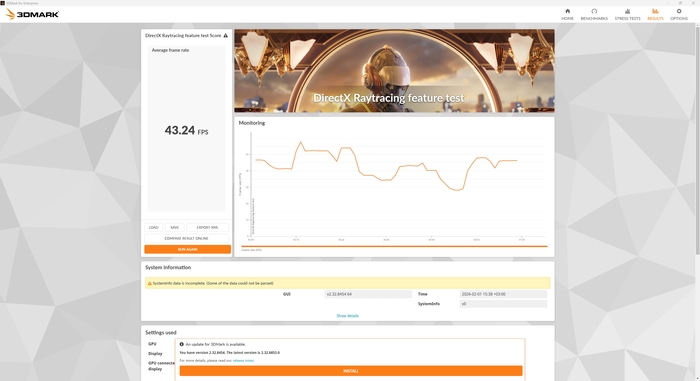

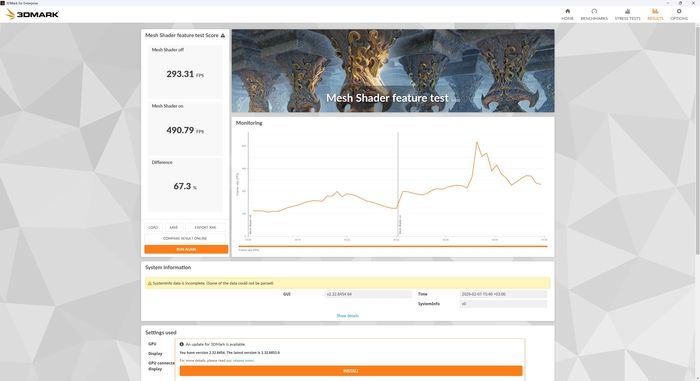

3DMark показал предсказуемую картину: видеокарта и процессор не конфликтуют друг с другом. В графических тестах карта делает свою работу, в CPU-сценариях процессор не выглядит слабым звеном. Важно другое – стресс-тесты. В Solar Bay Extreme стабильность 99.8%. Частоты не «плывут», троттлинга нет, поведение ровное. Это как раз тот момент, который ценнее красивых цифр. Потому что играть или рендерить вы будете не 30 секунд, а часами.

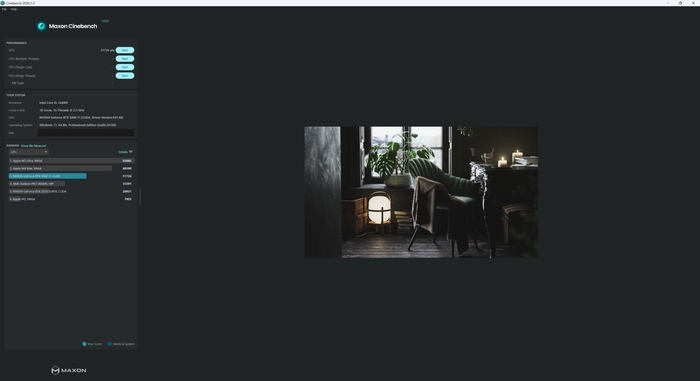

Cinebench 2026 добавил ясности. В многопоточном режиме процессор показывает адекватный для своего класса результат. Он не делает вид, что это i7 или i9, при этом явно не является узким местом. В однопоточном тесте цифры тоже на уровне, достаточном для игр и повседневных задач.

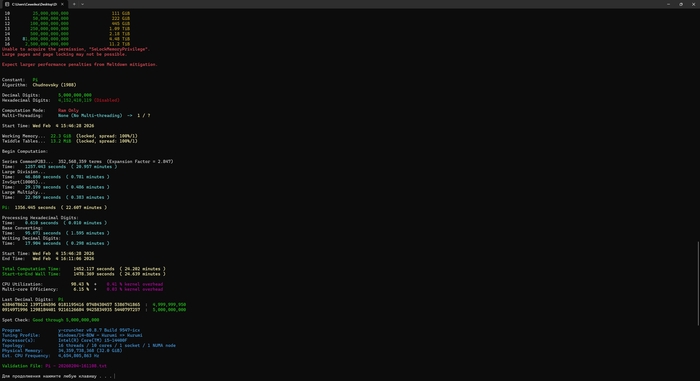

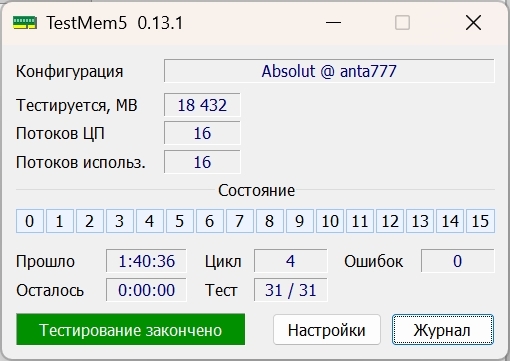

Я отдельно прогнал систему через y-cruncher и TestMem5. Это уже не про «синтетику ради скриншота», а про стабильность. Долгий расчет числа π прошел без ошибок, память в агрессивном профиле Absolut от anta777 тоже не дала ни одного сбоя. Это значит, что конфигурация не просто запускается, а реально выдерживает длительную нагрузку.

AIDA64 показала для памяти то, что и ожидалось от DDR5-6000 на B760: хорошие скорости чтения и записи, задержка около 70 нс. Не рекорд, но без аномалий.

Игры. Где заканчивается уверенность

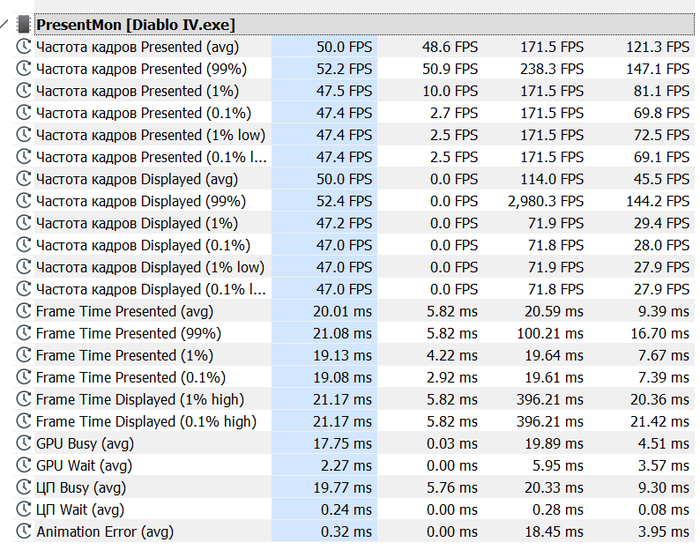

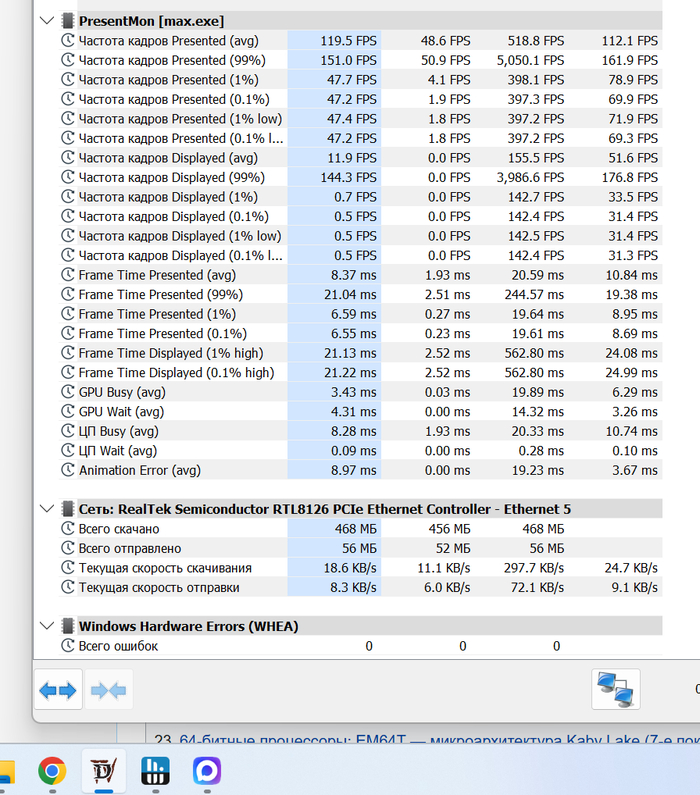

Я изначально тестировал систему не в одном разрешении. Мне было важно понять не просто «сколько FPS», а как меняется характер поведения при росте нагрузки. Full HD, 2K, 4K – без смены платформы, только разрешение.

И довольно быстро стало понятно: у этой конфигурации есть четко очерченная зона комфорта.

Full HD – ее естественная среда

В Full HD система чувствует себя уверенно почти везде. В «Мире Танков» частота кадров уходит далеко за пределы того, что нужно даже для 165 Гц монитора. Fortnite работает плавно, без упора в процессор. В S.T.A.L.K.E.R. 2 в Full HD FPS высокий, управление отзывчивое, запас по производительности заметен.

Здесь видеокарта работает активно, но без ощущения, что она уже на пределе своих возможностей. Процессор не становится бутылочным горлышком. Это тот режим, в котором сборка выглядит эффективной.

2K – все еще комфорт, но уже без запаса

При переходе на 2560x1440 нагрузка смещается в сторону видеокарты. В большинстве проектов FPS остается играбельным и комфортным, но запас уже не такой жирный, как в Full HD. В Fortnite и «Мире Танков» проблем нет – все плавно. В более тяжелых проектах вроде Cyberpunk 2077 становится заметно, что видеокарта начинает работать ближе к границе. Играть можно, но это уже не режим «максимум всего и не думать». Процессор при этом по-прежнему не является ограничением. Почти везде упор именно в GPU, и это хороший знак – значит, конфигурация собрана без явного перекоса.

4K – территория компромиссов

А вот 4K – это уже честный разговор. В легких или средних по нагрузке играх частота кадров может оставаться на приемлемом уровне. Но в тяжелых сценах, особенно в проектах вроде Cyberpunk 2077 или S.T.A.L.K.E.R. 2, производительность начинает резко проседать. И это нормально. RTX 5060 Ti с 8 ГБ видеопамяти – не видеокарта для «чистого 4K». Можно играть, можно подбирать настройки, можно использовать апскейл. Но режим «все на максимум и 4K натив» – это уже другая лига железа.

В новых проектах вроде Clair Obscur – Expedition 33 или Kingdom Come: Deliverance II картина схожая. В относительно спокойных сценах все держится достойно. В сложных – видеокарта упирается в потолок, FPS падает, и становится понятно, где реальный предел конфигурации.

Важно, что процессор в этих сценариях не мешает. Он не душит видеокарту, не создает странных скачков нагрузки. Почти везде ограничителем выступает именно GPU.

Что это значит на практике

Если играть в Full HD или 2K – сборка выглядит вполне рациональной. Она дает стабильный FPS, не перегревается, не троттлит, не упирается в процессор.

Если прицел на 4K как основной режим, особенно в тяжелых проектах, здесь уже придется идти на компромиссы. И это не «провал системы». Это просто честное соответствие классу комплектующих.

И вот здесь возникает главный вопрос всей статьи: если производительность понятна, то что с деньгами? Есть ли вообще смысл брать готовую сборку, если границы ее возможностей очевидны?

Деньги. И вот тут внезапно…

Я специально не сравнивал с «похожими вариантами», не подбирал альтернативы, не искал, где что дешевле на пару тысяч. Я взял ровно те комплектующие, которые стоят внутри, и посмотрел их стоимость в том же магазине.

Конфигурация по факту такая:

Intel Core i5-14400F OEM – 15 700 руб.

MSI PRO B760M-E – 7 500 руб.

Palit GeForce RTX 5060 Ti Dual 8 ГБ – 42 050 руб.

Kingston Fury Beast 32 ГБ (2x16) DDR5 – 57 500 руб.

Digma Meta S69 1 ТБ NVMe – 9 750 руб.

Azza PSAZ-850G – 11 299 руб.

ID-COOLING SE-224-XTS ARGB – 1 999 руб.

Корпус AZZA Hive – 6 600 руб.

ЛицензияWindows 11 Pro – 5 750 руб.

Если сложить именно эти позиции, получается 158 148 рублей.

Цена готового iRU Tactio 510B7GP в том же магазине – 145 800 рублей.

Разница – 12 348 рублей. И это уже не «погрешность», а вполне ощутимая сумма.

То есть в конкретном случае история «готовый ПК дороже, потому что коробка и сборка» просто не работает. Если собирать эту же конфигурацию самостоятельно, она обойдется дороже. Причем без учета времени, без учета сборки, без учета возможных нюансов с BIOS, кабелями и прочими радостями.

И вот здесь я, честно говоря, ожидал другого результата. Плюс есть еще одна вещь, о которой обычно забывают. Гарантия. Когда вы собираете систему сами, гарантия разрозненная. Видеокарта – в один сервис, плата – в другой, блок питания – в третий. Если что-то начинает вести себя странно, вы сначала гадаете, кто виноват, потом носите комплектующие по отдельности. В случае с готовой сборкой – одна точка входа. Один сервис. Одна гарантия на весь системник целиком, на три года. И для многих это реально аргумент. Но есть нюанс…

Экономия здесь достигается не магией, а логикой комплектации. Плата базовая. Один M.2. Два слота памяти. Нет Wi-Fi. Нет USB-C. Это не платформа «на вырост», это фиксированная конфигурация.

И вот тут начинается честный разговор. Если вы покупаете систему и реально планируете пользоваться ей в текущем виде – без постоянного апгрейда, без идеи «потом еще добавлю второй NVMe и поменяю половину железа» – готовая сборка выглядит рационально. Она уже собрана, настроена, протестирована и, что важно, в этом конкретном случае даже дешевле.

Если же вы относитесь к ПК как к конструктору, который будете постепенно перестраивать, добавлять второй быстрый накопитель, менять память без полной замены модулей, ставить Wi-Fi, играться с апгрейдом – тогда ограничения этой платформы могут начать раздражать довольно быстро. И вот здесь каждый выбирает не просто железо, а свой сценарий поведения.

Спойлер: все не так просто

Подводя итог, могу сказать, что iRU Tactio 510B7GP – это не «убийца всех сборок» и не «идеальный универсал». Это понятная, сбалансированная система среднего класса. В Full HD и 2K она чувствует себя уверенно. В 4K – с оглядкой на класс видеокарты. Под нагрузкой не разваливается. Процессор не мешает видеокарте. Память стабильна. SSD без рекордов, но и без провалов. А самое интересное – в конкретный момент времени она может стоить дешевле, чем самостоятельная сборка из тех же комплектующих. И вот здесь каждый решает сам.

Либо вы хотите контролировать каждую деталь и собирать сами, либо вы хотите включить систему, установить игры и работать, не думая о совместимости, BIOS и кабель-менеджменте. В этом случае готовая сборка перестает выглядеть как «переплата за коробку» и начинает выглядеть как просто еще один логичный вариант.