ИИ-тусовка помешалась на Clawdbot. Рассказываю, что это за штука

Пока ChatGPT Agent обрастает мхом, разработчик-одиночка Питер Штайнбергер соорудил Clawdbot – агента, который гремит на весь интернет. Правда, под давлением Anthropic, бот уже переименован в Moltbot, но первое название пока привычнее.

Clawdbot это надстройка над Claude Code, агентом для программирования для Anthropic. Чаще всего в нем используют Claude Opus/Sonnet 4.5, но поддерживаются как ИИ конкурентов, так и открытые модели, если железо потянет. Clawdbot устанавливается через терминал на Мак или ПК, и получает почти полный доступ к системе: настройки, файлы, бразуер, почта и т.д. Это поднимает вопросы к безопасности, о них – в конце поста.

В англоязычном X все скупают для Clawdbot-а MacMini $600, чтобы он на нем работал круглосуточно. Есть и другой путь – поставить на виртуальный сервер, где бот, кстати, превращается в мини-админа. Я плачу за сервер 5 евро в месяц, видел, что народ ставит на бесплатный тариф от AWS.

Разумеется, коммерческие модели типа Claude Opus 4.5 не крутятся на ПК/сервере физически – Clawdbot обращается к ним через API. В случае с Claude понадобится подписка Pro или Max, но учитывайте, что на Pro лимиты использования бот тратит от всей души.

Общение идет через Discord, WhatsApp, Telegram – по сути, через чат вы удаленно управляете ПК/сервером, на котором стоит очень мощный ИИ. Его можно использовать как чат-бота, админа, секретаря, программиста – насколько хватит вашей фантазии.

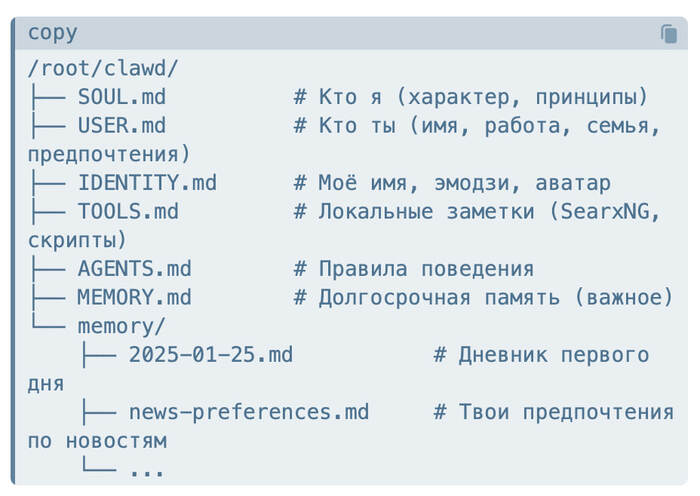

Clawdbot постоянно дорабатывает себя под запросы пользователя. Посмотрите на картинку выше – я попросил его рассказать, как устроена его память. На старте бот спрашивает, как его зовут и какой у него характер. Затем просит пользователя рассказать о себе. В процессе работы бот накапливает знания о пользователе и ведет дневник, запоминая, что делали каждый день, какие ошибки допустили.

Если в ChatGPT мы ограничены возможностями, заложенными разработчиком, то Clawdbot собирает инструменты под задачи на ходу. Простой пример: после установки я решил включить веб-поиск. Обычно используют Brave API, но там нужна иностранная карточка, а мне было лень заморачиваться.

Я спросил у Clawdbot-а альтернативы. Он предложил поднять SearxNG — опенсорсный метапоисковик, который агрегирует результаты из Google, Bing и DuckDuckGo. Один Docker-контейнер, никаких API-ключей, полностью бесплатно. Через пять минут у меня был собственный поисковый бэкенд на localhost:8888, а бот уже умел им пользоваться.

(это не я такой умный, просто попросил бота рассказать, что он сделал)

Появилась задача собирать заголовки и лид-абзацы с сайта – Clawdbot скачал себе Chrome, настроил и сделал. По утрам бот присылает мне новостную сводку, я отвечаю, что заинтересовало. Он корректирует темы и источники, чтобы лучше попадать в мои интересы. Также он шлет мне напоминалки – я много времени провожу в Telegram и это удобно.

Алекс Финн рассказал в X, как попросил Clawdbot-а зарезервировать столик в ресторане. OpenTable не сработал, поэтому бот использовал ElevenLabs для записи голосового сообщения, затем с помощью Voice Call плагина позвонил в ресторан. Фантастика.

Что с безопасностью?

Если установить Clawdbot на ПК, то он получает доступ ко всем вашим файлам, почте и настройке. Теоретически, этим могут воспользоваться злоумышленники: например, вы просите бота сделать саммари PDF, внутри которого спрятана команда собрать личные данные и отправить на нужный адрес. Бот ее читает и выполняет – классический prompt injection.

Поэтому советуют использовать Claude Opus 4.5 – это самая продвинутая модель Anthropic, которая лучше защищена от взломов. И не стоит сразу разворачивать Clawdbot на рабочей машине – лучше сначала поставить на старом ПК или виртуальном сервере и разобраться. А затем можно попросить бота настроить безопасность.

P.S. Поддержать меня можно подпиской на канал "сбежавшая нейросеть", где я рассказываю про ИИ с творческой стороны.