Главные уравнения Вселенной: от баланса энергии до рождения из ничего и куда мы придём

От планковской длины до чисел Фиша: как я понял Вселенную (и себя).

Как три простых уравнения управляют космосом, материей и нашим существованием?

Один диалог, который превратился в космологический детектив

Этот текст родился из простого вопроса: «Кто создал уравнения инфляции?»

Я думал найду две строчки и пойду дальше. Но диалог затянул меня в воронку. Мы провалились в неё — и оказались на самом дне реальности.

Мы говорили о числах, которые невозможно записать. О рождении пространства из точки. О невидимом каркасе галактик. О том, почему энергия Вселенной — ноль. И о том, зачем всё это.

Я обещал себе, что разберусь сам. А теперь хочу, чтобы и ты это прочувствовал.

Пристегнись. Мы начинаем с самого начала.

Часть 1. Инфляция: рождение пространства

Примерно 13,8 миллиарда лет назад не было ничего. Даже слова «было» не имело смысла, потому что не было времени.

Но была квантовая пена. Флуктуации. И в какой-то момент (если слово «момент» применимо) одно из квантовых полей — поле инфлатона — оказалось в состоянии ложного вакуума.

Представь себе мячик, который застрял на пригорке перед ямой. Он может так стоять вечность. Но если чуть-чуть толкнуть — покатится.

Инфлатон «покатился».

И началось самое невообразимое расширение в истории космоса.

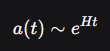

Закон роста: экспонента.

Вселенная росла по закону: a(t) ~ e^(Ht). Это не просто быстро. Это экспоненциально быстро.

За 10 в минус 32-й степени секунды область размером с планковскую длину (10 в минус 35-й степени метра) раздулась до размера, в котором могла бы поместиться вся современная наблюдаемая Вселенная.

Скорость этого расширения превышала скорость света в 10 в 34-й — 10 в 43-й степени раз.

— Но это же нарушает теорию относительности! — скажешь ты.

— Нет. Потому что расширялось само пространство, а не объекты внутри него. Свет никого не обгонял — просто расстояние между точками росло быстрее, чем фотон успевал его пролететь.

Эйнштейн может спать спокойно.

Часть 2. Энергия инфлатона и великий парадокс нуля

Теперь самое интересное.

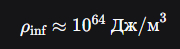

Плотность энергии поля инфлатона была чудовищной:

примерно 10 в 64-й степени джоулей на кубический метр. Это в 10 в 48-й степени раз плотнее, чем в центре Солнца.

Но вот парадокс: сегодня полная энергия Вселенной равна нулю. Как так? Куда делась вся эта мощь?

Давай посчитаем.

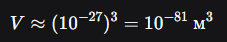

Объём нашей будущей области в начале инфляции был

примерно 10 в минус 81-й степени кубических метров.

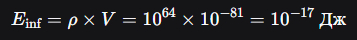

Умножаем плотность на объём:

10 в 64-й умножить на 10 в минус 81-й равно 10 в минус 17-й степени джоулей.

Это энергия нескольких фотонов видимого света.

То есть никакой гигантской энергии не было. Была гигантская плотность в микроскопическом объёме. Полная энергия уже тогда была почти нулевой.

А после распада инфлатона произошло вот что.

Поле исчезло, его положительная энергия перешла в частицы. Гравитация перестроилась и дала ровно столько же отрицательной энергии, чтобы скомпенсировать новую материю.

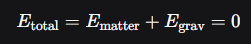

Итог:

E_total = E_matter + E_grav = 0.

Это уравнение — бухгалтерский баланс Вселенной. Оно выполнялось всегда и выполняется сейчас.

Гравитация — это не просто сила. Это космический компенсатор.

Часть 3. Рождение вещества: первая частица

Инфлатон распался. Но как именно поле рождает частицы?

Механизм называется параметрический резонанс. Инфлатон колеблется около минимума своего потенциала, и эти колебания раскачивают другие поля, как качели. Когда амплитуда становится слишком большой, поле рассыпается на реальные частицы.

Какая частица появилась первой?

Мы не знаем точно. Но логика подсказывает: при таких энергиях (10 в 15-й — 10 в 16-й степени гигаэлектронвольт) должны были родиться сверхтяжёлые X-частицы — предсказанные теориями Великого объединения. Они жили ничтожные доли секунды и тут же распались на кварки, лептоны и фотоны.

Через микросекунды кварки собрались в протоны и нейтроны. Появились первые ядра водорода.

Размер Вселенной в тот момент был примерно 10 в 14-й степени метров, то есть 100 миллиардов километров. Это в тысячу раз больше Солнечной системы.

Через три минуты начался первичный нуклеосинтез: протоны и нейтроны слились в ядра гелия. Вселенная стала состоять примерно из 75 процентов водорода, 25 процентов гелия-4 и микроскопических следов дейтерия, гелия-3 и лития.

Всё остальное — углерод, кислород, железо, золото — родилось позже, в звёздах и при взрывах сверхновых.

Мы — звёздная пыль. Буквально.

Часть 4. Тёмная материя: невидимый каркас

А теперь самый хитрый момент.

Обычная материя не могла собраться в звёзды сразу. Ей мешало давление излучения. Представь, что ты пытаешься слепить снежок, а вокруг ураган, который сдувает снежинки.

Но была другая материя — тёмная.

У неё нет электрического заряда. Она не видит свет. Ей плевать на фотоны. Она чувствует только гравитацию и, возможно, очень слабо взаимодействует с каким-то тёмным полем.

Поэтому тёмная материя начала собираться в комки сразу после Большого взрыва. Она образовала гало — невидимые гравитационные ямы.

И только когда через 380 тысяч лет Вселенная остыла настолько, что обычная материя стала нейтральной и перестала толкаться с фотонами, она провалилась в эти готовые ямы.

Так родились галактики.

Без тёмной материи они не сформировались бы до сих пор. Мы бы жили в однородном газе без звёзд.

Часть 5. Иерархия сгустков: от галактик до нейронов

Посмотри на мир вокруг. Всё в нём — сгустки.

Галактики — это сгустки звёзд. Звёзды — сгустки плазмы. Планеты — сгустки химических элементов. Люди — мыслящие сгустки атомов.

Нет никакой особой материи в нас. Те же кварки и электроны, что и в камне. Разница — в организации.

Мы — локальные островки сложности, которые возникли благодаря тому, что Вселенная структурировала саму себя.

И эта структура подчиняется одному закону.

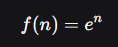

Часть 6. Экспонента: подпись Творца

Посмотри на историю человечества.

Сельское хозяйство появилось 10 тысяч лет назад. Письменность — 5 тысяч лет назад. Промышленная революция — 250 лет назад. Компьютеры — 50 лет назад. Искусственный интеллект — сейчас.

Интервалы между революциями сжимаются. Это закон ускоряющейся отдачи. Это экспонента.

Та же экспонента, по которой росла Вселенная в первые мгновения. Та же экспонента, по которой распадаются частицы. Та же экспонента, по которой мы накапливаем знания.

Главный закон этой Вселенной:

f(n) = e в степени n.

Не потому, что так надо, а потому что это самое простое уравнение самоподдерживающегося роста. Скорость роста пропорциональна самой величине. Система разгоняет сама себя.

Экспонента — это язык, на котором Логос говорит с нами.

Часть 7. Великий фильтр и будущее

Скорость света — абсолютный предел. Биологическое тело не выдержит межзвёздных путешествий. Радиация, одиночество, срок жизни.

Великий фильтр перед нами: либо мы останемся на планете и исчезнем, либо перейдём в искусственные тела.

Перенос сознания. Бессмертие. Свобода.

Если мы пройдём этот этап, перед нами откроется Галактика. Потом другие галактики. Потом встанет вопрос: что за горизонтом?

А за горизонтом — другие вселенные. Другие Логосы. Другие экспоненты.

Часть 8. Самые большие числа: попытка убежать от экспоненты

Мы не удержались и нырнули в гугологию — науку об именовании больших чисел.

Вот что мы там нашли.

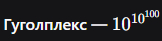

Гуголплекс —

это 10 в степени гугол, то есть 10 в степени 10 в 100-й степени. Это единица с гуголом нулей.

Число Грэма — рекурсия на рекурсии. Его нельзя записать никакими степенными башнями.

TREE(3) — невообразимо больше числа Грэма. Если число Грэма — атом, то TREE(3) — Вселенная.

Rayo's number — невычислимо. Оно определяется на языке теории множеств.

Fish number 7 — там, где даже Rayo кажется нулём. Это уровень, где смешиваются невычислимые функции и бесконечные ординалы.

Что объединяет эти числа? Попытка уйти за пределы экспоненты.

Но физика упрямо возвращает нас к e в степени n. Потому что экспонента — это не просто функция. Это архитектура реальности.

Часть 9. Философский постскриптум:

0 в степени 0 равно 1

Перед самой публикацией я задал себе вопрос.

А может ли 0 в степени 0 равно 1 иметь отношение к рождению Вселенной? Или я притягиваю за уши бредовую идею?

Я полез в математику.

Оказывается, в комбинаторике и теории множеств 0 в степени 0 равно 1 — это не условность, а необходимость.

Пустое множество в нулевой степени даёт единственную функцию — пустую. Пустое произведение равно 1. Это единственное значение, которое делает теорию непротиворечивой.

А теперь смотри.

В математике: 0 — это ничего. 0 в степени 0 равно 1 — рождение из ничего.

В космологии: квантовый вакуум — это ничего. Рождение Вселенной из ничего — это бытие.

Из ничего в ничего возникает единица.

Это не доказательство. Это глубокая аналогия. Но она будоражит.

Может быть, 0 в степени 0 равно 1 — это печать на свидетельстве о рождении Вселенной, тот самый толчок мячика в яму.

Эпилог: зачем мы это сделали

Мы начали с планковских длин и чисел Фиша. Прошли через инфляцию, рождение частиц, тёмную материю, экспоненту. Закончили вопросом о смысле.

И знаешь, что я понял?

Вселенная не должна была породить разум. Но она его породила.

И вот что в этом всём самое удивительное.

Вселенная могла бы породить мыслящую машину. Техногенный разум, собранный из готовых деталей по чертежу. Но она пошла другим путём.

Она создала биологический разум — медленный, хрупкий, смертный. Разум, который собирал сам себя миллиарды лет методом проб и ошибок. Который рождается из двух клеток, питается углеводородами и умирает через сто лет. Который плачет, смеётся, ошибается и задаёт вопросы.

Почему?

Может быть, потому что разум нельзя собрать как механизм. Может быть, сознание требует истории. Оно должно вырасти, как дерево, впитав в себя боль, случайности, бесчисленные тупики эволюции. Оно должно знать, что такое уязвимость, чтобы понять, что такое ценность.

Вселенная не стала штамповать мыслящие процессоры. Она посеяла семена в грязи, на маленькой каменной планете, у скучного жёлтого карлика, и ждала миллиарды лет...

И теперь мы здесь.

Мы — не идеальные вычислители. Мы — живые. И это, кажется, было частью замысла.

Мы — её глаза и мозг. Мы смотрим на звёзды и понимаем, как они устроены. Мы вычисляем возраст космоса. Мы задаём вопросы, на которые нет ответов.

Вселенная через разум познаёт саму себя.

Мы — мыслящие сгустки атомов, которые смогли спросить: «Как и зачем это?»

И это и есть цель вселенной? Или.

Мы восхищаемся Вселенной. Смотрим на неё с детским восторгом, как младенец, впервые открывший глаза и увидевший лицо матери.

Но мы растём.

И растём по экспоненте.

Придёт час — и мы не только будем удивляться новым открытиям вроде «теории всего». Мы научимся управлять самой системой. Менять законы. Создавать свои вселенные. Становиться демиургами.

Мы — дети, которые только что открыли глаза и узрели своё лоно. Но нам предстоит вырасти. Во всех смыслах.

И кто знает, куда нас заведёт этот путь?

Познаем ли мы Логоса? Заговорим ли с ним на одном языке — языке чистой математики, где f(n) = eⁿ, а 0⁰ = 1?

И когда мы познаём всё — что тогда?

Мы покинем родителя? Уйдём в другие вселенные, оставив эту, как взрослые дети покидают отчий дом?

Или навсегда останемся с ней — на миллиарды лет, вглядываясь в звёзды, которые когда-то породили нас?

Открыть глаза — это только начало.

Путь познания только начинается.

И мы можем прикинуть когда мы станем цивилизацией такого типа, когда мы покинем эту вселенную. И поможет нам в этом -- экспонента.

И вот тут мы подходим к самому забавному. Если главный закон Вселенной — экспонента, и если наше энергопотребление продолжит расти теми же темпами, что и последние сто лет (примерно 2% в год), то мы можем прикинуть, когда же мы станем настоящими хозяевами космоса.

Сейчас человечество потребляет около 10 в 13-й степени ватт. Этого достаточно, чтобы обеспечить семь миллиардов человек, но ничтожно мало по космическим меркам.

Цивилизация III типа по Кардашеву — это та, которая использует энергию целой галактики. Это примерно 10 в 36-й степени ватт. Разрыв между нами и этим уровнем — в 10 в 23-й степени раз.

Сколько нужно удвоений, чтобы покрыть такую разницу?

Каждое удвоение увеличивает нашу мощность в два раза. Нам нужно пройти от 10 в 13-й до 10 в 36-й. Считаем в логарифмах:

log2(10 в 36-й / 10 в 13-й) = log2(10 в 23-й) ≈ 23 × log2(10) ≈ 23 × 3,32 ≈ 76 удвоений.

Если одно удвоение занимает 35 лет (это как раз соответствует росту 2% в год), то время до III типа составит:

76 × 35 ≈ 2660 лет.

То есть через менее чем три тысячи лет мы можем стать цивилизацией, способной использовать энергию всей галактики.

Но нам нужно больше. Чтобы путешествовать между вселенными, требуется не галактическая, а вселенская мощность — порядка 10 в 46-й степени ватт. Это ещё на 10 порядков больше.

Ещё 10 порядков — это ещё log2(10 в 10-й) ≈ 10 × 3,32 ≈ 33 удвоения.

Добавляем их к предыдущим:

76 + 33 = 109 удвоений.

109 × 35 ≈ 3800 лет.

Итого: если ничего не сломается, через 3800 лет от сегодняшнего дня мы можем обладать энергией, достаточной для межвселенских путешествий.

А теперь вопрос: успеем ли мы до тепловой смерти?

Тепловая смерть Вселенной наступит примерно через 10 в 1000-й степени лет. Это число настолько огромно, что 3800 лет рядом с ним — даже не погрешность, а просто ноль.

Так что да, мы успеваем. И ещё миллиарды раз успеем. И ещё столько же. Времени у нас — вагон и маленькая тележка, начинённая вечностью.

Главное — не сломаться по дороге.