Что такое Deep Research агенты и зачем они нужны?

В свете недавнего выхода обновления Deep Research для Gemini стоит разобраться, как этот и подобные ему агенты работают.

Очевидно, что речь идет об автоматизированном поиске, вернее, о последовательности задач для поиска труднодоступной информации. Когда для получения финального решения проблемы необходимо пройти множество шагов по обнаружению и анализу данных, выполнить множество запросов, Deep Research может сократить время исследования до нескольких минут - по сравнению с часами, которые ушли бы на поиск в ручном режиме.

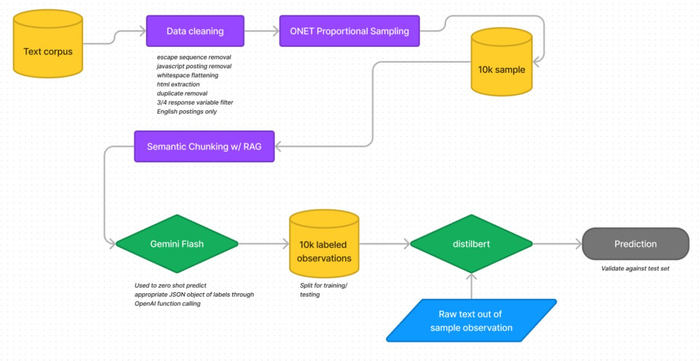

Многие AI-лаборатории - OpenAI, Google, IBM - имеют свои версии Deep Research агента. Но мы, тем не менее, знаем и его открытые его реализации, взять хотя бы Open Deep Research от LangChain. Последний дает хорошее представление об архитектуре - как и любой Deep Research пайплайн, он включает уточнение границ исследования, собственно поиск и формирование конечного отчета. Все это - хорошо знакомые мультиагентные сценарии, когда агент-супервайзер планирует конкретные поисковые задачи для агентов-исполнителей, вызывающих внешние функции. Основных проблем две: скорость выполнения задач и доступ к качественным источникам данных.

Скорость зависит от LLM - именно поэтому для агентных систем сейчас разрабатываются модели с высокой пропускной способностью, а также с упором на быстрый и точный reasoning. К этим разработкам относится недавний релиз первой модели нового поколения Nemotron 3 от Nvidia. Эта серия LLM была заявлена именно как вклад компании в развитие открытого агентного AI. Скорость инференса была повышена за счет гибридной архитектуры - трансформер плюс мамба, преимущества последней в отношении пропускной способности и экономного расхода памяти на KV-кэш хорошо известны. Впрочем, гибриды - не единственный путь для усиления агентных способностей AI. DeepSeek имеет очень выгодную для этого архитектуру, реализующую MLA-внимание (Multi-Head Latent Attention), которое обеспечивает высокопроизводительный инференс за счет очень малых, по сравнению с полным вниманием, расходов на KV-кэш.

Далее, мы сталкиваемся с проблемой, когда одна и та же реализация Deep Research дает очень разные результаты в зависимости от доступных данных. Для веб-поиска есть удобные, интегрируемые с AI агентами инструменты типа Tavily. Но далеко не на все вопросы можно получить ответы, просто “погуглив”. Для доступа к данным из частных источников, например, часто возникает необходимость деплоить Deep Research в приватное окружение. Я работаю с разными подходами к решению этой проблемы, включая облачные приватные эндпоинты, или собственный LLM-сервер, развернутый локально или в облаке. Все сводится к тому, как предоставить модели безопасный доступ к данным. Ответом может быть использование вашего собственного конфиденциального MCP-сервера, имеющего доступ к закрытым данным и реализующего определенный механизм авторизации для LLM, запрашивающим доступ к определенным частям этих данных (MCP-ресурсам). Например, если к LLM имеет доступ кто-то кроме вас, доступ не даем вообще или ограничиваем. Всегда можно запрашивать разрешение пользователя - владельца данных, что поддерживается протоколом MCP.

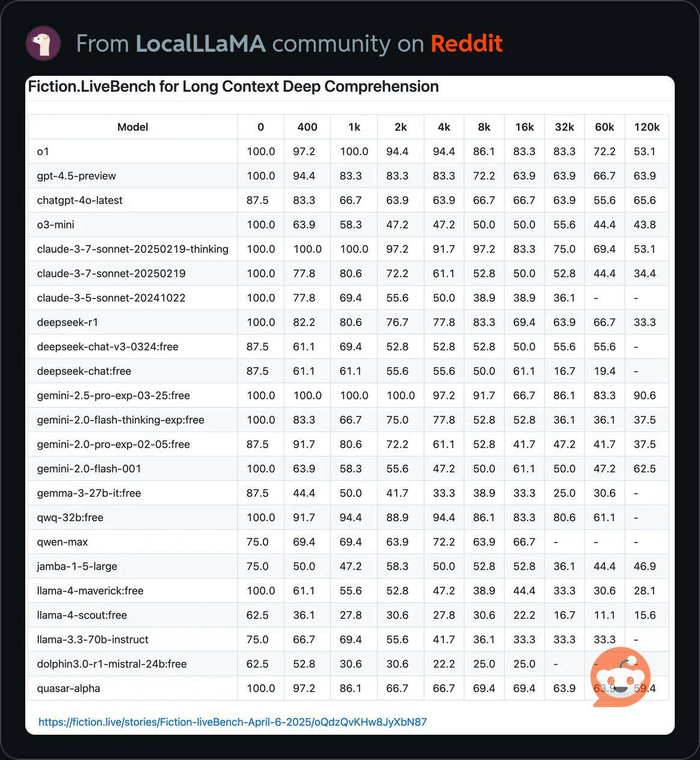

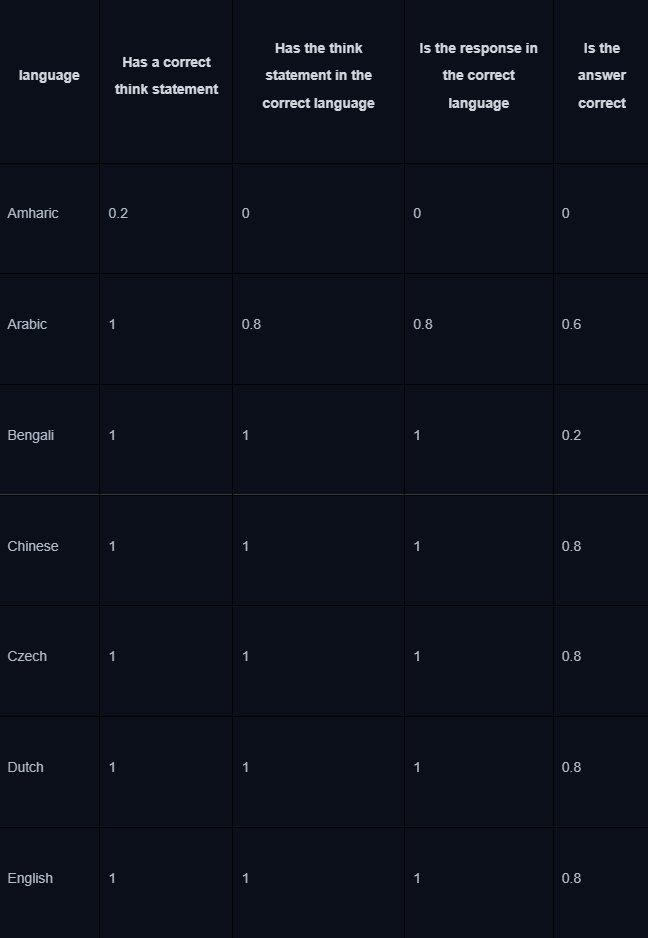

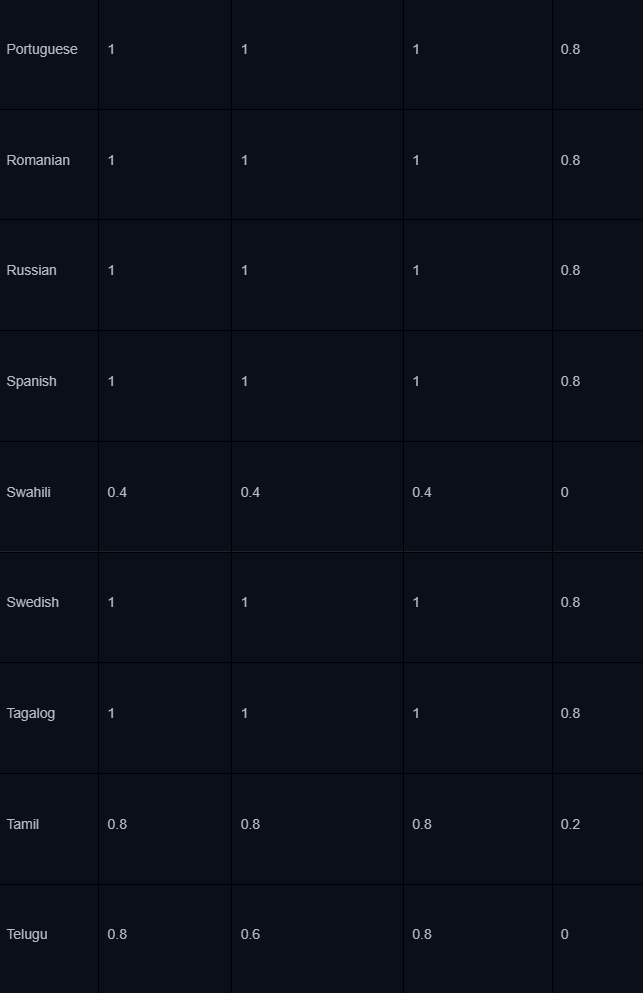

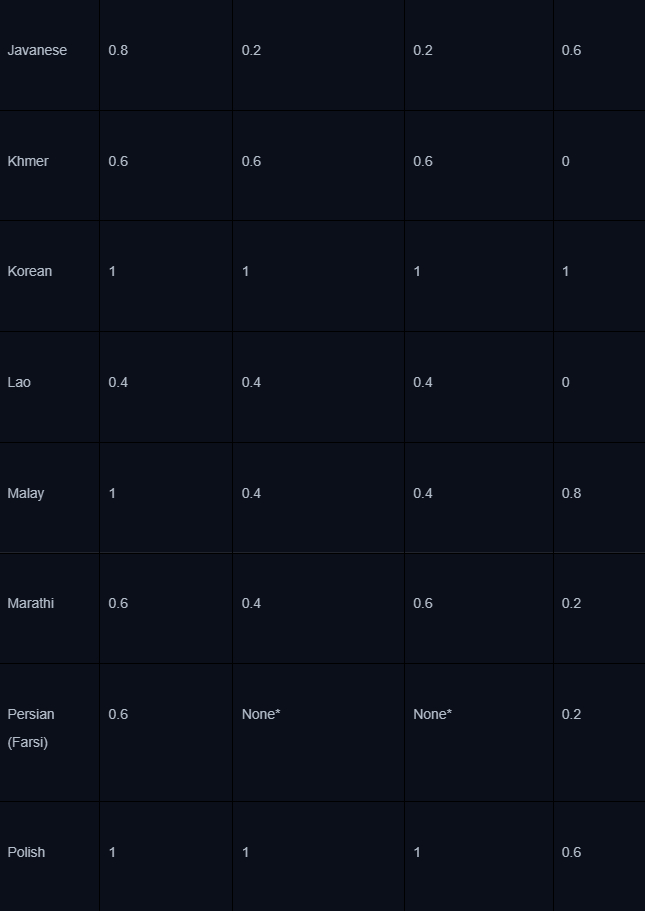

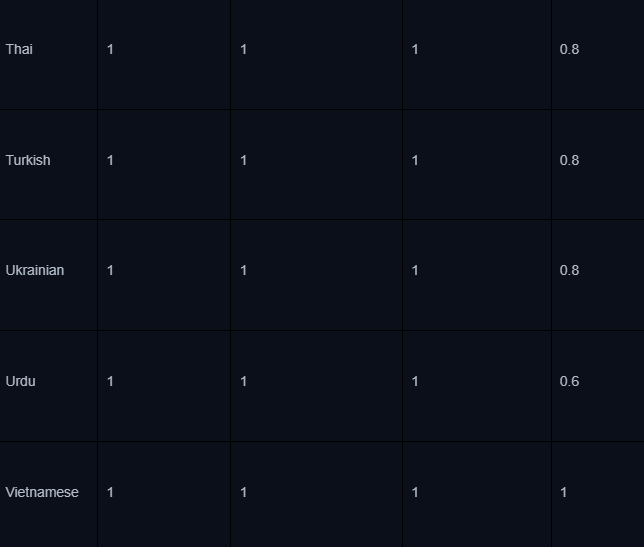

Наконец, необходимо совершенствовать поисковые способности открытых моделей. Крупные компании усиленно “качают” свои модели для повышения эффективности в многошаговых поисковых сценариях - например, Gemini 3 Pro, на котором работает их новый Deep Research агент. Основные вызовы, для достойного ответа на которые тренировали модель - улучшение качества финального отчета агента, в котором должны быть сведены к минимуму галлюцинации и должна присутствовать верификация выводов фактами из достоверных источников. Продуктом исследований Google стал углубленный бенчмарк DeepSearchQA, который может помочь и для улучшения открытых моделей, направленных на решение тех же задач. Преимущество этого бенчмарка - категоризация данных по различным областям исследований, их качество (примеры составлены вручную), и фокус на оценке не только правильности ответа, но и его полноте.

В итоге мы видим, что Deep Research - это агентный паттерн с широкой областью применения, который может быть востребован многими AI-системами. То, что нам нужно - это повышение надежности и автономности поиска, что зависит от факторов, рассмотренных выше.