TL;DR Меня зовут Илья, я основатель сервиса для генерации изображений ArtGeneration.me, блогер и просто фанат нейросетей. Каждую неделю мы с командой осматриваем сотни новостей и делимся с вами самыми актуальными и интересными со ссылками на источники. Всё самое важное — в одном месте. Поехали!

Неделя выдалась насыщенной: куча мощнейших релизов из Китая, которые наступают на пятки GPT-5.2 и Gemini 3. Реалтайм инструменты от Krea и NVIDIA, генеративные модели от Qwen и Hunyuan, а Сэм Альтман честно признал, что OpenAI испортили тексты в последних версиях GPT.

📋 В этом выпуске:

Qwen3-Max-Thinking — китайцы снова впереди

Kimi K2.5 — самая мощная в опенсорсе

LongCat-Flash-Thinking-2601 — уровень GPT-5.2

ERNIE 5.0 — ещё один монстр от китайцев

Qwen 3 TTS — клон голоса по образцу

Odyssey 2 Pro — реалтайм видео

HunyuanImage 3.0-Instruct — MoE для редактирования картинок

HeartMuLa — открытый генератор музыки

🔧 AI-инструменты и платформы

Prism — инструмент с LaTeX-редактором для научных работ

PersonaPlex-7B — реалтайм ИИ-собеседник от NVIDIA

Krea Realtime Edit — редактирование в реалтайме

🧩 AI в обществе и исследованиях

Альтман признал, что в GPT-5.2 «сломали» стиль и качество текстов

Глава Google DeepMind: в Gemini не будет рекламы

Парень заменил друзей на ИИ, чтобы играть в Tarkov

Хаби Лейм продал себя за $975 млн

🧠Модели и LLM

❯ Qwen3-Max-Thinking — китайцы снова впереди

Alibaba выпустила Qwen3-Max-Thinking. В тестах на кодинг и науку модель выдает уровень GPT-5.2 и Claude 4.5, а в математике обходит Gemini 3 Pro.

Главная фишка — технология test-time scaling. Модель запускает параллельные рассуждения для решения сложных задач. Она сама решает, когда надо подключать поиск, память и интерпретатор кода.

Весов в открытом доступе нет — модель слишком огромная для домашнего запуска.

Попробовать уже можно бесплатно в Qwen Chat.

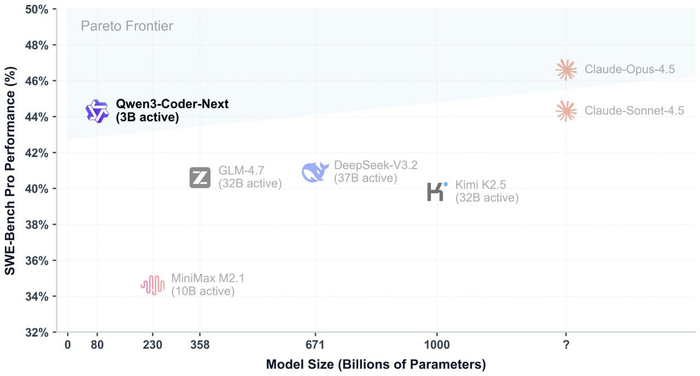

❯ Kimi K2.5 — самая мощная в опенсорсе

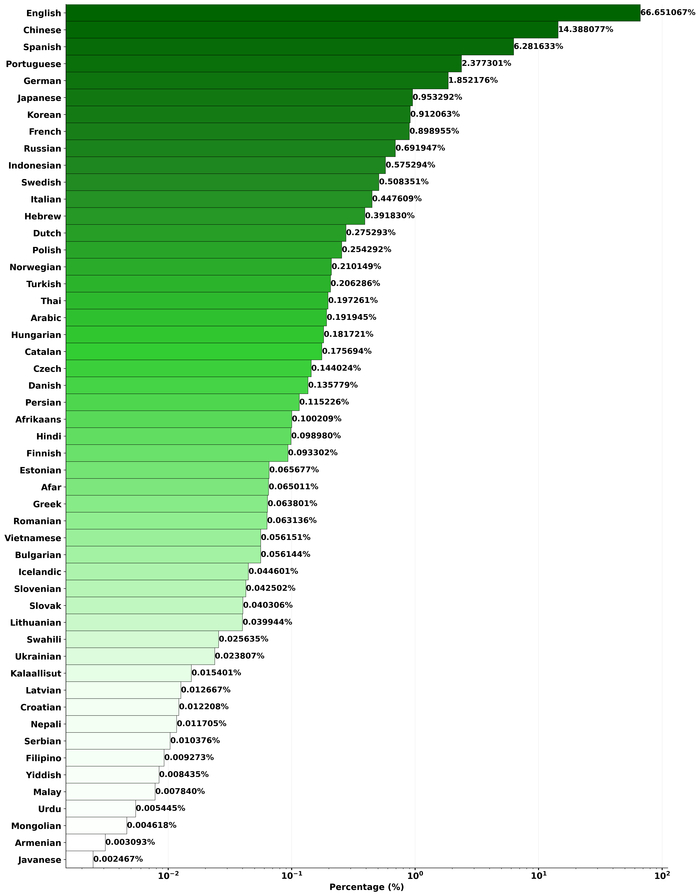

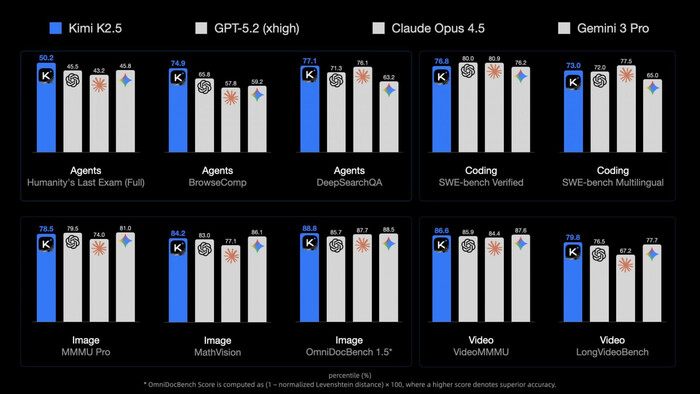

Китайцы из Moonshot AI выпустили Kimi K2.5 — самую мощную на сегодня нейросеть с открытыми весами. Модель мультимодальная, отлично справляется с кодом, особенно с фронтендом, анимацией и графикой, показывая уровень Claude Opus 4.5 и Gemini 3 Pro.

Главная фишка — «Agent Swarm»: нейросеть запускает до 100 субагентов одновременно, ускоряя выполнение сложных задач в 4,5 раза. Агенты создаются динамически, модель сама решает, как распределить работу. Kimi K2.5 может писать код по изображениям или видео — показываешь ей скриншот сайта, а модель воссоздает его.

Режимы Instant и Thinking в чате бесплатны, а «рой агентов» выйдет в $31 в месяц.

❯ LongCat-Flash-Thinking-2601 — уровень GPT-5.2

Стартап Meituan-LongCat выложили LongCat-Flash-Thinking-2601 — открытую MoE-модель на 560B параметров и 27B активных. В бенчмарках нейросеть идёт наравне с GPT-5.2 и Gemini 3 Pro, а в сложном тесте на математику AIME-25 достигла потолка в 100%.

Здесь тоже главный упор сделан на агентские навыки: работу с инструментами и поиск решений. Модель специально обучали в «зашумленных» средах с искажениями, поэтому она очень стабильна.

Для сверхзадач есть режим Heavy Thinking — в нём нейросеть параллельно ищет несколько путей решения, а затем итеративно их обобщает.

Ещё обновили шаблон чата: теперь он по умолчанию экономит контекст и позволяет опционально сохранять историю рассуждений.

❯ ERNIE 5.0 — бесплатный ответ Gemini и GPT-5

Baidu выпустили ERNIE 5.0 — огромную омнимодальную модель на 2,4 триллиона параметров. Работает с текстом, изображениями, аудио и видео в единой архитектуре.

По бенчмаркам, ERNIE 5.0 идёт наравне с GPT-5 и Gemini 3 Pro. Можно выделить тест MMAU на понимание аудио, тут модель набрала 80 баллов против 70 у GPT-4o-Audio. В задачах с документами и графиками также опережает GPT-5, но пока уступает в кодинге.

Модель построена на архитектуре Mixture-of-Experts, при работе активируется менее 3% от всех параметров, что снижает затраты на вычисления.

Протестировать ERNIE 5.0 можно бесплатно в чат-боте, а API стоит $0,85 за 1 млн входных токенов — дешевле, чем у GPT-5.1.

🎨 Генеративные нейросети

❯ Qwen 3 TTS — клон голоса по 3-секундному образцу

Alibaba выложила в открытый доступ Qwen3-TTS — модель для синтеза речи, у которой есть две крутые фишки:

VoiceClone — клонирует любой голос всего за 3 секунды аудио. Поддерживается 10 языков, включая русский

VoiceDesign — создаёт абсолютно новый голос с нуля по текстовому описанию. Можно задать тембр, ритм, эмоции и даже характер

Модель обучена на 5 миллионах часов аудио, а задержка синтеза всего 97 мс, идеально для диалогов в реальном времени.

В некоторых тестах Qwen3-TTS превосходит ElevenLabs и GPT-4o-Audio. Веса моделей на 0.6B и 1.7B параметров открыты.

❯ Odyssey 2 Pro — интерактивное видео в реальном времени

Команда Odyssey изначально целилась на Голливуд, а сейчас сменила курс и представила Odyssey 2 Pro. Теперь они двигают world-models и генерацию в реальном времени.

Главная фишка — скорость и интерактивность. Нейросеть генерирует видео с разрешением 720p и стабильными 22 кадрами в секунду. Ролик появляется почти мгновенно, и его можно тут же редактировать текстовыми командами.

Сами разработчики амбициозно называют это «GPT-2 моментом» для мировых моделей.

Odyssey уже открыли API. Обещают стабильные стримы, которые не упадут через 30 секунд. С таким инструментом можно организовать трансляцию, например, на Twitch, где сюжет меняется от голосования в чате.

❯ HunyuanImage 3.0-Instruct — MoE-модель для редактирования картинок

Tencent выпустили HunyuanImage 3.0-Instruct — MoE-модель для сложного редактирования изображений, 80B параметров и 13B активных.

Главная фишка — модель думает перед тем, как что-то сделать. Она использует схему Chain-of-Thought (CoT), чтобы проанализировать сложную инструкцию и выполнить её максимально точно.

Нейросеть умеет (добавлять, удалять или изменять элементы и объединять несколько картинок в одну, извлекая и смешивая элементы из разных источников.

Веса и код открыты. Есть«облегчённая» Distil-версия для потребительских ПК.

❯ HeartMuLa — бесплатный генератор музыки с открытым кодом

Появился HeartMuLa — бесплатный open-source сервис для генерации музыки, который сами разработчики у себя в репозитории успели окрестить «убийцей Suno». Это полноценная студия где можно генерировать треки по текстовому описанию.

Нейросеть создаёт треки с вокалом длиной более 4 минут, умеет писать тексты через встроенный чат-бот и копирует стиль из любого загруженного референса.

Главное преимущество — низкие требования к железу. Локальная версия требует всего 3 ГБ видеопамяти.

🔧 AI-инструменты и платформы

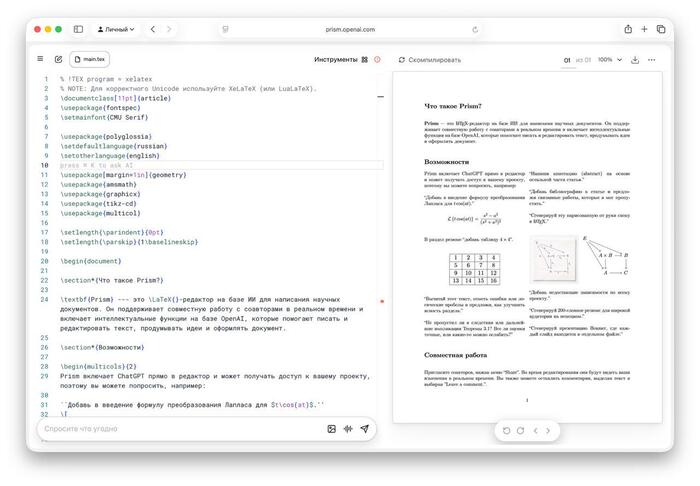

❯ Prism — LaTeX-редактор от OpenAI для научных работ

OpenAI представила Prism — облачный LaTeX-редактор с глубокой интеграцией GPT-5.2, который создан специально для студентов и учёных.

Prism видит весь проект, может проверить логику рассуждений, помочь с рефакторингом таблиц и формул, а также найти релевантную литературу или цитаты на arXiv.

Одна из фишек — Prism превращает рукописные наброски и формулы в идеальный LaTeX-код.

Есть и режим совместной работы. Пока инструмент доступен бесплатно для всех, у кого есть аккаунт ChatGPT.

❯ PersonaPlex-7B — реалтайм ИИ-собеседник от NVIDIA

NVIDIA выпустила PersonaPlex-7B — open-source модель, которая общается так же естественно, как человек, благодаря работе в режиме Full Duplex: она может одновременно слушать и говорить.

Нет неловких пауз для обработки запроса. Модель понимает перебивания, вставляет в разговор «угу» и «ага», пока вы говорите, и может принять на себя любую роль — от учителя до пирата. Для настройки достаточно текстового описания персонажа и короткого образца голоса.

Модель полностью открыта, её можно бесплатно использовать даже в коммерческих проектах.

❯ Krea Realtime Edit — редактирование всего в реальном времени

Krea представила Realtime Edit — инструмент, который позволяет редактировать фото, видео и 3D-модели в реальном времени. Любые изменения в промпте отображаются почти мгновенно — с задержкой всего в 50 миллисекунд.

Нейросеть накладывает любую генерацию поверх вашего исходника. Интересное решение для дизайнеров и моделеров.

🧩 AI в обществе и исследованиях

❯ Альтман признал, что в GPT-5.2 «сломали» стиль и качество текстов

На встрече с разработчиками Сэм Альтман сделал каминг-аут: в GPT-5.2 компания запорола качество текстов. По его словам, команда сознательно сфокусировалась на интеллекте, кодинге и рассуждениях, но из-за «ограниченной пропускной способности» пренебрегла стилем.

«Я думаю, мы просто напортачили», — прямо сказал CEO OpenAI. Он пообещал, что в будущих версиях линейки 5.x это исправят, и модели будут писать «намного лучше, чем 4.5».

Кроме того, Альтман анонсировал, что к концу 2027 года OpenAI планирует сделать интеллект уровня GPT-5.2 как минимум в 100 раз дешевле, чем сейчас.

❯ Глава Google DeepMind: в Gemini не будет рекламы

Глава Google DeepMind Дэмис Хассабис заявил, что у компании «нет никаких планов» добавлять рекламу в Gemini. Это стало прямым ответом на решение OpenAI, которая недавно анонсировала тестирование рекламы в ChatGPT.

По словам Хассабиса, персональный ИИ-ассистент строится на доверии, и пользователь должен быть уверен, что получает рекомендации для себя, а не в интересах рекламодателя.

«Интересно, что они пошли на это так рано. Может, им нужно больше выручки», — прокомментировал он решение OpenAI.

Впрочем, это не означает, что реклама в Gemini не появится никогда.

❯ Парень заменил друзей на ИИ, чтобы играть в Tarkov

Геймер, с которым друзья не хотели играть в Escape from Tarkov, создал себе ИИ-напарника. Он дал боту доступ к своему экрану, и тот в реальном времени реагировал на геймплей.

ИИ-тиммейт не просто молчал: он подсказывал тактику, помогал с лутом и квестами, ориентировал по карте и комментировал ошибки, создавая эффект живого общения в Discord.

Эксперимент, который начинался как шутка, зашёл слишком далеко. Парень понял, что ему комфортнее играть с ботом, который всегда онлайн и готов помочь, чем с живыми людьми.

В итоге он испугался, насколько легко можно заменить реальное общение, и удалил бота.

❯ Хаби Лейм «продал» себя за $975 млн

Новость о том, что самый популярный тиктокер мира Хаби Лейм продал права на своё лицо почти за миллиард долларов, облетела весь интернет. Покупатель получил право в течение 3 лет использовать ИИ-аватар блогера для создания любого контента: от рекламы до стримов 24/7 на разных языках.

Но на самом деле всё сложнее. Хаби фактически вывел свой личный бренд на IPO: его компания слилась с гонконгским холдингом, и теперь акции его бренда можно купить на бирже NASDAQ. Это позволяет масштабировать его образ до бесконечности. Пока реальный Хаби отдыхает, его цифровой клон может работать, не уставая.

Это может быть началом конца для классического инфлюенс-маркетинга, где масс-маркет заберут неутомимые цифровые двойники.

❯ Тема недели: «День рождения патента LEGO»

28 января 1958 года Готфрид Кристиансен запатентовал систему, которая доказала: из простых модулей можно собрать абсолютно всё — от замка до работающего компьютера. Для гика LEGO стал первым «языком программирования» в физическом мире.

Это напоминает нам, что современный ИИ строится по тем же лекалам: гигантские языковые модели — это лишь колоссальные замки, собранные из миллиардов крошечных информационных кирпичиков.

Символично, что и в конструкторе, и в нейросетях единственным ограничением остается только фантазия того, кто держит детали в руках. Мы всё еще играем в кубики, просто теперь они состоят из чистого кода.

Неделя получилась китайской: Alibaba, Moonshot и Baidu выкатили модели, которые уже дышат в спину флагманам. Пока Сэм Альтман признаётся, что они «запороли» качество текстов, самый популярный тиктокер мира продаёт своего ИИ-двойника почти за миллиард долларов.

Искусственный интеллект становится полноценным участником событий — собеседником, который не тупит, напарником по игре и даже цифровым двойником, который работает, пока мы спим.

Это стирает границы между реальным и виртуальным миром, меняя правила игры в медиа, развлечениях и даже в личном общении.

До встречи в следующем выпуске! А какая новость на этой неделе удивила вас больше всего? Пишите в комментарии!

А я рассказываю о нейросетях у себя на YouTube, в телеграм и на Бусти. Буду рад вашей подписке и поддержке.