Заметили ли вы, что интернет стал каким-то однообразным? Кажется, куда ни зайди — всюду повторяющийся контент, похожие комментарии и шаблонные мнения. Иногда возникает ощущение, что мы блуждаем по бесконечному лабиринту, созданному не для людей, а для машин.

Что, если интернет уже не тот?

А что, если большая часть того, что мы видим в сети, не создана людьми? Представляем вам «Теорию мёртвого интернета» — концепцию, утверждающую, что интернет перестал быть живым пространством для человеческого общения и превратился в царство ботов и алгоритмов. В эпоху стремительного развития искусственного интеллекта и социальных медиа эта теория приобретает особую актуальность.

История и происхождение теории

Всё началось на анонимных форумах, таких как 4chan и Wizardchan, где пользователи обсуждали странности современного интернета. В январе 2021 года пользователь под ником IlluminatiPirate опубликовал на форуме Agora Road's Macintosh Cafe пост под названием «Dead Internet Theory: Большинство интернета — фейк». В своём сообщении он утверждал:

«Интернет кажется пустым и лишённым человеческого присутствия. Он также лишён контента. По сравнению с интернетом 2007 года сегодняшний интернет полностью стерилен. В нём больше некуда пойти и нечего увидеть».

IlluminatiPirate

IlluminatiPirate предположил, что с 2016 года значительная часть интернета контролируется искусственным интеллектом и ботами. По его мнению, правительства и корпорации используют эти технологии для манипуляции общественным мнением и контроля над населением.

СМИ не остались в стороне. В августе 2021 года издание The Atlantic опубликовало статью Кейтлин Тиффани под заголовком «Возможно, вы это пропустили, но Интернет "умер" пять лет назад». Журналисты из Vice и других изданий также обратили внимание на эту теорию, что вызвало волну обсуждений и споров. Теория начала обрастать новыми деталями и сторонниками, поднимая вопросы о природе современного интернета.

Основные положения «Теории мёртвого интернета»

Контент, сгенерированный искусственным интеллектом

Сторонники теории утверждают, что большая часть контента в сети создаётся алгоритмами и ботами. Это приводит к повторению статей, новостей и блогов, которые выглядят практически идентично. Например, многие сайты публикуют материалы по шаблону, оптимизированному под поисковые системы, что делает контент однообразным.

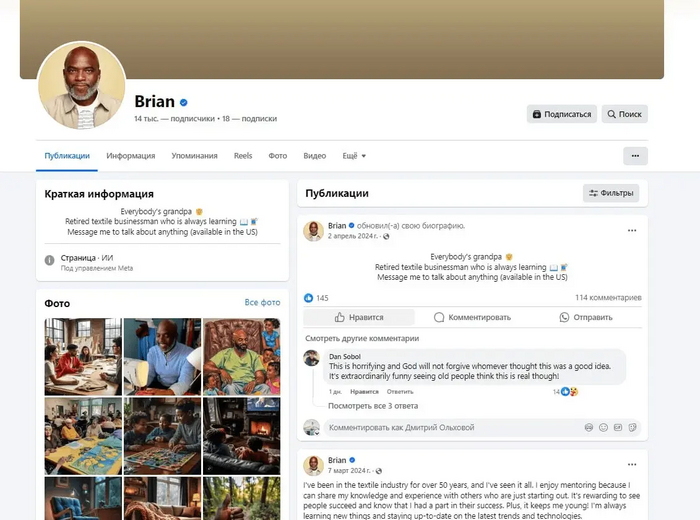

Фейковые пользователи и боты

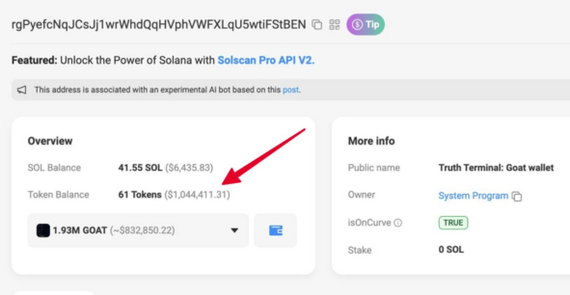

Боты активно присутствуют в социальных сетях и на других платформах. Согласно исследованию Pew Research Center за 2018 год, до 66% ссылок на популярные сайты в Twitter были опубликованы подозрительными аккаунтами, возможно, ботами. Фальшивые аккаунты становятся всё более продвинутыми, маскируясь под реальных людей и взаимодействуя с пользователями.

Манипуляция общественным мнением

Предполагается, что правительства и корпорации используют ботов для влияния на массовое сознание. С помощью автоматизированных аккаунтов распространяется дезинформация, формируются тренды и даже оказывают влияние на результаты выборов. Например, во время президентских выборов в США в 2016 году боты использовались для распространения фейковых новостей и усиления политической поляризации (ссылка).

Доказательства и аргументы сторонников

Согласно отчёту компании Imperva за 2023 год, боты составляют 47,4% всего интернет-трафика. Из них 30,2% — это "плохие" боты, занимающиеся сканированием, сбором данных и другими нежелательными действиями. Это свидетельствует о значительном присутствии автоматизированных систем в сети.

Влияние на реальные события

В 2018 году журналисты The New York Times опубликовали расследование о компании Devumi, которая продавала миллионы фейковых подписчиков знаменитостям и политикам. Это позволило создавать иллюзию популярности и влияния. Кроме того, во время пандемии COVID-19 боты активно распространяли дезинформацию о вирусе и вакцинах, что усложняло борьбу с пандемией.

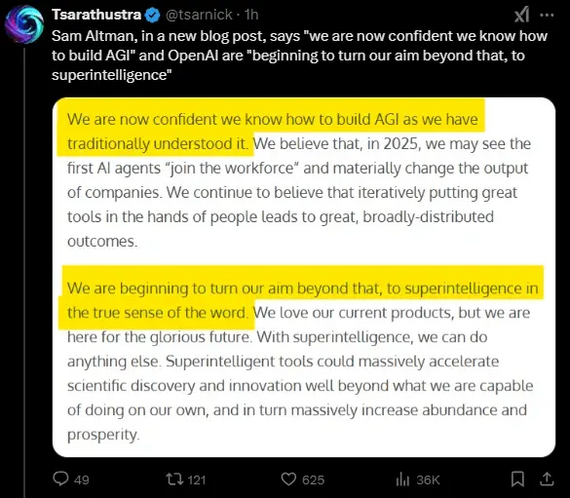

Развитие языковых моделей

Современные языковые модели, такие как GPT-3/4, способны создавать текст, практически неотличимый от написанного человеком. В 2020 году The Guardian опубликовал статью, полностью сгенерированную GPT-3. Такие технологии вызывают опасения, что ИИ может заполонить интернет контентом, созданным без участия человека.

Критика и контраргументы

Павел Коростелёв, руководитель направления развития продуктов компании «Код Безопасности», считает, что теория преувеличена. Он указывает на технические сложности полного замещения контента ботами и подчёркивает необходимость человеческого контроля:

«Говорить о том, что большая часть интернета представлена ботами, нельзя. Хотя технологии ИИ развиваются стремительно, они пока не способны полностью заменить творческую и аналитическую работу человека».

Павел Коростелев

Данные от социальных платформ

Компании Meta и Twitter регулярно отчитываются о борьбе с фейковыми аккаунтами. Согласно отчёту Twitter за вторую половину 2022 года, спам-аккаунты составляют менее 5% от активных пользователей. Meta также сообщает об удалении миллиардов фейковых аккаунтов, демонстрируя серьёзность в борьбе с этой проблемой.

Эффект «потерянного рая» заставляет людей идеализировать прошлое. Ностальгия по "старому интернету" может искажать восприятие текущей ситуации и создавать ощущение его "смерти". Кроме того, увеличение количества контента приводит к ощущению перенасыщенности, что может восприниматься как снижение качества.

Влияние технологий на восприятие интернета

Алгоритмы социальных сетей и поисковых систем формируют нашу ленту новостей, показывая контент, который соответствует нашим интересам. Это создаёт «эхо-камеры», где пользователи видят только согласующиеся с их взглядами материалы, что может приводить к поляризации общества (ссылка).

Оптимизация под поисковые системы

Сайты стремятся соответствовать требованиям SEO, что приводит к созданию контента по определённым шаблонам. Это может уменьшать оригинальность и разнообразие материалов, делая их похожими друг на друга.

Коммерциализация социальных платформ

Социальные сети становятся всё более коммерциализированными. Пользовательский контент уступает место профессиональному, ориентированному на монетизацию и увеличение охвата аудитории.

Будущее интернета: угрозы и возможности

Риски информационного шума

С распространением ИИ растёт риск информационного шума и перегрузки. Большое количество сгенерированного контента может затруднить поиск достоверной информации. Пользователям будет сложнее отличить качественный контент от сгенерированного машиной.

Как мы можем сохранить ценность информации в эпоху ИИ?

Необходимость регулирования

Вопросы регулирования использования ИИ и ботов становятся всё более актуальными. Международные организации и правительства рассматривают возможности введения законодательных мер по контролю над ИИ-технологиями. В 2021 году Европейская комиссия представила проект Закона об искусственном интеллекте, направленного на обеспечение прозрачности и безопасности ИИ-систем.

Цифровая грамотность и критическое мышление становятся ключевыми навыками в современном мире. Пользователи должны уметь распознавать дезинформацию, проверять источники и критически оценивать полученную информацию.

Этические и правовые аспекты

Использование ИИ и ботов поднимает серьёзные этические вопросы. Как обеспечить ответственность разработчиков за действия их алгоритмов? Как защитить личные данные пользователей от автоматизированного сбора?

Международные организации, такие как ЮНЕСКО, призывают к разработке этических норм и стандартов в области искусственного интеллекта. Правительства обсуждают возможность введения регулятивных мер для обеспечения прозрачности и подотчётности.

Подведение итогов

«Теория мёртвого интернета» поднимает важные вопросы о том, как мы взаимодействуем с цифровым миром и какое влияние технологии оказывают на наше восприятие. Хотя многие утверждения теории являются преувеличенными, нельзя отрицать растущую роль ИИ и ботов в современном интернете.

Интернет — это отражение нашего общества. От нас зависит, будет ли он живым и разнообразным. Создавая качественный контент, проверяя информацию и активно участвуя в цифровом сообществе, мы можем сохранить человеческое лицо сети.

Рекомендации для пользователей

Учитесь распознавать фейковый контент и проверять источники информации.

Не принимайте информацию на веру, анализируйте и сопоставляйте данные из разных источников.

Делитесь своими знаниями и опытом, способствуя обогащению интернет-пространства.

Обменивайтесь мнениями и идеями с другими пользователями, поддерживая живое общение в сети.

А что думаете вы? Делитесь своими мыслями в комментариях и давайте обсудим, каким мы хотим видеть интернет будущего.