Вышла новая модель для генерации 3D-движений человека HY-Motion 1.0

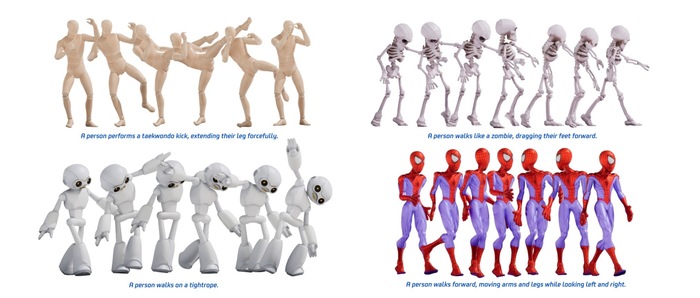

Загрузили сразу серию больших моделей для генерации 3D-движений человека по текстовому описанию HY-Motion 1.0 (https://huggingface.co/tencent/HY-Motion-1.0).

Эта модель первая в своей области с архитектурой Diffusion Transformer (DiT), масштабированная до миллиарда параметров.

Для того чтобы создать эту модель, её пришлось пронести через полный цикл обучения. В самом начале было предобучение на >3000 часов разнообразных данных о движениях. Затем началась точная настройка на 400 часах отобранных высококачественных данных. К концу перешли к доводке с помощью обучения с подкреплением (RL) на основе обратной связи от людей и reward-моделей для улучшения качества и соответствия тексту.

Для подготовки данных использовали собственный пайплайн обработки данных (очистка, аннотирование) с таксономией из >200 категорий движений.

В результате эта модель превосходит современные открытые аналоги по качеству движений и точности следования текстовой инструкции.