Вышла новая модель для машинного перевода TranslateGemma

Здесь у нас серия открытых моделей для машинного перевода на основе Gemma 3, называющаяся TranslateGemma (https://huggingface.co/collections/google/translategemma), которые специально дообучены для перевода, показывая значительное улучшение качества.

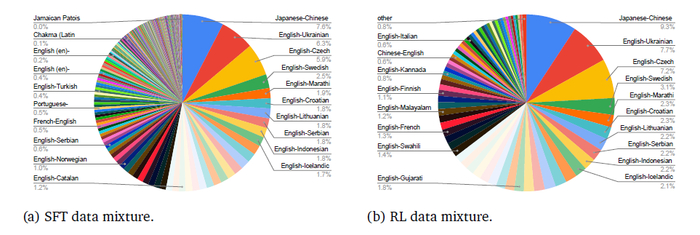

Чтобы дообучить модели первым делом использовали метод контролируемого обучения (SFT) на смеси синтетических (сгенерированных Gemini) и человеческих параллельных текстов (+30% общих инструкций). Вторым этапом шло обучение с подкреплением (RL), где для оптимизации качества использовали объединение reward-моделей (MetricX-QE, AutoMQM, ChrF и другие).

Во время сбора данных охватили множество языков, включая низкоресурсные, сочетая синтетические (Gemini + MADLAD-400) и человеческие (SMOL, GATITOS) данные.

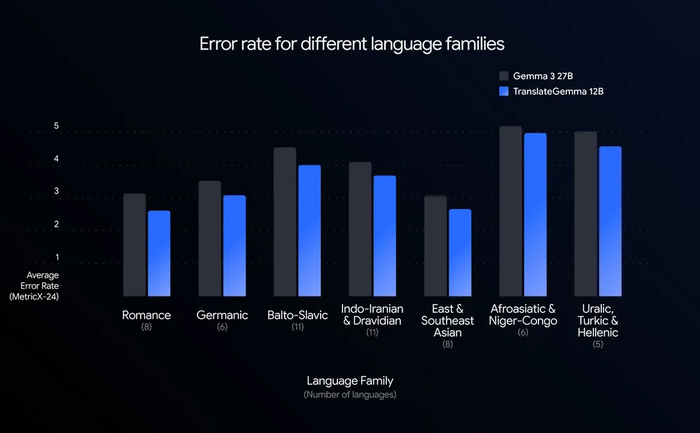

В результате на автооценке (WMT24++, 55 языков) TranslateGemma стабильно превосходит базовую Gemma 3 по MetricX и COMET22 во всех размерах (4B, 12B, 27B), причём меньшие модели часто сравнимы с большими базовыми. По задачам перевода изображений (Vistra) модели сохранили мультимодальность Gemma 3 и качество перевода текста на изображениях также улучшилось. Что касается человеческой оценки (WMT25, 10 языков), то она подтвердила улучшения, особенно для низкоресурсных языков, за исключением пары с японского на английский (регресс из-за ошибок в именах собственных).