Да выбор видеокарты сейчас перестал быть таким увлекательным занятием, как раньше.

После того, как нвидию пнули с консольного рынка, она крепко взялась за ПКшный. Её проплаченный GameWorks сильно режет производительно AMD во многих играх.

Поэтому выбор видеокарты соответствует следующей последовательности:

GTX650, GTX650Ti, GTX750Ti, GTX660, GTX760, GTX770, GTX780, 780Ti, Titan.

Конечно можно найти более выгодные аналоги из R7/R9 серии, но они муторнее в эксплуатации и, как я уже сказал, показывают себя намного хуже в проплаченных играх, к коим, например, относятся все игры Ubisoft.

После того, как нвидию пнули с консольного рынка, она крепко взялась за ПКшный. Её проплаченный GameWorks сильно режет производительно AMD во многих играх.

Поэтому выбор видеокарты соответствует следующей последовательности:

GTX650, GTX650Ti, GTX750Ti, GTX660, GTX760, GTX770, GTX780, 780Ti, Titan.

Конечно можно найти более выгодные аналоги из R7/R9 серии, но они муторнее в эксплуатации и, как я уже сказал, показывают себя намного хуже в проплаченных играх, к коим, например, относятся все игры Ubisoft.

раскрыть ветку (33)

R9 280X составляет хорошую конкуренцию 760й, по цене они отличаются на ~1k, всё что выше по цене лучше брать Nvidia, 770, 780, 780ti.

раскрыть ветку (8)

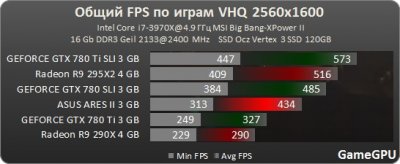

Кому он нужен. Проигрывает R9 295x2, шумнее, горячее и стоит в 2 раза дороже. За эти деньги можно 4 GTX780Ti взять и еще сдача останется.

раскрыть ветку (7)

раскрыть ветку (6)

раскрыть ветку (2)

"Имхо, Титан - серия компромисс, которая сочетает в себе плюшки GeForce, такие как CUDA и ништяки Quadro.", как я уже писал комментом ниже.

раскрыть ветку (1)

Никаких "нишяков" quadro он не поддерживает. Оптимизации на уровне драйверов нет, как у квадры, как и памяти с коррекцией ошибок и мощной гарантийной поддержки.

раскрыть ветку (1)

Имхо, Титан - серия компромисс, которая сочетает в себе плюшки GeForce, такие как CUDA и ништяки Quadro.

Ну блок вычислений с двойной точностью работает. Однако за цену одной карты можно взять 3 титана, а это все равно быстрее в вычислениях.

ещё комментарий

амд не так уж и хуже, я лучше возьму карту от более менее честной конторы, гораздо дешевле и буду играть в игры на 10 фпс меньше, чем покупать продукцию от лживых производителей, с необоснованной накруткой за бренд

раскрыть ветку (5)

Ну хоть Nvidia больше походит на корпорацию зла, лучше все же их карту взять, так как они стали вливать много денег в ПК рынок, а значит, игры, компаний которые сотрудничают с ней, получат большую производительность и дополнительные спецэффекты, в то время как конкурентам достанется худшая оптимизацию. Неприятная правда, которую не исправить до тех пока пока мантл не пойдет в массы.

А AMD я поддержу покупкой PS4.

А AMD я поддержу покупкой PS4.

раскрыть ветку (4)

раскрыть ветку (2)

И чем же?

Как я уже сказал, зеленых прогнали с консольного рынка, предпочитая более выгодное решение от AMD, да и мобильный рынок они прикрывают, после не самых удачных камней.

Естественно они теперь крепко взялись за ПК рынок, со своим GameWorks, который при незначительном улучшении картинки, чудовищно режет производительность на AMD. Похожее было с внедрением Физикса, но его хотя бы можно было отключить, а тут совсем беда. Пока GameWorks поддерживает только Ubisoft (это уже как минимум 3 AAA игры в это году). А что будет когда в массу пойдет UE4, где так же внедрена эта технология?

Так что уверяю тебя - это не бред.

Как я уже сказал, зеленых прогнали с консольного рынка, предпочитая более выгодное решение от AMD, да и мобильный рынок они прикрывают, после не самых удачных камней.

Естественно они теперь крепко взялись за ПК рынок, со своим GameWorks, который при незначительном улучшении картинки, чудовищно режет производительность на AMD. Похожее было с внедрением Физикса, но его хотя бы можно было отключить, а тут совсем беда. Пока GameWorks поддерживает только Ubisoft (это уже как минимум 3 AAA игры в это году). А что будет когда в массу пойдет UE4, где так же внедрена эта технология?

Так что уверяю тебя - это не бред.

раскрыть ветку (1)

А никто не будет пилить движок, железо которого большая часть рынка не поддерживает. Больше 70% юзеров, согласно стимовской статистике играет на интеловских встройках и картах amd. Зачем разработчикам писать движок, все плюшки которого будут доступны меньшинству?

ещё комментарии

А ничего, что между Titan black и GTX780Ti разницы в производительности нет. У них чипы абсолютно одинаковые. Да и одна игра не показатель. Так было всегда - где то одни быстрее, где то другие.

раскрыть ветку (8)

Ты сейчас про что?

Titan Black в любом случае будет классом выше, даже несмотря на одинаковую архитектуру и производительность. Там, как никак, в два раза больше памяти.

Со временем, эта разница покажет себя. Например, недавно вышедшему Watch_Dogs на максимальных настройках уже требуется больше 3гб видеопамяти.

Titan Black в любом случае будет классом выше, даже несмотря на одинаковую архитектуру и производительность. Там, как никак, в два раза больше памяти.

Со временем, эта разница покажет себя. Например, недавно вышедшему Watch_Dogs на максимальных настройках уже требуется больше 3гб видеопамяти.

раскрыть ветку (7)

раскрыть ветку (3)

Это да. Но в будущем такое количество потребляемой памяти вполне возможно. На консолях 8гб унифицированной памяти, а значит в ближайшем будущем (когда пойдут некстген игры) такой же минимум нужен будет и на ПК.

раскрыть ветку (2)

С вами нельзя не согласиться. Тот запас, который заложен в консоли последнего поколения, определенно намекает на развитие технологий графики в частности. Меня лишь огорчил тот факт, что игра так сильно раскрученая рекламой, так сильно обманула мои, конкретно, ожидания.

У меня самого скромный Redeon 6790 (по- моему), хотя я побегал в Ватч Догс, хоть и на минималках. Хотя бы оценил гемплей. С таким железом я особо не пытаюсь оценить графику D;

У меня самого скромный Redeon 6790 (по- моему), хотя я побегал в Ватч Догс, хоть и на минималках. Хотя бы оценил гемплей. С таким железом я особо не пытаюсь оценить графику D;

раскрыть ветку (1)

Я начитавшись обзоров решил даже не пытаться запустить игру. Прошел на PS3. И близко не похоже на E3 2012, зато хотя бы бегает стабильно)

3 гб видеопамяти Оо, Боже, мой комп такой старый там 512 мб, джифорс ДжТи 9800, пора менять железло

раскрыть ветку (1)

http://www.overclockers.ru/hardnews/61174/Galaxy_predlagaet_...

И такой трюк проделал уже не один производитель.

И такой трюк проделал уже не один производитель.

ещё комментарий

раскрыть ветку (7)

Я не стал указывать 690 потому что это двухчиповая карта. А двухчиповая в жизни не пригодится для обычных игроков. Если же просто хочется самый самый топ, то есть 295X2.

P.S. 780Ti и Titan по производительности на одном уровне.

P.S. 780Ti и Titan по производительности на одном уровне.

раскрыть ветку (6)

690 - это такая же игровая видеокарта. И фпс в играх выдает на 30-50% больше, чем 6990 и 7970. А 690 SLI - это топ

раскрыть ветку (5)

Игровая. Но как и остальные двухчиповые решения я бы их не посоветовал для игр без реальной надобности (например, сверхвысокое разрешение, несколько мониторов или 3D/VR).

А топ - это кроссфайр из R295X2, правда я представить не могу кому такой монстр нужен.

А топ - это кроссфайр из R295X2, правда я представить не могу кому такой монстр нужен.

раскрыть ветку (4)

Двухчиповая видеокарта - это, по сути, тот же SLI в лице одной карты.

Как по тестам, так ничего особенного. Одна двухчиповая карта мощнее на 10-15%, чем 780Ti SLI. Учитывая цену, тем более

Как по тестам, так ничего особенного. Одна двухчиповая карта мощнее на 10-15%, чем 780Ti SLI. Учитывая цену, тем более

раскрыть ветку (3)

Сейчас нет двухчиповок, которые быстрее 780Ti в SLI.

Даже 295X2 в среднем проигрывает на 10-15%, не говоря уже о более слабых 7990 и GTX690.

Даже 295X2 в среднем проигрывает на 10-15%, не говоря уже о более слабых 7990 и GTX690.

раскрыть ветку (2)

ещё комментарии