Представлен новый метод mHC от DeepSeek

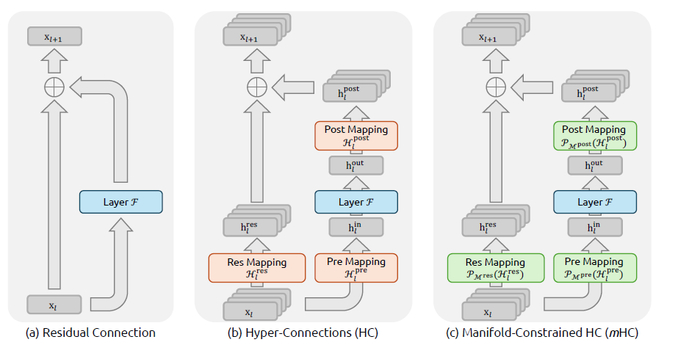

Проблема заключается в том, что метод Hyper-Connections (HC) расширяет и усложняет остаточные связи, что даёт прирост качества, но нарушает ключевое свойство identity mapping, приводя к нестабильности обучения (взрыв/затухание сигнала) и высоким системным накладным расходам при масштабировании.

Для решения этого был создан общий фреймворк mHC (Manifold-Constrained Hyper-Connections) (https://arxiv.org/abs/2512.24880), который проецирует пространство остаточных связей HC на специальное многообразие, восстанавливая свойство identity mapping.

Идея заключается в том, чтобы ограничить матрицу остаточного смешивания H_l^res множеством дважды стохастических матриц (Birkhoff polytope) с помощью алгоритма Sinkhorn-Knopp, гарантируя сохранение средней интенсивности сигнала (нормы) и его стабильность при распространении по слоям.

Для оптимизации использовали ядерное слияние (Kernel Fusion) и смешанную точность для снижения накладных расходов на доступ к памяти. Кроме того, применили перевычисление (Recomputing) активаций для экономии памяти. Дополнительно задействовали наложение вычислений и коммуникации в конвейерном расписании DualPipe.

В результате стабильность mHC устраняет нестабильность обучения HC, а градиенты остаются ограниченными. Также это привело к улучшению качества, превышая производительность базовой модели и HC на множестве тестов (MMLU, DROP, GSM8K и др.). Что касается масштабируемости, то этот метод эффективен для обучения больших моделей. При n=4 добавляет только ~6.7% к времени обучения. В конечном счёте инфраструктурные оптимизации сводят системные накладные расходы к минимуму.