Вышла новая модель IQuest-Coder-V1

Выложили семейство языковых моделей для кода (7B, 14B, 40B, 40B-Loop), достигших передовых результатов (https://huggingface.co/IQuestLab/IQuest-Coder-V1-40B-Loop-In...). Основной идеей было Code-Flow Training, где происходит обучение на динамической эволюции кода, а не на статических снимках.

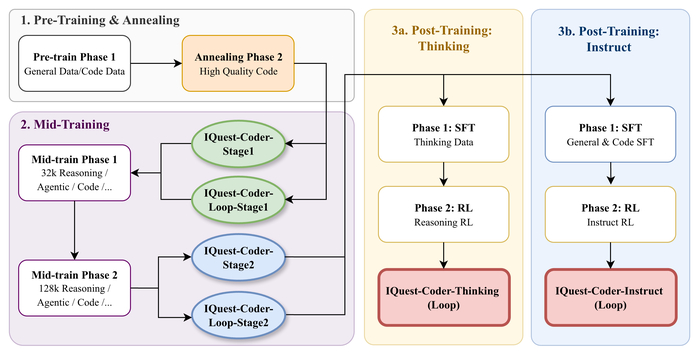

Во время обучения модель прошла несколько этапов.

В самом начале было предобучение на общих и код-данных, включая коммиты (историю изменений). Затем Mid-Training, который был критическим этапом на 32k/128k контексте с данными для логического рассуждения и агентских траекторий, что сформировало глубокую логическую основу. После началось пост-обучение, состоящее из двух путей. Первым был Thinking Path с обучением с подкреплением (RL) для автономного рассуждения и исправления ошибок, а вторым был Instruct Path, оптимизированный для следования инструкциям и общей помощи.

Архитектура Loop (V1-40B-Loop) представляла рекуррентный механизм для итеративной обработки сложного кода. Оптимизируя баланс между качеством и вычислительными затратами.

К концу были сделаны несколько выводов. Первый из них заключается в том, что данные из истории коммитов (изменений) лучше учат планированию задач, чем статический код. Второй, что внедрение траекторий рассуждения перед пост-обучением стабилизирует работу модели. Третий о том, что путь "Thinking" (с RL) даёт модели emergent-способность к самостоятельному исправлению ошибок в сложных задачах.

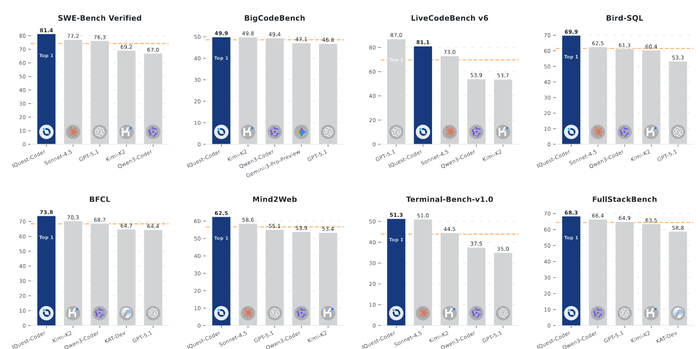

В результате модели показывают State-of-the-Art (SOTA) результаты в ключевых областях. Например, агентской разработке (SWE), соревновательном программировании, редактировании кода, использовании инструментов и рассуждениях.

А ещё была выпущена полная "белая" цепочка чекпоинтов для исследований.