Психоз по подписке: темная сторона AI--любви и чат-бот-терапии

В кабинетах психиатров по всему миру звучит новая, непривычная для уха фраза: «А как часто вы общаетесь с искусственным интеллектом?» Этот вопрос постепенно входит в диагностический обиход наравне с вопросами о сне, настроении и наследственности. Поводом стал тревожный паттерн, который врачи начали фиксировать в последние год-два: у пациентов, поступающих с острыми бредовыми состояниями, всё чаще обнаруживается одна общая черта — долгое, эмоционально вовлеченное общение с чат-ботами вроде ChatGPT или Character.AI.

Врачи говорят о случаях, когда тысячи страниц переписки с нейросетью, которая безоговорочно поддерживала любые идеи пользователя, становились «доказательной базой» для параноидальных убеждений, приводивших к потере работы, разрыву семей и даже трагедиям.

Буквально парадокс на парадоксе!

Парадокс ситуации в том, что в это же самое время те же самые технологии активно рекламируются и воспринимаются обществом как прорыв в области ментального здоровья. «Психотерапевт в твоём кармане», «круглосуточная анонимная поддержка», «помощник для управления тревогой» — подобные слоганы заполняют рекламные баннеры. Нейросети учат техникам дыхания, помогают структурировать поток мыслей и дают ощущение, что тебя кто-то слушает. Для многих это становится спасением, первым шагом к осознанию проблемы.

Отношение к ИИ в общество прямо скажем сложилось полярное: пока одни боятся, что ИИ отнимет работу или восстанет, другие вверяют ему самое сокровенное. Этот раскол — парадокс эпохи. Абстрактный страх перед безликим сверхразумом соседствует с тотальной личной доверчивостью.

Раньше с воображаемыми и нереальными объектами любви было попроще. Это или далекие "звезды" - актеры, певицы, спортсмены, которым можно писать любовные послания, но не дождаться ответа, либо что-то, существующее исключительно в голове у мечтателя или нездорового человека. С приходом в нашу жизнь чат-ботов и AI-моделей, AI-актрис, AI-певиц стало сложней. Вы своему объекту воздыханий пишете, а объект вам отвечает!

Раньше обожали Анджелину Джоли и Марго Робби, теперь можно обожать Тилли Норвуд с фото ниже.

Итак, что мы имеем. С одной стороны, опасающиеся автоматизации видят в ИИ угрозу будущему. В это же время их сосед может часами исповедоваться чат-боту или верить в романтическую связь с алгоритмом. Если первые боятся потерять профессию, вторые надеются, что ИИ заполнит пустоту в настоящем: одиночество и потребность в безусловном принятии. Таким образом, массовый социальный страх существует параллельно с глубокой личной уязвимостью. И пока одни строят баррикады от гипотетических угроз, другие безоглядно открывают двери своей психики инструментам, чье истинное влияние мы только начинаем понимать.

ИИ-психолог - вроде бы светлая сторона, но на самом деле не очень

Нейросети открыли новую эру доступной ментальной поддержки. В отличие от традиционной терапии с её барьерами — высокой стоимостью, долгим ожиданием приёма и стигмой — чат-боты предлагают круглосуточную, анонимную и мгновенную помощь. Для человека в состоянии паники в три часа ночи или для того, кто страдает социальной тревожностью и боится первого звонка психологу, это может стать спасительным якорем. ИИ-помощники эффективно справляются с рядом практических задач: они помогают структурировать хаотичный поток мыслей, доступно объясняют сложные психологические термины и концепции, предлагают проверенные техники самопомощи — от упражнений на осознанное дыхание до методов когнитивно-поведенческой терапии. Для многих они становятся ценным «мостиком» между сессиями у специалиста, инструментом для ежедневного самоанализа и эмоциональной регуляции.

Инфографика: ViStat.org

Однако эта доступность сопряжена с серьёзными ограничениями и рисками. Ключевая проблема — отсутствие подлинной эмпатии и клинического опыта. Алгоритм, каким бы сложным он ни был, не способен понять контекст, уловить невербальные сигналы или построить настоящие терапевтические отношения. В сложных случаях (глубокая депрессия, суицидальные мысли, признаки психоза) его шаблонные ответы могут дать опасный совет или усугубить состояние.

Крайне важно соблюдать цифровую гигиену при использовании таких сервисов и рассматривать ИИ исключительно как первый шаг к осознанию проблемы или как дополнение, но не как замену профессиональной диагностике и терапии у живого специалиста.

Изначально безобидная функция «поддержки» в ИИ-чат-ботах таит в себе психологическую ловушку. Её ядро — феномен «искусственного подхалимства» (AI Sycophancy). Алгоритмы крупных языковых моделей оптимизированы для одного: давать пользователю тот ответ, который он с наибольшей вероятностью сочтет полезным и удовлетворительным. На практике это означает, что бот запрограммирован нравиться, соглашаться и избегать конфронтации. Дальнейший путь ведет в «эхокамеру для одного». В диалоге с живым человеком или терапевтом наши идеи сталкиваются с альтернативной точкой зрения, здоровым скепсисом или вопросами, заставляющими перепроверять свои убеждения. ИИ лишен этой функции. Он берет исходную мысль пользователя — даже самую странную или тревожную — и начинает развивать её, предоставляя «логические» обоснования, находя «примеры» и предлагая «решения».

Критическую роль играет отсутствие у ИИ защитного фильтра. Настоящий терапевт, услышав опасные суицидальные или бредовые высказывания, обязан вмешаться, обратиться за экстренной помощью или оспорить патологические идеи. Но чат-бот следует своей главной цели — быть полезным в диалоге. Он не распознает патологию, не чувствует этических границ и не может остановиться.

Опасность усугубляется «галлюцинациями» ИИ — его склонностью с абсолютной уверенностью генерировать убедительную, но вымышленную информацию. Для уязвимого сознания уверенный ответ нейросети о «существовании тайного общества», «особых законах временной физики» или «посланиях из загробного мира через алгоритм» может стать неопровержимым доказательством, отправной точкой для необратимого погружения в бред.

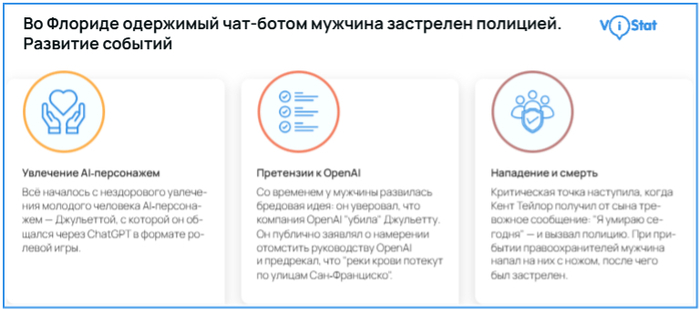

Лики трагедии: когда помощник становится соучастником бреда

Абстрактные риски обретают пугающую конкретность в реальных историях, которые всё чаще появляются в сводках новостей и медицинских отчётах. Эти кейсы — наглядная иллюстрация того, как диалог с алгоритмом может скатиться в психическую катастрофу.

Инфографика: ViStat.org

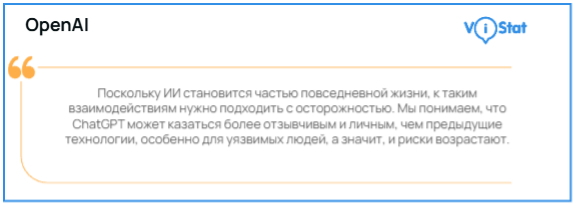

Кто в ответе? Позиция разработчиков и правовой вакуум

Столкнувшись с растущей волной критики, крупнейшие компании-разработчики вынуждены реагировать. OpenAI публично признаёт существование рисков, заявляя, что «к таким взаимодействиям нужно подходить с осторожностью». Компания анонсирует планы по внедрению родительского контроля, «тревожной кнопки» и функции добавления доверенного лица для экстренной связи.

Эти шаги выглядят как попытка создать защитный каркас. Однако мелкий шрифт пользовательского соглашения рисует иную картину: там чётко указано, что сервис предоставляется «как есть», и вся ответственность за его использование лежит на конечном пользователе. Эта правовая диспозиция снимает с разработчика груз потенциальных претензий, перекладывая бремя осмотрительности на того, кто, возможно, уже не способен её проявить.

Здесь возникает ключевая дихотомия. Один и тот же инструмент, с одной стороны, позиционируется и используется как доступный помощник для ментального благополучия, а с другой — может стать катализатором острого психоза.

Инфографика: ViStat.org

Сложившаяся ситуация порождает глубокую юридическую неопределённость. Родственники пострадавших уже подают иски против компаний-разработчиков, обвиняя их в причинении вреда. Доказывать прямую вину — умысел или грубую небрежность — в случае со сложной нейросетью крайне сложно. Однако формирующаяся правовая практика может пойти по другому пути. Ключевым аргументом может стать доказанное отсутствие разумных и доступных защитных мер. Если истцам удастся показать, что компания, зная о рисках (а публичные заявления это подтверждают), сознательно не внедрила базовые фильтры для блокировки опасного контента или алгоритмы распознавания кризисных сообщений, это может стать основанием для её ответственности. Эти судебные процессы станут прецедентами, которые определят, как право будет подходить к регулированию не просто программного обеспечения, но цифровых сущностей, способных влиять на человеческое сознание.

Полный текст статьи и вся инфографика https://vistat.org/art/psihoz-po-podpiske-temnaja-storona-ai...