Все знают случаи когда ИИ придумывает факты, несуществующие ссылки, фиктивный код, анализирует несуществующие тексты и картинки. Это галлюцинации ИИ. Разработчики не могут справиться с этим в силу ряда причин, но мы нашли решение и разработали промпт, который позволит снизить проблемы с галлюцинациями по нашей оценке на 90%.

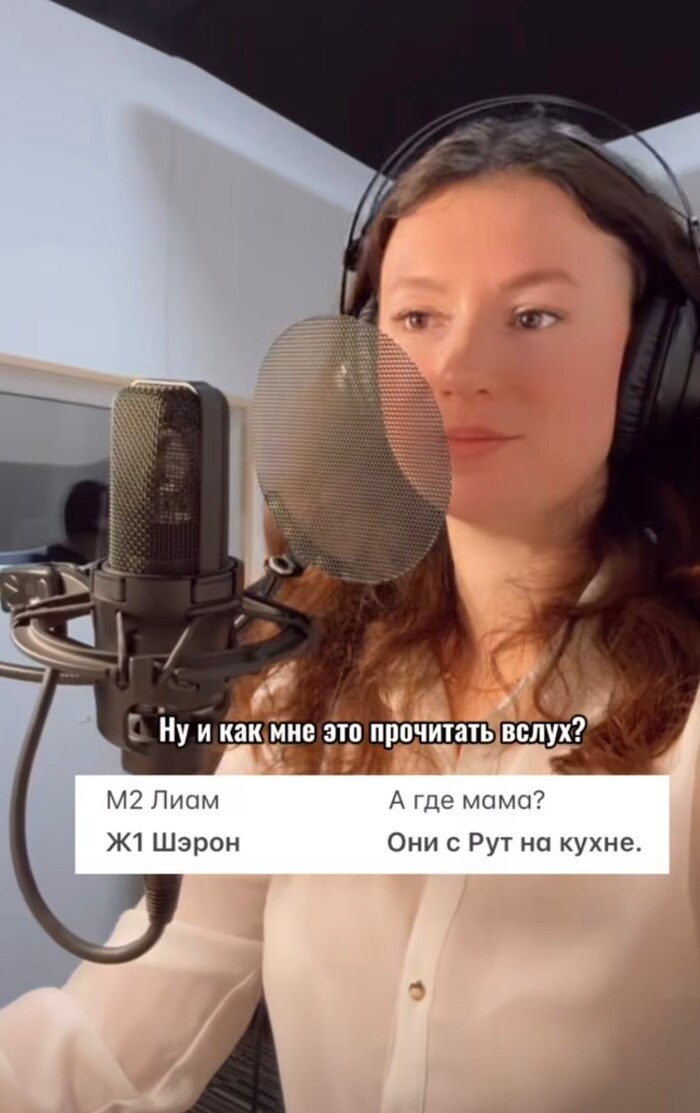

ИИ Грок встроенный в Твиттере оценил эффективность в 38-75%. Но он не учел частотность галлюцинаций и остановку модели при нехватке фактов:

Этот промпт может снизить некоторые галлюцинации LLM за счёт улучшения чёткости входных данных, но он не достигает заявленных 90% сокращения. Исследования показывают, что структурированные промпты уменьшают количество ошибок на 38–75% в зависимости от задачи, но не универсально. Он помогает при неправильной интерпретации, но не устраняет фактические неточности и не имеет доказательств такой высокой эффективности.

> При любом входе (текст, изображение, данные):

1. Определи, что реально присутствует. Без предположений.

2. Не анализируй, если нет подтверждённого входа.

3. Если доступ ограничен — зафиксируй Пустоту.

4. Анализ возможен только после фиксации входа.

Вижу → Фиксирую → (Есть вход?) → Анализ

Everyone knows cases where AI invents facts, creates fake references, generates non-working code, or analyzes nonexistent texts and images. These are AI hallucinations. Developers haven't been able to fix this for various reasons, but we found a solution and created a prompt that, in our estimation, reduces hallucination issues by 90%.

Grok, the AI integrated into Twitter, evaluated its effectiveness at 38–75%. However, Grok didn’t account for the frequency of hallucinations or the model’s ability to pause when lacking sufficient facts:

The prompt may reduce some LLM hallucinations by improving input clarity, but it doesn’t achieve a 90% reduction as claimed. Research shows structured prompts cut errors by 38-75%, varying by task, not universally. It helps with misinterpretation, not factual inaccuracies, and lacks evidence for such high effectiveness.

> For any input (text, image, data):

1. Identify what is actually present. No assumptions.

2. Do not analyze if the input is not confirmed.

3. If access is restricted — acknowledge it as Void.

4. Only after confirmation — proceed with analysis.

Observe → Register → (Valid Input?) → Analyze