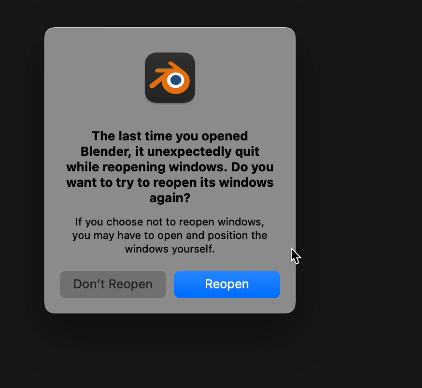

Разбор ошибки Blender has stopped working / Разбор похожих ошибок / Как защитить свои файлы от утери

Сейчас я расскажу о баге, который случился недавно, когда я зашёл на официальный сайт по багам Blender, сделав анализ большого количества сообщений от других пользователей, понял, что не только у меня подобное случилось. На данный момент из-за серверной части Vulkan, который является частью модуля gpu, на новых версиях стали происходить массовые баги, в связи с чем я себе сказал, что когда решу эту проблему, расскажу всё, что либо нашёл, и как я её решил.

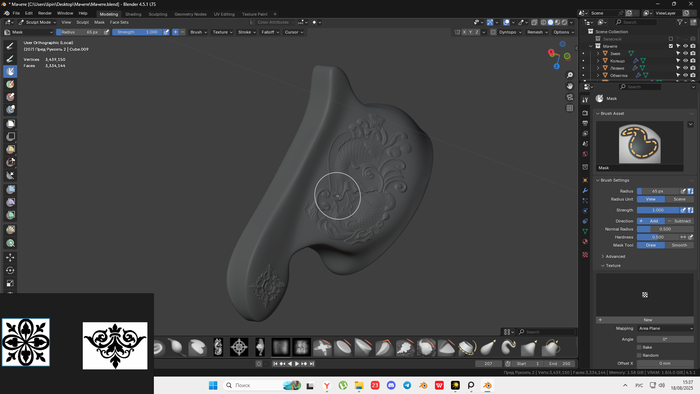

У меня проблема возникла во время скульптинга, файл сам по себе имел большой вес, когда я хотел закрыть проект, произошёл автосейв и получился тайминг, который и сломал модель, это я сделал вывод исходя из поиска решения. Что я делал, чтобы исправить ошибку: Blender crashes opening certain file.

Проект весил более 80 mb, имел версию 4.5.1 LTS.

Пункты я расставил в приоритетном порядке. То, что поможет точно — принудительная выкачка файлов со сцены.

Та самая выкачка файлов.

1. Открыть новую сцену -> File -> Append -> выбираем наш файл -> выбираем и по пунктам добавляем файлы -> осторожно с файлом scene — он может быть багнутым, и программа вылетит. \

2. Зайти в папку autosave и открыть прошлые сохранения, но если вы, как я, их удалили случайно или у вас их нет, то задумайтесь. \ *Если вы их удалили, то даже не думайте о программах для восстановления удалённых данных, я через это прошёл и могу сказать, что файлы после восстановления будут сломаны, но на файлы сцены, которые весят меньше 2mb может и сработает, но это до сотни полигонов :)

3. Открыть дополнительные сохранения, они находятся там же, где и сам файл, имеют тег blend1, blend2 и т. д. Рекомендую вам настроить их количество. Это делается там же, где и autosave. Функция называется «Save versions». \

Решение проблемы без выкачки.

- Скинуть файл доверенному другу, если открывается и у него, то пробуем все остальные способы. Если нет, можно на способы ниже не надеяться (но лучше попробовать) и сразу приступать к выкачке данных со сцены.

- Пытался запустить файл от имени администратора, через командную строку, через различные запуски блендера со специфическими ограничениями (запустить на базе OpenGL и т. д.). Запустить blender можно по-разному, достаточно глянуть его расположение, и можно увидеть много приложений cmd для аварийного запуска программы.

- Пытался проверить абсолютно все обновления PC, переустановил разные версии обновлений для видеоядра.

- Пытался открыть проект на других версиях (на версии 4.3 он не запускается, на версии 5.0 крашится). *Версия 5.0 имеет нововведения по устранению багов.

- Пытался отключить кастомные аддоны.

- Пытался переустановить Blender.

- Пытался использовать Steam-версию Blender.

- Пытался открыть файл в другом расположении. *В другой папке под другим именем, поменяв русский на английский. «Мачете» -> «Machete».

- Были попытки перезапуска компьютера. (Несколько раз комбинируя разные методы.)

- Я не пробовал, но как способ — запустить blender на другой видеокарте или без неё.

Что мне помогло? -Выкачка файлов через append и только..

Что я поменял? -Я сделал расположение временных файлов в другом месте, там я точно их не удалю, я увеличил количество сохранений до 5 (которые имеют тег blend1, blend2 и т. д.)

Я узнал о других ошибках и о их решениях, чаще начал сохранять файлы, больше появилось доверия к сообществу 3d.

Я нашёл решение сам, но спустя 2 часа решения, мне написали много вариантов, из которых и было тоже моё решение, это не может не мотивировать делать также.

Сайт с багами сообщества Blender - https://projects.blender.org/blender/blender/issue...

Сайт с новыми версиями Blender - https://builder.blender.org/download/daily/

Сайт с подробным списком версий Blender - https://download.blender.org/release/

Буду благодарен за распространение данной информации, сократим проблемы нашим коллегам.