REG RU vs PQ Hosting: разница между известностью и удобством

REG.RU — один из самых узнаваемых хостинг-провайдеров в России. Бренд сильный, сайт внушает доверие, и многие выбирают его просто потому, что «знают». Я протестировал VPS от REG.RU и сравнил с тем, что предлагает PQ.Hosting.

Цены и конфигурации

На старте REG.RU предлагает минимальный VPS за 480 ₽ в месяц — 1 ядро, 1 ГБ оперативной памяти и 10 ГБ NVMe. Но даже скромная рабочая конфигурация с 2 ядрами и 2–4 ГБ RAM обойдётся уже в 1200–2400 ₽. За 6 ядер и 6 ГБ — 3360 ₽ в месяц. Тарифы растут резко, и чем ближе к среднему уровню нагрузки, тем дороже каждый следующий шаг.

Для сравнения, в PQ.Hosting аналогичная конфигурация обойдётся в 5–6 евро — это около 500–600 ₽. Так же, стоимость не зависит от локации, а их там 46+, даже в самых востребованных странах цена одинаковая.

Прозрачность условий

REG.RU даёт возможность выбрать между стандартным SSD и более быстрым NVMe, но интерфейс выбора сбивает с толку. Под разные ядра идут разные частоты — от 2.2 ГГц до 3.7+, но без чёткого объяснения, что именно ты получаешь в рамках тарифа. У PQ.Hosting всё указано прямо — и по типу диска, и по частоте CPU, и по пропускной способности порта.

Панель и управление

REG.RU предлагает собственную панель управления. Она функциональна, но перегружена: много настроек, разбросанных по разделам, неинтуитивное размещение базовых параметров. Подойдёт тем, кто привык работать «по старой школе».

У PQ.Hosting интерфейс проще и быстрее. Всё ключевое — на одном экране, развёртывание занимает пару минут. Особенно это чувствуется, если часто переключаешься между локациями или управляешь сразу несколькими VPS.

Поддержка

REG.RU работает через тикеты, отвечает стабильно, но ощущается некоторая дистанция. Хотя возможно это мне так “повезло”, ситуация максимально “индивидуальная”. У PQ.Hosting — техподдержка, которая реально общается: через Telegram, почту, live-чат. В моём случае ответы приходили быстрее, и по делу.

REG.RU остаётся узнаваемым и массовым провайдером. Но если смотреть по цене, скорости включения, прозрачности тарифов и удобству панели — PQ.Hosting оказывается заметно выгоднее. Особенно если не принципиально размещение в РФ (хотя РФ регион имеется и у PQ.Hosting), а важнее — соотношение цена / производительность.

А как вам Reg.ru? Делитесь своим мнением в комментариях.

Как мы меняем индустрию: цены, бесплатный хостинг и комьюнити

Смотри, индустрия хостинга давно сгнила изнутри. Тут всё построено не на сервисе, а на выжимании: продай домен, дожми на апгрейд, подними цену через год.

Мы решили, что пора это хоронить. Поэтому сделали WebHostMost. Не чтобы “откусить долю рынка”, а чтобы не блевать каждый раз, когда ищешь нормальный веб хостинг.

Мы не дешевле всех. Мы честнее всех

Наша цена - это не “3$ в первый месяц, 9$ потом, и 17$ с третьего, если ты не заметил”.

У нас цена, которую ты видишь - остаётся навсегда, даже если купил со скидкой.

Фикс. Всегда. Без писем с сюрпризами.

Сайт грузится за полсекунды - это норма, а не тюнинг

LiteSpeed Enterprise (а не бесплатный OpenLiteSpeed)

Redis, HTTP/3, Brotli, Keep-Alive, APC Cache

NVMe-диски

Процессоры Ryzen EPYC

Инфраструктура, где реально есть защита от DDoS, Imunify360 и мониторинг 24/7

Пока другие строят “скорость” через прокси и заклинания, у нас она встроена в основу.

Бесплатный хостинг - без рекламы, боли и подвохов

Да, у нас есть реальный бесплатный тариф.

- Без баннеров.

- Без вымогательства “перейдите на PRO, чтобы не лагало”.

- С LiteSpeed, защитой, A+ заголовками и даже поддержкой.

Бесплатный хостинг - не значит ущербный. Это вход в нормальную экосистему, не маркетинговый мусор.

А теперь то, что конкуренты продают отдельно - у нас просто включено

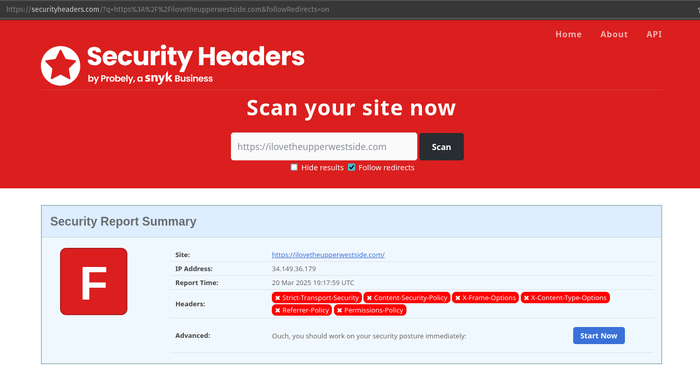

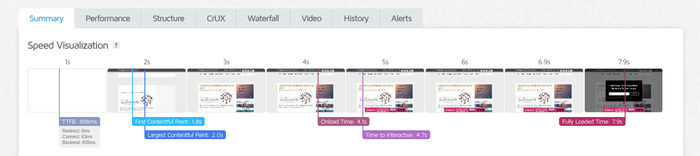

A+ по Security Headers - проверено через securityheaders.com (На секундочку, НИ ОДИН хостинг во всем мире не предоставляет такую защиту сразу "из коробки". А у нас это просто есть. Для всех, даже на бесплатном тарифе).

Поддержка всех стеков: WordPress, Node.js, Python, PHP, Laravel, Symfony, PostgreSQL, MongoDB, MariaDB и даже Perl

Настоящая админка - DirectAdmin с кастомом. Никакого cPanel с интерфейсом 2007 года

Встроенная почта, Cron, SSH, Web терминал, email-алиасы

Бесплатный SSL, домен, CMS-установщик, мгновенная активация

Прозрачный контроль над DNS, файлы, базы, FTP - всё через 1 панель

Мы не просто хостим. Мы строим своё комьюнити

Вот где мы реально выбиваемся из шаблона:

forum.webhostmost.com - который пока что просто есть =D

docs.webhostmost.com - не “чекни FAQ”, а пошаговые инструкции, гайды, примеры

blog.webhostmost.com - статьи, сравнения, боль и правда про хостинг

Telegram-чат - где отвечают не “менеджеры по клиентскому счастью”, а девопсы, саппорты, дизайнер и даже директор

И да, индустрия нас пока что ненавидит. Потому что:

Мы не делаем апсейл на функции, которые должны быть базой

Мы не ограничиваем пользователей, как shared-хостинги образца 2014

Мы не прячемся за чат-ботами, а реально сидим в комментах

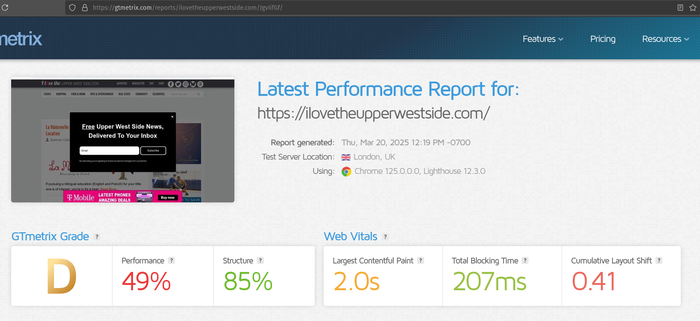

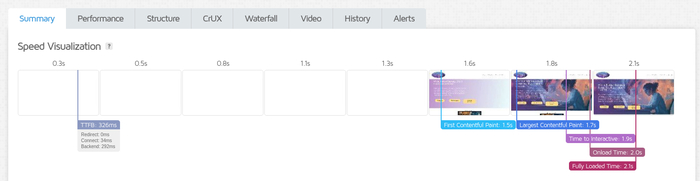

Кстати, вот вам немного сравнений с GTMetrix и SecurityHeaders рандомного UK сайта, который хостится на любом другом хостинге (в этом примере на SiteGround) и на нашем:

SiteGround:

WebHostMost:

И да, нас можно пнуть, задать неудобный вопрос и даже “о ужас” - поспорить с нами.

Но мы ответим. Мы рядом. Мы - WHM Crew.

Повышение производительности с использованием LVM Striping

В области управления хранилищами приоритетом является достижение оптимальной производительности дисков. Стремление к более быстрому доступу к данным, уменьшению задержек и повышению количества операций ввода-вывода (I/O) и пропускной способности привело к использованию передовых техник. Одной из таких является LVM Striping (полосование), мощная функция менеджера логических томов (LVM), которая существенно повышает производительность дисковых томов.

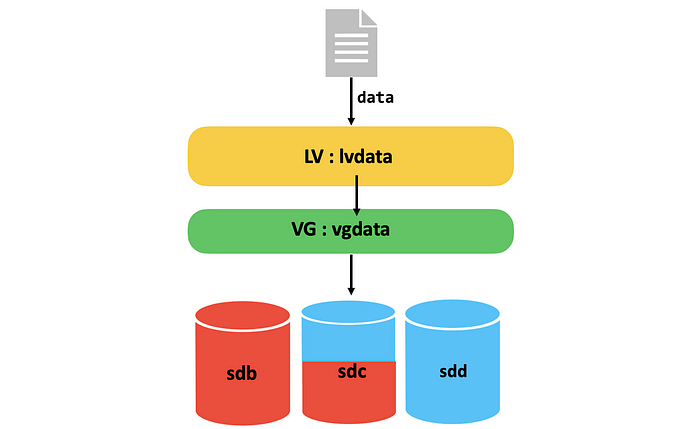

Линейный (Linear) LVM против LVM Striping:

1.1 — Линейный LVM:

Линейная конфигурация, являющаяся стандартным подходом для LVM, подразумевает последовательное добавление нескольких физических томов (дисков) в группу томов (Volume Group). Данные последовательно записываются на эти диски: сначала заполняется один диск, затем следующий, и так далее.

Хотя линейный LVM прост и удобен для расширения хранилищ, он не полностью раскрывает потенциал параллельной обработки и увеличения общей пропускной способности.

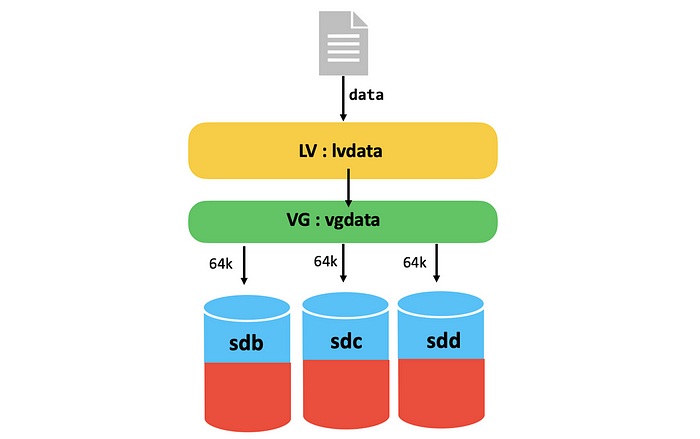

1.2 — LVM Striping (Полосование):

Напротив, LVM Striping представляет собой более продвинутый подход, при котором данные распределяются одновременно по нескольким физическим томам. Это создает логический том, охватывающий сразу несколько дисков, что позволяет осуществлять параллельные операции чтения и записи. В результате значительно повышается производительность, что делает LVM Striping особенно привлекательным для систем с высоким уровнем нагрузки ввода-вывода.

Процесс создания полос:

Создание полос:

Данные разделяются на сегменты («полосы»).

Каждая полоса записывается на отдельный диск в составе логического тома.

2. Параллельная запись полос:

Полосы записываются параллельно на несколько физических томов (дисков).

3. Равномерное распределение:

Полосы равномерно распределены по дискам, предотвращая появление узкого места (bottleneck).

4. Увеличение IOPS и пропускной способности:

Благодаря параллельной записи полос LVM Striping существенно увеличивает общую производительность и пропускную способность логического тома.

1.3 — Пример использования:

Рассмотрим пример с тремя дисками, каждый из которых обеспечивает пропускную способность 125 МБ/с:

При использовании LVM Striping суммарная производительность составит 375 МБ/с.

В случае же с линейным LVM, производительность останется равной 125 МБ/с, вне зависимости от количества добавленных дисков.

Настройка Linear LVM и Striping LVM:

В этом разделе мы создадим две группы томов (Volume Groups, VG): одну линейную, вторую — с полосованием, каждая с использованием трёх дисков. Затем создадим логические тома (Logical Volumes, LV), отформатируем и смонтируем их.

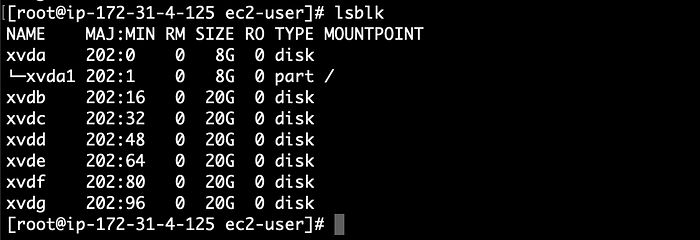

2.1 — Исходные данные:

Сервер: AWS EC2 instance типа m4.10xlarge

EBS-диски: 6 штук по 20ГБ (тип GP3, 3000 IOPS, 125MiB/s пропускная способность каждый)

ОС: Amazon Linux 2

Просмотр подключенных дисков:

# lsblk

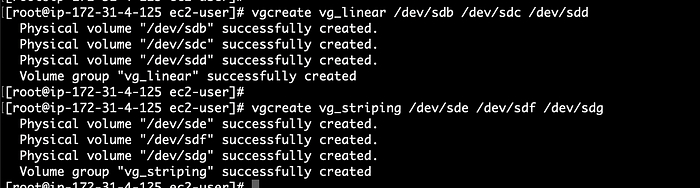

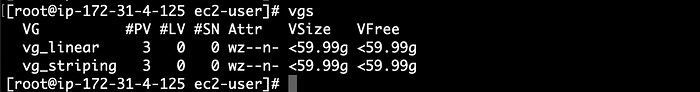

2.2 — Создание групп томов (VG):

Создадим две группы томов:

# vgcreate vg_linear /dev/sdb /dev/sdc /dev/sdd

# vgcreate vg_striping /dev/sde /dev/sdf /dev/sdg

# vgs

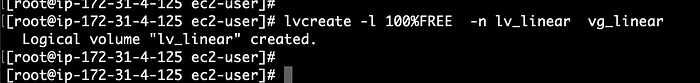

2.3 — Создание линейного логического тома (Linear LVM):

# lvcreate -l 100%FREE -n lv_linear vg_linear

Параметры:

-l 100%FREE — задействовать весь доступный объем VG.

-n lv_linear — имя логического тома.

vg_linear — целевая группа томов.

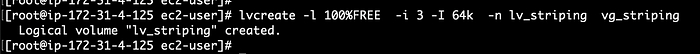

2.4 — Создание логического тома с полосованием (Striping LVM):

# lvcreate -l 100%FREE -i 3 -I 64k -n lv_striping vg_striping

Параметры:

-l 100%FREE — задействовать весь объем VG.

-i 3 — количество полос (равно числу дисков).

-I 64k — размер полосы.

-n lv_striping — имя логического тома.

vg_striping — целевая группа томов.

2.5 — Проверка созданных LV:

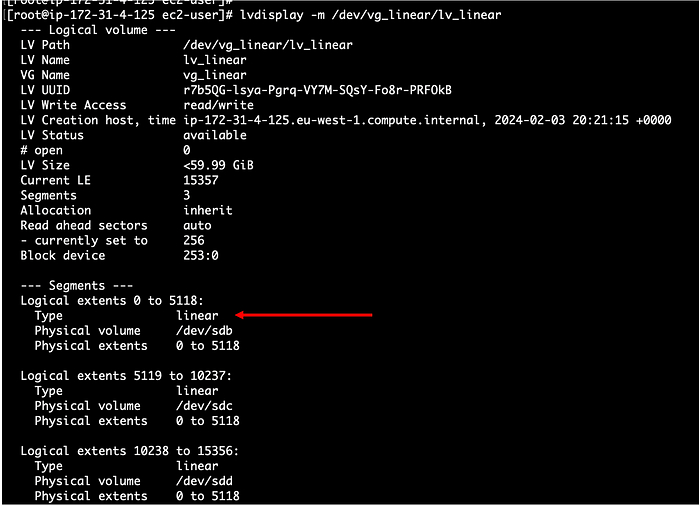

Проверка линейного LV:

# lvdisplay -m /dev/vg_linear/lv_linear

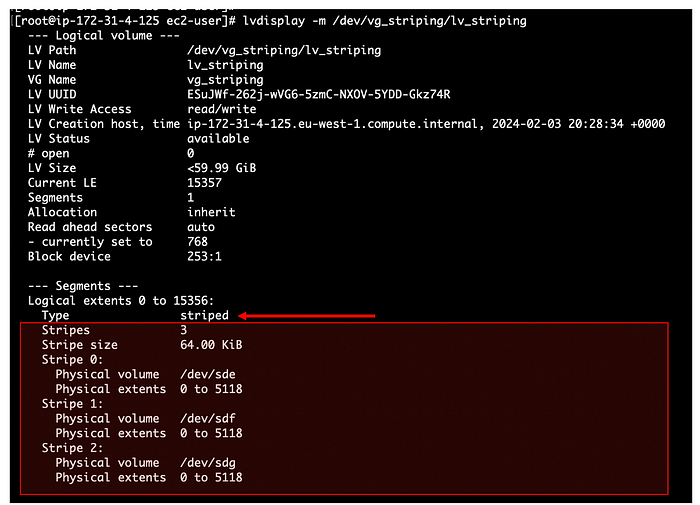

Проверка LV с полосованием:

# lvdisplay -m /dev/vg_striping/lv_striping

Здесь мы можем увидеть различные детали наших настроек.

2.6 — Форматирование и монтирование LV:

# mkfs.xfs /dev/vg_linear/lv_linear

# mkfs.xfs /dev/vg_striping/lv_striping

# mkdir /mnt/linear

# mkdir /mnt/striping

# mount /dev/vg_linear/lv_linear /mnt/linear/

# mount /dev/vg_striping/lv_striping /mnt/striping/

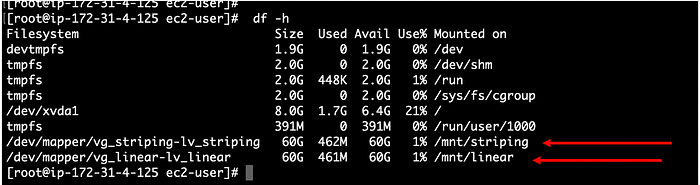

# df -h

LV успешно смонтированы.

3 — Тестирование производительности LV (benchmark):

Для тестирования используем инструмент fio:

# yum install fio -y

3.1 — Тестирование линейного LV:

Чтобы сравнить LV, мы будем использовать файл конфигурации FIO, который поможет нам генерировать трафик на 400м:

# cat fio_config-1.fio

[global]

ioengine=libaio

runtime=60

time_based

direct=1

rw=write

size=10G

bs=512K

rate=400M

numjobs=16

[job1]

filename=/mnt/linear/testfile

Запуск тестирования с созданным конфигом:

# fio fio_config-1.fio

Одновременно с этим в отдельном терминале запустим iostat, чтобы контролировать использование дисков:

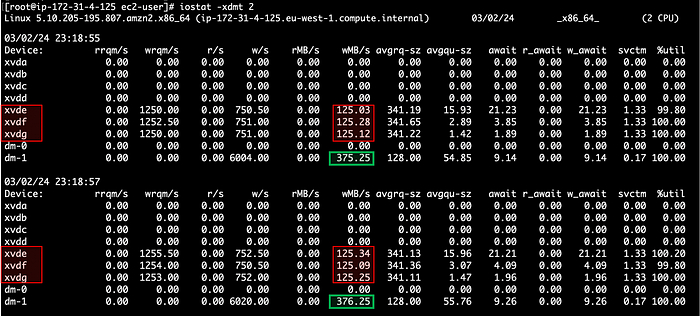

# iostat -xdmt 2

Видим, что используется только один диск xvdb со скоростью 125 МБ/с.

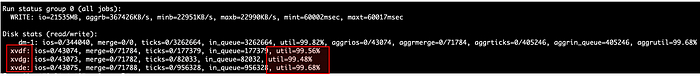

Ту же картину нам демонстрирует и fio:

Операции записи были выполнены исключительно на одном диске.

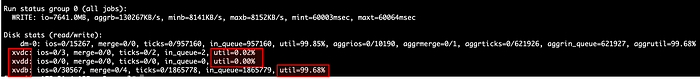

3.2 — Тестирование LV с полосованием:

Теперь снова запустим fio, но изменим параметр filename в файле конфигурации:

filename=/mnt/striping/testfile

Запускаем iostat:

Все три диска работают параллельно, суммарная скорость равна 375 МБ/с (125 x 3).

Аналогичную картинку нам демонстрирует и fio:

Вывод:

LVM Striping является мощным решением для организаций, которые хотят максимально эффективно использовать ресурсы своих хранилищ. Распределяя данные параллельно на несколько дисков, LVM Striping не только значительно увеличивает производительность, но и обеспечивает масштабируемость и гибкость управления хранилищами.

Используйте LVM Striping, чтобы раскрыть потенциал параллельной обработки данных и вывести производительность дисковой подсистемы на новый уровень.

Топ 10 самых объёмных жёстких дисков

24 000 ГБ

Невероятный жёсткий диск Seagate 3.5" Exos X24 с самым большим объёмом памяти на сегодняшний день 24 TB (24 000 ГБ). Основная целевая аудитория — владельцы центров обработки данных. Впрочем, никто не мешает использовать этот жесткий диск и в обычных домашних компьютерах — на таком HDD поместятся сотни фильмов, тысячи игр и миллионы фотографий. Стоит такой около 51 000 руб. Ссылка на него

22 000 ГБ

Жёсткий диск Seagate Exos X22 с 22 ТБ памяти. Технология записи CMR гарантирует стабильную скорость независимо от объема данных. Устройство предназначено для серверов: надёжность диска обеспечивает постоянную работу и непрерывные нагрузки. Стоит такой около 45 000 руб. Ссылка на него

20 000 ГБ

Жёсткий диск Seagate Exos X20 с 20 ТБ памяти. Стоит такой 33 200 руб. Ссылка на него

18 000 ГБ

Жёсткий диск Seagate Exos X18 c 18 TБ памяти. Стоит такой 28 200 руб. Ссылка на него

16 000 ГБ

Объёмный жёсткий HDD диск Seagate Exos X18 c 16 ТБ памяти. Стоит такой 18 800 руб. Ссылка на него

12 000 ГБ

Жёсткий диск Seagate IronWolf Pro с 12 ТБ. Подойдёт для записи видео с камер видеонаблюдения. Стоит 15 500 руб. Ссылка на него

8 000 ГБ

Жёсткий диск Seagate SkyHawk емкостью 8 ТБ является производительным и надежным запоминающим устройством, которое может использоваться в составе систем видеонаблюдения. Seagate SkyHawk AI позволяет хранить довольно большой массив информации и способен справляться с круглосуточными интенсивными нагрузками. Данный накопитель характеризуется скоростью вращения шпинделя 7200 об/мин и объемом кэш-памяти 256 МБ. Фирменное ПО SkyHawk Health позволяет выполнять мониторинг накопителя и управлять доступными параметрами. Подключение посредством интерфейса SATA III обеспечивает широкую совместимость и удобство установки в оборудование. Стоит такой 13 900 руб. Ссылка на него

6 000 ГБ

Жёсткий диск Seagate ёмкостью 6 ТБ. Стоит такой 9 900 руб. Ссылка на него

4 000 ГБ

Жёсткий диск Seagate ёмкостью 4 ТБ. Стоит такой 8 200 руб. Ссылка на него

2 000 ГБ

Жёсткий диск Seagate Exos 7E8 вместимостью 2 ТБ , отличное решение для использования в домашних или офисных компьютерах. Стоит такой 5 800 руб. Ссылка на него

P.S

Объём памяти в флешках, жёстких дисках, SSD, смартфонах и тд. всегда немного ниже, чем заявлено. Это норма! К примеру:

Флешка на 32 Гб – свободно ~29.8 Гб ,

SSD диск на 128 Гб – свободно ~119.2 Гб

Жёсткий диск HDD на 500 Гб - свободно ~465 Гб

Жёсткий диск HDD на 2 Тб – свободно ~1 861 Гб и тд.

Кто вы такие и что здесь происходит?

— Мы? Мы WHM Crew (Для вас в первую очередь “Новореги” =D).

— А что происходит? Это блог о нашем продукте, аналогов которому по качеству - просто нет (webhostmost.ru, кста).

Тут мы будем рассказывать, как мы решили обойти всех стариков индустрии: тех, кто просыпается только когда цены на автопродление надо повысить.

У нас всё иначе. Скорость загрузки сайта - не секунда, а полсекунды.

Цена - Стабильнее любой мировой валюты, не меняется НИКОГДА.

Техподдержка - не чат-бот с философским настроем (Но это пока что, эту тему мы раскроем в одном из постов и вы… Ахуеете? =D), а реальные люди. Да, даже по ночам.

И всё это - не корпорация. Мы - команда, почти семья, нас объединяет единая цель: СДЕЛАТЬ САМЫЙ УНИКАЛЬНЫЙ И ДОСТУПНЫЙ ПРОДУКТ НА РЫНКЕ ВЕБ ХОСТИНГА. Мы друг друга знаем в лицо, а не по ID в трекере задач. И скоро вы узнаете нас тоже.

Мы будем честно сравнивать свой продукт другим. Показывать, где "корпорации" косячат (А они все пиздец, как косячат =D), а где мы уже сделали лучше.

Будем кидать мемы, примеры, графики, истории, а иногда и просто душу.

Как вы уже наверняка заметили, у нас нет “Корпоративной этики”, мы привыкли говорить и делать “как чувствуем”, идя не просто в “ногу со временем”, а переворачивая всю веб хостинг индустрию.

Прекрасно понимаем, что для вас это пока что пустые слова, но наши последующие посты будут прямым доказательством того, что это не просто слова и АНАЛОГОВ НЕТ, как зумеры заставляют менять свой подход работодателей, так мы и наш продукт - заставляет крупные корпорации встать с банки (как в том видосе, да), набитой деньгами и обратить внимание на свое комьюнити.

И если вы сидели на хостинге, где сайт грузится с молитвой и жертвоприношением - добро пожаловать домой и до встречи в следующих постах!)

Влияние максимального размера I/O-запросов на производительность систем Linux

В области оптимизации производительности Linux важнейшим фактором является производительность дискового ввода-вывода (I/O), которая существенно влияет на общую эффективность системы. Одним из ключевых параметров, влияющих на производительность дискового ввода-вывода, является максимальный размер I/O-запроса, определяемый параметром max_sectors_kb. Понимание и настройка этого параметра могут привести к значительному улучшению производительности системы. В этой статье мы рассмотрим понятие максимального размера I/O, его важность в системах Linux, а также его влияние на производительность в целом.

Понимание максимального размера I/O (max_sectors_kb)

Параметр max_sectors_kb определяет максимальный размер отдельного I/O-запроса в килобайтах. Он устанавливает объём данных, который может быть передан в рамках одного I/O-запроса. Значение параметра max_sectors_kb ограничено логическим размером блока файловой системы и аппаратными возможностями устройства хранения данных. Оно не может быть меньше логического размера блока, делённого на 1024, и не должно превышать значение параметра max_hw_sectors_kb, который является параметром только для чтения и показывает максимально поддерживаемый аппаратурой размер запроса.

Минимальное значение = max(1, logical_block_size/1024)

Максимальное значение = max_hw_sectors_kb

Примечание: Максимальный размер I/O в Linux преимущественно применим к ядрам версии 4.x и выше. Рекомендуется проверить это в конкретном ядре вашей системы. Хотя впрочем очевидно - если у вас не какой-нибудь embedded, то ядро скорее всего будет выше 5.x

Важность в системах Linux

В Linux параметр максимального размера I/O существенно влияет на эффективность чтения и записи данных с устройств хранения. Он оказывает влияние на следующие аспекты производительности:

1. Баланс между пропускной способностью и задержками:

Пропускная способность (Throughput): Крупные размеры I/O-запросов увеличивают общую пропускную способность ввода-вывода за счёт обработки больших блоков данных за одну операцию. Это снижает накладные расходы на обработку множества мелких запросов, особенно эффективно при работе с последовательными потоками данных (видеостриминг, резервные копии баз данных).

Задержки (Latency): В то время как большие размеры I/O-запросов могут повысить пропускную способность для больших наборов наборов, они также могут увеличить задержку отдельных операций. Это происходит потому, что более крупные запросы требуют больше времени для завершения. Поэтому необходим баланс между улучшением производительности и допустимым уровнем задержек, особенно в чувствительных к задержкам интерактивных или real-time приложениях. В таких случаях предпочтительнее меньшие размеры запросов.

2. Использование CPU:

Увеличение размера запросов уменьшает нагрузку на CPU, поскольку снижается число переключений контекста и прерываний, связанных с обработкой отдельных запросов ввода-вывода.

3. Использование памяти:

Максимальный размер I/O влияет на объём выделяемой памяти под буферы ввода-вывода, что также отражается на общем использовании памяти системой.

Факторы, влияющие на максимальный размер I/O

Есть несколько факторов, которые влияют на максимальный размер запросов в Linux:

Аппаратные ограничения: Значение max_sectors_kb не должно превышать аппаратные возможности накопителя (значение параметра max_hw_sectors_kb). Превышение аппаратного лимита может привести к ошибкам или снижению производительности.

Драйверы устройств: Драйверы контроллеров хранения и накопителей могут задавать свои лимиты на размер запросов.

Ограничения файловых систем: У разных файловых систем разные лимиты на размер запроса ввода-вывода.

Параметры ядра Linux: Настройки блочных устройств ядра влияют на размер запроса.

Бенчмаркинг и мониторинг

Для определения оптимального размера I/O-запросов необходимо проводить тестирование (бенчмарки) и мониторить показатели производительности (например, с помощью утилиты iostat).

Рекомендуется учитывать:

Red Hat советует, чтобы значение max_sectors_kb было кратно оптимальному размеру I/O и внутреннему размеру блока стирания устройства. Если таких данных нет, рекомендуется выставить значение, совпадающее с логическим размером блока устройства.

Характеристики рабочей нагрузки: разные приложения выигрывают от разных размеров I/O.

Особенности накопителя: HDD и SSD имеют разные оптимальные диапазоны размеров I/O.

Ресурсы системы: доступная память и мощность CPU влияют на выбор оптимального размера I/O.

Практические аспекты настройки

Для настройки max_sectors_kb используется команда:

/sys/block/{device}/queue/max_sectors_kb

Например:

echo 256 | sudo tee /sys/block/sda/queue/max_sectors_kb

Данная команда устанавливает максимальный размер запроса в 256 КБ для диска /dev/sda. Перед изменениями желательно протестировать настройки на тестовой системе во избежание негативного влияния на производительность или стабильность системы.

Изменения параметра действуют только до перезагрузки системы. Чтобы изменения сохранялись, добавьте команду в rc.local или настройте сервис для применения параметров при загрузке.

Практическое исследование

Рассмотрим практический сценарий. Создадим лабораторную среду на Linux-сервере и проверим производительность диска. Нагрузку (IOPS) будем генерировать с помощью инструмента fio, а мониторинг производительности проводить с помощью утилиты iostat. Наша задача — оценить влияние параметра max_sectors_kb на производительность системы.

Среда для тестирования:

Тип EC2-инстанса: c5.12xlarge

EBS-том:

тип: GP3

размер: 20 GiB

IOPS: 3000

пропускная способность: 750 MB/s

Операционная система: Amazon Linux 2

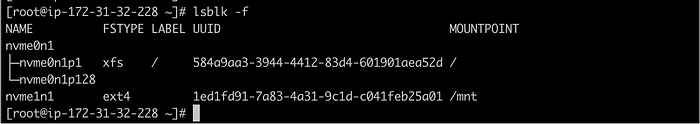

Проверка дисков и установка fio

Для начала проверим доступные диски:

Мы будем создавать нагрузку на диск nvme1n1 при помощи утилиты fio и параллельно мониторить производительность диска, в частности показатель IOPS. Если fio не установлен, используйте команды ниже:

Для Amazon Linux:

sudo yum install -y fio

Для Ubuntu:

sudo apt-get install -y fio

Запуск теста

Откройте два терминала одновременно:

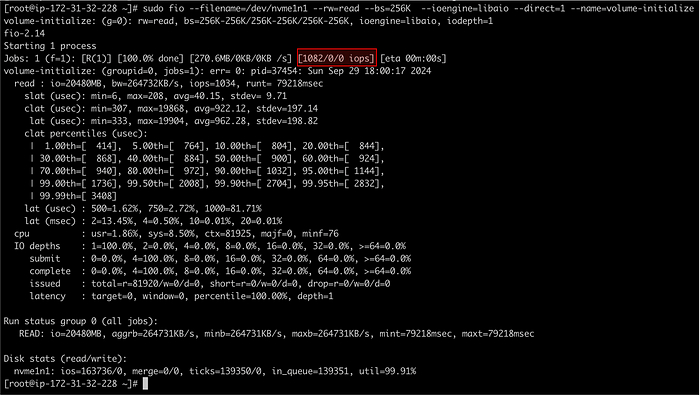

Терминал 1: Генерируем нагрузку:

sudo fio --filename=/dev/nvme1n1 --rw=read --bs=256K --ioengine=libaio --direct=1 --name=volume-initialize

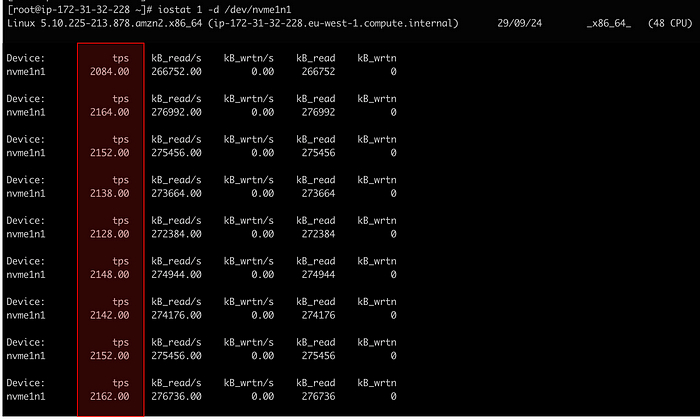

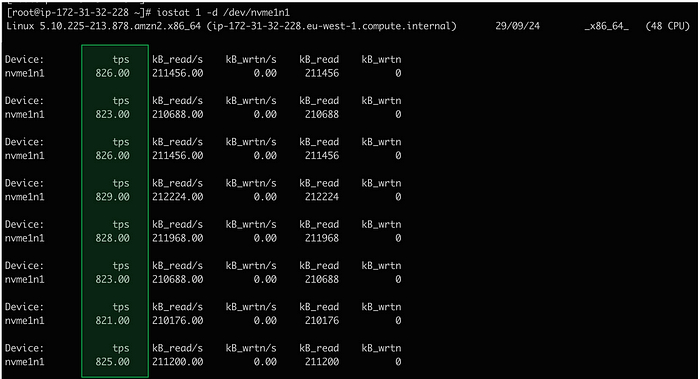

Терминал 2: Мониторим диск:

iostat 1 -d /dev/nvme1n1

Обратите внимание, что в команде fio мы задали размер запроса 256 KiB.

Наблюдения

На первом скриншоте видно, что утилита fio генерирует 1082 IOPS, однако утилита iostat показывает примерно 2164 IOPS (то есть в два раза больше).

Причина различий

Чтобы выяснить причину этого несоответствия, проверим значение параметра max_sectors_kb:

cat /sys/block/nvme1n1/queue/max_sectors_kb

Объяснение:

Инструмент fio создавал IOPS с размером 256 KiB, а max_sectors_kb был установлен на значение 128 KiB. В результате ядро Linux разбивало каждый запрос на два меньших запроса по 128 KiB каждый (256 KiB = 128 KiB × 2). Именно поэтому количество операций, регистрируемых iostat, было в два раза больше, чем указывал fio (1082 × 2 = 2164).

Важно: Увеличение числа запросов из-за неправильно настроенного max_sectors_kb может негативно повлиять на производительность сервера и привести к троттлингу производительности диска (например, EBS-тома), если число операций превышает базовый уровень IOPS.

Проверка максимального аппаратного лимита max_hw_sectors_kb

Проверим максимальное значение I/O, которое поддерживает наш сервер:

cat /sys/block/nvme1n1/queue/max_hw_sectors_kb

Результат: наш сервер поддерживает максимальный размер I/O-запроса в 256 KiB.

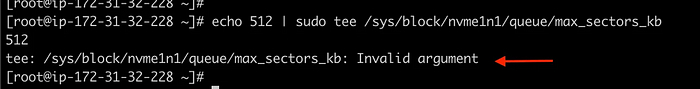

Попытка увеличения max_sectors_kb

Попробуем увеличить значение до 512 KiB:

echo 512 | sudo tee /sys/block/nvme1n1/queue/max_sectors_kb

Результат: Мы получили ошибку «Invalid argument» («Недопустимый аргумент»), так как указали значение, превышающее аппаратный лимит max_hw_sectors_kb.

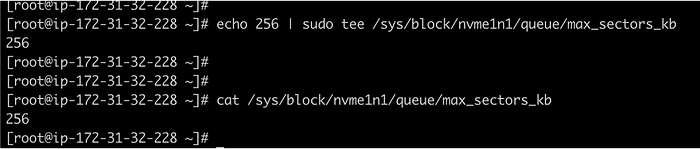

Теперь установим допустимое значение 256 KiB:

echo 256 | sudo tee /sys/block/nvme1n1/queue/max_sectors_kb

Результат: Значение успешно изменено на 256 KiB.

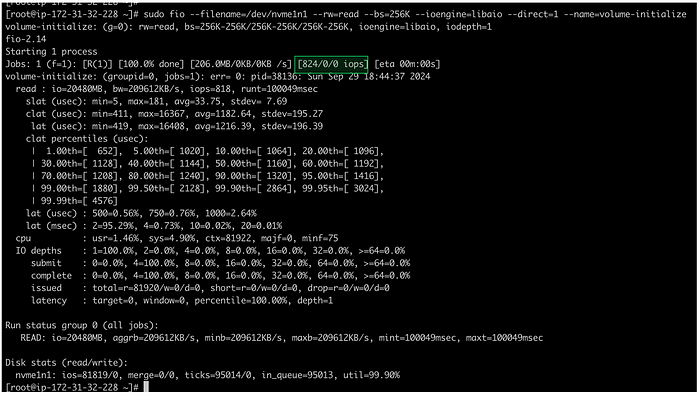

Повторный запуск теста fio

Повторим тест командой:

sudo fio --filename=/dev/nvme1n1 --rw=read --bs=256K --ioengine=libaio --direct=1 --name=volume-initialize

Результат: После изменения параметра max_sectors_kb количество операций IOPS, отображаемое fio и iostat, совпало.

Заключение:

Максимальный размер I/O-запроса (max_sectors_kb) является мощным инструментом для тонкой настройки производительности дисковой подсистемы в Linux. Правильно подобранное значение позволяет оптимизировать производительность ввода-вывода и снизить нагрузку на CPU, однако следует учитывать возможное увеличение задержек и аппаратные ограничения. Любые изменения параметров производительности следует предварительно тестировать и внимательно анализировать перед внедрением в продуктивную среду. Это гарантирует стабильность работы системы и её оптимальную производительность в различных сценариях.

Чемпионат мира по метанию серверов на фестивале CloudFest-2025

CloudFest – ежегодный фестиваль интернет-индустрии и облачных вычислений, прошедший в Германии с 17 по 20 марта 2025 года и привлекший почти 9 тысяч посетителей. Мероприятие традиционно проводится в Европе-Парке в Шварцвальде и имеет достаточно насыщенную программу: 250 выступающих от 150 компаний-участников из 80 стран. Доклады, мастер-классы, новинки от гигантов индустрии, стартапы и проч. … но, по понятным причинам шоу-стоппером и гвоздем фестиваля стал чемпионат по метанию серверов – World Server Throwing Championship (WSTC).

Метались серверы высотой 1U весом примерно 10 кг. (Говорят, можно даже было приносить свои серверы, но это не точно). Здесь всё как в большом спорте – громкие прозвища, например, Бартош-Зверь, Дирк-Машина, чемпионские пояса, анонсеры, чирлидерши и проч.

В конкурсе принимали участие как мужчины, так и женщины – единственное требование к участникам – надеть перчатки дабы не поранить руки о края девайса и желание метать сервер %&#* далеко (орфография сохранена).

Накануне основного дня соревнований устраивались отборочные туры, где у каждого метателя было по две попытки, из которых фиксировался самый дальний бросок. Затем три лучших финалиста вышли в финал и соревновались с победителями испанских и голландских квалификаций, а также с прошлогодними чемпионами.

Приводим ссылку на страницу соревнования и пару роликов:

Устроители шутят (или нет?) и поговаривают, что в будущем следует ожидать включение этого вида спорта в олимпийскую программу.

Комменты под видео в сети:

- Надо биатлон устроить: Сначала пишут код, который выполняет какую-то полезную работу на сервере, подключенном только к ИБП. Потом метают ИБП и сервер. Результаты суммируют.

- Никогда не используйте сервер, который не сможете выбросить в окно.

- Там от сервера - одно название. Ни тебе процессора с кулером, ни Хардов, ни РАМы, ни рек-Маунт-китов.

- Честно говоря, это самое приятное мероприятие, которое я когда-либо видел.

- Линукс знает, как падать.

- Обычный день сисадмина.

Материал подготовлен Московским заводом тепловой автоматики (МЗТА)