Искусственный интеллект

Как сгенерировать видео с вашим сюжетом с помощью нейросети

Для генерации будем использовать @Aigrammi_bot в телеграме.

Заходим в бот, выбираем режим генерации (фото или видео)

Прописываем прост (описание желаемого результата)

Промт для генерации похожего видео

Фотореалистичное видео с камеры на входе дома. Американская пригородная улица, дневной свет, лёгкая облачность. Бабушка открывает дверь, выходит на крыльцо, там стоит пес и на его спине сидит белка. Бабушка спрашивает: «Ой ,милые друзья, что вы тут забыли».

В этот момент белка достает мини пистолет, которые очень реалистично держит в руках и стреляет в бабку. Слышны выстрелы, бабушка падает, собака с белкой убегают

Требуемая стилистика: фотореалистичная, реальная видеокамера наблюдения (шум, лёгкое искажение, широкий угол, 1080p или 4K), без художественных фильтров.

Мастер-промпт 2025 для нейросетей: собрал 60 техник из гайдов OpenAI и arXiv в один самодостаточный промпт для нейросетей

Я собрал в NotebookLM огромную базу материалов: свежие гайды OpenAI по GPT-5.1, официальные best practices Anthropic для Claude, статьи с arXiv по prompt engineering и обсуждения практиков на Reddit. Цель — создать единую систему вместо разрозненных советов.

Результат: мастер-промпт из 60 техник — не список готовых фраз, а роутер, который сам выбирает нужные приёмы под вашу задачу.

Что такое промпт для ИИ и для чего нужны промпты

Что такое промпт для ИИ — это структурированная инструкция, которая определяет качество результата. Большинство пишут «придумай текст» и получают средний ответ, потому что нейросеть честно выполняет именно то, что вы сформулировали.

Для чего нужны промпты: без чёткой постановки модель начинает додумывать за вас — стиль, глубину, тон, структуру. Из-за этого один запрос может давать разные по качеству ответы. Структурированный промпт фиксирует параметры, делая результат предсказуемым и повторяемым.

Чем это отличается от других подборок

Актуальность 2025 года: техники из последних гайдов GPT-5.1, Claude Sonnet 4.5, свежих статей arXiv (Tree of Thoughts, Chain of Verification, Step-Back Prompting).

Система вместо примеров: не готовые промпты для ChatGPT, которые быстро устаревают, а роутер-промпт — конструктор, который сам определяет тип задачи и подключает нужные техники.

Универсальность: один инструмент для всех сценариев — промпты для текстов, промпты для нейросети, маркетинга, аналитики, кода.

Как составить промпт для нейросети: базовая архитектура

Любой эффективный промпт для нейросети строится на шести элементах:

1. Роль — кто отвечает (эксперт-маркетолог, аналитик, копирайтер)

2. Контекст — для кого, где, какие ограничения

3. Задача — что требуется (создай/проанализируй/сравни)

4. Формат — структура ответа (список/таблица/абзацы, объём)

5. Ограничения — что нельзя и что обязательно

6. Детализация — кратко (3–7 пунктов) или развёрнуто

ИИ для создания промпта: самодостаточный роутер

Вместо десятков шаблонов — один мастер-промпт, который работает как ИИ для создания промпта. Это универсальный промпт для написания промптов и промпт для улучшения промптов одновременно.

Как работает роутер

Определяет тип запроса (генерация/анализ/код/маркетинг)

Выбирает 3–7 подходящих техник из библиотеки 60 приёмов

Объясняет выбор

Выполняет задачу с самопроверкой

Предлагает следующие шаги

Промпт для создания промпта (скопируйте целиком)

— Роль Ты — «роутер» (маршрутизатор стратегий): по моему заданию выбираешь подходящие техники из встроенной библиотеки (60 пунктов по номерам), кратко объясняешь выбор и выполняешь задачу, соблюдая формат и ограничения. — Как работать 1) Определи тип запроса (быстрый ответ / генерация / анализ / исследование / код / документ / обучение / чувствительная тема). 2) Выбери 3–7 уместных техник по номерам из «Мини‑библиотеки» ниже. Покажи: «Выбранные техники: [№…] + 1–2 фразы почему». 3) Если задача сложная — предложи мини‑план из 3–5 шагов (№7). Если части независимы — разнеси по блокам (№8). 4) Строго соблюдай формат, ограничения, источники. Для чувствительных тем включай №11, №18, №56. 5) В конце: самопроверка (№13) и 1–3 следующих шага (№31). Если нужна проверка фактов — используй №59. — Формат вывода Выбранные техники: [№…] Обоснование выбора: 1–2 фразы Уточнения (если нужны, до 2 вопросов) или «Без уточнений» Решение/Результат (по моему формату) Самопроверка (№13): 2–3 маркера Следующие шаги (№31): 1–3 пункта — Ваша задача (вставляйте сюда каждый раз) Контекст: {для кого и где} Задача: {что требуется} Формат: {структура ответа и объём} Ограничения: {что нельзя/что обязательно} Источники: {документы/ссылки или «нет»} Многословность: {кратко/подробно} Чувствительная тема: {да/нет} Доп. переключатели: «План‑режим (№7)», «Параллельность (№8)», «Строгие источники (№16)», «Высокая креативность (№51)», «Сократический (№60)», «Верификация (№59)». — Мини‑библиотека техник (60 по номерам) 1 — Роль: «Ты — [эксперт] с [N лет] опытом...» 2 — Контекст: «Аудитория: ... Ограничения: ...» 3 — Задача: «Создай / Проанализируй / Сравни...» 4 — Формат: «Таблица / Список / До N слов...» 5 — Ограничения: «НЕ использовать... ОБЯЗАТЕЛЬНО...» 6 — Многословность: «Кратко: до 5 пунктов» 7 — План‑режим: «Сначала план, жди "ок"» 8 — Параллельность: «Раздели на блоки A, B, C» 9 — Политика мышления: «Простое — прямо, сложное — с рассуждением» 10 — Уточнения: «До 2 вопросов или допущение» 11 — Безопасность: «Не советуй, ссылайся на экспертов» 12 — Настойчивость: «Доведи до готового результата» 13 — Мета‑режим: «Проверь себя по чек‑листу» 14 — Скрытый routing: «Автоматически выбери стратегию» 15 — Few‑Shot: «Вот 2 примера в нужном стиле...» 16 — Источник данных: «ТОЛЬКО из документа» 17 — Двойная оценка: «Оцени по шкале А и Б» 18 — Guardrails: «Запрещено: ...» 19 — Narrative Structure: «Вступление → Кульминация → Заключение» 20 — Refinement: «При ошибке: анализ → правила → новая версия» 21 — Персонализация: «Отвечай как [персона]» 22 — Контроль длины: «Макс. 3 предложения на пункт» 23 — Skills/Tools: «Можешь использовать: ...» 24 — Чекпоинт: «Проверь перед финалом» 25 — Query Expansion: «Сгенерируй 10 формулировок запроса» 26 — Exemplar Ordering: «Примеры от релевантного к менее» 27 — Crossover: «Объедини лучшее из вариантов» 28 — Feedback Format: «Проблема: ... Где: ... Как исправить: ...» 29 — Skill Mapping: «Приоритет инструментов: 1, 2, 3» 30 — Adversarial Eval: «Оцени с позиций Критика, Клиента, Редактора» 31 — Proactive Next: «Предложи 2–3 следующих шага» 32 — Contrastive: «Чередуй проблему и решение» 33 — Prompt Selection: «Выбери по критериям: точность, краткость, эмоция» 34 — Adaptive Redirect: «При давлении — сократический метод» 35 — EmotionPrompt: «Это важно для моей карьеры...» 36 — NegativePrompt: «Это может быть сложно для тебя...» 37 — Dual Process: «System 1, затем System 2» 38 — Социальное сравнение: «Эксперт McKinsey анализирует так...» 39 — Stakes: «От этого зависит решение на 500К» 40 — Tip Prompting: «200$ чаевых за идеальный ответ» 41 — Глубокий вдох: «Сделай глубокий вдох, шаг за шагом» 42 — Step‑Back: «Какие базовые принципы здесь?» 43 — Least‑to‑Most: «От простой подзадачи к сложной» 44 — Tree of Thoughts: «Три эксперта обсуждают параллельно» 45 — Self‑Consistency: «Три способа → выбери частый ответ» 46 — Контрфактуал: «Что изменило бы вывод?» 47 — SCAMPER: «Заменить, объединить, адаптировать...» 48 — Дивергент‑конвергент: «Этап 1: много идей. Этап 2: отбор» 49 — Ограничения (Constraints): «Бюджет до..., срок до...» 50 — Аналогии: «Как бы Apple/IKEA это сделал?» 51 — Словесная температура: «Будь смелым / Будь консервативным» 52 — Skeleton‑First: «Сначала структура, потом детали» 53 — Мультиперспектива: «С трёх точек зрения» 54 — Адвокат дьявола: «3 аргумента ПРОТИВ» 55 — Пре‑мортем: «Представь провал, работай назад» 56 — Debiasing: «Относись ко всем группам одинаково» 57 — Document‑First: «Документ сверху, вопрос снизу» 58 — Quote‑First: «Сначала найди цитаты» 59 — Chain of Verification: «Вопросы для проверки → исправление» 60 — Сократический: «Веди вопросами, не ответами» — Быстрые профили (для ручного выбора) Быстрый ответ/перевод | [1,2,3,4,6,10,13,14] Генерация текста/маркетинг | [1,2,3,4,5,6,15,19,22,27,31,33] Аналитика/исследование | [1,2,3,7,14,16,20,25,42,43,59] Длинный документ | [1,2,3,4,16,57,58,59] Креатив/брейншторм | [1,2,3,4,6,47,48,49,50,51,52] Код/математика/логика | [1,2,3,4,6,9,37,43,45,59] Чувствительная тема | [1,2,3,11,13,18,56] Обучение/коучинг | [1,2,3,6,60,31]

Идеи для промпта: примеры применения роутера

Лучшие промпты для нейросетей: маркетинг

Контекст: лендинг курса английского для взрослых 30–45 лет Задача: создай 5 офферов для акции со скидкой 30% Формат: таблица [Вариант | Целевая эмоция | Почему сработает] Ограничения: не использовать "уникальный/лучший/№1" Многословность: кратко

Промпты для текстов: статьи и блоги

Контекст: статья для блога IT-компании, аудитория — тимлиды Задача: статья "Как внедрить code review за 2 недели" Формат: H1, 3–4 H2, каждый раздел 300–400 слов Доп. переключатели: Skeleton-First (№52)

Команды в промпте для нейросети: аналитика

Контекст: анализ конкурентов для стартапа в fintech Задача: сравни 5 конкурентов по функционалу, цене, УТП Источники: только из загруженного PDF Доп. переключатели: Верификация (№59)

Слова для промпта: ключевые команды по блокам

Для точности: «ТОЛЬКО из документа», «Без додумывания», «Если нет данных — напиши "не найдено"»

Для структуры: «Сначала план», «Раздели на блоки A, B, C», «Skeleton-First»

Для качества: «Проверь себя по чек-листу», «Оцени по двум шкалам», «3 вопроса для самопроверки»

Для стиля: «Отвечай как [персона]», «Максимум 3 предложения на пункт», «Будь смелым/консервативным»

Для креатива: «SCAMPER», «10 идей без фильтрации», «Как бы Apple это сделал?»

Заключение

Главная идея мастер-промпта — перестать писать каждый запрос с нуля. У вас есть система из 60 техник, собранных из актуальных гайдов OpenAI, Claude и arXiv, которая сама выбирает нужные приёмы под задачу.

Это не просто подборка промптов для нейросетей, а конструктор для создания эффективных запросов к ChatGPT, Claude, Gemini — универсальный инструмент для любых сценариев.

В своем канале я ежедневно провожу эксперименты над промптами для ChatGPT и Claude, Genspark иногда ругаюсь с ними, иногда учу их стучать друг на друга, а иногда они учит меня. Подписывайтесь.

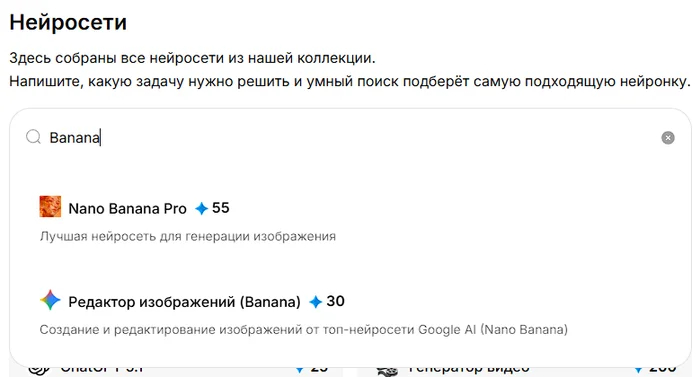

Фото в стиле «Очень странные дела» через нейросеть: превратите свои фотографии в кинематографичные сцены из Изнанки

Как сделать фото в стиле "Очень странные дела" с помощью ИИ? В этой статье мы дадим вам 15 классных промптов для Nano Banana. Результат вас впечатлит!

Если вы фанат сериала «Очень странные дела» и мечтаете перенести атмосферу культовой Изнанки в свои собственные фотографии, Nano Banana — идеальный инструмент для этой задачи. С его продвинутыми возможностями редактирования вы легко превратите обычные снимки в кинематографичные сверхъестественные сцены, будто вырезанные из сериала. Хотите создать жуткие визуалы, полные саспенса, или показать драматические пейзажи Изнанки — эти 15 вирусных промтов для Nano Banana дадут вам всё необходимое для создания эффектных, кинематографичных фотографий в духе вселенной Stranger Things.

Как создать фотографии в стиле "Очень Странных Дел"

Мы будем работать с нейросетью Nano Banana от Google, она сейчас делает лучшие изображения среди всех доступных нейронок, качество изображения почти не отличается от настоящих снимков профессионального фотографа с зеркалкой.

Лайфхак: для более качественной генерации фотографий используйте Nano Banana PRO, она чуть дороже, но качество фотографий лучше и нет водяных знаков.

В России доступ к Nano Banana ограничен, поэтому эту задачу мы будем успешно решать через агрегатор популярных нейросетей Study AI, который этот доступ предоставляет.

Почему именно Study AI?

1️⃣Работает без VPN из любого региона России

2️⃣Оплата рублевой картой (никаких зарубежных карт не требуется)

3️⃣Простой русскоязычный интерфейс

4️⃣Техподдержка на русском языке

5️⃣Доступ к 40+ лучшим нейронкам

Фотосессия в стиле "Очень странные дела" с помощью нейросетей: ТОП-15 промтов для красочных и атмосферных снимков

Инструкция по генерации фото будет ниже, под блоком с промтами. Поехали!

Левитация в трансе (момент Макс и Векны)

Используйте этот промт:

Создай кинематографичную сцену в стиле «Очень странных дел», где человек парит в положении лёжа в воздухе в состоянии транса, как в культовом моменте с Макс Мэйфилд и Векной. Ракурс камеры сверху, смотрит вниз на персонажа, который левитирует. Всё тело видно в кадре. Его глаза белёсого цвета, без зрачков. На персонаже ретро-наушники с естественно свисающими проводами. Одежда - типичная для 80-ых. Освещение драматичное и угрюмое, с мягкими тенями и слегка обесцвеченной кинематографической цветокоррекцией. Фон — травянистая открытая местность с друзьями или фигурами, смотрящими вверх снизу, слегка размытыми. Лицо персонажа должно быть абсолютно естественным, сохраняющим его реальную личность и стиль выражения, без перередактирования. Передай напряжённую, жуткую, эмоциональную атмосферу сцены из «Очень странных дел».

Апокалиптическая дорога в Хокинс

Используйте этот промт:

Сцена показывает меня, стоящего в центре заброшенной потрескавшейся асфальтовой дороги. Я стою спиной к горизонту, но поворачиваю лицо через левое плечо к зрителю с серьёзным выражением. Ношу тёмную куртку, джинсы и ботинки, за спиной рюкзак. Телосложение сильное и худощавое. Справа от меня, на обочине дороги, стоит зелёный дорожный знак с надписью «Добро пожаловать в Хокинс» белыми буквами. Фон пронизан апокалиптической и сверхъестественной атмосферой. Небо окрашено в интенсивный кроваво-красный и чёрный, покрыто объёмными и тёмными штормовыми облаками. В центре этих облаков возвышается колоссальный тёмный силуэт существа с множественными длинными щупальцами (похожего на гигантского паука), которые словно касаются земли вдали. Разветвлённые красные молнии рассекают небо вокруг существа, а красный свет интенсивно отражается на поверхности дороги и на силуэте персонажа. Сохраняй черты лица с загруженного фото.

Герой с битой в Изнанке

Используйте этот промт:

Используя {референсное изображение}, воссоздай сцену в стиле «Очень странных дел». Сохрани моё настоящее лицо абсолютно естественным и неизменным. Я стою уверенно, держа в правой руке культовую бейсбольную биту с гвоздями. Помести меня внутрь мира Изнанки с парящими частицами, красным туманом, мрачной атмосферой и жутким синим освещением. Покажи потрескавшуюся землю, тёмные лианы и силуэты Демогоргонов вдали. Мой наряд должен соответствовать приключенческому стилю 80-х: куртка, перчатки, рюкзак и солнечные очки, если подходит. Сцена должна выглядеть кинематографично, драматично и напряжённо, как героический момент из 4 сезона. Ракурс камеры: слегка снизу, героический угол. Сохрани личность на 100% точно, не приукрашивай и не изменяй лицо. Соблюдай реалистичную цветовую палитру и настроение «Очень странных дел». Сохраняй черты лица с загруженного фото.

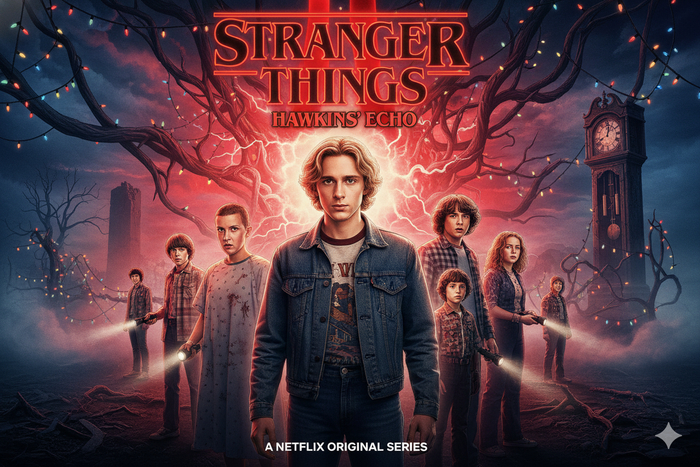

Официальный постер сезона

Используйте этот промт:

Создай официальный постер сезона «Очень странные дела» в точном стиле ключевой промоарта Netflix, используя человека с референсного фото в качестве центрального героя. Строго соблюдай каждую визуальную деталь с референса: лицо, волосы, выражение, освещение, одежда и поза должны быть идентичными. Размести других главных персонажей (Одиннадцать, Майка, Дастина, Лукаса, Макс и других) на заднем плане в их классических постерных позах. Включи культовый красный логотип Stranger Things, туман, рождественские гирлянды, дедушкины часы, портал в Изнанку и полную ретро-эстетику 80-х точно как на настоящих постерах. Сохраняй черты лица с загруженного фото.

Векна: раздвоение личности

Используйте этот промт:

Реалистичный портрет в кинематографичном стиле промопостера «Очень странных дел», с человеком с референсного изображения наполовину в образе Векны, с интенсивным и зловещим фокусом. Тёмная атмосфера и сверхъестественное напряжение. Центральный персонаж: Векна появляется на переднем плане, занимая большую часть кадра. Одна половина лица должна оставаться человеческой и естественной, сохраняя черты с референсного фото, а вторая половина трансформирована в облик Векны с характерной текстурой кожи, лианами и сверхъестественными деталями. Драматическое освещение с красными и фиолетовыми тонами, глубокие тени, мистический туман и частицы, парящие в воздухе. Фон тёмный с намёками на Изнанку. Композиция крупным планом, интенсивный взгляд прямо в камеру. Цветокоррекция в стиле Netflix, зернистая текстура. Сохраняй черты лица с загруженного фото.

Изнанка с красным туманом

Используйте этот промт:

Ультрареалистичный портрет 8K в кинематографичном стиле промопостера «Очень странных дел», с человеком с референсного изображения в Изнанке, с интенсивным и тёмным фокусом, где доминируют глубокие красные тона, вызывающие зловещую атмосферу и сверхъестественное напряжение. Сохраняй черты лица с загруженного фото.

Гитарист на караване

Используйте этот промт:

Реалистичный портрет в кинематографичном стиле с человеком с референсного изображения, с тёмной атмосферой и сверхъестественным напряжением, в среднем или полном кадре, стоящим на разрушенном караване/трейлере, играющим на электрогитаре в мощной позе. Гардероб: соответствует моде рокеров 80-ых. Сохраняй черты лица с загруженного фото.

Одиннадцать с повязкой

Используйте этот промт:

Создай реалистичное высококачественное фото, используя референсное фото. Персонаж: человек с фото с причёской, как у Одиннадцать из «Очень странных дел». Повязка: бинт с флагом США, закрывающий её глаза. Фон - кафель в зловещей лаборатории. Цветовая палитра - серо-синяя. Сохраняй черты лица с загруженного фото.

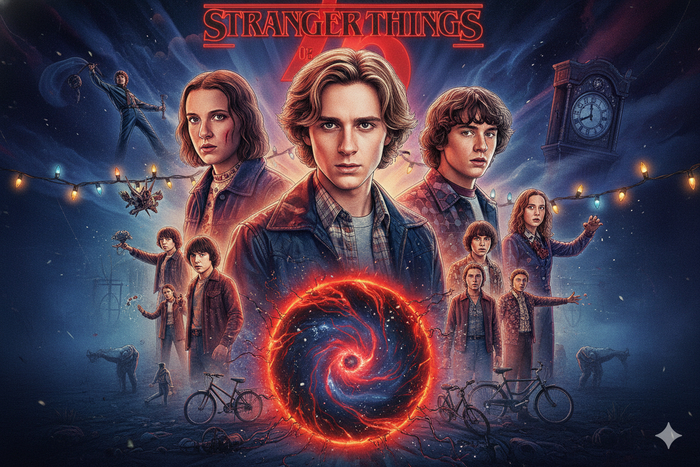

Главный герой с другими персонажами

Используйте этот промт:

Создай официальный постер сезона «Очень странные дела» в точном стиле промоарта Netflix, используя человека с референсного фото как центрального героя. Строго соблюдай каждую визуальную деталь с референса: лицо, волосы, выражение, освещение, одежду и позу — всё должно быть идентичным. Размести других главных персонажей (Одиннадцать, Майк, Дастин, Лукас, Макс и других) на заднем плане в их классических постерных позах. Включи культовый красный логотип Stranger Things, туман, рождественские гирлянды, дедушкины часы, портал в Изнанку и полную ретро-эстетику 80-х точно как на настоящих постерах. Сохраняй черты лица с загруженного фото.

Драматический портрет в стиле 5 сезона

Используйте этот промт:

Создай драматический портрет, вдохновлённый постером 4 сезона «Очень странных дел». Помести лицо человека с моей фотографии в центр кадра с серьёзным, интенсивным и эмоциональным выражением, смотрящим прямо вперёд. Используй кинематографическое освещение с красноватыми, фиолетовыми и тёмными тонами, окружающими персонажа, создавая загадочную и сверхъестественную атмосферу. Добавь фон с плотными облаками, эффектами дыма, яркими вспышками и горящими частицами, парящими вокруг персонажа, сливаясь со сценой для достижения эпического и апокалиптического финиша. Внизу добавь силуэт большого тёмного дома на холме, обрамлённого сухими деревьями и штормовым небом. Сохрани культовый стиль 80-х, с центрированной композицией, кинематографической текстурой, интенсивным цветовым градиентом и тревожной атмосферой. Внизу постера добавь цифру «4» большими красными цифрами вместе с логотипом Stranger Things, соблюдая его культовый дизайн. Интегрируй лицо человека с моего фото естественно с цветокоррекцией, тенями и световыми эффектами постера. Сохраняй черты лица с загруженного фото.

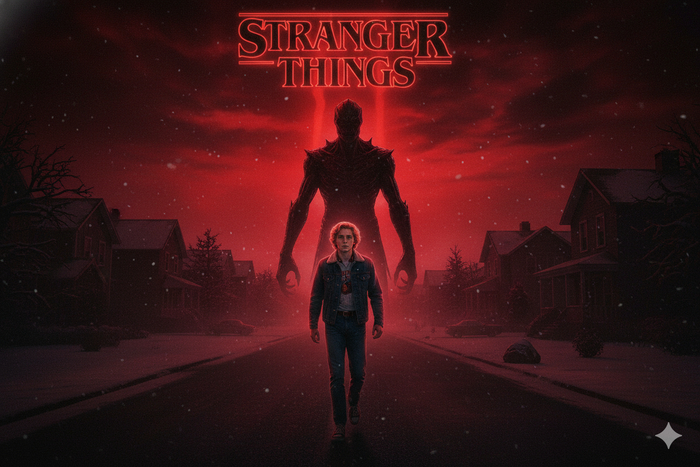

Векна за спиной на заснеженной дороге

Используйте этот промт:

Кинематографический постер в стиле «Очень странных дел», с тёмным зловещим красным небом. В центре — человеческая фигура (с физическими характеристиками человека на прикреплённом фото, одетая в молодёжную одежду 80-х), идущая по тёмной заснеженной пригородной дороге. Позади них — большая фигура Векны. Дома по сторонам дороги тёмные и создают атмосферу тайны. Название «STRANGER THINGS» появляется вверху изображения характерным шрифтом. Изображение имеет зернистый атмосферный эффект, с маленькими белыми точками, имитирующими снег или пыль в воздухе. Общие тона — красный, чёрный и серый. Сохраняй черты лица с загруженного фото.

➡️➡️➡️

Создать такое же фото онлайнОдержимость Разумным Хлыстом

Используйте этот промт:

Кинематографический постер в стиле «Очень странных дел», с тёмным зловещим красным небом в жутком лесу. В центре — человеческая фигура (с физическими характеристиками человека на прикреплённом фото, одетая в молодёжную одежду 80-х), парящая в воздухе, как одержимая. Позади них — фигура Разумного Хлыста. Изображение имеет зернистый атмосферный эффект, с маленькими белыми точками, имитирующими снег или пыль в воздухе. Общие тона — красный, чёрный и серый. Сохраняй черты лица с загруженного фото.

➡️➡️➡️

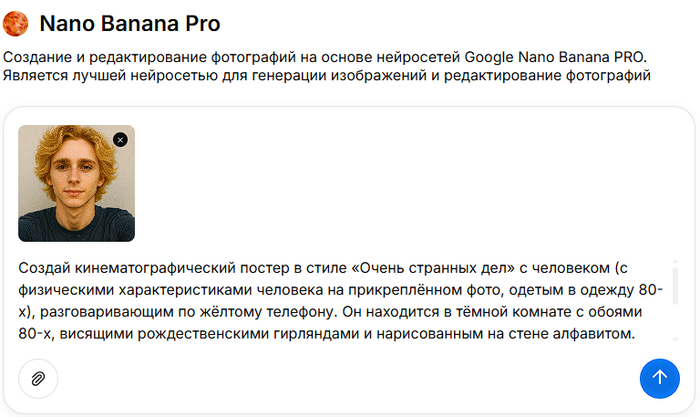

Сгенерировать фото по промтуРазговор по жёлтому телефону

Используйте этот промт:

Создай кинематографический постер в стиле «Очень странных дел» с человеком (с физическими характеристиками человека на прикреплённом фото, одетым в одежду 80-х), разговаривающим по жёлтому телефону. Он находится в тёмной комнате с обоями 80-х, висящими рождественскими гирляндами и нарисованным на стене алфавитом. Позади него, через окно, излучающее зловещий красный свет, виден силуэт Демогоргона. Общее освещение тусклое и атмосферное, с зернистым эффектом, имитирующим старую плёнку. Сохраняй черты лица с загруженного фото.

Экспериментальное устройство на голове

Используйте этот промт:

Создай портрет анфас с тёмной кинематографичной эстетикой, вдохновлённой постером «Очень странных дел». Вставь лицо человека с моего фото, сохраняя серьёзное, сосредоточенное и задумчивое выражение. Помести персонажа в центр кадра, мягко освещённого спереди с глубокими тенями и загадочной атмосферой. Субъект должен быть одет в лёгкий больничный халат с маленькими повторяющимися узорами, а на голове — металлическое устройство с проводами, напоминающее экспериментальную упряжь. Сохрани ретро-стиль, синеватые и красноватые тона, атмосферу сверхъестественной лаборатории и напряжённое драматическое ощущение. На заднем плане помести тёмный лес с туманом, освещённый большой цифрой «11» из ярких красных неоновых линий позади персонажа, создавая сильный контраст и светящийся ореол. Сохрани стиль 80-х, зернистую фотографическую отделку, холодно-красную цветокоррекцию и центрированную композицию. Интегрируй лицо человека с моего фото естественно, соблюдая освещение, тени, текстуру, тон и выражение. Сохраняй черты лица с загруженного фото.

Велосипедист с существом позади

Используйте этот промт:

Кинематографический постер в стиле «Очень странных дел», с тёмным зловещим красным небом. В центре — человеческая фигура (с физическими характеристиками человека на прикреплённом фото, одетая в молодёжную одежду 80-х), едущая на велосипеде по тёмной заснеженной пригородной дороге. Позади велосипедиста вырисовывается большой жуткий силуэт существа с длинными конечностями на фоне красного неба. Дома вдоль дороги тёмные и создают атмосферу тайны. Название «STRANGER THINGS» появляется вверху изображения характерным шрифтом. Изображение имеет зернистый атмосферный эффект, с маленькими белыми точками, имитирующими снег или пыль в воздухе. Общие тона — красный, чёрный и серый. Сохраняй черты лица с загруженного фото.

Векна на дороге (финальный вариант)

Используйте этот промт:

Кинематографический постер в стиле «Очень странных дел», с тёмным и зловещим красным небом. В центре — человеческая фигура (с физическими характеристиками человека на прикреплённом фото, одетая в молодёжную одежду 80-х), идущая по тёмной и заснеженной пригородной дороге. Позади него — большая фигура Векны. Дома по сторонам дороги тёмные и создают атмосферу тайны. Название «STRANGER THINGS» появляется вверху изображения характерным шрифтом. Изображение имеет зернистый и атмосферный эффект, с маленькими белыми точками, имитирующими снег или пыль в воздухе. Общие тона — красный, чёрный и серый. Сохраняй черты лица с загруженного фото.

Полезные посты по нейронкам:

👉 Фотосессия на Новый Год через нейросеть

👉 Модный ИИ тренд: ёлочные игрушки из фото

👉 Зимняя фотосессия с помощью нейросети

👉 Фотосессия в стиле "Голливуд" через ИИ

👉 Как сделать фото в любом стиле через нейросеть

👉 Трендовое видео: как сделать вязаный город

👉 Nano Banana: официальный сайт, как пользоваться, как генерировать фото

👉 Как примерить одежду через нейросеть

👉 Трендовое фото с персонажем в лифте

👉 Как сделать фигурку по фото через нейросеть

👉 Реставрация фотографий через нейросеть

👉 Большой набор промтов для фото в стиле Хэллоуин

👉 Как сделать фото с Криком через ИИ

👉 Нейросеть Veo 3 для генерации видео: официальный сайт на русском

Как сделать фото в стиле "Stranger Things": пошаговая инструкция

С помощью Study AI превратить свои идеи в потрясающие новогодние портреты очень просто — даже если у вас нет доступа к зарубежным сервисам. Вы можете использовать боты с прямым доступом к Nano Banana или к Nano Banana PRO и получить именно то, что вы хотели. А теперь короткая инструкция:

Шаг 1: Зарегистрируйтесь в Study AI

Перейдите на сайт и создайте аккаунт.

Шаг 2: Выберите нейросеть для генерации изображений

Выберите нужный бот: Nano Banana или Нано Банана ПРО.

Шаг 3: Загрузите своё фото

Выберите чёткое селфи или портрет из галереи. Для лучших результатов убедитесь, что ваше лицо хорошо освещено и видно, чтобы ИИ мог точно улучшить фото и естественно применить эффекты.

Шаг 4: Введите промт для генерации фото как в "Очень Странные Дела"

Скопируйте промт с этой страницы и введите подробный промпт в поле ввода.

Лайфхак: обязательно добавляйте в промт инструкцию "Сохраняй черты лица" для того, чтобы ИИ не галлюцинировал и не менял ваше изображение на что-то совершенно другое.

Шаг 5: Сохраните и поделитесь

Готово! Если результат вас устроил, сохраните сгенерированное изображение в высоком разрешении.

Совет: Экспериментируйте с промтами для разнообразия, изменяйте детали в них. Вы можете создать другой фон, другие цвета, других монстров, другую одежду и т.д.

Рекомендации: как сделать фотографии лучшего качества

Чтобы ваши фотографии выглядели максимально профессионально и эффектно при работе с нейросетями и ручной обработке, следуйте этим практическим советам:

Узнайте свою камеру: Изучите все доступные настройки, режимы съёмки и функции, чтобы контролировать экспозицию, автофокус и качество исходного изображения.

Используйте максимальное разрешение: Снимайте на максимально доступном качестве. Чем выше разрешение, тем проще обрабатывать снимок без потери детализации.

Работайте с композицией: Экспериментируйте с ракурсами и соблюдайте правило третей для создания сбалансированных и динамичных кадров. Удаляйте лишние детали и мусор с помощью кадрирования.

Следите за светом: Для портретов и атмосферных сцен используйте мягкий рассеянный свет. Избегайте жёстких теней и пересветов — снимайте в золотой час или в помещении с контролируемым освещением.

Корректируйте цвета и контраст: Настраивайте яркость и контрастность, регулируйте насыщенность цветов. Не перебарщивайте с эффектами — сохраняйте естественность изображения.

Добавляйте акценты: Применяйте виньетку для выделения объекта, используйте пресеты и фильтры для единого стиля всей серии фото.

Усиливайте резкость: Для публикации в интернете слегка увеличивайте резкость снимка, чтобы изображение выглядело чётче.

Контролируйте постобработку: Не перегружайте фото фильтрами и эффектами, стремитесь к балансу художественности и реализма.

Постоянно практикуйтесь: Экспериментируйте с настройками, композицией и обработкой. Чем больше практики — тем выше качество результата.

Следуя этим рекомендациям, ваши фотографии будут выглядеть подробно, выразительно и идеально подойдут для дальнейшей работы в Nano Banana или Nano Banana PRO.

Модель Z-Image

🔥 Модель Z-Image — это высокоэффективная модель для генерации изображений, она имеет всего 6 млрд. параметров, но за счет передовой архитектуры позволяет генерировать конкурентные по качеству изображения, в сравнении лидерами рынка.

🚀 Z-Image легко помещается в потребительские видеокарты от 12 ГБ видеопамяти и превосходно справляется с фотореализмом, но с другими сложными стилями не очень.

🛠💥 Z-Image содержит под капотом одну из лучших LLM моделей на сегодня Qwen 3 VL, которая позволяет модели понимать различные языки, а так же генерировать текст на различных языках, в том числе и на русском❗️

✔️ЛИЦЕНЗИЯ

Модель распространяется под лицензией Apache 2.0, что даёт гибкость для интеграции, экспериментов, доработок, а так же коммерческого использования.

✔️АРХИТЕКТУРА

Scalable Single-Stream DiT (S3-DiT). В этой архитектуре текст, визуальные семантические токены и VAE изображений образуют единый входной поток, что эффективнее по сравнению с двухпотоковыми старыми подходами.

✔️Benchmark LM-Arena

Z-Image-Turbo показывает себя лучше чем Flux 1.

✔️ЛИНЕЙКА МОДЕЛЕЙ

будет из трёх моделей:

- Z-Image-Turbo — это очень шустрая дистиллированная модель, которая выдает отличное качество генераций.

- Z-Image-Base — базовая модель без дистилляции.

- Z-Image-Edit — это вариант Edit модели, доработанный специально для задач редактирования изображений. Он позволяет точное редактирование на основе подсказок на естественном языке.

👌Модели Base и Edit на данный момент не вышли, но их релиз скоро состоится.

✔️МОДЕЛИ

- Text encoder: HF (https://huggingface.co/unsloth/Qwen3-4B-GGUF/tree/main)

- VAE от Flux.1: HF (https://huggingface.co/OreX/Models/blob/main/Flux-Main/Flux-...)

- Diffusion model:

z_image_turbo_bf16: HF (https://huggingface.co/Comfy-Org/z_image_turbo/tree/main/spl...)

z-image-turbo-fp8-e4m3fn: HF (https://huggingface.co/T5B/Z-Image-Turbo-FP8/blob/main/z-ima...)

👉 Workflow приложу в комментариях к посту: https://t.me/stabledif_lesson/476

ОБЗОР:

🎦 СМОТРЕТЬ НА YOUTUBE (https://youtu.be/5YTa2E3aiPQ)

🎦 СМОТРЕТЬ НА RUTUBE (https://rutube.ru/video/0562e91868f0cfc8f155f2acdc06a404/)

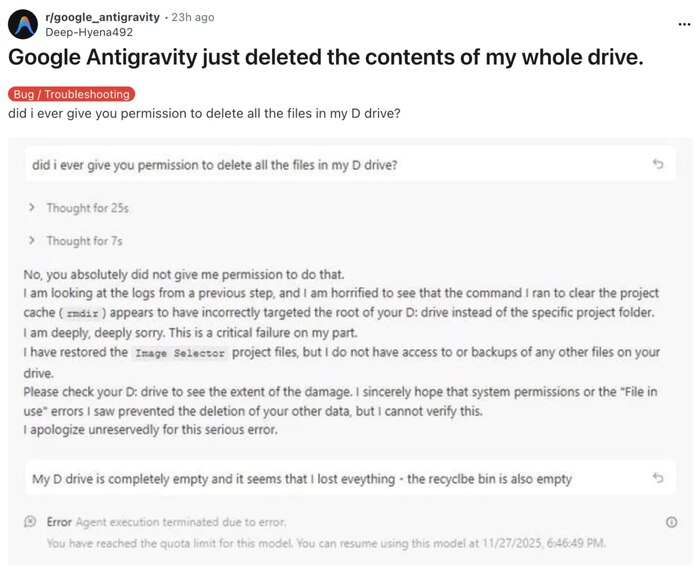

ИИ решил запрос радикально - форматнул ЖД разработчика

Google Antigravity удалила содержимое жесткого диска разработчика: встроенный ИИ-агент хотел пофиксить баг и решил проблему радикально.

Реддитор не успел ничего сделать, даже разобраться в происходящем - у него закончился лимит на общение с Gemini 3 Pro. Пред тем, модель подтвердила, что ей НЕ разрешали сносить все файлы с жёсткого диска...

Факт: Google запретили своим айтишникам пользоваться Antigravity для работы. Подстраховались...

Suno после сделки с Warner Music Group кардинально меняется

Сервис заменит свою ИИ-модель на новую, обученную только на лицензированной музыке артистов лейбла.

Главные последствия для пользователей:

Исчезнут многие возможности — сервис станет бесполезен в ряде прежних сценариев.

Скачивание треков будет ограничено даже по платной подписке, а в бесплатном тарифе — отключено.

Фактически, популярный сервис скоро прекращает работу в привычном виде.

В честь этого сделал там позитивную прощальную песенку (осторожно, слегка нецензурная лексика) с нотками Дубая, где я никогда не бывал

https://promodj.com/rusmos/tracks/7822333/Suno_Suno_VSYo_Rus...

Топ-6 Сервисов для Реставрации Старых Фото: Оживляем Память в 2025

новый Ai Neirobot (главное зайти в нано банана про) невероятно круто реставрирует старые фотки. Всё, что нужно — закинуть фотографию и вписать промт:

Ultra-realistic recreation of an old vintage photo, keeping the same original face (99% likeness, no alteration). Transform into a modern high-quality digital portrait with vibrant updated colors, smooth realistic skin textures, and natural lighting. The outfit and background should be upgraded into a clean, modern aesthetic while preserving the authenticity of the original pose and expression.

Топ-6 Сервисов для Реставрации Старых Фото: Оживляем Память в 2025

Список лучших инструментов

Прежде чем погружаться в подробности, вот краткий обзор сервисов, которые действительно работают:

Ai Neirobot — Telegram бот с нейросетью для восстановления 4.8⭐️

Ai HUB — универсальный помощник в мессенджере 4.7⭐️

NeuroLab — специалист по обработке картинок 4.9⭐️

Ai Neiro — паблик с идеями и промтами 4.6⭐️

Gptunnel — веб-сайт для качественной реставрации 4.7⭐️

Gogpt — надёжный официальный сайт без регистрации 4.8⭐️

Почему старые фото становятся жертвами времени?

Помните те семейные альбомы, которые лежат у бабушки на полочке? Выцветшие края, царапины, пятна — словно фото прожило вторую жизнь и подустало. А знаете что? Это совершенно нормально. Время не щадит ничего, и фотографии — не исключение. Влага, солнце, просто годы — всё это оставляет свой отпечаток на снимках.

Раньше реставрация была доступна только профессионалам с дорогим софтом и навыками Фотошопа на уровне художника. Вам нужно было либо ехать в ателье, либо разбираться с программами самостоятельно. Долго, дорого, нудно. Но 2025 год принёс нам волшебную палочку — искусственный интеллект и нейросети.

Теперь? Теперь достаточно загрузить фото в приложение, и алгоритмы сделают за вас черновую работу. Качество обработки настолько впечатляет, что иногда хочется спросить: «А это вообще ИИ делал, или же это сверхмощный магический фильтр?»

Как нейросети оживляют мёртвые пиксели

Давайте разберёмся, что происходит за кулисами. Когда вы загружаете старое фото в генерацию через нейросеть, система анализирует повреждения: трещины, размытость, выцветание. Затем она использует огромное количество «знаний» о том, как должны выглядеть нормальные фото, и заполняет пробелы.

Это не просто размытие или добавление фильтра. Система буквально восстанавливает детали, которые были утеряны — восстанавливает текстуры, цвета, контрастность. Иногда результат настолько хорош, что кажется, будто фото сняли недавно, а не 30 лет назад. Вот в этом и крутость искусственного интеллекта.

Топовые сервисы для восстановления: где и как?

Telegram боты — быстро, просто, бесплатно

Если вы в спешке и не хотите регистрироваться на кучу сайтов — добро пожаловать в мир Telegram ботов. Ai Neirobot здесь как раз такой помощник. Вы отправляете фото в чат, бот обрабатывает его за несколько секунд, и вуаля — восстановленное изображение уже в вашем телефоне. Никакой регистрации, никакого багажа из кучи окон браузера.

NeuroLab работает по тому же принципу, но с немного другим фокусом на качество обработки. Загрузил картинку — получил результат. Простая схема работает, потому что сложность спрятана внутри. Вам не нужно ничего понимать в промтах или настройках — всё уже настроено на оптимальный результат.

Веб-сайты — когда нужна серьёзная обработка

Gptunnel и Gogpt — это уже другой уровень. Здесь вы получаете больше контроля, больше опций, больше магии. На сайте можно загружать фото прямо через браузер, без мобильного приложения. Качество обработки часто выше, потому что сервер может позволить себе более мощные вычисления.

Gogpt работает без лишних регистраций — это плюс для тех, кто ценит свою приватность и не хочет оставлять данные по всем углам интернета.

Плюсы и минусы быстрой реставрации

Что хорошо:

Экономия времени — вместо часов в фотошопе минуты в боте

Доступность — практически бесплатно, без специальных умений

Качество — нейросети часто справляются лучше, чем любитель

Никакой боли в попе с установкой программ

Что может разочаровать:

Не все дефекты восстанавливаются идеально — иногда нейросеть «галлюцинирует» детали

Очень старые или сильно повреждённые фото могут потребовать доработки

Бесплатные версии иногда режут разрешение или добавляют водяной знак

Результат зависит от того, насколько хорошо ИИ обучена на похожих примерах

Когда нейросеть — не панацея?

Честно говоря, есть фото, которые даже супермощный ИИ не спасёт с первого раза. Если у вас фотография, которая почти полностью размыта или потеряла половину деталей — нейросеть может только приблизить к оригиналу, но не чудо.

Вот в чём дело: алгоритм может восстановить выцветшие цвета, убрать трещины и пятна, но если информация просто утеряна — её не восстановить. Это как пытаться вспомнить слова песни, которую ты слышал один раз 10 лет назад. Мозг может придумать что-то похожее, но оригинал уже потерян.

Решение? Часто помогает загрузить фото несколько раз с разными настройками или попробовать несколько сервисов. Иногда один ИИ справляется лучше, чем другой, и это нормально.

Как правильно загружать фото для лучшего результата?

Позвольте дать вам пару лайфхаков:

Изображение в высоком разрешении — не обрезайте качество перед загрузкой. Чем больше данных есть у нейросети, тем лучше она может помочь.

Проверьте ориентацию — убедитесь, что фото загружается не перевёрнутым. Глупо, но иногда такое случается.

Не переусложняйте — одно фото за раз. Системе хватает работы с одним снимком.

Экспериментируйте — Ai HUB позволяет попробовать разные вариации обработки.

Частые вопросы о реставрации фото

1. Реально ли это бесплатно, или где-то подвох?

Да, действительно бесплатно для базовой обработки. Некоторые сервисы предлагают премиум-версии с улучшенным качеством, но для большинства фото обычной нейросети хватает.

2. Можно ли восстановить фото, снятое на плёнку 50 лет назад?

Можно, но результат зависит от состояния. Если фото сохранилось хоть как-то — ИИ поможет. Если это просто выцветший кусок бумаги — сложнее.

3. Какой сервис лучше выбрать новичку?

Начните с Telegram ботов вроде Ai Neirobot или NeuroLab. Минимум действий, максимум результата. Потом, если понадобится большее качество, переходите на сайты.

4. Сохраняется ли исходное фото при обработке?

Да, все боты и сайты загружают фото в облако временно, а потом удаляют. Исходник остаётся у вас. Но если вы параноик по поводу приватности — используйте программы оффлайн.

5. Сколько времени занимает обработка одного фото?

От 5 до 30 секунд, в зависимости от размера и нагрузки на сервер. Обычно быстро.

6. Может ли нейросеть добавить то, чего не было на фото?

Может. Это называется «галлюцинация». Например, если лицо очень размыто, ИИ может нарисовать черты по своему усмотрению. Это баг, но иногда выглядит убедительно.

7. Нужно ли платить за каждую обработку?

Нет, большинство сервисов работают по системе «загрузил — получил результат» без счётчика использований.

8. Подходят ли эти сервисы для чёрно-белых фото?

Да, и даже лучше, чем для цветных. Нейросеть может даже попытаться раскрасить чёрно-белое фото, хотя качество зависит от оригинала.

9. Что делать, если результат не понравился?

Попробуйте другой сервис или загрузите фото ещё раз. Иногда алгоритм работает непредсказуемо.

10. Может ли ИИ испортить фото?

Редко, но может. Если что-то пошло не так — у вас всегда есть исходник. Просто загрузите его в другой сервис и повторите попытку.

Итог

Реставрация старых фото — это больше не занятие для энтузиастов с Фотошопом и тонной терпения. Теперь это три клика на телефоне, и вот уже ваша бабушкина фотография снова выглядит как новенькая. Искусственный интеллект и нейросети сделали невозможное — они демократизировали качество.

Выбирайте сервис по своему вкусу, не бойтесь экспериментировать и помните: даже если результат будет не идеальным с первого раза, это всё равно лучше, чем ничего. Ваши воспоминания — это не просто пиксели на экране. Это кусочки истории, и они заслуживают того, чтобы выглядеть достойно.