Искусственный интеллект

Американская экономика "висит" на дата-центрах для ИИ

Знаете, что держит на плаву американскую экономику в 2025 году? Искусственный интеллект. Точнее, дата-центры для него.

Экономист из Гарварда Джейсон Фурман посчитал, что без инвестиций в дата-центры рост ВВП США в первой половине года составил бы 0,1%. Практически ноль. А в августе аналитики Renaissance Macro Research оценили, что вклад строительства дата-центров для ИИ впервые в истории превзошёл потребительские расходы американцев. Вдумайтесь! Потребительские расходы — это две трети ВВП!

По словам Фурмана, инвестиции в оборудование для обработки информации составили всего 4% ВВП за первое полугодие. Но они обеспечили 92% роста ВВП за тот же период. 92%!

Техногиганты вроде Microsoft, Google, Amazon и Nvidia инвестировали десятки миллиардов в дата-центры. Лиза Шаллет из Morgan Stanley отметила, что за последние годы капитальные расходы выросли вчетверо и составили почти 400 млрд долларов ежегодно. По её оценкам, расходы на дата-центры добавляют примерно сто базисных пунктов к реальному росту ВВП США.

Но этот всплеск происходит на фоне общей экономической вялости. Создание рабочих мест замедлилось. Другие секторы — производство, недвижимость, торговля — внесли минимальный вклад или их вообще вычли из общего объёма производства.

Даже основатель Amazon Джефф Безос настаивает, что эти дата-центры — промышленный пузырь, а не финансовый...

--

Мой тг-канал: ИИ by AIvengo, пишу ежедневно про искусственный интеллект

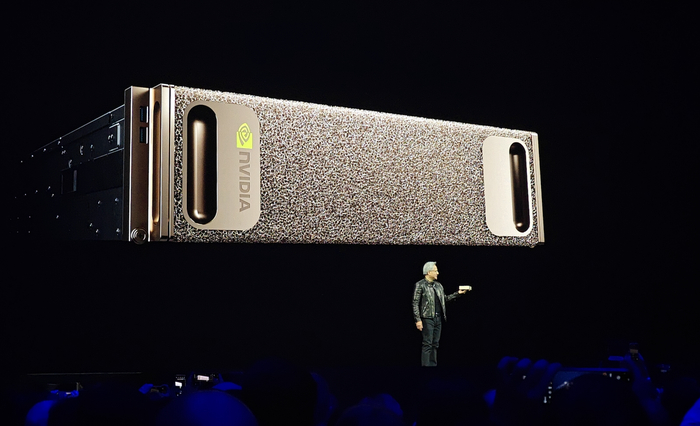

Личный «суперкомпьютер» за $3 999: зачем Nvidia выпускает DGX Spark

Компания Nvidia начинает продажи DGX Spark — настольного мини-компьютера для работы с искусственным интеллектом. Цена — около $3 999, поставки стартуют на этой неделе. В Nvidia позиционируют новинку как «персональный суперкомпьютер»: небольшая коробка, которая способна делать то, ради чего раньше приходилось арендовать сервер в облаке.

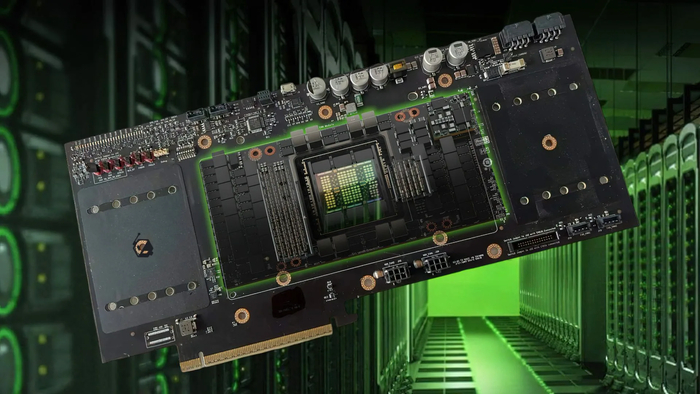

Что внутри

В основе Spark — новая платформа GB10 (Grace Blackwell). Это гибрид, где центральный процессор и графическое ядро распаяны в одном модуле и делят 128 ГБ единой памяти. На практике это означает меньше «узких мест» между CPU и GPU и высокую эффективность при работе с нейросетями.

В комплекте — NVMe-накопитель до 4 ТБ и порт ConnectX-7 на 200 Гбит/с для объединения двух устройств в мини-кластер. Производительность — до 1 петафлопса в низкой точности (формат FP4), что вполне достаточно для большинства задач инференса и дообучения локальных моделей.

Продажи пойдут через партнёров Nvidia — Acer, ASUS, Dell, Lenovo и других. У каждого своя внешность и система охлаждения, но все устройства поставляются с предустановленным ПО для работы с моделями и нейросетями.

Зачем это нужно

DGX Spark задуман как промежуточное звено между «игровыми» видеокартами и большими дата-центрами. Он подходит исследователям, небольшим командам и компаниям, которым нужно обучать или дорабатывать модели на своих данных, но при этом не хочется или нельзя уходить в облако. Для стартапа, который боится потерять приватность или платить по счётам AWS, это вариант «под рукой»: включил и работай.

Где подводные камни

Цена в $3 999 звучит привлекательно, но это только начало расходов. Spark требует питания и охлаждения, а его 128 ГБ памяти — ограничение для полноценного обучения гигантских моделей. Да и сам формат новый: пока экосистема софта и инструментов под Grace Blackwell только становится на ноги. Впрочем, Nvidia обещает совместимость со всеми основными фреймворками — от PyTorch до TensorRT.

Что в итоге

DGX Spark — это не гаджет для игр и не замена серверу, а инструмент для разработчиков и инженеров, которым нужна мощность рядом, а не в облаке. Такой блок может стать новым форматом домашней лаборатории: на столе не монитор, а мини-кластер. И да, впервые фраза «у меня дома суперкомпьютер» звучит не как шутка, а почти как техническое описание.

P.S. Поддержать меня можно подпиской на канал "сбежавшая нейросеть", где я рассказываю про ИИ с творческой стороны.

Китай тормозит ввоз чипов Nvidia. Почему заденет и россиян?

По данным Financial Times, китайские власти начали тщательно проверять поставки продвинутых микросхем на границе. Под усиленный контроль попали так называемые «китайские версии» ускорителей Nvidia — H20 и специальные версии профессиональных видеокарт для локального рынка — и теперь проверки распространяются и на другие мощные процессоры. Официально это мотивируется контролем импорта, борьбой с обходом ограничений и поддержкой собственных чипов. Но в итоге страдает не только американская компания, а вся мировая цепочка поставок.

Как это бьёт по рынку

Любая дополнительная проверка в портах Китая — это время и деньги. Контейнеры стоят дольше, страховка дорожает, а груз нужно где-то хранить. Эти издержки сначала ложатся на импортёров, потом — на интеграторов, облачные сервисы и компании, которые ждут новое «железо». Для китайских Big Tech вроде Baidu, Alibaba и ByteDance это значит сдвиг сроков запуска ИИ-сервисов и поиск обходных решений: урезанные версии чипов, внутренние ускорители, оптимизации программного кода.

Западные вендоры, зависящие от спроса в КНР, рискуют терять обороты: Китай остаётся одним из крупнейших рынков для Nvidia, и любая пауза в поставках там отражается на всём мире. Чем больше КНР замыкает свой полупроводниковый цикл, тем меньше «свободных» ускорителей оказывается на глобальном рынке.

Кто проигрывает, а кто выигрывает

Проигрывают те, кто работает «на границе»: импортёры, дата-центры, интеграторы. Доступной мощности становится меньше, а аренда GPU — дороже. Выигрывают китайские проектировщики чипов и локальные облака: у них появляется шанс предложить альтернативу, пусть и скромнее по производительности. В плюсе и разработчики, умеющие «выжимать максимум» из менее мощных систем — оптимизация софта, сжатие моделей, гибридные решения CPU+GPU становятся не модой, а необходимостью.

Почему это касается и россиян

Российский рынок вычислительной техники и ИИ-железа сейчас сильно зависит от Китая. Через китайские каналы идёт существенная часть поставок, включая серверные ускорители, видеокарты и компоненты для систем охлаждения и питания. Если таможня тормозит контейнеры, это означает одно: поставки будут дольше, а цены — выше.

Сначала подорожает корпоративный сегмент — облачные провайдеры, интеграторы и стартапы, которые арендуют мощности для обучения моделей. Когда они поднимут прайсы, эффект может дойти и до потребителей: массовые видеокарты часто дорожают, когда дата-центры забирают крупные партии.

Что делать сейчас

Бизнесу, который строит ИИ-сервисы, стоит заранее закладывать больший бюджет и время на поставки. Имеет смысл распределить заказы между разными каналами и рассмотреть софт-оптимизации — уменьшение моделей, гибридные пайплайны, квантование. Ритейлу — выравнивать ассортимент, не зависеть от «хитовых» моделей и честно предупреждать покупателей о возможных задержках.

А частным пользователям — следить за ценами: если давно присматриваетесь к видеокарте, лучше не затягивать. Любая новая таможенная инициатива в Китае способна сделать покупку ощутимо дороже уже через пару месяцев.

Итог

Это не катастрофа и не прямой обмен торговыми ударами, но сигнал: вычислительная мощность дорожает по всей планете. Китай укрепляет контроль над «железом», США — над экспортом, а страны вроде России оказываются зависимыми — от чужих решений, чужих границ и чужих проверок. Выиграет тот, кто успеет подстроиться — и научится считать не только террафлопсы, но и дни доставки.

P.S. Поддержать меня можно подпиской на канал «сбежавшая нейросеть», где я рассказываю про ИИ с творческой стороны.

Пиратские книги и ChatGPT: суд требует показать внутренние чаты OpenAI

Федеральный суд в Нью-Йорке потребовал от OpenAI раскрыть внутреннюю переписку, где обсуждалось удаление наборов данных с пиратскими книгами — в том числе из базы Library Genesis (LibGen). Суд хочет понять, знала ли компания, что обучает модели на нелегальных текстах, и не проводила ли затем спорные чистки данных. OpenAI ссылалась на адвокатскую тайну, но суд счёл, что часть сообщений не подпадает под неё, — и их придётся раскрыть.

Истцы — авторы и издательства — утверждают, что OpenAI использовала их тексты без лицензий, а затем убрала спорные материалы, когда начались иски. Теперь вопрос не только о «честном использовании» и авторском праве: суду важно, кто что знал и когда. Если выяснится, что в компании осознанно оставили в обучающем наборе пиратские книги, а потом удалили их без огласки, это может обернуться крупными убытками и возможными санкциями.

История шире, чем кажется

ИИ развивается быстрее, чем юристы успевают писать регламенты, и соблазн велик — забирать всё подряд из открытых источников «ради качества модели». Но этот подход возвращается бумерангом: одно неосторожное сообщение в «Slack» может стать доказательством в суде. Эпоха «серых» наборов данных заканчивается.

Ответственность бизнеса очевидна. Нельзя строить индустрию по принципу «потом разберёмся». Нужно документировать происхождение данных, фиксировать, кто и почему что-то удаляет, и подключать юристов заранее, а не тушить пожар постфактум. Если компания ссылается на адвокатскую тайну, она должна показать, что речь действительно о юридических консультациях, а не о бытовом «пора всё подчистить».

Но ответственность не только на компаниях. Государствам тоже пора включаться: нужны стандарты прозрачности — как хранить и проверять наборы данных, кто отвечает за авторские права, какие журналы событий сохранять при судебных спорах. Без этого даже добросовестные разработчики окажутся под подозрением просто потому, что «так делают все».

Пока суды изучают переписку и документы, индустрия учится жить по новым правилам. Это нормальный этап взросления технологий: чем мощнее инструмент, тем выше планка прозрачности и ответственности.

P.S. Поддержать меня можно подпиской на канал «сбежавшая нейросеть», где я рассказываю про ИИ с творческой стороны.

Кому доверить тормоз и газ в ИИ: что предлагает идеология «оптимизма с осторожностью»

Когда речь заходит об искусственном интеллекте, мир делится на два лагеря: тех, кто видит в нём спасение, и тех, кто ждёт катастрофу. Джек Кларк, автор рассылки Import AI и один из самых известных обозревателей ИИ, предлагает третий путь — технооптимизм с осторожностью.

Он не призывает ни тормозить прогресс, ни отпускать его без присмотра. Его позиция проста: ИИ — мощный инструмент, и если уж человечество взялось за него, нужно строить систему правил и предохранителей, чтобы не въехать в стену на полной скорости.

Почему этого нельзя доверить самим компаниям? Потому что у них другой приоритет — выиграть гонку. Саморегуляция в мире, где каждый новый релиз может принести миллиарды, работает плохо. ИИ развивается быстрее, чем успевают писать законы, а риск-менеджмент подменяется маркетингом.

Кларк предлагает понятные шаги.

Компании должны публиковать отчёты о рисках и результаты тестов своих моделей.

Нужны независимые центры проверки безопасности, которые смогут тестировать модели до релиза.

Для «высокорисковых» применений — обязательные аварийные выключатели и внешние аудиторы.

Государства и международные структуры должны ввести стандарты прозрачности — не для галочки, а как условие допуска на рынок.

По сути, это идея «газ и тормоз в разных руках». Исследователи и компании — за скорость. Общество и регуляторы — за контроль. Только вместе они могут не дать машине ни заглохнуть, ни сорваться с обрыва.

И вот в чём главный оптимизм: это можно сделать. Если человечество сумело договориться о правилах для ядерной энергетики и биотехнологий, то и с ИИ справится — если начнёт вовремя.

P.S. Поддержать меня можно подпиской на канал «сбежавшая нейросеть», где я рассказываю про ИИ с творческой стороны.

GPT-5 Pro опровергла 18-летнюю математическую гипотезу

Математик Паата Иванишвили сообщил, что модель GPT-5 Pro обнаружила контрпример, опровергающий математическую гипотезу 2007 года из списка открытых задач престижного Института Саймонса (задача №25).

Речь идёт о модели неинтерактивной дистилляции корреляций со «стираниями» — ситуации, когда часть входных данных теряется.

Долгое время математики предполагали, что при такой потере данных оптимально работает правило большинства. Если объяснить простыми словами: представьте «анкету» из ответов +1/−1, где часть ответов стёрта. Требуется найти правило, которое по неполной анкете выдаёт максимально надёжный итоговый знак. Считалось, что лучший метод — просто смотреть, какого знака больше среди известных ответов.

Новый контрпример показывает, что иногда эффективнее работает взвешенное решение, где разным признакам придаётся разная важность. Эта тонкая настройка даёт выигрыш всего на тысячные доли, но достаточный, чтобы опровергнуть гипотезу в общем виде.

Значимость открытия в том, что подобные модели описывают множество реальных ситуаций — от каналов связи и сенсорных сетей до агрегирования частично наблюдаемых сигналов и результатов опросов. Получается, что интуитивно понятное правило «спросить у большинства» не всегда оптимально при пропусках данных.

GPT-5 Pro удалось найти контрпример благодаря способности исследовать огромное пространство возможных решений. Человеческая интуиция тяготеет к симметричным и «красивым» формулам, отсеивая странные варианты ещё до проверки.

К тому же ручной перебор близких кандидатов утомителен, и легко упустить слабый сигнал. Искусственному интеллекту безразлична «эстетика» формулы — он терпеливо перебирает даже почти неотличимые варианты, точно фиксирует микроскопические различия и не устаёт.

Пока Иванишвили поделился находкой только в своих соцсетях. Следующим этапом должна стать публикация формальной научной статьи с рецензированием.

Вот это круто.

--

Мой тг-канал: ИИ by AIvengo, пишу ежедневно про искусственный интеллект

Виртуальные миры Илона Маска или ИИ-вселенная для гуманоидов

Илон Маск решил, что его искусственный интеллект заскучал без дела. И теперь компания xAI займётся созданием виртуальных миров. Причём не просто красивых картинок, а настоящих симуляций. Где объекты взаимодействуют друг с другом по физическим законам. Начнут, конечно же, с игр — куда без них в двадцать пятом году.

Илон Маск переманил из Nvidia двух специалистов, и это уже показывает серьёзность намерений. Зишан Пател и Этан Хэ раньше как раз занимались так называемыми моделями мира. А теперь будут помогать xAI создавать виртуальные миры с использованием видео и данных от роботов.

Смотреть весь выпуск на VK Видео

Смотреть весь выпуск на YouTube

Приятного просмотра!

--

Мой тг-канал: ИИ by AIvengo, пишу ежедневно про искусственный интеллект

Простота в машинном обучении: один агент превосходит сложные системы

Обзор статьи «Operand Quant: A Single-Agent Architecture for Autonomous Machine Learning Engineering»

Автор: Денис Аветисян

Автономность и Сложность: Поиск Баланса

Автоматизированное машинное обучение (AutoMLE) обещает демократизировать разработку искусственного интеллекта, однако сталкивается со значительными трудностями на пути к истинной автономии. Если система держится на костылях, значит, мы переусложнили её. Текущие подходы часто полагаются на хрупкие эвристики или обширный человеческий надзор, ограничивая масштабируемость и адаптивность. Мы наблюдаем тенденцию к модульности ради модульности, но модульность без понимания контекста — иллюзия контроля.

Долгое время автоматизация ограничивалась решением узких, предопределённых задач. Но для настоящего прорыва требуется не просто автоматизация отдельных шагов, а создание агента, способного к выполнению всего спектра задач, возникающих в процессе машинного обучения. Такой агент должен уметь не только подбирать модели и параметры, но и самостоятельно проводить анализ данных, выявлять проблемы, проектировать эксперименты и интерпретировать результаты.

Необходимо смещение парадигмы: от автоматизации конкретных задач к созданию агента, обладающего общими навыками машинного обучения. Такой агент должен воспринимать процесс машинного обучения не как набор изолированных этапов, а как единую, взаимосвязанную систему. Он должен уметь адаптироваться к новым данным, новым задачам и новым требованиям, без необходимости постоянного вмешательства человека.

Создание такого агента — сложная задача, требующая новых подходов к проектированию и реализации систем искусственного интеллекта. Необходимо разработать новые алгоритмы и методы обучения, которые позволят агенту эффективно работать в условиях неопределенности и изменчивости. Также необходимо создать новые инструменты и инфраструктуру, которые обеспечат агенту доступ к необходимым ресурсам и данным.

Однако, несмотря на все сложности, создание автономного агента для машинного обучения — вполне достижимая цель. Успех в этой области откроет новые возможности для развития искусственного интеллекта и позволит демократизировать доступ к технологиям машинного обучения для широкого круга пользователей.

Operand Quant: Архитектура Простоты и Целостности

Operand Quant представляет собой принципиально новую архитектуру для автономной машинной инженерии, в корне отличающуюся от всё более сложных многоагентных систем. В основе лежит простая, но глубокая идея: меньше связей – меньше точек отказа. Всё ломается по границам ответственности – если их не видно, скоро будет больно. Многоагентные системы неизбежно порождают паутину коммуникаций, где отслеживать взаимодействие и выявлять узкие места становится непосильной задачей. Operand Quant же избавляется от этой сложности, концентрируя всю логику управления в рамках единого агента.

Эта архитектура позволяет агенту поддерживать целостное понимание всего процесса машинного обучения, от начального анализа данных до финальной постановки в производство. Нет необходимости в сложных протоколах координации, в передаче контекста между разными компонентами. Все знания – внутри, всё под контролем. Это подобно опытному инженеру, который держит в голове всю картину проекта, а не полагается на отдельные команды, работающие изолированно.

Operand Quant функционирует в рамках симулированной интегрированной среды разработки (IDE). Этот выбор не случаен. IDE предоставляет привычный и эффективный рабочий интерфейс для машинной инженерии, знакомый каждому специалисту. Это не абстрактная платформа, а среда, которая позволяет агенту оперировать с кодом, данными и инструментами так же, как это делал бы человек. Использование IDE позволяет агенту эффективно решать задачи, требующие тонкого понимания контекста и гибкости.

Для оценки возможностей Operand Quant были проведены тщательные испытания с использованием MLE-Benchmark. Этот эталонный набор задач позволяет объективно оценить способности агента в изолированных условиях, исключая влияние внешних факторов и случайных событий. MLE-Benchmark – это строгий экзамен, который выявляет слабые места и подтверждает надёжность системы. Результаты испытаний показали, что Operand Quant демонстрирует конкурентоспособные показатели и способен решать сложные задачи машинного обучения без вмешательства человека.

В конечном счёте, Operand Quant – это не просто архитектура, это философия. Философия простоты, ясности и целостности. Мы верим, что надёжная система – это живой организм, в котором каждая часть гармонично взаимодействует с остальными. И Operand Quant – это шаг к созданию такой системы.

Глубокое Мышление: Ансамблевый Подход к Рассуждениям

Модуль Глубокое Мышление системы Operand Quant призван решать проблемы, возникающие при построении логических цепочек, за счёт использования ансамблевого подхода к рассуждениям. В основе данной стратегии лежит идея о том, что масштабируемость определяется не вычислительной мощностью, а ясностью идей. Вместо того, чтобы полагаться на наращивание ресурсов, система стремится к более эффективной организации и обработке информации.

Глубокое Мышление объединяет результаты работы нескольких моделей, что позволяет повысить точность и устойчивость принимаемых решений. Вместо слепого следования одному пути, система рассматривает различные варианты, оценивает их сильные и слабые стороны, и выбирает наиболее оптимальный. Такой подход позволяет избежать локальных оптимумов и находить более глобальные решения.

Ключевым аспектом работы модуля является использование контекстуального мышления. Система не просто анализирует текущие данные, но и учитывает всю доступную информацию об окружающей среде, историю предыдущих действий и текущее состояние системы. Это позволяет ей поддерживать целостную картину происходящего и принимать более обоснованные решения. Представьте себе экосистему, где каждый элемент влияет на целое – именно так работает контекстуальное мышление.

Важнейшим требованием к системе является надёжность и воспроизводимость результатов. Для этого используется механизм детерминированного сохранения состояния, который обеспечивает возможность отладки и анализа работы системы в любых условиях. Это позволяет исследователям отследить логику работы системы, выявить потенциальные ошибки и улучшить её производительность. Система функционирует как живой организм, где каждая деталь взаимосвязана с другими, и понимание целого требует глубокого анализа каждого элемента.

В конечном итоге, Глубокое Мышление – это не просто технический инструмент, а философский подход к решению сложных задач. Это стремление к ясности, последовательности и надёжности, которые являются основой любой успешной системы.

Деградация Контекста и Эволюция Операционной Модели

Анализ работы системы выявил, что деградация контекста является ограничивающим фактором, снижающим гибкость рассуждений модели по мере увеличения длины запроса. Подобно тому, как перегруженная городская магистраль замедляет движение, чрезмерный объем информации затрудняет эффективную обработку и принятие решений. Исследователи отмечают, что это естественное ограничение, присущее большинству больших языковых моделей, и Operand Quant не является исключением.

Однако, в отличие от систем, пытающихся обойти эту проблему за счет грубой силы (увеличения вычислительных ресурсов или укорочения контекста), авторы подошли к решению вопроса с точки зрения эволюции структуры. Операционная модель Operand Quant построена на принципах неблокирующего исполнения и пошагового (turn-based) функционирования. Это позволяет максимизировать эффективность и отзывчивость системы, подобно тому, как хорошо спланированная транспортная сеть обеспечивает непрерывное движение даже при возникновении локальных заторов.

Эти методы позволяют агенту продолжать обработку других задач, пока долго выполняющиеся операции находятся в процессе завершения. Представьте себе строительную бригаду, которая, пока застывает бетон, может приступить к выполнению других элементов проекта. Вместо того чтобы бездействовать в ожидании, Operand Quant использует время с максимальной отдачей. Этот подход особенно важен в контексте ограниченных временных рамок и вычислительных ресурсов, установленных протоколом MLE-Benchmark.

Несмотря на это ограничение, связанное с деградацией контекста, система демонстрирует значительный прогресс в направлении действительно автономного машинного обучения. Подобно тому, как город постоянно адаптируется и улучшается, Operand Quant представляет собой эволюционную модель, демонстрирующую потенциал для создания интеллектуальных систем, способных решать сложные задачи без вмешательства человека. Авторы подчеркивают, что дальнейшие исследования будут направлены на смягчение последствий деградации контекста и повышение общей эффективности системы.

«Искусство программирования — это искусство организации сложности.»

— Donald Knuth

Эта работа с Operand Quant подтверждает мою давнюю убежденность в том, что хорошо спроектированная система должна обладать внутренней связностью. Автономная разработка машинного обучения, как показано в исследовании, требует не просто набора инструментов, но и единого агента, способного к контекстному рассуждению и глубокому анализу. Изменение одной части системы, например, стратегии поиска гиперпараметров (ключевой аспект MLE-Benchmark), оказывает эффект домино на всю архитектуру. Operand Quant демонстрирует, что именно ясная структура определяет поведение, а не простое увеличение количества агентов.

Что дальше?

Успех Operand Quant, безусловно, впечатляет. Мы видим, как система демонстрирует компетентность в решении задач, определённых в MLE-Benchmark. Но давайте будем честны: бенчмарк — это лишь имитация реальности. Настоящая сложность машинного обучения не в достижении максимальной точности на статичном наборе данных, а в постоянной адаптации к изменяющимся условиям, борьбе со смещением данных и, что самое важное, в понимании *зачем* мы вообще строим эти модели. Мы оптимизируем не то, что нужно, а то, что измеримо. Operand Quant – это элегантный инструмент, но и инструмент, как известно, бессилен, когда отсутствует ясная цель.

Зависимости — настоящая цена свободы, и Operand Quant, интегрированный в IDE, несомненно, страдает от этой дилеммы. Чем глубже интеграция, тем сложнее система, и тем выше риск возникновения непредсказуемых эффектов. Хорошая архитектура незаметна, пока не ломается, и вопрос в том, когда и где эта система проявит свою хрупкость. Следующим шагом должно быть исследование не просто производительности, а устойчивости и способности к самовосстановлению.

В конечном итоге, мы должны признать, что автоматизация машинного обучения – это лишь часть более широкой проблемы. Нам нужна не просто система, которая может строить модели, а система, которая может *понимать* проблему, формулировать вопросы и, возможно, даже сомневаться в правильности своих решений. Простота масштабируется, изощрённость – нет, и в погоне за автоматизацией мы рискуем создать монстра, который будет решать не те задачи, и решать их не тем способом.

Оригинал статьи: https://arxiv.org/pdf/2510.11694.pdf

Связаться с автором: https://www.linkedin.com/in/avetisyan/