Искусственный интеллект Джона Маккарти

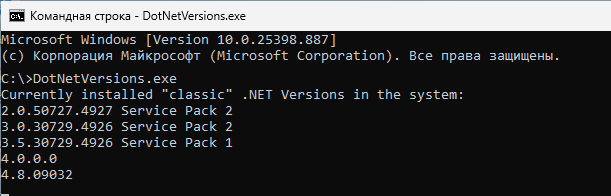

«Я не считаю, что человеческий интеллект — это нечто такое, чего люди никогда не смогут понять». Джон Маккарти, март 1989 г.

Сегодня исполняется 97 лет со дня рождения Джона Маккарти, одного из людей, которые изменили весь информационный мир. Даже Джон Коннор существует только благодаря Джону Маккарти, ведь именно он придумал само понятие «искусственный интеллект», а драмы в его жизни хватало. Он внёс огромный вклад в развитие робототехники и многие другие системы, например — в распознавание речи. Отдавая дань памяти Джону мы сделали для вас, дорогие читатели, аудиоверсию статьи по старинке, без использования искусственного интеллекта.

Джон Маккарти имел классические американские корни, что логично, ведь он родился 4 сентября 1927 года в Бостоне, в семье ирландского эмигранта и литовки еврейской национальности, тоже переселившейся в США, правда… они ещё были активистами коммунистического движения, так что наша логика начинает несколько страдать. Отец Джона была убеждённым католиком, рыбаком и плотником, а также организатором профсоюзных движений, что стало причиной частых переездов семьи. Мать, профессиональная журналистка, сначала перешла с уровня федерального на уровень коммунистической газеты, а потом ушла в соцработники.

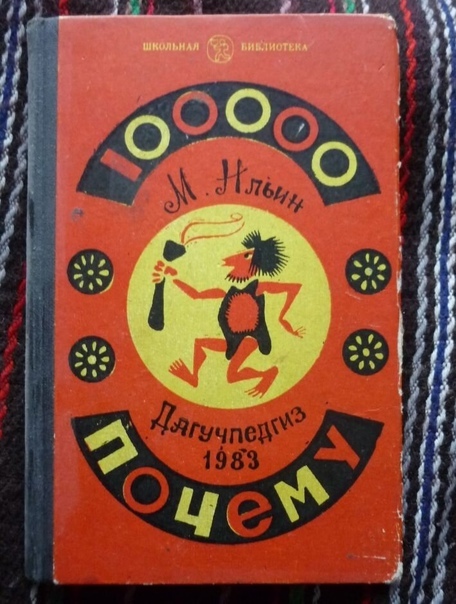

Сам Джон своё ранее увлечение наукой прямо связывал с политическими убеждениями своих родителей. Его любимая книга – совершенно обычная и знакомая многим из нас «100 000 почему» М. Ильина (это псевдоним, настоящее имя писателя – Илья Яковлевич Маршак, он брат Того Самого Маршака). С учётом того, что дело происходило в 1930-е гг. в США, ситуация несколько удивляет. Сам Джон уже ближе к старости отметит: «Я как-то недавно читал про одного китайского не по годам развитого ребёнка, который тоже читал 100 000 почему».

Сам Джон в многочисленных интервью практически не уделяет внимания своему детству, да и вспоминает себя как «рядового школьника», только этот «рядовой школьник» ещё в старших классах получил копии учебников по матанализу, которыми пользовались в Калифорнийском технологическом университете студенты первых двух курсов. Когда он туда поступил, обучение по этим предметам сразу началось на уровне третьего курса. Однозначно «типичный школьник».

❯ Путь к знаниям через страх

В 1948 году случилось одно из значимых событий в жизни Джона Маккарти. Он перешёл в аспирантуру Принстона и посетил симпозиум Хиксона по мозговым механикам (полное название – Hixon Symposium on Cerebral Mechanisms and Behavior). Само мероприятие могло не сохраниться в человеческой памяти, если бы не первая встреча Джона Маккарти и Джона Фон Неймана. Маккарти никогда не был учеником Неймана в привычном нам смысле. В то же время они изредка работали вместе.

Удивительно, но даже для гениев характерны страх и сомнения в себе. Джон Маккарти вспоминал, что он, будучи молодым аспирантом Принстона, пришёл к Нейману в Институт перспективных исследований и поделился с маэстро своими задумками – реакция, в целом, была очень положительной. Джон фон Нейман указал, что нужно учесть для дальнейшей проработки… а Джон Маккарти подумал и решил, что идеи для этого недостаточно хороши. И не стал их записывать. Спрашивается, зачем тогда ходил? Спустя годы сам Маккарти прямо скажет: «Это было глупо с моей стороны». Глупости он в целом любил. Например, прогуливал физкультуру настолько, что оказался в армии США, и лишь в 1948 году закончил учёбу.

Ранние идеи Маккарти были сложны, модель, которую он разрабатывал и пытался объяснить фон Нейману, не могла быть грамотно сформулирована даже её автором. Джону потребовалось более девяти лет, чтобы опубликовать свои наработки, ведь его встреча с фон Нейманом состоялась в 1948 году, а публикация появилась только в 1959 году. В этой публикации Джон смог сформулировать, как заставить мозг изучать конкретные факты и математическую логику. Статья вышла под названием «Программы со здравым смыслом» и, как считал сам Маккарти, сыграла важную роль в начале логического искусственного интеллекта.

К моменту публикации данной статьи уже сложно было найти что-то общее между Маккарти и тем молодым и совсем неопытным Джоном, который был слегка придавлен авторитетом своего статусного коллеги. В 1951 году Джон получил свою Ph.D. в Принстоне под руководством Дональда Клайтона Спенсера, известного американского математика. Успел сам поработать и в Принстоне, и в Стенфордском университете и в 1955 году стать доцентом Дартмутского университета. Этот период в жизни Маккарти имеет особое значение. Именно там и в это время зародился искусственный интеллект.

❯ Дартмутская мастерская – кузница искусственного интеллекта

В прекрасном городе Ганновер (США) шёл летний исследовательский проект [Dartmouth Summer Research Project on Artificial Intelligence] с 18 июня по 17 августа 1956 года. Его второе название – Dartmouth workshop, Дартмутская мастерская. Важно не путать данное мероприятие с серией Дартмутских конференций, до старта которых ещё несколько лет.

К тому моменту сложилось множество названий для области «думающих машин», использовалось название «кибернетика», «теория автоматов», «сложная обработка данных» и ещё ряд названий. Своё название в эту плеяду решил внести Джон Маккарти, недавно ставший доцентом Дартмутского колледжа. Практически сразу после того, как он получил своё новое место работы, Джон начал собирать группу для работы над идеями о мыслящих машинах. Именно он выбрал новое название для области своих действий – «Искусственный интеллект».

Это был весьма изящный ход, ведь название новое, а значит мастодонтов, которых нужно было слушать с придыханием, несколько меньше. Так, к примеру, Норберт Винер, одна из величайших фигур кибернетики своего времени, был несколько отстранён. Похожая ситуация и с «маэстро теории автоматов», Джоном фон Нейманом, правда, ситуация Джона несколько отличается. На момент собраний он находился в тяжёлой борьбе за своё здоровье, которую выиграть было не суждено.

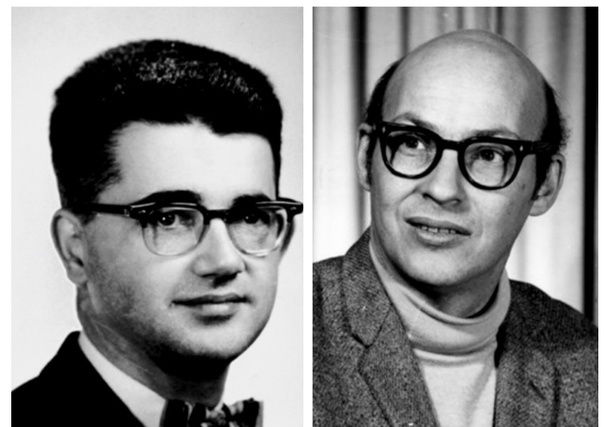

За спонсорством своей научной тусовки Джон Маккарти обратился в Фонд Рокфеллера. Всего планировалась оплата работы десяти учёных. Вместе с Маккарти был Клод Элвуд Шеннон, учёный весьма широкого профиля, специалист по криптоанализу, порой именуемый «Отец теории информации». Шеннон, без сомнения, достоин отдельной истории, где он будет главным героем, а пока он помогает Джону Маккарти найти деньги для организации семинара 1956 года. Двое учёных встретились с представителем фонда Рокфеллера, а уже 2 сентября 1955 года был официально предложен проект от четырёх человек: «О проведении двухмесячного исследования искусственного интеллекта с участием 10 учёных летом 1956 года в Дартмутском колледже в Ганновере, штат Нью-Гемпшир. Исследование должно основываться на предположении, что каждый аспект обучения или другая черта интеллекта в принципе могут быть описаны настолько точно, что можно создать машину для их имитации: «Мы считаем, что можно добиться значительного прогресса, если тщательно отобранная группа учёных проработает над ними вместе в течение лета». В дополнении к этому предположению стояли четыре фамилии: Джон Маккарти, Марвин Мински, Натаниэль Рочестер, Клод Шеннон.

Именно эту четвёрку наиболее корректно считать организаторами данного форума и сооснователями искусственного интеллекта. Их биографии сопровождали заявку, подтверждая тот факт, что они имеют право просить того, чего просят. Начинал Клод Шеннон, как самый влиятельный учёный из группы на тот период. Шеннону было 40 лет, и подчёркивал он в своей биографии работу над коммутационными схемами, проектирование обучающихся машин, криптографию и теоретические вычисления (машинами Тьюринга). Маккарти выделил среди своих заслуг работу по математической природе взаимосвязей между моделью мозга, его средой и использование языков машинами, которую Маккарти обсуждал с фон Нейманом в рамках представления его знаменитого доклада «Общая и логическая теория автоматов». Мински, товарищ Маккарти по учёбе, сделал упор на то, что «построил машину для моделирования обучения с помощью нейронных сетей», причём это была «не пустая болтовня», Мински настолько впечатлил Шеннона, фон Неймана и Норберта Винера, что они совместно рекомендовали его на должность в Гарварде. Последний из группы, Натаниэль Рочестер, был старшим инженером IBM и её менеджером по информационным исследованиям, управлял первым коммерческим научным компьютером от IBM. Кроме чисто управленческих функций Рочестер написал первый ассемблер в 1951 году, а к началу конференции работал над моделированием нейронных сетей.

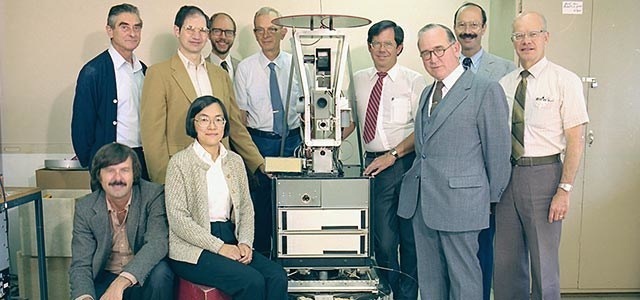

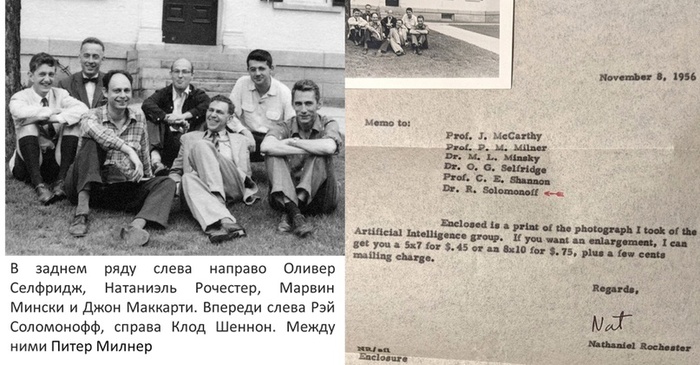

У фото, которое вы видите выше, необычная история. Его нередко можно было встретить без упоминания Питера Милнера, который указывался просто как «один неизвестный». Дело в том, что его специализация существенно отличалась от остальных первопроходцев в ИИ. В своей книге 1999 года он прямо писал: «Меня пригласили на встречу компьютерных учёных и теоретиков информации в Дартмутском колледже. Большую часть времени я понятия не имел, о чём они говорят!» При этом работы самого Милнера сильно повлияли на раннее развитие искусственных нейронных сетей, ввиду чего он был приглашён на встречу совершенно заслуженно. Среди учёных существовал огромный интерес к изучению мозга и нейронов для воспроизведения функций и интеллекта.

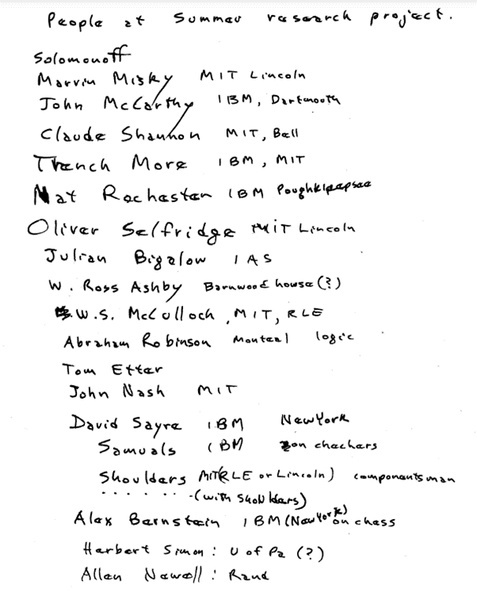

Список участников, который сохранил Рей Соломонофф, фамилии узнаваемы, учреждения, которые представляют учёные, – тоже

В некотором роде это было уникальное собрание. Это не был классический исследовательский проект, у которого есть цель, задачи, некоторая структура. Это был огромный мозговой штурм, позволим себе назвать сие собрание «научным шабашем», который собрал весьма влиятельную плеяду специалистов. Вместо изначальных 10 учёных было 20 человек, которые прибывали на разные сроки, в основном небольшие.

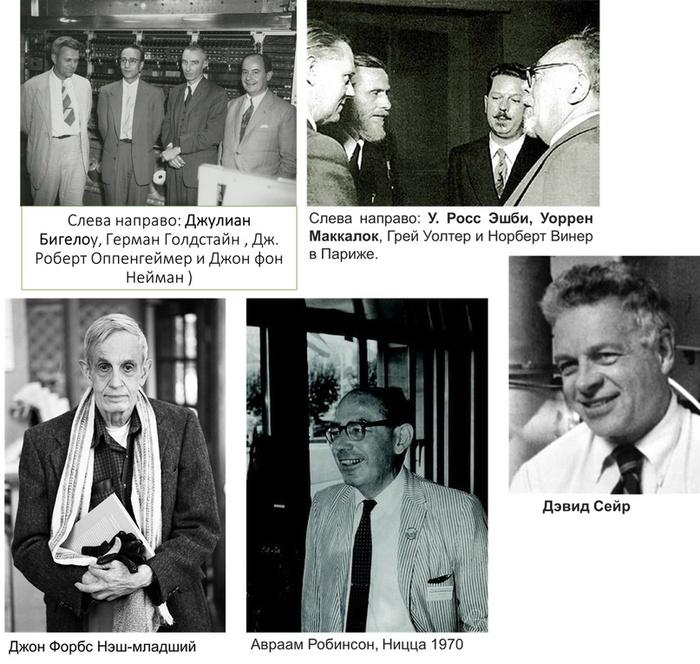

Рэй Соломонофф вёл записки, они оцифрованы, благодаря им у нас есть ещё и полный список участников, т. к. свою копию Джон Маккарти умудрился потерять. Мы не смогли найти общее изображение участников встречи одновременно, так что попытаемся создать для наглядности несколько коллажей, которые охватят их всех.

Вторая достаточно известная проблема с фотографиями, когда вместо Тренчарда Мора (крайний портрет в нижнем правом углу на фотографии), размещают совершенно иного человека, в лучшем случае это будет Питер Милнер с первой групповой фотографии, в худшем – Луи Тренчард Мор, умерший больше чем за десятилетие до проведения собрания.

К сожалению, путанице неплохо так помог фильм от нетфликс «Закодированная предвзятость», куда закралась ошибка с определением личностей, и заметить которую смог только лично присутствовавший там Рей Соломонофф (о чём подробно написал у себя на странице, за что мы ему благодарны). Соломонофф, Мински и Маккарти – три человека, которые провели на «сборах» всё время проведения мозгового штурма.

Пытаться описывать процесс хаотичного общения гениальных учёных между собой – идея, которая обречена на провал. Сам Маккарти был очень пессиместичен и в 1979 году написал о своём детище: «Все, кто там был, были упрямы в стремлении следовать своим идеям, которые были ранее. Никакого реального обмена идеями не было. Люди приезжали на разные периоды времени, хотя изначальная идея строилась на том, что все согласятся приехать на шесть недель. Для меня это было большим разочарованием, потому что это действительно означало, что мы не могли проводить регулярные встречи.

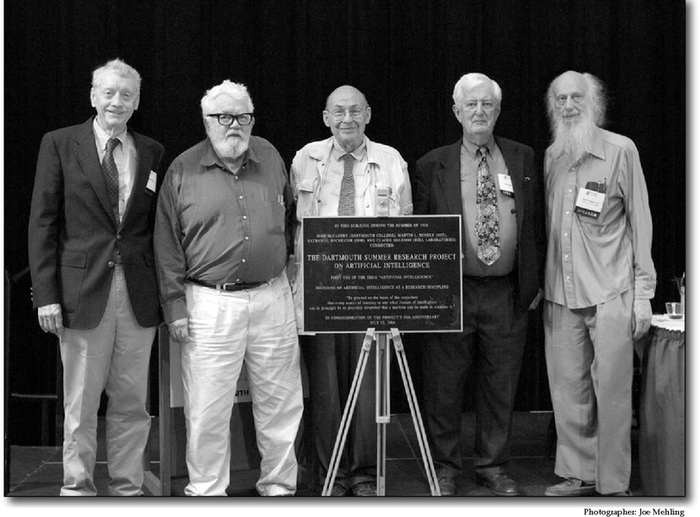

Пятеро участников конференции AI@50 в 2006 году, которые были участниками Дартмутского лета 1956 года: Тренчард Мор, Джон Маккарти, Марвин Мински, Оливер Селфридж, Рэй Соломонофф

❯ Краткие итоги, новые начала

Помните, что я говорил о молодом Маккарти, который болезненно переживал собственные (частично выдуманные) ошибки? Взрослый и серьёзный учёный от этого так до конца и не избавился.

При всём пессимизме Маккарти, как минимум появился сам термин «искусственный интеллект», который стал прямым результатом проведения конференции. Кроме того, в самый короткий срок после проведения мероприятия были созданы работы Ньюэлла, Шоу и Саймона по обработке информации (IPL) и их логико-теоретической машине (Moor, 2006).

Артур Сэмюэль в 1959 году ввёл термин «машинное обучение» и создал программу Samuel Checkers-playing, одну из первых в мире успешных программ самообучения. Селфриджа теперь часто называют «отцом машинного восприятия» за его исследования в области распознавания образов. Мы несколько забежим вперёд, но Мински получит премию Тьюринга в 1969 году за «центральную роль в создании, формировании, продвижении и развитии в области искусственного интеллекта». Ньюэлл и Саймон получили ту же премию в 1975 году за вклад в «искусственный интеллект и психологию человеческого познания». Во всех этих достижениях виден след встречи, о которой вспоминали практически все учёные, принявшие в ней участие.

Данная научная встреча не просто так вызывала столь много внимания, это была ступень, после которой изучение искусственного интеллекта было уже не остановить. И создал эту ступень Джон Маккарти, что бы он сам по этому поводу ни думал.

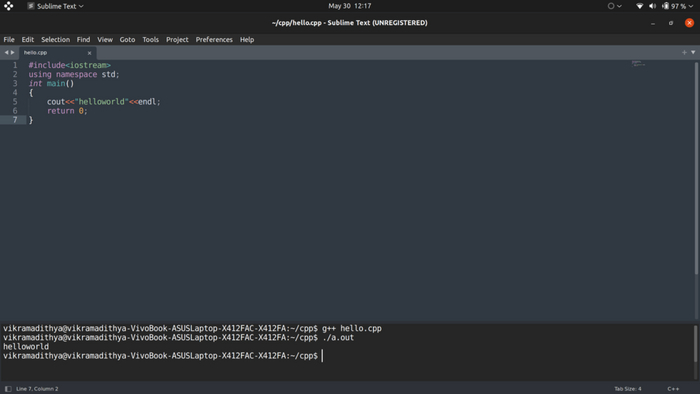

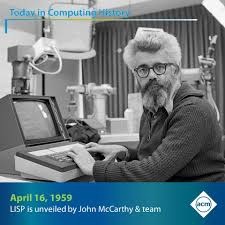

В том же 1958 году по итогам прошедшего мероприятия началась разработка ещё одной вехи периода искусственного интеллекта – языка программирования LISP (англ. List Processing language — «язык обработки списков»). Не станем подробно говорить о технической сути языка, на хабре есть соответствующая статья, ему посвящённая, отсылаем всех туда. Кроме того, есть статья самого Джона Маккарти от 1980 года «LISP – Заметки о прошлом и будущем». В этот же период он участвует в разработке Algol 60 и вносит в язык рекурсию и условные выражения.

Активная разработка LISP началась по окончании конференции, когда Маккарти, Ньюэлл, Сайман и Мински вдоволь наобщались. Маккарти взял у них идею обработки списков, однако они использовали язык IPL, который Маккарти иначе как «ужасным» не называл. Но другие господа не собирались от него отказываться. Не собирались, но отказались, ведь прогресс не стоит на месте. LISP взял у них идею обработки списков, а затем для формы языка взял в качестве модели Fortran. Кроме этого, появляется сборщик мусора, существенно облегчающий работу.

В 1959 году Джон Маккарти написал отчёт, в котором показывал LISP как универсальное вычислительное средство. Для этого он провёл сравнение с машиной Тьюринга, описание которой состояло из шести страниц текста, в то время как сам Маккарти управился в несколько строк.

❯ Как давать советы машине?

В этом маленьком промежутке 1958–1959 годов была создана и опубликована статья «Programs with Common Sense» [полный текст статьи доступен благодаря сайту Джона Маккарти]. Это была одна из первых попыток научить программу понимать математическую логику. Маккарти считал, что возможно давать советы программе, рассказывая о символическом окружении и том результате, который требуется. Для этого нужно научить программу широкому перечню непосредственных логических следствий всего, что ему говорят, и его предыдущих знаний. Ожидается, что это свойство будет иметь много общего с тем, что заставляет нас описывать некоторых людей, как обладающих здравым смыслом. «Поэтому мы будем говорить, что программа обладает здравым смыслом, если она автоматически выводит для себя достаточно широкий класс непосредственных следствий всего, что ей говорят, и того, что она уже знает».

Параллельно Маккарти работал над концепцией букв, в которой он существенно не соглашался с книгой Джерома Брунера «Исследование мышления». Ему не нравилось само понятие «концепции». Маккарти пытался обработать концепцию форм букв: выпуклая ли она? Есть ли в ней отверстие. Через огромный комплекс элементарных концепций можно было бы совершить необходимое множество элементарных комбинаций и создать алфавит, который можно обрабатывать. Однако это требует существенного теоретического понимания, ведь если взять букву, которая состоит из отрезка и трёх других отрезков, перпендикулярных первому, получиться может и заглавная буква «Е», и русская буква «Ш», различия будут лишь в угле поворота. Поэтому идея Маккарти может быть сведена к следующему: «Описание, а не дискриминация». Нужно не манипулировать имеющимися объектами, а максимально описывать те, которые требуются. Без этого не может быть работы робототехники, не может быть эксперимента. Хотя до активного включения в робототехнику ещё осталось несколько лет.

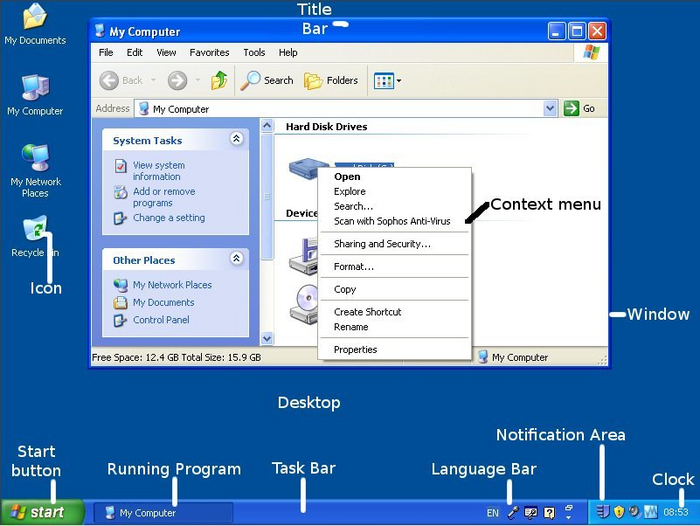

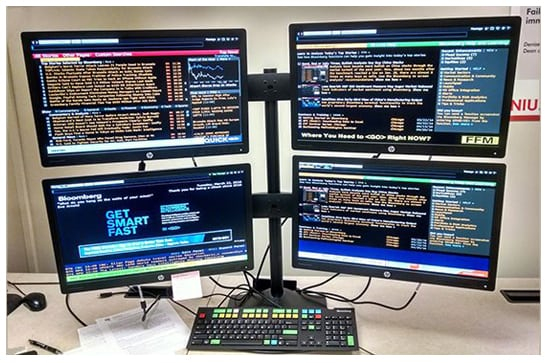

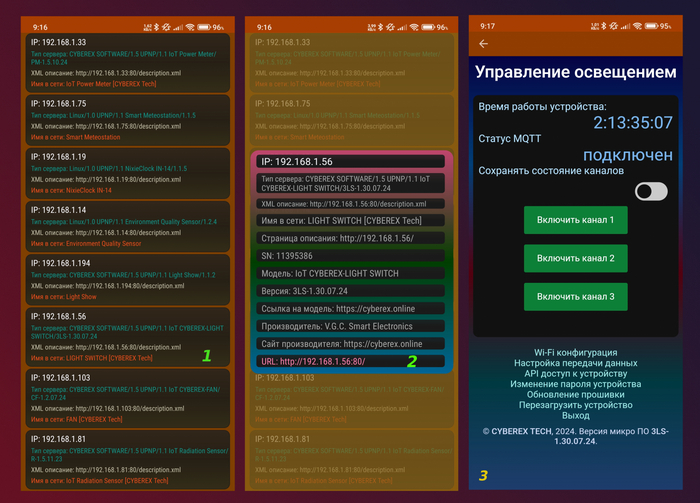

❯ Система разделения времени

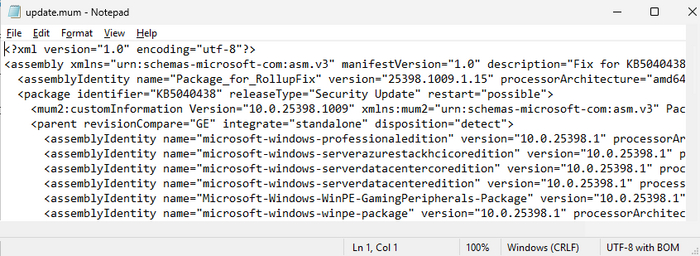

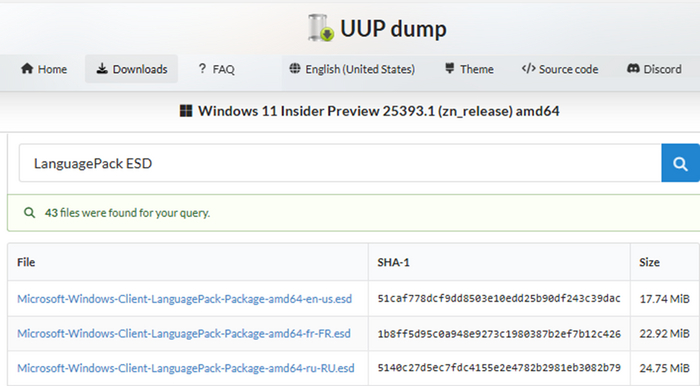

В конце 1950-х гг. компьютеры становились существенно мощнее, но оставались при этом невероятно дорогими устройствами. Для предоставления возможности к равноценному использованию мощностей Джоном Маккарти была предложена система Compatible Time-Sharing System. Принял участие Джон и в создании BBN Time-Sharing System. Этот уникальный человек участвовал в разработке всех трёх первых систем разделения времени, в дальнейшем они перешли к облачным вычислениям. Джон инициировал эти разработки на самом раннем этапе.

Меморандум о системе разделения времени, созданный Джоном Маккарти. Полный текст меморандума доступен по ссылке [англоязычный материал]

При этом коллега Маккарти Фредкин говорил о том, что разделение времени вполне может быть реализовано даже на самом небольшом компьютере, например RDP-1: «Изобретение Джоном разделения времени и то, как он рассказывал мне о своих идеях, произошло до того, как появился PDP-1. Когда я впервые увидел PDP-1 на Восточной объединённой компьютерной конференции, я понял, что это идеальное недорогое средство для реализации идей Джона».

❯ Создание лаборатории искусственного интеллекта Массачусетского технологического института

Следующим шагом на пути неостановимого Маккарти стало создание Лаборатории искусственного интеллекта Массачусетского технологического института. О её создании Джон вспоминал весьма красноречиво, попробую передать вам этот эпохальный диалог в пересказе самого Маккарти. Обращаю ваше внимание, что Джон несколько иронизировал, допуская, что он не до конца достоверно передаёт ситуацию.

Джон Маккарти (встречая в коридоре института своего товарища Марвина Мински): «Марвин! Нам нужна лаборатория для изучения искусственного интеллекта!».

Марвин Мински: «Джон, это чертовски хорошая идея! Надо её реализовать!».

Джон Маккарти: (встречая в том же коридоре Джерри Визнера, который был главой Исследовательской лаборатории электроники): «Эй, Джерри! Марвин и я хотим иметь лабораторию искусственного интеллекта!».

Джерри Визнер: «Хорошо. Что вам нужно?».

Джон Маккарти: «Нам нужна комната, и секретарь, и перфоратор, и два программиста».

Джерри Визнер: «А как насчет шести аспирантов?».

Джон Маккарти, Марвин Мински: «Да».

Джерри Визнер: «Договорились, у вас будет ваша лаборатория».

Сей перфоманс был связан с тем, что непосредственно в тот момент MIT получил очень хороший контракт от Joint Services, и у организации были хорошие финансовые возможности. Денежные потоки делились между отделами свободно, а у «математиков» появилась потребность пристроить шестерых аспирантов для работы. Фактически случилось чудо, и Мински с Маккарти просто пришли и отобрали организационный вопрос у Джерри Визнера, который пытался придумать, как ему распределить неожиданно свалившиеся ресурсы. Джон Маккарти позже будет вспоминать, что такой подход его откровенно разбаловал.

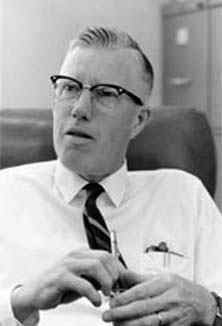

В 1962 году Маккарти с некоторым приключением возвращается в Стэнфорд. В тот момент он бы доцентом кафедры коммуникационных наук на кафедре электротехники. Научная деятельность шла своим чередом, и совершенно неожиданно Джону Маккарти позвонил Джордж Форсайт из Стэнфорда. Этот человек был пионером компьютерной науки, подготовив 17 докторов наук, известных под названием «плеяда Форсайта», каждый из которых тоже подготовил множество выдающихся учёных.

Просто отказать такому человеку Маккарти не мог и сказал, что вернётся в Стенфорд только профессором. И это через год после того, как Маккарти стал доцентом. Наглость? Наглость! Но ведь это был лишь «вежливый отказ», Джон не думал о том, что его заберут. Но Маккарти был нужен Форсайту! Форсайт хотел свою кафедру компьютерных наук. При этом, как позже узнал Джон, Форсайт не был знаком с его научной деятельностью, они были из «разных сфер», но Маккарти сформировал свою репутацию, и она стала приносить деньги! Чертовски большие деньги!

Между Стэнфордом и MIT развернулась целая борьба за будущего профессора. MIT готов был поднять зарплату с 9 до 15 тысяч долларов, но не был готов дать Маккарти должность профессора, не предоставив такую же должность его товарищу Мински, с которыми их ставили в одну научную связку даже с учётом того, что они работали на разных факультетах. MIT даже готов был поднять Маккарти в должности до директора по исследованиям на факультете компьютерных наук, но, как вспомнит Джон, он чертовски не любил расчищать снег на подъездной дорожке и решил уехать в Стэнфорд, приняв их приглашение.

Новый отдел был достаточно солидным, хоть и небольшим. Сам Форсайт – числовой аналитик. Джон Маккарти, ещё один аналитик Джин Голуб. Вместе с ними был «монстр» научной деятельности в сфере информатики – Дональд Эрвин Кнут, которого тоже убедили перейти в Стенфорд, его «искусство программирования» уже в процессе.

На дворе был 1962 год, с тех пор до своего выхода на пенсию в 2000 году Джон Маккарти больше не покидал Стенфорд. Особым его достижением стало создание Стэнфордской лаборатории искусственного интеллекта, она же SAIL.

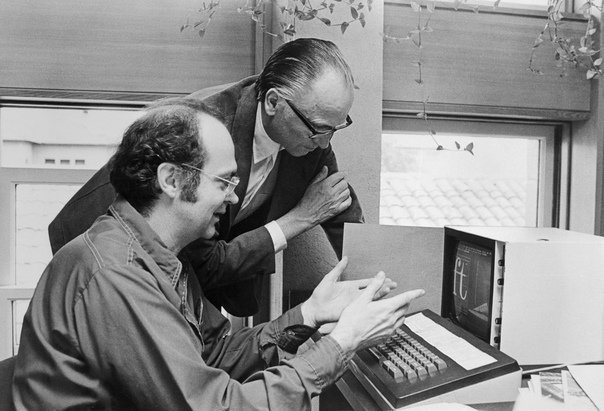

Работа этой лаборатории была связана с целым рядом компьютерных систем и новейшими достижениями робототехники. Началось всё с того, что Джон Маккарти работал над компьютером PDP-1, занимался разработкой системы разделения времени для BBN, о чём вы уже знаете. Маккарти запросил денег на создание лаборатории робототехники имея описания необходимых ему действий. Он стремился получить компьютер PDP-6, не будучи удовлетворённым компьютером PDP-1, и свою технику получил, вместе с новыми возможностями.

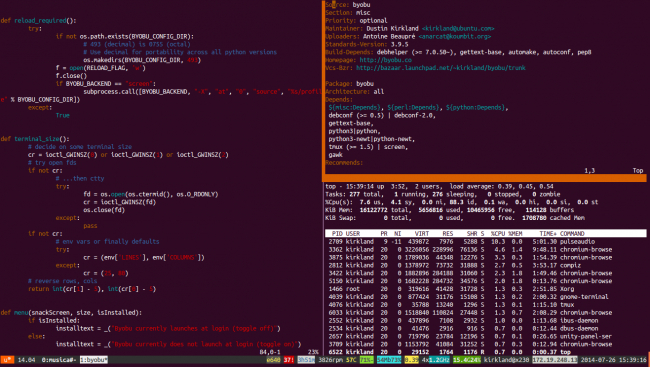

❯ Компьютерная партия Коток-Маккарти

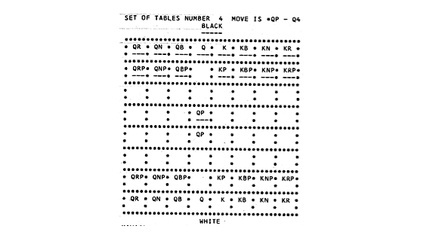

Из «Программы игры в шахматы для компьютера IBM 7090», дипломной работы Алана Котока, научный руководитель Джон Маккарти, Массачусетский технологический институт, 1962 г

Прежде чем перейти к работе лаборатории, нужно уделить внимание проекту который длился с 1959 по 1962 годы.

Это была одна из первых компьютерных программ для игры в шахматы, известная также под названием A Chess Playing Program for the IBM 7090 Compute. Эта программа известна тем, что играла свой первый матч между двумя компьютерными программами и проиграла его. Эту программу написала группа аспирантов Джона Маккарти: Элвин Берлекамп, Алан Коток , Майкл Либерман, Чарльз Ниссен и Роберт А. Вагнер. Они добавили альфа-бета-обрезку к minmax по предложению Маккарти, чтобы улучшить генератор правдоподобных ходов, и к 1962 году, когда закончили свою учёбу, смогли научить программу играть на уровне, «сравнимом с любителем, имеющим опыт около 100 игр».

В 1965 году Джон Маккарти посещает СССР и знакомится с компьютером М-2, в лаборатории Александра Кронрода в Московском институте теоретической и экспериментальной физики (ИТЭФ). Между компьютерами была начата шахматная партия по переписке. Советская сторона выиграла матч по переписке , который проводился по телеграфу в течение девяти месяцев в 1966-1967 годах. Программа Котока-Маккарти проиграла матч со счетом три к одному. Через год после игры Александр Кронрод потеряет свою должность (по одной из версий) из-за жалоб на то, что компьютерные ресурсы используются для создания игры. Возможно, «письмо 99» несколько ближе к его проблемам, но это точно другая история.

Маккарти же «свою» партию в шахматы выиграл и продолжил руководить своей лабораторией.

❯ Чем занималась лаборатория?

Синтезировала интеллект из видных учёных. Простите за каламбур, но ответить на такой простой вопрос достаточно сложно. Логичнее всего будет сказать, что она стала точкой концентрации широкого рода научной деятельности, важнейшим из которых стала робототехника. Там ковались именитые учёные. Например, Виктор Шейнман.

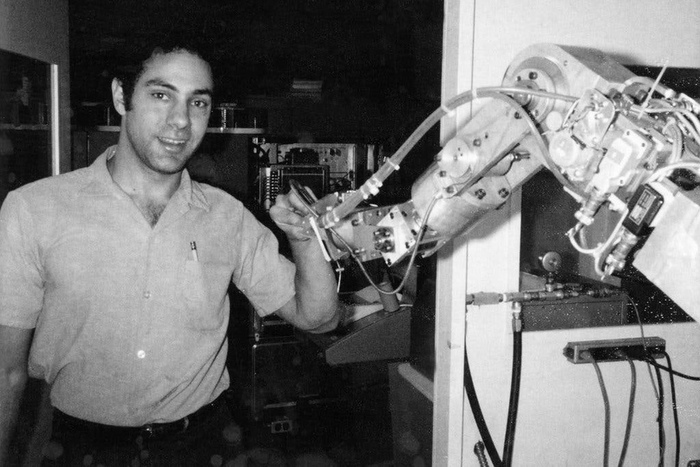

В 1962 году на базе исследовательской лаборатории началось создание робота. Изначально Маккарти хотел «полного» робота, но очень быстро понял, что ресурсы не позволяют в ближайшем будущем создать механически или программно полного робота. И интерес был перенесён на руку. В тот момент в лаборатории работал аспирант Виктор Шейнман, которого Маккарти именовал «гением». Он занимался проектированием механических рук. В 1965 году лаборатория купила компьютер PDP-6, после чего началось активное сотрудничество с Шейнманом. Удивительно, но роботизированные руки, которые изготавливались во время Второй Мировой войны, оказались никому не нужными, Джон вспоминал, что их просто бросили, и лаборатория начала полностью собственные разработки.

Первая рука, созданная Виктором, была гидравлической, пластиковые трубки под высоким давлением имели шанс создать полноценное орудие убийства в случае аварии. Из-за этого рукой никогда не пользовались, для неё было построено небольшое строение на территории. А использовались руки более слабые и намного более маленькие, которые работали на электричестве. При этом финансирование на них выбивал Маккарти. Первая рука была настолько сложной в управлении, что профессор Дональд Пипер в докторской диссертации назвал её целью «разбивание вещей» и рекомендовал определённые конфигурации связей, которые позволили бы упростить решения для руки.

В 1969 году была создана знаменитая Рука Стэнфорда, полностью электрическая, шестиосевой промышленный робот. Как и предрекал Дональд Пипер, робот существенно расширил сферу своего применения. Под управлением компьютера он научился следовать произвольным траекториям и освоил элементы сборки и дуговой сварки, он имел три оси запястья и тормоза на каждой оси, что облегчило управление при помощи компьютера с разделением времени. Шейнман создавал свои руки для других научных учреждений, среди которых Бостонский университет, SRI, MIT и т. д. Шейнман продолжал заниматься машиностроением вплоть до своей смерти.

❯ Shakey the Robot

В лаборатории было создано множество по-настоящему прогрессивных роботов, каждому из которых можно посвятить отдельную статью. Например, робот Шейки. На хабре есть про него достаточно подробная статья. Кроме того, имеется качественный видеоролик, основанный на архивных материалах, который мы также рекомендуем посмотреть, не углубляясь в тонкости робототехники.

Чарльз Розен, Питер Харт, Нил Нильссон - создатели робота. Мы настоятельно советуем ознакомиться с видеороликом, прикреплённым ниже, о создании этой удивительной машины

Оригинальный видеоролик, с качественным архивным материалом, посвящённый созданию робота

Shakey показал, что фантастика не так уж далека от реальности. Во-первых, в отличие от Unimate, Shakey мог двигаться. Во-вторых, там, где Unimate должен был быть предварительно запрограммирован для выполнения определённой задачи, Shakey мог выполнять задачи, которые требовали от него динамического планирования, поиска маршрута и перестановки простых объектов. В-третьих, в отличие от Unimate, который не имел взаимодействия за пределами программистов, Shakey мог понимать около 100 слов письменного английского языка. Он переводил эти команды в код, так что непрограммисты могли заставить Shakey выполнить какую-то работу...

ЧИТАТЬ ДАЛЕЕ ↩ (без регистрации и СМС)

Материал получился достаточно объемным и все подробности, к сожалению, не влезли :(

Написано специально для Timeweb Cloud и читателей Пикабу. Больше интересных статей и новостей в нашем блоге на Хабре и телеграм-канале.

Хочешь стать автором (или уже состоявшийся автор) и есть, чем интересным поделиться в рамках наших блогов — пиши сюда.

Облачные сервисы Timeweb Cloud — это реферальная ссылка, которая может помочь поддержать авторские проекты.

![Меморандум о системе разделения времени, созданный Джоном Маккарти. <a href="https://pikabu.ru/story/iskusstvennyiy_intellekt_dzhona_makkarti_11775533?u=http%3A%2F%2Fjmc.stanford.edu%2Fcomputing-science%2Ftimesharing-memo.html&t=%D0%9F%D0%BE%D0%BB%D0%BD%D1%8B%D0%B9%20%D1%82%D0%B5%D0%BA%D1%81%D1%82%20%D0%BC%D0%B5%D0%BC%D0%BE%D1%80%D0%B0%D0%BD%D0%B4%D1%83%D0%BC%D0%B0%20%D0%B4%D0%BE%D1%81%D1%82%D1%83%D0%BF%D0%B5%D0%BD%20%D0%BF%D0%BE%20%D1%81%D1%81%D1%8B%D0%BB%D0%BA%D0%B5%20%5B%D0%B0%D0%BD%D0%B3%D0%BB%D0%BE%D1%8F%D0%B7%D1%8B%D1%87%D0%BD%D1%8B%D0%B9%20%D0%BC%D0%B0%D1%82%D0%B5%D1%80%D0%B8%D0%B0%D0%BB%5D&h=e41c9282067c004d0edf4ed08b736a884a29892e" title="http://jmc.stanford.edu/computing-science/timesharing-memo.html" target="_blank" rel="nofollow noopener">Полный текст меморандума доступен по ссылке [англоязычный материал]</a>](https://cs15.pikabu.ru/post_img/2024/09/04/7/1725446868296587143.jpg)