В этой статье мы узнаем, почему преступники и бизнесмены мыслят похожими категориями. Я расскажу, как экономисты оправдывают злодеев, и почему обществу выгодно, чтобы совершались преступления. А главное — как же эффективно бороться с криминалом? Спойлер — полиция тут не при чем.

С древних времен большинство людей сходилось во мнении, что преступники — это девианты, у которых не все в порядке с головой. Но в 1968 году экономисты предложили взглянуть на эту проблему иначе. Что если корыстные преступления (кража, грабежи, отмывание денег и т. д.) совершаются с холодным расчетом и на трезвую голову?

Возможно, самый известный пример корыстного преступника в мире. Конкуренцию ему сегодня может составить только персонаж с последней картинки в этой статье

То есть, человек вполне рационально размышляет, как можно больше заработать – продавая бытовую технику в сетевом магазине или пряча закладки. Если преступная занятость выглядит перспективнее, то человек «устраивается» на соответствующую криминальную профессию. Вкратце, вот как сегментирован рынок такого труда.

Человек, который решил заняться криминалом, но при этом закончил девять классов, займется грабежами и кражами, потому что он больше ничего и не умеет. А вот «белые воротнички» запустят более рентабельные проекты – организуют финансовую пирамиду, увлекутся инсайдерской торговлей или просто поуклоняются от налогов.

Термин «беловоротничковая преступность» был придуман в 1930-х годах социологом Эдвином Сазерлендом, чтобы привлечь внимание к преступлениям, которые совершают высокообразованные люди на серьезных должностях.

В общем, на криминальном рынке труда образование тоже решает, да еще как. Однако если бы все было так примитивно, то половина офис-менеджеров прямо сейчас переметнулась бы в даркнет, искать криминальные вакансии. Почему же большинство из нас, все-таки, работает законно?

Палка о двух концах

Главный стимул, который заставляет нас вести послушный образ жизни – наказание за нарушение правил, а точнее – вероятность наказания и его тяжесть. Причем для большинства преступников сильным сдерживающим фактором будет именно высокая вероятность поимки, а не тяжесть наказания. Ведь когда человек знает, что он в любом случае будет наказан, то ему не надо грозить многолетним лишением свободы, он и так десять раз подумает, стоит ли брать взятку и давать откаты.

Уверен, кто-то скажет – зачем вообще лишать преступников свободы, пусть они платят штрафы или, в крайнем случае, метут улицы. Тогда их наказание пойдет на благо общества. Но проблема в том, что уравниловка здесь работает очень плохо. У разных преступников разные ценности. Образованные и обеспеченные нарушители, те, что строят финансовые пирамиды, больше всего ценят именно время. Штраф для них – как слону дробина.

Думаю, главе финансовой пирамиды Finiko потенциальный штраф был до одного места. Еще бы, когда твоя организация на пике собрала с «партнеров» 5 млрд рублей

Поэтому для преступников в белых воротничках самым страшным наказанием будет лишение свободы. А вот некоторые рецидивисты вовсе не прочь провести время в колонии — там они поживут на наши налоги и подтянут нетворкинг за время отсидки.

Все коту масленица

Но ведь согласитесь, какие бы ни были наказания, всегда найдутся люди, которые будут нарушать закон. При этом, результаты многих исследований показывают, что средний ожидаемый криминальный доход, как выигрыш в казино – величина с отрицательным математическим ожиданием. То есть, средний преступник всегда будет в минусе. А раз так, то разве можно говорить, что преступники рациональны?

На самом деле, можно. Ведь и в повседневной жизни кто-то закладывает дом, чтобы взять кредит на реализацию своей бизнес-идеи, а кто-то всю жизнь сидит на низкооплачиваемой работе.

Примерно так и сделал нидерландский дизайнер Хэнк Роджерс. Взял кредит под залог дома на распространение советской игры Тетрис в 1988 году. Отчаянный парень

Получается, что выбор преступного пути сродни открытию стартапа. Не факт, что выгорит, но если получится, то можно срубить кучу денег. Как тогда повлиять на этих рискованных ребят, которые постоянно ищут, что плохо приколочено?

Синяя таблетка vs красная таблетка

Теоретически преступность можно срезать под корень, если бросить все ресурсы общества на борьбу с ней. Но чем сильнее защита правопорядка, тем большее давление испытывают нормальные законопослушные граждане. Они не только содержат за счет налогов армию сил правопорядка, но чувствуют себя как на ладони. Уже представили это бескомпромиссное полицейское государство? Очевидно, что полностью победить преступность можно только в тоталитарном антиутопическом обществе, но, думаю, никто из вас не согласится заплатить за безопасность такую цену.

С другой стороны, бороться с преступность необходимо, потому что никто не хочет везти деньги в страну, где чувствуешь себя в опасности, а это – недополученные инвестиции и упущенный экономический рост. Ущерб от преступности для российского общества оценивается ежегодно в сотни миллиардов рублей, а каждое преступление фактически забирает у человека из кошелька 135 тысяч рублей.

Получается, что, общество ставит на одну чашу весов ущерб от преступности, а на другую – борьбу с ней. Если мы увеличиваем расходы на борьбу с преступностью, то остается меньше денег на образование, пенсии, здравоохранение и иную социалку, а люди чувствуют напряжение. Если не тратим деньги на борьбу с криминалом, то общество скатывается в хаос. Что же важнее?

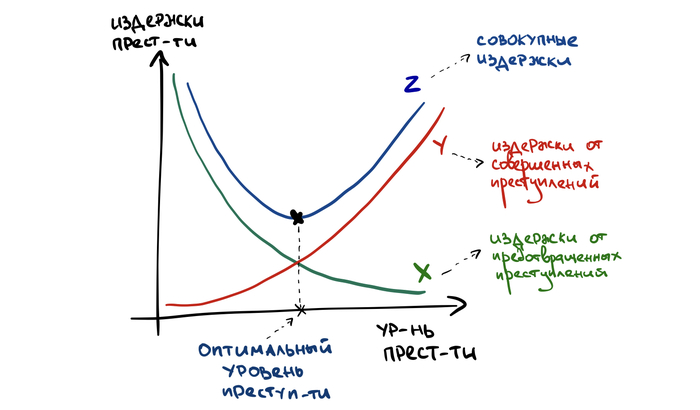

Полностью искоренять преступность невыгодно. Надо найти приемлемый уровень, который несет наименьшие издержки для общества

На самом деле, чтобы минимизировать потери от преступности, общество должно принять некий оптимальный ненулевой уровень криминала. В этой точке расходы на от совершенных преступлений и расходы на борьбу с ними минимизируются. Такой вот парадокс. Но как же тогда бороться с тем, что нельзя победить?

Если не можешь побороть – возглавь?

Спорная тактика состоит в том, чтобы вывести из тени некоторые виды преступлений. Легализуй проституцию, легкие наркотики и тогда все останутся в плюсе – госбюджет получит кучу денег, а грустные преступники пойдут работать на заводы.

Но в жизни так не происходит, потому что чем дольше человек занимается какой-то профессиональной деятельностью, тем сложнее ему сменить род занятий. Это как попытаться уйти в IT после месячных курсов, когда ты тридцать лет проработал учителем литературы. Попробовать конечно можно, но я бы не рекомендовал повторять это в домашних условиях.

Поэтому, когда легализуют какую-то сферу криминального бизнеса, преступники не бросают противозаконную работу. Они меняют квалификацию. Поэтому вначале уровень преступности действительно снижается – возникает криминальная безработица. Но со временем нарушители адаптируются и берутся за хорошо забытое старое.

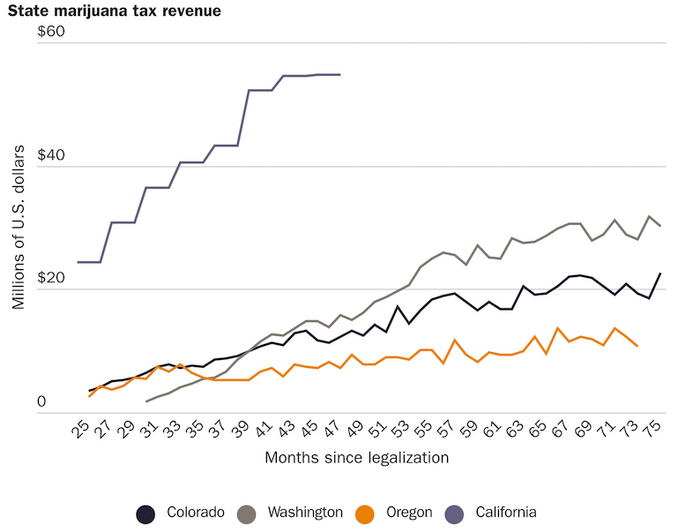

Хороший тому пример – последствия легализации каннабиноидов в некоторых штатах Америки. Когда картели поняли, что поставки легких наркотиков больше не приносят прибыли, они просто переключили свои логистические цепочки на другие, более тяжелые наркотики.

Как увеличивались доходы американских штатов от продажи марихуаны после ее легализации. Можно предположить, что теневые доходы от этого бизнеса снижались пропорционально

Ты наконец скажешь, что делать, или нет?

Корень проблемы корыстной преступности лежит намного глубже, чем неудачные решения политиков и нехватка ресурсов правоохранителей. Дело в том, что современное общество ставит перед людьми одинаковые цели: престижная работа, большая семья, роскошный дом, люксовый автомобиль, а лучше два. Но у всех нас разные возможности в достижении этих целей.

Перед человеком висит морковка, которую он не может получить законным путем. И человек с умеренной склонностью к риску играет по правилам, а человек толерантный к риску в определенных ситуациях становится преступником. Чем сильнее разрыв между желаемым и действительным, чем больше неравенство между людьми и чем хуже работают социальные институты, тем больше людей будет нарушать законы, которые не дают добиться желаемого.

Кстати, у людей, которые заболевают трудноизлечимой болезнью вероятность совершить преступление возрастает в два раза

Сегодня система образования направлена не на формирование полноценной и всесторонне развитой личности, а на подготовку будущего работника, исполнителя конкретных производственных функций. Институт семьи не выполняет свою роль по воспитанию детей, так как родители часто заняты зарабатыванием денег и решают свои личные проблемы.

Неудивительно, что в этих условиях социальные функции защиты и воспитания начинают выполнять нелегальные институты — преступные группировки, как например, мафия на Сицилии или якудза в Японии.

Материальное благосостояния стало универсальным мерилом успеха, что создает ложные установки такие как «цель оправдывает средства», и вот преступный путь уже не кажется таким аморальным. Поэтому, конечно, можно бороться с преступностью, бесконечно увеличивая бюджеты правоохранительной системы, но это тупиковый путь. Бороться надо не с преступностью, а с глубинными проблемами – бедностью, неравенством и доступностью образования. И тогда уровень преступности снизится сам собой, потому что выбирать криминальную профессию станет не выгодно.

Спасибо, что дочитали до конца. Я постарался интересно и объективно рассказать об экономической теории рациональной преступности. Этот материал также доступен в формате видео. Если статья вам понравилась, буду рад комментариям и подписке на мой канал, где я научно-популярно рассказываю об экономике широкой аудитории.