Должно хватать

Телеграм - Пиксель

Телеграм - Пиксель

Nvidia неожиданно представила нижнебюджетную видеокарту GeForce RTX 5050 — младшую модель в линейке Blackwell. Устройство уже доступно в России, поддерживает все ключевые технологии RTX (включая DLSS 4), и вызывает интерес благодаря привлекательной цене (~30 000 ₽). Ниже — подробности.

Кратко:

Доступная видеокарта начального уровня с 8 ГБ GDDR6, 2560 CUDA-ядер, полной поддержкой тих технологий RTX 50 серии (аппаратный трассинг, DLSS 4 с Multi Frame Generation). В играх 1080p сопоставима по FPS с 50-й серией RTX среднего класса.

Характеристики:

CUDA‑ядра: 2560 (Blackwell GB207 GPU)

Память: 8 ГБ GDDR6, 128‑бит шина, 320 ГБ/с

Boost‑частота: до 2 570 МГц

TDP: около 130 Вт, рекомендуется блок питания от 550 Вт

Подключение: PCIe 5.0 x8, новый 12V–2×6 разъём питания (Backwards-совместимый)

Трассинг и DLSS: RT‑ядра 4-го поколения, Tensor‑ядра 5-го поколения, включает DLSS 4 с Multi Frame Generation

Цена: в России от 28–31 000 ₽ (~$249 MSRP)

Плюсы:

Поддержка всех функций RTX 50‑го поколения: трассинг и DLSS 4

Производительность ~60 % быстрее RTX 3050 и близка к RTX 4060 в 1080p и 1440p

Эффективный выбор для сборки с PSU 550 Вт и ниже — не нужно минимум 650 Вт

Уже доступна в РФ — первые модели MSI и Palit от 28 000 ₽

Минусы:

Отстаёт от RTX 4060 на 3–6 % и уступает GDDR7‑моделям по «сырому» FPS

GDDR6 вместо GDDR7 снижает пропускную способность по сравнению с старшими моделями

MSRP $249 — немного завышена, ~USD199 предпочтительней

Cyberpunk 2077 (1080p, ультра, DLSS 4): ~80 FPS — плавный геймплей и трассинг

Синтетика: на 34 % быстрее, чем RTX 3050; превосходит RTX 3060 на ~11 % в 1080p и ~7 % в 1440p

Сравнение с RTX 4060: отстаёт всего на 3–6 % в тяжелых играх

Согласно тестированию TechPowerUp, видеокарта GeForce RTX 5050 обходит RTX 3050 в среднем на 34% при разрешении 1080p и на 35% в 1440p. Преимущество над RTX 3060 чуть скромнее: порядка 11% в Full HD и около 7% в Quad HD.

По производительности RTX 5050 вплотную приблизилась к RTX 4060. Разница между ними составляет всего 2–3%: в Full HD RTX 5050 отстаёт на 3%, а при 1440p — всего на 2%, что делает её крайне выгодной альтернативой более дорогим решениям.

Стоит ли покупать?

Выбирайте RTX 5050, если:

Хочешь играть в AAA-игры на 1080p при высоких настройках, с поддержкой трассинга и DLSS 4

Имеешь блок питания примерно на 550 Вт — можете собрать ПК без замены PSU

Ищешь дешёвое решение в RTX‑экосистеме — уже можно купить в РФ

Подумать дважды, если:

Ищете максимальный FPS — RTX 4060 обеспечит ~5 % прироста

Вас смущает отсутствие GDDR7 — пропускная способность ниже

MSRP кажется завышенной — желательно дождаться стабилизации цены ближе к ₽25 000

RTX 5050 — лучшее стартовое решение RTX 50 серии: трассинг, DLSS 4, комфортная 1080p‑производительность за ≈30 000 ₽. Это мощный шаг вперёд по сравнению с RTX 3050/3060 и отличный шанс попасть в мир трассинга без лишних трат. Если цена упадёт до уровня $199 (≈25 000 ₽), то это станет ещё более привлекательным вариантом.

💵 Рыночная стоимость NVIDIA впервые превысила 4 трлн $, что сделало её самой дорогой компанией в мире. Её капитализация теперь больше, чем все публичные компании Великобритании вместе взятые.

📈 Акции NVIDIA выросли на 2,76%, до 164,41 $, а её рыночная стоимость достигла 4,02 трлн $. Microsoft 3,74 трлн $ и Apple 3,13 трлн $ занимают второе и третье места.

🤖 Рост связан с бумом ИИ. Крупнейшие клиенты Куртки — Microsoft, Alphabet и Amazon.

#Nvidia #Куртка #ИИ #Дичь

🎙Подписывайтесь на ARCHiTECH

Привет, Пикабу.

Столкнулся с проблемой - при попытке подключить два монитора происходит НЁХ.

Видеокарта 5080. Подключаю в её разъёмы

Первый монитор это именно монитор от LG, подключен через DP, c ним проблем нет, работает штатно.

Вместо второго монитора - телевизор от TCL, подключаю через HDMI 2.1 (кабель новый, хороший, по этому же кабелю подключал монитор - работает штатно, разъём 2.1 на телевизоре присутствует).

Телевизор сам по себе как монитор работает штатно (автоматически переходит в игровой режим, никаких проблем)

как только включаю телек при работающем мониторе - происходит, как я уже сказал, Неведомая Ёбаная Хуйня. Конкретнее: устройства начинают с большой скоростью включаться-выключаться, примерно раз в 3-4 секунды, отбирая управление друг у друга. В настройках дисплея стоит "дублировать мониторы".

Разрешение и частота у монитора и телевизора стоят одинаковые.

что за срань?

на форумах ничего не могу найти - типа проверьте порты, проверьте шлейфы. Нормально всё с портами и шлейфами.

подскажите, пожалуйста , какие ещё варианты.

Привет, читателю!

Около года назад в интернете появились слухи о мистических видеокартах rtx 4090 на 48 гигабайт.

Первое время не был никаких подтверждений того, что это возможно, лишь слухи и скриншоты непонятного качества. Но в какой-то момент мой друг из Китая предложил купить данную видеокарту. Вот тогда - стало интересно, что это и из чего она сделана.

Немного теории - у стандартной карты 4090 всего 24 ГБ памяти:

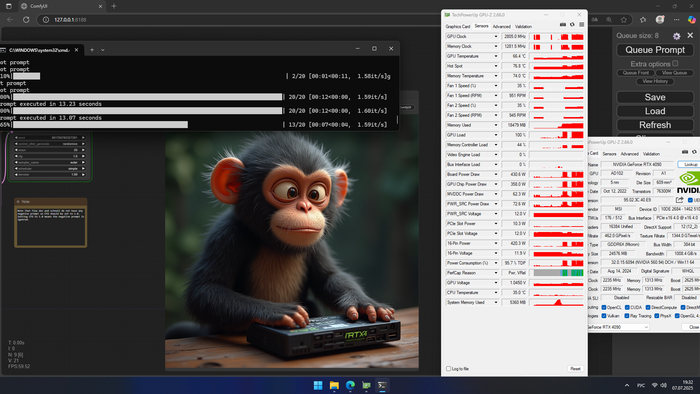

Карта набирает 12639 баллов в суперпозишн, при генерировании изображений выдает около 1.59 итераций в секунду. А сгенерировать 5 картинок у нас получилось за 68 секунд.

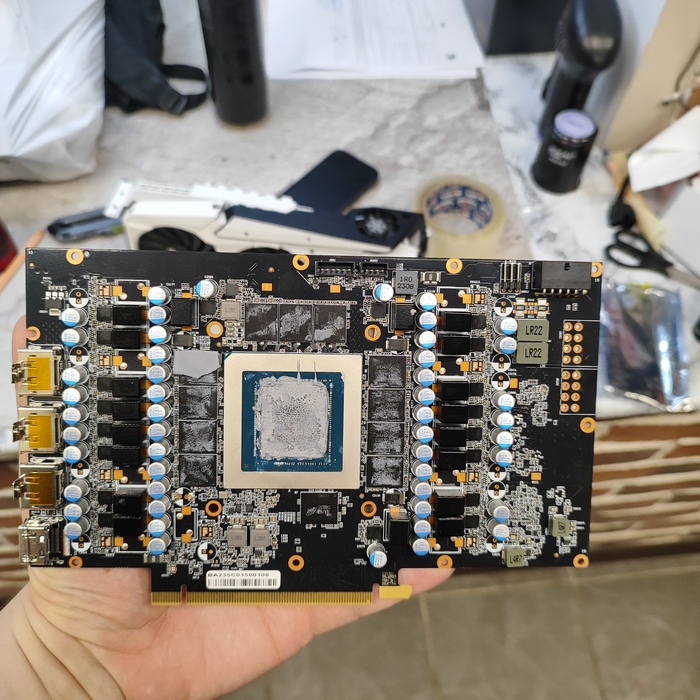

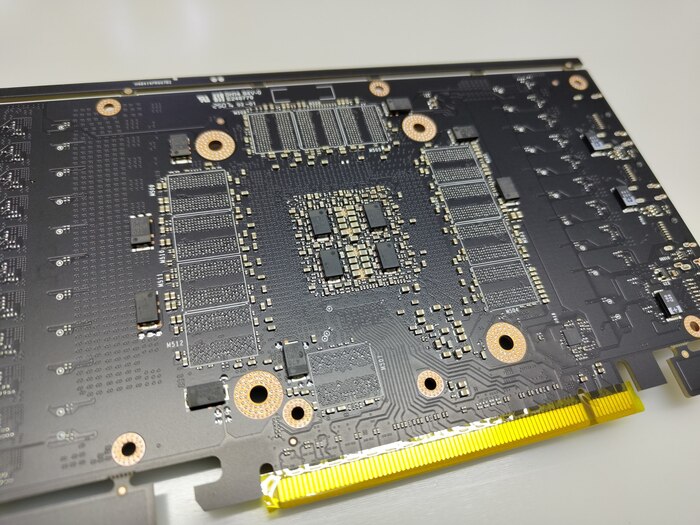

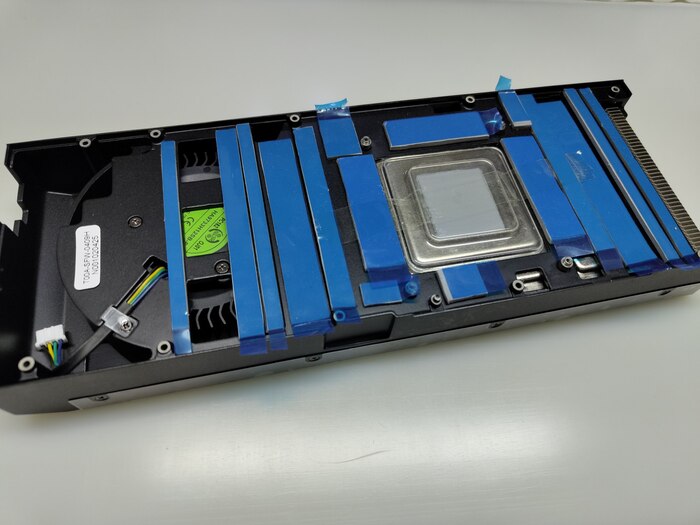

Плата выглядит стандартным образом:

На фото карта палит, но концепция ясна

Спереди расположено "сердце" самой видеокарты - видеочип rtx 4090, ну и 12 чипов памяти, объемом по 2 гб каждый. А сзади, в целом, ничего интересного. Обвязка чипов памяти, фильтры по питанию, прочие элементы, которые не относятся к топику.

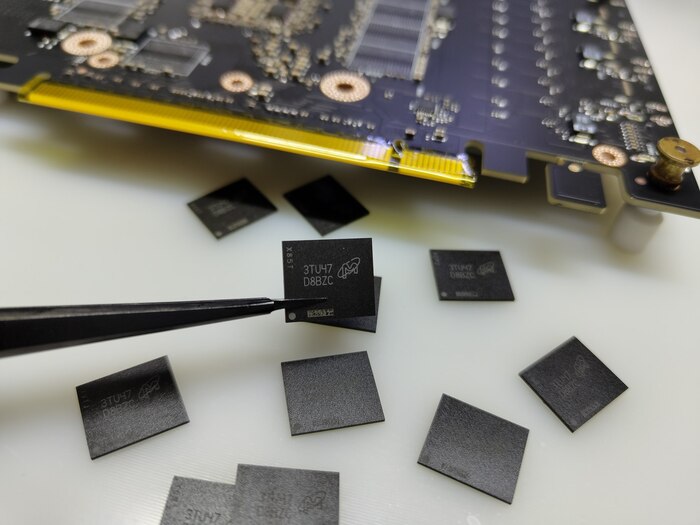

Читатель, который интересуется вопросом спросит - и как же можно поставить сюда память объемом в 48 гб? Ведь тут всего 12 возможных посадочных мест под память. А максимальный объем чипа памяти GDDR6X (только с ними работает чип rtx 4090, сам чип памяти - уникальная разработка Nvidia совместно с компанией Micron) ограничен 2 GB. И объема в 4 GB не существует и не будет существовать (производство gddr6x подходит к своему логическому концу, его заменил новый стандарт памяти GDDR7). А ответ хранится в следующих картинках:

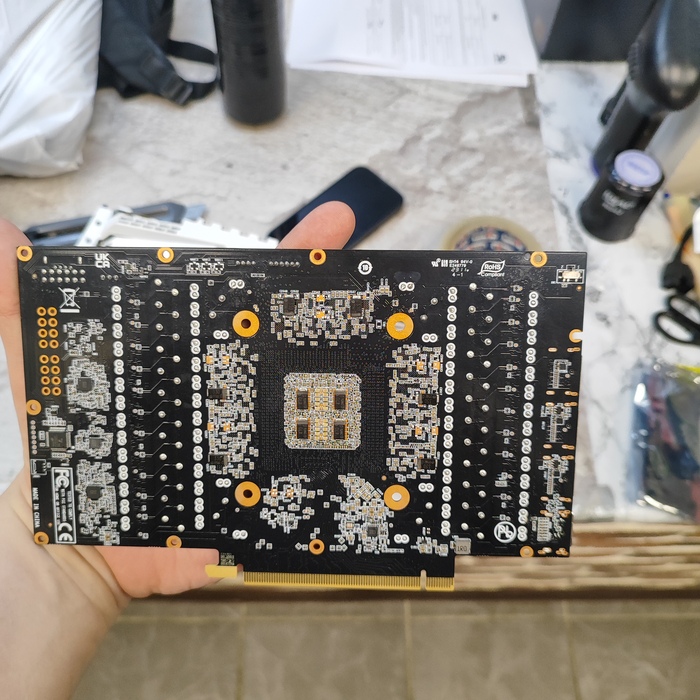

Магическая плата, на которой есть возможность расположить 12 чипов памяти спереди и 12 сзади.

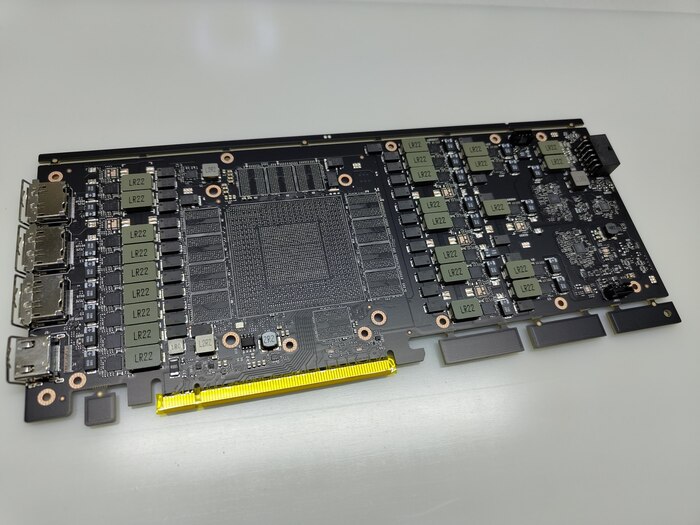

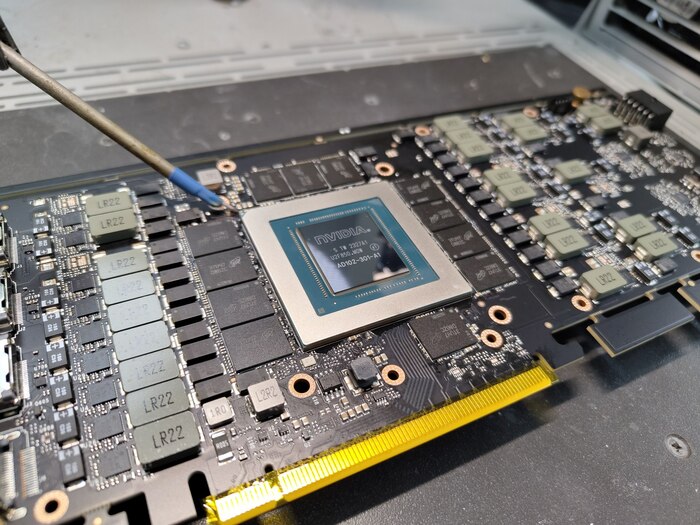

Полностью новые платы, на которые можно поставить гпу от 4090 и 24 чипа памяти, чем мы, собственно, и займемся:

Для этого подготавливаем 24 чипа памяти D8BZC объемом по 2 гб и гпу AD102-301-A1

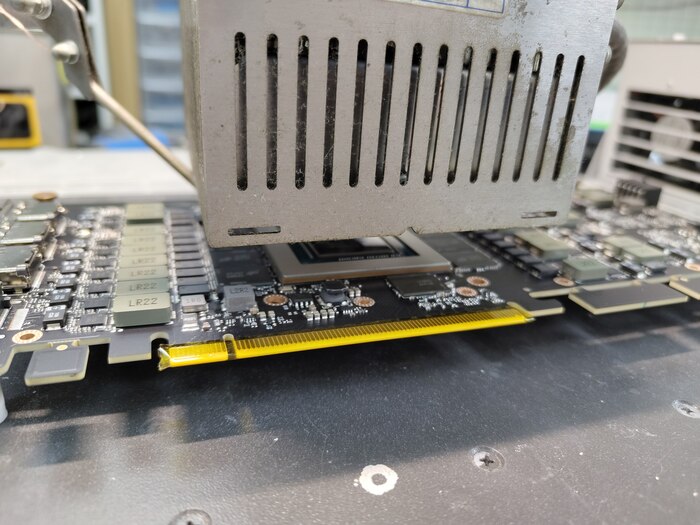

Саму плату полностью зачищаем и подготавливаем к посадке чипов:

А потом и гпу вместе с памятью одновременно

После чего проверяем видеокарту на картинку, которая появилась. И полностью собираем карту:

В системе драйвер поставился без ошибки (никаких специальных драйверов она не требует), все 48 гб памяти определились корректно:

Суперпозишн, ожидаемо, выдал такое же количество баллов (ведь если нет упора в видеопамять - производительность гпу не изменилась). Мониторинг работает верно, отслеживаются обороты турбины, потребление в 450вт - нормально для 4090.

Тест с заполнением объема памяти - тоже успешно, карта умеет работать со всей своей памятью.

В этот раз карта справилась за 62 секунды, но более важно - теперь она может вмещать в себя модельки с бОльшим объемом!

Ну и финально - во время генерации карта выдала чуть большую производительность и стала потреблять намного больше видеопамяти!

И зачем все это? Кому это нужно? Оказывается, достаточно широкому спектру людей и компаний, ведь мы вступили в эру нейросетей, обучений и других задач, где требуются огромные производственные мощности! Покупать rtx a6000 с таким же объемом памяти, так ещё и gddr6 кажется не таким привлекательным и универсальным решением (особенно по цене в 2 раза больше). Больше 5 компаний уже купили у нас данные карты для тестов в своих серверах (хотя мы никому не рассказывали об их существовании, чаще у нас спрашивали, возможно ли это :)

Помню лет 10 назад попалась мне задачка реализовать визуализацию модели колебания тонкой пластинки с закрепленными концами а различными точками возбуждения с разным сигналом.

На тот момент ничего лучше чем сделать все на CPU не вышло. Но в целом вышла очень даже прикольная платформа где можно было налету создавать профиль пластины, точки, барьеры и прочее. Но все равно задача казалась очень прям серьезной. ИИ на тот момент еще не существовало. ))

Получилось тогда так себе.

Единственный косяк что максимальный размер пластины можно было использовать только 32*32 иначе начинался жуткий тупняк.

А сейчас на досуге решил вспомнить этот проект и поиграться с вычислительными шейдерами.

И каково же было удивление что вычислительные шейдеры на самом деле такая простая штука .. либо это опыт либо хз что.

Да и вообще шейдеры это сказка, хочешь сотню источников освещение? Да на здоровье.. )) даже и не напрягается.

Ну а самая вишенка это конечно работа этих шейдеров.

В итоге пластина 1024*1024. Уже детальнее видно волны. Любое количество источников колебаний, барьеров или закреплений пластины. И также любые параметры функций колебания и профилей контакта.

И главное что вообще ни грамма тормозни ... даже при том что запускается на обычном компе со встроенной видяхой.

И заняло буквально пару дней на все.. правильно говорят - опыт, как и половое бессилие, приходит с годами. ))

Дальше интересно сделать вариант где волны гуляют по поверхности сферы ..

Тестирование энергоэффективности и скорости вычислений видеокарт в BOINC проектах

Опубликовано: 07.07.2025

Рубрика: Uncategorized

Автор: AlexA

Статья размещается на сайте с разрешения автора — S.Buzun. Кроме того, Сергей предоставил архив с данными, по которым писалась статья. Возможно кто-то захочет посмотреть исходные данные.

Оригинал статьи находится по ссылке: https://promtechautomat.ru/articles/boinc.php

На момент написания статьи идет криптозима (весна 2025 года). Количество предложений видеокарт от майнеров на популярных площадках увеличивается, и сейчас неплохое время для апгрейда оборудования. Материал этой статьи будет полезен для сравнения характеристик видеокарт для майнинга в проектах распределенных вычислений на платформе BOINC.

Кроме того, Сергей предоставил данные, по которым писалась статья, архив с ними можно скачать по ссылке.

Подробно о добровольных вычислениях и проектах можно почитать здесь:

Характеристики графических процессоров, которые будут протестированы, приведены в таблице 1. Данные для таблицы взяты с сайта techpowerup.com, как показали эксперименты в реальности тактовая частота работы графических процессоров отличается от приведенной в открытых источниках. Также по графическому процессору CMP 90HX в таблице завышен показатель TDP, как показали замеры, энергопотребление ограничено мощностью 250 Вт. Возможно попался экземпляр с модифицированным биосом.

Таблица 1 – Характеристики графических процессоров

Рис. 1

Характеристики тестового стенда приведены в таблице 2.

Таблица 2 – Состав тестового стенда

Рис. 2

Установка драйверов

В Windows видеокарты CMP 170HX и P102-100 одновременно работать с BOINC отказались, видимо, это связано с тем, что для этих видеокарт драйвера находятся в разных установочных пакетах (для CMP 170HX требуется Datacenter driver for Windows).

Если вы все сделали правильно, в диспетчере устройств появится видеоадаптер NVIDIA A100. Настройка системы охлаждения графического процессора. Ниже приводится описание, как установить драйверы для видеокарты CMP 170HX в Windows 10 Pro.

Уменьшение влияния на производительность графического процессора центрального процессора

Видеокарта CMP 170HX является урезанной версией ускорителя NVIDIA A100, однако производитель не включил отдельный драйвер в установочный пакет, и поиск драйвера на сайте nvidia ни к чему не приведет. Чтобы установить драйвер для CMP 170HX, необходимо скачать Data Center Driver for Windows с поддержкой устройств A-series. На момент написания этого обзора, самая новая версия этого драйвера 572.61-data-center-tesla-desktop-win10-win11-64bit-dch-international. Далее нужно распаковать файлы драйвера в папку (например, программой 7zip) и через диспетчер устройств указать Поиск и установка драйвера вручную

Если вы все сделали правильно, в диспетчере устройств появится видеоадаптер NVIDIA A100.

Настройка системы охлаждения графического процессора

Современные графические процессоры имеют встроенную температурную защиту от перегрева. При приближении температуры кристалла к критической, происходит динамическое изменение частоты работы процессора (частота снижается), за счет этого температура не поднимается выше. Также существует лимит по энергопотреблению, который также имеет связь с температурой кристалла. Чтобы исключить влияние температуры на производительность, удобнее всего вручную задать скорость вращения вентиляторов системы охлаждения, проверив под нагрузкой, что максимальная температура кристалла графического процессора меньше критической и тактовая частота постоянная (равна максимальной). Например, для работы CMP 170HX с максимальной производительностью, температура кристалла должна быть меньше 73 градусов. Уже про 74 градусах максимальная тактовая частота будет ниже 1410 МГц.

Уменьшение влияния на производительность графического процессора центрального процессора

Различные задачи BOINC нагружают центральный процессор по-разному. При оценке производительности графического процессора (GPU), нужно убедиться, что центральный процессор (CPU) не является узким местом вычислительной системы. При работе приложений BOINC, использующих видеокарту, загрузка центрального процессора не должна быть 100%. Особенно это актуально если в системе несколько видеокарт и проект активно использует ресурсы центрального процессора. Например, при использовании тестового стенда и 5 видеокарт Zotac P102-100 для расчетов заданий проекта Einstein@Home, время выполнения задания выше на 50%, из-за перегрузки центрального процессора. При использовании 3-х видеокарт Zotac P102-100, в проекте Einstein@Home перегрузки процессора Intel Core i5-6600K уже не происходит, как результат — производительность вычислительной системы с тремя видеокартами выше, чем с пятью. Если центральный процессор не является узким местом вычислительной системы, время выполнения задания и время ЦП в статистике задания должны быть примерно равны (для All-Sky Gravitational Wave search on O3), и загрузка процессора меньше 100%.

* У P102-100 отсутствует измерение потребляемой мощности с помощью Afterburner, соответственно эти данные заполнялись с помощью пересчета % мощности GPU и значения TDP в потребляемую мощность. Так как величина TDP не является максимальным теоретическим тепловыделением процессора, то полученные при пересчете значения не будут точными. Для 1080ti есть данные и по потребляемой мощности в Ваттах и по мощности GPU в %. Мощность, измеренная в Ваттах примерно на 11-12% больше чем рассчитанная мощность (Мощность GPU в % умножить на TDP и разделить на 100%). Для точного измерения потребляемой мощности требуются внешние приборы, эта задача выходит за рамки настоящего исследования.

Затраты энергии на выполнение задания на CMP 170HX в 3,9 раза меньше чем у графических процессоров GeForce 10 серии. Скорость вычислений CMP 170HX в различных приложениях BOINC выше в 3,1 раза по сравнению с 1080ti и P102-100.

Затраты энергии на выполнение задания CMP 90HX в 1,9 раза меньшее чем у графических процессоров GeForce 10 серии Скорость вычислений CMP 90HX в различных приложениях BOINC выше в 2 раза по сравнению с 1080ti и P102-100.

На сайте проекта PrimeGrid имеется информация о относительной скорости графических процессоров (вычисляется автоматически на основе присланных результатов) https://www.primegrid.com/gpu_list.php#GFN20. К сожалению, там нет информации по графическим процессорам для майнинга. Приняв допущение, что производительность P102-100 примерно равна производительности 1080ti, получаем следующий рейтинг по относительной скорости (для задач Genefer 20 4.04 (OCLcudaGFN20).

В рейтинге CMP 90HX заметно ниже NVIDIA GeForce RTX 3080, разница в 23% объясняется уменьшением лимита потребляемой мощности до 250 Вт, скорее всего при одинаковом лимите энергопотребления, время вычисления заданий тоже будет одинаковым.

Графический процессор CMP 170HX также занял достойное место в рейтинге. При вычислениях задач Genefer 20 4.04 потребляемая мощность практически равна значению TDP. У топа из рейтинга — GeForce RTX 4090 TDP равно 450 Вт, у CMP 170HX измеренное потребление – 225 Вт. Соответственно, если сравнить скорость при одинаковом энергопотреблении, производительность двух ускорителей CMP 170HX будет ниже на 12% производительности одной карты GeForce RTX 4090. Тут нужно отметить, что 170HX выпускается по техпроцессу 7 нм, а RTX 4090 по техпроцессу 5нм.