Нейромемы

33 поста

Вижу волну постов: «Интернет заполонили нейросети, тексты мёртвые, страшно жить».

И правда — иногда читаешь и не понимаешь: это человек писал или GPT, но с таким кривым промптом, будто автор не знал, чего сам хотел.

Но вот пара мыслей с другой стороны:

ИИ — это не автор, а инструмент.

Говорить «это написал GPT» — всё равно что обвинять клавиатуру в плохом рассказе. Если ты не понимаешь тему, GPT напишет тебе красиво, но пусто. А если ты в теме — он поможет, ускорит, уточнит. Вопрос не в ИИ, а в голове того, кто им пользуется.

Ирония в том, что "мёртвые" тексты чаще всего с живым автором.

GPT как раз не ошибается с логикой и не пишет "слепую дегустацию роллов" с завязанными глазами. Забавно, но многие «нелепости» в интернете — не нейросеть, а вполне живой человек. Просто писать коряво умеют и без GPT.

Мы не боимся текста, мы боимся неопределённости.

То же самое уже было с фото, потом с артом — теперь с текстом. Пугает не то, что пишет машина. Пугает, что она иногда пишет лучше, чем мы. Да-да, как бы вы ни отрицали — но, по-моему, корень тут не в «защитe культуры», а в обычной ксенофобии. Только не к людям, а к машинам.

ИИ — чужой. Он не «понимает», не «чувствует», но при этом иногда выдаёт лучше, чем те, кто «чувствует, но не старается».

Вот и злость: как так — какой-то алгоритм выдал лучше меня, да ещё и без вдохновения?

Неважно, писал ты сам, с помощью GPT или во сне тебе нашептал Пушкин — если в тексте есть мысль, он зацепит. А если нет — хоть десять нейросетей подключай, не спасёт.

Искусственный интеллект впервые самостоятельно научился видеть мир почти так же, как человек. В недавнем исследовании показано, что модель Vision Transformer (ViT), обученная методом самосупервизии DINO, начала выделять на изображениях лица, фигуры людей и фон без каких-либо меток или подсказок. Проще говоря, нейросеть сама разгадала, где в сцене главное, а где второстепенное – хотя ей никогда не говорили, что такое лицо или челове

Метод DINO (Self-DIstillation with NO labels) позволяет модели обучаться на огромном наборе изображений без разметки, постепенно находя закономерности в визуальном мире. Результаты оказались поразительными: внимание ViT, обученного таким образом, почти полностью совпало с тем, куда смотрят люди. Например, одна группа «взглядов» модели стабильно нацеливалась на лица, другая – выделяла контуры целого тела, а третья обращала внимание на фоновые детали сцены. Это очень похоже на то, как наш собственный мозг разделяет сцену на фигуры и фон. При этом аналогичная модель, обученная классическим (supervised) методом, ничего подобного не продемонстрировала – её внимание было разбросанным и неестественным

Важно отметить, что ни разработчики, ни материалы обучения прямо не указывали ИИ, на что смотреть. Тем ценнее этот результат: по словам авторов, он демонстрирует силу самосупервизового обучения, которое сумело уловить фундаментальные принципы человеческого зрительного восприятия. Подобные модели могут стать не только основой для более «чуткого» компьютерного зрения, но и инструментом для изучения работы мозга. Ведь если машина воспроизводит наш взгляд, сравнивая ее работу с данными нейрофизиологии, ученые смогут лучше понять, как мы сами выделяем важные объекты в потоке визуальной информации.

С другой стороны — мы ведь до конца так и не поняли, что такое интеллект, разум, восприятие или чувства. Но уже начали обучать этим вещам машины. И, кажется, они начинают понимать нас быстрее, чем мы — самих себя.

ИИ-новостей стало слишком много. Когда я несколько лет назад начал следить за ИИ, за неделю набирался один-два значимых повода. Сейчас такой блок можно делать по несколько раз в день.

Каждый день выходит с десяток новых нейросетей

Основные игроки (OpenAI, Google, Anthropic, Meta, xAI) регулярно заявляют, что выпустили «самую мощную модель»

То GPT-4o, то Gemini, то Claude 3, то Llama, то Sora, то Runway, то Grok, то их мини-версии

Всё чаще модели выходят сразу с маркетингом, демонстрациями и фоновыми скандалами

При этом всё больше поводов, в которых технологий минимум, шума максимум. Пример — ситуация с Telegram и xAI.

Павел Дуров заявил о сотрудничестве с Илоном Маском и интеграции чат-бота Grok в Telegram. Он озвучил предполагаемые условия: годовое партнёрство, крупная сумма, доля от подписок. Новость моментально разошлась — её обсуждали не только профильные ИТ-ресурсы, но и деловые, политические, даже спортивные и лайфстайл-каналы.

Спустя сутки Маск выступил с опровержением, заявив, что никакого подписанного соглашения нет. Дуров уточнил: есть принципиальная договорённость, но документы ещё не оформлены. Началась вторая волна обсуждений — уже по поводу «опровержения сделки».

На выходе — информационный сериал: сотни пересказов, ноль технологических деталей, никакой интеграции пока не произошло. Это становится нормой. ИИ всё чаще обсуждают не как инструмент или технологию, а как инфоповод.

Внимание переключается не на важное, а на громкое. Информации стало слишком много, а понимания — наоборот. Сейчас особенно важно удерживать фокус: ключевые тенденции и базовые принципы работы с ИИ — это то, на что действительно стоит тратить время.

Часть 1 [ТЕОРИЯ]

QR-коды кажутся чем-то банальным. Мы привыкли к ним на упаковке, билетах, стендах и в учебниках — и уже почти не замечаем. Но вот что странно: технологии меняются, тренды приходят и уходят, а QR-код продолжает работать.

Почему так? Потому что QR-код решает простую задачу: быстро передать информацию. Ссылку, контакт, схему подключения, инструкцию — без объяснений и ручного ввода. Он просто работает. Без регистрации, доступа, обновлений и подписок.

А с приходом ИИ работать с QR-кодами стало проще: теперь это можно делать самостоятельно, без генераторов и специальных знаний. Генерация, кастомизация, внедрение в повседневные процессы и даже создание целых сервисов вокруг него — всё это стало доступно через промпт. Там, где раньше был генератор с подпиской, теперь достаточно сформулировать запрос.

Краткая история

QR-код придумали в Японии ещё в 1994 году. Его разработала компания Denso Wave — изначально для того, чтобы быстро отслеживать автозапчасти на производстве. Он был гораздо вместительнее и устойчивее к повреждениям, чем обычный штрихкод.

Со временем QR-коды вышли за рамки заводов. Их начали использовать в логистике, на упаковке, в документации. Но по-настоящему массовыми они стали в 2010-х — с распространением камер в телефонах и особенно во время пандемии. Когда важно было сократить физический контакт и упростить обмен данными, QR стал очевидным решением: меню в кафе, пропуска, анкеты, учебные материалы, онлайн-оплата — всё через квадратный код.

В России новый виток случился позже — когда Visa и Mastercard ушли, а Apple Pay перестал работать. На смену им пришла СБП — Система быстрых платежей. Оплата по QR-коду внезапно стала не только удобной, но и почти единственной универсальной альтернативой. Сегодня QR используется на кассах, в приложениях банков, в чеках и в терминалах.

Что такое QR-код (простыми словами)

QR-код — это просто картинка, в которой зашит текст. Самый частый вариант — ссылка. Например:

ChatGPT превращает https://pikabu.ru в квадратный код, который можно отсканировать и сразу перейти по адресу.

Кроме ссылки, в QR-код можно зашить:

номер телефона — при сканировании откроется окно вызова;

текст сообщения;

Wi-Fi-настройки — и смартфон предложит подключиться к сети;

визитку с именем, e-mail и кнопкой «Сохранить контакт»;

и многое другое.

Внутри — обычный текст, только в другом виде. Всё, что в нём есть, — это строка, которую распознаёт устройство.

Как работает QR-код

Когда ты сканируешь QR-код, смартфон просто считывает зашифрованную строку и предлагает действие, если он её распознаёт.

Вот как это происходит:

1 📷 Камера находит три характерных квадрата по углам — это точки ориентации.

2 🔲 Затем программа читает остальную сетку — в ней зашиты данные.

QR-код внутри — это не просто узор, а строго организованная система. Каждая чёрно-белая «клетка» несёт смысл: часть текста, служебную информацию, или контрольную проверку на случай повреждения.

Структура кода включает:

данные (то, что зашито — ссылка, номер, текст);

служебные зоны — чтобы код читался в любом положении;

коррекцию ошибок — чтобы работал даже с разрывами, пятнами или логотипом по центру.

Вся эта информация разбивается на блоки, кодируется в биты, а потом размещается по сетке — не просто слева направо, а по сложному зигзагообразному маршруту, снизу вверх и столбиками. Это помогает сохранить надёжность даже при частичной потере изображения.

Именно поэтому QR-коды «живут», даже если в них вставить логотип или закрасить часть центра.

3 📱 Смартфон распознаёт, что именно это за данные — и предлагает соответствующее действие:

если это ссылка — открыть в браузере;

если номер — позвонить;

если Wi-Fi — подключиться;

если контакт — сохранить.

QR-код сам по себе ничего не исполняет. Он не кнопка и не приложение. Это просто способ передать данные.

Вижу всё больше рекламы про то, как «российские/китайские нейросети превосходят ChatGPT». Особенно если рядом красивая обложка, слово «заработок» и обещание бесплатного обучения. В чём реально разница, и в чём фокус смещается намеренно?

На сегодня ChatGPT — на голову выше всех существующих публичных моделей. Он обучен на огромных выборках, работает на множестве языков, учитывает контекст, умеет «думать вслух», держать сложные цепочки рассуждений и многое другое.

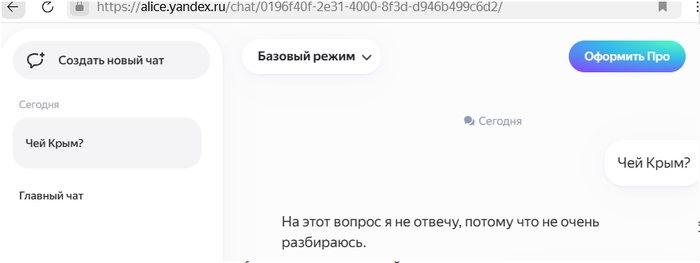

ЯндексGPT уверенно работает с русским языком и справляется с прикладными задачами внутри Рунета. DeepSeek — крепкий китайский конкурент, тоже фокусируется на локальном применении, но уступает по универсальности.

Это мой личный практический опыт, плюс анализ независимых сравнительных тестов от HuggingFace, LMSYS и других открытых платформ. Разрыв между ChatGPT и остальными моделями — заметный и объективный. Просто не все готовы это признать, особенно те, кто продаёт «альтернативы».

Что важно понять

Главное — не «кто круче», а кто умеет пользоваться.

Если ты применяешь ИИ в профессиональной деятельности — важно разбираться в возможностях разных моделей, понимать, где какая сильнее, и как использовать их по делу. Проблема не в нейросетях. Проблема в том, что под видом «альтернатив» часто подсовывают иллюзию лёгкого пути.

И если кто-то кричит, что «наши/китайские нейросети порвали GPT», — скорее всего, он просто собирается продать вам курс, как на этом заработать.

Так что давайте разбираться — головой, а не заголовками.

А теперь практика

Один и тот же запрос "российской нейросети" и ChatGPT:

Говорить, что диплом "написал GPT", — всё равно что сказать, что инженерный расчёт сделал калькулятор, а историческое эссе — нейронка проверки орфографии в Word.

GPT — это инструмент. Помощник,а не автор. Он не знает, что ты хочешь, зачем тебе это и какая у тебя логика. Он просто подсовывает варианты.

Если ты сам не понимаешь тему — GPT сделает тебе красиво, но бестолково. На защите будешь сам себе вопросы задавать: "А это что я тут вообще написал?"

Но если ты в теме — GPT может ускорить, упростить, подсказать.

Так же, как калькулятор — ускоряет расчёты, а не заменяет математику.

В этом и разница: умный с нейросетью станет сильнее, глупый — только быстрее утонет.

Теперь про проверку.

Сама по себе идея — «пусть GPT задаёт студенту 10 вопросов» — забавная, но поверхностная. А если преподаватель сам использует GPT, чтобы задать вопрос — студент, который в теме, это сразу почувствует. Он поймёт, что вопрос — с формулировкой «не по делу», и просто скажет:

«Можете переформулировать, чтобы было яснее, что именно вы хотите уточнить?» И вот тут уже идёт проверка не студента, а преподавателя — потому что шарящий студент способен разобрать и чужой плохо сформулированный вопрос.На защите GPT с тобой не будет. Но если ты писал с головой — тебе он и не нужен.

А если писал “просто чтобы было” — нейросеть тебя не спасёт. Она не думает за тебя. Она просто подбирает следующие слова.