Про Билла Гейтса и мать его

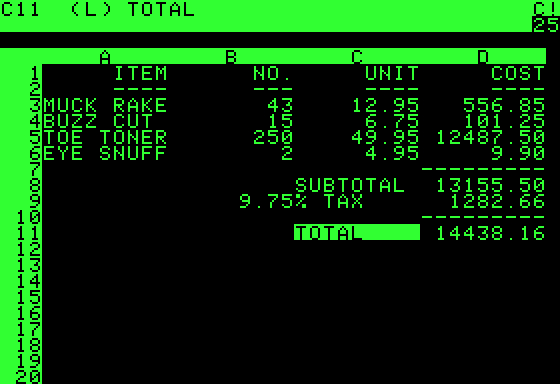

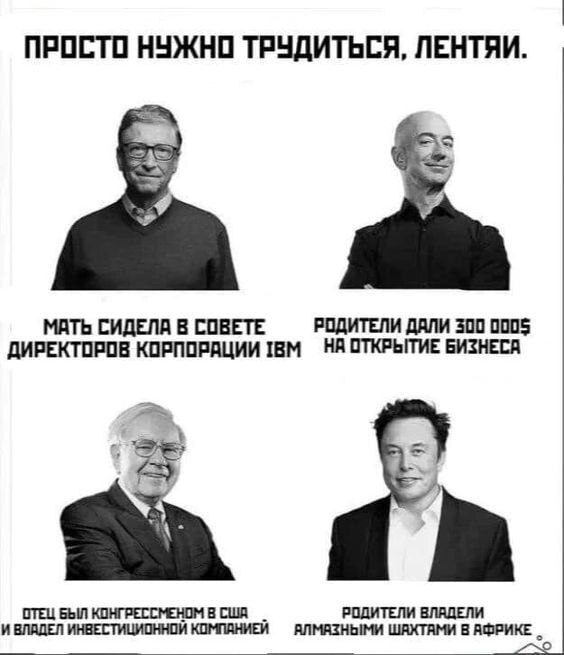

Многие видели эту картинку на просторах Пикабу:

Разумеется, на самом деле Мэри Гейтс никакого отношения к корпорации IBM не имела, а реальная история подписания исторического контракта намного интереснее.

Основатель Microsoft действительно родился в очень богатой семье. Его отец был преуспевающим корпоративным адвокатом, а мать на протяжении многих лет строила карьеру, доступную для богатой, образованной, энергичной и в меру эмансипированной американки. Основным её занятием было участие в работе всевозможных общественных организаций. Впрочем, бизнесом она тоже не пренебрегала.

В 1980 году Мэри Гейтс вошла в совет директоров одного из крупнейших благотворительных фондов в стране - United Way, куда кроме неё входило также множество других известных и влиятельных личностей. Ничего удивительного в этом нет, поскольку благотворительность в Америке - занятие почётное и для богачей практически обязательное. Среди прочих, в совет директоров фонда входил тогдашний президент IBM Джон Опель. После одного из заседаний между ним и Мэри Гейтс состоялся примечательный разговор.

"Мэри Гейтс упомянула, что IBM как раз начала работать с компанией её сына, однако Опель никак не прокомментировал это утверждение. Позднее, когда разработчики ПК докладывали руководству IBM о своих планах, они упомянули возможность сотрудничества с Microsoft. "Это случайно не компания сына Мэри Гейтс?" - спросил Опель. С этого момента Гейтса стали воспринимать как "имеющего связи в IBM".

(Цитируется по Janet Lowe "Bill Gates Speaks. Insight from the World's Greatest Entrepreneur", 1998)

Самый ранний источник, в котором рассказана эта история и до которого мне удалось дотянуться через Google Books - это книга "The Computer Entrepreneurs. Who's Making It Big and How in America's Upstart Industry" (Robert Levering, Michael Katz, Milton Moskowitz, 1985, стр. 163). К сожалению, ссылка из неё ведёт на страницу, которой нет в бесплатном доступе, поэтому докопаться ещё глубже и выяснить, кто именно впервые рассказал об этом разговоре, я так и не смог. Возможно, это взято из какого-то раннего интервью с Джоном Опелем, или, быть может, скомбинировано из рассказов нескольких людей. Допускаю, что об этом мог рассказать и сам Билл Гейтс. Во всяком случае, факт этого разговора, да и в принципе факт знакомства своей мамы с президентом IBM он никогда не отрицал.

Но обратите внимание, что в разговоре с Опелем Мэри Гейтс упоминает сотрудничество между IBM и Microsoft как уже состоявшийся факт. И далее при обсуждении планов сначала разработчики будущего ПК упоминают Microsoft, и только потом всплывает факт знакомства матери Гейтса с президентом компании. Да и здраво рассуждая, откуда Мэри Гейтс могла бы узнать о проекте персонального компьютера? Он ведь держался в строгом секрете, президент IBM не стал бы распространяться о нём случайной знакомой. Равно как и не стал бы рисковать многомиллионным проектом, нанимая никому неизвестного студента-недоучку для важнейшей миссии.

Так в чём же дело? Почему IBM обратилась к мелкой никому не известной компании, которая никакого отношения к операционным системам не имела? Выглядит подозрительно и справедливо навевает мысли о каких-то подковёрных интригах...

Широко известная в узких кругах компания

А ответ на самом деле очень прост: на момент заключения соглашения с IBM компания Microsoft уже была крупным игроком на рынке ПО для микрокомпьютеров. Более того, как раз в 1980-м году Microsoft продемонстрировала способность сделать именно то, в чём нуждалась корпорация IBM - перенести существующую операционную систему на новое железо.

Разумеется, до современного софтверного гиганта компании было далеко, но в 1980-м году софтверных гигантов вообще не существовало в природе. Компьютеры были большими, дорогими и совершенно несовместимыми друг с другом, большую часть прогрммного обеспечения для них создавали сами же производители. Возникший в 1975-м году рынок микрокомпьютеров хоть и бурно развивался, но был ещё слишком мал.

На фоне большинства тогдашних софтверных компаний (пара друзей в папином гараже с купленным вскладчину Altair или Apple) Microsoft выглядела весьма солидно - прибыль под миллион долларов, штат более ста человек, и даже офис продаж в Японии. Фактически, продукцией Microsoft к 1980-му году пользовалось большинство владельцев микрокомпьютеров, хотя само название "Microsoft" тогда ещё мало кому было известною.

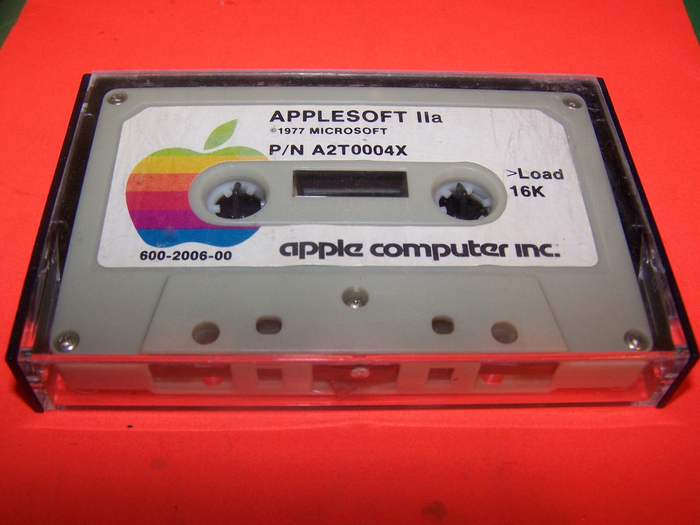

Те, кто хоть немного знаком с историей вычислительной техники и восьмибитными компьютерами, думаю, понимают, о каком именно продукте Microsoft идёт речь. Да, совершенно верно, я говорю про Microsoft BASIC.

Кассета в хорошем состоянии на eBay стоит несколько сот долларов, между прочим. Ни у кого не завалялась?

У Microsoft были и другие компиляторы, но именно компилятор Бейсика был первым и главным продуктом компании. Созданный в 1975-м году под Altair8800, к 1977-му Microsoft BASIC уже стал достаточную популярен, чтобы заинтересовать компанию Commodore, лицензировавшую Бейсик для своего Commodore PET. В следующем году Apple выпустила карту расширения с майкрософтовским Бейсиком (под именем Applesoft BASIC) для своего Apple II. В усовершенствованном Apple II+ чип Applesoft BASIC уже был встроен в материнскую плату, так что с тех пор большая часть написанного на Бейсике ПО для Apple II требовала для работы именно майкрософтовский вариант. В 1979-м году компилятор лицензирует корпорация Radio Shack - владелец крупнейшей сети магазинов радиотоваров в США, чей микрокомпьютер TRS-80 по объёму продаж опережал Apple и Commodore вместе взятые.

При этом Бейсик для 8-битного микрокомпьютера был не просто языком программирования, а фактически примитивной операционной системой. Интерпретатор находился в ПЗУ на материнской плате, загружался автоматически при включении компьютера и, кроме ввода текста с клавиатуры, позволял загрузить с кассеты и запустить программу. Да, привычные нам команды для работы с файлами в Бейсике ещё не появились, но тогдашнему 8-битному микрокомпьютеры они всё равно были не нужны по причине отсутствия у них дисководов как таковых. Ну то есть сами дисководы-то существовали, конечно, но стоили как крыло самолёта, так что вот тебе, мальчик, магнитофон, вот тебе кассета и пиу-пш-ш-ш-и-у-и-у-и-у-ш-ш-ш...

Разумеется, и дисководы, и продвинутые ленточные накопители активно использовались в мейнфреймах. Применялись они и в ориентированных на бизнес "персональных" микрокомпьютерах (да, ПК начали называть ПК ещё до появления первого IBM PC), но стоили эти игрушки очень дорого и поначалу не смогли завоевать большую популярность. Большинство попыток продвинуть микрокомпьютер в бизнес разбивались о весьма ограниченные возможности 8-битных машин и отсутствие нужного софта. Причём я не говорю даже о каких-то роскошествах типа электронных таблиц или сложных базах данных, речь шла о самых элементарных вещах. Базовые модели "святой троицы", например, не умели выводить на экран строчные буквы, так как памяти знакогенератора хватало только на заглавные. (Просто невероятно, как Apple II при тогдашних аппаратных ограничениях ухитрялся хоть как-то пищать динамиком и выводить на экран цветную (!!!) графику).

Расширение аппаратных возможностей микрокомпьютеров приводило к резкому удорожанию, что делало покупку просто-напросто неоправданной по сравнению с таймшерингом, т.е. с сервисом по удалённому доступу к мейнфрейму через терминал. И сам терминал, и вычислительную мощность, и доступ к нужному ПО - всё можно было взять в аренду,. Да, софт как сервис по подписке во всей своей красе. Всё новое - это хорошо забытое старое.

Но всё меняется. К концу 70-х комплектующие для микрокомпьютеров (и прежде всего - память) существенно подешевели, позволив создавать более мощные машины по более приемлемой цене. И Apple, и Commodore, и TRS-80 уже обзавелись платами расширения, позволявшими ликвидировать наиболее узкие места первых моделей, и, в том числе, стали поддерживать дисковые накопители.

В 1979-м году происходит прорыв: на рынке практически одновременно появляются WordStar - первый успешный текстовый процессор для восьмибитных микрокомпьютеров (до него был Electric Pencil, но кому какое дело), и VisiCalc - первая электронная таблица в принципе. Микрокомпьютер из игрушки для богатых детей резко превратился в насущную потребность для бизнеса.

Итак, микрокомпьютерам резко понадобились работать с дисками. А что нужно для работы с дисками, кроме, собственно, диска и дисковода? Правильно, дисковая операционная система, ДОС, как у взрослых. И такая ДОС у восьмибитных компьютеров уже была.

Пара слов о Гэри Килдалле

Гэри Килдалл сам по себе личность легендарная и заслуживающая отдельного рассказа, но для нас сейчас важно только одно его достижение: в 1974 году, ещё до появления Altair-8800, он создал дисковую операционную систему CP/M для микропроцессора Intel 8080. Причём для того, чтобы написать первую операционную систему для микрокомпьютеров, Килдаллу пришлось сперва создать первый язык программирования для микрокомпьютеров - PL/M. Ох уж эти семидесятые... Когда на рынок вышел Altair-8800, Килдалл основал компанию Intergallactic Digital Research (зацените название!) и начал продавать права на свою операционную систему всем желающим.

Фактически, CP/M стала первой более или менее кроссплатформенной операционной системой. Никаких общих стандартов для железа и софта в то время не существовало, но программа, написанная для CP/M, могла (с определёнными ограничениями) работать на любом микомпьютере, основанном на процессорах Intel 8080 или совместимом с ним Zilog Z80. При этом всё взаимодействие с железом операционная система брала на себя, а запущенная в ней прикладная программа выполняла основные операции ввода-вывода через набор стандартных функций. Исключением могли быть разве что какие-то очень специфические действия (например, отрисовка графики), но большинству программ того времени возможностей ОС хватало за глаза.

(Кстати, если вам показалось, что описанный принцип работы CP/M чертовски похож на принцип работы BIOS, то нет, вам не показалось. Эту штуку придумал именно Килдалл, включая, собственно, и само название "BIOS". Я же говорю, легендарная личность).

CP/M была не единственной, но, благодаря кросс-платформенности, самой популярной дисковой операционной системой для микрокомпьютеров. К 79-му начал нарастать снежный ком: новые бизнес-пользователи покупали компьютеры с CP/M, поскольку под неё накопилась большая библиотека программного обеспечения, а разработчики ПО, в свою очередь, всё больше и больше ориентировались на CP/M благодаря её популярности у пользователей.

Но в 1979 году на Apple II выходит VisiCalc - первая в мире программа для электронных таблиц, моментально изменившая правила игры. Позднее VisiCalc назвали первым "приложением - убийцей", т.е. таким приложением, которое абсолютно необходимо всем и каждому, и которое работает только на этом конкретном железе. (Чуть позже такими "убийцами" станут потомки VisiCalc - Lotus 1-2-3 на IBM PC и MS Excell на, внезапно, Apple Macintosh).

Получается, что самая главная программа для бизнеса работает на Apple II, который построен на процессоре MOS 6502, имеет свою собственную Apple DOS и не может работать с приложениями, написанными для CP/M. А куча других бизнес-приложений, включая текстовый процессор WordStar, работают под CP/M на процессорах 8080 и Z80, которые совместимы между собой, но совершенно несовместимы с MOS 6502. И портировать софт с одного процессора на другой в тогдашних условиях - то ещё развлечение, архитектура Intel 8080 и MOS 6502 слишком сильно отличались друг от друга (в частности, они совершенно по-разному работали с памятью). Тот же VisiCalc, например, не был доступен для других микрокомпьютеров вплоть до конца 1980-го года, а портировать CP/M на Apple Килдалл даже не пытался.

Нужно было другое решение, которое, собственно, и нашла Microsoft по принципу "если гора не идёт к Магомету, дон, то Магомет пойдёт к горе".

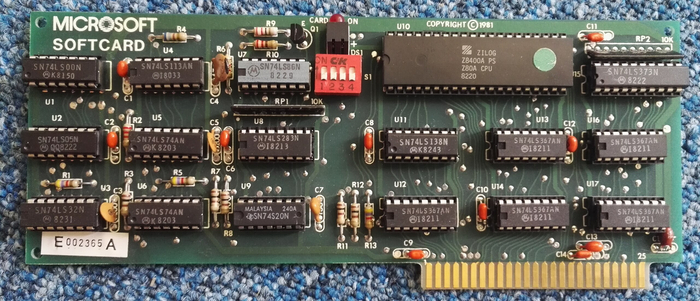

Весной 1980-го году Microsoft выпустила свой самый успешный до-айбиэмовский продукт: карту расширения для Apple II с процессором Z80 на борту, позволявшую запускать приложения для CP/M на компьютерах Apple. К карте, естественно, прилагался и диск с самой CP/M, которую Гейтс лицензировал у Digital Research по цене всего 4 доллара за каждую проданную копию.

Microsoft SoftCard была показана публике в марте 1980-го и моментально стала бестселлером. Всего за первые три месяца было продано пять тысяч карт по цене 350 долларов за штуку, прибыль от её продажи в том году превзошла прибыль от всех остальных продуктов Microsoft. Но что ещё важнее, в этот момент Microsoft стала известна не только как разработчик компиляторов, но и как компания, успешно портировавшая популярную операционную систему на ранее не приспособленный под неё компьютер.

И произошло это как раз в тот момент, когда IBM потребовался сторонний разработчик ПО для нового секретного проекта.

Одна ошибка и ты ошибся

Итак, Microsoft в 1980-м уже приобрела определённую репутацию и причина, по которой она в принципе попала в поле зрения IBM, стала понятна. Понятна и причина, по которой IBM выбрала для своего нового продукта именно CP/M - для неё уже было создано множество бизнес-приложений, которые, как считалось, можно будет легко адаптировать для нового ПК.

Но всё же, если мы выбрали для нашего будущего компьютера CP/M, почему не обратиться непосредственно к её правообладателю, Digital Research?

И да, именно так. IBM поначалу действительно хотела договориться с Digital Research. Легенда о том, что именно Гейтс предложил IBM операционную систему на своих условиях, возникла позже (и была отражена, в частности, в фильме "Пираты Кремневой долины"). Якобы хитрый юноша сначала убедил недалёких умом пиджаков, потом метнулся к знакомому, по-быстрому купил у него прообраз MS DOS, доработал напильником и стал миллиардером.

На самом деле, естественно, всё было совсем не так.

Представители IBM связались с Гейтсом в июле 1980 года, и изначально речь шла только об адаптации майкрософтовских компиляторов, не более того. Замечу, что IBM PC с самого начала разрабатывался с широким привлечением сторонних производителей, так что само решение обратиться к Microsoft лежало вполне в рамках общей концепции. Разработчики хотели выйти на рынок очень быстро, в течение года, при том, что обычный срок разработки в IBM тогда составлял 4 - 5 лет. Основания для беспокойства были - предтечи будущего IBM PC (IBM 5100, 5110 и 5120) разрабатывались слишком долго в том числе и из-за проблем с собственным ПО, а новейшая модель IBM 5322 DataMaster задержалась с выходом почти на год как раз из-за проблем - сюрприз! - с родным айбиэмовским интерпретатором Бейсика.

Восьмибитный IBM 5322 Datamaster, 1981 год. Игрушка ценой 9 тысяч долларов (порядка 35 тыс. на нынешние деньги). Для сравнения, вышедший в том же году VIC-20 от Commodore стоил всего 300 долларов.

Гейтс, сообразив, что такой шанс выпадает раз в жизни, тут же отменил все назначенные встречи, радушно принял дорогих гостей и без вопросов подписал соглашение о неразглашении. Компилятор Бейсика для 8086 на тот момент уже был практически готов, остальные были на подходе (компания начала разработку сильно заранее, спасибо связям Пола Аллена в Интел. Кстати, по одной из версий именно Аллен убедил айбиэмовцев выбрать 16-битный процессор вместо 8-битного, хотя лично мне это кажется весьма сомнительным).

Поскольку общее впечатление о молодом Гейтсе сложилось крайне положительное, гости поинтересовались условиями контракта между Micrisoft и Digital Research. Компания продаёт CP/M со своими платами для Apple, может быть, она сможет сделать то же самое и для будущего IBM PC?

Гейтс совершенно честно ответил, что всего лишь продаёт CP/M по лицензии, прав на переработку у него нет и за самой ОС надо обращаться в Digital Research. Более того, как только дорогие гости покинули офис, Гейтс немедленно позвонил Килдаллу. "Я не могу разглашать подробности" - сказал он, - "но скоро к тебе обратятся очень важные люди. Прими их как следует, у них очень серьёзные намерения".

Почему Гейтс, не замеченный впоследствии в какой-то особой этичности в конкуренции, предоставил возможность заработать Килдаллу? Этого никто не знает, но сам факт неоспорим: его подтверждают не только он сам и коллеги по Microsoft, но и работники самой Digital Research, участвовавшие в переговорах. Возможно, тут сыграли роль дружеские чувства (Гейтс и Килдалл были близко знакомы). Возможно, в 1980-м году Гейтс ещё не успел превратиться из компьютерного романтика в циничного до потери совести бизнесмена. А возможно, он просто решил не рисковать и сыграл по правилам, чтобы продемонстрировать свою надёжность перед IBM. Попытка продать что-то, что тебе не принадлежит (и что ещё хуже, чего у тебя нет) могла закончиться очень плохо, а подозрение в нечестности просто уничтожило бы на корню любую возможность к сотрудничеству.

Через пару дней айбиэмовцы связались с Килдаллом, однако переговоры не заладились. Легенда о том, что он вообще отказался от встречи ради игры в гольф, разумеется, не соответствует действительности, однако Килдалл действительно заставил айбиэмовцев ждать окончания другой встречи. Затем он потребовал переработать соглашение о неразглашении, односторонне составленное в пользу IBM.

Против доработки CP/M Килдалл ничего не имел (фактически, Digital Research в любом случае собиралась адаптировать свою ОС на новые 16-битные процессоры Intel, но планы были отложены в пользу другого проекта). Однако Килдалл хотел лицензировать её на тех же условиях, на которых лицензировал восьмибитную версию для всех остальных партнёров (10 долларов за каждую проданную копию). IBM же хотела купить права на операционную систему за фиксированную сумму. Споры возникли даже в отношении названия: Килдалл считал, что название CP/M уже достаточно известно, чтобы его менять, и отказался продавать свою ОС под именем PC DOS.

Вообще, друзья и коллеги Гэри Килдалла описывали его как человека мягкого и не склонного к конфликтам, так что остаётся загадкой, почему в переговорах с IBM он проявил подобную неуступчивость. Возможно, дело было в уязвлённом самолюбии самого Килдалла: гигантская корпорация изначально вела себя слишком нагло, не как равный партнёр, но как хозяин положения, делающий Килдаллу одолжение, при том, что именно IBM нуждалась в продукте Digital Research, а не наоборот.

Кроме того, в Digital Research тогда в принципе не верили в то, что у IBM что-то получится. Рынок мейнфреймов, с его долгими циклами разработки, внедрения и поддержки дорогих машин, разительно отличался от нового и крайне динамично развивающегося рынка ПК, а IBM уже тогда была известна своей крайней забюрократизированностью и неповоротливостью. (Справедливости ради, Килдалл в своём скептицизме был отнюдь не одинок. Журнал BYTE в своё время писал, что для IBM создать успешный микрокомпьютер - это как слону научиться танцевать чечётку).

При этом с точки зрения IBM ситуация выглядела совсем иначе. IBM была многомиллиардным монстром, одним из столпов американской экономики, а Microsoft и Digital Research при всех своих успехах оставались по сравнению с ней лишь детишками в песочнице. Вот только первый "ребёнок" с первого же момента продемонстрировал понимание момента и согласился работать под покровительством большого дяди (держа при этом фигу в кармане, но кому какое дело), а второй почему-то вообразил себя взрослым и вздумал артачиться.

Сыграл ли тут роль факт знакомства Джона Опеля с Мэри Гейтс? Сомнительно, но даже если и да, то весьма незначительную. Окажись Килдалл чуть уступчивее - контракт без сомнения ушёл бы к нему, а Гейтсу пришлось бы довольствоваться доходами от компиляторов.

Последний шанс Килдалл упустил, не выпустив адаптированную CP/M сразу вместе с IBM PC. Да, IBM всё же заключили с ним соглашение, чтобы избежать потенциальных судебных исков. Хотя формально права Digital Research нарушены не были (исходный код CP/M в MS DOS не использовался, а идеи и принципы авторским правом не охраняются), однако в IBM всё же решили не рисковать. Благо, соглашение с Digital Research им ничего не стоило - корпорация всего лишь обязалась предлагать пользователям выбор между собственной PC DOS и CP/M. Однако 16-разрядная версия CP/M появилась лишь через год после аннонса IBM PC и просто не смогла нагнать конкурента. "Чистая" операционная система без прикладных программ оказалась никому не нужна.

Позднее Килдалл ещё поборется с Гейтсом, создав DR DOS (причём со стороны Гейтса эта конкурентная борьба велась уже намного менее благородно, чем ранее), и окончательную точку в противостоянии поставит уже Windows 3.0. В 1991-м Килдалл продал свою компанию со всеми разработками компании Novell, а ещё через три года трагически, но нелепо погиб, получив травму головы в барной драке.

Успешный успех

Ещё одна легенда гласит, что Microsoft вообще ничего не создавала, а Гейтс всего лишь купил переделанную CP/M за гроши у настоящих разработчиков - Seattle Computer Products (SCP). Эта легенда, как и все прочие, имеет под собой очень мало оснований.

В реальности Тим Паттерсон начал адаптацию CP/M под 8086 всего за несколько месяцев до этого и работал практически в одиночку. После заключения исторического контракта с IBM Гейтс выкупил права на уже написанный код у SCP, сам Паттерсон перешёл в Microsoft и завершил работу уже там, причём вместе с ним над проектом работало ещё три десятка сотрудников. Так что большая часть работы над будущей MS DOS была проделана уже в самой Microsoft.

Кстати, SCP хоть и получила изначально всего 75 тысяч долларов, но по условиям соглашения с Microsoft могла неограниченно продавать саму MS DOS (включая все её последующие версии) вместе со своими компьютерами. По факту компьютеры SCP провалились, и единственным источником дохода компании стала продажа MS DOS вместе с каким-то минимальным набором железа. Для устранения конкурента Microsoft пришлось заплатить SCP фантастические по тем временам 925 тысяч долларов.

Ну и раз уж мы заговорили о лицензиях, то надо упомянуть и условия самого соглашения между IBM и Microsoft. Возможность продавать свою ОС сторонним производителям действительно сыграла ключевую роль в последующем успехе Microsoft (и в последующем закате оригинальных IBM PC), однако мнение о том, что это был какой-то гениальный ход со стороны Гейтса, совершенно неверно. Продажа неисключительной лицензии на программное обеспечение - вполне обычная практика что тогда, что сейчас. На тех же условиях IBM приобрела права на все три (!) операционные системы, которые предлагались пользователям вместе с IBM PC - MS DOS (под именем PC DOS), CP/M от Digital Research и UCSD p-System от разработчиков из Университета Южной Калифорнии.

В полном выкупе прав на операционные системы смысла не было, наоборот, это противоречило самой концепции разработки PC с использованием открытой архитектуры и сторонних производителей. Покупка прав означала переход процесса разработки ОС от Microsoft к IBM, то есть именно того, чего создатели PC как раз хотели избежать.

При этом сами айбиэмовцы, разумеется, не были наивными чукотскими юношами и вполне осознавали, что в случае успеха их компьютер тут же попытаются скопировать конкуренты. Для предотвращение копирования было найдено простое, но (как тогда казалось) надёжное решение - IBM опубликовала исходный код своего BIOS-а, тем самым защитив его авторским правом от несанкционированного копирования.

И это... сработало! Очень быстро после выхода IBM PC рынок наводнили "совместимые" компьютеры, на которых успешно запускалась адаптированная под новое железо MS DOS и пара-тройка программ (тех, что работали со стандартным API операционной системы без прямого обращения к железу). Однако стандартный набор функций MS DOS был весьма ограничен, и программы, требовавшее прямого доступа к BIOS, работали в то время только на оригинальных IBM PC.

Когда в 1982-м году журналисты из PC Magazine принесли на одну из выставок пару дискет со стандартным набором тогдашнего ПО и предложили участникам протестировать их "совместимые" PC на реальную совместимость, половина просто отказалась (чуть ли не физически заклеив дисководы у своих выставочных экземпляров), а большинство остальных с треском провалили испытание. Несколько реально совместимых компьютеров всё же нашлось - из тех, кто не побоялся скопировать айбиэмовский BIOS, но как раз их-то IBM смогла достаточно быстро прижучить за нарушение авторских прав.

Однако уже в 1983-м году Compaq смогла с нуля написать код совместимого с PC BIOS, не используя оригинальный айбиэмовский код. Само по себе это было не так страшно - обратный инжениринг и разработка стоила гигантских денег, недоступных большинству мелких конкурентов, но примечателен был сам факт того, что это возможно. Настоящий же прорыв для "совместимых" компьютеров случился годом позже - компания Phoenix начала продавать совместимый с оригинальным PC BIOS всем желающим. Конкурировать с одним лишь Compaq было можно, но с мириадом мелких безымянных производителей - уже нет.

Только в этот момент IBM поняли, что разработку ОС надо контролировать самим. Новую OS/2 они уже разрабатывали хоть и совместно с Microsoft, но под своим собственным контролем и с сохранением всех прав. Фишка, однако, была в том, что все те проблемы гигантской корпорации, которых удалось избежать при создании первого IBM PC, никуда не делись, и прекрасную во всех смыслах операционную систему OS/2 в итоге сгубила сама IBM своим бюрократизмом и неумением адаптироваться к быстро меняющемуся рынку.

Но это уже совсем другая история...

!["Святая троица" 1977 года - Commodore PET, Apple ][ и TRS-80. Все три работали с Microsoft Basic.](https://cs19.pikabu.ru/s/2025/12/30/19/3hlewfwo.jpg)