Дэдпул 4 (2025)

сгенерировал не большой фрагмент с помощью нейросетей. если кому понравилось есть группа телеграм где публикую подобное:

https://t.me/generatorfilm

сгенерировал не большой фрагмент с помощью нейросетей. если кому понравилось есть группа телеграм где публикую подобное:

https://t.me/generatorfilm

Не помню, когда точно вкатился во всю эту тему с нейросетями — то ли в 2021 году, то ли в начале 2022 года, но с тех пор пытаюсь ими заниматься в меру сил и возможностями. Не создаю никаких шедевров, больше в прикладном плане — использование нейросеток в МРТ и КТ. Поглядывал, как там дела обстоят на других фронтах, но не более. В ту пору ничего зрелищного ещё не было — те же генеративные изображения выходили кривыми и не впечатляли.

Но примерно с осени 2022 года количественные изменения наконец-то перешли в качественные: вышла Midjourney v.4, порвал всех ChatGPT. С тех пор отошёл от чисто математики/физики и принялся следить за направлением уже пристально. И, как оказалось, не зря. Я хоть и гик и топлю за технологии/науку, но даже меня оторопь берёт, как всё быстро развивается. Год в нейросетях — это уже устаревшие технологии, которые мало кому нужны, а два года — древняя древность, не стоящая внимания вовсе.

Оценить, насколько сильно продвинулись генеративные сети, лучше всего на изображении и видео. Хотя прогресс идёт по всем областям, но математические задачки интересны узкому кругу красноглазых фанатов спецов, а вот визуально его оценить может даже не специалист. В качестве примера изображение, которое создавало Midjourney про одному и тому же промту:

Р азница между первым и последним — около 2 лет. В последних изображениях отличия не так заметны, но просто потому, что достигнут фотореализм — даже спец не отличит от обычного фото с фильтрами.

А вот так сетки прокачались в рисовании четырёхлапых:

Прогресс шёл не только по качеству изображения, но и по физике. Первые три версии выдавали что-то мало похожее на реального котейку.

Теперь же неспециалисту различить, где сгенерированное фото, а где реальное, очень сложно. Мало того — и спецу всё сложнее.

Конечно, в процессе развития бывали анекдотичные ситуации — нейросети любили рисовать дополнительные пальцы (не иначе, на что-то намекали), людей-раскоряк и всякую галиматью вместо текста (они его просто не понимали и рассматривали как изображение). Часто получалась прямо-таки крипота:

Однако очень быстро всё поправили и нейросети научились и в пальцы и в текст, и правильно понимать промт. Мало того — начали появляться нейросетевые редакторы, которые позволяли не просто сгенерировать изображение, а и отредактировать его без каких либо навыков. Сейчас существует с десяток сеток, которые выдают прекрасные картинки на уровне лучших художников. Мало того — нейросетки научились имитировать разные стили и продолжают учиться. На очереди — создание образа и возможность затем использовать его без изменений.

В тоже время, с видео всё было не так хорошо. Ну, оно и понятно — где одно изображение, а где целый набор? Да не просто набор, а связанные логически и художественно? В общем, сначала все довольствовались чем-то вроде такого:

И тут попробуй ещё пойми, что более страшное — люди или чудовище.

И как бы не бились разработчики, что-то вменяемое удалось создавать только из почти статичных картинок, да и то, длительностью только в 2-3 секунды на сцену. Но даже это смотрелось круто:

Однако было ясно, что не видать нам с таким прогрессом нормального порно видео ещё долгие годы.

И вот, в январе 2024 года я наткнулся на трейлер «Гарри Поттера и Молот Войны»:

Видео было сделано всего одним человеком, но смотрелось очень хорошо (и да, нужен фулл). Но даже с таким качеством картинки и постановки было понятно, что до нормального качества ещё далеко.

А уже в следующем месяце вышла Sora. И она была реально крута.

Выход Sora хотя и был несколько локальным событием, но прекрасно показал — пределов, оказывается, нет. Генерировать реалистичные видео если и сложнее, чем реалистичные изображения, то не намного:

Конкуренты, максимум которых тогда было слегко анимированное изображение, приуныли. Казалось, всё. Ну правда, кому они нужны, когда тут такое?

Однако доступ тогда к этой сетке дали лишь избранным, и, как оказалось, не без причины. Впоследствии выяснилось, что:

На создание нескольких секунд подобного видео уходит просто чудовищное количество компьюта (времени работы видеокарт);

Такие ролики получаются хорошо, если один раз на пятый;

Ошибки в физике всё равно встречаются частенько.

В общем, после некоторого периода спада народ опять бросился пилить свои видеонейросетки. И не зря — буквально через несколько месяцев у нас начали появляться Luma, RunWay, Kling и прочие, и прочие. Они выглядели не так впечатляюще, зато их можно было попробовать простым смертным. Народ тогда знатно упоролся в туже же Luma, оживляя изображения и мемы. Иногда получалось очень хорошо, но в целом эти нейросетки создавали нечто похожее и до Sora им было весьма далеко. Как оказалось, создать что-то действительно вменяемое сложно.

Энтузиасты, впрочем, не унывали и со временем у нас начали появляться ролики, которые не вызывали фейспалма:

Да, как что-то применимое в работе их было рассматривать трудно, но как демонстратор того, что при должной прямоте рук и времени можно сделать нормально — вполне. Графика достигла очень хорошего уровня (кое-где выйдя на уровень реальных съёмок, хоть и с особенностями), но в физику нейросети умели плохо.

И вот, на днях OpenAI наконец-то релизнула свою нейросеть Sora. Не только сам генератор, но и редактор, позволяющий проводить манипуляции с видео. Некоторые ролики, несмотря на огрехи, очень хороши:

Демо, представленные на сайте, впечатляюще выглядят, так что народ ринулся тестировать, несмотря на высокую плату (200 долларов за возможность генерить видео в 1080p). И разочаровался: несмотря на крайне достойную картинку, с физикой у генератора получилось не очень:

В общем, как и ранее, чтобы получить хороший результат, придётся постараться. Энтузиасты опять разошлись пилить ролики, но уже на более высоком уровне.

Далеко, правда, расходиться не пришлось — сегодня Google представил Veo 2.

Забавно, но Google Deep Mind, ребята из которого (тогда ещё Google Brain) в своё время и изобрели трансформерную архитектуру, сильно запоздали с развитием своих нейросетей. Ударившись в научные изыскания, они пропустили расцвет как генерации изображений, так и видео. Первые версии своих продуктов они представили в начала 2024 года и они откровенно проигрывали конкурентам. В общем, Google списали со счетов. И зря, как оказалось. После прохладного приёма работников загнали в шарашки пацаны и пацанессы собрались и к концу года выкатил-таки генератор изображений Imagen 3 и генератор видео Veo 2. И они реально хороши. Настолько, что по изображениям приблизились к конкурентам, а по видео — обошли всех:

Как утверждают разработчики, им удалось заметно снизить частоту галлюцинаций нейросеток, так что теперь кривоногих людишек и пропадающих вникуда объектов стало заметно меньше.

Им, разумеется, никто не поверил (народ уже учёный) и бросился сравнивать видео. Оказалось, что да — действительно заметно меньше артефактов, хотя не обошлось и без них:

Но пока все ждут, когда компания предоставит доступ всем желающим. Сейчас он только по талонам заявкам.

Над генерацией изображений и видео сейчас принято подшучивать. Есть за что: начиная от пресловутых пальцев и заканчивая непониманием устройства мира, когда нейросеть запросто может пририсовать берег моря внутри дома.

Однако ничего нового тут нет. Нейросети сейчас проходят этап становления, как и любая технология до них. Когда-то мобильная связь начиналась со звонилок, камера в которых казалось роскошью. А сейчас смартфоны оставили на обочине цифровые фотокамеры, плееры, часть консолей, заменили бумажные книги, калькуляторы, будильники и множество других предметов. И продолжают развиваться — на днях T-Mobile объявила о сотрудничестве со Starlink. Теперь позвонить, пообщаться в месседжерах или полазить в интернете можно вне зоны действия сотовой сети с обычного смартофона. Учитывая, что Starlink – глобальная спутниковая сеть, речь идёт о связи в любой точке мира (ну, кроме стран, где эта забугорная дрянь запрещена).

Ровно то же самое и с нейросетями, текущие проблемы которых можно разбить на несколько типов:

Высочайшая стоимость обучения и использования.

Эх, вот рано человечество изобрело трансформер. Лет через 20 всё было бы куда проще, а пока обучение и работа крупной нейросети на миллиарды параметров стоит очень дорого. Кластеры на сотни тысяч видеокарт — норма и компании уже задумываются о кластерах на миллионы карт. А это деньги, время, энергия… всего нужно много. Так что Дженсен «Куртка» Хуанг гребёт деньги лопатой, сделав свою Nvidia самой дорогой компанией в истории. Всем нужны его карточки, хотя конкуренты и пытаются вайтивайти и соорудить что-то своё.

Как бы там ни было — эта проблема проблемой не является. Несмотря на постоянные заявления скептиков о том, что энергия кончилась ещё вчера, чипы упёрлись в нанометровый барьер, общая выработка растёт год из года, а стоимость компьютерных мощностей падает. Модель, на обучение которой года два назад надо было потратить месяц, сегодня можно обучить за день-два на домашней стойке. Некоторые модели уже можно запихнуть на локальный компьютер.

Ошибки генерации.

Это те самые галлюцинации, когда пропадают и пропадают предметы и люди, происходит мешанина и прочее.

Проблема существенна, но тоже решаема, что и показывает развитие нейросетей. И главное — проблема решаема в короткие сроки. В 2021 году о нейросетях знали только энтузиасты, а теперь они проникают во все отрасли жизни. Нет сомнения — года через 3-4 практически от всех багов удастся избавиться. Вот тогда-то и настанет время роликов с тентаклями!

Недостаток данных.

Большие языковые модели так устроены, что чем больше данных в неё для обучения подашь, тем лучше они работают. В своё время именно масштабирование позволило совершить прорыв в работе моделей. Увы, доступные данные ограничены и они если не близки к исчерпанию, то где-то близко. На десятилетия их точно не хватит. Значит, развитие моделей должно прекратиться.

На деле же никакого прекращения развития не ожидается. Во-первых, новые данные появляются постоянно и чем дальше, тем их становится больше. С видео это особенно заметно — стоит человеку завести телефон, как он тут же стремится выложить всю свою жизнь в сториз. Людей, у которых до сих пор нет смартфона, огромное количество. Рано или поздно они точно также подключатся к сети и начнут выкладывать видео. Вдобавок, никто не мешает компаниям нанимать дата-майнеров — людей, которые будут по заказу снимать видео на заданные темы. Работа для студентов, школьников и просто всех подряд, которая позволит взять дешёвой массовостью.

Во-вторых, результат очень сильно зависит от качества данных. Одно дело просто снять ролик и обозначить его как «закат на реке», и совсем другое — разметить видео «тут река-тут берёза-тут собака пробежала». Чем выше качество данных, тем меньше их требуется. Разница вполне может достигать пары порядков. Так что помимо дата-майнеров у нас могут появиться ещё и разметчики.

Наконец, разработчики меняют сами подходы. Недавно прошёл эксперимент по распределённой тренировке нейросети. Результаты заметно хуже, чем при обучении в дата-центре, но приемлемы, учитывая первый опыт. Так что рано нести свою видеокарту на Авито, она ещё пригодится. Есть попытки провернуть нечто подобное и с процессорами, хотя они для такого не предназначены.

Кроме эксперимента, меняются и алгоритмы. Нейросети начинают учиться на собственных сгенерированных данных, контроль которых осуществляет часть сети. Скайнет? Оно самое. Трудности есть и тут, но метод рабочий.

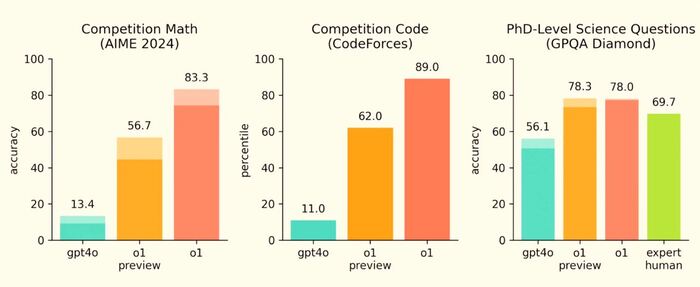

Относительно недавно начал распространяться подход к работе, когда нейросеть рассуждает шаг за шагом, а не пытается выявить закономерности. Он уже показал отличные результаты в некоторых областях. Есть ещё целый ряд алгоритмических улучшений. Нынешние нейросети — это совсем не те нейросети, которые были ещё пять лет назад.

Так что повторимся — технология сейчас проходит начальный этап развития, ошибки и проблемы неизбежны. Ну а скептики, любящие говорить про «никогда», в очередной раз ошибутся. Как оно и бывало ранее.

P.S. Ещё у меня есть бессмысленные и беспощадные ТГ-каналы (ну а как без них?):

Про игры и игровую индустрию: https://t.me/gameprodev;

Мой личный, куда сваливается наука и всякое гиковское: https://t.me/deeplabscience.

Только что вышедшая на свободу нейросеть SORA, уже способна просто по текстовому запросу создать почти полноценный трейлер несуществующего блокбастера. С учетом того, с какой скоростью они(нейросети) эволюционируют, через год-два я смогу заказать себе уже полнометражный фильм на свой вкус. Я уже составляю список своих "хотелок"). Например окунуться в детство и посмотреть несуществующий второй сезон про Алису Селезнёву и её приключения в космосе. Причем с артистами из того времени, а не этот современный новодел с кудрявым и смазливым Колей Герасимовым. Или анонсированную в "Бриллиантовой руке", но так и не вышедшую кинокомедию "Костяная нога".)) #нейросети #кино #будущее #технологии #трейлер #фантастика #SORA

Пока Sora еще раскатывается на всех пользователей, появились первые отзывы от счастливых обладателей доступа за 200 баксов 😅

Напомню, что Sora это тот самый очень ожидаемый видео генератор от OpenAI (примеры генераций на видео), которого ждали год и как и ожидалось доступ открыли после выборов США во избежании фейков.

Так вот первые пользователи не сказать, что в восторге - большое количество брака из 15 генераций только одна более менее окей, выкрученные фильтры, чтобы вы на генерили чтобы-нибудь такого криминального или порнушного😎

Видится так, что сейчас OpenAI ищет какой-то баланс и перестраховывается и назвать это классным видео генератором нельзя.

👉Поэтому, друзья, вот список вполне рабочих видео генераторов, не хуже и дешевле, которые можно юзать для своих целей

1. Kling - Простая и удобная платформа для генерации видео с AI, подходит для создания контента с минимальными затратами. Платные тарифы начинаются от $10 в месяц, предоставляя 660 кредитов;

2. Runway - Мощный инструмент для редактирования видео и создания спецэффектов с помощью машинного обучения. Платные подписки начинаются от $15

3. Luma - Специализируется на 3D-визуализации и создании высококачественных видео из изображений Платные планы начинаются от $10 в месяц за 70 видео.

4. Minimaх - Доступный генератор видео с акцентом на простоту и эффективность. Бесплатный план предоставляет 3 генерации в день с ожиданием в очереди от 5 до 60 минут. Платные тарифы начинаются от $10 в месяц

Больше про нейросети тут: https://t.me/robotfleksa

Привет, друзья! OpenAI наконец-то представила публичную версию своего видеогенератора — Sora Turbo. Почти год назад я писал о первых демо этой технологии, и мы все были в полном восторге от показанных возможностей. Меня зовут Илья, я основатель онлайн-нейросети для создания изображений ArtGeneration.me, техноблогер и нейро-евангелист, и сегодня мы с вами разберем, что же на самом деле получили пользователи после года ожиданий. И спойлер — всё оказалось совсем не так радужно, как нам обещали.

OpenAI презентовала видеогенератор, который создаёт ролики в 1080p длиной до 20 секунд (хотя все демки длиной 5-10 секунд и в разрешении 960). Можно использовать текстовые описания, картинки или видео как референсы, плюс есть интерфейс для тонкой настройки кадров. На первый взгляд звучит неплохо, правда? Но давайте копнем глубже.

Первый подводный камень — доступ к модели получают только подписчики ChatGPT Plus и Pro.

ChatGPT Plus ($20/месяц):

До 50 приоритетных видео (1000 кредитов)

Разрешение до 720p и длительность до 5 секунд

ChatGPT Pro ($200/месяц):

До 500 приоритетных видео (10,000 кредитов)

Неограниченное количество обычных видео

Разрешение до 1080p, длительность до 20 секунд и 5 одновременных генераций

Загрузка без водяного знака

Второй камень гораздо больше — сервис недоступен там, где нет официального ChatGPT, плюс в ЕС и Великобритании из-за их законодательства.

Тут всё упирается в экономику. По моим оценкам, минута видео на оригинальной Sora могла стоить несколько сотен долларов. Запустить сервис с такими ценами было бы самоубийством. Но сейчас у OpenAI, похоже, не осталось выбора: каждую неделю появляются новые видеогенераторы, а с ChatGPT-5 пока нет значимых успехов. Пришлось выпускать то, что есть.

Эта версия Sora совсем не та, что нам показывали год назад. Той впечатляющей физики в демках больше нет. Качество картинки заметно хуже, везде видны следы работы апскейлера и интерполятора. Честно говоря, текущая версия даже не выглядит лучше существующих решений на рынке. А их, кстати, уже немало.

Я как раз собираюсь провести сравнение всех видео генераторов, потому собрал список всех проприетарных технологий генерации видео:

И все они активно развиваются, удаться ли openai их вообще догнать?

Даже если вы загорелись идеей попробовать эту версию Sora, скорее всего у вас ничего не выйдет. Жёсткие региональные ограничения плюс сообщение "Account creation currently unavailable" эффективно блокируют доступ большинству пользователей. А обходить эти ограничения и ждать когда регистрацию откроют ради такого результата...

В опенсорс Sora точно не выйдет, это даже обсуждать не стоит. Чем OpenAI планирует конкурировать на уже насыщенном рынке — большой вопрос. Возможно, стоило дождаться, пока технология действительно будет хороша? А то получилось как обычно: обещали революцию, а выдали... ну, сами видите что. Уровень любого китайского генератора.

Пишите в комментариях свои мысли об этом релизе. Может, кому-то уже удалось потестить? Удивили ли вас результаты по вашим запросам?

Научиться создавать крутые изображения https://neuralprofit.ru/

ChatGPT o1 вышла на замену ChatGPT o1 preview, считавшейся самой продвинутой. Теперь можно загружать изображения, ответы стали быстрее на 60%, улучшилось написание кода и решение математических задач.

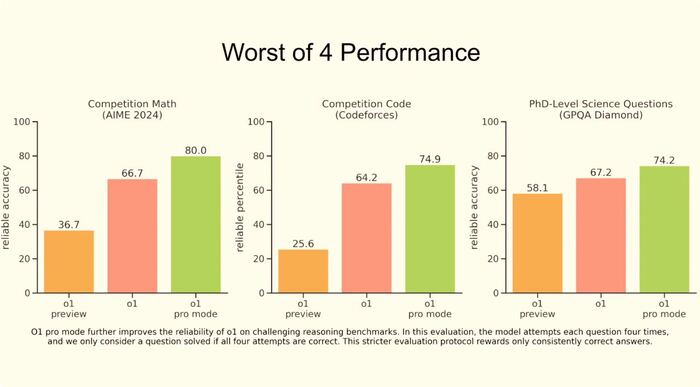

Так же вышла ChatGPT o1 Pro - самая мощная модель за 200$ в месяц для топов в своем деле, которым нужен качественный анализ больших данных или стратегическое планирование, и они готовы за это платить, и главное, это окупается.

Что дает подписка за 200 баксов пользователям для рядовых задач? Разве что обход ограничений. OpenAI так стимулируют купить подписку, что теперь для тарифов Plus и Team ввели ограничения: в o1 доступно 50 сообщений в неделю; в o1-mini доступно 50 сообщений в день. Еще и безлимитную Sora, об этом ниже.

Более подробно, как использовать ChatGPTдля своих задач и правильно составлять промпты мы учимся в Закрытом сообществе Нейроучеба. Там же вы научитесь применять нейросети для работы и учебы. Присоединяйтесь к сообществу единомышленников сегодня!

OpenAI наконец-то официально выпустили - Sora - перед нажатием убедитесь, что вы в США и других странах (кроме ЕС, Великобритании и Китая). До этого многие уже начали сомневаться, а существует ли она в природе? Или дадут ли ее обычным пользователям, а не только киностудиям?

Почему все так ждали этот видеогенератор, и почему он такой революционный, я рассказала здесь.

– Создавать видео по текстовому промту и анимировать изображения

– Комбинировать два видео

Подробнее про эти функции я рассказала здесь

Доступ постепенно дают платным пользователям ChatGPT, естественно с лимитом в 50 генераций. Но мне, в данный момент не удалось создать учетку и попробовать, потому что:

Создание учетной записи Sora временно недоступно. В настоящее время мы испытываем большую нагрузку и временно отключили создание учетных записей Sora. Если вы еще ни разу не входили в Sora, пожалуйста, зайдите на сайт в ближайшее время.

Помимо впечатляющих примеров видео на сайте Sora есть крутые видео с промтами и советами на сайте OpenAi , где они подробно рассказали про новую модель, про лимиты тарифных планов ChatGPT - куда включена теперь и Sora, забегая вперед скажу, что качество в 1080p и без вотермарок скачать видео вы сможете только за 200$, а за 20$ извольте получить только 720p.

Где доступна Sora: США и другие страны (кроме ЕС, Великобритании и Китая).

В общем, есть над чем подумать, за 200 $/месяц и безлимит на Sora и суперумная модель ChatGPT в придачу, или пока оставаться на 20$. И если ChatGPT o1 реально нужен пока не столь большому числу людей, остальные прекрасно для своих задач будут использовать ChatGPT за 20$, то безлимитная Sora нужна всем, кто профессионально связан с производством видеоконтента, это уже вопрос конкурентоспособности

Подпишитесь на НейроProfit и узнайте, как можно использовать нейросети для бизнеса, учебы и работы, не теряя свое время.

Компания OpenAI торжественно анонсировала запуск своего последнего достижения в области искусственного интеллекта - нейросети Sora, разработанной для генерации видео. Эта долгожданная нейросеть, которая уже на стадии пробных запусков показала себя лучше предшественников по качеству и функциональности, теперь доступна широкой публике. В прошлом для создания циклических видео использовалась система Luma, а Kling Ai помогала в реализации реалистичных анимаций. Теперь Sora Ai объединила эти возможности и добавила эксклюзивные функции.

Нейросеть от OpenAI, Sora, будет предоставлена для использования внутри США и за её пределами.

Те, кто подписался на премиальный план ChatGPT Plus Pro, получат доступ к Sora без необходимости вложений.

Усовершенствованная версия Sora Turbo расширит функционал, предоставляя возможности для преобразования текста в видео, оживления изображений и создания видео-ремиксов.

Назначение Sora:

ИИ Sora был разработан для понимания мира и его физических закономерностей, что позволило ему обучаться, анализируя видеоматериалы.

Создание видео:

Возможность генерировать видеоконтент из текстовых промптов или изображений с возможностью выбора формата, разрешения и длительности.

Поддерживаются форматы: квадратный, вертикальный и горизонтальный.

Максимальное разрешение видео достигает 1080p.

Максимальная длительность видео ограничена 20 секундами.

Обычно затрачивается от семи до десяти минут на создание десятисекундного видеоклипа. Тем не менее, этот промежуток времени может расшириться из-за ограничений на быструю генерацию, применяемых к профессиональным аккаунтам.

Сториборд - это передовой инструмент редактирования, который позволяет устанавливать последовательность сцен. Пользователи могут детализировать особенности персонажей, назначать им действия и добавлять подходящие изображения для создания видеонарратива. Платформа Sora предоставляет интерфейс, схожий с общепринятыми видеоредакторами.

Опция Remix: Этот функционал дает возможность модифицировать уже созданные видеоролики, где пользователь лишь отмечает необходимые изменения, а Sora самостоятельно преобразует контент.

Опция Recut: Обеспечивает инструменты для монтажа и компоновки видео, в том числе внедрение новых фрагментов и модификацию структуры проекта.

Уникальные возможности: Функции зацикливания (Loop) и объединения двух кадров (Blend) открывают новые горизонты для креативности пользователей.

Первая версия Sora может содержать определенные огрехи; однако, она уже представляет собой ценный ресурс для выполнения творческих заданий.

Скоро возможности искусственного интеллекта Sora будут внедрены в @yes_ai_bot, благодаря чему вы сможете обойтись без платной подписки Pro в OpenAI, которая обходится в $200.

Чтобы быть в курсе свежих обновлений, присоединяйтесь к нашему Telegram-каналу: @yes_ai_official

Официальный сайт нейросети: https://sora.com

Подписчики ChatGPT Plus из США смогут воспользоваться новой нейросетью для создания видео на сайте https://sora.com/. Жители других стран получат доступ к сервису позже на этой неделе.

Sora генерирует видео продолжительностью до 20 секунд с разрешением 480p, 720p и 1080p. В интерфейсе можно объединять короткие ролики в одно длинное видео, создавая единую сюжетную линию.

Дождались, господа!