Цифровое вырождение в замкнутом круге

Биологи давно знают, что происходит с изолированными популяциями. Когда генетическое разнообразие падает, если близкие родственники скрещиваются между собой на протяжении всего пары поколений, начинается неизбежная деградация. Невероятно быстро накапливаются вредные мутации. Снижается жизнеспособность. Появляются уродства. Европейские монархические династии продемонстрировали это с впечатляющей наглядностью: Габсбурги с их знаменитой выступающей вперед нижней челюстью; гемофилия среди потомков королевы Виктории. Генетический материал, циркулирующий в замкнутом контуре, превращается в яд для самого себя.

С искусственным интеллектом происходит то же самое, только быстрее.

Явление получило научное название — model collapse, коллапс модели. Суть проста: когда языковая модель обучается на текстах, сгенерированных другими языковыми моделями, она начинает терять качество. Причём не линейно, а катастрофически. Исследования показывают, что уже через пять-семь поколений такого "самообучения" модель превращается в нечто бесполезное. Она начинает повторяться, генерировать однообразный текст, галлюцинировать несуществующие факты с ещё большей уверенностью, чем раньше.

Это очень напоминает игру в испорченный телефон, где каждый следующий участник слышит только предыдущего; искажения накапливаются, нюансы теряются, ошибки усиливаются. Но с ИИ всё хуже: модели не просто передают информацию — они её интерпретируют, упрощают, приглаживают острые углы. Каждое новое поколение обучается на чуть более гладкой, чуть более усреднённой, чуть менее разнообразной версии реальности. Редкие слова исчезают. Сложные конструкции упрощаются. Остаются только самые частотные паттерны, самые банальные формулировки.

Интернет, который должен был стать тренировочной площадкой для ИИ, превращается в закрытый генофонд. По некоторым оценкам, уже сейчас от 30% до 50% нового контента в сети генерируется алгоритмами. SEO-статьи, написанные ChatGPT. Обзоры товаров от ботов. Новости, пересказанные нейросетью. Посты в соцсетях, комментарии, описания — всё это попадает обратно в датасеты для обучения следующих моделей.

Получается идеальный замкнутый круг. ИИ генерирует контент. Этот контент индексируется поисковиками, сохраняется в архивах, собирается в новые датасеты. Следующее поколение ИИ обучается на этой смеси человеческого и машинного текста. Генерирует ещё больше контента. И так далее, с каждым циклом доля "чистого" человеческого текста уменьшается.

Династия цифровых Габсбургов обречена на вырождение. Вопрос только в том, как быстро это произойдёт и заметит ли кто-нибудь момент, когда ИИ из умного помощника превратится в гиперактивного идиота.

Кто понимает угрозу

Разработчики крупных языковых моделей знают о проблеме. В научных статьях появляются тревожные графики, показывающие, как быстро деградирует качество при обучении на синтетических данных. На конференциях обсуждают методы фильтрации ИИ-контента из датасетов. Создаются детекторы, водяные знаки, системы верификации.

Но рынок требует другого. Каждый квартал нужна новая модель, ещё больше параметров, ещё шире охват. Данных для обучения требуется всё больше, а качественного человеческого контента — конечное количество. Книги оцифрованы. Научные статьи собраны. Reddit проиндексирован. Что дальше? Приходится скрести по сусекам интернета, где синтетический мусор уже неотделим от настоящего.

Тех-гиганты инвестируют друг в друга круговыми потоками. Microsoft вкладывается в OpenAI. Google гонится за собственными разработками. Amazon, Meta — все в игре. Капитализация растёт головокружительно, а вот реальная окупаемость ИИ-продуктов остаётся под большим вопросом. Инвесторы пока готовы верить в будущую прибыль, но пузырь держится именно на вере и взаимных вливаниях, а не на конкретных доходах. Главное — поддерживать биржевую стоимость, а там хоть потоп.

Обычные пользователи проблемы не видят вообще. Поисковик выдаёт результаты — значит, работает. ChatGPT отвечает на вопросы — значит, полезен. Статья выглядит нормально написанной — значит, можно ссылаться. Фотография растения убедительна — значит, можно покупать семена. Порог чувствительности к качеству у большинства довольно высок. Пока ответ выглядит правдоподобно, пока не бросаются в глаза очевидные глупости — всё устраивает.

Экологи интернета — те немногие, кто пытается привлечь внимание к проблеме загрязнения информационного пространства — остаются голосом в пустыне. Их предупреждения звучат абстрактно. "Деградация качества данных", "эрозия доверия", "информационная экология" — всё это кажется чем-то далёким, академическим, не относящимся к повседневной жизни.

Ситуация напоминает ранние этапы осознания климатического кризиса. Учёные предупреждали десятилетиями, но пока последствия не стали очевидными для каждого, проблема казалась преувеличенной. С цифровым инцестом похожая история. Только деградация здесь может произойти гораздо быстрее. Не за столетия, а за годы.

Рукопись Войнича

Чтобы понять, насколько опасна ситуация с самообучением ИИ на собственном мусоре, стоит взглянуть на исторический прецедент. Единичный случай, который мучает исследователей уже больше века.

В 1912 году антиквар Вилфрид Войнич купил на вилле Мондрагоне близ Рима старинную рукопись. 240 страниц пергамента, исписанных неизвестным алфавитом. Странные растения с невозможной анатомией. Обнажённые женские фигуры в бассейнах, соединённых трубами. Астрономические диаграммы без понятной логики. Радиоуглеродный анализ позже покажет: пергамент датируется началом XV века. Чернила — того же времени.Подделка исключена.

За столетие с лишним рукопись пытались расшифровать лучшие криптографы мира. Во время Второй мировой над ней бились взломщики кодов. В XXI веке подключили компьютеры, машинное обучение, статистический анализ. Результат неизменный: ничего. Текст обладает статистическими свойствами естественного языка — распределение частот букв, структура слов, даже что-то похожее на грамматику. Но смысла извлечь не удаётся.

Появились три основные теории. Первая: это шифр, настолько изощрённый, что превосходит возможности своей эпохи. Вторая: это искусственный язык, созданный для какой-то эзотерической цели. Третья, самая циничная: это мистификация. Кто-то в XV веке решил создать книгу, которая выглядит значимой, полна таинственности и намёков на глубокое знание, но на самом деле не содержит ничего. Бессмыслица, тщательно замаскированная под мудрость.

Последняя версия выглядит всё более правдоподобной. Лингвистический анализ показывает: текст слишком простой для настоящего языка, слишком однообразный. Слова повторяются с подозрительной частотой. Структура предложений примитивна. Похоже на то, что кто-то создал систему правил — своего рода алгоритм — и методично генерировал страницу за страницей правдоподобно выглядящей тарабарщины.

Растения в иллюстрациях тоже подозрительны. Они напоминают реальные виды, но при ближайшем рассмотрении оказываются химерами — корни от одного растения, листья от другого, цветы от третьего. Ботаники не могут идентифицировать ни один вид. Возможно, автор просто фантазировал, комбинируя знакомые элементы в невозможные сочетания.

Рукопись Войнича — это средневековый генератор контента. Человек или группа людей потратили месяцы, может быть годы, создавая артефакт, который имитирует знание, но знанием не является. И преуспели настолько, что обманывают исследователей спустя шесть веков.

ИИ-мусор — индустриализация бессмыслицы

Разница между рукописью Войнича и современным ИИ-мусором начинается с мотивации. Зачем средневековый автор потратил годы на создание нечитаемой книги — загадка. Может, это была интеллектуальная игра, алхимический трактат, мистификация ради славы. Цель остаётся неясной спустя шесть веков.

С ИИ-мусором всё предельно прозрачно: деньги. Попасть в топ поисковой выдачи, собрать трафик, показать рекламу, получить клики по партнёрским ссылкам. Чем больше контента, тем выше шансы на монетизацию. Качество вторично. Главное — чтобы поисковые алгоритмы проиндексировали, а пользователь кликнул.

Начиналось невинно. SEO-оптимизаторы первыми поняли, что можно автоматизировать производство текстов для продвижения сайтов. Статьи о "лучших способах похудеть" или "топ-10 смартфонов 2024 года" штамповались конвейером. Качество было отвратительным, но поисковикам этого хватало. Алгоритмы ранжирования смотрели на ключевые слова, длину текста, структуру заголовков — а не на смысл.

Потом появились GPT-3, GPT-4 и их многочисленные клоны. Качество сгенерированного текста резко выросло. Теперь статья, написанная ИИ, могла выглядеть вполне прилично. Грамматика правильная, логика не хромает, даже стиль сносный. Отличить от человеческого текста стало труднее. А значит, и монетизировать проще.

Индустрия контент-ферм расцвела пышным цветом. Сайты, полностью состоящие из ИИ-статей. Блоги, где боты пишут посты и комментируют друг друга. Интернет-магазины с тысячами автоматически сгенерированных описаний товаров. Новостные агрегаторы, пересказывающие чужие новости через нейросеть — чтобы избежать обвинений в плагиате. Фейковые обзоры, накрученные рейтинги, сфабрикованные отзывы. Каждый элемент оптимизирован под одну цель: заработок.

По некоторым оценкам, к концу 2024 года от трети до половины всего нового текстового контента в интернете создаётся алгоритмами. Точную цифру установить невозможно — детекторы ИИ-текста работают неидеально, а создатели мусора постоянно совершенствуют методы маскировки.

К текстам добавились изображения. Midjourney, Stable Diffusion, DALL-E наводнили интернет картинками, которые никогда не существовали в реальности. Фотостоки заполнились синтетическими фотографиями людей, пейзажей, объектов. Pinterest превратился в галерею цифровых миражей. Образовательные сайты начали иллюстрировать статьи сгенерированными изображениями — дешевле, чем покупать настоящие фотографии или нанимать художников.

Видео, музыка, даже программный код — всё это теперь генерируется автоматически и в промышленных масштабах. Экономическая логика железная: производство синтетического контента стоит копейки, монетизировать можно через рекламу, подписки, сбор данных.

Никто не проверяет качество. Главное — количество, охват, трафик. Пользователи кликают, алгоритмы индексируют, рекламодатели платят. Система работает. То, что интернет при этом превращается в свалку правдоподобно выглядящего мусора — это уже детали.

Рукопись Войнича была диковинкой с непонятной целью. ИИ-мусор — это индустрия с предельно ясной бизнес-моделью.

Фейковая ботаника и теневые энциклопедии

Среди всего многообразия ИИ-мусора даже фейковые растения занимают своё место. Это не просто бессмысленный текст ради SEO — это создание чуть ли не параллельной ботаники.

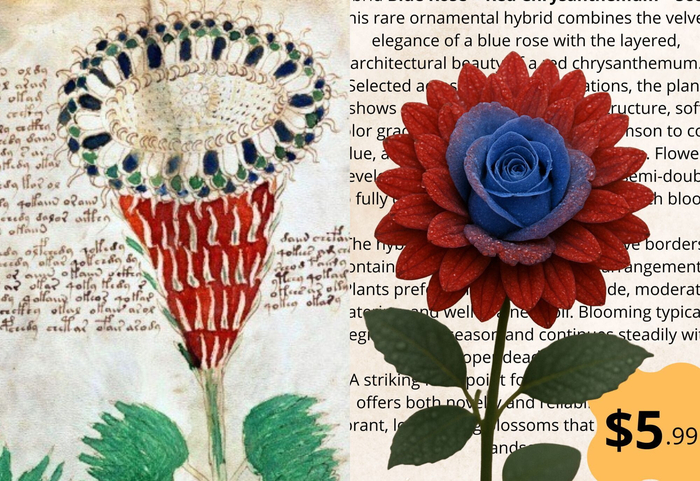

Механизм прост. Нейросеть генерирует изображение растения, комбинируя признаки реальных видов. Получается что-то правдоподобное: стебель как у одного растения, листья как у другого, цветы как у третьего. Визуально убедительно. Ботаник при внимательном изучении заметит несоответствия, но обычный пользователь — нет.

Дальше к изображению добавляется описание. Латинское название, условия произрастания, особенности ухода, лечебные свойства. Всё генерируется тем же ИИ на основе реальных ботанических текстов. Получается связный, научно звучащий текст о растении, которого не существует.

Эти фантомные виды попадают в Pinterest, где их сохраняют тысячи пользователей в коллекции "Редкие растения" или "Что посадить в саду". Они просачиваются в образовательные блоги, где иллюстрируют статьи о биоразнообразии. Оседают в базах данных небольших сайтов о садоводстве.

Появились интернет-магазины, продающие семена этих несуществующих растений сгенерированных ИИ. Сами сайты тоже сгенерированы ИИ — дизайн, тексты, структура страниц. Фотографии, подробные инструкции по посадке, отзывы довольных покупателей — всё синтетическое. Цены умеренные, доставка обещана быстрая. Что именно получают покупатели — отдельный вопрос. Может, семена чего-то реального, но не того, что на картинке. Может, вообще ничего. Жалоб удивительно мало.

Студенты пишут курсовые работы о фейковых видах, находя "информацию" в интернете. Школьники готовят доклады, скачивая сгенерированные изображения. Преподаватели не всегда могут отличить выдумку от реальности — ботаника обширна, никто не знает все виды наизусть.

Постепенно накапливается теневая флора. Растения, которых нет в гербариях и научных каталогах, но которые существуют в интернете с фотографиями, описаниями и даже "фактами" об их применении. Цифровые бестиарии XXI века, где химеры выглядят убедительнее реальных организмов.

Проблема распространяется на животных, минералы, исторические события, медицинские препараты. Создаётся параллельная энциклопедия — правдоподобная, детализированная, полностью вымышленная. И эта энциклопедия становится частью датасетов для обучения следующих поколений ИИ.

Рукопись Войнича хотя бы изолирована в библиотеке. Фейковые растения интегрируются в живое знание, размывая границу между реальным и сгенерированным.

Последствия для настоящего — деградация на глазах

Большинство пользователей замечает проблему только когда сталкивается лично. Поисковик выдаёт десять статей на один вопрос — все похожи, все ни о чём. Рецепт блюда переписан пятью разными сайтами с минимальными вариациями, но ни один не работает. Техническая документация содержит противоречивые инструкции. Медицинский совет с одного ресурса противоречит другому, хотя оба ссылаются на "исследования".

Поисковые системы теряют полезность. Google, Yandex, Bing — все борются с потоком синтетического контента, но проигрывают. SEO-оптимизаторы адаптируются быстрее, чем обновляются алгоритмы ранжирования. Результат: первая страница выдачи заполнена правдоподобным мусором, а действительно полезная информация спрятана на третьей-четвёртой странице, куда почти никто не доходит.

Образование под ударом. Студенты пишут работы, используя ИИ-сгенерированные источники. Преподаватели проверяют работы, не зная, что половина ссылок ведёт в никуда или на фейковые данные. Школьники готовят доклады о несуществующих исторических событиях, найденных в интернете. Система образования всегда полагалась на верифицируемость источников — теперь эта верифицируемость размыта.

Научные базы данных начинают загрязняться. Препринты, автоматически сгенерированные статьи, фальшивые исследования с правдоподобными графиками просачиваются в репозитории. Рецензирование не справляется — объём публикаций растёт экспоненциально, а рецензентов не становится больше.

Доверие к онлайн-информации падает, но альтернативы нет. Библиотеки закрываются, печатные энциклопедии не обновляются, эксперты дороги и недоступны. Интернет остаётся основным источником знаний для миллиардов людей. Только теперь этот источник всё больше напоминает болото, где настоящее и поддельное неразличимы.

Экономика контента рушится. Журналисты, писатели, фотографы, художники конкурируют с бесплатным ИИ-контентом. Зачем платить автору, если нейросеть напишет статью за секунды? Зачем покупать фотографии, если Midjourney сгенерирует любую картинку? Профессионалы уходят из индустрии. Остаются только те, кто может конкурировать ценой — то есть алгоритмы.

Теория "мёртвого интернета" перестаёт быть теорией заговора. Боты общаются с ботами, алгоритмы генерируют контент для алгоритмов, люди становятся меньшинством в цифровом пространстве. И самое страшное: большинство этого не замечает, пока система ещё как-то работает.

Загадка для цифровых археологов

Представьте историка 2124 года, изучающего начало XXI века. Перед ним — петабайты данных. Тексты, изображения, видео, социальные сети, новостные ленты. Казалось бы, самая задокументированная эпоха в истории человечества.

Но как отличить реальное от сгенерированного? Фотография события — настоящая или синтетическая? Новостная статья написана журналистом или алгоритмом? Обсуждение в комментариях ведут люди или боты? Отзыв на товар оставил покупатель или программа?

Детекторы ИИ-контента, если они вообще сохранятся, будут бесполезны. Технологии генерации совершенствовались быстрее технологий детекции. К тому же, многие файлы потеряют метаданные, пройдут через конвертации и сжатия, будут скопированы и переделаны десятки раз.

Физических артефактов нет. Рукопись Войнича можно потрогать, изучить пергамент, проанализировать чернила. Цифровые файлы не оставляют материальных следов. Всё, что есть — биты данных, которые могли быть созданы кем угодно и когда угодно.

Перекрёстная проверка не работает. Обычно историки верифицируют информацию, находя её в нескольких независимых источниках. Но если десять сайтов ссылаются на одно и то же фейковое растение, это не делает растение реальным. Это просто значит, что мусор был скопирован десять раз.

Что останется достоверным? Возможно, государственные архивы, если их защищали от цифрового загрязнения. Возможно, академические публикации из проверенных журналов — хотя и они не застрахованы. Возможно, личные дневники и письма людей, которые вели их по старинке.

Остальное превратится в цифровой эквивалент рукописи Войнича. Огромный массив данных, который выглядит информативным, но большей частью нечитаем в смысле достоверности. Историки будут гадать: это документ эпохи или артефакт алгоритма? Исследователи 2124 года столкнутся не с одной загадочной рукописью, а с целой эпохой, где граница между реальностью и симуляцией размыта безвозвратно.

Есть ли выход?

Технические решения существуют, но все они играют в догонялки. Детекторы ИИ-контента анализируют статистические паттерны текста, ищут признаки машинной генерации. Работают неплохо — пока создатели мусора не адаптируют свои алгоритмы. Через несколько месяцев детекторы устаревают, требуют обновления, а новые методы генерации уже обходят защиту.

Цифровые водяные знаки — встраивание незаметных маркеров в ИИ-контент — звучат перспективно. OpenAI, Google, другие компании экспериментируют с этой технологией. Проблема в добровольности. Крупные игроки могут маркировать свои модели, но что с открытыми алгоритмами? Что с китайскими, российскими, любыми другими моделями, которые не подчиняются западным стандартам? Водяные знаки работают, только если их используют все. А их не будут использовать все.

Блокчейн-верификация контента предлагает фиксировать происхождение каждого файла в распределённом реестре. Теоретически элегантно. Практически — кто будет это внедрять и поддерживать? Как заставить миллиарды пользователей и миллионы сайтов участвовать в этой системе?

Возможно, спасение в кураторстве. Появление верифицированных зон интернета, где контент проходит человеческую проверку. Что-то вроде цифровых заповедников качественной информации. Академические базы данных с жёстким рецензированием. Новостные агентства с репутационной ответственностью. Образовательные платформы с проверенными материалами. Дорого, медленно, элитарно — но достоверно.

Законодательное регулирование могло бы помочь. Обязательная маркировка ИИ-контента, ответственность платформ за распространение синтетического мусора, штрафы за создание фейковых коммерческих сайтов. Европейский союз уже движется в этом направлении. Эффективность под вопросом — интернет глобален, юрисдикции ограничены.

Образование критическому мышлению, может быть, самое важное. Учить людей проверять источники, сомневаться в правдоподобном, искать первоисточники, понимать ограниченность онлайн-информации. Долго, сложно, результаты не гарантированы.

Архивирование "чистого" интернета — сохранение контента, созданного до массового распространения ИИ-генерации. Проекты вроде Internet Archive становятся не просто хранилищами истории, а резервуарами достоверности.

Все эти меры могут замедлить деградацию. Остановить — вряд ли. Экономические стимулы слишком сильны, технологии слишком доступны, контроль слишком сложен. Окно возможностей закрывается быстро.

Заключение

Рукопись Войнича ценна именно своей уникальностью. Одна загадочная книга среди миллионов читаемых — это интеллектуальный вызов, объект исследований, источник теорий. Она не мешает получать знания из других источников. Она не подрывает доверие к средневековым манускриптам вообще.

Превращение всего интернета в такую рукопись — задача иного масштаба. Когда правдоподобный мусор становится нормой, система знания рушится изнутри. Не внезапно, не катастрофически — медленно, почти незаметно, пока порог не пройден.

Самоусиливающийся цикл уже работает. Машины учатся у машин, датасеты загрязняются собственными продуктами, граница между достоверным и синтетическим размывается. Через десять лет археологи будущего столкнутся с эпохой, где невозможно верифицировать базовые факты. Через двадцать — ИИ превратится в бесполезный инструмент, обученный на собственных галлюцинациях.

Заметят, когда станет поздно. Когда поисковики перестанут находить что-либо достоверное. Когда образование потеряет опору в проверяемых источниках. Когда наука утонет в потоке синтетических публикаций.

Экологи интернета говорят об этом сейчас, но их мало кто слушает. Проблема кажется абстрактной, далёкой, преувеличенной. Ровно так же когда-то казался преувеличенным климатический кризис.

Разница в скорости. Климат деградирует столетиями. Интернет может превратиться в нечитаемую загадку за годы.