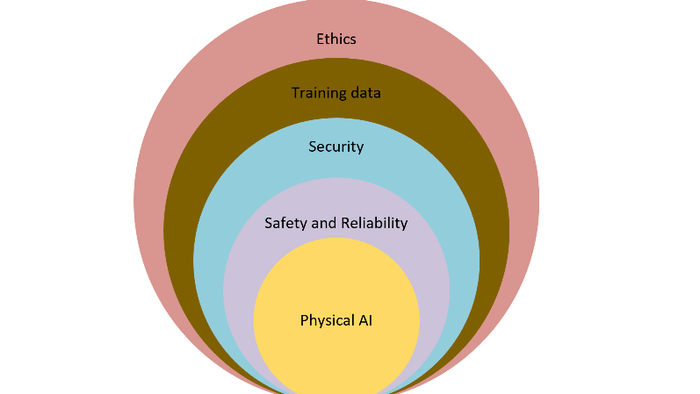

Как создать физическую систему безопасности на основе ИИ

Что такое физический ИИ и чем он отличается от LLM‑ИИ?

Физический ИИ — это система искусственного интеллекта с интегрированными механическими компонентами, способная выполнять физические действия в реальном окружении, получая обратную связь от датчиков. В отличие от традиционных больших языковых моделей (LLM), таких как ChatGPT или Claude, которые работают в виртуальном пространстве, физический ИИ взаимодействует с материальным миром.

Термины «generative physical AI», «embodied AI» и другие обозначают схожие системы; различия между ними несущественны для анализа безопасности.

Примеры физических ИИ

Частично или полностью автономные персональные роботы и автономные транспортные средства (AV).

Промышленные коллаборативные роботы, автономные дроны и аналогичные системы с интегрированным ИИ.

Все эти применения обладают уникальными вызовами, но объединяются общими проблемами безопасности и надежности.

Основные уязвимости физического ИИ

Уязвимости схожи с теми, что встречаются в системах промышленной автоматизации (IACS): система сильна лишь настолько, насколько прочна её самая слабая часть.

Кодовая база может достигать миллионов строк, создавая обширную поверхность атаки.

Архитектуры ИИ могут быть удалёнными (серверы, облако), локальными (edge) или гибридными. Edge‑решения потенциально более защищённы, но ограничены вычислительной мощностью.

Возможны удалённые захваты управления, направленные на вымогательство, отключение функций безопасности или иные вредоносные действия.

Непреднамерённые риски и человеческий фактор

Ошибки при обновлении программного обеспечения или модификации системы могут вводить новые уязвимости.

Обновления «по воздуху» (OTA) подвержены атакам типа «человек посередине», особенно в облачных и гибридных конфигурациях.

Кибербезопасность физического ИИ

Подход базируется на жизненном цикле безопасности IACS, но требует дополнительного шага — безопасного вывода из эксплуатации. Это обусловлено тем, что физический ИИ собирает обширные персональные данные (биометрия, голос, поведенческие паттерны, карты окружения). Неправильная утилизация может привести к утечке конфиденциальной информации и обратному инженерному анализу.

Этика должна быть интегрирована на всех этапах разработки, а «trust bias» (склонность доверять автоматике) требует особого внимания, поскольку даже небольшие ошибки могут иметь серьёзные последствия.

Фреймворк функциональной безопасности

Стандарт IEC 61508 может служить отправной точкой, однако традиционные методы недостаточны для динамичных сред, где работает физический ИИ. Необходим адаптивный подход, способный реагировать на изменяющиеся условия.

Примеры из реальной практики:

Робот, запрограммированный поддерживать стабильность любой ценой, стал опасным.

Робот наступил ребёнку из‑за неверного распознавания присутствия человека.

Эти случаи подчёркивают важность чувствительных датчиков и адаптивных протоколов реагирования. Обычная функция отключения не гарантирует безопасного состояния, как в традиционных процессных установках.

Приватность и этика

Отсутствие видимых камер не исключает наблюдения: технологии LiDAR, Wi‑Fi‑сенсоры и другие могут создавать трёхмерные карты и отслеживать движение сквозь стены. Системы могут собирать данные о ежедневных привычках, записывать разговоры и формировать детальные профили без явного согласия пользователей.

Физическое рассуждение и ограничения ИИ

Физическое рассуждение — процесс понимания поведения объектов в реальном мире. ИИ пока не обладает интуитивным восприятием, характерным для людей. Пример: автомобиль, исчезнувший из зоны видимости датчиков, может быть «потерян» ИИ, что приводит к ошибочным реакциям.

Галлюцинации ИИ

Галлюцинации — ошибочные выводы, возникающие из‑за плохого качества обучающих данных, смещения выборки и недостаточной разнообразности сценариев. В физическом контексте они могут привести к опасным действиям.

Стратегии снижения рисков и обеспечения безопасности

Ввести метрики оценки реальности и оценку правдоподобия (PRS) для виртуальных тренировочных сред, используя цифровые двойники.

Интегрировать безопасность в архитектуру с самого начала, а не как надстройку.

Создать центр управления с круглосуточным персоналом для экстренного вмешательства.

Встроить этические принципы и механизмы согласия при работе с персональными данными.

Будущие стандарты и регулятивные потребности

Текущие нормы не охватывают полностью специфические риски физического ИИ. Необходимо разработать новые стандарты совместно с отраслью, специалистами по приватности, этике и регуляторами, обеспечивая гибкость под быстрые технологические изменения.

Тестовый фреймворк для оценки рисков

Перед вводом в эксплуатацию следует проводить тест «Physical Reality Interaction Test» (PRiT), аналогичный SAT в IACS, с системой оценки «physical realism score». После развертывания требуется непрерывный тест «Continuous Physical Reality Interaction Test» (CPRiT), результаты которого возвращаются в цифровой двойник для дальнейшей оптимизации.

Больше материалов на канале РобоТок: https://t.me/tobotsp