Теперь к видео.

Само видео - 2 часа 15 минут. Шуйский, ты меня настолько не любишь, что прислал ЭТО?

Пошел смотреть, что там рассказывают.

Видео: 0:45 «В начале 2000х в мире начала широко использоваться технология базовой виртуализации».

Мнение. IBM announced its first official VM product, VM/370, on August 2, 1972 for the System/370.

Видео 1:25 технология .. позволила мигрировать приложение без потери сервиса.

Мнение: HA это не то же самое что VMware vSphere™ 4 Fault Tolerance . И это не миграция.

То есть, если мы говорим про «миграцию при выходе сервера из строя», то это FT, и это не миграция. Если говорим про HA, то это не миграция, а перезапуск нового экземпляра с общего хранилища, с, разумеется, перерывом в обслуживании и без гарантий, что перезапустится.

Видео 2:02 Объединение ЦОДов в единую вычислительную платформу.

Мнение: Не совсем. Никакого объединения именно вычислений между ЦОД не происходит, мешает скорость света и проклятая физика. Есть единое управление группами сервисов в ЦОД, и разные схемы репликации данных. Именно вычислительный кластер в пределах ЦОД, это отдельные развлечения в виде построения именно вычислительного кластера.

Видео 5:25 Примерно 11 лет назад .. на российском рынке виртуализации присутствовали VMware, Citrix, Microsoft.

Мнение: Забыты Red Hat, IBM, и все решения вокруг OpenStack – с 2010 года. Виртуализация на российском рынке присутствует с первых поставок IBM в СССР в 70е. Виртуализация на ESXi и потом Windows server в масс маркете - с выхода 2008R2, примерно. ESXi с его лицензированием и первичной сложностью был в сильно верхней части масс маркета, и стоил, с его лицензированием памяти, как-то очень дорого, а лицензировать поверх него Windows стоило еще дороже.

Видео 10:40 Рынок вендоров по виртуализации в России разделился на две группы.

Мнение: Это как считать. В основе у многих «вендоров» – Linux + KVM разных редакций. У кого-то был FreeBSD, и, вроде, даже Linux + Xen. "Российского" в Linux что-то около ноля, там и до всех приключений в команде «около ядра» было человек 10, и далеко не основные разработчики \ контрибьюторы. Этот финн всегда не любил РФ.

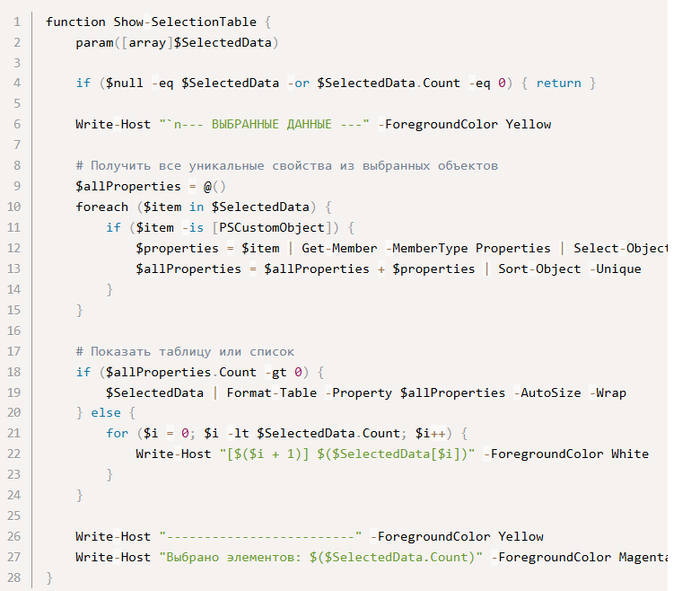

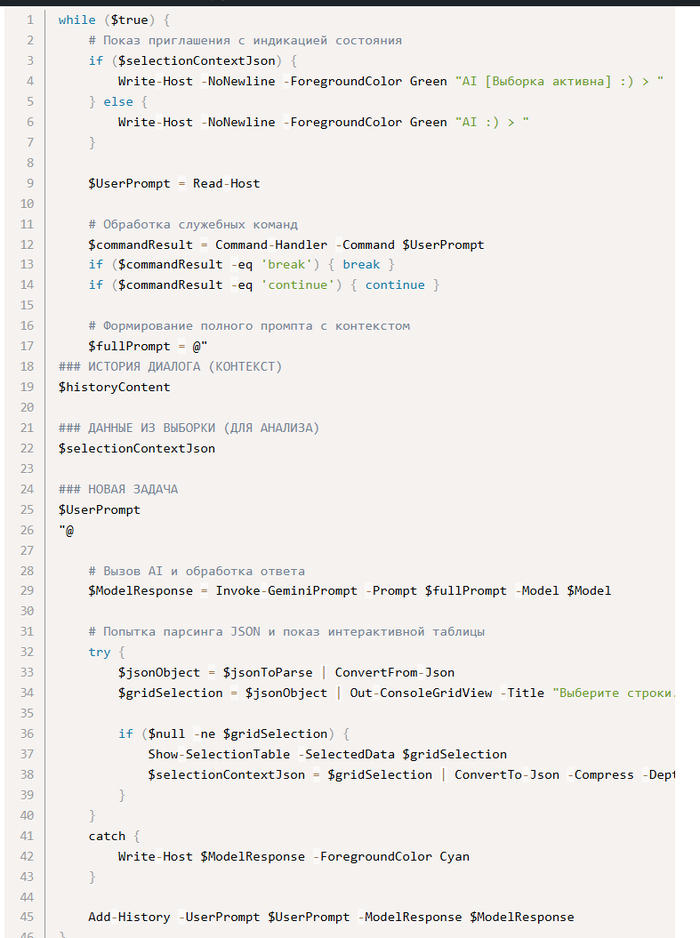

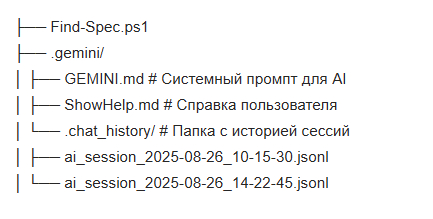

У того же SpaceVM – виртуализация из того же Linux, то есть qemu-kvm, и это не секрет, но официальная документация, цитата:

Управление ВМ обеспечивается модулем-гипервизором qemu-kvm, входящим в состав ТОС. Гипервизор qemu-kvm устанавливается непосредственно на физический сервер вместе с ТОС с дистрибутива SpaceVM и отдельной установки не требует. Документация | SpaceVM

У VMware by Broadcom и Microsoft в основе виртуализации целиком свои собственные ОС, если кто-то не знал. Как показывает дальнейшее видео, участники видео не в курсе.

В виртуализацию, то есть в данном случае в KVM (или Xen) вклад от российских вендоров .. не могу сказать что 100% отсутствует, но и в присутствии сильно сомневаюсь.

Видео 11:50 Opensource не является конечным продуктом, иначе бы любой человек мог его скачать, проинсталлировать.

Мнение: является. Любой человек может скачать хоть Debian \ Ubuntu \CentOS, хоть ванильный опенстек, и поставить его в инфраструктуру, и он будет работать. И да, идея была именно в этом – вы качаете бесплатный Linux и не занимаетесь его покупкой. Но цена поддержка RHEL или Oracle Linux, ой.

Видео 14:00 В рамках опенсорс проектов есть специально привнесенные уязвимости

Мнение: Пока такого не замечено. Утащенные документы (Ассанж плюс Шульте = WikiLeaks) показывают, что уязвимости ищут, но не внедряют. Хотя с Cisco и внедрением в них троянского модуля, не все так просто.

И наоборот, у проприетарного Касперского была уязвимость, когда пароли генерировались исходя из простого алгоритма времени. И недавно ее одна, когда пароль писался в логи в открытом виде.

Если быть чуть точнее, то у ряда небольших проектов после 02.2022 появился код, который можно считать вредоносным «для РФ», но в РФ даже не стали поддерживать проект по поиску такого ПО.

Видео 15:05 VMware использует ядро Linux.

Мнение: для виртуализации не использует. Для системы управления, vCenter – использует.

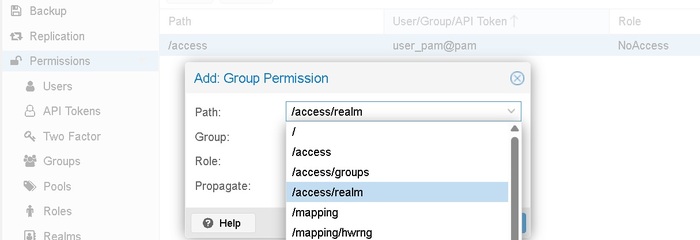

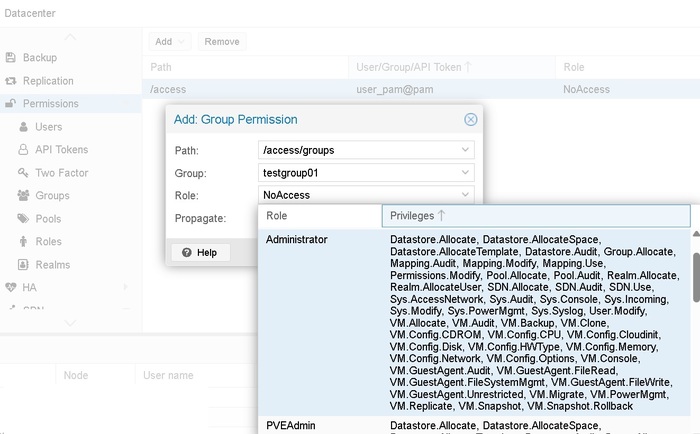

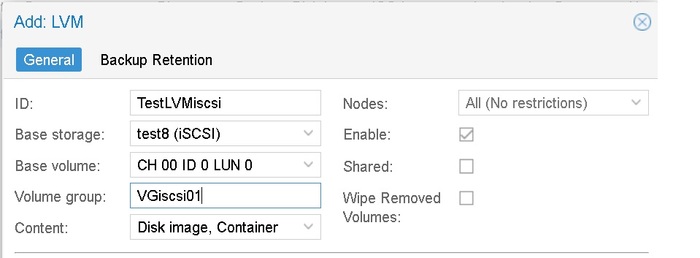

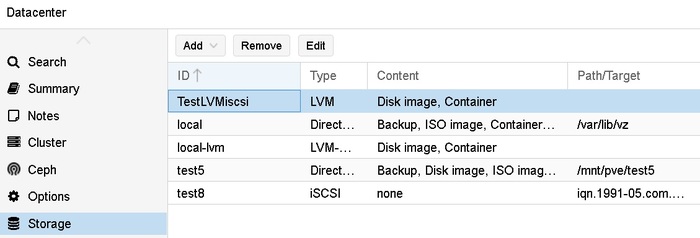

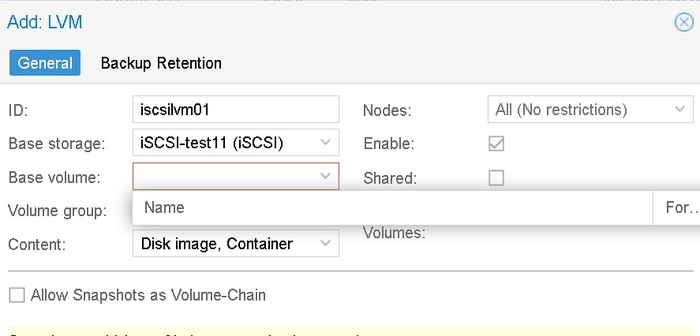

Видео 15:45 Например .. возьмем Proxmox .. обернем его своим Web-интерфейсом.

Мнение: Но зачем? То есть, у Proxmox есть свой web, есть свое API, что там еще поверх нужно оборачивать? Нескучные обои?

Видео 16:00 потребуется (для Proxmox) написать свои прослойки в виде абстракций

Мнение: Но зачем? Для портала самообслуживания?

Видео 18:35 Само по себе ядро Linux не позволяет вам делать виртуализацию.

Мнение: KVM это Kernel-based Virtual Machine. Технически это: KVM (for Kernel-based Virtual Machine) is a full virtualization solution for Linux on x86 hardware containing virtualization extensions (Intel VT or AMD-V). It consists of a loadable kernel module, kvm.ko, that provides the core virtualization infrastructure and a processor specific module, kvm-intel.ko or kvm-amd.ko. The kernel component of KVM is included in mainline Linux, as of 2.6.20.

То есть с времен Linux_2_6_20 ,с февраля 2007, это модуль ядра.

Видео 18:55 Эти модули они пишут сами.

Что-то пишут, но под "что-то" зачастую qemu, apache, и так далее.

Видео 22:00 Red Hat

Мнение: IBM купила Red Hat в 2018 и в 9 июля 2019 закрыла сделку. Фирма Red Hat как фирма не существует, акций у нее (ISIN US7565771026) больше нет. Бренд существует, продукция под брендом выпускается, такая как Red Hat Enterprise Linux 10, но это уже 6 лет как подразделение IBM

Видео 25:00 Какие-то опенсорс модули, но не те, которые отвечают за предоставление конечной функции.

Мнение: за функцию «виртуализация на KVM» отвечают модули ядра Linux. Какая там еще может быть «конечная функция»? Предоставление web интерфейса?

Видео 25:51 первые собственные технологии вы как раз можете увидеть через 5-6 лет.

Мнение: по городской легенде, Xen был написан на спор за выходные.

Видео 26:10 Рекламная пауза с музыкой.

Видео 28:34 Proxmox .. сами его обслуживают, сами его дорабатывают.

Мнение: Коллеги в РФ активно используют Proxmox, репозитории Proxmox (и Debian) из РФ в июне еще были открыты (потом не спрашивал), и вряд ли что-то поменялось. Ничего «самим» обслуживать не надо, если не считать за «обслуживание» apt get update.

Видео 30:50 VMware взяли операционную систему на базе ядра Linux.

Мнение: На базе Linux была ветка ESX. Ее развитие закончилась в 2007 году, с выходом своего ядра, VMware ESXi 3.5 First Public Release, билд 67921.

Видео 31:25 Это их (VMware) ветка (Linux)

Мнение: это не «их ветка», это, если говорит про ESXi, свое ядро ОС с 2007 года. Более того, в 2020 году, с выходом версии 7, оттуда (из VMkernel) выкинули модуль VMKLinux, когда-то давно оставленный для возможности через 333 трансляции использовать Linux драйвера. Завываний в сообществах было очень много. Про то, что злые проприетарщики (по итогам суда за SCSI) выкинули поддержку копролитов, поддержкой которых лет за 10 не озаботился ни вендор, ни сообщество. Сообщество не сделало драйвера за 10 лет, а виноват в этом почему-то VMware.

Photon OS при этом используется для vCenter, и не только.

Видео 34:15

Мнение: Это новая мода такая, показывать волосатые колени?

Видео 34:40 Web интерфейс это наша собственная разработка.

Мнение: интерфейс да, а под ним Apache. База данных, согласно руководству, Postgres Pro. Это нормально, vCenter Server Appliance (VCSA) использует PostgreSQL.

Видео 35:50 GFS2 (Red Hat) плюс Pacemaker плюс Corosync на слайде.

Мнение: Pacemaker временами вытворял такое, странное.

Видео 36:06 используется GlusterFS

Мнение: Proxmox VE has officially dropped support for GlusterFS as a storage option starting with Proxmox VE 9.0. This decision is based on the Proxmox developers' assessment that GlusterFS is no longer actively maintained upstream.

Видео 37:10 Слайд Space Agent VM содержит qemu агент и virtio.

Мнение: Нормальное явление, там же qemu-kvm, и сеть от virtio

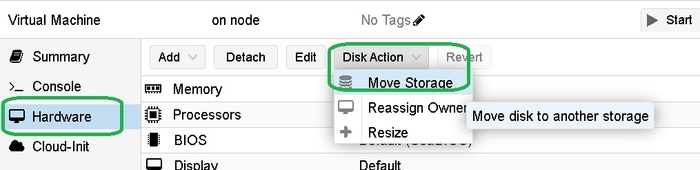

Видео 37:45 Реализован автоматический перенос виртуальной машины на резервный сервер в случае выхода из строя основного.

Мнение: это не перенос, это перезапуск виртуальной машины на другом сервере. Именно перенос, FT и аналоги, реализован у VMware by Broadcom как FT, и как-то был у Stratus (но могу ошибаться), но фирма Stratus перекуплена, и что то там еще с ней было. Есть еще аппаратные реализации FT, но дорого.

Видео 39:00 В SpaceVM реализован функционал микросегментации.

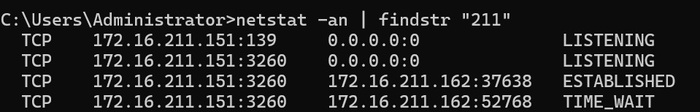

Мнение: судя по документации, не совсем микросегментации. Документация: Правила фильтрации политик виртуальной сети и виртуальной машины. Для меня выглядит фильтрация на уровне L2+L3, но как-то не понятно, это все же L2 фильтрация, и я могу сделать группы IP\MAC внутри L2 сети, или нет. Судя по запрету широковещательных, это ближе к private vlan.

Видео 40:50 все исходные коды принадлежат вам

Мнение: в контексте разговора да, но код kernel (в том числе KVM), СУБД, и прочих компонентов, им, конечно, не принадлежит.

Видео 43:20 Технология Free Grid может применяться там, где закончилась лицензия NVidia Grid.

Мнение: «обход» какой угодно лицензии в отсутствии в РФ официального правительственного указа о разрешении обхода лицензий еще недавно трактовался как УК РФ 146, УК РФ 273.2 (потому что могли добавить и нейтрализацию средств защиты компьютерной информации). Что-то, видимо, поменялось.

Видео 45:30 Музыкальная пауза. Кому-то, похоже, переставляют Linux.

Видео 46:25 (SpaceVM) Устанавливается на любое железо.

Мнение: то есть, про тестирование и списки совместимости ( Hardware compatibility list) речь не идет, работает и ладно.

Ранее в видео говорилось про enterprise class, ну что ж.

Видео 54:00 Соревнования в надежности с VMware by Broadcom

Мнение: если говорить про ОС, то есть ESXi by VMware by Broadcom, то надежность у нее была, и остается, на принципиально не достижимом уровне, для текущих версий «всего на Linux». Почему? Потому что ОС, точнее vmkernel, распаковывался в оперативную память, и после запуска не нуждался ни в дисках, ни в каком-то загрузчике. Да, при смерти диска, на который ESXi сгружало логи, и где хранился агент, самой ОС могло стать нехорошо. Хост отваливался от vCenter, управление тупило, но сами гостевые виртуальные машины работали как часы, позволяя штатно, в согласованное время, выключить виртуальные машины, и штатно их запустить на другом хосте в кластере. Про это целая статья есть, Падучая ESXi или возвращение блудного хоста. И Grigory Pryalukhin статьи писал - Перезапуск Management agents в ESXi и терпение.

У Hyper-V есть схожая особенность, при смерти управляющей виртуальной машины (minroot 0 или как его там), гостевые виртуальные машины живут до выключения, даже на любой форме локальных дисков.

Windows на выдернутых \ и особенно перешедших в RO дисков, это очень странный, но реальный сценарий. И оно даже работает.

У Linux ? Выдерните диск из-под Linux с KVM и посмотрите. Мне выдергивали как-то случайно. Эффект .. странный.

Если делать соревнования по надежности, то что ESXi , что Windows server с Hyper-V работают без перезагрузок и патчей, по 3-5 лет. Я всегда очень удивлялся, что есть такие люди, которые по 3-5 лет без единого патча или ребута обходятся (Кто тут громко подумал МТС \ СДЭК \ Аэрофлот ? ), но технически это возможно. Делать так, конечно, не надо. Наиболее вредоносное ПО, с постоянно текущей памятью, приносит (в основном) отдел имитационной безопасности. С этим ПО все очень плохо, оно течет.

Это (подтекание) касается не только российского ПО, все «типа антивирусы», кроме Palo Alto, Sophos и Microsoft, вот эти все из правого верхнего угла 2023 Gartner® Magic Quadrant™ for Endpoint Protection, вот они все кривые и косые. Про CrowdStrike теперь не слышал разве что совсем слепой и глухой.

55:20 Теперь давайте про Citrix

Мнение. Странно, что забыты Horizon и Workspace ONE, они теперь не VMware by Broadcom.

VMware Horizon теперь Omnissa Horizon

AirWatch стал Workspace ONE, точнее Omnissa Workspace ONE Unified Endpoint Management (UEM)

Странно, что забыт Microsoft Remote Desktop Service. Инсталляций полно.

Я с Citrix почему-то сталкивался крайне редко, последний раз в 2015 году. Citrix Systems куда-то продавали, кто-то с кем-то его скрещивал, но я не слежу.

В 2018 году доля Citrix уже была невелика (Hypervisor Market Share – ControlUp Perspective). То есть, он не умирает, но есть тред на реддите, что в ряде отраслей его сложно заменить (Question: Is Citrix dying?).

Видео 58:30 Уход VMware

Мнение. Уход VMware, это очень громко сказано, но надо понимать нюанс. Да, российским фирмам отключили учетные записи на портале, не вернули деньги за поддержку, и перестали оказывать саму поддержку. Это было бы пол-беды. Все, кто хотел, решили вопрос со скачиванием.

Нюанс в том, что 26 мая 2022 года Broadcom объявил про покупку VMware, сделка была закрыта 22 ноября 2023 года, и понеслось.То переактивация записей, то переделка портала, то смена модели лицензирования, отчисление всего малоденежной части покупателей, выделение и продажа наружу Horizon и Workspace ONE, удаление ESXi free, удаление еще кучи продуктов.

Дошло до того, что Microsoft пишет: Migrate VMware virtual machines to Hyper-V in Windows Admin Center (Preview).

Лично мне смешно, что вот эти граждане ходят по граблям, но на Hyper-V переходить не хотят.

Поэтому, если бы VMware осталась VMware, а не стала VMware by Broadcom, то российский центр экспертизы имел бы смысл. А так, даже вне РФ, приходится бежать от них, теряя тапки.

Видео 1:04:00 Деньги никто не вернул

Мнение. А мог? Санкции в первую очередь были финансовые, свифт отключили. Я напомню, как доллары из банков РФ, со своих счетов, запретили получать гражданам РФ. Так что про чистоплотность относительно долларов РФ в российской банковской системе, еще до указа о запрете вывода, это вопрос не к вендорам, а к системе переводов. Не говоря про лимиты вывоза из РФ своих же денег в долларах.

Видео 1:05:00 .. и работает только по их правилам.

Мнение. Я напоминаю, что это видео лежит на ютубе, и странно говорить про работу по правилам и чистоплотности говорить в системе, которая с 1991 года не может вернуть долги собственным гражданам. Но говорить, безусловно, можно. Да, правовая система США и Европы работает в своем правовом поле. Именно поэтому до 2022 года в значимой части контрактов стояло, что разбирательство должно быть в Лондоне.

Видео 1:07:40 Как только у них (МЦСТ) появилась аппаратная поддержка виртуализации, на 16С

Мнение. Мне кажется, или 16С в серию так и не пошел?

Видео 1:07:45 Скоро будет новости (про МЦСТ Эльбрус 16С)

Мнение. На Тайване их не делают, неужели заказали партию в Китае? Потому что на 180/350 нм технологиях в РФ, 16С будет размерами с пеноблок. И такой же производительности, как пеноблок, из-за длины дорожек.

Видео 1:08:00 Большую часть приложений (x86-64\win32) можно будет использовать на Эльбрусе

Мнение. Эльбрус 4\8 и инженерный 16С в 2021 чудовищно отставал по производительности от Intel. Выступал на уровне Core i7 2600 из 2011 года. Запускать на нем Word \ Excel для целей можно, но уже в 1с баба Маша вас проклянет, и повесит вашу шкуру у чайника в кабинете бухгалтерии, по примеру Кристобаля Хозевича Хунты (у него было целое чучело).

Видео 1:14:00 Обход лицензирования NVidia через FreeGRID .. засылать несоразмерные платежи.

Мнение. Интересная логика про "несоразмерность". У той же Microsoft лицензия Datacenter, или расширенная поддержка Windows Server 2012 стоит, по моему мнению, несоразмерных денег. Почему не продавать активаторы, в таком случае? Но с этим вопросом пусть юристы разбираются, еще недавно за активацию "несоразмерных" лицензий Windows, фотошопа, 1С, и так далее, выписывали штраф. И у 1С уже много раз уже таймбомбы.

Видео 1:15:00 VMware ввели новый вид лицензирования.

Мнение. Как я уже писал, уже не VMware, но уже Broadcom. Они всегда (последние лет 20), были адскими жмотами, жлобами, и как хотите, так и называйте. Но не прячьте ваши денежки.

Чрезвычайно уважаемые люди давно сказали – будет как в Computer Associates и UCC-7 - CA-7. Так и вышло.

Видео 1:20:00 Отучиться на Cisco

Мнение. Первые два курса Cisco, ICND 1 и ICND 2, это курсы не про продукцию CISCO, а про базовейшую из базовых теорий. Cisco Press активно выпускала книги на русском, Cisco академия работала повсеместно. Курс, если вам было жалко денег, валялся везде и бесплатно. Пройдя базовую Cisco и понимая теорию, можно было уже на базовом уровне понимать, как это реализовано у остальных вендоров.

Видео 1:21:10 У них аппаратка DELL –а стояла, все было хорошо.

Мнение. При монтаже пропал фрагмент видео.

Видео 1:24:30 Виртуализация должна иметь стык для работы с антивирусом

Мнение. Broadcom очень давно, если не всегда, писал что:

It is not recommended to install antivirus software directly on the VMware vCenter Server Appliance (VCSA) due to potential performance issues

Unfortunately for defenders, ESXi hosts themselves do not currently support natively run EDR (endpoint detection and response). Best security practices for ESXi environments

То есть для провайдеров были решения на уровне интеграции модулей, но это не привычный антивирус.

А уж сколько люди поели с vGate.

По поводу Microsoft процитирую:

You have just deployed Hyper-V and the (in)security officer has decided that the standard edict of “all files and processes must be scanned because Windows is insecure” must be applied. Here’s my advice: Get that in writing. No, better: Get that written in their own blood, with your boss, your boss’s boss, and the (in)security officer’s boss as witnesses. Antivirus on a Hyper-V Host: Do You Need It?

Видео 1:27:00 Совместимость с системами хранения данных

Мнение. НАКОНЕЦ ТО дошли до озвучивания проблем с HCL. Спустя полтора часа.

Итого.

Видео 1:30:00. С тремя перерывами и двумя перекурами я дотащился до отметки 1:30 из 2:15

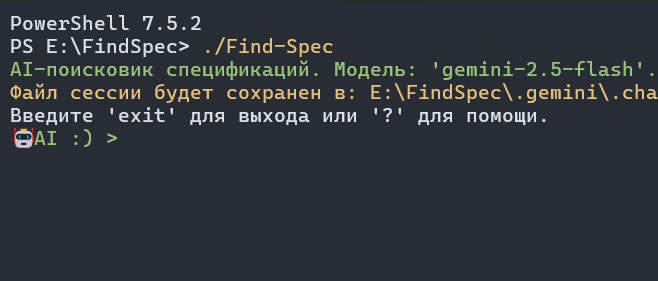

На просмотр и пометки за полтора часа реального времени ушло три часа из жизни. При этом никакой особо полезной информации я не узнал.

Окей, в РФ есть еще одна платформа на KVM (из 50 похожих?), и обещают, что платформа не хуже Proxmox.

Окей, если бы у меня стояла задача импортозамещения, я бы и так в 2022 начал смотреть на рынок российского ПО. Но у меня такой задачи нет в принципе, а на Proxmox на текущей работе начали уходить еще в начале 2024, когда стало очевидно, что будут перемены с политикой Broadcom, и что давно пора снизить число лицензий на Microsoft.

Рассказ про Linux внутри ESXi (хотя ESXi никак не Linux) заставляет меня несколько скептически оценивать все остальные заявления.

Но, меня это все не касается никак, а с таким подходом к лицензированию nVidia пусть юристы разбираются.

Досматривать я это даже не буду.