ТОП-16 курсов Data Engineering: онлайн-обучение на инженера данных бесплатно и платно

Один из перспективных направлений обучения в IT сейчас — Data Engineer курсы. Эта профессия связана с обработкой big data, а также созданием и поддержкой хранилищ данных и их инфраструктуры. А работать по ней можно как в проектах data science, так и в аналитике. Освоить специальность смогут все со знанием SQL, навыками Python и опытом решения практических задач в программировании. А Data Engineering курсы уже позволят изучить технологии big data и научат применять инструменты для их анализа и обработки.

Я рассмотрела не один десяток таких программ и собрала список из 16 лучших вариантов. В первой части обзора будет краткое и подробное описание ТОП-10, а во второй — список еще 6 неплохих предложениях. Также для некоторых курсов я нашла дополнительные эксклюзивные скидки, акции и промокоды.

ТОП-10 лучших курсов Data Engineer в 2025 году

Дата-инженер от Нетологии — курс от специалистов Яндекса и Сбербанка, после которого в портфолио появятся сразу 6 готовых проектов.

Профессия Data Engineer от Skillbox — программа с вечным доступом, в формате для гуманитариев и с разными дополнительными курсами в подарок.

Инженерия данных от Нетологии и НИУ ВШЭ — направление для специалистов, уже получивших высшее образование в любой математической области.

Инженер данных с нуля от Яндекс Практикума — программа профессиональной переподготовки с поддержкой наставников и free-доступом к Yandex GPT.

Инженер данных от Хекслета — курс со стажировкой на реальных проектах, 80% практики и карьерным сопровождением после окончания учебы.

Инженер данных от Karpov.Courses — еще один курс с помощью в устройстве на работу, который даже включает в себя симуляторы собеседований.

Data Engineer от Otus — на программе вебинары всегда проходят в прямом эфире, а всем студентам дарят стартовый курс по Python.

Data-инженер от Слёрм — курс с бесплатным доступом на 3 дня, в течение которых студенты успевают выполнить собственный реальный проект.

Профессиональная переподготовка Инженер данных от АПОК — несмотря на свое название, проходит «с нуля» и наличия профессионального опыта не требует.

Инженер больших данных (Big Data Engineer) от Специалист.ru — комплексная учебная программа из 11 отдельных курсов и с гибким графиком обучения.

Онлайн-курсы Data Engineer

1. Дата-инженер | Нетология

Используйте промокод kursfinder, чтобы получить скидку 7%

Обучение Data Engineer с free-доступом к Yandex Cloud, в рамках которого студенты учат особенности проектирования хранилищ данных, а также узнают правила выбора DWH на основе конкретных задач и бюджетов бизнеса. Также на курсе проходят разные процессы обработки данных, обучаются работе со Spark SQL, DataFrame и т. д. И, что немаловажно, изучают, как эффективнее презентовать важные для компании данные, и получать отдачу.

Кроме того, участники курса выполняют шесть проектов для своего личного портфолио и учатся трансформации в Pentaho. А также разрабатывают запросы SQL под аналитические задачи и не только запускают базу данных, но и наполняют ее с помощью ETL-процессов.

Стоимость: от 4 083 руб. в месяц

Длительность: от 1 года

Формат обучения: вебинары, записи лекций, практические работы, задания на дом

Сертификат: есть

Кому подойдет: и начинающим, и опытным специалистам (есть 3 уровня сложности).

Преимущества:

гибкий график обучения и бесплатный доступ к Yandex Cloud в процессе обучения, плюс постоянная поддержка кураторов в чате;

шанс учиться у преподавателей с большим профессиональным опытом — среди них есть бизнес-архитекторы и аналитики, специалисты Сбербанка, Яндекса и др.;

опция возврата денег в том случае, если курс по каким-то причинам не подойдет, а также возможность оформить за обучение бонусный вычет;

бонусные курсы по облачной инфраструктуре, Java, визуализации и английскому — в подарок каждому участнику;

митапы с экспертами и HR, а также общая практическая направленность обучения и помощь в подготовке к трудоустройству (но не само трудоустройство).

Недостатки:

отсутствие подробного разбора домашних заданий — из-за этого может тратиться много времени на самостоятельный поиск дополнительной информации;

часть лекция была записана несколько лет назад, хотя IT-рынок уже изменился.

Программа обучения:

изучение основ SQL и получения больших данных, проектирование DWH;

знакомство с языком Python для анализа данных и Tableau для их визуализации;

обучение профессиональной работе с Data Lake & Hadoop;

получение навыков работы с потоковыми данными;

подробное ознакомление с облачными технологиями в работе с big data.

2. Профессия Data Engineer | Skillbox

Используйте промокод kursfinder, чтобы получить скидку 50%

Комплексное обучение Data Engineering позволяет пройти путь от первого шага в области анализа данных до уровня Junior. Причем учиться можно без привязки времени, а все обучающие материалы сохраняются у участников курса в вечном доступе. В процессе обучения уделяется много внимания навыкам программирования на Python, SQL и работе с технологиями big data. А практические занятия строятся на реальных задачах из бизнеса.

Также пользователи учатся применять инструменты для построения Data Lake, и по итогу получают сертификат, с которым могут претендовать на достойные рабочие места. Кроме этого, курс был обновлен в 2025 году, и соответствует современным требованиям индустрии.

Стоимость: от 5 848 руб. в месяц

Длительность: 9 месяцев

Формат обучения: записи лекций, задания на дом, проекты, онлайн-тренажеры

Сертификат: есть

Кому подойдет: новичкам и уже опытным программистам или аналитикам.

Преимущества:

возможность учиться даже гуманитариям — все темы курса объясняются «с нуля» и максимально подробно;

free-доступ к Yandex Cloud в течение всего срока обучения, а также 3 онлайн-курса в подарок плюс шанс на получение дополнительной скидки;

добавление в портфолио 3 проектов (в случае хороших успехов в учебе) и помощь в трудоустройстве, включая крупнейшие IT-компании;

постоянная поддержка кураторов, а также общение в чате с другими участниками курса — для создания мотивирующей атмосферы;

обновленные модули по машинному обучению и аналитике, а также актуальность информации как таковая — все темы были доработаны или изменены.

Недостатки:

блоки не синхронизированы, что может приводить к повторениям информации;

нехватка подсказок в некоторых учебных заданиях — из-за этого приходится искать много информации самостоятельно, на что не всегда есть время;

не всегда полное раскрытие темы — недостаток теории для выполнения практики.

Программа обучения:

введение в само направление Data Science — базовое и более продвинутое;

изучение основ статистики, теории вероятностей и математики для Data Science;

прохождение специализации по машинному обучению;

еще одна специализация, уже по анализу данных;

подтверждение навыков через выполнение финального проекта.

3. Инженерия данных | Нетология и НИУ ВШЭ

Используйте промокод kursfinder, чтобы получить скидку 7%

Еще одна программа по профессии инженер данных, обучение в которой дает серьезный объем знаний и необходимую для успешной реализации в специальности квалификацию. В ходе курса пользователи изучают сразу 3 актуальных языка программирования, учатся владеть инструментами разработки и проводить аналитику больших баз данных, а также автоматизировать эти процессы и др. По окончании получают диплом с приложением на английском.

Более того, если выбрать это дистанционное обучение в рамках магистратуры, то можно получить отсрочку от армии. К тому же, организаторы предоставляют всем возможность сначала ознакомиться с курсом бесплатно — чтобы заранее понять специфику профессии.

Стоимость: 200 000 руб. за семестр

Длительность: 2 года

Формат обучения: видеолекции, онлайн-семинары, практические занятия на дом

Сертификат: есть

Кому подойдет: выпускникам технических и естественно-научных факультетов.

Преимущества:

онлайн-формат с вебинарами, хакатонами и практикой — это позволяет соединять обучение на курсе с работой (или учиться в ВШЭ из любой точки страны);

преподавательский состав — практикующие специалисты, которые делятся своим реальным опытом и говорят о действительно актуальных сегодня задачах;

поддержка от кураторов и активная обратная связь на протяжении всего периода обучения — по любым вопросам, связанным с учебным процессом;

акцент на практику — участники курса работают с настоящими данными и только теми задачами, которые предлагают компании-партнеры;

обязательные стажировки в крупных компаниях и помощь в трудоустройстве — в рамках программы даже есть спецкурс по успешному выходу на рынок труда.

Недостатки:

достаточно высокая стоимость обучения — 2 года по 200 тыс. за семестр;

необходимость иметь диплом бакалавра по любой технической специальности — со средне-специальным или гуманитарным образованием на курс не принимают;

сложные задания — иногда для них нужна та информация, что не было в лекции.

Программа обучения:

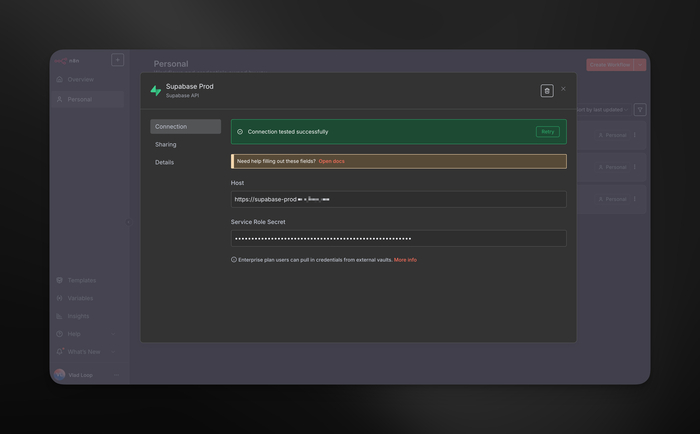

освоение работы с такими важными для инженера данных инструментами как SQL, PostgreSQL, Airflow, Yandex Cloud, ClickHouse, CI/CD и др.;

обучение более глубокому владению языками Python, SQL и Java, а также сбору big data, трансформации и обработке данных и т. д.;

знакомство с главными рабочими задачами дата-инженера и методами их решения;

семинары с подготовкой проектов по программной и системной инженерии;

участие в хакатоне с демонстрацией навыков командного взаимодействия.

4. Инженер данных с нуля | Яндекс Практикум

Купите курс с выгодой до 20% при оплате сразу

Программа для тех, кто понимает, что пройти Data Engineering курс бесплатно и получить при этом необходимый для работы практический опыт не получится. И поэтому выбирает изучить навыки программирования на Python и SQL, а также работу с big data, Data Lake и хранилищами в рамках полноценной программы обучения — для всех желающих, включая гуманитариев. Она предлагает интенсивное погружение в темы и решение реальных задач.

Курс ориентирован на практику и применение современных инструментов, включая Spark, Airflow и др. А самые сложные модули успешно проходятся с помощью кураторов. Кроме того, по завершению учебы все участники получают поддержку при устройстве на работу.

Стоимость: от 6 899 руб. в месяц

Длительность: 11 месяцев

Формат обучения: видеолекции в записи, онлайн-тренажеры, воркшопы

Сертификат: есть

Кому подойдет: всем, кто хочет освоить новую профессию без опыта в IT.

Преимущества:

можно дойти до уровня Junior Data Scientist со статуса абсолютного новичка, а также получать помощь от карьерного центра компании;

доступ к учебным материалам в любое время и поддержка экспертов и кураторов в течение всего срока обучения;

выполнение 10+ проектов, которые можно добавить в персональное портфолио — с ним диплом государственного образца обычно оценивается лучше;

ставка не на теорию, а на практическую работу — обучение на курсе выстраивается по так называемой спринтовой модели;

изучение самых востребованных сегодня технологий и периодически обновляемая программа — для достижения максимальной актуальности.

Недостатки:

по отзывам, практических воркшопов меньше, чем этого бы хотелось студентам;

часть заданий похожи на работу тестировщика — поиск и отлов багов, ошибок и др., что тоже полезно для студентов, но не входит в саму специальность;

материалов лекций мало для выполнения заданий на дом без поиска информации.

Программа обучения:

базовое и углубленное изучения языка Python, инструментов разработчика, работы с HTTP-запросами;

знакомство с алгоритмами и структурами данных, основами SQL и PostgreSQL, а также продвинутым SQL;

проектирование хранилища данных и работа с их витринами, проверка качества и интеграция данных сразу из нескольких источников;

создание аналитической базы и Data Lake, реализация потоковой обработки;

работа с облачными технологиями и подготовка выпускного проекта.

5. Инженер данных | Хекслет

Программа, которая попала в лучшие курсы по Data Engineer потому, что делает ставку на практику — на решение реальных рабочих задач и проекты в ней отведено почти 80%. При этом участники сразу получают доступ к коммерческим, а не умозрительным IT-проектам, и учатся работать в командах. Однако в процессе это не так пугающе, как кажется, потому что студентов сопровождают наставники, которые подробно разбирают с ними код, и т. д.

Помимо этого, обучение идет без жестких дедлайнов, а учебные материалы сохраняются у пользователей навсегда. Плюс отдельное внимание уделяется трудоустройству и будущим собеседованиям, включая их имитацию и отработку самых правильных ответов и реакций.

Стоимость: от 5 651 руб. в месяц

Длительность: 10 месяцев

Формат обучения: видеоуроки, онлайн-тренажеры, домашние задания, тесты

Сертификат: есть

Кому подойдет: IT-специалистам без опыта и всем, кто хочет перейти в дата-инжиниринг.

Преимущества:

отведение на практику 80% всей программы и работа с реальными коммерческими задачами, результаты которых наиболее наглядные и мотивирующие;

стажировка с настоящими релизами и поддержка куратора на каждом шаге — в том числе в течение полугода после окончания курса (в процессе поиска работы);

наличие бесплатного модуля — для свободного старта и знакомства с форматом еще до внесения оплаты;

помощь в составлении резюме и отработка поведения на будущих собеседованиях — для более успешного их прохождения и возможности выбирать компании;

гарантия возврата денег за обучение — если получить должность дата-инженера по каким-либо причинам не получится.

Недостатки:

сложность материала — если нет никаких базовых познаний в программировании;

отсутствие точных ответов от куратора — они дают скорее направление для поиска;

тестовая часть — по отзывам студентам, тесты не помогают усвоению материала, и их прохождение нужно только «для галочки».

Программа обучения:

введение в основы Data Engineering, языка Python и программирования;

знакомство с инструментами разработки и функциями профессионального Python;

освоение навыков работы с базами данных и API, а также администрирования;

проработка Soft Skills и прохождение отдельного карьерного модуля;

стажировка в крупных партнерских компаниях и выполнение выпускного проекта.

Курс для тех, кому хочется освоить эту профессию с нуля и уверенно приступить к работе сразу после окончания учебы. В ходе программы студенты выполняют более 230 заданий, работают над практическими кейсами и получают максимально приближенный к реалиям опыт. Для этого они развивают навыки программирования, построения хранилищ данных, а также использования SQL, Python, Spark и других инструментов обработки информации.

Причем процесс обучения разработан самой школой и является авторским, а весь учебный материал остается доступным для учеников даже после выпуска. Также они проходят ряд тестовых заданий и формируют профессиональное портфолио из выполненных проектов.

Стоимость: 80 750 руб.

Длительность: 6 месяцев

Формат обучения: видеоуроки, текстовые конспекты, симуляторы, задания на дом

Сертификат: есть

Кому подойдет: всем новичкам в IT, а также начинающим дата-инженерам без опыта.

Преимущества:

множество практических и тестовых заданий, а также наличие симуляторов для тренировок собеседований;

персональная обратная связь от кураторов проекта плюс приоритетный доступ к вакансиям партнерских компаний;

создание полноценного профессионального портфолио Junior Data Engineer — с проверкой и рекомендациями от экспертов;

прохождение курса на собственной платформе компании — с комментариями по каждому домашнему заданию и доступом к материалам в любое время;

гарантия возврата денег в течение 2 недель после старта обучения — если станет ясно, что программа (или сама профессия) не подходит.

Недостатки:

чересчур академическая подача материала, которая устраивает не всех студентов;

неравномерное соотношение теоретической и практической части в ряде модулей — это создает трудности в усвоении программы;

задержки при проверке домашних заданий — из-за большого потока пользователей.

Программа обучения:

изучение основ обработки данных — от архитектур систем и до выбора нужных для решения конкретных задач инструментов;

работа с базами данных — построение хранилищ, оптимизация запросов и т. д.;

создание пайплайнов — начиная со сбора и трансформации данных и заканчивая их правильной загрузкой;

приобретение навыков работы с облачными решениями и обучение развертыванию инфраструктуры;

разработка идеи финального проекта, его реализация и презентация.

7. Data Engineer | Otus

Очередная программа, попавшая в топовые курсы по Data Engineering из-за значительного количества практики. Она проходит в Yandex Cloud, где пользователи поэтапно осваивают главные профессиональные инструменты и основы работы с хранилищем данных. Также в процессе уделяется внимание потоковому и пакетному режиму обработки, а в завершении обучения участники могут сами проектировать пайплайны, работать с Apache Spark и т. д.

Также студенты курса получают бесплатный доступ к целому ряду ресурсам и находятся в активном диалоге с преподавателями и кураторами. Отдельно нужно отметить комьюнити платформы — оно большое, быстро развивается и поддерживает всех новых пользователей.

Стоимость: 114 000 руб.

Длительность: 5 месяцев

Формат обучения: вебинары, текстовые материалы, практические задания на дом

Сертификат: есть

Кому подойдет: начинающим дата-инженерам, аналитикам и другим IT-специалистам.

Преимущества:

учеба в любое удобное время (все лекции можно смотреть в записи) и пожизненный доступ к обучающим материалам;

вводный курс по Python в подарок, а также практика в Yandex Cloud — для навыков работы с облачными технологиями в целом;

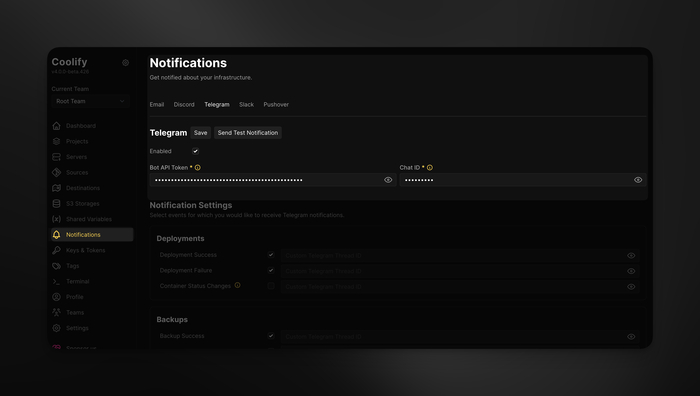

поддержка преподавательского состава по любым вопросам, связанным с учебным процессом, а также добавление во внутреннее Telegram-сообщество;

работа на комфортной и аккредитованной платформе, которая включена в реестр отечественного программного обеспечения;

создание профессионального портфолио из реальных коммерческих проектов — на базе задач от компаний-партнеров проекта.

Недостатки:

несогласованность в работе преподавателей — они могут повторяться по темам;

ошибки в раздаточных материалах — например, там встречается устаревший код.

Программа обучения:

знакомство с основами дата-инжиниринга и архитектурой систем данных;

углубленное изучение программирования на Python, а также продвинутого SQL;

работа с облачными платформами, обработка big data с применением Apache Spark;

постройка, оптимизация ETL/ELT, работа с разными СУБД и системами хранения;

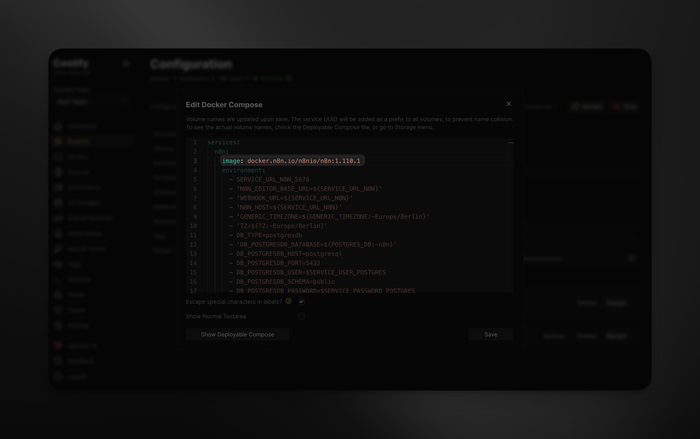

использование функций Docker, разработка и защита выпускного проекта.

8. Data-инженер | Слёрм

Курс позволяет освоить профессию дата-инженера от А до Я, начиная с базовых знаний и заканчивая участием в проектах крупных компаний. Причем обучение проходит в комфортном для студентов темпе, и после каждого его модуля они выполняют задания на виртуальных стендах — с подробным разбором их решений экспертами. Цель программы — сформировать у аудитории прикладные навыки применения актуального инструментария.

При этом учащиеся могут использовать не только открытые источники, но и свои данные, а итоговый проект становится частью их портфолио. Программа максимально практична и нацелена на бизнес-задачи, а также регулярно обновляется — вместе с изменениями рынка.

Стоимость: от 4 735 руб. в месяц

Длительность: 120 часов (без дедлайнов)

Формат обучения: видеоуроки, работа на онлайн-стендах, практические задания

Сертификат: есть

Кому подойдет: начинающим аналитикам баз данных, другим IT-специалистам без опыта.

Преимущества:

ориентация на практику — из 120 часов учебной программы на решение реальных задач бизнеса отводится 88;

двухгодичный доступ к материалам курса после его завершения, а также получение постоянной менторской поддержки и разбора заданий от специалистов;

возможность учиться без привязки не только к месту, но и ко времени — участники курса могут пройти 120 часов за любое удобное им количество недель или месяцев;

гарантия актуальности информации и инструментов — после каждого обновления в программе остаются только действительно нужные в моменте технологии;

шанс получить корпоративную скидку и оформить налоговый вычет — что делает стоимость обучения еще более выгодной.

Недостатки:

недостаточная проработанность материалов, по мнению ряда пользователей;

несмотря на обновления, в части тем так и проскакивают уже устаревшие сведения.

Программа обучения:

изучение языка программирования Python и терминала задач Data Engineering;

знакомство с Hadoop, распределенными файловыми системами и реляционными базами данных;

методология и архитектура хранилищ big data, их процессинг и перекладка;

обучение обращению с оркестраторами и шинами данных, потоковой аналитикой;

обретение навыка работы с ETL-инструментом, изучение оценки качества данных;

разработка, выполнение и защита финального проекта.

Курс готовит специалистов по работе с большими объемами данных и позволяет им освоить все необходимые инструменты в достаточно сжатые сроки. Студенты изучают особенности хранилищ big data, способы их обработки и подготовки для ML-инженеров и других отделов и т. д. Таким образом, программа рассчитана на то, чтобы они приобрели фундаментальные навыки работы в дата-инженерии, и быстро нашли работу в этой сфере.

Однако так как это программа профессиональной переподготовки, то для поступления на курс надо уметь уже законченное высшее или средне-специальное образование. И желательно математического плана — точных ограничений по профессиям нет, но это упростит учебу.

Стоимость: 29 980 руб.

Длительность: 1 месяц (250 часов)

Формат обучения: вебинары, текстовые конспекты, онлайн-тесты, задания на дом

Сертификат: есть

Кому подойдет: всем, кто хочет поменять свою специальность на работу дата-инженера.

Преимущества:

отсутствие четкого расписания — учеба в любое удобное время, а также совмещать обучение с работой;

высокое качество учебных материалов — структурированная и понятная подача информации, подкрепление теории практическими примерами и т. д.;

активная поддержка студентов — преподаватели и методисты отвечают на вопросы и помогают решать разные вопросы в течение всего срока обучения;

возможность оформить оплату обучения в рассрочку, а также получить налоговый вычет за эту сумму;

при необходимости готовый диплом о профессиональной переподготовке может быть отправлен выпускнику курса по почте (бесплатно).

Недостатки:

технические проблемы с учебной платформы — иногда не сохраняются тесты и др.;

недостаток практических заданий — по сравнению с остальными программами;

высокая интенсивность — освоить 250 часов в течение месяца может быть сложно, особенно если процесс учебы сочетается с работой.

Программа обучения:

введение в само направление Data Science, а также работу с данными и основными инструментами дата-инженера;

изучение основ статистики для анализа данных и технологий машинного обучения;

знакомство с анализом временных рядов и прогнозированием;

работа над реальными бизнес-кейсами и настоящими коммерческими задачами;

разработка итогового проекта, создание портфолио, подготовка к собеседованиям.

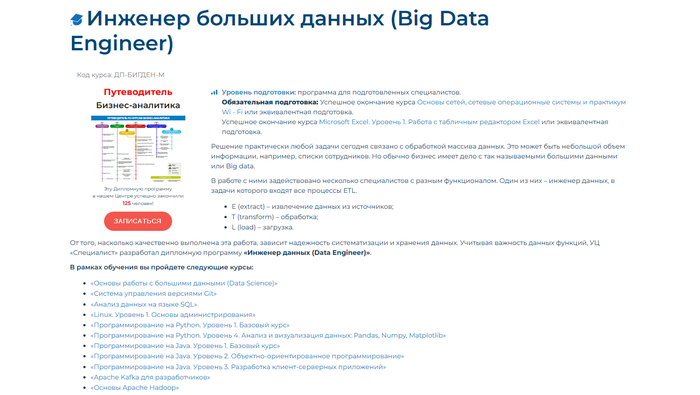

Комплексный курс включает в себя 11 отдельных модулей обучения. Учащиеся начинают освоение специальности с изучения специализированных инструментов Excel, и потом приступают к формированию SQL-запросов и использованию базовых конструкций Python. После этого стартует обучение построению диаграмм и разнообразных графиков, а также знакомство с тем, каким образом big data можно соединять и переформатировать.

Учиться по программе можно в свободном графике — записи лекций и семинаров доступны в любое время и к ним разрешается возвращаться еще в течение полугода после финала обучения. А другие учебные материалы (не видео) остаются у студентов навсегда.

Стоимость: 285 290 руб.

Длительность: от 4 месяцев

Формат обучения: записи лекций, семинары с преподавателями, занятия на дом

Сертификат: есть

Кому подойдет: уже подготовленным специалистам с базовыми знаниями по сетевым ОС.

Преимущества:

опытный преподавательский состав — не только практикующие программисты или инженеры, но и доктора наук, а также научные сотрудники РАН;

подарок за успешное окончание курса (на практике его получают все пользователи) — 3 бесплатные персональные консультации по пройденным темам;

участие в «живых» онлайн-семинарах с преподавателями, в ходе которых можно задавать вопросы и получать разбор своих ошибок;

обретение не только теоретических знаний, но и практических навыков в решении стандартных рабочих задач современного дата-инженера;

гарантированная помощь в трудоустройстве (вплоть до подбора самых подходящих вакансий) и возможность получить налоговый вычет за внесенную оплату.

Недостатки:

бессрочный доступ предоставляется только к некоторым материалам курса;

большой объем материала — часть лекций растягивается на 3–4 часа без перерывов, и в отзывах можно найти множество предложений разбивать их на куски.

Программа обучения:

изучение основ работы с большими данными и анализа данных на языке SQL;

программирование на Python и Java — базовые курсы с дополнениями по теме;

знакомство с Apache Kafka для разработчиков и основами Apache Hadoop, а также такими инструментами как MapReduce, Hive, Spark и Cassandra;

обучение автоматизации рабочих процессов при помощи Airflow;

построение пайплайнов — процессов доставки данных из одного места в другое.

Еще 6 курсов Data Engineer

Так как сегодня это очень востребованное направление, на перечисленных программах по профессии инженер данных курсы в интернете не кончаются. Более того, в предложениях есть и полностью бесплатные варианты — они прекрасно подойдут для знакомства с темой.

Прикладной анализ данных и машинное обучение от Skillfactory — программа для всех, кто хочет получить более фундаментальные знания в сфере анализа больших данных. Техническое образование для поступления на курс не требуется, учиться можно с нуля.

Инженер данных от Компьютерной Академии ТОП — на курсе студенты могут получить все необходимые для освоения новой профессии знания и навыки. В частности, их обучают управлению потоками big data, работе с базами, обработке больших объемов данных при помощи Apache Airflow и проектировке архитектуры хранилищ.

Симулятор «Инженер данных» от Simulative — интерактивный курс с настоящими бизнес-проектами, который подойдет пользователям, предпочитающим практико-ориентированный подход и желающим получить реальный опыт работы с big data.

Big Data Engineer от TopTrening — полноценный курс продолжительностью 1 год, который подходит специалистам, уже работающим в сфере big data или в смежных IT-специальностях.

Data Engineer от NewProlab — обучающая программа с упором на практику, причем максимально приближенную к реальной работе дата-инженеров.

Data Engineer от МФТИ — бесплатное обучение на инженера данных, состоящее из комплекта материалов от преподавателей крупного российского института. По ним пользователи могут освоить работу с Python и SQL, ознакомиться с особенностями Hadoop и Spark, а также разобраться в Apache Kafka, Hive и Git.

Часто задаваемые вопросы

Чем занимается на работе Data Engineer?

Дата-инженеры занимаются созданием и обновлением инфраструктуры данных, а также поддержанием ее работоспособности. Плюс в их обязанности входит разработка и оптимизация процессов загрузки и трансформации big data и их последующего хранения.

Какие навыки нужны, чтобы стать дата-инженером?

Это навыки программирования (Python, SQL), знание баз данных и инструментов для их обработки (Apache Spark, Hadoop и др.), а также облачных технологий и принципов big data. Однако необязательно знать их заранее – множество курсов обучают этому с нуля.

Какие технологические тренды влияют на Data Engineering?

Прежде всего, это распределенные системы обработки данных и облачные технологии для их хранения и анализа. Плюс нельзя не отметить влияние автоматизации процессов ETL и внедрение машинного обучения для анализа информации: всему этому обучают на курсах.

Как в области Data Engineering можно вырасти?

Для этого надо продолжать обучение новым технологиям и методикам обработки данных, а также не отказываться от участия в профессиональных конференциях, вебинарах и т. п. Еще один путь развития — регулярное прохождение курсов для повышения квалификации.

Если я специалист в бизнес-процессах, что мне даст Data Engineering?

В таком случае учеба в этом направлении поможет создавать более эффективные решения для обработки больших данных. Причем именно такие решения, которые будут подходить потребностям определенного бизнеса и, как следствие, повышать показатели его прибыли.

Если обучение Data Engineer уже было, надо ли учиться сейчас? Или сразу идти работать?

Технологий и тенденции в области инженерии данных и IT-сферы постоянно меняются, и поэтому свои знания все же стоит обновить. Это даст возможность эффективнее работать с большими данными, выбирать оптимальные инструменты и двигаться в карьере дальше.

Чтобы пройти любые Data Engineer курсы успешно, нужно заранее оценить свои навыки и уже имеющийся опыт, выбрать подходящую к ним учебную программу, и подключиться к профессиональным сообществам еще на этапе обучения. Это позволит не только влиться в среду и быстрее найти стажировку, но и не потерять мотивацию. Также важно создавать портфолио из выполненных проектов, которое станет важным дополнением к резюме. А с вакансиями проблемы не будет — из-за стремительной цифровизации компаний профессия инженера данных становится ключевой, и бизнес крайне нуждается в таких специалистах.