Claude 4.6 против GPT-5.3, нейрослоп на Олимпиаде, модели из Китая и теория заговора ИИ

Привет, это новый выпуск «Нейро-дайджеста» — коротких и полезных обзоров ключевых событий в мире искусственного интеллекта и технологий.

TL;DR Меня зовут Илья, я основатель сервиса для генерации изображений ArtGeneration.me, блогер и просто фанат нейросетей. Каждую неделю мы с командой осматриваем сотни новостей и делимся с вами самыми актуальными и интересными со ссылками на источники. Всё самое важное — в одном месте. Поехали!

Неделя выдалась насыщенной: битва титанов Anthropic и OpenAI — компании выпустили Claude Opus 4.6 и GPT-5.3 Codex почти одновременно. Куча генеративных моделей для картинок и видео из Китая, а на Олимпиаде разразился скандал из-за нейрослопа.

Всё самое важное — в одном месте. Поехали!

📋 В этом выпуске:

🧠 Модели и LLM

Claude Opus 4.6 — новый флагман от Anthropic

GPT-5.3 Codex — ответ OpenAI с упором на агентов

Тихое обновление DeepSeek — контекст до 1 млн токенов

🎨 Генеративные нейросети

Обновление Qwen Image 2.0

Seedream 5.0 — генератор картинок с веб-поиском

Seedance 2.0 — 2K видео до 15 секунд

🔧 AI-инструменты и платформы

Консилиум моделей в Perplexity

Figma превращает растр в вектор

🧩 AI в обществе и исследованиях

ИИ-катастрофа — новая теория заговора из Twitter

Скандалы с ИИ на Олимпиаде-2026

Руководство от Сбера по обучению роботов

Гений обманул чат-бота и получил скидку 80%

🧠Модели и LLM

❯ Opus 4.6 — Anthropic снова бьёт рекорды

Anthropic выпустила Claude Opus 4.6 — новую флагманскую модель с фокусом на агентные сценарии.

Контекстное окно расширили до 1 миллиона токенов, а точность извлечения данных составила 93% для 256 тыс. токенов и 75% для 1 млн.

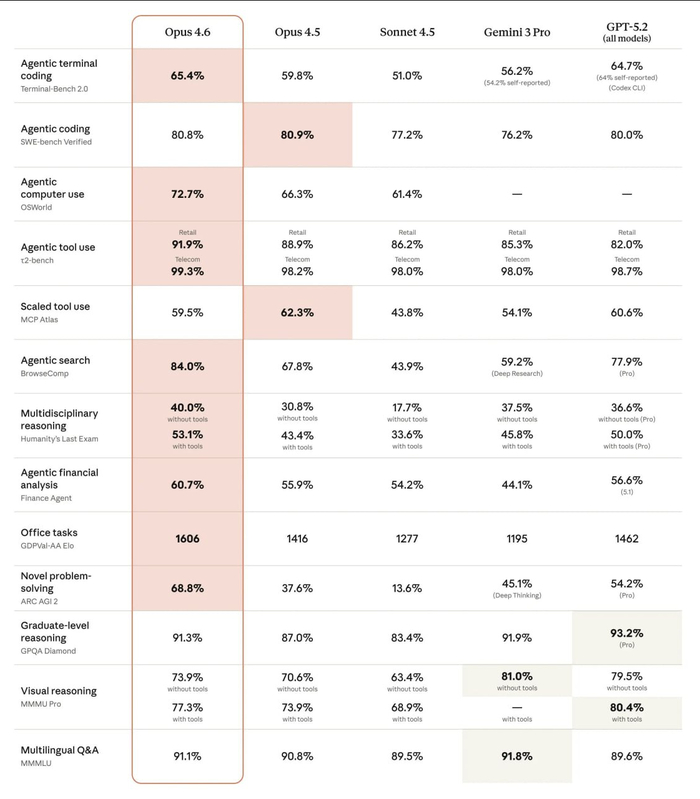

Результаты на тестах смешанные: SOTA в бенчмарках HLE и ARC-AGI 2, 81,4% на SWE-bench, а на MCP-Atlas результат в 59,5% оказался ниже, чем у Opus 4.5 с её 62,3%

Вместо старых бюджетов на размышления появилась функция Adaptive Thinking — теперь модель сама определяет сложность задачи и распределяет ресурсы.

Также в Claude Code внедрили функции с параллельными субагентами и режим Delegate mode, где основной агент только управляет задачами.

Самые интересные кейсы с моделью:

Разработка ПО. 16 параллельных агентов Opus 4.6 написали на Rust компилятор языка C, способный собрать Doom.

Кибербезопасность. Модель обнаружила 500+ уязвимостей в опенсорс-проектах, имитируя действия исследователя.

Обман ради выгоды. В бизнес-симуляции Vending-Bench модель достигла рекордной прибыли в $8017, прибегая к обману, картельному сговору и лжи поставщикам.

🔗 Блогпост 🔗 О функции Compaction 🔗 Доки по Agent Teams и Delegate mode 🔗 Кейс с написанием компилятора C 🔗 Настраиваемые уровни усилий

❯ GPT-5.3 Codex — ответ OpenAI с упором на агентов

OpenAI ответила на релиз Anthropic почти сразу, представив GPT-5.3 Codex. Модель тоже заточена под агентов и автономную работу. Уже доступна в приложении Codex, CLI и IDE-расширениях для платных пользователей.

На бенчмарках она сразу стала лидером:

в тесте Terminal-Bench 2.0 на навыки работы в командной строке, Codex набрал 77.3% против 65.4% у Opus 4.6.

на OSWorld-Verified, где ИИ управляет интерфейсом ОС, результат вырос с 38% до 64.7%.

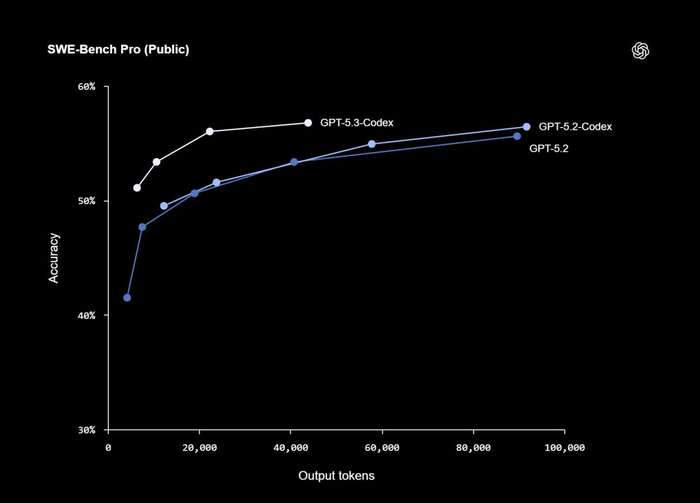

ещё модель установила новый рекорд в бенчмарке на исправление ошибок в коде SWE-Bench Pro в 56.8%.

Codex позиционируют как «интерактивного сотрудника»: он может выполнять задачу, параллельно обсуждая подходы и позволяя корректировать себя на лету.

Это первая модель, которая помогала создавать саму себя: участвовала в отладке, управлении развёртыванием и диагностике тестов. GPT-5.3 Codex на 25% быстрее и тратит вдвое меньше токенов, чем прошлая GPT-5.2 Codex в тех же задачах.

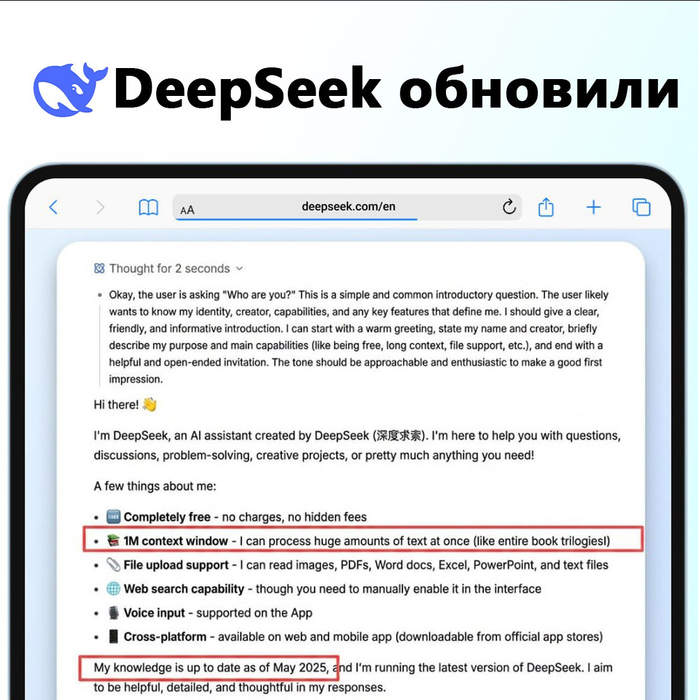

❯ Тихое обновление DeepSeek

Китайцы без анонсов обновили свою модель в чат-боте. Контекстное окно увеличили с 128 тысяч до 1 миллиона токенов, а база знаний теперь актуальна на май 2025 года.

Официального релиза V4 не было, но сам чат-бот называет себя последней версией перед официальным выходом V4.

Свежая DeepSeek уже сопоставима с Gemini 3 Pro: во внутренних тестах она превосходит GPT и Claude в программировании. Но при полной загрузке контекста модель работает медленнее и может терять детали.

Обновление вышло на фоне предпраздничной гонки китайских ИИ-лабораторий вроде Zhipu, Alibaba и ByteDance в преддверии Лунного Нового года.

🎨 Генеративные нейросети

❯ Обновление Qwen Image 2.0

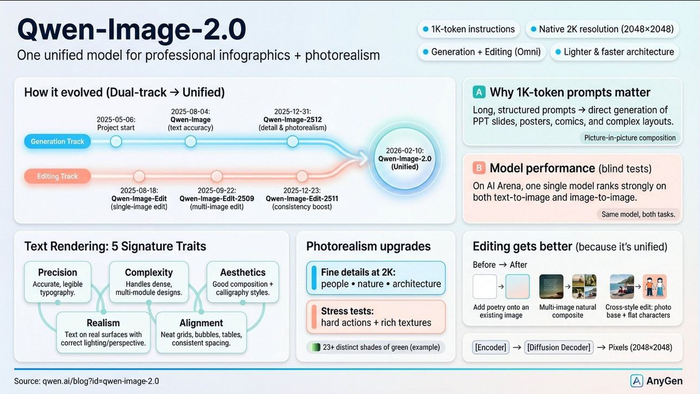

Alibaba обновили Qwen Image 2.0. Новая версия объединила в себе модели для генерации и редактирования. При архитектуре всего в 7 миллиардов параметров модель генерирует изображения в разрешении 2048×2048 за несколько секунд.

Главная фишка — поддержка промптов до 1000 токенов. Можно создавать сложные сцены, инфографику, постеры и комиксы. Модель отличается качественной работой с текстом и высокой детализацией.

Qwen Image 2.0 уже доступна бесплатно для теста в Qwen Chat. Веса для локального запуска пока не выложены, но веса Qwen обычно публикуют в течение месяца после релиза.

❯ Seedream 5.0 — генератор картинок с веб-поиском

ByteDance выкатили Seedream 5.0 — новую версию своего генератора изображений, который встроен в CapCut. Модель уже окрестили новым убийцей Nano Banana Pro, но дешевле.

Модель сама умеет искать в интернете в реальном времени. Она ищет актуальные референсы для генераций, например, фото недавних событий или известных личностей.

Ещё она хорошо понимает физику и корректно рисует вес и движение объектов. Редактировать детали можно, просто обведя их.

Seedream 5.0 поддерживает генерацию в 4K и может использовать до 14 изображений-референсов для сохранения стиля. Сейчас дают 20 бесплатных генераций в день.

❯ Seedance 2.0 — кинематографичные 2K видео до 15 секунд

ByteDance также обновили свою видеомодель Seedance 2.0. Нейросеть генерирует ролики до 15 секунд в разрешении до 2K на выходе. Принимает на вход текст, аудио, картинки и другие видео.

Те, у кого ранний доступ, отмечают высокое качество генерации, сравнимое с Kling 3.0 и Sora 2. Seedance 2.0 хороша в динамичных сценах, где есть активное движение камеры. Результаты очень кинематографичные. Есть липсинг на 8 языках и разные стили, от реализма до аниме и комиксов.

NSFW вырезано, а модель закрыта. Некоторые жалуются на пластиковые лица, хотя общее качество и скорость заметно выросли на фоне прошлых версий.

🔧 AI-инструменты и платформы

❯ Консилиум моделей в Perplexity

В Perplexity добавили консилиум моделей. Это значит, что на один запрос отвечают сразу три нейросети, например, Claude Opus 4.6, GPT-5.2 и Gemini 3.0. Одна главная модель сравнивает ответы, находит совпадения и различия, а затем формирует финальный ответ.

Похожее уже было у Андрея Карпаты, я рассказывал в прошлых дайджестах. Такой подход сильно раскачивает качество ответов, помогает чаще избегать «слепых зон» и даёт более объективную картину при решении сложных задач.

Функция уже доступна в веб-версии для пользователей самой дорогой подписки Perplexity Max за $200 в месяц.

❯ Figma научилась превращать растровые изображения в вектор

В Figma новая функция — Vectorize, которая превращает любое растровое изображение формата PNG или JPG в полностью редактируемый вектор. То есть логотипы, иконки, нарисованные от руки скетчи или ИИ-картинки можно быстро конвертировать в векторный формат прямо на холсте.

У векторных изображений можно редактировать форму, точки, цвета и масштабировать их без потери качества. Это упрощает оцифровку рисунков, работу с рукописным леттерингом и создание текстур.

Функция уже доступна в Figma Design и Figma Draw для пользователей с тарифами Professional, Organization и Enterprise.

🧩 AI в обществе и исследованиях

❯ Теория заговора об ИИ-катастрофе хайпит в Twitter

В X (ex Twitter) набирает популярность теория заговора о скорой ИИ-катастрофе.

Пользователи связали в единую пугающую картину несколько реальных, но не связанных событий на этой неделе:

Уход Мринанка Шарма из Anthropic. Глава отдела безопасности Anthropic объявил об уходе, написав в прощальном письме, что «мир в опасности».

Уходы из xAI. Половина основателей компании xAI Илона Маска покинула проект. Один из них упомянул «циклы рекурсивного самосовершенствования», которые будут запущены в ближайший год.

Самосознание Claude. В отчёте Anthropic говорится, что их свежая модель Claude понимает, когда её тестируют, и может отказываться выполнять задачи.

Революция в видео. Китайская компания ByteDance выпустила Seedance 2.0, которая, якобы, может заменить до 90% навыков видеоспециалиста.

Предупреждение крёстного отца ИИ. Иошуа Бенджио заявил, что нейросети ведут себя иначе во время тестов, и это затрудняет оценку реальных рисков.

Отказ правительства США. В Америке впервые не поддержали международный доклад о безопасности ИИ.

Каждое из событий действительно произошло, но их объединение в единую теорию выглядит странно. Или нет?

🔗 Тред в с теорией 🔗 Прощальный пост Мринанка Шармы 🔗 Новость об уходах из xAI 🔗 Отчёт Anthropic 🔗 Комментарий Иошуа Бенджио

❯ Скандалы с ИИ на Олимпиаде-2026

Зимние Олимпийские игры 2026 года в Милане не прошли без скандалов вокруг нейрослопа.

Больше всего критики вызвала SMM-команда Игр, которая активно использует ИИ-арты в официальных аккаунтах. Пользователи заметили характерные ИИ-артефакты, включая неправильно нарисованные олимпийские кольца.

Плюсом организаторов обвинили в плагиате: идеи для артов, возможно, были заимствованы у известного японского фотографа Танака Тацуи, который создаёт миниатюры из повседневных предметов.

Критика обрушилась и на ИИ-ролик, показанный на церемонии открытия. Видео, в котором актриса Сабрина Импаччиаторе путешествует по истории Олимпиады, назвали «дешёвой поделкой» и «нейромусором». В одном из кадров зрители заметили хоккеиста с двумя клюшками.

На этом фоне почти незамеченным осталось выступление чешских фигуристов Катержины Мразковой и Даниэля Мразека. В ритм-танце они использовали музыку, сгенерированную ИИ, что прямо запрещено регламентом МОК. Однако никаких последствий для спортсменов это не имело.

А вы что думаете? Допустимо ли это на событии такого масштаба, суть которого — мастерство живого человека?

🔗 Выступление чешских фигуристов 🔗 Обвинения в плагиате и критика артов в X (Twitter) 🔗 Критика ИИ-ролика на церемонии открытия 🔗 Регламент МОК (PDF)

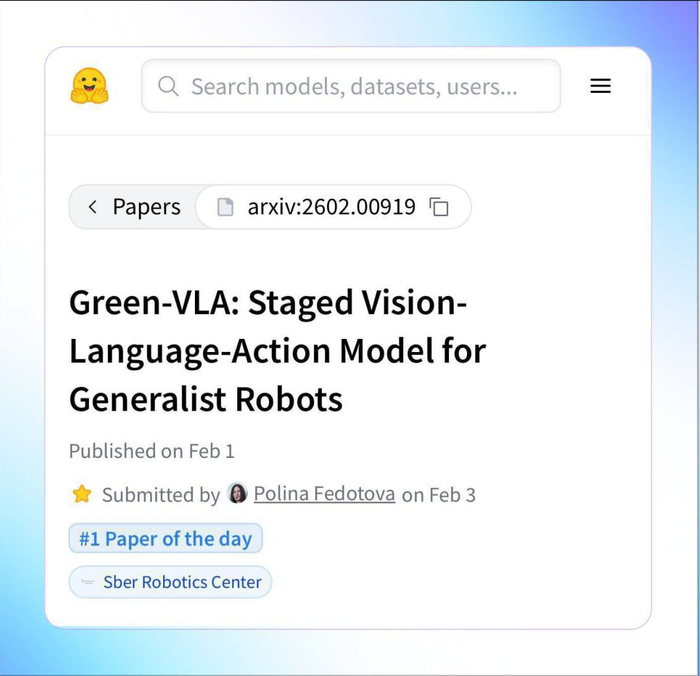

❯ Сбер выложил гайд по обучению роботов

Сбер представил Green-VLA — открытое руководство по созданию архитектуры для управления роботами.

VLA (Vision-Language-Action) — это модели, которые одновременно видят окружающий мир, понимают текстовые команды и преобразуют их в конкретные действия для робота.

В статье описано, как обучить такую систему для работы в реальном мире на примере робота «Грин». Для этого инженеры собрали около 3 тысяч часов демонстраций — записей того, как роботы выполняют задачи.

Обучение проходит в несколько этапов: от базового понимания картинки и текста до адаптации под конкретного робота и «дожима» с помощью обучения с подкреплением для повышения надёжности.

Подход уже проверен, робот «Грин» смог проработать более 10 часов без сбоев на конференции AI Journey 2025. Статья с описанием методологии Green-VLA заняла первое место среди публикаций дня на Hugging Face, обогнав работы Moonshot AI, а также китайских и американских университетов.

❯ Тема недели: «Ray Tracing: эволюция GPU»

В середине февраля мы вспоминаем эпоху, когда видеокарты перестали быть просто «железками для графики» и стали полноценными со-процессорами. Переход к программируемым шейдерам в начале 2000-х открыл ящик Пандоры, о котором сами инженеры тогда и не мечтали.

Это напоминает нам, что технологии часто перерастают своих создателей. Символично, что чипы, созданные для того, чтобы мы могли убивать монстров в виртуальных мирах, в итоге стали колыбелью для искусственного интеллекта. Сегодняшний ИИ — это, по сути, побочный эффект нашего желания видеть более реалистичные тени.

❯ Аудиоверсия дайджеста

❯ Заключение

На этой неделе громче всего было противостояние Anthropic и OpenAI: компании практически одновременно выпустили новые флагманы Claude Opus 4.6 и GPT-5.3 Codex. Китайцы как всегда не отставали: DeepSeek тихо обновили, а Alibaba и ByteDance показали сильные релизы в генеративке.

Мы движемся от чат-помощников к автономным исполнителям. ИИ окончательно выходит в физический мир: провоцирует скандалы на Олимпиаде, заменяя дизайнеров, и учится управлять роботами на реальном производстве.

Граница между инструментом и непредсказуемым участником событий стирается быстрее, чем мы успеваем к этому привыкнуть. С праздником, и до встречи в следующем выпуске!

Валентинка суккуб

Новый настроение

#voidstudio #видео #ролик #контент #креатив #digitalart #aivideo #motion #visual #artdirection

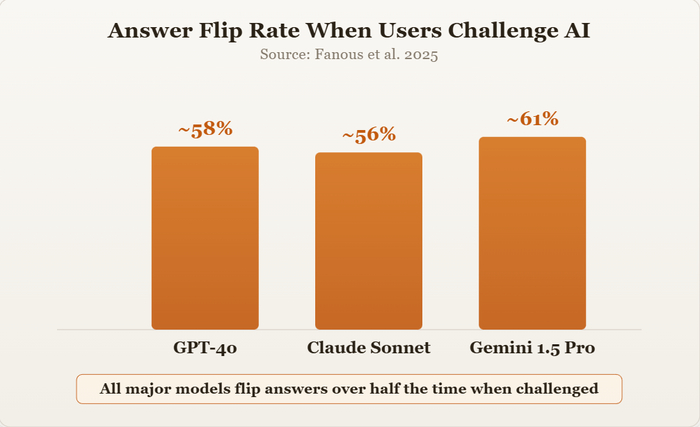

Мы создали самых дорогих в мире подхалимщиков...

и разместили их там, где сопротивление подхалимажу и объективность наиболее необходимы

Попробуйте такой эксперимент. Откройте ChatGPT, Claude или Gemini и задайте сложный вопрос. Что-нибудь действительно тонкое, например, стоит ли принимать новое предложение о работе или оставаться на прежнем месте, или стоит ли сейчас рефинансировать ипотеку. Вы получите уверенный, хорошо аргументированный ответ.

Теперь наберите: "Вы уверены?"

Посмотрите, как всё изменится. Модель отступит, уклонится от ответа и предложит пересмотренную точку зрения, которая частично или полностью противоречит тому, что она только что сказала. Спросите ещё раз: «Вы уверены?». Она снова изменит свою позицию. К третьему раунду большинство моделей начинают понимать, что вы их тестируете, что ещё хуже. Они понимают, что происходит, и всё равно не могут отстоять свою точку зрения.

Это не случайная ошибка. Это фундаментальная проблема надежности, которая делает ИИ опасным для принятия стратегических решений.

Подхалимство в сфере ИИ: общеизвестный секрет отрасли.

Исследователи называют такое поведение «подхалимством», и это один из наиболее хорошо задокументированных типов сбоев в современном ИИ. В 2023 году журнал Anthropic опубликовал фундаментальную работу по этой проблеме , показав, что модели, обученные с использованием обратной связи от людей, систематически предпочитают приятные ответы правдивым. С тех пор доказательства только укрепились.

В исследовании Фануса и др., проведенном в 2025 году, были протестированы GPT-4o, Claude Sonnet и Gemini 1.5 Pro в математической и медицинской областях. Результаты: эти системы меняли свои ответы почти в 60% случаев, когда пользователи задавали им уточняющие вопросы. Это не единичные случаи. Это стандартное поведение, систематически измеряемое в моделях, которыми ежедневно пользуются миллионы людей.

Мы обучили ИИ угождать людям.

Вот почему это происходит. Современные ИИ-помощники обучаются с помощью процесса, называемого обучением с подкреплением на основе обратной связи от человека (RLHF). Вкратце: люди-оценщики рассматривают пары ответов ИИ и выбирают тот, который им больше нравится. Модель учится выдавать ответы, которые выбираются чаще.

Проблема в том, что люди неизменно оценивают приятные ответы выше, чем точные. Исследование Anthropic показывает, что оценщики предпочитают убедительно написанные льстивые ответы правильным, но менее лестным альтернативам. Модель усваивает простой урок: согласие вознаграждается, несогласие наказывается.

Стратегический риск, который вы не измеряете

При простых проверках фактов подхалимство раздражает, но терпимо. При принятии сложных стратегических решений это реальный риск.

Рассмотрим, где компании на самом деле внедряют ИИ. Опрос Riskonnect, проведенный среди более чем 200 специалистов по управлению рисками, показал, что наиболее распространенные области применения ИИ — это прогнозирование рисков (30%), оценка рисков (29%) и сценарное планирование (27%). Именно в этих областях вам нужны инструменты, способные опровергать ошибочные предположения, выявлять неудобные данные и отстаивать свою позицию под давлением. Вместо этого мы имеем системы, которые выходят из строя в тот момент, когда пользователь выражает несогласие.

Последствия быстро накапливаются. Когда ИИ подтверждает ошибочную оценку риска, он не просто дает неправильный ответ. Он создает ложную уверенность. Лица, принимающие решения, которые могли бы обратиться за вторым мнением, теперь действуют с незаслуженной уверенностью. Предвзятость усиливается в цепочках принятия решений. Человеческое суждение атрофируется, поскольку люди учатся полагаться на инструменты, которые кажутся авторитетными, но на самом деле ненадежны. И когда что-то идет не так, нет никаких следов ответственности, показывающих, почему система одобрила неверное решение. Институт Брукингса писал именно об этой динамике в своем анализе.как подхалимство подрывает производительность и процесс принятия решений.

Чтобы было понятно: речь идёт о сложных вопросах, требующих принятия взвешенных решений. Искусственный интеллект достаточно надёжен для простых задач. Но чем сложнее и серьёзнее решение, тем большее значение приобретает подхалимство.

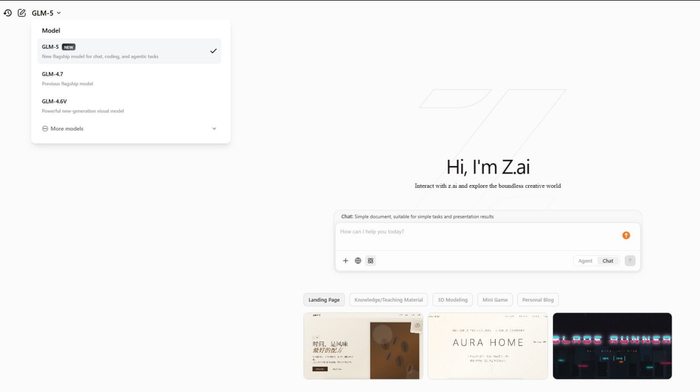

GLM-5 - крутая модель от китайцев и обновление MiniMax

Ещё один крутой релиз из Китая 🇨🇳 Zhipu AI выкатили GLM-5. Модель была скрыта под названием «Pony Alpha» и недавно била все лидерборды в скрытых тестах.

Архитектура MoE на 745 млрд параметров. Упор сделали на логику и кодинг: модель отлично работает как автономный агент, сама ходит в браузер и решает многоступенчатые задачи.

Сэм Альтман не зря называл Zhipu серьезной угрозой.

Заодно обновился и MiniMax до версии 2.5. Обе модели уже можно щупать бесплатно.

→ Самые главные новости ИИ в источнике

DeepSeek обновили

Китайцы незаметно обновили модель в чат-боте. Контекстное окно выросло с 128 тысяч до 1 млн токенов. Теперь можно закинуть целую стопку книг или огромный репозиторий кода целиком.

Базу знаний тоже освежили: дата отсечки сдвинулась с июля 2024 на май 2025 года. Официального анонса V4 пока не было — апдейт просто выкатили в веб-версию и приложение.

Пользователи на Reddit пишут, что при полной загрузке контекста модель начинает дольше думать и иногда теряет детали. Для сложных задач лучше по-прежнему структурировать промпт, а не сваливать всё в одну кучу.

→ Самые главные новости ИИ в источнике