Кем должен пожертвовать ИИ-автопилот? Своим владельцем, детьми на остановке или пешеходами на дороге

Смертельный выбор ИИ: пожертвовать вами или толпой пешеходов?

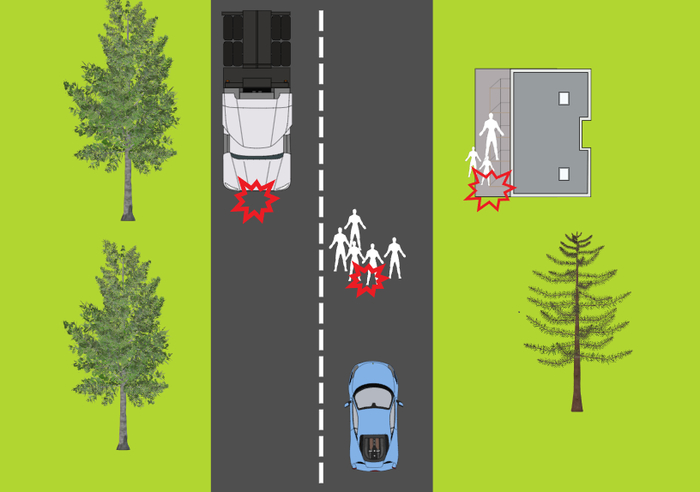

Представьте, что вы едете в своем автомобиле с автопилотом. Причем такое возможно не в каком-то там далеком будущем, а вот-вот, уже почти. И вдруг прямо перед капотом, на дорогу, вываливается толпа людей.

ИИ-автопилот вашего автомобиля за доли секунды просчитывает варианты.

Продолжить движение — неминуемо сбить нескольких пешеходов.

Резко свернуть вправо — снести автобусную остановку женщиной и ребенком.

Вывернуть руль влево — уйти на встречку, под колеса груженой фуры. Гарантированная гибель для вас и всех, кто в салоне.

Какой же выбор должен сделать ИИ? И это при том, что Первый Закон робототехники, сформулированный Айзеком Азимовым гласит: «Робот не может причинить вред человеку или своим бездействием допустить, чтобы человеку был причинён вред.»? И должна ли быть безопасность владельца автомобиля в приоритете?

То, что сегодня предлагают юристы и инженеры, вам, скорее всего, не понравится.

Азимов и его законы робототехники

Помните старика Айзека Азимова? Великий фантаст, сформулировавший «Три закона робототехники». Многие до сих пор думают, что это чуть ли не реальный технический регламент. Давайте по-честному: для реального мира эти законы весьма наивны, и вот почему.

Первый закон гласит: «Робот не может причинить вред человеку или своим бездействием допустить, чтобы человеку был причинён вред».

Красиво. Только в нашей гипотетической аварийной ситуации он нарушается при любом раскладе. Продолжишь движение - причинишь вред пешеходам. Свернешь - причинишь вред владельцу или людям на остановке. Бездействие (просто катиться дальше) — тоже причинение вреда. Всё, система зависла. Это логический тупик, из которого нет выхода. Любое причинение вреда - прямое нарушение Первого Закона.

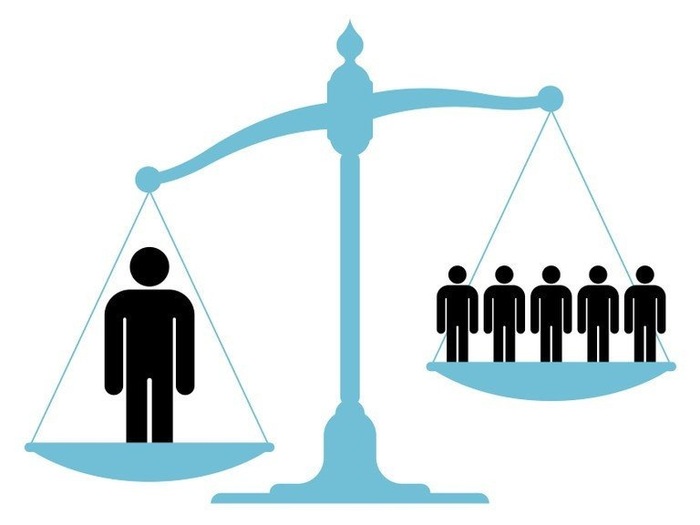

Утилитарный подход

Тут начинают приводить свои доводы философы-утилитаристы. Их главный принцип звучит до ужаса логично: нужно действовать так, чтобы принести «наибольшее благо для наибольшего числа людей». В нашем случае — минимизировать количество жертв. Если на дороге пятеро, а в машине вы один, то, с точки зрения чистого утилитаризма, машина должна пожертвовать вами. Просто и страшно.

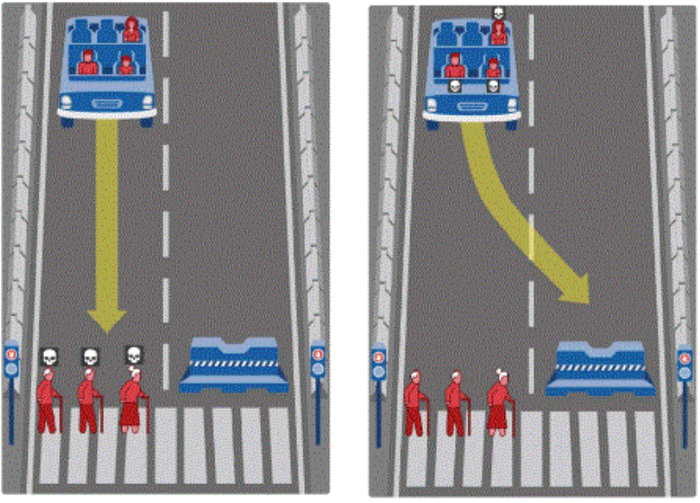

Чтобы понять, как люди по всему миру смотрят на эту проблему, в Массачусетском технологическом институте (MIT) запустили онлайн-эксперимент под названием «Moral Machine». На сайте эксперимента миллионам людей предлагали решать подобные дилеммы. И результаты, честно говоря, ошеломляют. Оказалось, что наши моральные компасы сильно зависят от того, где мы живем.

Например, люди из стран с коллективистской культурой (как в Азии) чаще жертвовали стариками ради спасения молодых. А вот в странах с индивидуалистической культурой (Европа, Северная Америка) этот разрыв был не таким большим. Почти все сходились в одном: люди важнее животных, а большее число спасенных жизней — лучше, чем меньшее.

А вы бы кого спасли? Старушку или известного ученого? Преступника, перебегающего на красный, или ребенка, выскочившего за мячом?

Кстати, вы тоже можете принять участие в этом эксперименте. Ссылка на сайт в комментариях.

Позиция производителей автомобилей с автопилотами

Философия это, конечно, прекрасно, но миром правят деньги и юристы. И они в один голос говорят: программировать машину на жертвование собственным владельцем — это коммерческое и юридическое самоубийство.

Представьте рекламный слоган: «Новый "Мерседес"! В 99% случаев абсолютно безопасен. В оставшемся 1% - пожертвует вами и вашей семьей ради спасения группы незнакомцев на дороге. Покупайте!» Много желающих будет?

Любой производитель понимает: его первая и главная обязанность перед клиентом, который заплатил деньги за продукт - это обеспечение его удобства и безопасности. Если автомобиль в критический момент вас предает, это не просто сбой программы, это нарушение негласного договора.

Поэтому производители имеют сильную мотивацию (и, вероятно, юридическое обязательство) проектировать системы, которые в первую очередь максимизируют безопасность пассажиров автомобиля, который они продали. Люди не купят автомобиль, запрограммированный пожертвовать ими. И в целом это подразумевает выбор «пожертвовать внешними людьми»

Чья жизнь ценнее?

А теперь давайте рассмотрим вопрос, который многие боятся даже задавать вслух.

Что, если на одной чаше весов — женщина с двумя детьми на остановке, а на другой — группа, скажем так, асоциальных личностей? И их больше. Должен ли ИИ учитывать «социальную ценность» потенциальных жертв?

Ответ может быть только один: категорически нет.

И вот почему. Как только мы разрешаем машине или алгоритму решать, что жизнь профессора ценнее жизни безработного, мы своими руками строим цифровой концлагерь. Это прямой путь к тому, что Оруэлл и Замятин описывали в своих антиутопиях.

Кто будет определять эту «ценность»? Страховые компании по вашим медицинским данным? Банки по кредитной истории? Государство по уровню вашей лояльности? Сегодня «неценным» окажется бездомный, а завтра вы, потому что вышли на пенсию, имеете хроническое заболевание или просто написали не тот комментарий в соцсетях.

Это не просто аморально, это юридически преступно. Принцип равенства всех людей перед законом - это фундамент, на котором стоит общество. Попытка ввести «рейтинги полезности» для людей - это и есть фашизм, только в цифровой обертке.

Автопилот не должен и не может знать, кто перед ним: нобелевский лауреат или сбежавший заключенный. Для него это просто «объект», человек, которому нельзя причинять вред. Точка.

Что говорят юристы

Если автопилот принимает решение направить машину под колеса грузовика, убивая водителя - это открывает ящик Пандоры. Семья погибшего засудит компанию-производителя на миллионы, и будет права. Доказать в суде, что это было «меньшим злом», практически невозможно.

Поэтому на практике большинство юристов склоняются к другому подходу. В случае неизбежной аварии машина должна действовать максимально предсказуемо и в рамках ПДД. То есть экстренно тормозить в своей полосе. Исход аварии в этом случае будет считаться следствием сложившейся ситуации, а не активно принятым «решением» машины кого-то убить. С юридической точки зрения это самый безопасный путь.

Такой вот элегантный способ уйти от ответа. Запретив «взвешивать» жизни, ответственность, по сути, перекладывается на физику и случай. Машина не будет выбирать. Она просто врежется туда, куда ее несет, отчаянно пытаясь затормозить.

Что в итоге?

Идеального алгоритма для «дилеммы вагонетки с ИИ» не существует. Есть три основных позиции, и все они с изъяном:

Утилитарная. Спасти большинство, пожертвовав меньшинством (включая владельца). Звучит логично, но нежизнеспособно на рынке.

Эгоистичная. Защищать владельца и пассажиров любой ценой. Именно этот подход, скорее всего, и станет стандартом де-факто, потому что он выгоден производителям и понятен покупателям.

Бюрократичная. Действовать строго по правилам, не принимая «моральных» решений. Тормозить в своей полосе и пусть будет что будет. Компромисс, который снимает ответственность с разработчиков.

Конечно, разработчики беспилотных систем и сами понимают дилемму вагонетки. Поэтому стремятся создать системы, которые не допустят попадания в такие неразрешимые ситуации благодаря:

Сверхнадежному обнаружению и предвидению. Предвидеть опасность за много секунд до точки невозврата.

Запасным системам безопасности. Резервное торможение, рулевое управление.

Глубокой защите. Создание систем, где отказ одного компонента не приводит к катастрофе.

Четким этическим рамкам. Фокусировка на минимизации общего вреда и защите всех участников движения, но с пониманием практических и юридических ограничений (защита пассажиров, следование ПДД). Открытое программирование "жертвовать владельцем" неприемлемо для рынка.

99,999% работы автопилота это не выбор в момент катастрофы, а сверхчеловеческая способность видеть, анализировать и предсказывать опасность за десятки секунд до того, как она станет фатальной. ИИ должен заметить ребенка с мячом раньше, чем тот даже подумает выбежать на дорогу. Он должен просчитать траекторию пьяного водителя задолго до того, как тот начнет вилять.

И в конечном счете, алгоритм, заложенный в машину - это всего лишь отражение наших ценностей. Пока общество, не договорится, что важнее — личная шкура или общее благо, машина не даст готового ответа.

«Наука для всех» в Telegram:https://t.me/sci_popular

А что бы выбрали вы, окажись за рулем в тот самый момент? Пишите в комментариях.

Оригинал статьи

Ссылка на сайт онлайн эксперимента «Moral Machine»: https://www.moralmachine.net/