Правила генерации в Veo3 опытным и непростым путём (чтобы сделать вот такую смешинку)

Вчера я сел попробовать Veo3, самую крутую видео-нейросетку на данный момент, и сделал mindfulness-смешинку выше.

Доступ к Veo3 я получил очень просто — у меня был американский Google-аккаунт, и он разрешил оформить триал на тариф за $20.

И вот я стал счастливым обладателем 10 генераций. Кстати, интересно: когда через интерфейс Gemini я использовал все 10 кредитов, он сообщил, что новые лимиты появятся только 31 мая. Надеюсь, это не шутка.

Какие правила я выделил:

1️⃣ Даже в консоли Gemini промпт пишем на английском, но прямую речь в кавычках можно писать на русском языке. Так и пишем:

...(he/she) says in Russian: «....»

Тогда речь действительно будет на русском. Также можно добавить надпись на русском (как я сделал на видео с надписью «СССР»).

Кстати, английский язык генерируется гораздо лучше русского.

2️⃣ Помните, что видео может быть максимум 8 секунд, и с прямой речью работает только text-to-video. То есть нельзя загрузить картинку, чтобы она заговорила. А ещё, если вы захотите продолжить генерацию, то там будет уже Veo2, а не Veo3. В общем, используйте свои 8 секунд аккуратно. Если нужен тот же персонаж, точной копии не будет — придётся максимально подробно описывать его заново, чтобы хотя бы был похож.

3️⃣ Важно: если хотите прямую речь или пение, не прописывайте персонажу никаких действий кроме says или sings. Иначе он начнёт совершать действие (например, брить мужика как ниже), но не заговорит (с английской речью тут попроще).

4️⃣ Можно указать каждую деталь: музыку, шумы, акценты, эмоции. Промпт может быть большим, но учитывайте, что всё это должно уложиться в 8 секунд. А ещё имейте в виду, что не больше половины запросов генерируется без галлюцинаций. Вот пример. Просто внезапно она перевела мою русскую речь на английский.

5️⃣ Можно делать акценты! Например, на втором видео был грузин, которому я прописал русский язык с грузинским акцентом. Без аудио тоже иногда генерится, просто нет звука. И пожаловаться некому ( В общем 30% только нормального результата.

6️⃣ Пишите цифры словами для правильного произношения, а также не используйте тире — иначе ваш персонаж может случайно матюкнуться, как это произошло с моим милиционером.

Итогом, сделать видео в veo3 заняло около часа)

пожалуй всё, ещё два-три месяца, и это действительно будет уже продакшн-уровень для фильмов. Главное, чтобы цена снизилась, а то 8 секунд стоит 200-300 рублей)

== Но я не успокоился, и решил всё адаптировать под вертикальный формат.

Но как это сделать, когда у меня 16 на 9 видео?

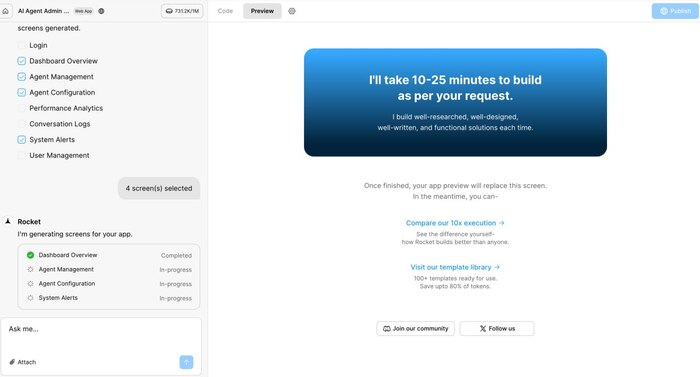

1️⃣ Идём в RunwayML (http://runwayml.com/), выбираем "создать сессию", а затем выбираем Gen-3-Alpha-Turbo

2️⃣ В менюшке справа, которая состоит из 4 значков, выбираю последний — Expand video

3️⃣ Загружаю видео и расширяю границы куда надо — из рилса также можно сделать горизонтальный формат. А далее ввожу промт — там просто описываю, что мне надо или не надо видеть. Коротенький, типа "минималистичная улица, без надписей"

4️⃣ Чтобы совсем хорошо было, у готовой генерации снизу нажимаю 4к, и получаю видео в соотвествующем качестве! Тогда и увеличивать можно не боясь как я вот тут сделал.

Результат вот такой получается:

P.S. Звук оригинальный остаётся, можно не бояться.

P.P.S. Шутки написал не я, а Claude 4 sonnet ) Он ограниченно бесплатный с VPN)

Если будет настроение - заходите в мой тг канал, там тоже всякую практику из своей работы даю по вайбкодингу, автоматизации и вот таким вот штукам выше