Как сделать эффект пикселей CRT-screen (ЭЛТ-монитора) в Photoshop

Перед прочтением предупрежу, что в гайде будет очень много повторений слова "пиксель", учтите это перед ознакомлением, пожалуйста.

В последнее время очень увлекся стилем synthwave VHS, даже для прошлого поста про художников замутил обложку, придерживаясь всех канонов. Досконально разобрал стиль и заболел им — так появилась эта инструкция.

Что нам понадобится?

Героем программы сегодня станет Adobe Photoshop. А в напарники к нему пойдет черно-белый исходник моего логотипа. Цветные варианты тоже подойдут, скажу пару слов об этом в конце.

Перейдем к практике

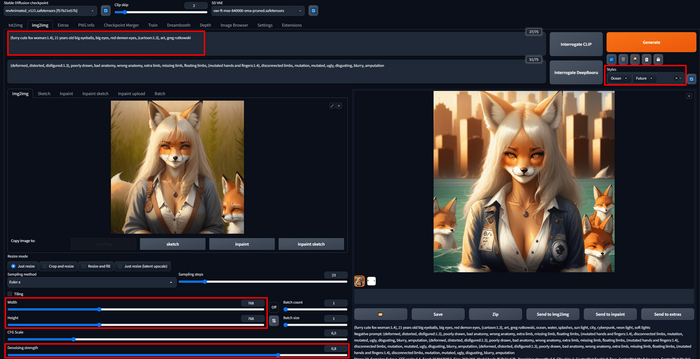

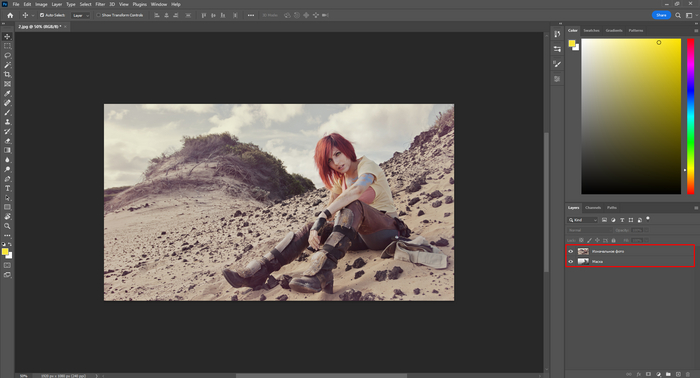

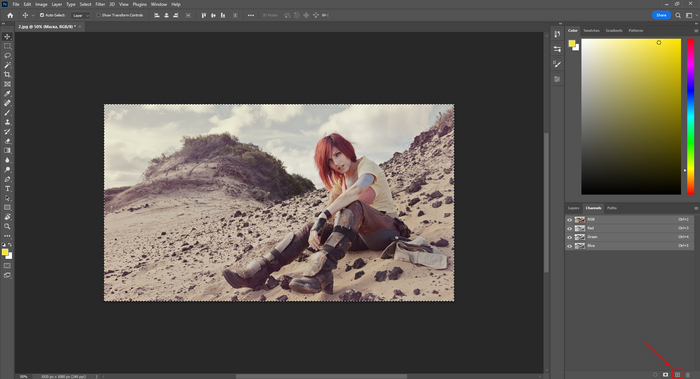

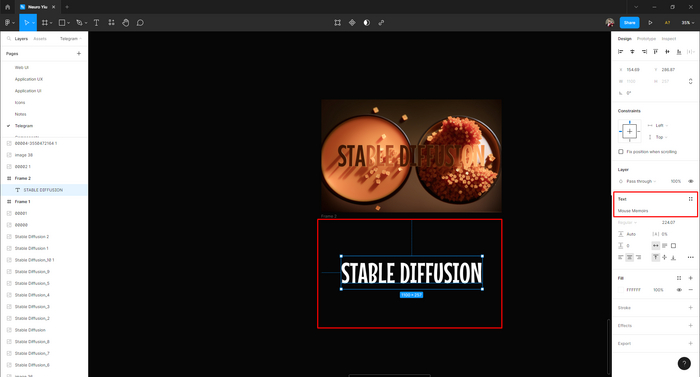

Для начала создадим черную заливку и загрузим логотип в Photoshop — кадрируем под нужное нам соотношение сторон и располагаем там, где нужно. Пока выглядит совсем не олдово, но мы это исправим :]

Затем дублируем слой с логотипом и преобразуем его в смарт-объект (Convert to smart object) — так мы можем в любой момент корректировать изменения и параметры наложенных фильтров. Для преобразования клацкаем ПКМ по слою и ищем нужный пункт меню.

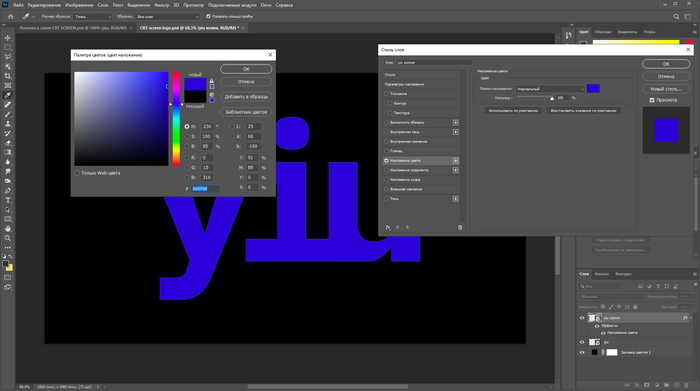

Далее кликаем два раза ЛКМ по копии слоя и выбираем наложение цвета (Сolor overlay) — заливаем синим. Нужно это для того, чтобы затем добавить хроматические аберрации ЭЛТ-монитора.

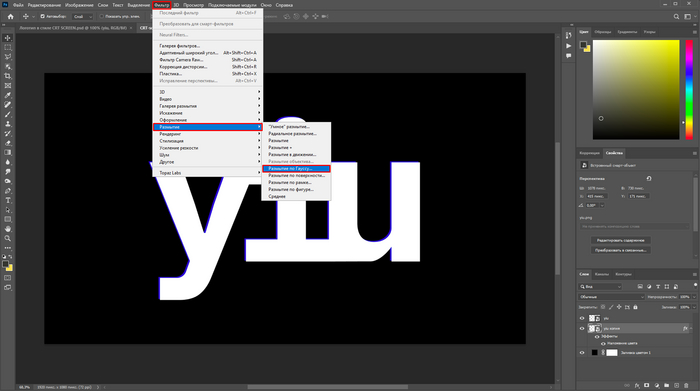

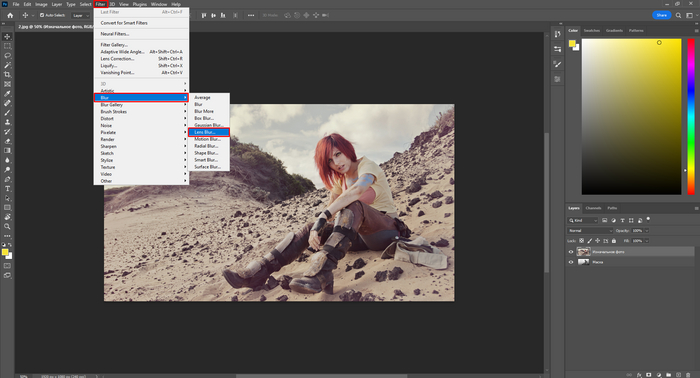

Скопированный слой переносим ниже и нажимаем на стрелки на клавиатуре три раза влево и два вверх. После данной операции в окне эффектов выбираем размытие по Гауссу (Gaussian blur).

Интенсивность эффекта выставляем на 20%, а непрозрачность слоя выбираем 65%.

Снова дублируем слой и в наложении цвета выбираем бирюзовый, непрозрачность которого должна стоять на 30%, а радиус размытия на 110%. Получиться должно примерно следующее:

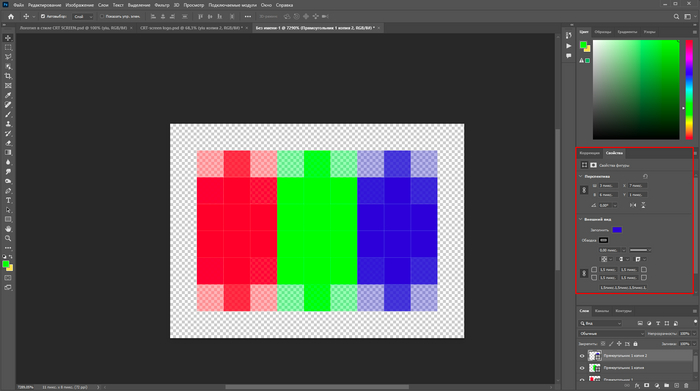

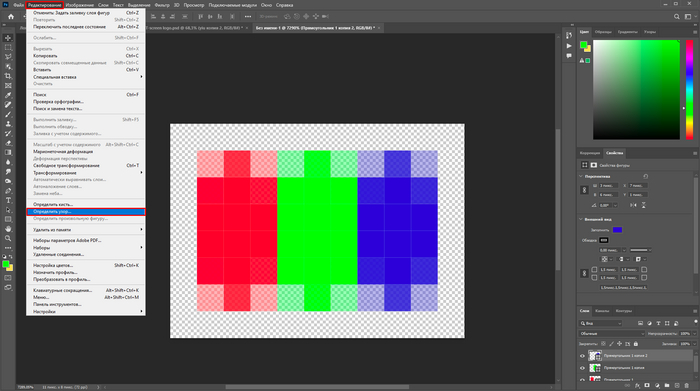

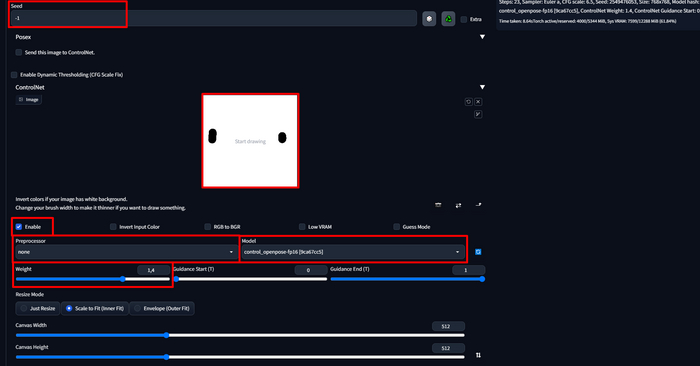

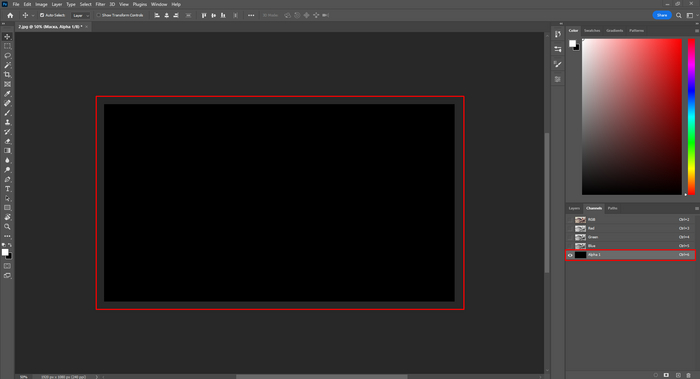

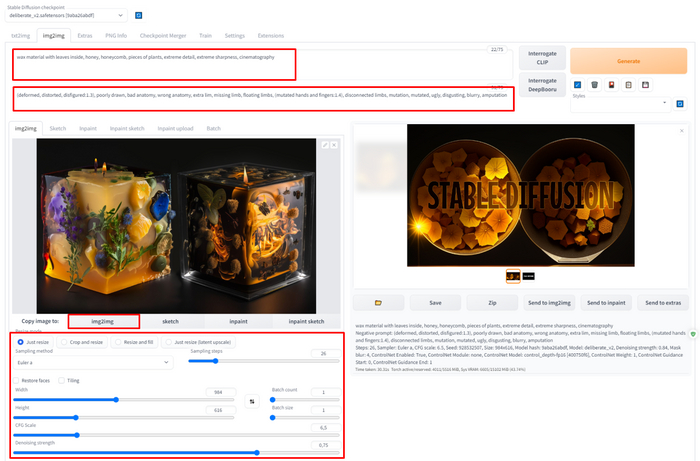

Далее самое интересное — создание пикселей и их наложение по всему кадру. Делать их мы будет вручную, ибо в интернете ни один исходник не подойдет. Что для этого нужно? Ну, во-первых, создать новый файл (11 на 8 пикселей) с прозрачным фоном, а во-вторых, нарисовать эти самые пиксели с помощью фигуры прямоугольник. Файл, думаю, создать без подсказок сможете, а вот про пиксели подробнее расскажу.

На самом деле все просто — пугаться не стоит.

В новом файле мы рисуем прямоугольник (3 на 6 пикселей) с помощью инструмента, собственно, прямоугольник (Rectangle), после чего скругляем углы на 1.5 пункта —это даст нам имитацию тех самых старых пикселей и добавит реализма: будто снято на реальную камеру.

Так вот, созданный прямоугольник со скругленными гранями мы красим в красный, затем дублируем — заливаем зеленым, а потом и синим. Все, мы получили пиксель из трех цветов.

Из прекрасного трехцветного рисунка делам узор, который потом сможем наложить на логотип. Что нужно? Заходим в пункт редактирование (Edit) — определить узор (Define pattern). Называем его, как душе угодно, и возвращаемся к логотипу.

Закрываем страницу с прямоугольниками без сохранения.

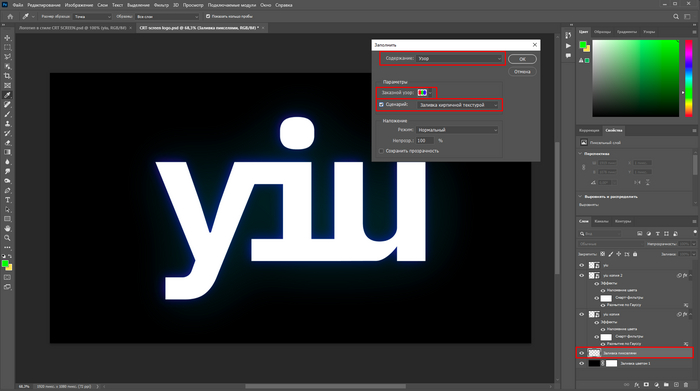

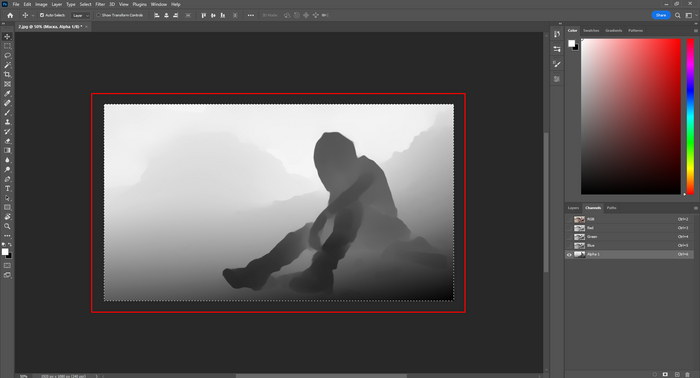

Вернувшись, создаем новый слой, выделяем его, клацаем по разделу редактирование (Edit) — выполнить заливку (Fill). В открывшемся окне ставим параметры, как у меня.

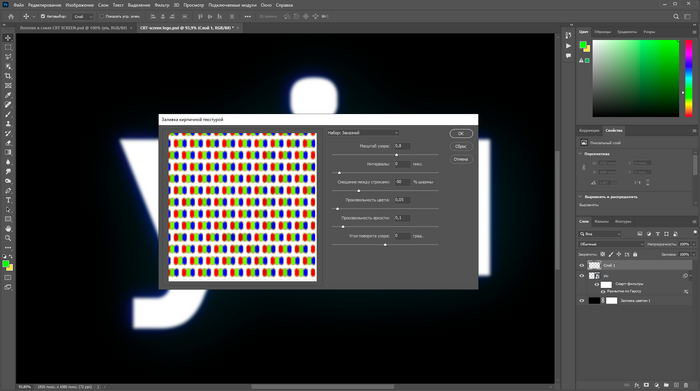

Ниже тоже повторяем за мной. Можете пробовать экспериментировать с масштабом узора до единицы — так структура пикселей будет более проработанная, а картинка перестанет рябить.

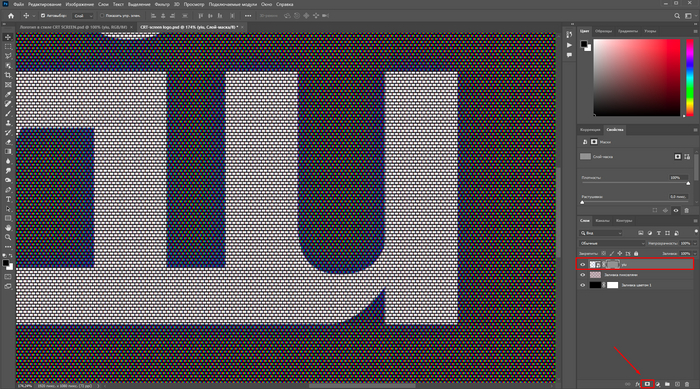

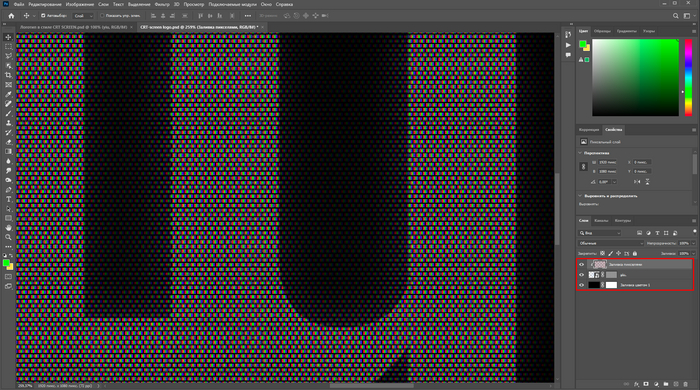

Вот у нас создастся сетка из пикселей под логотипом, но нам ведь не нужна такая каша, правильно? Правильно!

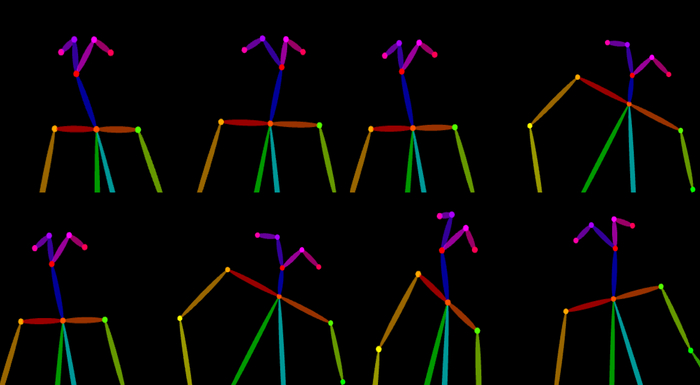

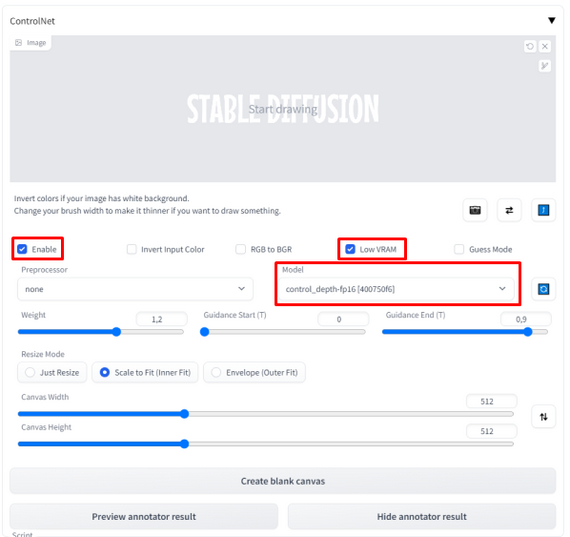

Чтобы кашу расхлебать, мы выделяем три слоя логотипа и преобразуем в смарт объект (smart object). Далее с зажатым CTRL кликаем по слою с пикселями — они должны выделиться — нажимаем на слой с лого и создаем для него маску.

Мы на финишной прямой, не засыпать!

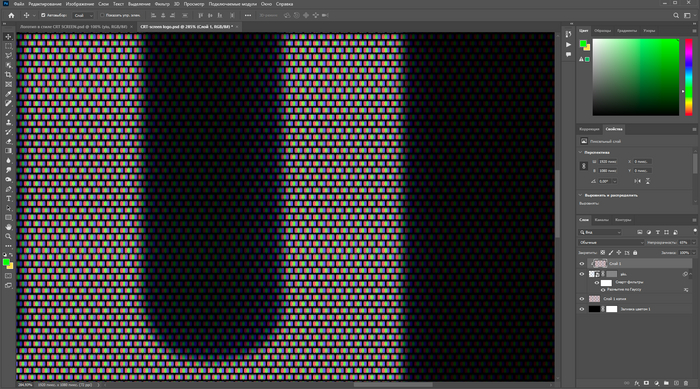

Перемещаем слой с пикселями наверх и наводим курсор между слоями логотипа и RGB, с зажатым ALT смело клацаем ЛКМ — так сетка старинных лампочек будет отображаться только там, где есть логотип.

Для лучшего эффекта дублируем слой с сеткой пикселей и перемещаем вниз — ставим непрозрачность на 10%. У старых телевизоров всегда видны пиксели, поэтому важно их отобразить. Не менее важно размыть логотип на 9% по Гауссу — так мы добьемся неравномерности подсветки, прям как у старых телевизоров!

Также непрозрачность верхнего слоя (который прикреплен к логотипу) переводим на 65% — это уберет чрезмерную рябь и добавит читаемости.

Дополнительно я исказил картинку с помощью (Lens distortion), ибо ЭЛТ-экраны все немного выгнутые. Сочетанием клавиш (CTRL + ALT + SHIFT + E) объединяем слои и заходим в фильтры (Filters) — фильтр Camera raw (Camera RAW filter) — повторяем за мной.

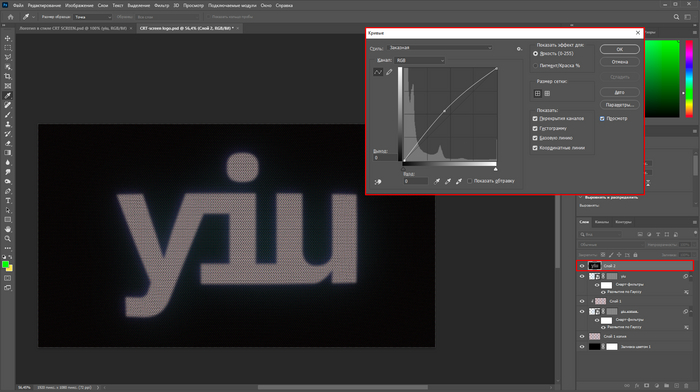

Нет ничего идеального, подумал я, но все же решил кривыми (Curves) прибавить изображению яркости. Выделяем верхний слой и жмем (CTRL + M).

Цель достигнута :3

Кстати, с цветным изображение работает также прекрасно. Единственное, нужно будет выставить режим наложения у сетки пикселей на линейный затемнитель (Darker color).

Congratulations, вы справились!

Теперь кто-то умеет воспроизводить эффект CRT-screen с помощью Photoshop :3

Буду рад обратной связи и вашим комментариям, а также приглашаю в свой телеграм чат, где отвечу на все вопросы касаемо дизайна и генерации изображений с помощью нейросетей.

Буду рад видеть вас в телеграм-канале, где я собираю лучшие гайды по Stable Diffusion. А если не найду, то пишу сам.