Что делать, если не работает Automatic1111, а генерировать красоту надо? Спасаем ситуацию!

Друзья, предисловие для затравки

Три дня я не мог работать в Automatic1111 из-за появившихся багов со стороны разработчика. Три дня я страдал, искал решение, переустанавливал все подряд как в Google Drive, так и на своем ПК — ничего не помогало...

Работать было нужно, поэтому использовал Midjourney от безысходности. Кстати, кому интересно, в моем телеграме есть гайд, как пользоваться миджорни бесконечно и бесплатно.

Решение оказалось гениальным и простым: я вспомнил, как когда-то видел в местном чате кастомный блокнот Google Colab, в котором можно было в пару кликов запустить одну из популярных моделей. Я подумал: а вдруг этот блокнот не обновился вопреки официальному репозиторию? И оказался прав, блокнот действительно остался тем же самым и работал так же хорошо, как и раньше. Бинго! Кстати, вот автор блокнота.

Перейдем к практике

По ссылке вы сможете перейти на тот самый блокнот, который работал не смотря на массовые сбои. Я сделал его копию к себе на диск и обновил некоторые модели на более свежие, чтобы вы могли пользоваться самыми новенькими наработками сообщества стэблистов.

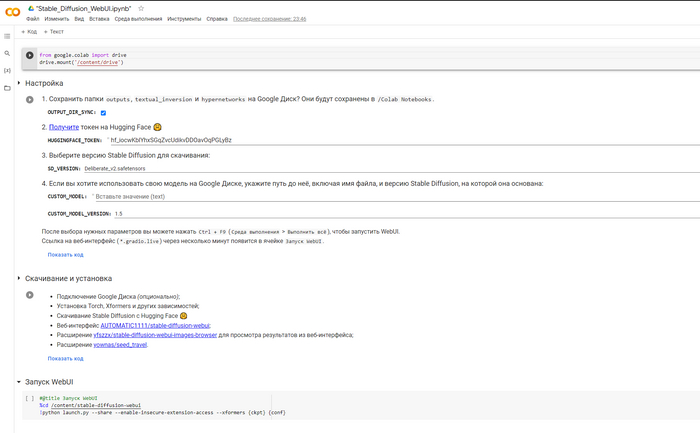

Когда вы переместитесь по ссылке, то увидите следующий интерфейс:

Как вы можете видеть, разделов совсем минимум, не то что в оригинальном Automatic1111 от TheLastBen. Давайте разберем все по порядку, чтобы не было куриного переполоха.

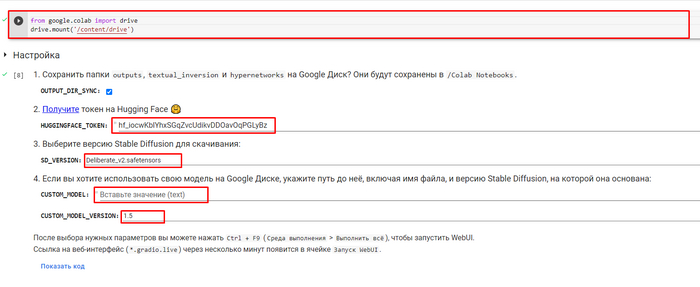

Первый блок — это подключение своего Google disk, чтобы можно было загружать и выгружать файлы. Данный пункт не обязателен, так как сборка способна работать полностью автономно.

В блоке Настройка мы видим пункт для ввода HuggingFace_Token, который понадобится для того, чтобы сборка могла загружать модели и использовать их для генерации изображений.

В пункте 3 клацаем на понравившуюся модель из выпадающего списка, либо в четвертом вставляем ссылку на путь к своей модели. После всех махинаций необходимо выбрать версию модели (зачастую это 1.5)

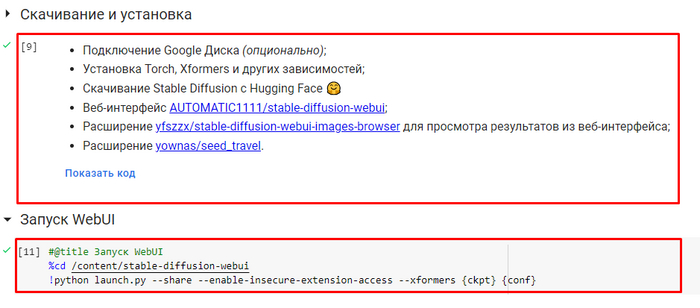

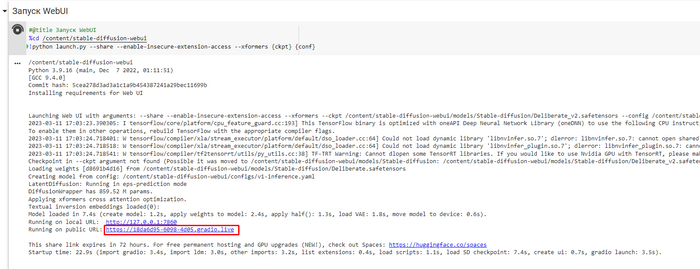

Разделы на скриншоте выше загружают то, что мы выбрали на предыдущем шаге, после чего запускается веб-интерфейс Automatic1111. Запуск сборки составляет 3-4 минуты, что вполне допустимо и терпимо + ваш диск не засоряется лишними файлами, а это значит, что не нужно будет тратить время на их удаление. Сборку также не придется переустанавливать, поэтому эти 3-4 минуты ничего не решают.

Минус же заключается в том, что каждый раз придется запускать все заново, а ваши генерации удалятся при закрытии блокнота. Учтите, что изображения придется сразу сохранять к себе на компьютер и только потом останавливать процесс, в противном случае они сотрутся.

Когда вы запустите последний блок, то появится ссылка, выделенная красным — по ней и нужно перейти, чтобы открылся веб-интерфейс.

Кстати, в сборке сразу же установлено расширение depthmap2mask, с помощью которого можно вырезать фон, строить карту глубины и менять окружение фотографии.

Congratulations, вы справились!

Теперь кто-то умеет работать и создавать красоту даже тогда, когда остальные только чешут репу и думают: эх, не сегодня, Джонни. Буду рад обратной связи и вашим комментариям, а также приглашаю в свой телеграм чат, где отвечу на все вопросы касаемо SD.

Заходите в телеграм-канал, где я собираю лучшие гайды по Stable Diffusion. А если не найду, то пишу сам.