Искусственный интеллект в медицине: обещания и боль от некачественных данных

Автор: Денис Аветисян

Все мы знаем, что персонализированная медицина – это благородная цель, но пока что она больше напоминает красивую обёртку от конфеты, чем реальный прорыв. Постоянно говорят о революционных данных, о геномных чудесах, но когда дело доходит до реальной интеграции этих потоков информации, всё упирается в старые добрые проблемы совместимости и, будем честны, банальной небрежности. И вот, когда мы уже почти смирились с тем, что "Implementation of AI in Precision Medicine" станет очередным набором красивых слайдов, авторы этой работы заставляют задуматься: а не окажется ли, что главная сложность не в алгоритмах, а в том, что мы, как всегда, пытаемся прикрутить высокотехнологичное решение к системе, которая сама по себе разваливается?

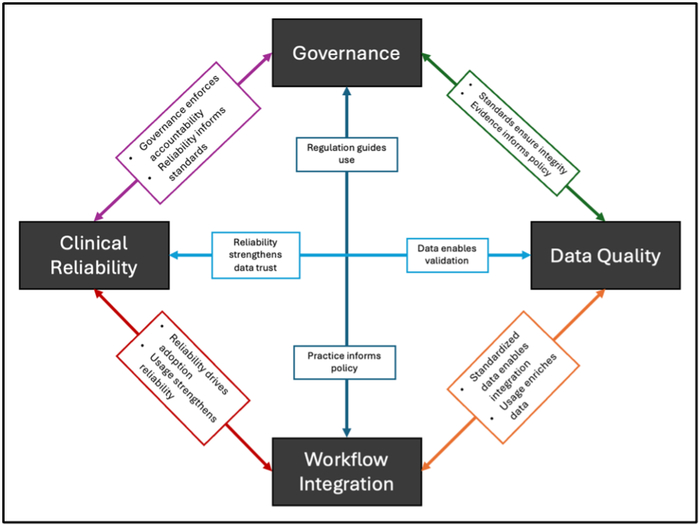

Элегантная идея точной медицины на базе ИИ сталкивается с суровой реальностью: внедрение – это всегда компромисс между мечтой и тем, что реально работает. В этой схеме – все факторы, которые неизбежно сломают идеальную теорию.

Персонализированная медицина: Между надеждой и техническим долгом

Идея «персонализированной медицины» звучит, конечно, заманчиво. Обещания адаптировать лечение под конкретного пациента, выстраивая терапию на основе его уникального набора данных… Всё это, в теории, может радикально изменить здравоохранение. Но давайте смотреть правде в глаза: за каждым «революционным» прорывом скрывается тонна технического долга. Авторы этой работы, как и мы все, прекрасно понимают, что переход к AI-управляемой медицине – это не просто вопрос алгоритмов, а комплексная проблема, упирающаяся в существующую инфраструктуру.

В основе этого нового подхода лежит концепция Мультимодальных данных. Не просто генетический анализ, не только история болезни, но и образ жизни, привычки, даже данные с носимых устройств. Всё это – потенциальный источник ценной информации, который, в теории, позволяет выстроить более точную и эффективную модель лечения. Но, как известно, чем больше данных, тем больше головной боли. Интегрировать, очистить, структурировать, обеспечить безопасность… Это задача, которая требует огромных ресурсов и, главное, хорошо продуманной архитектуры.

Авторы подчеркивают, что просто создать «умный» алгоритм недостаточно. Необходимо решить ряд серьезных проблем, связанных с внедрением AI в существующую систему здравоохранения. Нехватка квалифицированных специалистов, устаревшее оборудование, разрозненные базы данных, отсутствие стандартов… Всё это – препятствия, которые необходимо преодолеть, чтобы AI-управляемая медицина перестала быть красивой теорией и превратилась в реальность. Они говорят, что часто «оптимизируют ради оптимизации» и, в итоге, только усложняют процесс.

Авторы подчеркивают, что успешное внедрение AI требует не только технических инноваций, но и серьезных организационных изменений. Необходимо пересмотреть существующие процессы, обучить персонал, обеспечить взаимодействие между различными подразделениями. И, самое главное, необходимо помнить, что AI – это всего лишь инструмент, который должен помогать врачам, а не заменять их. Мы не создаем автоматизированные системы, мы реанимируем надежду, а это требует очень аккуратного подхода.

В заключение, авторы отмечают, что преодоление этих трудностей является ключом к раскрытию всего потенциала AI в улучшении результатов лечения пациентов. Это не просто вопрос технологического прогресса, это вопрос нашей ответственности перед теми, кто нуждается в помощи. Всё, что оптимизировано, рано или поздно оптимизируют обратно, и нам нужно быть к этому готовыми.

Данные: Основа надежного AI, или почему «мусор на входе – мусор на выходе»

Исследования показали, что точность и полнота исходных данных – краеугольный камень для создания действительно надёжных моделей искусственного интеллекта в здравоохранении. Нельзя построить замок на песке, и нельзя ожидать, что алгоритм выучит закономерности в хаосе. Авторы отмечают, что разрозненность данных, их противоречивость между различными системами – это прямой путь к неэффективности, к бессмысленному потреблению ресурсов. Каждая больница, каждая лаборатория хранит информацию по-своему, словно собирает пазл, детали от которого принадлежат к разным картинкам. И не удивительно, что «устройство» отказывается работать.

На практике это выглядит примерно так: данные одного пациента могут быть распределены между несколькими информационными системами, дублироваться, содержать ошибки или неполные сведения. Это, разумеется, вносит искажения в работу алгоритмов, заставляя их «видеть» ложные закономерности или игнорировать важные факторы. И даже самые сложные алгоритмы машинного обучения бессильны, если исходные данные – это мусор. Всё, что можно задеплоить – однажды упадёт. И это не вина разработчиков, а плата за пренебрежение к качеству данных.

Впрочем, недостаточно просто собрать данные в одном месте. Необходимо обеспечить их стандартизацию, унификацию и проверку на наличие ошибок. Авторы подчеркивают, что надёжная валидация моделей – это не просто техническая необходимость, а фундаментальное требование для обеспечения их применимости в реальной клинической практике. Модель, которая хорошо работает на одной группе пациентов, может оказаться совершенно бесполезной или даже опасной для другой. И тут важна не только статистическая значимость, но и клиническая релевантность.

Особое внимание исследователи уделяют проблеме обобщаемости моделей. Алгоритм, обученный на данных одной больницы, может плохо работать в другой, из-за различий в протоколах лечения, демографическом составе пациентов или особенностях оборудования. Чтобы избежать этой проблемы, необходимо проводить тщательное тестирование моделей на различных группах пациентов и в различных клинических условиях. Но даже это не гарантирует успеха. Любая абстракция умирает от продакшена. Всегда найдутся какие-то краевые случаи, которые модель не учтет, какие-то неожиданные факторы, которые повлияют на результат.

Таким образом, решение проблем с качеством данных – это не просто техническая задача, а комплексный процесс, требующий участия врачей, программистов, аналитиков и других специалистов. Это не просто исправление ошибок, а создание культуры качества, в которой каждый участник процесса осознает свою ответственность за достоверность и полноту информации. Авторы утверждают, что без решения этих проблем клинические выгоды от использования искусственного интеллекта останутся лишь на бумаге. И в этом, пожалуй, заключается главная ирония: самая передовая технология может оказаться бесполезной, если не обеспечить её надёжную основу.

Прозрачность и объяснимость: Почему врачи не доверяют «чёрным ящикам»

Исследования показали, что врачи, как и любые другие пользователи, хотят понимать, почему система пришла к тому или иному выводу. И это не прихоть, а необходимость. Ведь мы все знаем, как прекрасно работает «продакшен» — рано или поздно найдется случай, когда элегантная модель выдаст совершенно абсурдный результат. И тогда кто будет отвечать? Не алгоритм, конечно.

Поэтому методы Explainable AI (XAI) — это не просто модное словечко, а критически важный инструмент. Они должны давать врачам возможность заглянуть «под капот» и понять, какие факторы повлияли на рекомендацию. Врачи не хотят слепо доверять «черному ящику», они хотят видеть логику, пусть и сложную. Иначе зачем вообще что-то менять?

Системы поддержки принятия клинических решений, работающие на основе XAI, могут, конечно, улучшить диагностическую точность. Но давайте будем реалистами: они не заменят врача. Они должны дополнять клиническое суждение, предоставлять дополнительную информацию, а не диктовать условия. Врачи — это не операторы ввода данных, они — специалисты, и их опыт бесценен.

А вот Digital Twins — это интересная история. Создать виртуальную копию пациента, чтобы смоделировать его реакцию на лечение? Звучит красиво, но кто будет поддерживать эту модель в актуальном состоянии? Данные устаревают быстрее, чем успеваешь их обновить. Но если подойти к этому вопросу разумно, можно получить действительно полезный инструмент для разработки персонализированных планов лечения.

Однако внедрение этих решений в существующий клинический workflow — это задача нетривиальная. Нельзя просто взять и навязать врачам новый инструмент, не посоветовавшись с ними. Необходима тщательная подготовка, обучение и, самое главное, сотрудничество между разработчиками AI и медицинскими работниками. Иначе, всё это превратится в дорогую игрушку, которая будет пылиться на полке. В конечном итоге, мы все хотим одного — чтобы пациенты получали качественную медицинскую помощь. А это требует не только передовых технологий, но и здравого смысла.

И да, не забывайте о данных. Качество данных — это фундамент любой AI-системы. Если данные плохие, то и результат будет соответствующий. А хорошие данные — это дорого и сложно. Но это уже другая история…

Предвзятость и этика: Как не навредить, внедряя AI в медицину

Исследования, щедро описывающие возможности искусственного интеллекта в медицине, неизменно упускают из виду один важный момент: всё рано или поздно превращается в технический долг. Авторы этих работ, как правило, сосредотачиваются на элегантности алгоритмов и «бесконечной масштабируемости», но умалчивают о тех подводных камнях, которые неизбежно возникают при внедрении в реальную клиническую практику. Особенно это касается проблемы предвзятости алгоритмов.

Алгоритмическая предвзятость – это не абстрактная угроза, а вполне реальный риск, который может усугубить существующее неравенство в здравоохранении. Если обучающие данные содержат систематические ошибки или отражают предвзятое отношение к определенным группам пациентов, то итоговый алгоритм будет выдавать несправедливые или неточные прогнозы. И, как показывает опыт, выявить эту предвзятость на этапе тестирования бывает крайне сложно – особенно если тесты показывают только «зелёный свет».

Но предвзятость – это лишь одна сторона медали. Этические аспекты, связанные с конфиденциальностью данных пациентов, их безопасностью и ответственностью за принимаемые решения, приобретают первостепенное значение. Нельзя забывать, что за каждым набором данных стоят реальные люди, и их право на неприкосновенность личной жизни должно быть гарантировано. Идея о том, что данные можно «анонимизировать» и использовать без ограничений, наивна и опасна.

Чтобы минимизировать риски, необходимо придерживаться строгих стандартов при подготовке и обработке данных. Внедрение общих онтологий и схем метаданных позволит улучшить качество данных и снизить вероятность возникновения систематических ошибок. Это потребует значительных усилий и ресурсов, но в конечном итоге окупится. Всё равно, как и тщательное тестирование – в идеале, тестирование должно имитировать реальные условия эксплуатации, а не просто проверять синтаксис.

Впрочем, даже самые передовые технологии не смогут решить всех проблем. Важно помнить, что искусственный интеллект – это всего лишь инструмент, и его эффективность зависит от того, кто и как его использует. Необходимо обучать медицинский персонал работе с новыми технологиями, а также формировать у них критическое мышление. Иначе, все эти «революционные» алгоритмы превратятся в дорогостоящую игрушку, которая не принесет никакой пользы.

По сути, задача состоит в том, чтобы создать устойчивую экосистему, в которой данные собираются, обрабатываются и используются ответственно и этично. Это потребует совместных усилий со стороны ученых, врачей, разработчиков и регуляторов. И да, это будет непросто. Но если мы хотим, чтобы искусственный интеллект действительно улучшил здоровье людей, нам придётся приложить немало усилий.

В конце концов, всё возвращается на круги своя. Мы изобретаем новые технологии, надеемся на лучшее, а потом сталкиваемся с теми же проблемами, что и раньше. Но, возможно, в этот раз мы сможем сделать что-то по-другому. Иначе, все эти разговоры о «революции» останутся просто словами.

Всё это напоминает старую истину. Как говорил Линус Торвальдс: «Плохой код похож на раковую опухоль: он будет расти, пока его не удалят». В контексте прецизионной медицины и внедрения ИИ, описанном в статье, мы видим ту же самую картину. Потенциал огромен, но без тщательной проработки качества данных и интеграции в клинический процесс, все эти «революционные» алгоритмы быстро превратятся в технический долг. Особенно важно помнить, что даже самая элегантная модель машинного обучения бессильна перед некачественными исходными данными – это и есть та самая «опухоль», которую нужно удалять, прежде чем надеяться на успех.

Что дальше?

Итак, мы снова говорим о чудесных перспективах искусственного интеллекта в персонализированной медицине. Как будто мы не слышали этого уже раз двадцать. Каждая "революция" неизбежно превращается в гору технического долга, и я подозреваю, что скоро кто-то назовёт эту гору "AI-driven healthcare platform" и получит инвестиции. Проблема, как всегда, не в алгоритмах, а в данных. Пока мы спорим о точности моделей, клинические базы данных продолжают страдать от хаоса и неполноты. Цифровые двойники? Звучит красиво, но кто будет поддерживать эту сложную систему, когда "простой bash-скрипт", который всё работал, сломается?

Нас ждёт неизбежное разочарование. Обещания "объяснимого AI" (XAI) кажутся особенно наивными. Объяснить, почему модель предсказала редкое заболевание, когда в данных были пропуски и ошибки – это задача для философа, а не для инженера. И, конечно, не стоит забывать об этических аспектах. Кто будет нести ответственность, когда "умная" система примет неверное решение? Я начинаю подозревать, что они просто повторяют модные слова, чтобы получить грант.

В конечном итоге, успех в этой области зависит не от гениальных алгоритмов, а от скучной, рутинной работы по очистке данных, интеграции систем и обучению врачей. А это, увы, не так гламурно, как "AI-powered healthcare revolution". И документация, как всегда, врёт.

Искусственный интеллект

4.8K постов11.4K подписчика

Правила сообщества

ВНИМАНИЕ! В сообществе запрещена публикация генеративного контента без детального описания промтов и процесса получения публикуемого результата.

Разрешено:

- Делиться вопросами, мыслями, гипотезами, юмором на эту тему.

- Делиться статьями, понятными большинству аудитории Пикабу.

- Делиться опытом создания моделей машинного обучения.

- Рассказывать, как работает та или иная фиговина в анализе данных.

- Век жить, век учиться.

Запрещено:

I) Невостребованный контент

I.1) Создавать контент, сложный для понимания. Такие посты уйдут в минуса лишь потому, что большинству неинтересно пробрасывать градиенты в каждом тензоре реккурентной сетки с AdaGrad оптимизатором.

I.2) Создавать контент на "олбанском языке" / нарочно игнорируя правила РЯ даже в шутку. Это ведет к нечитаемости контента.

I.3) Добавлять посты, которые содержат лишь генеративный контент или нейросетевой Арт без какой-то дополнительной полезной или интересной информации по теме, без промтов или описания методик создания и т.д.

II) Нетематический контент

II.1) Создавать контент, несвязанный с Data Science, математикой, программированием.

II.2) Создавать контент, входящий в противоречие существующей базе теорем математики. Например, "Земля плоская" или "Любое действительное число представимо в виде дроби двух целых".

II.3) Создавать контент, входящий в противоречие с правилами Пикабу.

III) Непотребный контент

III.1) Эротика, порнография (даже с NSFW).

III.2) Жесть.

За нарушение I - предупреждение

За нарушение II - предупреждение и перемещение поста в общую ленту

За нарушение III - бан