А что толку, исполняемые потоки, такие как логика механика и вычисления всеравно идут на процессор, то что она сделала только сделала хуже, так как поток информации который хоанится на видеокарте теперь идет чере pci на мать на проц перативу и снова возвращается на карту, да, текстуры допустим не будут затрагиваться процессором но они будут выкачиваться с оперативного диска видахи на мать и снова возвращаться на видяху, только лишний раз загрузила шину, потому то так никто из мужиков не поступает и не делал до нее.

Это просто чтобы выпендриться. Так это рамдиск.

А ещё кто-то там хотел объединённое адресное пространство на ПК - для системной и видео памяти. Но вроде этим занималось АТИ, а не нвидиа. Так это обычно делается на консолях.

Все приходит на круги своя. В Спектруме ПЗУ, видеопамять, ОЗУ, и порты ввода-вывода все были в едином адресном пространстве 64 К.

Да и не только в спектруме. Многие микрокомпьютеры так работали, так же БКшка, например.

Просто сначала возникает ситуация, когда специализированный чип работает лучше, чем ЦПУ. А потом специализированный чип получает расширенные возможности, свой собственный мини язык программирования, и сам становится ещё одним ЦПУ.

Например, вот это видели?

https://www.shadertoy.com/view/MddGzf

Это на графической карте работает. В браузере. И есть и круче.

я хз, что ты хотел показать, но в арканоид я залип, сука! а я спать собирался, между прочим.

Но только это всё же не ЦПУ. ЦПУ это центральное процессорное устройство. Графический процессор, хоть и расширил свои возможности далеко за пределы далеко за пределы графики, и обзавёлся даже несколькими "языками программирования", но всё же центральным он не является. В принципе графический ускоритель остался хорош именно в том, в чём изначально был лучше - в параллельных вычислениях, в частности для обсчёта векторов и прочей линейной алгебры.

Современный БИОС может - иногда, в зависимости от модели - может выйти в меню при отсутствии центрального процессора.

в чём изначально был лучше

Не, видеокарты изначально этим не занимались. Они пиксели рисовали, самые первые причём не использвоали аппаратное ускорения для вершин. Это уж не говоря о вещах вроде CGA/Hercules.

А ещё вспомните, что случилось с FPU. Потому что когда-то он был отдельным.

-------

Детали это всё. Детали.

Ну, выйти в БИОС не значит полноценно функционировать. Есть конечно отдельные случаи, вплоть до видеокарт которые работают напрямую с сетью. Но тем не менее, говорить что видеокарты всё же развились до отдельного, своего ЦПУ внутри другой системы считаю всё же неверным. Видеокарта не является центральным управляющим устройством, не должна им являться, а чаще всего - и не может. Иногда лишь может взять на себя некоторые, отдельные функции, да и то при помощи своих собственных сопроцессоров. Даже если там БИОС работает на самом графическом процессоре (честно, не знаю, но сомневаюсь), это ничего не меняет, VBIOSы существовали с ранних времён существования IBM PC, только вот их задачи - низкоуровневые процессы обеспечения взаимосвязи с тем самым ЦПУ.

И да, естественно я веду речь про трёхмерные ускорители, именно с момента их появления берут начало устройства, которые мы сейчас именуем видеокартами. То что существовало до этого не имеет никакого отношения ни к эволюции современных графических карт, ни к тому как графика сейчас отрисовывается вообще. Несмотря на идентичное название и идентичную роль, считаю что называть трёхмерные ускорители развитием двухмерных - не верно. Всё равно что считать светодиодные лампы развитием ламп накаливания. Это, безусловно, развитие, но в общем смысле, а не в плане того что одно "развилось" до другого.

P.S. Вообще, считаю что спор потерял смысл. Вы ради красного словца сказали что ГПУ "развились до своего собственного ЦПУ" не придав значения аббревиатуре "ЦПУ", а теперь просто защищаете это без каких-либо весомых аргументов. Меня это, честно, зацепило, потому как с ГПУ я работаю довольно плотно. Я понимаю что вы хотели сказать, это просто доебон до формулировки. И нет, это не детали, это херовая формулировка. Графический ускоритель не может выступать в роли центрального процессорного устройства.

своего ЦПУ внутри другой системы считаю всё же неверным

На мой взгляд вы слишком заостряете внимание на "центральный" и точности определения. Что я не считаю полезным.

Вы ради красного словца

Вот не надо нормальный диалог уводить в сторону наездов и подкалываний а затем спускать его в унитаз. Поковыряйте возможности современных шейдеров и CUDA фреймворков, посмотрние RWStructuredBuffer и также ссылки на шейдертой, которые я сбрасывал в другом комментарии. И подумайте так ли сильно отличие.

И ещё вот, например:

https://www.nvidia.com/en-us/geforce/forums/gaming-pcs/8/265...

Для меня ребенка это была магия, пишешь много раз poke(рандомная цифра) и что то менялось в непредсказуемом месте. Чаще всего ничего.

память - да. у портов было свое пространство. мало того, с неполной дешифрацией. вот у букашки действительно все было в одной кучке

Вы немного попутали. в процессоре Спектрума Z80 адресное пространство и порты ввода-вывода разделены. А вот в i8080 там всё в куче.

Это не тоже самое. Просто часть оперативки выделяется для видео. Это уже изолированный отдельный кусочек памяти к которому только видеоядро имеет доступ и по сути ничем не отличается от памяти распаяной на видюхе, ну кроме качественных показателей.

"через видеодрайвер"

Вот тут то и собака зарыта. UMA( https://en.wikipedia.org/wiki/Uniform_memory_access ) относится к мультипроцессорным системам, и вы её спутали c HSA (https://en.wikipedia.org/wiki/Heterogeneous_System_Architect...) , которую как раз таки пропихивает AMD, и которую называли hUMA.

Отличие в том, что со сшаренной видеопамятью, доступ в банк памяти будет осуществляется как к системной, БЕЗ бодания с видеодрайвером.

А то, что там "через драйвер", это всё хрень. Вы мне возьмите указатель на блок памяти на GPU, без маппинга в объект буфера, Map/Unmap/Lock/Unlock, тогда и поговорим.

И то же самое с встроенным видео, кстати. Обычно встроенная видеокарту блок памяти резервирует полностью и делает его недоступным для всех.

Да в начале 90-х так все играли без хардов! Каждый школьник так умел. То же уфо 1 или герои. Заканчивались с дискет и валились на них. Только что при выключении сейвы не делались. Эх, молодость. Родители ещё молодые были, бесшабашность и все впереди.

С аппаратным ускорением - не было.

Но зато до нулевых были майнфреймы, которые очень схожи с современными идеями с "облаком".

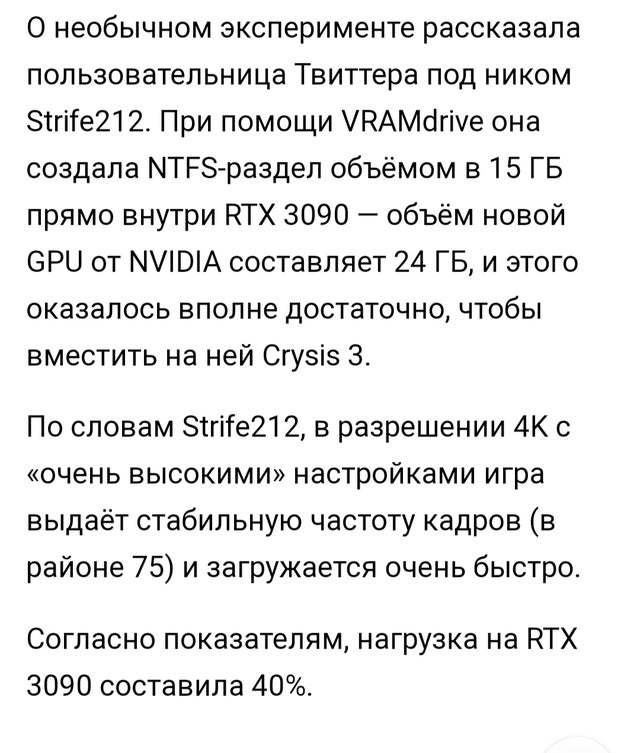

Я, например, благодаря этой новости, раскиданной по всему интернету (не только на пикабу) узнал о существовании такой железки (RTX3090).

Напрашивается вывод: а не для того ли весь этот шум-гам с VRAMdrive и "Crysis 3"?

А что ты вообще знаешь про видеокарты?

Если ты геймер и смотришь актуальное поколение, то выбор у тебя небольшой:

Amd rx 5600 и 5700, nvidia rtx 3070 3080 3090. Да 3090 не самая популярная модель ввиду ее стоимости, но проблем с известностью среди целевой аудитории у нее точно нет.

да ни хрена я о них не знаю. У меня 1050ti и спокойно "в неделю по чайной ложке" пытаюсь пройти Control, хотя бы дойти до того места где забыл когда забыл что в нее играл. Сначала начал. Я про Этернал вообще молчу. Старый я и пью . И вали оно всё во все ядра

Вот вы вообще ничего о 3090 не знаете.

30я серия видеокарт от nVidia задействует новую технологию SSD-to-VRAM, названную RTX IO, передавая напрямую в видеопамять данные минуя процессор.

При должной реализации и утилитах можно это "провернуть" с любой игрой, даже внутри сэмулированного виртуального жесткого диска внутри VRAM.

https://www.guru3d.com/news-story/nvidia-announces-rtx-iogpu...

30я серия видеокарт от nVidia задействует новую технологию SSD-to-VRAM, названную RTX IO, передавая напрямую в видеопамять данные минуя процессор.

Вы пишите о том что слегка не понимаете: чтобы это работало, необходима поддержка этого в игре.

При должной реализации и утилитах можно это "провернуть" с любой игрой, даже внутри сэмулированного виртуального жесткого диска внутри VRAM.

Пруфы можно? Потому что есть существенные сомнения, что виртуальный диск в видеопамяти реализуется корректно, а не через хак и поддержвает передачу данных через DMA.

GPU Ram Drive нужная вам прога. Выдаёт на GDDR 5X памяти показатели неплохого NVME SSD 2,2гига линейки и 80 метров рандома.

Тем не менее nVidia обещает увеличение скорости распаковки до 100 раз и уменьшение нагрузки на процессор на 40%. При чем это все будет делаться аппаратно самой видеокартой!

в приведенной выше статье уменьшение нагрузки на проц не 40 а 20%

но это маркетинг, минимум делим вдвое не 20 а 10%

Технология будет запушена в следующем году а зная что вокруг рукожопы то увеличить а не уменьшить

Ну и главное это не отменит - ЦП все равно будет сильно участвовать в процессе.

брехня, технология в винде появится через год минимум, сами майкрософт сказали. И еще не факт, что все кинутся её срузу делать, её еще и прикручивать к игре нужно будет, а не прям все игры ускорит

RTX IO станет доступна как только разработчики начнут выпускать игры с её поддержкой. Однако, предварительные версии Microsoft DirectStorage для разработчиков появятся только в следующем году, так что раньше второго квартала 2021 года ждать появления игр с RTX IO не стоит. Отметим также, что RTX IO будет работать как на новых графических процессорах Ampere, так и на предыдущих Turing. Поэтому владельцы RTX 20-й серии не останутся без внимания.

идея 10 баллов: передавать данные в видеопамять из видеопамяти для процессора минуя процессор

В смысле? Мужики никогда ничего не использует не по назначению лулзов ради? Какие мужики скучные существа.

Подозреваю, что главная проблема производительности крайзиса это частые подгрузки данных с диска, поэтому такой эффект произошел

nvme ssd типа samsung 970 evo plus будет ни разу не медленнее памяти видеокарты через pci-e, подключенной через эмулятор, лишняя нагрузка на процессор идёт при чтении/записи этих файлов.

да и поставить 32/64гб оперативки и создать рамдиск в ней будет дешевле и быстрее

могу конечно ошибаться, но у самсы скорости порядка 2-3 Гигов в секунду, скорость памяти видеокарт на пару порядков выше. [ UPD] у 3090 около 1 Тбайта в секунду. Такие пиковые цифры конечно далеко не всегда являются показателями конечной производительности, но уже дают возможность прикинуть приблизительную разницу

Память может и пропускает условный терабит в секунду, однако она не будет быстрее шины pci-e, для 3.0 предел 16гб/с, для 4.0 32гб/с.

Для сравнения память ddr4 2666мгц имеет пропускную способность ~20гб/с, а в двухканалке все 40гб/с (в 4 канальном режиме ~80гб/с), что в разы быстрее шины pci-e и самое главное имеет меньшую задержку чтения/записи по сравнению с pci-e

там не терабит указан был, а именно терабайт. А по ограничениям шины памяти, да всё верно, тут я не в ту сторону думал

Пропускная pcie 4 - 32 Гбайт в сек на 16 линий. думаю можно смело поделить на 4, получится 3х кратный прирост по сравнению с nvme

Видеопамять для своих задач даёт намного лучшие задержки, нежели оперативка и ссд. Оперативка лучше ссд раз в 5 тупо по скорости, а ссд вообще ни туда ни сюда - у него и скорости говно и задержки. Вмешательство в видеопамять имеет смысле, если эти данные нужны непосредственно для видеокарты - иначе будешь по кругу гонять данные из видеопамять процессору и обратно

ух ты, у 4х реально 1ГгБайт.

учитывая, что в DDR5 наконец есть полноценный ECC, использование видеопамяти для кеша данных уже как то не выглядит странным.

но есть нюанс, у DDR4(которая в оперативке) идеальная скорость 17Гбайт/с,, при случайном доступе уже в разы хуже.

речь про скорость, а не про пропускную способность. у памяти 3ххх карт скорость 21 гбит.

Я к тому что некорректно говорить "да не, у самсунга 2-3 гигабайта, а у нвидии аж целый терабайт"

В вычислительной технике пропускная способность — это максимальная скорость передачи данных по заданному пути.

Перекину из соседней ветки: некорректно говорить "да не, у самсунга 2-3 гигабайта, а у нвидии аж целый терабайт"

скорость памяти видеокарт на пару порядков выше. [ UPD] у 3090 около 1 Тбайта в секунду.

Лол, откуда данные про терабайт? Прекрасно знаю что это неверно но интересно стало где вы это вычитали

Но зачем? Даже 2014 ms sql, при наличии достаточного количества памяти, грузит базу в оперативку.

з.ы. от скорости мы сами охуели, думали день минимум уйдёт

Это не совсем верно: да, данные будут кэшироваться в оперативке, но все транзакции обязаны сохраняться на диск (ACID - Durable), поэтому обращения к диску будут. Более того, если идёт работа с tempdb то её данные всегда будут писаться на диск, по тем же самым причинам.

Ну tempdb то давно уже в рам диске лежит, а по поводу сохранения транзакций - да, но опять же зависит от характера запроса.

ага. только в обычном варианте сначала данные затянуть с диска в память. и это в лучшем случае sata express на pci, в худшем - просто sata.

Эм. Почитайте на досуге, зачем нужна оперативная память. Прежде чем рассказывать о затягивании с диска в память в процессе игры.

А может Вы мне расскажете? может в Вашей вселенной цп напрямую с диска большие массивы молотит

Думаю современные технологии позволят рам-диск создать, например, на телевизоре, к которому подключен комп. И можно будет заявить о том, какой я крутой перец! Но какого либо смысла в этом нет.

p/s/ Вот был у меня когда то старый сканер. Сказёвый, и не было к нему адаптера, но надо было как то подключить. Сказёвый разъём был у меня на старом и ненужном магнитооптическом накопителе. Он, в свою очередь, подключался через какой то конвертер из скази в лпт. Причём сканер через этот конвертер не подключался. В итоге этот франкенштейн подключался последовательно. И определялся системой тоже интересно. Сначала находился лпт конвертер. Потом, опа! да у вас тут магнитооптика! Потом, опа! да у вас тут сканер ещё! Всё работало, но особого смысла, конечно, не имело.

Абсолютно не согласен.

Она разместила файлы на жестком диске. Ты думаешь процессор напрямую с жесткого диска читает, и сразу пишет обратно? Конечно же все сначала в оперативку идет при загрузке, подгружаться будут только новые локации и все такое. Опять же, они будут с жесткого диска (который тут видюха) грузиться в оперативку. Это в итоге никак не скажется на работе процессора. Конечно, было бы гораздо лучше сделать жесткий диск в оперативке и хранить игру там. В любом случае это почти не даст прироста производительности по сравнению с хорошим SSD, разве что чуть-чуть будут загрузки уровней быстрее (если оно в игре есть).

текстуры допустим не будут затрагиваться процессором

По моему опыту gramdisk нормально так нагрузку дает на процессор. i7-2***m где-то на 40-50% загружался.