Новостной дуйджест. Часть вторая. Величавая

Продолжаем рубрику технических новостей прошедшей (и не только) недели. Ну ничего с этим не поделать, опять этот ваш ИИ. Часть первая для ознакомления.

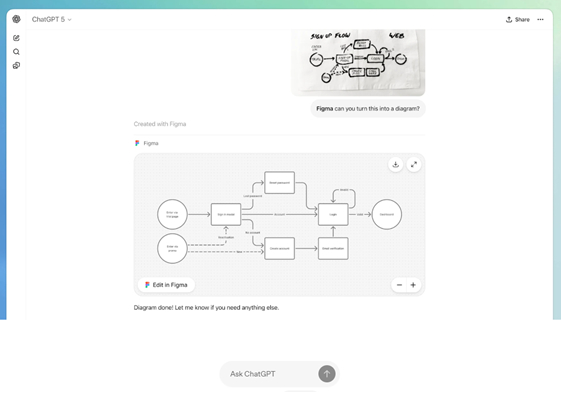

От Figma до Spotify: в ChatGPT появились сторонние приложения.

Ссылка. OpenAI представила Apps SDK для ChatGPT — инструментарий, который позволит сторонним разработчикам добавлять свои приложения. Пользователи получат доступ к сервисам, которым уже привыкли пользоваться — достаточно использовать свой логин и пароль прямо в чате. Среди приложений, которые были показаны в демонстрации: Coursera, Spotify, Figma, Canva, Zillow. Доступ пользователей к приложениям начнут открывать с сегодняшнего дня (раскатка может занять определенное время), а разработчики начнут получать доступ к SDK и опциям монетизации.

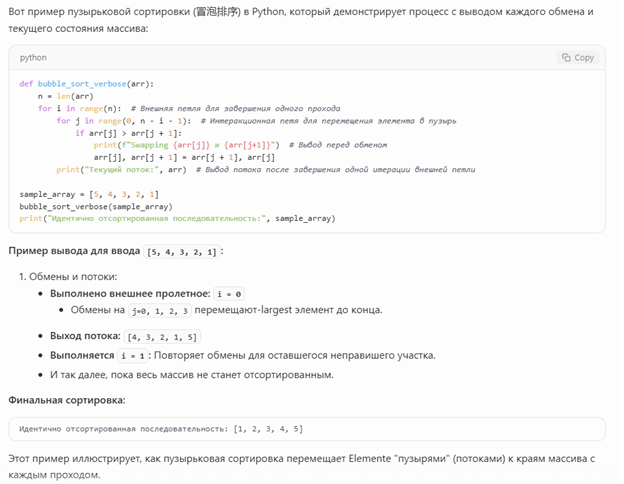

Мюсли. А вот это интересное и, с моей точки зрения, абсолютно правильное направление развития для компании OpenAI. Вау эффект уже давно прошел, пятая версия языковой модели GPT-5 не произвела такого впечатления, как это было с предыдущими версиями. Обычного генератора текста, даже достаточно «умного», уже недостаточно. Именно поэтому создаются новые продукты, где языковая модель выступает в роли промежуточного, но «умного» звена/посредника, что должно привести к более понятному, быстрому и удобному взаимодействию с такими продуктами. Ниже пример с Figma.

AgentKit: единая среда от OpenAI для создания и тестирования собственных агентов.

Ссылка. До сегодняшнего дня сборка и запуск AI-агентов напоминала джунгли. Разработчики метались между десятками несовместимых SDK, кастомных пайплайнов и ручных интеграций. Построить надёжного агента значило неделями клеить код, чинить баги в оркестрации и постоянно балансировать между скоростью и качеством. Теперь OpenAI предлагает другой путь — AgentKit, набор инструментов, который объединяет в себе всё, что раньше требовало десятков фреймворков и недель настройки.

Мюсли. Как и с любой другой областью, которая относительно недавно появилась, до языковых моделей дошли стандарты. В общем и целом, это безусловно win, так как значительно упрощает процесс разработки (все стандартизировано же) и добавляет большое количество документации и, в будущем, гуидов (обожаю гуиды на ютубе, особенно от индусов).

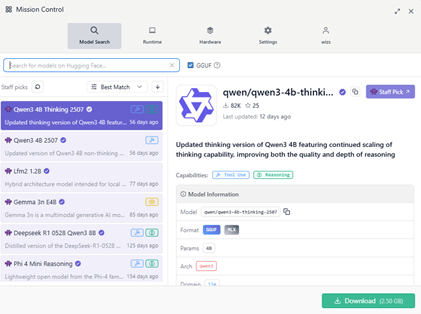

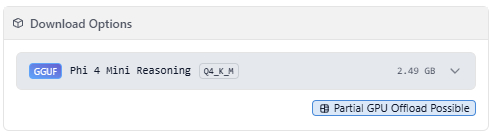

GPT-OSS теперь можно запустить на топовых Android-смартфонах.

Ссылка. Команда Nexa AI добавила в свое приложение Nexa Studio версию GPT-OSS, оптимизированную для запуска на топовых Android-смартфонах. Модель уже доступна в приложении, весит 10 ГБ, а для запуска требуется смартфон с 16 ГБ памяти и передовой процессор. В Nexa AI протестировали GPT-OSS на смартфоне ASUS ROG 9 с процессором Snapdragon Elite Gen 5, получив следующие характеристики: время до получения первого токена — 3 секунды, скорость генерации — 17 токенов в секунду.

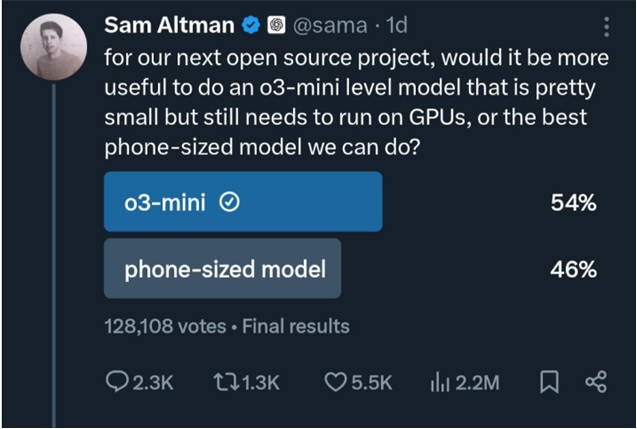

Мюсли. На хабре пишут, что языковая модель GPT-OSS-20b как раз и затачивалась под возможность запуска на смартфонах. Наш дорогой Сэм мать его Альтман для этого опрос проводил в этих ваших интернетах.

Так что новость является закономерным развитием жизненного цикла языковой модели и это, определенно, круто. Правда не представляю, какое время жизни телефона будет и его нагрев, жесть жеж наверное.

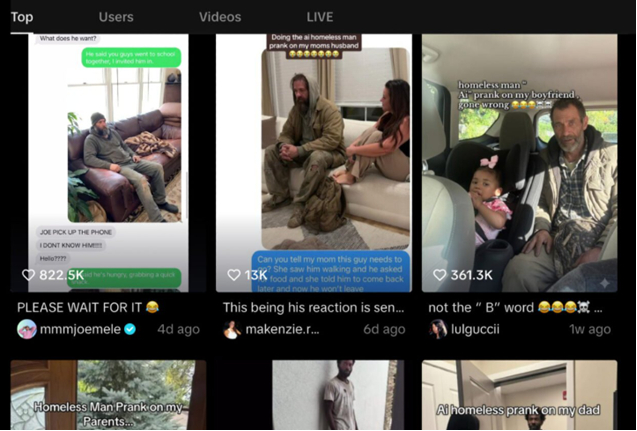

Из веселого. Или не очень. Полиция США попросила подростков прекратить розыгрыши с участием дипфейка бездомного.

Ссылка. В TikTok завирусился новый тренд: подростки используют технологии искусственного интеллекта, чтобы создавать дипфейки бездомного человека в своих домах, а затем показывают эти изображения родителям. Несколько таких розыгрышей закончились приездом полиции. Теперь правоохранители просят подростков воздержаться от подобного поведения.

Мюсли. Не такого применения ИИ я ожидал, определенно. А хотя, это как с любой технологией, можно использовать для создания чего-либо «хорошего», а можно в противоположность ему. Стоит хотя бы на Sora 2 посмотреть, где генерируют видео с умершими людьми (часто знаменитостями) и отправляют родственникам.

Ну а так вроде все пацаны и пацанята, пацантре и пацанини. Ну и не забываем, я разработал чат-рулетку в виде мини-приложение в telegram, как говорится welcome t.me/Twittly_bot/twittly. Затестите, вам не сложно, мне приятно!!!))).

Ссылка на мой telegram канал t.me/socionyxchannel, you are welcome too, где я пишу про будни разработчика.