Все хотят модный ИИ. Но почти никто не понимает, куда его воткнуть на производстве

Последние пару лет ИИ на производстве стал чем‑то вроде обязательного пункта повестки. Про него говорят собственники, его ждут от команд, его упоминают в стратегиях «на будущее». Часто – с молчаливым ожиданием, что ИИ сам по себе наведет порядок: ускорит процессы, сократит ручной труд, сделает бизнес более управляемым.

На практике этого почти никогда не происходит. ИИ не является универсальным решением и уж точно не становится точкой входа в изменения. Более того, если внедрять его без понимания, какие именно проблемы он должен решать, он лишь добавляет новый слой сложности.

Эта статья – о том, как на самом деле выглядит работа с ИИ на производстве. Не как модный эксперимент, а как управленческий подход. Мы разберем один реальный производственный кейс и покажем, почему ИИ начинает работать только тогда, когда перестает быть самоцелью.

Как выглядел запрос клиента

Ко мне в телеграм-канал пришел собственник крупного мебельного производства. Бизнес уже зрелый: серийный выпуск, несколько цехов, собственное конструкторское бюро, финансовый и коммерческий блоки, активные продажи через разные каналы. Производство загружено, заказов хватает, компания продолжает расти.

Разговор начался с осторожным интересом и сомнением:

«Давайте подумаем, где мы можем внедрить ИИ, чтобы он дал результат».

За этой формулировкой стояло вполне понятное состояние. С одной стороны – ощущение, что бизнес упирается в потолок эффективности. С другой – непонимание, за что именно хвататься.

На старте ни собственник, ни команда не могли четко сформулировать:

– какие конкретные проблемы должен решить ИИ;

– где компания реально теряет деньги или время;

– какие решения сейчас принимаются скорее «по опыту», чем на основе системы.

При этом внутреннее напряжение уже накапливалось. Много ручных операций. Сильная зависимость от отдельных людей и их экспертизы. Разные подразделения опираются на разные цифры. Эффект от изменений часто становится понятен слишком поздно – когда что-то исправлять уже дорого или сложно.

В такой точке ИИ выглядит почти спасением. «Он же должен уметь считать, подсказывать, автоматизировать». Именно с этим ощущением клиент и пришел.

Тогда мы предложили начать не с поиска ИИ‑инструментов, а с более приземленного вопроса: какая цифровая стратегия вообще имеет смысл для этого бизнеса, исходя из его реальных процессов и целей.

Почему нельзя начинать с ИИ

На старте кажется, что все и так понятно: где‑то много ручного труда, где‑то не хватает прозрачности, где‑то люди перегружены. Хочется сразу идти в решения.

Но в реальности у каждого блока своя картина происходящего. Производство видит одни узкие места. Финансы – другие. Коммерция – третьи. Если в этот момент начинать внедрять ИИ точечно, под запрос одного отдела, результат почти всегда получается локальным и плохо масштабируемым.

Поэтому в этом проекте мы принципиально не начинали с технологий.

Что мы сделали вместо этого

По сути, именно на этом этапе и начинает складываться цифровая стратегия – не как документ и не как план внедрения технологий, а как общее понимание того, какие изменения действительно нужны бизнесу и в каком порядке.

Первым шагом стали разговоры с руководителями всех ключевых блоков: производства, финансов, КБ, коммерции, логистики. Не презентации и не сбор идей «что можно автоматизировать», а подробный разбор реальной управленческой рутины.

Мы спрашивали:

– какие решения вы принимаете регулярно;

– где уходит больше всего ручного времени;

– в каких местах вы понимаете результат слишком поздно;

– где бизнес держится не на системе, а на конкретных людях.

Эти разговоры быстро показали: запрос на ИИ – это следствие, а не причина. Основные проблемы лежат в несогласованных данных, ручных пересчетах, разрывах между подразделениями.

После интервью мы поехали на производство. Это был важный этап: часть проблем, которые в разговорах звучали абстрактно, в цехах и на складе оказывались вполне осязаемыми узкими местами.

Дальше мы собрали собственника и всю управленческую команду на стратегическую сессию. Цель была не в том, чтобы придумать решения, а в том, чтобы впервые посмотреть на проблемное поле целиком – одной командой. Проговорить, подтвердить, приоритизировать и соотнести с тем, каким бизнес должен стать через несколько лет.

Именно здесь обычно и становится понятно, зачем вообще нужны такие сессии, если «и так все ясно». Пока проблемы не названы и не согласованы вместе, любые технологии лечат симптомы, а не причины.

По итогам сессии команда неожиданно поймала себя на странном ощущении. Они шли на встречу с ожиданием, что два часа будут говорить про ИИ – возможности, инструменты, «фокусы». А вместо этого почти все время ушло на спокойный и местами даже нудный разбор узких мест компании: где решения принимаются вручную, где данные не сходятся, где бизнес держится на людях, а не на системе. В этот момент стало особенно ясно, что проблема была не в отсутствии ИИ, а в отсутствии общей картины.

Где ИИ действительно дал эффект (а где – нет)

Когда проблемное поле было согласовано, а приоритеты расставлены, разговор про ИИ резко изменился. Он перестал быть абстрактным и стал прикладным.

Выяснилось, что значительная часть проблем вообще не требует ИИ. Где-то достаточно упростить процесс. Где-то – договориться о единых правилах расчета. Где-то – убрать ручные исключения.

ИИ появился только в тех точках, где:

– есть повторяющаяся операция;

– задействовано несколько человек;

– цена ошибки ощутима;

– автоматизация дает понятный экономический эффект.

Один из таких примеров – склад.

На складе несколько сотрудников занимались исключительно ручной проверкой отгрузок. Погрузчик подъезжает, человек сканирует каждую упаковку, сверяет позиции с отгрузочным заданием и только после этого дает разрешение на загрузку. Процесс рабочий, но полностью завязанный на внимательность людей и плохо масштабируемый.

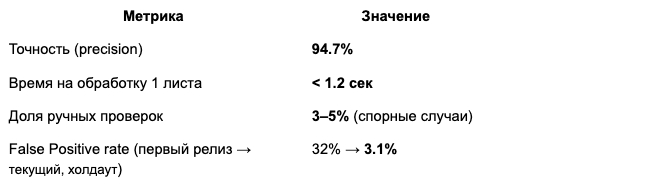

В этом месте мы предложили использование компьютерного зрения: камера фиксирует зону отгрузки, система автоматически считывает штрихкоды с упаковок, сопоставляет их с заданием в учетной системе и дает сигнал – можно грузить или нет. Человеку не нужно ходить и проверять каждую позицию вручную.

Эффект здесь легко считается: меньше ручного труда, меньше ошибок, высвобождение людей под другие задачи. Именно в таких местах ИИ начинает работать как инструмент эффективности, а не как модная надстройка.

Важно, что в других блоках ИИ сознательно не внедряли. Потому что сначала нужно было привести в порядок данные, логику расчетов и саму управленческую модель. Без этого любые «умные» инструменты не дали бы устойчивого результата.

Почему так сработает не у всех

После подобных историй часто возникает желание повторить: «значит, нам тоже нужен ИИ».

Но здесь важно быть честными. ИИ не станет волшебной палочкой, если:

– процессы нестабильны;

– данные противоречат друг другу;

– решения все равно принимаются по ощущениям;

– бизнес не понимает, какие проблемы для него критичны.

В такой ситуации ИИ либо не даст эффекта, либо создаст новые точки сложности.

Как работать с ИИ, чтобы он действительно давал эффект

Рабочий подход почти всегда начинается не с технологий, а с управления:

Понять, какие решения в бизнесе реально влияют на деньги.

Разобраться, где эти решения принимаются вслепую или с запозданием.

Навести порядок в процессах и данных.

И только потом использовать ИИ – там, где он дает измеримый результат.

Именно такой подход мы и называем цифровой стратегией.

ИИ не делает бизнес управляемым сам по себе. Он лишь усиливает то, что в компании уже есть – процессы, данные, логику принятия решений.

Поэтому цифровая стратегия – это не просто выбор технологий. Это честный разговор о том, как компания принимает решения и где она теряет эффективность. Иногда в этом разговоре ИИ оказывается полезным инструментом. Иногда – нет. И это нормально.

Мы регулярно видим, что самый большой эффект дает не сам ИИ, а работа, которая ему предшествует: разбор управленческих узких мест, согласование приоритетов, наведение порядка в данных и процессах.

Если вам сейчас тоже кажется, что «ИИ вроде бы нужен, но непонятно зачем и куда», возможно, стоит начать не с технологий, а с этого разговора.