Исследователи представили новый способ двигать изображения

Как они сообщили, они вдохновились первой реализацией DragGAN о которой писал ранее. В новой реализации в комплекте идет инструмент который обучается на изображении пользователя создавая минимодель. После чего ее можно подключить и изменять части изображения по своему желанию.

Нельзя сказать что это уже полностью рабочий продукт. Так как пайплайн пока не особо удобный. Но технология очень привлекательная и интересная поэтому я за ней слежу.

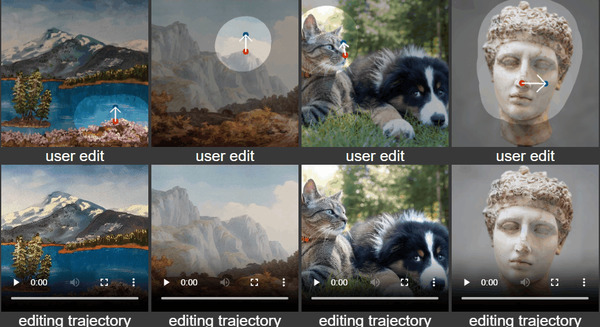

Точная и управляемая редакция изображений является сложной задачей, которая привлекает значительное внимание. Недавно была разработана система DragGAN, позволяющая интерактивную редакцию изображений на основе точек и достигающая впечатляющих результатов с пиксельной точностью. Однако, поскольку этот метод основан на генеративных антагонистических сетях (GAN), его общность ограничена емкостью заранее обученных моделей GAN. В данной работе мы расширяем такую систему редактирования до диффузионных моделей и предлагаем DragDiffusion. Используя заранее обученные диффузионные модели большого масштаба, мы значительно улучшаем применимость интерактивной редакции изображений на основе точек в реальных сценариях. В то время как большинство существующих методов редактирования изображений на основе диффузии работают с текстовыми вложениями, DragDiffusion оптимизирует диффузионный латент для достижения точного пространственного контроля. Хотя диффузионные модели генерируют изображения итеративным способом, мы эмпирически показываем, что оптимизация диффузионного латента на одном этапе достаточна для генерации согласованных результатов, что позволяет DragDiffusion эффективно завершать работу по высококачественной редакции. Обширные эксперименты в широком диапазоне сложных случаев (например, множественные объекты, различные категории объектов, различные стили и т. д.) демонстрируют универсальность и общность DragDiffusion.

Как видим из этого описания это уже ближе к тому с чем многие уже привыкли работать. А именно дифузионные модели. Например Stable Diffusion.

Проект доступен на гитхаб. Для запуска рекомендуется видеокарта от NVIDIA. А так же разработчики тестировали код только на linux.

__

Наш чат где генерируем и обсуждаем новости и помогаем друг другу с решением технических проблем

Мой канал с гайдами по Stable Diffusion. Где бесплатно обучаю с нуля и до самостоятельного обучения моделей.

Stable Diffusion

2.6K поста2K подписчиков

Правила сообщества

Придерживайтесь стандартных правил Пикабу.