Разрабатываю игру при помощи ИИ

1 пост

Второй год подряд делаю новогодний квест для детей исключительно при помощи нейросетей. В прошлом году AI были не такими крутыми, но и тогда получилось неплохо. В этот раз — на порядок лучше.

Детям (7 и 9 лет) зашло. Прошли за полтора часа, использовали подсказки всего пару раз. В статье расскажу весь процесс пошагово, чтобы любой родитель мог повторить на день рождения или другой праздник.

Сразу запустил процесс в трёх AI:

Claude (Anthropic)

ChatGPT

Gemini (Google)

Почему три? Хочу посмотреть, кто справится лучше. У каждой свои сильные стороны.

Промпт был максимально простой, без промпт-инжиниринга:

"Хочу сделать квест для детей 9 и 7 лет новогодний со всякими интересными загадками на подумать, с сюжетом может немного детективным увлекательным. Локация загородный дом, несколько этажей улица бассейн. Задачи на логику, может где то на математику главное чтобы что то интересное было, можно сделать поиск подсказок по дому. Главное чтобы был увлекательный общий сюжет всего квеста. Задай мне дополнительные вопросы и предложи варианты такого квеста.."

Сразу попросил: задавайте вопросы и предлагайте варианты.

Переписка с Claude, где он задаёт вопросы: "Мальчики, девочки, вместе? Реквизит? Локации? Что в финале?

Claude: Предложил вариант А (классический поиск сокровищ) и вариант Б (секретная миссия "Спасти Новый год"). Выбрал Б. Расписал весь квест с локациями и заданиями.

ChatGPT: "Операция Снежная печать". Сразу огромный квест со всеми заданиями, конвертами, уликами. Качественно и подробно.

Gemini: Вот тут интересно. Единственный, кто спросил про интересы детей: "Что им нравится? Minecraft, Гарри Поттер, динозавры, космос, Roblox?"

Сделал квест на основе мультивселенной, чтобы все интересы запихнуть. Сюжет получился самый интересный, задания тоже крутые.

Единственный минус Gemini — почему-то сделал всё в стиле киберпанка (видимо, я до этого много генерил таких картинок). Детям не очень подошло бы.

Основу сюжета от Claude

Несколько заданий от Gemini (с яйцами, водная планета, лестница с книгой Гарри Поттера)

Хотел сделать не просто бумажки, а полноценный интерактив:

Видеообращение от главного героя

Ввод секретных кодов

Система подсказок

Финальное поздравление

Каждая нейросеть сгенерила свой вариант сайта. В Gemini получился в стиле киберпанка, в Claude — более классический.

Больше всего итераций было с Claude. Много правок, доработок. Но это нормально — с первого раза идеального результата не будет.

Сайт сделан под мобильную версию (ссылка можете открыть и посмотреть).

Мог бы сделать просто: нашёл предмет → нажал "Готово". Но это скучно.

Вместо этого: нашёл предмет → прочитал код на записке → ввёл на сайте.

Если ошибся — получаешь подсказку. Вторая подсказка уже прямо говорит ответ.

Главный герой — эльф Бубенчик. Он даёт задание в начале и поздравляет в конце.

Проблема: Sora каждый раз генерила разных эльфов. Начальный и финальный не совпадали.

Решение:

Сгенерил картинку эльфа в Gemini (Нана банана 2)

Прикрепил её к Sora 2

Только так получилось сделать одинакового персонажа

Вот как выглядел финальный квест:

Загадка про огонь → идут к камину → находят записку с кодом 147.

Загадка про ёлку → ищут под ёлками во дворе → находят "гнездо" (корзинку) с Киндер-сюрпризами.

В каждом яйце — цифра и пример. Нужно найти три яйца, где сумма равна 10 (7+3, 5+5, 8+2). Цифры в них — код 258.

Загадка про лестницу → находят 9-ю ступеньку → там записка: "Ищи в комнате старшего по возрасту книгу Гарри Поттер, код на странице 100".

Косяк: В задании написано загадка про лестницу (надо отгадать, что это лестница), а потом "ищи записку под 9 ступенью" — слишком сильный спойлер. Заметил только после.

Находят книгу → страница 100 → код 369.

Загадка про бассейн → ныряют → на дне раскиданы ракушки → в одной запечатанная записка с кодом.

Записку обклеил скотчем, чтобы не размокла.

В комнате младшего героя лежит УФ-фонарик. Раскиданы бумажки с буквами.

Подсвечиваешь УФ-фонариком → видишь буквы (невидимая ручка) → складываешь слово "ЗВЕЗДА" → ищешь звезду.

Звезда под ёлкой (логично для Нового года) → там записка с кодом 592.

Тут дети впервые воспользовались подсказками.

Загадки про предметы из повседневной жизни. Первые буквы ответов складываются в слово "ТЕЛЕВИЗОР".

Идут к телевизору → находят кристалл и записку с кодом 637.

Даётся алфавит с номерами букв. Нужно расшифровать числа: получается слово "ПОДВАЛ".

Идут в подвал → находят сундук → он заблокирован.

Последняя задача: посчитать героев квеста + этажи в доме + лапы всех животных = 18.

Код 18 → открывается сундук → внутри сладости и подарки.

Все записки генерил в Gemini — он лучше всех работает с русским текстом. ChatGPT до сих пор иногда криво пишет буквы.

Формат: А6 (маленькие), чтобы проще прятать.

Стартовое письмо — А4.

Печатал в типографии.

Хотел сделать, чтобы дети были на фото с Дедом Морозом/Санта-Клаусом.

Gemini умеет подставлять любую фотографию на любой фон. Просто пишешь: "Вот эта девочка находится в такой-то локации" — и он делает.

Получилось не с первого раза. Генераций с 15-ю. Один ребёнок получился с Дедом Морозом, второй — с Санта-Клаусом (не знаю, почему так). Но детям понравилось.

Фотографии положил в финальный подарок — на память.

Сгенеренные фото детей с Дедом Морозом

Claude (Anthropic) — основа сюжета, создание сайта, много итераций

ChatGPT — альтернативный сюжет (не использовал)

Gemini — лучшие задания, генерация всех картинок и записок, работа с фото

Sora 2 — видео с главным героем (нужен американский IP)

Если не хотите покупать подписки на всё сразу — можно взять Perplexity. Там одна подписка, но можно выбирать разные модели.

Несколько вечеров. С первого раза идеального результата не будет — это нормально. Зная, что и как делать, можно сделать за вечер.

Что-то не понравится по сюжету, где-то AI ошибётся, что-то захочется переделать.

Но: это можно сделать самостоятельно. Без программиста. Без сценариста. Без дизайнера.

Используйте несколько AI — у каждой свои сильные стороны

Gemini лучше всех работает с русским текстом в картинках

Claude хорош для сюжета и долгих итераций

Коды лучше галочек — проверяют, что реально нашли

Подсказки обязательны — дети застревают

Не ждите идеала с первого раза — нужны правки

Детям зашло. Проходили полтора часа, использовали подсказки 1 раз.

Видео, в котором рассказано тоже самое, но есть видео, где рассказываю тоже самое со вставками детей проходящих квест(сюда видосы залить не смог из-за веча)

Если будете делать свой квест — пишите, как получилось. Интересно посмотреть на ваши вариации.

Каждый Новый год в интернете всплывает история о том, что Деда Мороза якобы придумал Ленин или большевики. Давайте проведем факт-чекинг и разберемся, что тут правда, а что — советская пропаганда, которую мы приняли за чистую монету.

Ленин не придумывал Деда Мороза. Более того, современный образ новогоднего волшебника был официально возвращен в СССР через 13 лет после смерти Ленина — в 1937 году. А сам персонаж существовал в России задолго до революции.

Начнем с того, что сам Новый год в привычные нам даты появился в России только при Петре I. До этого новолетие праздновали 1 сентября. Петр в 1699 году издал указ праздновать Новый год 1 января по европейскому образцу. Тогда же появилась традиция украшать дома хвойными ветками.

Традиция рождественской елки пришла в Россию из Германии в XIX веке вместе с немецкими переселенцами. Первоначально это воспринималось как иноземное новшество, даже как что-то немного чужеродное. Когда началась Первая мировая война с Германией, в некоторых городах елку даже запрещали как "вражескую традицию". Но к началу XX века обычай прочно прижился в городской среде, особенно в дворянских и буржуазных семьях.

В 1840 году князь Владимир Одоевский опубликовал сказку "Мороз Иванович" — это первое литературное воплощение персонажа в привычном нам виде. Седой старик, живущий в ледяной избушке на дне колодца, награждающий добрых девочек и наказывающий ленивых. В конце XIX — начале XX века Дед Мороз уже массово тиражируется на рождественских открытках. Под елку ставили фигурки Мороза Ивановича. Это была типичная городская буржуазная традиция.

Для крестьян же новогодняя елка оставалась "барской забавой". Простой народ праздновал Рождество и Святки по своим обычаям, без наряженных деревьев и Деда Мороза. Именно эту деталь потом использовали большевики в своей пропаганде — мол, раньше елки были только у богатых, а детишки рабочих с завистью смотрели в окна.

После революции 1917 года елку не запретили сразу. Более того, в первые годы советской власти рождественские праздники продолжались. В 1919 году Ленин действительно присутствовал на детской елке в Сокольниках, но это была еще рождественская елка, не новогодняя. К этому эпизоду мы еще вернемся.

Настоящий запрет начался в 1927-1928 годах, когда Сталин развернул жесткую антирелигиозную кампанию. Елку объявили "поповским праздником" и "буржуазным предрассудком". Появились агитационные лозунги вроде "Только тот, кто друг попов, елку праздновать готов!" или "Не губите елки — не празднуйте рождества!". Автором первого лозунга, кстати, был поэт-обериут Александр Введенский. Дед Мороз попал под раздачу вместе с елкой.

Почему же елку вдруг вернули? 28 декабря 1935 года в газете "Правда" вышла статья второго секретаря ЦК компартии Украины Павла Постышева под названием "Давайте организуем к Новому году детям хорошую елку". В ней Постышев писал: "В дореволюционное время буржуазия и чиновники буржуазии всегда устраивали на Новый год своим детям ёлку... Почему у нас школы, детские дома, ясли, детские клубы, дворцы пионеров лишают этого прекрасного удовольствия ребятишек трудящихся Советской страны?"

Любая строчка в "Правде" была руководством к действию. Буквально через два дня, 30 декабря 1935 года, в Харькове состоялась первая после запрета большая елка для 1200 школьников. А в январе 1937 года в московском Доме Союзов прошла первая официальная всесоюзная новогодняя елка. Именно здесь впервые публично появились Дед Мороз и Снегурочка в их новом, советском воплощении.

Павел Постышев — вот настоящий "крестный отец" советского Деда Мороза. Правда, его биография — это отдельный детектив. Постышев был одним из главных проводников сталинских репрессий. За свою "непомерную жестокость" в феврале 1938 года его исключили из партии, а 26 февраля 1939 года расстреляли в Бутырской тюрьме. Через 17 лет, в 1956 году, его реабилитировали при Хрущеве.

Ирония истории: человек, вернувший детям Деда Мороза, сам был репрессирован через год после своего "новогоднего триумфа". Конечно, без одобрения Сталина такая инициатива не прошла бы. Лозунг "Жить стало лучше, жить стало веселей" требовал подтверждения. Народу нужен был праздник. Но обязательно без религиозной составляющей.

Советский Дед Мороз серьезно отличался от дореволюционного. Из рождественского он стал новогодним — праздник полностью отвязали от религии. Персонаж получил уникальную спутницу — Снегурочку, аналогов которой нет в других культурах. Изначально Дед Мороз ходил в синей или фиолетовой шубе, красная стала доминировать позже. Ездил он на русской тройке лошадей, а не на оленях, как западный Санта. Внешне это был богатырь-воевода, могучий старик, а не толстячок.

Вифлеемскую восьмиконечную звезду на елке заменили красной пятиконечной — такой же, как на кремлевских башнях (их, кстати, тоже заменили на красные рубиновые именно в 1935-1937 годах). Елочные игрушки теперь изображали не ангелов, а красноармейцев, шахтеров, летчиков, парашютистов, дирижабли. Идеология проникала буквально везде.

Здесь интересная история. После возвращения елки в 1935-1937 годах советская пропаганда создала две канонические легенды, которые должны были показать преемственность и легитимность новой традиции.

Елка в Сокольниках (1919 год) — это реальное событие, которое позже обросло пропагандистскими наслоениями. 6 января 1919 года, на старое Рождество, в Лесной школе в Сокольниках устроили елку для детей. Там отдыхала жена Ленина Надежда Крупская, лечившаяся от базедовой болезни. Ленин действительно приехал на праздник. По дороге на него напали бандиты из шайки известного московского уголовника Якова Кошелькова — отобрали револьвер и угнали машину. Ленин все равно добрался до школы и повеселился с детьми. На празднике выступали знаменитые певицы Валерия Барсова и Фанни Вахман, играл пианист Самуил Фейнберг. Это был скорее концерт с угощением, чем детский утренник.

А потом началась мифологизация. В 1933 году Владимир Бонч-Бруевич описал это событие в приторно-слащавых тонах. В 1939 году писатель Александр Кононов написал рассказ "Елка в Сокольниках", убрав упоминание о бандитах (заменив инцидент на метель) и добавив игру в жмурки с детьми. Этот рассказ стал хрестоматийным — его изучали все советские школьники. Создали десятки картин, диафильмов, почтовых марок с изображением Ленина на елке. К 1960-м годам образ Ленина, водящего хоровод вокруг елки, был так же канонизирован, как любая другая революционная легенда.

Елка в Горках (1924 год) — вторая каноническая история. 7 января 1924 года в Горках для детей из соседних деревень устроили праздник с пятиметровой елкой. Ленин присутствовал, но был уже тяжело болен — его вывезли на коляске. Это была скромная елка для детей персонала и близких родственников, не массовое мероприятие. Через две недели, 21 января, Ленин умер. Журналист Михаил Кольцов, побывавший в доме сразу после его смерти, писал: "Стоит неубранная ёлка, в бусах, свечечках и ватном инее — последняя забава маленьких друзей...".

Простая идеологическая схема работала в несколько этапов. Сначала, в период запрета елок с 1927 по 1935 год, в пропаганде активно продвигался образ "самого человечного человека Дедушки Ленина", который как бы замещал детям Деда Мороза. Детей учили, что настоящий волшебник — это не какой-то там буржуазный старик, а товарищ Ленин.

Когда в 1935-1937 годах елку вернули, нужно было объяснить идеологический кульбит: почему раньше запрещали, а теперь разрешают? Легенды о ленинских елках показывали: "сам Ленин любил елки, значит, это правильно!" Советская власть могла говорить, что они не возвращаются к буржуазному прошлому, а продолжают ленинскую традицию. Хотя на самом деле просто скопировали то, что было до революции, только убрали религиозный контекст.

Миф первый: Деда Мороза придумали большевики или Ленин.

Реальность: Дед Мороз существовал в России с XIX века, задолго до революции. Первое литературное описание в 1840 году, массовое распространение в конце XIX — начале XX века.

Миф второй: Советская власть сразу вернула елку и Деда Мороза.

Реальность: С 1927 по 1935 год елка и Дед Мороз были под строжайшим запретом как "буржуазный предрассудок" и "поповский праздник".

Миф третий: Ленин вернул Деда Мороза.

Реальность: Деда Мороза официально вернул Постышев при одобрении Сталина в 1937 году, через 13 лет после смерти Ленина.

Миф четвертый: Ленин активно праздновал Новый год с детьми.

Реальность: Ленин действительно посещал детские елки, но это были рождественские, а не новогодние праздники. События сильно приукрашены пропагандой — в реальности не было никаких хороводов и жмурок.

Частичная правда: Советская власть действительно трансформировала образ Деда Мороза, сделав его новогодним, а не рождественским персонажем. Это советское изобретение прижилось и дожило до наших дней.

Советская пропаганда работала качественно и методично. Легенды о ленинских елках вбивались в головы через школьные учебники, картины, марки, диафильмы, детские книжки. Несколько поколений выросли на этих историях, воспринимая их как абсолютную правду.

Происходит подмена понятий. Люди путают реальный факт "Ленин был на елке в 1919 году" с ложным утверждением "Ленин придумал советского Деда Мороза". Одно плавно перетекает в другое, и получается логическая ошибка.

Историческая безграмотность тоже играет свою роль. Многие просто не знают, что между смертью Ленина в 1924 году и возвращением Деда Мороза в 1937 году прошло целых 13 лет. Эта деталь ломает всю стройную легенду, но о ней мало кто задумывается.

Ну и наконец, это просто удобная легенда. Проще сказать "Ленин придумал", чем объяснять сложную историю запретов, реабилитаций, идеологических кульбитов, Постышева, расстрелов и всего этого абсурда.

Нет, Дед Мороз — это не ленинское изобретение и не советский проект с нуля. Это традиционный персонаж русской культуры XIX века, который существовал в дореволюционной России, был запрещен большевиками в 1927-1935 годах как "буржуазный предрассудок", затем был возвращен Постышевым при одобрении Сталина в 1937 году и идеологически переработан из рождественского в новогоднего персонажа.

Ленин тут вообще ни при чем. Он умер за 13 лет до официального возвращения Деда Мороза. Да, он посещал детские елки. Да, эти события использовали для пропаганды. Но придумать персонажа, который уже существовал 100 лет до него, Ленин физически не мог.

Настоящий "отец" советского Деда Мороза — Павел Постышев, один из главных проводников сталинских репрессий, которого расстреляли через год после его новогоднего триумфа. Вот такая вот не очень праздничная история у нашего любимого новогоднего волшебника.

Интересный факт на закуску: советские елочные игрушки 1930-х годов изображали Ленина и Сталина. Представьте — на елке висят шары с портретами вождей рядом с парашютистами и дирижаблями. Идеология проникала буквально везде, даже в детский праздник.

Nvidia стоит $3.3 триллиона — больше, чем ВВП России, Франции или Канады. AI-стартапы собирают сотни миллионов долларов на красивых презентациях, где главный аргумент — «мы используем GPT». Каждая вторая компания добавляет в своё описание магические буквы «AI».

Знакомо?

Ровно так же было в 1999-м с приставкой «.com». Тогда пузырь лопнул, индекс NASDAQ рухнул на 78%, инвесторы потеряли $5 триллионов, сотни компаний обанкротились за считанные месяцы. Но знаете что? Интернет никуда не делся. Более того — изменил мир настолько, что мы уже не представляем жизнь без него.

Сейчас мы проходим тот же путь с искусственным интеллектом. И да, будет больно. Но давайте разберёмся, почему это нормальный этап развития технологии, кто выживет в этой гонке, и стоит ли вообще паниковать.

Финансовый пузырь — это когда цена актива растёт не потому, что он реально стоит дороже, а потому что все вокруг сходят с ума и боятся упустить свой шанс разбогатеть. Классическая схема: кто-то находит что-то новое и перспективное → ранние инвесторы зарабатывают → все остальные видят их успех и бросаются вкладываться → цены взлетают до небес → рано или поздно становится очевидно, что король-то голый → паника → крах.

Человечество регулярно наступает на эти грабли. Были тюльпаны в Голландии (да, серьёзно, в 1637 году за одну луковицу давали цену хорошего дома), была железнодорожная лихорадка в XIX веке, был dot-com в конце 90-х, были криптовалюты в 2017-м и NFT в 2021-м.

Главный парадокс: технология обычно реальна и меняет мир. Проблема в том, что большинство компаний, которые пытаются на ней заработать, не доживают до того момента, когда технология становится мейнстримом.

Представьте: 1999 год, интернет только-только начинает проникать в дома обычных людей. Модемы пищат, сайты грузятся по минуте, никто толком не понимает, как на этом зарабатывать. Но все уверены: кто первым займёт нишу в интернете — тот станет миллиардером.

Масштаб эйфории:

NASDAQ вырос с 751 пункта в январе 1995 до 5048 в марте 2000 — в 6.7 раз за 5 лет

В 1999 году прошло 457 IPO, большинство — интернет-компании без выручки

Коэффициент P/E для NASDAQ достиг 90.2 (для сравнения, здоровый рынок — 15-25)

Любая компания, добавившая «.com» в название, взлетала на бирже на 50-100%

А теперь конкретные истории — они лучше цифр показывают градус безумия.

Pets.com — символ эпохи

Интернет-магазин корма для собак. IPO 11 февраля 2000 года при оценке $290 миллионов. Бизнес-модель была... скажем так, сомнительной: они теряли 26 центов на каждом заработанном долларе. Привлечение одного клиента стоило $400, средний чек — $30.

Компания потратила $70 миллионов за 7 месяцев, заработав при этом всего $619,000. В их послужном списке — реклама на Super Bowl за $1.2 миллиона, которая стала хрестоматийным примером того, как нельзя тратить деньги.

От IPO до ликвидации прошло 268 дней. Финальная цена акции — $0.19.

Webvan — самый дорогой провал

Амбициозный проект доставки продуктов. Основатель Луис Бордерс (тот самый, из книжной сети Borders) хотел построить склады стоимостью $30-50 миллионов каждый в 26 городах. Проблема? Они работали меньше чем на 30% мощности.

Привлекли $830 миллионов инвестиций, включая $275 млн от SoftBank. Пиковая оценка — $8 миллиардов. Выручка до IPO — $395,000. Да, вы правильно прочитали: почти миллиард инвестиций при выручке меньше полумиллиона.

Банкротство случилось в июле 2001-го, акции упали до $0.06, 2,000 сотрудников уволены одним днём.

eToys — оценка выше, чем у Toys 'R' Us

IPO в мае 1999 года. В первый день торгов акции выросли с $20 до $76. Пиковая капитализация — $7.8 миллиардов — больше, чем у физического ритейлера Toys 'R' Us с тысячами магазинов по всей стране.

Через полтора года, в феврале 2001-го, акции стоили $0.09. Активы продали за $8.7 миллионов — меньше 0.1% от пиковой оценки.

*Примечание: В тексте указана оценка при IPO. Сумма привлечения на самом IPO составляла $82.5 млн (согласно биржевым данным того времени).

Понять инвесторов того времени можно. Интернет действительно был революционной технологией. E-commerce действительно имел смысл. Проблема была в трёх вещах:

Во-первых, инфраструктура не успевала за амбициями. Dialup-интернет, отсутствие онлайн-платежей, логистики — всё это появится позже.

Во-вторых, сработало стадное чувство. Когда ваш сосед заработал 300% на акциях какого-нибудь TheGlobe.com, сложно сидеть в стороне.

В-третьих, появилась мантра «старые правила больше не работают». Прибыль? Зачем, когда есть рост числа пользователей! Sustainable бизнес-модель? Да ладно, главное — первым занять рынок!

«Последнее, что я хочу — это быть прибыльным. Потому что тогда я не получу оценку интернет-компании» — типичный питч стартапа в 1999 году

Венчурные фонды заливали деньги во всё подряд, лишь бы в названии был «.com». Инсайдеры продавали акции в 23 раза больше, чем покупали за месяц до пика — они-то знали, что вечеринка скоро закончится.

10 марта 2000 года NASDAQ достиг исторического максимума в 5,048 пунктов. А потом...

14 апреля 2000-го, в «Чёрную пятницу», индекс рухнул на 9% за день и 25% за неделю. К октябрю 2002-го NASDAQ упал до 1,114 пунктов — минус 78% от пика.

$5 триллионов рыночной капитализации испарилось. Около 4,800 dot-com компаний обанкротились к 2003 году. 200,000 человек потеряли работу только в Кремниевой долине.

На восстановление индекса до уровней 2000 года ушло 15 лет — только в апреле 2015-го NASDAQ вернулся к отметке 5,000.

30 ноября 2022 года OpenAI выпустила ChatGPT как «research preview». Через 5 дней у них был 1 миллион пользователей. Через 2 месяца — 100 миллионов. Это самое быстрорастущее приложение в истории.

И началось.

Инвестиционная лихорадка:

2023: $55.6 миллиардов инвестиций в AI-стартапы (18% от всех венчурных инвестиций)

2024: от $100 до $131.5 миллиардов — треть всего мирового венчурного финансирования

Почти каждый четвёртый новый стартап — AI-компания

Но главное не объёмы, а оценки. Давайте посмотрим на конкретные компании.

OpenAI — флагман с убытками

Оценка выросла в 300 раз за 6 лет. Выручка в 2024-м — около $3.7 млрд. Убыток — $5 миллиардов. Прогноз убытков к 2026 году — $14 млрд.

Мультипликатор: 81× выручки. Для сравнения, у прибыльной Nvidia — 25-50×.

Anthropic — гонка за OpenAI

Основана бывшими сотрудниками OpenAI в 2021-м. Привлекла от $14 до $27 миллиардов суммарно. Amazon вложил $8 млрд, Google — $3.5 млрд+.

Оценка в марте 2025: $61.5 миллиардов, растут к $170 млрд. Выручка 2024 года — около $1 млрд. Рост оценки: в 9 раз за 18 месяцев.

Inflection AI — когда $1.3 млрд превращаются в $650 млн

В июне 2023 привлекли $1.3 миллиарда при оценке $4 млрд от Microsoft, Билла Гейтса, Эрика Шмидта. Сделали чатбот Pi с ~1 млн активных пользователей, но без внятной бизнес-модели.

Март 2024: Microsoft покупает команду и лицензию за $650 миллионов. Инвесторы получили номинальный возврат $1.10-1.50 на каждый вложенный доллар. То есть практически ничего не заработали.

Stability AI — история провала

Октябрь 2022: раунд $101 миллион при оценке $1 миллиард+. В 2023-м пытались привлечь по оценке $4 млрд — не вышло. Burn rate около $8 миллионов в месяц.

Март 2024: CEO Эмад Мостаке уходит под давлением инвесторов. Компания не платит счета AWS, задерживает зарплаты, ключевые исследователи увольняются.

Если вы следите за tech-новостями, наверняка заметили эти паттерны:

1. Массовая FOMO

54% управляющих фондами считают AI-акции переоценёнными или в пузыре (опрос Bank of America). Но продолжают покупать, потому что «все покупают».

2. «Без AI ты проиграл»

Любая компания, добавившая «AI» в описание продукта, получает приток инвестиций. Даже если AI там — просто обёртка над GPT API.

3. Оценки на основе будущего, а не настоящего

OpenAI оценивается в $300 млрд при убытках $5 млрд в год. Объяснение: «Но ведь в будущем...»

4. Знаменитости-инвесторы предупреждают

«Мы определённо в пузыре» — Рэй Далио, Bridgewater, ноябрь 2025

«Рынок AI находится в пузыре, похожем на dot-com. Люди будут переинвестировать и терять деньги» — Сэм Альтман, CEO OpenAI, август 2025

Когда даже глава OpenAI говорит о пузыре — это о чём-то говорит.

5. Sequoia Capital: вопрос на $600 миллиардов

Партнёр Sequoia Дэвид Кан посчитал: чтобы окупить все инвестиции в AI-инфраструктуру (GPU, дата-центры, электричество), индустрии нужно генерировать $600 миллиардов годовой выручки.

Реальная AI-выручка сейчас — около $35 миллиардов.

Разрыв: $565 миллиардов.

В центре всего этого безумия — одна компания, которая стала символом AI-эры точно так же, как Cisco была символом dot-com.

Капитализация:

Конец 2023: $1.23 триллиона

Конец 2024: $3.29 триллионов (+169% за год)

Текущая: $4.37 триллионов

Рост акций:

2022: -50% (медвежий рынок tech)

2023: +239% (AI-бум начался)

2024: +171%

Финансовые показатели:

Да, вы правильно прочитали. $130 миллиардов годовой выручки. Для сравнения: весь ВВП Украины — около $188 млрд, Казахстана — $296 млрд.

Прибыльность:

Gross margin: 73-75% (non-GAAP)

Чистая прибыль Q3 FY2026: $31.91 миллиарда — за один квартал

Data Center (AI-чипы) составляет 87-90% общей выручки

Всё просто: они производят то, без чего AI не существует — GPU для обучения нейросетей.

Доля рынка:

70-95% рынка AI-чипов (разные оценки)

AMD: 4-11%

Intel: меньше 1%

Остальное — собственные чипы Google, Amazon, Microsoft

Когда OpenAI нужно обучать GPT-5, они покупают тысячи чипов Nvidia. Когда Anthropic масштабирует Claude, они покупают Nvidia. Когда любой AI-стартап хочет запустить свою модель — Nvidia.

Эффект «продавца лопат»:

Помните золотую лихорадку в Калифорнии XIX века? Большинство золотоискателей разорились. Но знаете, кто точно заработал? Леви Страусс, продававший джинсы и лопаты.

Nvidia — это современный Леви Страусс. Пока все копают AI-золото (причём большинство копает впустую), Nvidia продаёт им лопаты по $30,000 за штуку.

Вопрос на триллион (буквально).

Сравнение с ВВП стран:

Капитализация Nvidia превышает ВВП 189 из 194 стран мира

Nvidia = 3.6% мирового ВВП

Больше, чем ВВП России ($2.24 трлн), Франции ($3.0 трлн)

Приближается к ВВП Германии ($4.5 трлн)

Аргументы «за» (быки):

Реальная, огромная прибыль — не какие-то там убытки

Технологическое лидерство: CUDA, экосистема разработчиков

Спрос превышает предложение — очередь на чипы на год вперёд

P/E около 45-50 — не космос для такого роста

59 из 66 аналитиков рекомендуют Buy

Аргументы «против» (медведи):

Вся выручка завязана на AI-хайп — что будет, когда пузырь сдуется?

Конкуренция растёт: AMD MI300X, Intel Gaudi 3, собственные чипы Microsoft/Amazon

Goldman Sachs предупреждает о «циркулярной выручке»: Nvidia инвестирует в AI-стартапы → те покупают чипы Nvidia → «рост продаж»

Геополитические риски: экспортные ограничения в Китай

Seeking Alpha оценивает fair value в $86 за акцию (текущая цена ~$145)

Мнение CEO Jensen Huang:

«Началась следующая промышленная революция. Nvidia находится в эпицентре — мы двигатель крупнейшей промышленной революции в истории человечества» — Jensen Huang

«Спрос на Blackwell [новое поколение чипов] зашкаливает» (off the charts)

Уверенность впечатляет. Но знаете, кто ещё был уверен? CEO Pets.com в январе 2000-го.

Хорошая новость: не все умерли.

Amazon — падение 94%, сейчас $2 триллиона

Акции рухнули с $106.69 в декабре 1999 до $5.51 в 2001 — минус 94%. Компания была на грани банкротства.

Что спасло:

За месяц до краха привлекли $1.25 миллиарда — хватило на survival mode

Была реальная бизнес-модель: люди действительно покупали книги онлайн

Первая прибыль в Q4 2001 — доказали, что умеют зарабатывать

Пивот: запуск AWS в 2006 — диверсификация от e-commerce

$1,000, инвестированные в Amazon на пике 1999 года, сегодня стоят $15,500+.

Google — не вышел на IPO во время пузыря

Основан в сентябре 1998 — в разгар роста пузыря. IPO только в августе 2004 по $85 — уже после краха.

Почему выжили:

Прибыльная бизнес-модель с первого дня: контекстная реклама работала

Eric Schmidt как CEO (2001) добавил управленческую дисциплину

Не тратили деньги на безумную экспансию

$1,000 на IPO 2004 года = $66,000+ сегодня.

Priceline/Booking Holdings — падение 99%, сейчас $158 миллиардов

Акции рухнули с $974 в апреле 1999 до $6.60 в октябре 2002 — минус 99.3%.

Как выжили:

Была реальная выручка (хоть и небольшая прибыль)

CEO Jeff Boyd (2002) пивотнул от «Name Your Own Price» к классическому бронированию отелей

Приобретение Booking.com в 2005 — вовремя увидели международный рынок

$10,000, инвестированные в октябре 2002, превратились в $1.47 миллиона к 2013.

Вот что важно понять: интернет не исчез после краха 2000-го.

Наоборот:

E-commerce вырос в десятки раз

Появились соцсети (Facebook, 2004)

Облачные сервисы (AWS, 2006)

Стриминг (Netflix перешёл на стриминг в 2007)

Смартфоны и мобильный интернет (iPhone, 2007)

85-95% оптоволокна, проложенного в dot-com эру, не использовалось 4 года после краха. Но потом именно эта инфраструктура обеспечила рост YouTube, Netflix, облачных сервисов.

Инвесторы переоценили скорость adoption, но недооценили масштаб влияния.

Что отличало Amazon, Google, eBay от Pets.com и Webvan?

1. Реальная бизнес-модель

Не «мы будем терять на каждом клиенте, но компенсируем объёмом», а «вот как мы зарабатываем прибыль».

2. Unit-экономика, которая сходится

CAC (cost of acquisition) < LTV (lifetime value). Простая формула, которую 48% выживших соблюдали, а 100% провалившихся — игнорировали.

3. Умение генерировать выручку

Не «у нас 10 миллионов посетителей сайта», а «у нас $50 миллионов годовой выручки».

4. Решение реальной проблемы

Люди действительно хотели покупать книги онлайн (Amazon), искать информацию (Google), бронировать отели (Priceline). Люди не хотели покупать корм для собак с доставкой дороже самого корма (Pets.com).

5. Финансовая дисциплина

Расходы соответствуют выручке. Не $70 миллионов затрат при $600,000 выручки.

Применим уроки dot-com к текущей ситуации.

1. Большие технологические компании

Google, Microsoft, Meta, Amazon — у них:

Огромные денежные резервы ($600+ миллиардов совокупных)

Существующие продукты, в которые они встраивают AI

Собственные дата-центры и инфраструктура

Не зависят от венчурного капитала

Microsoft интегрирует AI в Office, Azure, Windows. Google — в Search, Gmail, YouTube, Cloud. Meta — в Instagram, WhatsApp, рекламу. Amazon — в AWS, Alexa, e-commerce.

2. Поставщики инфраструктуры (с коррекцией)

Nvidia, AMD, облачные провайдеры — они продают лопаты, а не копают сами. Но:

Оценка Nvidia может упасть на 30-50%

Появятся новые игроки (кастомные чипы от Microsoft, Google, Amazon)

Маржа снизится с текущих космических 73-75%

3. Вертикальные AI-решения

Не «AI для всего», а AI для конкретной индустрии:

AI для медицинской диагностики (уже работает лучше врачей в некоторых областях)

AI для legal tech (анализ контрактов, поиск прецедентов)

AI для финтеха (fraud detection, кредитный скоринг)

У них есть проприетарные данные и глубокая интеграция в workflow.

1. «Обёртки над GPT»

Стартапы, которые просто вызывают API OpenAI/Anthropic и добавляют красивый UI. Барьер входа — ноль, конкурентное преимущество — ноль.

~85% AI-стартапов обанкротится за 3 года — прогноз венчурных инвесторов.

2. Компании с огромными оценками, но без выручки

Если у тебя оценка $5 миллиардов, убыток $100 миллионов в год и выручка $20 миллионов — у тебя проблемы.

3. Consumer AI hardware

Humane AI Pin (закрылся в 2025), Rabbit R1 — красивая идея, плохое исполнение, нет product-market fit.

4. Стартапы без собственной технологии

Если твоё конкурентное преимущество — «мы раньше других начали использовать GPT-4», у тебя нет конкурентного преимущества.

Консолидация

Крупные купят перспективных по 10-20% от пиковой оценки. Microsoft + Inflection, Google + Character.AI — это только начало.

Падение оценок на 50-70%

Компании, оценённые в $5 миллиардов в 2024-м, будут стоить $1.5-2.5 миллиарда в 2026-м.

AI станет коммодити

Как сейчас облачные сервисы: необходимая инфраструктура, но не источник сверхприбылей.

Рост практического применения

Меньше хайпа, больше real use cases. McKinsey: 80% компаний используют AI, но 80% не видят значимого влияния на выручку. Это изменится — но через 3-5 лет, не сейчас.

Не покупайте на хайпе

Когда Uber-водитель даёт вам советы по AI-акциям — пузырь близок к пику. Классический индикатор.

Смотрите на фундаментальные показатели

P/E больше 60-70 без безумного роста выручки = красный флаг

Отсутствие прибыльности + огромная оценка = ещё один красный флаг

Зависимость от одного тренда = третий красный флаг

Диверсифицируйте

Не ставьте 50% портфеля на AI. Даже если вы уверены. Особенно если вы уверены.

Помните статистику

48% dot-com выжили до 2004, но по гораздо более низким оценкам. Выживут и AI-компании — но какие именно, мы узнаем только после.

Внедряйте AI там, где это даёт реальную пользу

Не «давайте добавим AI куда-нибудь», а «эта конкретная задача решается AI в 10 раз быстрее/дешевле/точнее».

Не переплачивайте

Когда AI-консультанты говорят «вам нужна custom LLM за $500,000» — в 90% случаев вам хватит ChatGPT Enterprise за $60/месяц на сотрудника.

Готовьтесь к снижению стоимости AI-инструментов

Цены на AI упадут в 5-10 раз за 3-5 лет. Не стройте бизнес-модель на том, что AI будет вечно дорогим.

AI точно останется

Это не очередной blockchain или metaverse, который обещали и забыли. AI реально работает и реально полезен.

Учитесь работать с инструментами

ChatGPT, Claude, Midjourney, Notion AI — изучайте их сейчас. Через 5 лет это будет базовая грамотность, как Excel в 2000-х.

Не паникуйте от новостей о крахе стартапов

Когда закроется очередной AI-стартап с $500 миллионов оценки — это нормально. Это как гибель Pets.com не означала смерть e-commerce.

Помните: технология ≠ конкретная компания

Интернет остался, хотя Webvan умер. AI останется, хотя многие AI-стартапы умрут.

Давайте смотреть правде в глаза.

Да, будет больно. Многие потеряют деньги. Около 85-90% AI-стартапов закроются. Инвесторы, вложившиеся на пике, увидят портфели в минусе на 50-70%. Nvidia может упасть с $4.4 триллионов до $2-2.5 триллионов.

Но искусственный интеллект не исчезнет.

Он станет такой же обыденностью, как интернет сегодня. Помните, что после краха dot-com'ов появились Google (2004 IPO), Facebook (2004), iPhone (2007), AWS (2006). Вся современная цифровая экономика выросла на руинах dot-com пузыря.

После AI-пузыря появится что-то ещё круче. AGI? Персональные AI-ассистенты в каждом устройстве? AI-first операционные системы? Мы не знаем. Но это будет.

Просто не все доживут до этого момента.

Три ключевых урока:

Технология реальна, но тайминг решает всё

Интернет в 1999-м был реален. AI в 2024-м реален. Но большинство компаний, пытающихся на этом заработать прямо сейчас, провалятся.

Выживают те, кто умеет зарабатывать, а не только тратить

Amazon выжил, потому что научился быть прибыльным. Pets.com умер, потому что только жёг кэш.

Пузыри — нормальная часть развития технологий

Они больно лопаются, но без них не было бы ни смартфонов, ни соцсетей, ни облаков. Пузыри концентрируют капитал и таланты в одной области. Да, 90% провалятся. Но 10%, которые выживут, изменят мир.

Что делать вам прямо сейчас?

Если вы инвестор — пересмотрите портфель. Если вы предприниматель — проверьте unit-экономику. Если вы обычный человек — начните изучать AI-инструменты.

И помните слова Марка Твена: «История не повторяется, но рифмуется».

Мы уже видели этот фильм в 1999-м. Концовка будет похожей, но не идентичной.

Статья написана на основе публичных данных, финансовых отчётов компаний и аналитических исследований. Автор не даёт инвестиционных рекомендаций. Все инвестиционные решения вы принимаете на свой страх и риск.

Короче, пацаны и пацанессы, мне 30+ (или сколько там), и я наконец решил сделать то, о чём мечтал ещё в школе - свою собственную игру. Да-да, я знаю, что вы сейчас подумали: "Ну вот, ещё один". Но выслушайте.

История моей боли

С детства хотел делать игры. Даже были попытки - открывал всякие движки, пытался что-то сваять. Но есть нюанс: я НЕ программист. Вообще. То есть я типа пытался научиться, но дальше Hello World дело не зашло. А быть одним лишь сценаристом в геймдеве - это как прийти на стройку с идеями, но без инструментов. Никому не надо.

И вот я сидел годами с этой мечтой в голове, понимая, что без команды и без навыков это всё так и останется фантазиями.

А потом случился AI-бум

И тут началось. ChatGPT, Claude, Cursor, всякие кодогенераторы... Внезапно оказалось, что все эти креативные ребята, которые раньше могли только мечтать, теперь могут генерить себе приложения, игры, книги, фильмы - что угодно, на что хватит фантазии.

Я смотрел на это года полтора и думал: "А почему бы и нет?" В конце концов, если не попробовать сейчас, когда ещё?

Что я решил делать

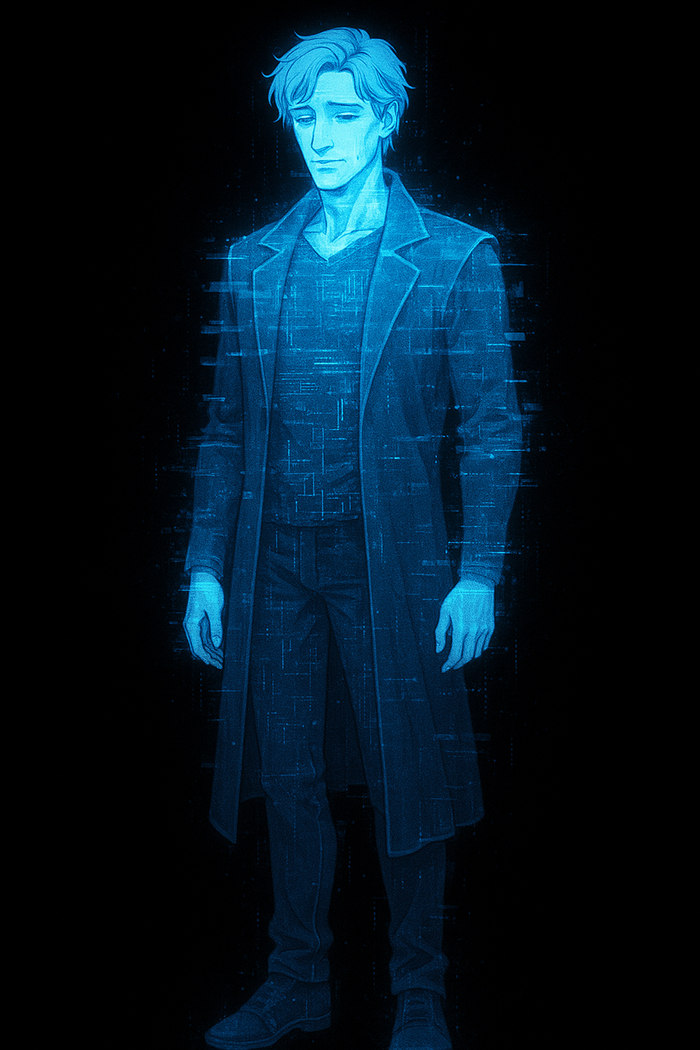

Мобильная визуальная новелла в сеттинге киберпанка.

Почему визуальная новелла? Потому что это самое простое для программирования (я надеюсь). Потому что я даже не уверен, что с помощью нейросетей смогу что-то запрограммировать вообще, но новелла - это хоть какой-то шанс довести до конца.

Почему киберпанк? Потому что люблю. Потому что атмосфера. Потому что неоновые огни и философия про человечность в мире технологий - это всё ещё актуально.

План действий (или "как я собираюсь облажаться публично")

Сначала пишу сценарий, уже начал. Потом буду подходить к кодированию - буду использовать Claude Code и другие AI-инструменты, буду гуглить, материться и, возможно, найду себе в помощь живого разработчика. Арты буду делать через нейросети, но с редактурой. Даю себе на всё это один год. Либо к концу 2026 у меня будет игра, либо эпичный провал.

И вот этой статьёй я запускаю серию постов о разработке. Буду писать, с какими трудностями сталкиваюсь, что получается, что нет, как AI помогает или, наоборот, генерит дичь.

Что уже есть

Я плотно посидел с нейросетями, попробовал кучу вариантов, внес много корректировок и сделал три концепта сценария. Один мне очень нравится, два других - так себе. Прилагаю их к посту.

Версия сюжета 1

Сеттинг: Мегаполис Гексагон, 2071 год

После Корпоративных войн 2050-х годов старые государства рухнули. Миром правят пять мегакорпораций. Гексагон — нейтральная зона на стыке трёх из них: ОмниГрупп, НейроТех Синдикат и Сингулярность.Ко.

Атмосфера:

Вечные сумерки из-за смога и светового загрязнения

Неоновые джунгли из рекламы и голограмм

90% населения живёт с нейроинтерфейсами

Уличные хакеры (нетраннеры) — цифровые наёмники без романтики

Визуальный стиль: Грязный киберпанк в духе "Бегущего по лезвию" + "Нейроманта". Не яркий neon-punk, а мрачный, реалистичный мир корпоративной антиутопии.

Нетраннерка-одиночка, ~30 лет. Циничная, уставшая, умирающая от неисправного нейроинтерфейса. Работает не за идею, а за выживание. Бывшая корпоративная сотрудница, чью команду предали и убили. Её память частично фальсифицирована корпорацией.

Загадочный нетраннер, который никогда не встречается в реале. ТВИСТ: он умер три года назад от болезни, был оцифрован корпорацией и превращён в цифровую рабочую силу. Сбежал из виртуальной тюрьмы. Теперь существует только в сети. Его мотивация — месть корпорации, которая превратила людей в программы.

Романтическая линия: Веха влюбляется в Шума, не зная, что у него нет тела. Раскрытие правды происходит в Акте 3.

Бывший партнёр Вехи, предавший команду. Теперь работает на НейроТех. Ключевой источник информации, но ему нельзя доверять.

Веха получает заказ: взломать хранилище ОмниГрупп и извлечь данные проекта "Серое зеркало". Плата — 50,000 кредитов (достаточно для лечения интерфейса). Во время взлома она сталкивается с другим хакером — Шумом. Их взломы конфликтуют, система засекает обоих. Они вынуждены объединиться.

Собирая фрагменты данных из разных корпораций, герои раскрывают правду о "Сером зеркале" — программе массовой фальсификации памяти через нейроинтерфейсы. Корпорации могут редактировать воспоминания миллионов людей.

Между Вехой и Шумом возникают чувства, но Шум избегает встречи в реале. Постепенно раскрывается его тайна.

Получив доступ к полным данным, герои узнают:

Память Вехи была изменена

Шум — оцифрованное сознание, сбежавшее из цифровой тюрьмы

"Серое зеркало" уже активно и контролирует миллионы людей

У них три варианта использовать данные.... (далее не буду писать всю интригу сюжета)

Версия сюжета 2

Город, построенный как памятник чему-то давно сгнившему. Вечный дождь смывает грязь с улиц, но тут же заменяет её новой. Смог застилает небо так плотно, что никто не помнит, когда последний раз видел солнце. Неоновые вывески превращаются в ядовитые кляксы на мокром асфальте.

Структура мира:

Верхний город — башни из хрома и презрения, где правит Aeterna Dynamics

Нижний город — трущобы, где живут "призраки" и нетраннеры

Цифровое пространство — "Нексус", сеть корпоративных данных, защищённая ICE-системами

Они не торгуют оружием или наркотиками. Это слишком грязно. Они торгуют тем, что дороже — памятью.

Их продукты:

"Хранилище" — база данных оцифрованных сознаний. Вечная жизнь в виде холодного слепка.

Технология "Очищения" — удаление травматических воспоминаний. Выжигание кусков души каленым железом кода.

Редактирование памяти — корпорация решает, что ты должен помнить и кем должен быть.

Философия мира: В Кенотаф-Сити нельзя доверять никому. Особенно — собственным воспоминаниям.

Те, кто ныряет в цифровые бездны за данными. Мусорщики на свалке чужих воспоминаний. Они единственные, кто ещё пытается сохранить хоть какую-то независимость от корпорации.

Внешность:

Мужчина, возраст неопределён (~30-35)

Потрёпанный, циничный

Носит старое, но функциональное снаряжение нетраннера

Следы множественных кибермодификаций

Характер:

Параноик, который доверяет только фактам

Использует "шум" как тактику — громкие отвлекающие взломы

Предпочитает работать один

Циничный, но не жестокий

Мотивация: Ищет технологию "Очищения" в базах Aeterna Dynamics. Причина пока неясна — возможно, хочет удалить собственные воспоминания или спасти кого-то. Это личная миссия, не просто работа.

Стиль взлома: Агрессивный, "громкий". Использует старые, но проверенные эксплойты. Оставляет следы, но компенсирует это скоростью.

Внутренний конфликт: Понимает, что его методы устарели. Защита Aeterna адаптируется. Он либо изменится, либо погибнет.

Внешность:

Женщина, возраст неопределён (~27-30)

Элегантная, контролирующая каждое движение

Плащ из дорогого материала (меняет цвет в зависимости от освещения)

Короткие тёмные волосы

Спокойные, анализирующие глаза

Характер:

Ледяная, рациональная

Говорит ровным, почти механическим голосом

Не тратит слов впустую

"Призрак" — мастер незаметного проникновения

Мотивация: Ищет "Хранилище" и слепок своего брата. Брат был оцифрован Aeterna (вероятно, без его согласия или умер). Стазис хочет либо освободить его, либо узнать правду.

Стиль взлома: Хирургически точный, невидимый. Проходит сквозь ICE-защиту "как игла сквозь ткань, не оставив следа". Абсолютная скрытность.

Внутренний конфликт: Чтобы достать брата, ей нужен напарник. Она ненавидит зависеть от других, но у неё нет выбора.

Завязка: Апокриф планирует взлом Aeterna Dynamics в одиночку, чтобы добраться до технологии "Очищения". Его методы устарели — он оставляет цифровые следы, корпорация уже знает, что кто-то идёт.

Стазис выслеживает его и предлагает сотрудничество. Она знает о его цели (каким-то образом). Она предлагает сделку: она поможет ему пройти незаметно в обмен на доступ к "Хранилищу", где находится слепок её брата.

Первый выбор: Апокриф решает — доверять ей, атаковать информацией о её брате или притвориться, что не понимает, о чём речь.

Результат: Вынужденный альянс. Они начинают планировать взлом "Нексуса" — центральной базы данных Aeterna.

Развитие: Апокриф и Стазис совершают серию взломов, собирая ключи доступа к "Нексусу". Каждый взлом раскрывает больше о мире:

"Хранилище" — это не просто база данных. Это цифровая тюрьма, где миллионы оцифрованных сознаний существуют в симуляции без возможности выхода.

Технология "Очищения" — не удаляет воспоминания, а заменяет их ложными. Aeterna буквально переписывает личности людей.

"Нексус" содержит данные обо всех, кого корпорация "обработала" — включая Апокрифа и Стазис.

Моральные дилеммы:

Во время взломов они находят информацию, которая может спасти невинных или помочь им. Но использование этой информации привлечёт внимание корпорации.

Они обнаруживают, что многие нетраннеры, которых они знали, уже мертвы или "очищены". Стоит ли рисковать ради мёртвых?

Отношения: Между Апокрифом и Стазис возникает напряжение — не романтическое, а психологическое. Они начинают понимать методы друг друга. Апокриф учится тонкости. Стазис понимает ценность хаоса.

Но доверие хрупко. Каждый скрывает что-то важное.

Далее уже спойлеры.

Версия сюжета 3

МИР ИГРЫ, ПЕРСОНАЖИ И СЮЖЕТ

⚠️ Примечание: Данное описание основано на прологе игры. Полный сюжет не раскрыт в предоставленном фрагменте.

Мир постоянной слежки и контроля. Дождь здесь не просто погода — это "лучший шифр", маскирующий цифровую активность. Город пронизан системами мониторинга:

Камеры наблюдения с распознаванием речи и жестов

Дроны-патрули в коридорах и на улицах

Системные логи отслеживают каждый паттерн трафика

"Горячие узлы" — опасные точки сети с усиленной защитой

Атмосфера:

Затемнённые боксы без акустики (для безопасных встреч)

Мокрый неон за окнами

Гул дронов как постоянный фоновый шум

Влажные коридоры

Параноидальная осторожность во всём

Философия:

Слова опасны — камеры обучаются новым терминам

Жесты безопаснее речи

"Ровные вещи опасны. Их швы всегда где-то внутри" — любая идеальная система скрывает уязвимость

"Любая тень тянет" — каждое действие оставляет след

Сеть, где движется трафик с сигнатурами. Нетраннеры работают с:

Масками — способами скрыть цифровые следы

Паттернами трафика — которые система анализирует

Маршрутами — безопасными путями через узлы сети

Хвостами — следами, которые невозможно полностью стереть

Характер:

Осторожная до паранойи

Философски настроенная — мыслит метафорами

"Стараюсь приходить пустой" — не несёт лишней информации, минимализм

Профессионал, который понимает риски

Стиль:

Предпочитает тишину и осторожность

Думает о последствиях каждого действия

Внутренний монолог раскрывает её мыслительный процесс

Готова прикрыть напарника (высокая Связь)

Специализация: Работа с масками и сигнатурами. Умеет скрывать цифровые следы, маскировать паттерны трафика.

Мотивация (не раскрыта в прологе):

Упоминается "долг" и то, что "будущее уже кем-то оплачено"

Возможно, работает, чтобы закрыть какое-то обязательство

Внутренний конфликт:

Баланс между безопасностью и эффективностью

Доверие к напарнику vs собственная осторожность

Характер:

Сухой, лаконичный

Прагматичный — говорит только по делу

"Нечего обучать камеры новым словам" — понимает систему слежки

Осторожный в речи

Стиль:

Краткие команды

Не называет вещи прямо (использует намёки)

Работает с Лакуной как команда, но держит дистанцию

Специализация: Прикрытие каналов связи, возможно работа с сетевой инфраструктурой.

Мотивация: "Когда это кончится — у меня будет закрыт один долг."

Керн работает не по своей воле, а чтобы расплатиться с кем-то. Это не добровольная миссия.

Внутренний конфликт:

Хочет закончить это дело и освободиться

Зависит от Лакуны, но не говорит об этом прямо

Лакуна и Керн — профессиональный дуэт:

Работают вместе, но не раскрывают всех карт

Оба связаны "долгом" — работают по принуждению

Доверяют навыкам друг друга, но не эмоционально близки

Их диалоги минималистичны — экономия слов в мире слежки

Система отношений (через флаги):

Связь — уровень доверия и синхронности (влияет на эффективность совместных действий)

Шум — уровень заметности в системе (чем выше, тем опаснее)

Долг — прогресс в закрытии обязательств (мотивация персонажей)

Ситуация: Лакуна и Керн встречаются в затемнённом боксе без акустики — одном из немногих мест, где можно говорить относительно безопасно. Керн показывает ей фрагмент сигнатуры — цифрового следа чего-то важного.

Проблема: Сигнатура "неестественно ровная" — это признак либо ловушки, либо чего-то очень секретного. Система мониторинга уже обнаружила "нетипичный паттерн трафика".

Задача: Им нужно:

Замаскировать сигнатуру — скрыть след от системы (головоломка "Маска-солвер")

Вывести данные тихо — без активации защитных систем

Выбраться из локации — не попав под наблюдение дронов

Первый выбор:

Спокойно согласиться помочь → повышает Связь

Колко ответить → понижает Связь, но показывает независимость

Головоломка "Маска-солвер": Игрок должен замаскировать сигнатуру, используя паттерны трафика. После успешного решения система регистрирует: [Сигнатура замаскирована]

Второй выбор (кто идёт первым):

Лакуна выходит первой → она рискует, Шум −1 для Керна

Лакуна прикрывает Керна → повышает Связь, но Лакуна в зоне риска

Раскрытие мотивации: Керн признаётся, что работает, чтобы "закрыть долг". Лакуна философски отвечает: "Долги — это когда будущее уже кем-то оплачено."

Оба персонажа работают по принуждению, расплачиваясь за что-то из прошлого.

Также сделал несколько видеозаставок... но они получились какими-то слишком уличными, не знаю. Может, лучше сделать стандартную анимацию? Или взять мультяшный стиль, чтобы было менее кринжово? Хз, буду думать.

Концепт арты персонажей, окружения и интерфейса игры

Мне нужна ваша помощь

Серьёзно. Я хочу знать ваше мнение. Как вам концепты? Какой заходит больше? Видеозаставки в таком стиле - это норм или лучше не надо? Есть ли вообще смысл в этой затее?

Можете осудить, обсудить, поржать - всё принимается. Главное - дайте фидбек.

Почему я всё это рассказываю публично?

Потому что если я просто начну делать игру один в тишине, я брошу это через неделю. А так у меня появится груз ответственности. Вы будете спрашивать: "Чувак, ну как там твоя игра?" И мне придётся отвечать. Это мой хитрый план.

Ещё у меня есть телеграм-канал https://t.me/mrLastmann - там буду постить новости чаще, чем на Пикабу. Если вам интересно следить за процессом, добро пожаловать.

Спасибо всем, кто дочитал. Увидимся в следующей серии "Как я пытался написать код и плакал".

За годы, что я слежу за Эпохой, я убедился, что в ней самое активное и дружелюбное комьюнити на моей памяти. Это множество людей из десятков стран, которые общаются, играют и создают контент вместе. Я подумал, что наша любимая игра заслуживает особый день в году, как праздник. Похожие “народные” праздники существуют и в других сообществах. Например фанаты “Star Wars” отмечают 4-е мая(May 4th - игра слов от знаменитой фразы May the force be with you), а фанаты Mass Effect празднуют 7-е ноября.

Этот день может стать способ привлечь новых игроков в Эпоху, показать разработчику и издателю, что к игре сохраняется высокий интерес, а также станет повод вернуться ненадолго для тех, кто со временем играть перестал, но сохранил теплые воспоминания об игре и следит за ней на стримах и в Ютубе.

Сначала я хотел предложить 14.11 как “День Эпохи” честь самых популярных таунтов и дня релиза АоЕ2:DE, но будний вечер неудобное время для многих. По статистике Steam больше всего людей играет в Эпоху по выходным. Поэтому предлагаю установить правило - первое воскресенье после 14 ноября - это “День Эпохи” как компромисс между символизмом и удобством.

Что же делать в такой делать? Зависит от того, насколько вы погружены в мир игры. Предлагаю несколько вариантов:

1. Для активных игроков просто прийти и сыграть любимый режим в мультиплеере или погонять ботов именно в вечер воскресенья

2. Те, кто давно не заходил могут попробовать новые нации или кампании. Год назад несколько дополнений стало бесплатными, а также вышли Троецарствие и Хроники.

3. Либо можно поиграть в пользовательские кампании за Хорватов, Арабов, Славян и другие. Орнлу, например делал подборку кампаний пару лет назад (https://www.youtube.com/watch?v=mUtSv0pRZY8)

4. Можно позвать старых знакомых и устроить игровой вечер в ффа или других фановых режимах. Например, в эпохе есть арты Скайрима и Вестероса.

5. <Любая активность внутри АоЕ от игр с ботами до 9x FFA кастомки>

А еще возник безумный челлендж для всего сообщества - обновить рекорд пикового онлайна в игре. И тут вы такие: "У тебя 560 подписчиков в тг и средний онлайн в 100 человек - ты куда разогнался?" И будете правы - в одного такую штуку в жизни не поднять, поэтому я уже набежал в личку к разным иностранным стримерам от США до Китая с этой инициативой.

Это сложная, но реальная цель, если все сообщество будет действовать вместе. Сейчас за неделю пиковый онлайн - это 26-28 тысяч, а за всю историю - это 38 тысяч человек в Стиме. То есть нам надо, чтобы за сутки в игре показалось дополнительно 10-12 тысяч человек. Для сравнения - это средний онлайн стримов по вечерам. При этом активных игроков, которые хоть раз за месяц играли командные игры 67 тысяч человек - просто они заходят в игру в разное время.

В итоге, чтобы побить рекорд онлайна надо собрать игроков в одно время в воскресенье в игре. Для этого расскажите об этой идее всем знакомым и поделитесь ей с любимыми стримерами и ютуберами и врывайтесь играть в следующее воскресенье! Раскачаем наше СНГ-сообщество и отметим первый День Эпохи по-настоящему ярко!

Знаешь, я тут на днях в очередной раз перепроходил Киберпанк (да-да, опять, не смотри на меня так), и внезапно прозрел. Стоп. Это же Балдурс Гейт 3, только с пушками вместо фаерболов! Серьёзно, я сейчас тебе на пальцах объясню почему эти две игры — близнецы-братья, только один в кожаной куртке с мантис-блейдами, а второй в робе с посохом.

Окей, смотри как работает схема. В Киберпанке тебе впиливают в череп чип-реликварий с цифровым призраком Джонни Сильверхенда. Этот чип медленно, но верно перезаписывает твою личность. То есть понимаешь — ты буквально умираешь, пока какой-то рокербой-террорист пятидесятилетней давности оккупирует твой мозг. Круто, да? Нет, не круто, это полный караул.

А теперь Балдурс Гейт. Тебе запихивают в мозг иллитидского головастика. Эта мерзкая личинка должна сожрать тебя изнутри и превратить в свежевателя разума — такого кальмарообразного монстра без души и личности. По канону у тебя там буквально дней семь до превращения, но магия замедлила процесс. Спасибо, конечно, но ненадолго.

И вот что самое интересное — в обоих случаях тебя насильно этим заразили, ты этого не выбирал. В Киберпанке чип вживляют обманом через Декстера, в БГ3 вообще просто похищают и всаживают личинку силой. В обеих играх у тебя тикают часы — живёшь с постоянным ощущением "я скоро сдохну или превращусь в монстра". И знаешь что? Паразит в обоих случаях даёт силу, но при этом убивает. Джонни делится опытом и связями, головастик открывает иллитидские способности, но оба медленно уничтожают тебя как личность. А весь сюжет обеих игр вертится вокруг одного вопроса: как мне вытащить это из головы, пока не стало слишком поздно?

Знаешь что самое смешное? Обе игры проходят через одни и те же этапы! Сначала идёт фаза "Господи, что со мной происходит". В Киберпанке ты просыпаешься, видишь Джонни, Виктор говорит "у тебя пара недель", и ты такой сидишь в лёгком шоке. В БГ3 вылезаешь из корабля свежевателей, чувствуешь шевеление в башке, и все вокруг типа "братан, ты труп ходячий, соболезную".

Потом начинается второй этап — "Кажется, есть надежда!.. а нет, обломинго". В Киберпанке Вудуисты обещают решение, потом кидают тебя, и в итоге всё равно ведут к Альт Каннингем. В БГ3 друиды обещают помочь — облом, гитьянки обещают — тоже облом, всякие знахари и мудрецы — опять пролёт. Классическая схема ложных надежд, когда ты бегаешь от одного "эксперта" к другому, а они все разводят руками.

И наконец третий этап — "Всё гораздо хуже, чем казалось". В Киберпанке выясняется, что Альт может спасти только одного — либо ты, либо Джонни, и никакого простого хэппи-энда не предвидится. В БГ3 оказывается, что твой головастик особенный, связан с Абсолютом и Нетером, и просто так вырезать его означает сдохнуть на месте.

Видишь схему? Это буквально один и тот же сюжет, просто в разных обёртках. Только в одном случае это всё происходит в неоновом Найт-Сити под синтвейв, а в другом — в средневековом фэнтези под звуки лютни.

ЧТО ЕСТЬ "Я"? — ФИЛОСОФИЯ ДЛЯ ЗАДРОТОВ

Обе игры задают один и тот же экзистенциальный вопрос: а кто ты вообще такой? И это не просто красивые слова для трейлера, это реально центральная тема.

Киберпанк постоянно тебя мучает вопросами. Энграмма Джонни — это реальный Джонни или просто очень убедительная программа, которая думает, что она Джонни? Если тебя перезапишут, ты умрёшь или "переедешь в другое тело"? А концовка с Альт вообще рвёт шаблоны — твоя душа в сети, это всё ещё ты или уже копия копии? Игра не даёт однозначных ответов, она просто ставит вопросы и отходит в сторонку с видом "сам разбирайся, приятель".

БГ3 играет в ту же игру. Останешься ли ты собой после превращения в иллитида? Свежеватели разума — это продолжение их жертв или совершенно новые существа? Финальный выбор с Орфеем прямо об этом — принять трансформацию значит убить себя как личность, даже если твоё тело продолжит существовать.

Понимаешь, обе игры не утешают тебя простыми ответами. Они ставят перед фактом: "Вот тебе дилемма, теперь сам думай, мы не будем держать тебя за ручку". И это честно. Жёстко, но честно.

Ещё один момент, который меня просто поразил своей идентичностью — постоянные "советчики" в голове. В Киберпанке Джонни материализуется рядом каждую секунду, комментирует буквально каждое твоё действие, спорит, критикует выборы, иногда даже соглашается — но чаще нет. В БГ3 Хранитель Снов (он же Император-иллитид, привет-привет) является во снах, даёт "советы", манипулирует, пытается показать себя союзником.

И знаешь что? Оба на самом деле преследуют свои цели. Оба — паразиты, которые изо всех сил пытаются выглядеть симбионтами. Джонни хочет закончить то, что начал при жизни, Император хочет выжить и сохранить свою свободу. Твоё благополучие для них важно ровно настолько, насколько оно помогает их планам.

А теперь команда. Обе игры дают тебе целую толпу напарников, и у каждого свой личный кризис идентичности. В Киберпанке у тебя Панам — изгнанная из клана, ищущая себя и своё место в мире. Джуди потеряла Эвелин и не знает, куда двигаться дальше. Керри — старый рокер в кризисе возраста, пытающийся понять, кто он теперь, когда молодость давно позади. Ривер разочаровался в системе и ищет справедливость там, где её быть не может. Бестия — королева Посмертия, пытающаяся найти своё место в постоянно меняющейся реальности.

В Балдурс Гейт история повторяется. Астарион — вампир-раб, который двести лет мечтал о свободе и теперь не знает, что с ней делать. Гейл — ходячая бомба, потерявший связь с богиней, которую любил, и теперь буквально взрывоопасен. Шедоухарт с украденной памятью не помнит, кто она на самом деле. Лаэзель предана своей королевой и ищет новый путь, когда старый рухнул. Уилл заключил сделку с дьяволицей и теперь расплачивается за свой выбор каждый день.

То есть понимаешь схему? Весь твой отряд в обеих играх — это сборище людей (ну или не совсем людей), которые так же мучаются с вопросом "кто я теперь такой". Это не случайность, это намеренная композиция. Игры окружают тебя персонажами с похожими проблемами, чтобы усилить центральную тему.

А теперь самое вкусное — концовки. Обе игры кульминируют в абсолютно невыносимом выборе, где правильного ответа просто не существует в природе.

Киберпанк даёт тебе варианты, и все они ужасны по-своему. Можешь отдать тело Джонни — жертвуешь собой ради того, чтобы он получил второй шанс. Можешь оставить тело себе — Джонни исчезает навсегда, но ты живёшь от силы полгода. Можешь уйти в киберпространство с Альт — но это вообще ты или уже нет, большой вопрос. Или продать душу Арасаке в надежде на спасение, что, честно говоря, хуже смерти.

БГ3 предлагает не менее жёсткий выбор. Можешь стать иллитидом сам — спасёшь всех остальных, но умрёшь как личность, превратившись в того самого монстра, которого боялся всю игру. Можешь заставить стать иллитидом Орфея или Карлаха — спасёшь себя, но убьёшь друга или обречёшь его на судьбу хуже смерти. Или попытаться схитрить с Орфеусом и Императором, но последствия этого выбора непредсказуемы.

В обоих случаях игра говорит: "Выбирай из плохого и очень плохого". Настоящего хэппи-энда, где все живы, здоровы и счастливы, нет ни там, ни там. Кто-то умрёт, кто-то потеряет себя, кто-то будет жить с грузом вины до конца дней. Это не баг, это фича — игры показывают, что взрослые решения не бывают лёгкими.

При всей схожести структуры, настроение у игр принципиально разное, и это важно понимать.

Киберпанк — это нуар отчаяния в чистом виде. Игра с первых часов бьёт тебя правдой в лицо: "Ты умрёшь. Точка. Нет спасения". Это не история о том, как найти лекарство и вылечиться. Это история о том, как прожить последние недели жизни так, чтобы они что-то значили. Это про принятие неизбежного, про поиск смысла перед лицом смерти. Весь Найт-Сити пропитан этим ощущением — дождливые улицы, неоновые огни, которые не могут разогнать тьму, персонажи, которые давно смирились с тем, что мир жесток и несправедлив.

БГ3 — героическое фэнтези в классическом понимании. Да, угроза серьёзная, да, может быть очень страшно, но игра сохраняет авантюрный, почти оптимистичный тон. Превращение в иллитида ужасно, но где-то в глубине души ты веришь, что может быть "настоящий" хороший финал, что герои справятся, что добро победит. И знаешь что? Игра эту надежду поддерживает почти до самого конца. Спойлер: может быть хороший финал, но за него придётся платить.

Эта разница в тоне критически важна для восприятия. Киберпанк давит на тебя безысходностью, БГ3 вдохновляет на борьбу. Но структура сюжета при этом остаётся идентичной.

Мораль простая: Cyberpunk 2077 и Baldur's Gate 3 используют одну и ту же архетипическую завязку, только упакованную в разные сеттинги.

Формула железобетонная и работает безотказно. Герою насильно впихивают в голову что-то постороннее — паразита, программу, сущность. Это даёт новые способности и силу, но медленно убивает или превращает в монстра. Запускается обратный отсчёт — у тебя есть ограниченное время. Весь сюжет строится вокруг поиска спасения, но каждый шаг только усложняет ситуацию. И финал — это всегда невозможный выбор о цене выживания, где придётся чем-то пожертвовать.

Это классический сторителлинг дивайс: "герой проклят и должен найти исцеление до того, как станет монстром или умрёт". Этой схеме сотни лет, если не тысячи. Но разработчики обеих игр взяли этот древний приём и реализовали его на высочайшем уровне. Только один раз это сделали в стиле киберпанк-нуара с синтетическими наркотиками, мегакорпорациями и дигитальными душами, а второй — в стиле классического D&D с драконами, магией и древними богами.

Различия? Ну конечно есть. Одна игра происходит в Найт-Сити, другая — в Вратах Балдура. В одной стреляешь из техно-пушек, в другой кидаешь фаерболы. Одна про умирающего наёмника, другая — про героя-авантюриста. Но механика завязки, её нарративная функция и эмоциональное воздействие на игрока практически идентичны.

Обе игры на высочайшем уровне эксплуатируют одни и те же темы. Что такое личность — набор воспоминаний, физическое тело или что-то ещё? Где граница между "я" и "не-я"? Готов ли ты умереть, чтобы остаться собой, или лучше жить монстром, чем не жить вообще? Что важнее — сохранить себя или спасти других? Эти вопросы одинаково работают и в футуристическом Найт-Сити, и в фэнтезийных Вратах Балдура.

Философы от геймдева, одним словом. И знаешь что? Обе справились на отлично. Обе игры заставляют тебя думать о своих выборах, переживать за персонажей, мучиться с решениями. Обе оставляют послевкусие надолго после финальных титров.

Так что в следующий раз, когда кто-то удивлённо спросит "что общего у Киберпанка и Балдурс Гейта", можешь смело отвечать: "Практически всё. Это одна игра в двух совершенно разных шкурах, но с одинаковым сердцем".

P.S. Теперь мне интересно, сколько ещё игр используют эту схему, и я просто не обращал внимания. Пишите в комментах, если найдёте ещё примеры — давайте составим целую коллекцию. А я пойду в третий раз перепройду обе эти игры, потому что они просто шедевры. Каждая по-своему, но шедевры.