Цифровые сооснователи: как агентный ИИ превращает воображение в солобизнес

Анализ научной работы Farhad Rezazadeh и Pegah Bonehgazy (12 ноября 2025 г.). Digital Co-Founders: Transforming Imagination intoViable Solo Business via Agentic AI

Сегодня я бы хотел обсудить научную работу, которая смело исследует проблему нехватки ресурсов на все задачи у предпринимателей, которые решили открыть бизнес в одиночку и как в этом может помочь искусственный интеллект.

Эта тема действительно интересна, ведь было бы круто иметь правую руку, которая может разгрузить тебя в рутине, помочь не забыть важное или провести мозговой штурм. Но реально ли это на сегодня? В статье НЕ обсуждаются конкретные инструменты, НЕ делается оценок реальности создания ии-сооснователя. Мне кажется такие обсуждения (в части полной автоматизации) еще далеки от реальности, до полностью агентных систем, которые смогут обеспечить достаточную точность еще далеко, а для бизнеса очень важно отсутствие галлюцинаций и ошибок, т.к. ставки высоки. Но обсуждать необходимо и важно, т.к. однажды мы проснемся в реальности, где солобизнес с ИИ будет обыденностью.

Исследуется как все-таки возможно превращать креативные идеи в успешные соло-бизнесы в эпоху, в которой всё большую роль играют агентные системы искусственного интеллекта.

Соло-бизнесы и предприятия с единственным учредителем становятся всё более заметной и влиятельной частью глобального экономического ландшафта. Благодаря цифровым платформам, недорогим инструментам и гибким форматам занятости люди сегодня могут придумывать, тестировать и запускать продукты или сервисы без традиционной инфраструктуры крупной компании или команды основателей.

В основе солопредпринимательства лежит парадокс, который ИИ одновременно усложняет и помогает решать. С одной стороны, соло-основатели обладают высокой степенью свободы. Они могут определять собственное видение, выбирать собственный темп и менять направление без необходимости согласования. С другой стороны, эта же свобода ограничена скудностью человеческих ресурсов, ограниченной когнитивной пропускной способностью и эмоциональной устойчивостью. Один человек вынужден одновременно быть стратегом, создателем, маркетологом, операционным менеджером и финансовым управляющим, уборщиком и всем всем всем. ИИ-агенты могут частично взять на себя некоторые из этих ролей - заниматься рутинными задачами, запускать эксперименты или взаимодействовать с клиентами, - но при этом они создают и новые требования: разработка промптов, надзор за системами и стратегическая оркестрация взаимодействия человека и ИИ.

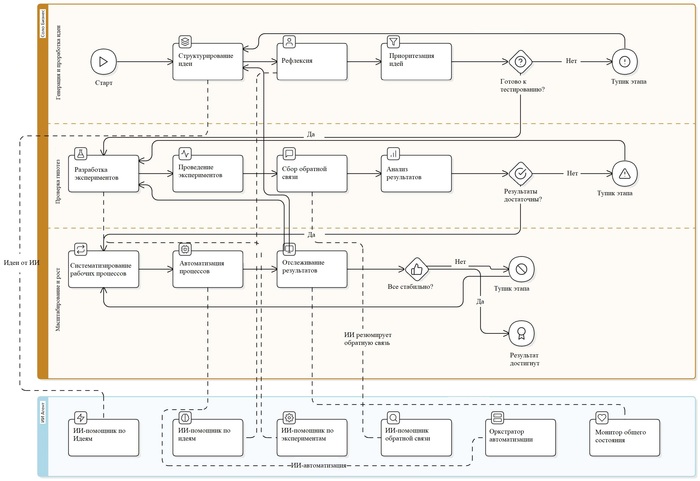

Жизнь стартапа можно описать тремя простыми этапами:

Генерация и проработка идеи

Проверка гипотез (валидация)

Масштабирование и рост

1. Генерация и проработка идеи: от воображения к гипотезе

Первый этап - это не просто «придумать что-то крутое». Это системная работа по превращению абстрактных увлечений в конкретные бизнес-гипотезы. Например, ваша страсть к экологии может стать основой для SaaS-платформы по отслеживанию углеродного следа малого бизнеса. Здесь ИИ выступает как проводник, помогающий структурировать хаос творческого мышления.

Ключевые механизмы:

От смысла к ценности. Вы задаетесь вопросом: «Что важно для меня, и как это решит чью-то проблему?». Генеративный ИИ предлагает варианты монетизации ваших ценностей: анализирует ниши, формирует нарративы, подсвечивает аудитории. Но финальный выбор всегда за вами - только человек оценивает, насколько идея соответствует его миссии.

Проблема → решение. Размытые идеи обретают контуры через вопросы: «Кто столкнется с этой проблемой?», «Почему мой подход лучше аналогов?». ИИ сканирует рынок: анализирует отзывы в тематических сообществах, сравнивает предложения конкурентов. На этом этапе важна не точность данных, а формирование логичного направления.

Портфель идей. Успешные солопредприниматели редко фокусируются на одной концепции. Они создают «портфель» гипотез и ранжируют их по критериям: соответствие личным ценностям, доступность ресурсов, риск. ИИ помогает визуализировать сравнения, моделирует базовые сценарии - например, прогнозирует время вывода продукта на рынок при использовании разных инструментов автоматизации.

Маленькие шаги. Идея оживает через микрообязательства: «Провести 5 интервью с целевой аудиторией», «Создать лендинг за 48 часов». ИИ снижает барьер для старта: генерирует черновики текстов, дизайны мокапов, настраивает простые автоматизации. Это сохраняет мотивацию и минимизирует страх перед неудачей.

Ресурсы этапа: бизнес-канвасы, дневники рефлексии(mind-map), тематические сообщества, канвасы бизнес-модели, канвасы ценностного предложения, а также цифровые инструменты, помогающие артикулировать и уточнять идеи. ИИ здесь — когнитивный усилитель, который ускоряет исследование рынка и артикуляцию мыслей.

2. Проверка гипотез: лаборатория для смелых экспериментов

Второй этап - проверка на прочность. Никаких масштабных запусков и инвестиций. Только быстрые, недорогие тесты, которые подтвердят или опровергнут вашу гипотезу.

Как это работает:

Нано-MVP. Забудьте о классических MVP. Для солобизнеса достаточно поста в соцсетях с описанием услуги, опроса в Telegram-чате или простого лендинга с кнопкой «Предзаказ». ИИ генерирует контент для таких экспериментов за минуты: тексты, иллюстрации, шаблоны email-рассылок.

Обратная связь без иллюзий. Качественные данные важнее количественных. 10 глубоких интервью с потенциальными клиентами дадут больше, чем 1000 анкет. ИИ транскрибирует беседы, выделяет ключевые боли, но интерпретировать эмоции и скрытые мотивы - задача основателя. Здесь легко попасть в ловушку: игнорировать критику, потому что идея слишком личная, или, наоборот, отказаться от перспективного направления из-за пары негативных отзывов.

Цикл «Действие → Анализ → Решение». Каждый эксперимент заканчивается выбором: развивать идею, изменить аудиторию/модель или закрыть проект. Критерии просты: «Есть ли платящие клиенты?», «Дает ли это мне энергию?». ИИ помогает фиксировать результаты, выявлять тренды - например, отмечает, что запросы на ваш сервис растут только в определенном регионе.

Совместное создание с клиентами. Первые пользователи помогают дорабатывать продукт. ИИ берёт на себя рутинное общение: сам отправляет сообщения после разговоров и собирает отзывы через чат-бота. Но личное участие основателя в этих разговорах по-прежнему критично важно, чтобы общение оставалось живым и настоящим.

Ресурсы этапа: no-code инструменты для прототипирования, платформы для сбора обратной связи, автоматизации рабочих процессов - расширяют то, с чем один человек может поэкспериментировать за ограниченное время.

3. Масштабирование: как расти, не теряя себя

Когда гипотеза подтверждена, наступает время систематизировать успех. Цель - создать машину, которая работает даже в ваше отсутствие, но при этом не превращает вас в узника собственного бизнеса.

Стратегии устойчивого роста:

Рутинизация процессов. Все повторяющиеся задачи - от обработки заказов до написания постов - должны быть сведены к четким алгоритмам: чек-листам, шаблонам, расписаниям. ИИ-агенты берут на себя рутину: бронируют встречи, генерируют отчеты, отвечают на стандартные вопросы клиентов. Но ключевые решения (например, изменение позиционирования) остаются за человеком.

Сетевое масштабирование. Вместо найма команды вы строите экосистему: фрилансеры для узких задач, no-code платформы для автоматизации, ИИ-агенты для аналитики. Например, контент-стратегия может включать генерацию идей через ChatGPT, создание графики в Midjourney, а продвижение - через интеграцию с фрилансером-таргетологом.

Бренд как компас. Понятно сформулированный бренд помогает не размазаться, когда вы растёте. ИИ помогает держать единый стиль: следит за тем, как вы звучите в соцсетях, подсказывает, как немного менять текст под разные площадки. Но идея бренда, его ценности и голос - это зона личной ответственности основателя.

Ресурсы этапа: CRM-системы, инструменты автоматизации, образовательные платформы для апскейла навыков. ИИ здесь - инфраструктурный элемент, который усиливает ваши возможности, но не заменяет стратегическое мышление.

По итогу, искусственный интеллект, как инструмент – помощник в бизнесе определенно дает огромное преимущество, но чтобы пользоваться этим инструментом придется нарастить экспертизу в еще одном направлении, что может быть очень сложно солопредпринимателю, ведь на его плечах все задачи по построению бизнеса. Человеку в этой ситуации главное быстро сориентироваться и применять инструменты, которые при малых усилиях дадут огромный буст в производительности.

Реально ли уже сегодня управлять своим бизнесом в одиночку и разгрузить рутину на ИИ-Агентов – определенно да, вопрос в желании и открытости к новому.