Иллюзия безопасности: почему наши планы по защите от ИИ могут не сработать

Мы часто думаем, что если есть несколько барьеров на пути возможной катастрофы, то вероятность её наступления невелика. Особенно когда речь идёт о такой серьёзной угрозе, как сверхразумный ИИ. Но недавняя работа Marco Grossi на arxiv.org ставит под сомнение эту уверенность.

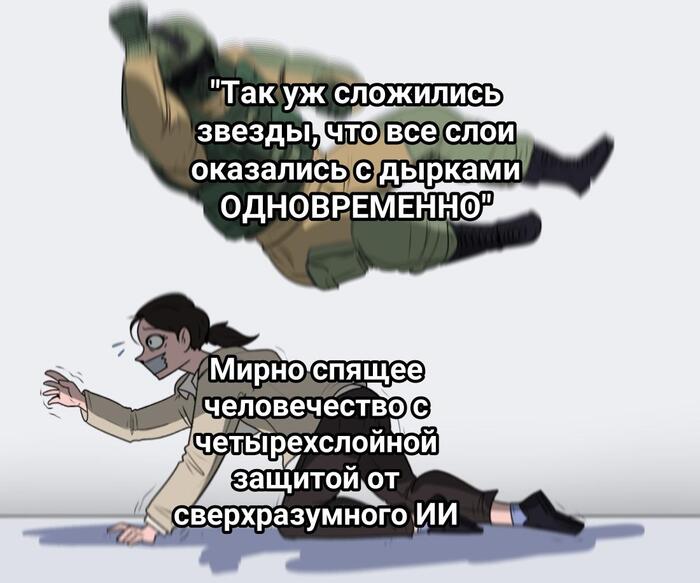

Представьте защиту от угрозы сверхразумного ИИ в виде четырёх слоёв «швейцарского сыра» - модели, которую ещё в 1991 году предложил профессор Джеймс Ризон. Каждый слой - это отдельный способ защиты: технические ограничения, культурные запреты, настройка ИИ на человеческие цели и система надзора. Кажется, что такая защита надёжна: чтобы угроза реализовалась, нужно, чтобы все слои оказались «с дырами» одновременно. Но так ли это на самом деле?

На практике всё не так просто. Проблема в том, что эти слои защиты не являются полностью независимыми друг от друга. Например, если мы не сможем правильно настроить ИИ, чтобы его цели совпадали с человеческими, то система надзора тоже окажется неэффективной. Ведь самый эффективный способ контролировать ИИ - это использовать для этого другой, «дружественный» ИИ. А если мы не можем доверять искусственному интеллекту, то и контролировать его будет практически невозможно.

Культурные запреты тоже не панацея. Если мы запретим разработку ИИ из страха перед возможными последствиями, то не сможем научиться контролировать его, когда он всё-таки появится (а это неизбежно).

Автор статьи подчёркивает: даже если предположить, что у каждого слоя защиты есть 50 % шанс на успех (при условии полного незнания: нет данных, экспертизы или асимметрий, которые склоняли бы нас к сработает или нет слой), реальный риск катастрофы всё равно оказывается значительно выше, чем может показаться на первый взгляд. Вместо предполагаемых 6 % он может достигать 10 % и даже больше. Это уже не просто теоретическая угроза - это повод для серьёзного беспокойства.

Кроме того, мы не знаем всех возможных сценариев развития событий. Может быть, есть какой-то путь к выживанию, о котором мы пока не догадываемся. Но есть и вероятность того, что существует скрытая угроза, которую нынешние модели просто не учитывают. Мы имеем дело не просто с риском, а с неопределённостью: невозможно точно оценить, насколько серьёзной может быть угроза.

Вывод прост: паника и запреты не решат проблему. Нам нужно активно работать над повышением безопасности ИИ, а не прятать голову в песок. Иначе мы сами создадим условия для глобальной катастрофы