Привлечь разом 600 посетителей на новый сайт услуг, как это сделать? Или как получить целевых покупателей товаров? И может ли юрист, врач, бухгалтер, учитель разом заявить о себе потенциальным клиентам? Да, можно и нужно, только делать это нужно автоматизировано, сейчас об одном аспекте этого – парсеры и боты.

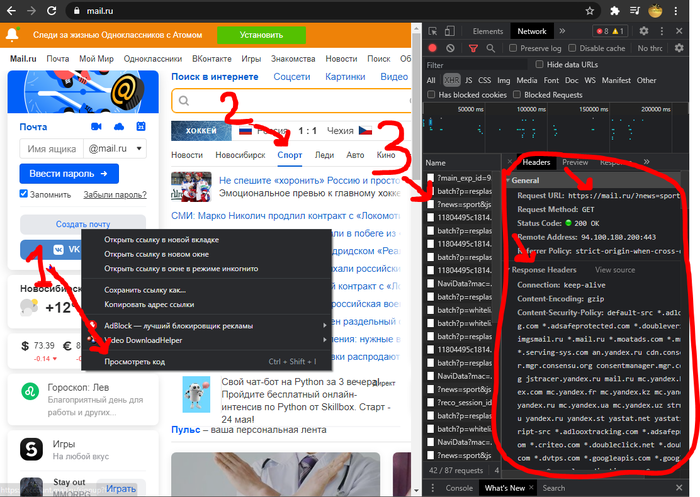

Назначение парсинга это получить структурированную информацию, раньше была разбросана по страницам, а теперь в одном списке или файле. Если вы видите на странице сайта курс валют, то с высокой вероятностью этот курс получили с сайта минфина, погоду – с сайта погоды, новости – с других сайтов. То есть данные не вводят каждый день вручную, это автоматизированный процесс, чаще парсерами.

Вот как пример http://alexmarned.zzz.com.ua/baza/

Обычные новости на поисковиках — это тоже результат парсинга. Разработчики гугла или другого поисковика пишут роботов, которые мониторят газеты и новостные порталы и просто выводят эту информацию для вас в виде кратких анонсов с ссылкой на источник.

И привлечение клиентов через рассылку и прямое обращение - для этого парсинг простой понятный путь найти клиентов. Хотя тут надо наших бизнесменов обучать как это правильно делать– вроде элементарно, а всегда вопросы по деталям – да, думаю, что тут нужно специальное обучение. Перенести товар с сайта конкурентов и при этом сделать контент уникальным – тоже частая задача. Множество бизнесменов так и начинает.

У поисковиков нет журналистов, нет стриммеров и они выводят актуальную информацию путём парсинга. Кстати, выявить наиболее актуальные новости и анонсы — это очень интересная задача, невероятное сплетение высокой математики, статистики и программирования. Я делал небольшой анализатор новостей, это очень полезно для бизнеса, ведь небольшое преимущество это всё-таки преимущество во времени н деньгах, и будут уже ваши конкурентные моменты, позволяющие заработать немного больше. А как известно курочка по зёрнышку клюёт. Правда, это разработка для уровня директор или сопоставимая величина, человек принимающий решения, или может быть акционер. Если анализатор новостей кому интересен, то напишите, сделаю такую страницу в открытый доступ.

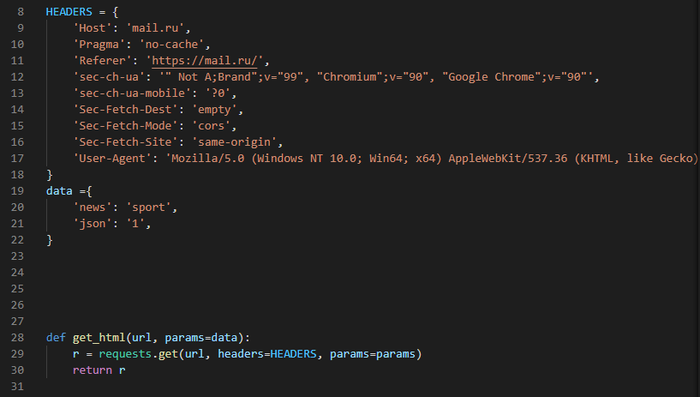

Обычные запросы по парсингу от клиентов - это отследить цены свои или конкурента, отследить ассортимент конкурента, проверить наличие товара на сайте, выяснить позиции товара на маркетплейсах, сравнить и добавить отсутствующее на сайт. Постоянные проблемы бизнеса с добавлением товара на сайт сильно упрощаются парсингом, пусть на первом шаге это не уникально и шаблонно, только это уже будет сделано, потом можно доработать.

И немного посчитаем. Прибыль зависит от количества покупателей, а это уже поддаётся подсчёту и прогнозированию. Автоматизацией бизнеса мы можем сильно увеличить охват аудитории - просто добавив функционала, который сам покажет и объяснит посетителям все детали. И это круглосуточно. И поэтому такие действия увеличивают вашу прибыль, а если ваш сайт не автоматизирован, то увеличиваются и затраты на обслуживание. По итогу это всё равно выгоднее, чем ждать клиентов в расчёте на случай.

Потом реклама – а привести её можно только на свой сайт, чужое рекламировать бессмысленно, только деньги выкидывать. А на вашем сайте нужно наполнение. Варианты этого такие: можно сделать контент самому хотя-бы за полгода или второй вариант - сделать парсингом за один - два дня и через пару месяцев сайт будет полноценно работать? Выбор очевиден.

Получить целевую аудиторию с групп и сообществ? Вручную это делать бессмысленно, затраты слишком высоки и по времени очень затратно. Это и через парсинг очень непросто сделать, вручную лучше и не пробовать. Целевая аудитория даст моментальный рост бизнеса, часто показатели вырастают по траектории ракеты.

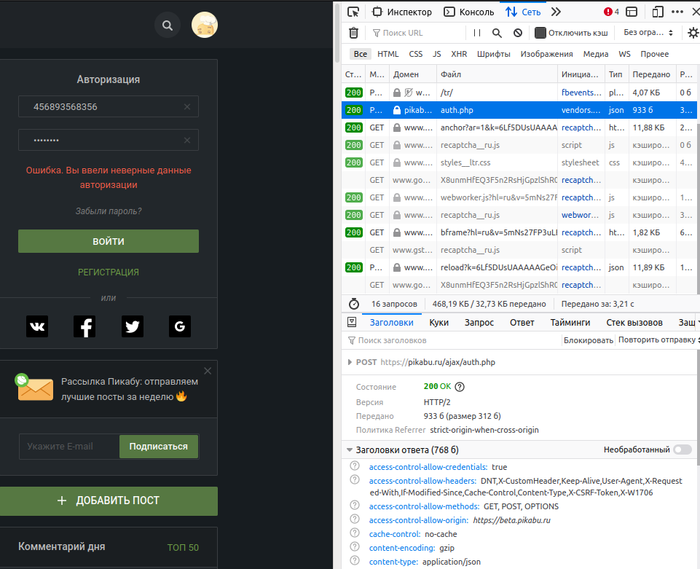

И если вы получили контакты целевых клиентов, то тогда можно сделать рассылку писем. На самом деле рассылка, это очень сложный бизнес, ваши письма могут попасть в спам, вас могут заблокировать и много чего может случиться. И вам могут отказать в рассылке, даже без жалоб на вас, отказать в платной рассылке, вы не сможете пройти модерацию по разным причинам. Потому что всем важен рейтинг, а вы его можете сильно понизить и только деньгами это не исправить.

Но рассылка возможна и тут тоже могут быть очень хорошие результаты – даже суточная рассылка даст посетителей на сайт и нескольких клиентов в месяц.

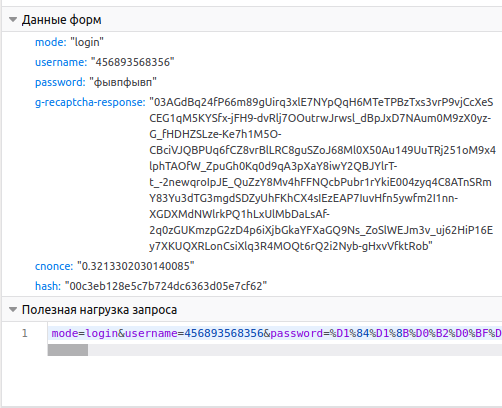

В этом вопросе я тоже продвинулся немного дальше – сделал инструмент для сбора всех доступных контактов клиентов. Задаём вводные данные и потом получаем список в экселе со всеми телефонами, почтой, адресом, социальными сетями, контактами в мессенджерах; иногда программа находит и другие данные, вплоть до налоговый данных, дальше просто не разрабатывал.

Это даёт разные каналы для привлечения потенциальных клиентов ваших услуг или товаров. Юристы или бухгалтеры тоже могут привлекать клиентов таким способом, не обязательно это должен быть физический товар.

И получается, что это очень хороший инструмент для бизнеса. Только пользуйтесь аккуратно - неосторожное использование принесёт вам кучу головной боли – баны, блокировки, занесение в черный список, предупреждения от важнейших для бизнеса сервисов, понижение в рейтингах, отлучение от хостинга, снижение скорости доступа. Всего не перечислишь.

Если проплюсуете за пост, выложу ещё базы в открытый доступ и если нужно, то сделаю обучалку по этому.