Возможность на $300 млрд: как заработать на вертикальных ИИ-агентах

Сегодня наступает новая эпоха, в которой ИИ не только помогает с рутинными задачами, но становится настоящим «сотрудником».

Если в 2000-х появление SaaS (Software as a Service) превратило громоздкие программы в облачные сервисы и сформировало рынок в $300 млрд долларов, то теперь нас ждет следующий подобный скачок — эра вертикальных ИИ-агентов.

Аналитики и инвесторы уже всерьез заявляют: вертикальные ИИ-агенты могут превысить масштабы нынешнего SaaS-рынка. ИИ-агенты могут заменить целую команду: от отдела продаж до QA-инженеров. Разница с классическим SaaS колоссальна: если SaaS повышал эффективность существующих команд, то ИИ-агенты позволяют создавать компании с куда меньшим штатом, а в перспективе - полная автоматизация бизнес-процессов компании.

В отличие от облачного приложения, которое упрощает отдельные операции, ИИ-агент самостоятельно планирует, действует и принимает решения. Также SaaS был общим инструментом для всех, а вертикальный ИИ-агент нацелен на конкретную функцию.

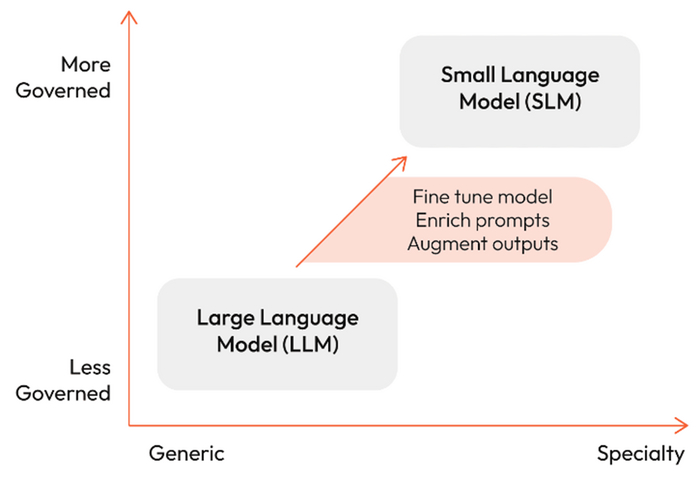

Интересно, что крупным игрокам тяжело конкурировать в специальных вертикальных сегментах. Гиганты, подобно Google, игнорировали узкие ниши (скажем, автоматизацию специфических банковских операций или фарм-процессов) — именно там стартапы выигрывают. Они глубоко погружаются в специфику, обучают ИИ-модели на уникальных данных, создают технологический барьер для конкурентов и предлагают решение, за которое клиент готов платить больше, ведь оно идеально «заточено» под его задачи.

Эта ситуация напоминает ранний период SaaS, когда небольшие компании, вроде Salesforce, нашли «золотую жилу» до того, как старые IT-корпорации успели перестроиться. История циклична: сейчас — звездный час стартапов, работающих над вертикальными ИИ-продуктами.

Поэтому вот основные советы для технологических предпринимателей:

- Найдите проблему, которую ИИ может решить лучше, чем человек, и двигайтесь в сторону “вертикализации” решения, усиляя барьеры для конкурентов;

- Используйте уникальные данные для обучения более «умных» агентов;

- Начав с обертки над GPT, развивайтесь в сторону автоматизации полноценного рабочего процесса, интегрируясь с большим количеством инструментов.

Например, Harvey - GPT для юристов, подчеркивает тренд: нишевые задачи, ранее требовавшие десятков сотрудников, теперь может решать один специализированный ИИ-агент. Генерация контрактов, анализ законодательных актов, поиск судебных прецедентов — все становится «интеллектуальной рутиной» для ИИ.

Другой пример — превратить сервисный бизнес в продуктовую компанию: кадровые агентства, маркетинговые агентства, консультационные фирмы уже сейчас могут автоматизировать ключевые операции с помощью обученных на собственных экспертных данных ИИ-моделей. Это дает им технологическое преимущество, повышает маржинальность и открывает дорогу к упаковке сервисов в продукты.

Появление LLM, технологических платформ, а также инструментов вроде CrewAI, LangChain и n8n упростило создание ИИ-агентов. Также сегодня человек без навыков программирования может разработать простое приложение, используя ИИ. С правильно выбранной нишей и подходом можно быстро вывести на рынок MVP и протестировать спрос.

Мы находимся в уникальном моменте: ещё недавно гиганты определяли правила игры, а теперь небольшие стартапы могут захватить лидерские позиции в отдельных отраслях. Те, кто вовремя адаптируются, создав вертикальные ИИ-решения, способные заменить целые команды, окажутся в числе тех, кто будет делить пирог не в миллионы, а в миллиарды долларов.

Потенциал колоссален, а возможности безграничны.

$300 млрд — не предел, а стартовая отметка для тех, кто решит пойти по пути вертикальных ИИ-агентов. Сейчас самое время начать действовать, чтобы войти в историю нового технологического бума.

Если вам интересна тема ИИ, подписывайтесь на мой Telegram-канал — там я регулярно делюсь инсайтами по внедрению ИИ в бизнес, запуску ИИ-стартапов и объясняю, как работают все эти ИИ-чудеса.